基于Chebyshev神经网络的非线性Fredholm积分方程数值解法

2020-03-25韩惠丽房彦兵

李 娜, 韩惠丽, 房彦兵

(宁夏大学 数学统计学院, 银川 750021)

微积分广泛应用于材料学、 物理学和工程技术等领域. 非线性积分方程由于其自身的性质, 已有的大量积分方程无法获得解析解, 于是人们设法去求解其近似解, 目前已发展了许多可行的求解方法[1]. 例如: 用Legendre多项式结合配置法求解非线性Volterra-Fredholm积分方程[2]; 径向基函数与离散配置法结合求解非线性Volterra积分方程[3]等. 上述数值求解方法中多采用了级数形式、 多项式插值或小波分析理论等. 随着神经网络理论[4]研究的不断深入及计算技术的不断发展, 应用神经网络逼近理论求解微积分方程已逐渐成为一种新型的数值计算方法. 张志刚等[5]提出了应用传统BP人工神经网络对第二类线性Fredholm积分方程进行求解的方法; 郭新辰等[6]提出了应用径向基神经网络求解第二类Volterra积分方程, 把方程的求解采用神经网络逼近转化为对网络训练指标的优化问题, 应用粒子群优化学习算法进行网络迭代计算; Jafarian等基于反馈神经网络求解了Fredholm积分方程(组)[7]和Volterra积分方程(组)[8], 采用Taylor展式的第N次截断代替未知函数, 把问题转化为求解未知函数Taylor展式的系数, 通过构建三层反馈神经网络调整系数, 与已有的数值方法相比, 其具有良好的泛化能力, 计算精度较高; Tomasiello等[9]给出并研究了由块脉冲函数导出的一组正交基函数对非线性Volterra-Fredholm积分方程的基于神经网络的算法; 邹阿金等[10]基于多项式理论提出了一种基函数神经网络模型, 这种网络结构的隐层采用正交多项式进行激励响应, 基函数的项数确定了隐层神经元的个数. 由于组成基函数的基底具有不同的性能, 能更全面反映神经网络结构对函数的高精度逼近; 文献[11]对该类神经网络的逼近性能进行了理论分析, 并证明了网络的全局收敛性质, 结果表明在相同条件下, 当选择Chebyshev多项式作为隐层激活函数时, 所构造的神经网络性能最优; 吴小俊等[12]运用Stone-Weierstrass定理对Chebyshev神经网络逼近能力最优给出了理论证明. 本文基于Chebyshev神经网络模型求解非线性Fredholm积分方程, 模型中隐层神经元的激励函数为一组Chebyshev正交多项式序列.

1 Chebyshev正交基函数

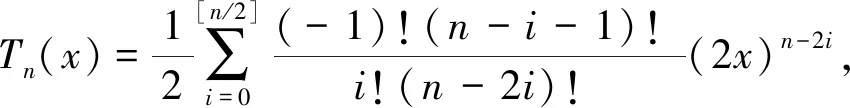

定义1[10]第一类Chebyshev多项式定义为

Tn(x)=cos(narccosx), -1≤x≤1.

(1)

(2)

且满足递推公式:

T0(x)=1,T1(x)=x,Tn+1(x)=2xTn(x)-Tn-1(x),n=1,2,…

(3)

性质1[10]Chebyshev多项式Tn(x)最高次幂项xn的系数是2n-1.

性质2[10]当|x|≤1时, |Tn(x)|≤1.

性质3[10]权函数ρ(x)有如下正交性:

2 Chebyshev神经网络求解非线性Fredholm积分方程

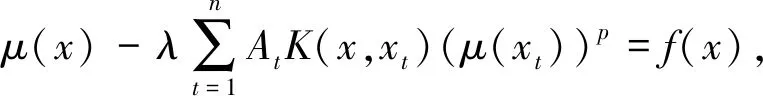

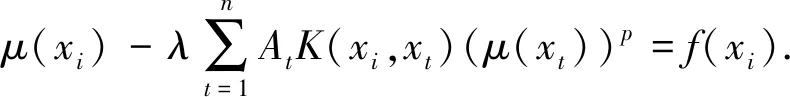

本文基于多项式插值和函数逼近原理, 提出一种以Chebyshev正交基函数为神经网络隐层激励函数的神经网络模型求解非线性Fredholm积分方程

(4)

式中:K(x,t),f(x)是已知函数;μ(x)是未知函数.

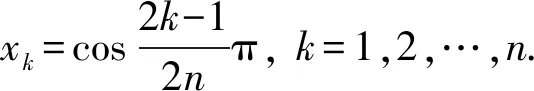

2.1 数值求解格式

(5)

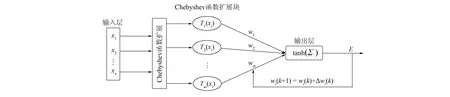

构建如图1所示的Chebyshev神经网络(Chebyshev neural network, ChNN)模型, 该模型包含两部分: 数值变换和ChNN学习算法. 采用Chebyshev扩展块代替隐层结构, 优化神经网络.

图1 Chebyshev神经网络拓扑结构

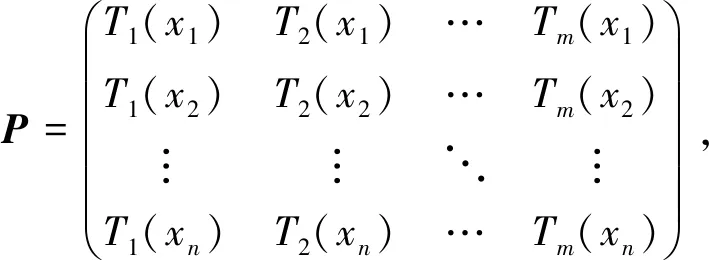

输入向量x=(x1,x2,…,xn)进入输入层, 线性输出后, 进入Chebyshev扩展块, 实施Chebyshev多项式展开, 得到激励矩阵:

(6)

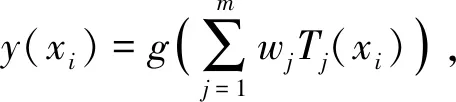

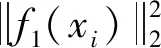

作为新的输入向量进行计算,w=(w1,w2,…,wm)为Chebyshev扩展块到输出层的权值. 网络输出为

(7)

其中:

网络误差为ei=(f1(xi)-f(xi))2/2.

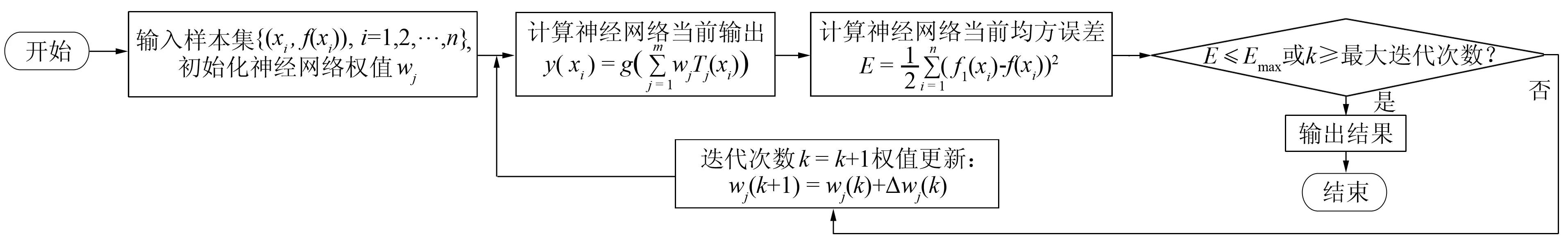

2.2 学习算法

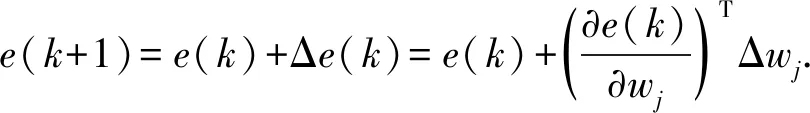

神经网络的学习算法是影响其性能的重要因素之一. 利用定义在[a,b]内的输入向量x=(x1,x2,…,xn)对神经网络参数wj(j=1,2,…,m)进行修正, 在训练指标最小化的约束下使神经网络实现高效逼近. 本文采用梯度下降学习算法对训练指标(8)进行优化, 得

(9)

其中:k=1,2,…为迭代次数;η为神经网络学习率;

且

(11)

算法流程如图2所示.

图2 Chebyshev神经网络算法流程

3 收敛性分析

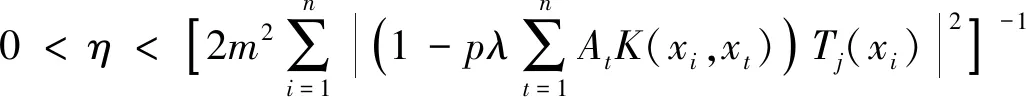

定理1当学习率η满足

(12)

时, 求解非线性Fredholm积分方程的Chebyshev神经网络算法收敛, 其中m为Chebyshev多项式项数.

证明: 若使神经网络算法收敛, 则需取Lyapunov函数V=e2(k)/2, 满足

所以

从而有

即η满足式(12)时有ΔV(k)<0, 从而求解非线性Fredholm积分方程的ChNN算法收敛.

4 数值算例

例1考虑如下非线性Fredholm方程[13]:

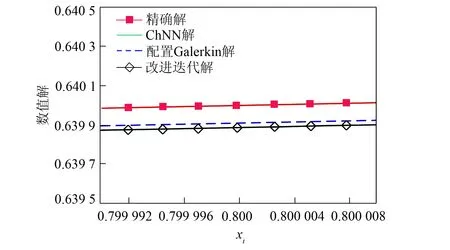

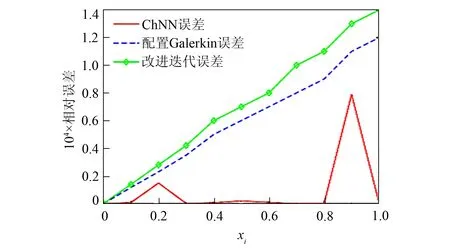

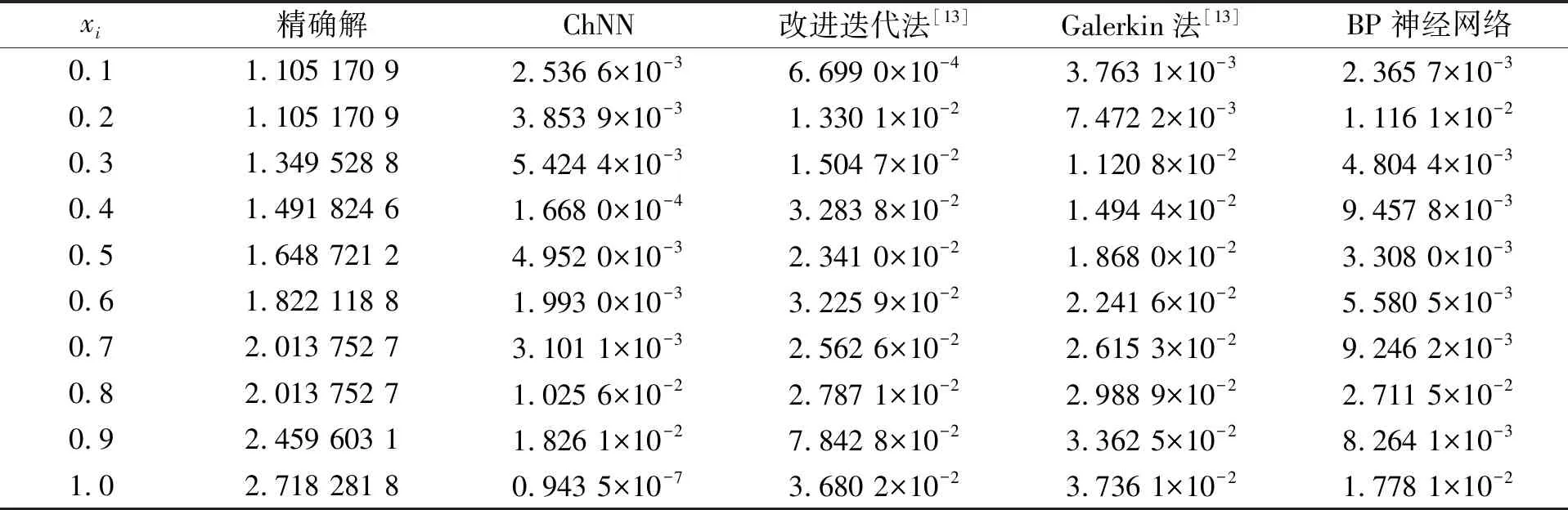

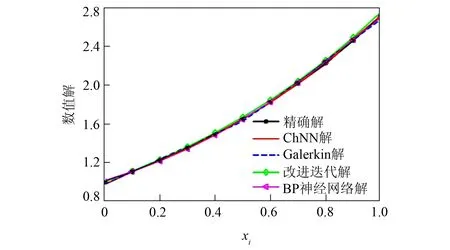

表1列出了文献[13]所提出的配置Galerkin法、 改进迭代法与本文构建的ChNN解法以及传统BP神经网络解法计算得到的相对误差对比结果. 由表1可见, ChNN解法对非线性Fredholm积分方程逼近精度较高. 对积分区间进行10等分, 当离散后的输入节点xi选取不同数值时, 将上述4种方法所得的数值解与精确解做对比, 结果如图3所示. 图4为当x=0.8时对图3局部放大的结果. 由图4可见, ChNN解的精度更高. 图5为上述4种方法的相对误差比较. 由图5可见, 传统BP神经网络的相对误差明显比其他3种方法都高. 对配置Galerkin法、 迭代法与ChNN方法的误差曲线进行放大, 结果如图6所示. 由图6可见, 配置Galerkin法和迭代法的相对误差不断增大, 而ChNN法的相对误差较小, 比较平稳.

表1 在给定节点处不同数值方法求解例1相对误差的对比 Table 1 Comparison of relative errors of example 1 solved by different numerical methods at given node

图3 不同算法求解例1数值解与精确解的比较

图4 x=0.8时对图3局部放大的数值解与精确解

图5 4种算法求解例1数值解的相对误差比较

图6 3种算法求解例1数值解的相对误差比较

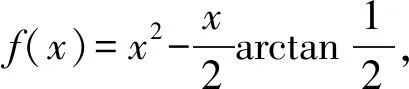

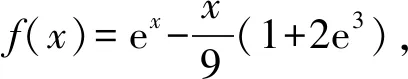

例2考虑如下方程[13]:

表2列出了Chebyshev神经网络、 文献[13]提出的Galerkin方法和迭代法、 传统BP神经网络计算得到的数值相对误差比较结果. 对积分区间进行10等分, 当离散后的输入节点xi选取不同数值时, 上述4种方法所得数值解与精确解的对比结果如图7所示. 图8为当x=0.4时对图7的局部放大结果. 由图8可见, ChNN方法比3种对比数值方法的拟合效果都好, 精度更高. 4种算法的相对误差对比结果如图9所示.

表2 在给定节点处不同数值方法求解例2相对误差的对比

图7 4种算法求解例2数值解与精确解的比较

图8 x=0.4时对图7局部放大的数值解与精确解

由图9可见, Galerkin方法的误差不稳定, 迭代法的误差不断增大, BP神经网络的误差相对稳定, 而ChNN方法虽然在区间端点处出现了局部波动, 但中间节点处误差基本稳定, 相对误差较小, 能更有效地逼近.

例3考虑如下线性Fredholm积分方程[7]:

其精确解为μ(x)=-12x-8.

文献[7]先对Fredholm积分方程未知函数进行Taylor展开, 得到关于Taylor展式中系数的矩阵方程组, 设定方程组的系数矩阵为所构造的神经网络权值, 网络迭代更新从而得到积分方程的数值解, 因为方程组的系数矩阵元素为积分形式, 导致计算相对复杂, 运算时间较长. 表3列出了本文构造的ChNN方法、 文献[7]构造的神经网络方法和传统BP神经网络方法计算例3得到的相对误差比较结果.

表3 在给定节点处不同数值方法求解例3相对误差的对比

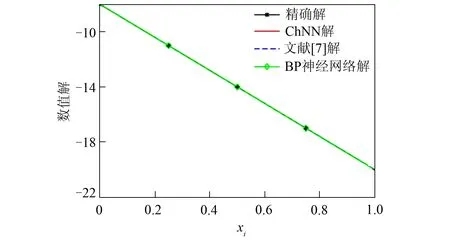

对积分区间进行5等分, 离散后的输入节点xi选取不同数值时, 上述3种方法所得的数值解与精确解对比如图10所示. 图11为当x=0.75时对图10局部放大结果. 由图11可见, ChNN方法的拟合效果较好, 精度更高. 4种方法求解例3产生的相对误差对比如图12所示. 由图12可见, ChNN方法比其他两种神经网络方法的误差更稳定.

图9 4种数值方法求解例2的相对误差对比

图10 3种算法求解例3数值解与精确解的比较

图11 x=0.75时对图10进行局部放大的结果

图12 3种数值方法求解例3的相对误差对比

综上, 本文求解了非线性Fredholm积分方程的数值解, 首先对方程进行数值离散得到代数方程组的形式, 然后应用基于梯度下降法的Chebyshev神经网络进行样本训练, 从而得到理想的数值解. 其次, 从理论上分析了当学习率满足一定条件时, 本文构造的Chebyshev神经网络算法是收敛的; 最后用数值算例验证, 进一步说明了本文方法的有效性和可行性.