融入帧间差分法的深度学习目标识别仿真研究

2019-12-27于立君刘朝达高天禹

王 辉,于立君,孙 蓉,刘朝达,高天禹

融入帧间差分法的深度学习目标识别仿真研究

王 辉,于立君,孙 蓉,刘朝达,高天禹

(哈尔滨工程大学 自动化学院,黑龙江 哈尔滨 150001)

目标检测与识别是数字图像处理实验的创新性实验项目。传统的目标识别算法可以识别目标类型,但不能识别目标的位置信息,且对相同目标的识别率较低。该文设计了一种基于帧间差分法的深度学习目标识别算法,即在深度学习理论构架下,将帧间差分法融入识别过程,补充增强候选框分割图像,通过NMS算法对候选框进行筛选。仿真结果表明,该算法在识别目标种类的同时还能对目标在图像中的位置进行精确标定,并可判断目标是否处于运动状态,具有较高的识别率。

目标检测与识别;创新性实验项目;帧间差分法;深度学习

近年来,随着现代机器人技术的快速发展,机器工作的场景已不再局限于室内,在许多室外工作场所中,机器代替人工进行生产作业提高了工作效率、降低了生产成本。这些应用都需要可靠的目标检测识别算法[1]来帮助机器人完成任务。传统的识别算法识别效果完全取决于人工设计的特征提取算法是否合理,然而大部分人工设计的特征提取算法都无法完全满足要求,算法产生的特征健壮性不佳,难以作为分类器分类的依据。

本文利用深度学习技术将平台上的摄像机捕获的图像中的目标识别出来,再通过Tensorflow对其进行实现,同时将帧间差分法的动态目标识别算法融入Faster RCNN[2]分割候选区域选择与最终标注中。动态目标识别算法能够为神经网络提供多帧图像间的变化信息加强识别效果,还能够帮助确定目标的运动情况,从而为无人平台提供更多参考信息。

1 特征提取基网络构架

卷积神经网络[3]能够通过卷积一层层地提取图像的特征信息并进行分类识别。但是在目标识别任务中,卷积神经网络[4]只能对图像中存在的目标进行整体的定性识别。为了利用神经网络提取图像中目标的更多信息,需要对网络结构进行改变。

1.1 迁移学习提取特征层

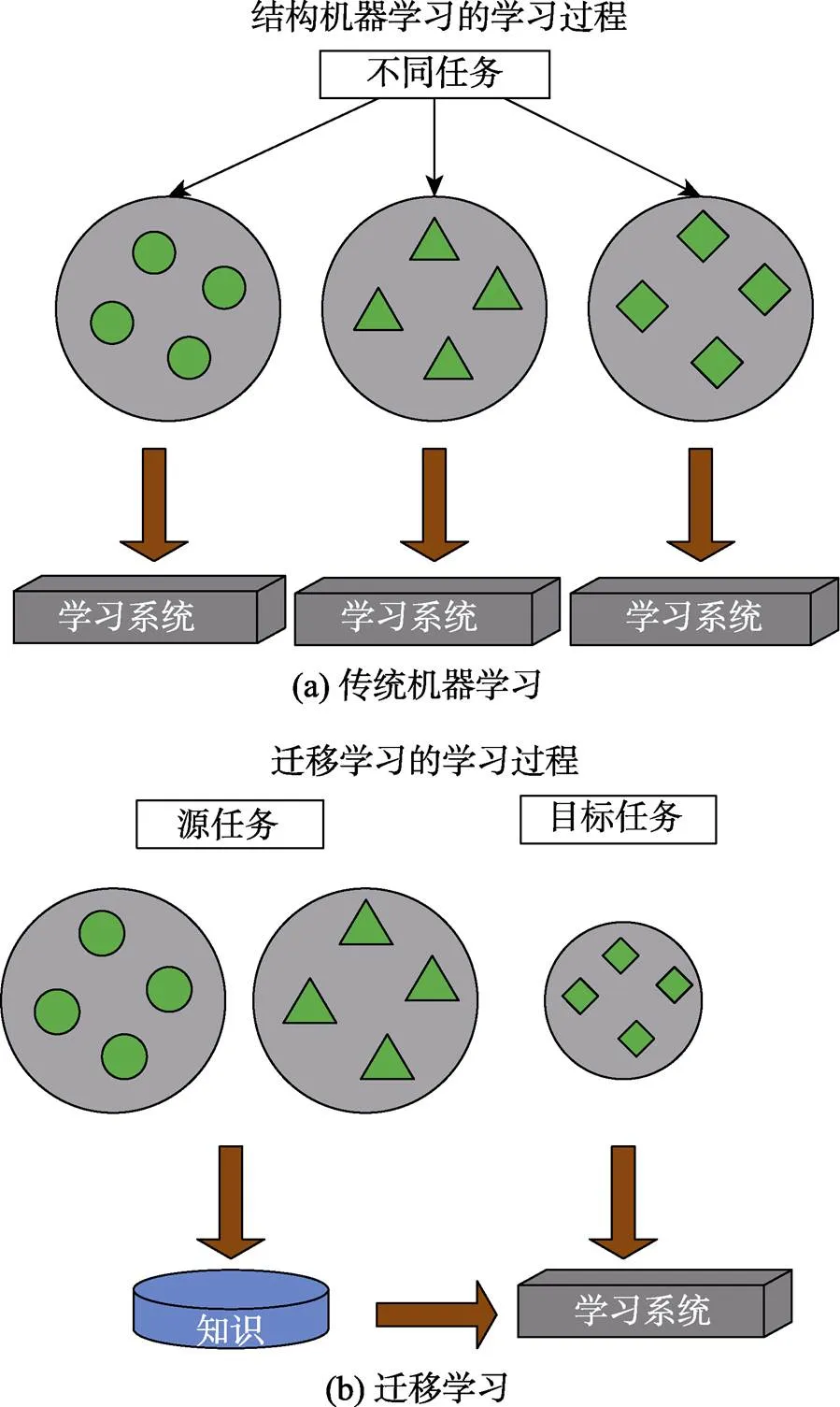

在构建新的神经网络时,需要在原有的目标识别基础上加入对目标位置的检测。而迁移学习[5]的作用就是将深度网络通过训练所学习到的“知识”,从一个作用场景迁移到另一个作用场景,如图1所示。

图1 迁移学习

迁移学习可以调用现有的训练成果,使已经完成的工作成果被重复利用,而不用浪费时间重新训练。当对某类目标只有少量数据集的情况下,以已经训练好的网络为基础进行训练,能够成功完成。最常用的一种迁移学习方式是将原训练模型进行分割,保留基础模型数据,再将模型迁移到新领域。本文构建网络的第一步就是以已经训练好的卷积神经网络为基础,用迁移学习方式来提取用于识别任务的特征层。

1.2 迁移学习基网络

本文选择VGG16网络[6]作为迁移学习的对象。VGG是由AlexNet发展而来的网络,相对于最初的AlexNet,VGG网络选择使用的卷积核尺度及卷积计算步长更小,分别为3×3 的卷积核大小与2像素每次卷积步长。

VGG网络[7]系列的结构包括从11层到19层的不同版本。一般来说,识别效果随着网络深度(层数)的不断加深越来越好,但进行训练的难度及参数数量也越多,尤其在超过19层之后,网络训练会因为梯度难以传递等问题变得无法进行,因此大多选择16或19层的VGG。

2 帧间差分法深度学习识别算法设计

本文采取RPN层提取建议框方法来构建深度神经网络。VGG16[8]卷积生成的特征图中,每一个像素都与原图有着空间上的对应关系,因此在新的网络中可以首先对整个图片用VGG16进行特征提取,这样可以获得一个22×22的特征层,然后再在这张特征图上通过建议框进行划分,而不是直接在原图上进行划分。相较于预先划分好候选框再对框内的内容调整大小进行卷积,新的网络结构只需要使用一次卷积过程,所有建议框内部内容的检测都是以卷积形成的特征层为基础的,大大减少了计算工作量。

2.1 帧间差分法增强候选框

通过RPN生成候选框是针对[9-11]单帧图像进行候选框识别的,但在实际的无人平台中传回来的是一串图片流,通过这些图片的时间先后次序可以提取相关信息帮助进行图像检测。因此,在利用RPN生成候 选框的基础上,可以融入帧间差分法,再次提高系统的性能。

帧间差分法可以在摄像机保持静止不动的情况下提取到合适的候选框,将其作为RPN层候选框的补充增强。

2.2 非极大值抑制算法

将RPN层提取出的anchor前景得分较高的部分送入最后的全连接层进行预测,此时的预测结果往往已经足够精确。但由于选出进行全连接层预测的候选框有300个左右,不能全部作为输出,需要再次对候选框进行筛选。本文引入非极大值抑制(NMS)算法,对同一类识别目标候选框进行筛选,舍去重复的,只保留一个。

NMS算法[13]的输入是RPN层产生的候选框,以及全连接层对这个候选框中的内容在当前这一类识别目标的评分。他们组成了一个5列的数组,前4列是每一个建议框的坐标,第5列则是对该建议框的评分。计算中首先按分数高低对数据进行排列。然后从分数最高的开始,依次计算与之后各候选框的重叠度,如果重叠度大于设定的阈值,就将这个候选框舍去。完成一轮计算后,再在剩下的候选框中选择分数第二高的重复上述过程,并再舍去一些候选框,这样不断进行直到最后,如图2所示。经过非极大值抑制后,就可以通过对候选框的不断过滤直至得到最后输出。

2.3 网络参数训练

为了使网络能够正常工作,需要训练好网络中各部分的参数。在网络的训练过程中,选择PASCAL VOC数据集作为训练集。

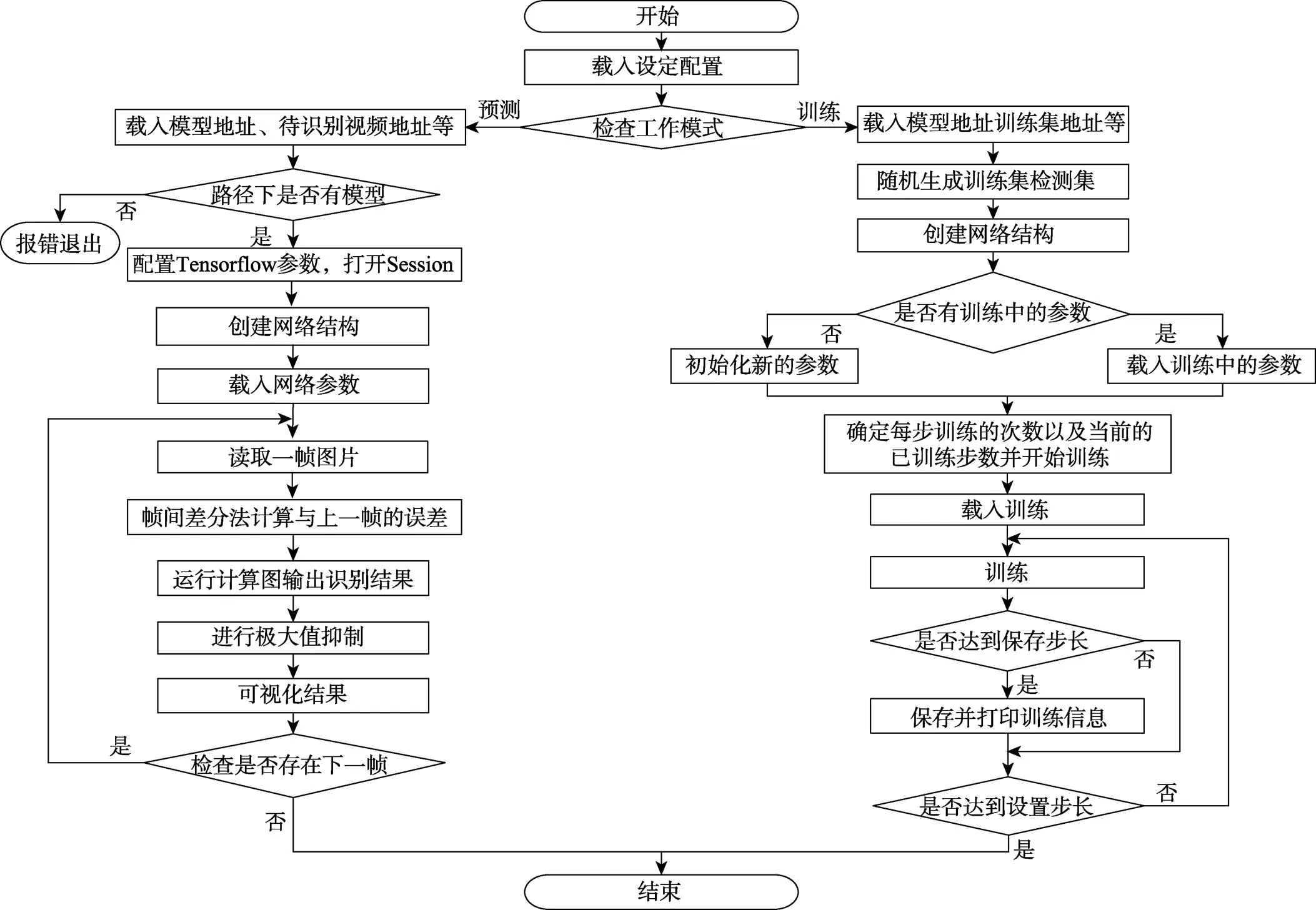

首先提取特征值,将特征值送入RPN层生成各个anchor点的前后景概率以及回归参数,依照这些参数构造候选框,并将候选框对应的值送入FC层产生分类预测及基于此分类预测的第二次回归参数。然后将第二次回归好的候选框进行NMS过滤,产生最终结果。程序流程图如图3所示。

图2 NMS算法流程图

图3 总程序流程图

3 实验结果与分析

本文采用的图像数据来源于公路(见图4—图7),因为这里识别目标较多,且识别目标之间相互存在重叠,可以更好体现算法的性能。对这种复杂的空间交叠识别目标,以往传统的通过harr特征结合SVM检测算法处理起来困难很大,但是通过基于深度学习的目标识别与检测算法,则非常方便。

图4 原图像

图5 图片中汽车的识别结果

图6 图片中人的识别结果

图7 划分区域识别结果

图4为原图像,图5、图6是对图像中汽车和人的识别结果。相较于一般的卷积神经网络,带有区域的RCNN不仅能够检测出图像中目标的位置,而且还能提高最终的识别效果。这是因为在RCNN中进行区域分割,相当于减少了每一个区域的内部干扰。在单独使用卷积神经网络时,如果一个画面中同时出现多种识别目标,就会因为互相影响使最后的识别结果不准确。本文对基于区域的卷积神经网络进行划分后,识别效果如图7所示。

图8是对一幅图像单独使用卷积神经网络的识别结果。可以看出,由于VGG16输出的是整张图的情况,所以对各个种类目标的评分普遍较低。而图7在准确标定目标位置的同时,对各个目标分类的准确率也大幅上升。

图8 单独使用卷积神经网络识别的结果

为了更好地使用帧间信息,使用帧间差分法对Faster RCNN进行补充,帧间差分法的计算结果如图9所示。

图9 帧间差分法对图像的处理结果

帧间差分法很好地提取出了目标的范围。将这样提取到的ROI区域作为RPN层候选框的补充,如图10所示。

图10 补充后的候选框集

其中最后一行为帧间差分法得到的候选框。新产生的候选框将与RPN层产生的原候选框一同被送入全连接层进行检测,增加了候选框的数量,增大了识别目标的可能性。

在摄像头保持静止时,帧间差分法还可帮助确定目标是否运动。将帧间差分法得到的结果与神经网络经过NMS处理后的输出检测框进行重叠度计算,当计算结果达到某一阈值时,即可判定该目标处于运动中,如图11所示。相较于后方停车场中静止的车辆,道路上车辆的运动被检测出来。

图11 加入帧间差分法后获得运动信息

4 结语

本文提出一种基于帧间差分法的深度学习目标识别算法,并采集来自公路上包含复杂信息的视频图像进行了仿真验证。相比于传统的目标识别算法,基于卷积神经网络的深度学习算法能够很好地利用卷积层提取到的特征,对图像中的目标类别进行识别。同时,RPN层产生的候选框还能帮助网络在复杂背景中确定目标位置。而帧间差分法的融入,能够对RPN层产生的候选框进行补充增强,在提高算法识别率的同时,还能识别出目标的运动状态。此外,由于采取了先分割再识别的方式,相比于直接使用卷积网络大大提高了识别的准确率。

[1] 孙晓峰.基于图像识别的智能小车障碍物检测方法研究[D].昆明: 昆明理工大学, 2017.

[2] 胡靖逸, 郭雪亮, 李会军, 等.目标检测算法R-CNN在现实场景数字检测任务中的应用[J].电子技术与软件工程, 2018(24): 90.

[3] 周飞燕, 金林鹏, 董军.卷积神经网络研究综述[J].计算机学报, 2017, 40(6): 1229–1251.

[4] 陈全, 王泽, 贾伟.基于深度卷积神经网络的车标识别研究[J].工业控制计算机, 2018, 31(12): 36–38.

[5] 徐旭东, 马立乾.基于迁移学习和卷积神经网络的控制图识别[J].计算机应用, 2018, 38(增刊2): 290–295.

[6] 陈毅, 黄妙华, 胡胜.基于改进VGG卷积神经网络的前方车辆目标检测[J].数字制造科学, 2018, 16(4): 282–287.

[7] GU J X, WANG Z H, JASON K, et al. Recent advances in convolutional neural networks[J]. Pattern Recognition, 2018(77): 354–377.

[8] DMYTRO M, NIKOLAY S, JIKI M. Systematic evaluation of Convolution Neural Network advances on the ImageNet[J]. Computer Vision and Image Understanding, 2017(161): 11–19.

[9] REN S Q, HE, K M, GIRSHICK R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis & Machine, 2015.

[10] 曹诗雨, 刘跃虎, 李辛昭.基于Fast R-CNN的车辆目标检测[J].中国图象图形学报, 2017, 22(5): 671–677.

[11] 王林, 张鹤鹤. Faster R-CNN模型在车辆检测中的应用[J].计算机应用, 2018, 38(3): 666–670.

[12] 孙挺, 齐迎春, 耿国华.基于帧间差分和背景差分的运动目标检测算法[J].吉林大学学报(工学版), 2016, 46(4): 1325–1329.

[13] 赵文清, 严海, 邵绪强.改进的非极大值抑制算法的目标检测[J].中国图象图形学报, 2018, 23(11): 1676–1685.

Research on simulation of deep learning target recognition based on inter-frame difference method

WANG Hui, YU Lijun, SUN Rong, LIU Chaoda, GAO Tianyu

(College of Automation, Harbin Engineering University, Harbin 150001, China)

Target detection and recognition are an innovative experimental project in digital image processing experiment. Traditional target recognition algorithm can recognize the type of target, but it can’t recognize the location information of the target, and the recognition rate of the same target is low. A deep learning target recognition algorithm based on frame difference method is designed. In the framework of deep learning theory, the frame difference method is applied to the recognition process, the enhanced candidate frame is segmented and the candidate frame is filtered through the NMS algorithm. The simulation results show that the algorithm can’t only recognize the type of the target, but also accurately calibrate the position of the target in the image. It can also judge whether the target is in a moving state and has a high recognition rate.

target detection and recognition; innovative experimental project; inter-frame difference method; deep learning

G642.0

A

1002-4956(2019)12-0178-04

10.16791/j.cnki.sjg.2019.12.042

2019-04-25

黑龙江省教改项目(SJGY20170505,SJGY20170506);哈尔滨工程大学教改项目(JG2018Y06)

王辉(1976—),女,黑龙江肇东,博士,副教授,控制工程(电气工程)实验教学中心副主任,硕士生导师,主要研究方向为模式识别与智能系统、教学研究。E-mail:wangh@hrbeu.edu.cn

于立君(1975—),男,黑龙江安达,博士,副教授,自动化学院副院长(主管实验教学),硕士生导师,主要研究方向为船舶控制、智能控制、教学研究。E-mail:yulijun@hrbeu.edu.cn