地铁站出入通道多摄像机移动目标跟踪研究

2019-06-14赵凌

赵 凌

(铁道警察学院 轨道交通安全保卫系, 郑州 450053)

地铁站视频监控摄像机是地铁交通安全维护的重要手段,公安机关利用视频监控系统可以实现网上巡查、移动目标跟踪抓拍、回放搜索、大客流预警与警力部署等工作。传统的工作流程是先录制视频,再人工调取、分析视频段。该方法对于单一摄像机视域尚可应用,但面对地铁车站多摄像机视域时很可能耗时较多,从而影响后续工作部署。因此,在多摄像机视域下实现移动目标轨迹的自动跟踪对于高效预警、控制可疑人员具有重要意义。

地铁站出入通道是可疑人员进站乘车的必经之路,其间安装的视频监控摄像机具有以下视域特点:① 视域固定;② 出入通道光照亮度均匀;③ 移动目标会在相邻摄像机视域内交替出现;④ 不同摄像机视域可能无重叠,也可能有重叠;⑤ 当多个移动目标同时出现在同一视域中时,可能相互遮挡,跟踪难度加大。据此,多台摄像机交替识别并跟踪同一移动目标的关键是相邻摄像机之间的目标传递。当前的相关研究主要集中在两个方面:无重叠区域和有重叠区域的多视域移动目标跟踪。

在无重叠区域跟踪方面,文献[1]通过提取两个视域下有价值的特征点,设置匹配阈值,从而实现移动目标的传递和跟踪。文献[2-4]以移动目标所在的坐标和进出两个视域边界线的时间差阈值为约束条件,利用图像的空间分块和颜色直方图匹配的方法实现移动目标的传递和跟踪。文献[5-7]利用分层结构的单词树直方图和全局颜色直方图获取前景图像的外观特征,建立支持向量机增量学习在线训练外观特征的外观识别模型,并对该模型进行在线自适应融合实现移动目标的传递和跟踪。文献[8-9]利用累加直方图转换函数对图像的R、G、B分量进行亮度转换,定义了颜色向量距离,在主颜色聚类的基础上提取目标的主颜色直方图,最后通过设置阈值对两个目标的主颜色直方图进行匹配,从而确定传递的目标。

有重叠跟踪方面,文献[10]利用尺度不变特征转换(scale-invariant feature transform,SIFT)算法[11-12]自动提取移动目标特征点,生成视野分界线,通过颜色直方图完成目标传递,利用Mean Shift算法[13-14]完成目标跟踪。文献[15]提出改进的投影不变量目标交换算法,将目标在两个视域内的距离差与设置的阈值进行比较,若小于该阈值的目标只有1个,则完成目标传递;若类似目标有多个则启动直方图匹配算法进行匹配运算,匹配度最好的目标即传递的目标。考虑到地铁站出入通道中移动目标的出现有其随机性,接下来将重点研究无重叠区域相邻两台摄像机的移动目标传递问题[16],这对于多摄像机无重叠区域的移动目标跟踪研究更具普遍意义。

1 地铁站出入通道相邻摄像机监控模型的构建

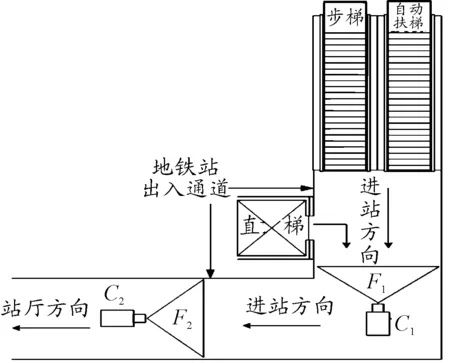

地铁站出入通道是指地铁站的步梯、直梯或自动扶梯与地铁站厅层之间的人行通道。通常情况下,行人会由步梯、自动扶梯或直梯进入地铁站出入通道,之后进入地铁站厅层,凭票进入地铁站台层乘车出行。行人下车后由站台层凭票途经站厅层,再经过地铁站出入通道由步梯、自动扶梯或直梯出站。据此可知,行人乘坐地铁势必经过地铁站出入通道,从而留下个人的移动轨迹,而地铁站出入通道上通常会设置拐角,在拐角的显著位置附近安装有固定视域的视频监控摄像机,这就使得相邻摄像机对同一行人在不同视域内的轨迹跟踪成为可能。本文主要研究行人经过“L形”地铁站出入通道进站乘车的情况。如图1所示,其中,F1、F2为相邻摄像机C1、C2的无重叠区域的视域。

图1 “L形”地铁站出入通道相邻摄像机监控模型示意图

目标传递是多摄像机移动目标跟踪的基础。在图1中,行人要进站乘车,必定按进站方向途经F1后,沿“L形”地铁站出入通道继续前行,之后必将出现在F2中。若C1、C2认定该行人为同一目标,则完成该行人图像在两台相邻摄像机之间的传递。

2 相邻摄像机的目标传递

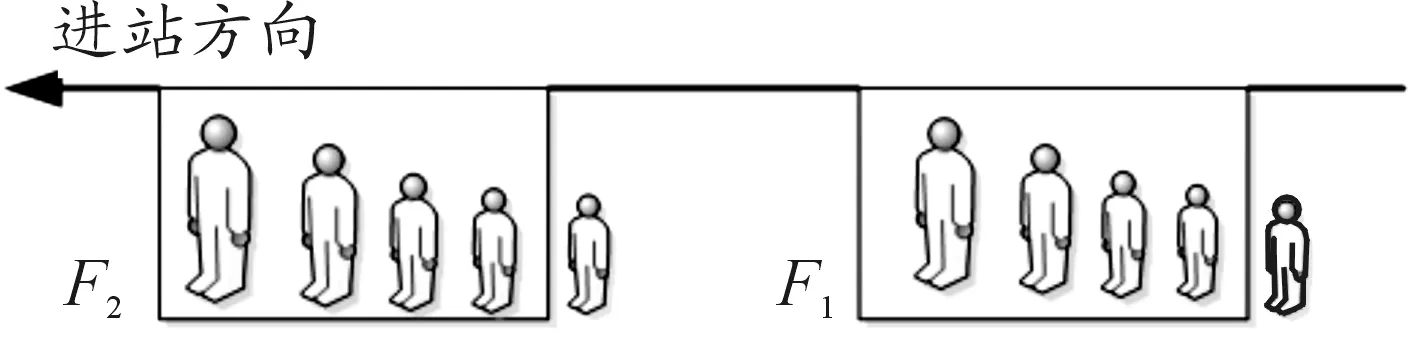

乘车进站时,行人正面出现在地铁站出入通道摄像机中,成像大小为正比例逐渐放大,直到离开摄像机视域,如图2所示。

图2 行人经过视域时成像变化示意图

F1、F2为相邻两台摄像机的有效检测视域,行人沿进站方向移动,成像逐渐变大。当行人进入摄像机视域时,可能会出现两种情况:

情况1行人已经在此前地铁站出入通道的摄像机视域中出现过,如图1中的F2;

情况2行人第1次出现在地铁站出入通道的摄像机视域中,如图1中的F1。

一般情况下,行人在较短时间内途经F1、F2时的外观、行为不会发生较大变化。本文选取行人的移动方向、身高宽度比、行走速度、着装特征作为C1、C2目标传递时的特征匹配要素。

2.1 移动方向的匹配

由于摄像机安装位置、视域范围固定,因此可将摄像机在地面的投影点设为坐标原点C,以通过该点垂直于两侧墙体的直线为横坐标x,以通过该点垂直于横坐标的直线为纵坐标y,建立单有效视域二维平面坐标系,如图3所示。

图3 单有效视域二维坐标系

由图3可知,在单视域环境下,摄像机的有效视域范围为D1、D2与两侧墙体所构成的空间环境。一旦摄像机安装位置确定,可认为在该空间环境对应的地面x、y坐标是确定的,即有效视域范围内的行人脚下的坐标值(x,y)是确定的,且会随着行人的移动不断变化。假设行人在地铁站出入通道行走时,行走路线近似直行,且通常有面向摄像机和反向摄像机两种相对的行走方向。比较行人脚下坐标与坐标原点C(X,Y)之间欧氏距离的变化趋势,欧氏距离减小则判断为面向摄像机方向行走,欧氏距离增大则判断为反向摄像机方向行走。本文只研究跟踪面向摄像机移动的行人,从而排除反向摄像机方向行人的干扰。Ti和Tj分别是同一行人在途径单有效视域下的任意两点,其坐标分别为(xi,yi)和(xj,yj),若两点和原点C(X,Y)之间的欧氏距离为DTij,则:

(1)

那么,当DTij>0时,行人面向摄像机移动;当DTij<0时,行人背向摄像机移动;当DTij=0时,行人没有移动或沿垂直墙面方向移动。

2.2 身高宽度比的匹配

行人正面出现在摄像机视域中,其身高H和体宽W的轮廓数值是比较稳定的。但由于相邻摄像机的参数不同,行人在不同视域中成像放大倍数也不同,H、W的数值会随着行人的移动而不断变化,因此只单独考虑H、W的数值作为目标传递的参数是行不通的[17]。设身高宽度比为η,即行人作为移动整体成像时垂直高度与水平宽度之间的比值:

(2)

显然,η不会因是否被放大而发生变化。当相邻摄像机参数设置均相同时,η可以作为实时采样比较的约束条件。考虑到检测误差和现场客观因素的限制,取行人途径F1、F2的身高宽度比分别为η1和η2,那么两者差值为

Dfη=|η2-η1|

(3)

比较得出最小值,完成身高宽度比的匹配,即:

minDfη

(4)

实际情况下,并不是所有行人在经过F1或F2时都正对摄像机,在经过视域两侧时η值偏小,而正对着摄像机的η值接近真实值,因此同一行人在不同视域下η值可能相差较大。若单独以η值作为目标传递的特征进行匹配可能无法完成目标传递,因此本文引入行走速度匹配。

2.3 行走速度的匹配

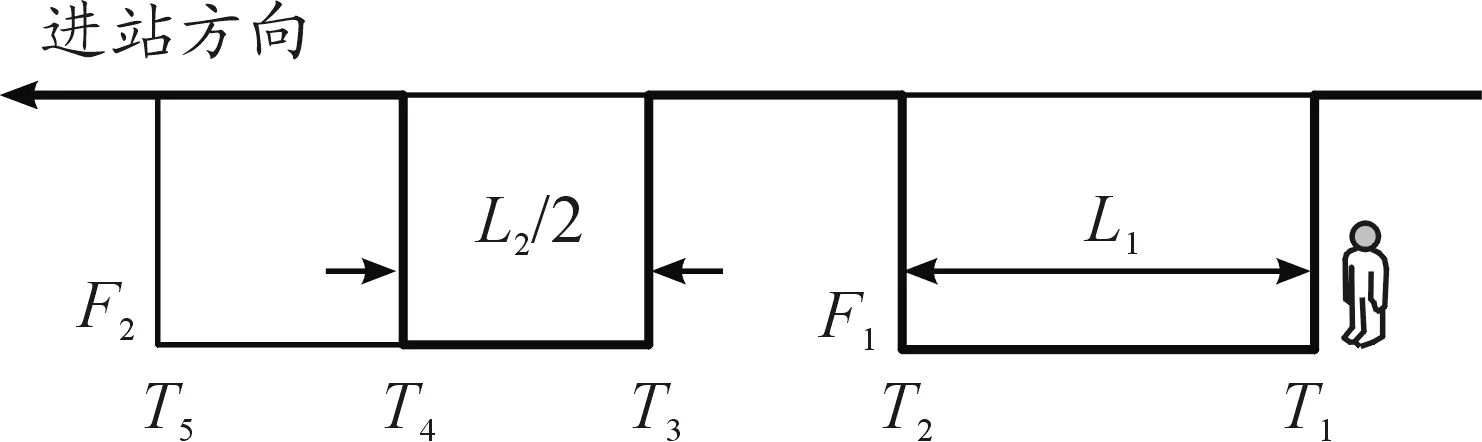

通常情况下,受摄像机安装位置和有效视域范围的限制,行人在地铁站出入通道单摄像机中出现的时间一般在10 s以内,行走速度相对稳定,这就为行走速度特征匹配创造了条件[18]。假设行人进入和离开F1的时间点分别为T1和T2,F1的有效长度为L1,如图4所示。

图4 行走速度检测示意图

行人经过F1的平均行走速度为

(5)

在途经F2时,利用同样的方法可测算出行人经过L2/2时的平均行走速度为

(6)

行人在途经F2的T4与T5之间的后L2/2期间,通过计算相继进入F1、F2的不同行人v2与v1的绝对差值:

Dfv=|v2-v1|

(7)

比较得出最小值,完成行人速度匹配,即:

minDfv

(8)

2.4 空间颜色直方图的匹配

2.4.1空间位置选择

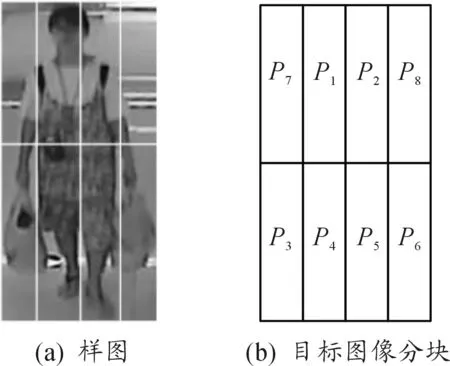

颜色直方图只包含图像中颜色值出现的频数,缺乏像素的空间位置信息,致使目标传递所需的特征匹配因素缺乏有针对性的比较对象[19]。为进一步提高目标匹配的准确性,以行人着装特征为研究对象,同时兼顾行人提、拉箱包的情况,本文采用空间颜色二维直方图匹配方法,先将行人图像分割成2×4的方块组合,然后统计每块区域内的颜色直方图,从而获取该图像的空间颜色二维直方图,如图5(a)所示。由图5(b)可知:行人整体所在的主要块区分布在P1、P2、P3、P4、P5、P6块区,考虑到人体着装颜色稳定性特点,根据经验可以增加P1、P2块区和P4、P5块区的权重来提高图像匹配的准确度。

图5 空间位置选择实例

2.4.2直方图匹配

为尽可能避免非理想状态下产生的噪声影响,基于单摄像机目标跟踪时,先对要跟踪的行人随机抽取n-1帧m级目标图像直方图作为比较样本,记为:

sij=aij

(9)

其中i=1,…,n,j=1,…,m。那么最新一帧的直方图与样本直方图的差的绝对值记为

Distn=|anj-aij|

(10)

当Disti小于某个阈值时,记为Threshold,对Disti进行累加操作,记为

(11)

当Sum值小于等于某一个经验值(本文设Sum值为2)时,完成目标匹配。

3 仿真实验与分析

3.1 算法设计

本文首先利用ViBe算法[20-21]建立移动目标背景检测模型,当有行人出现时,即可建立移动目标模板,通过提取行人的移动方向、身高宽度、行走速度、空间颜色直方图等特征信息构建行人的样本集合。当满足图像匹配条件时,即可认为实现了移动目标在无重叠区域的相邻两台摄像机视域下的轨迹跟踪。算法具体流程如图6所示。

图6 算法流程

3.2 实验结果及分析

通常情况下,行人按照图1的“进站方向”进站乘车。本文以国内某城市真实地铁站出入通道视频监控图像为背景,构建由2台相邻摄像机组成的无重叠区域的实验现场,对移动行人进行跟踪,并建立特征跟踪模板,如图7所示。

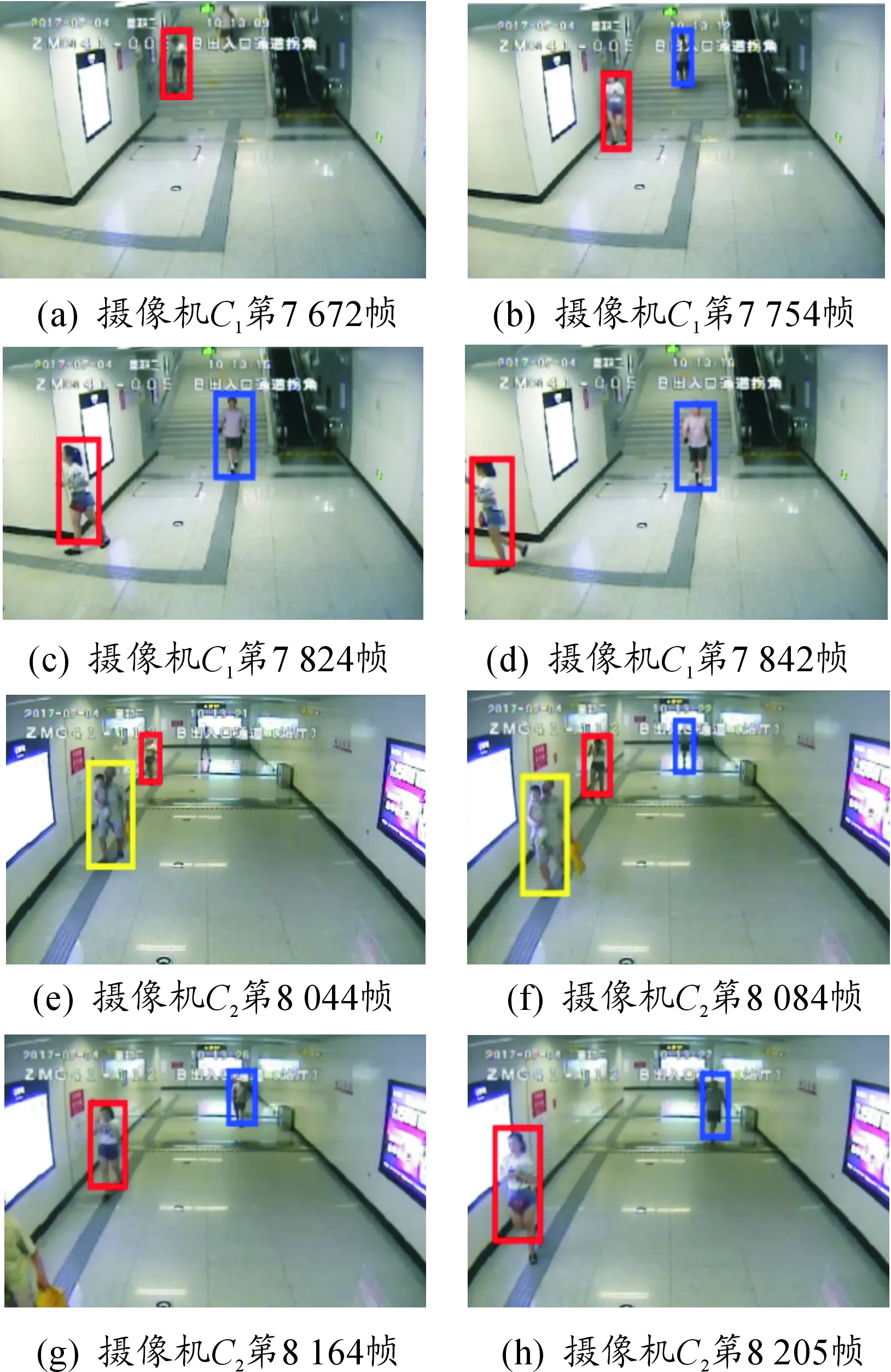

图8是2台摄像机对行人目标交接的结果。图8(a)在C1的第7 672帧图像中检测到目标1,用红色方框跟踪标识。图8(e)在C2的第8 044帧图像中检测到目标1,该目标是C2中第2个目标。图8(b)在C1的第7 754帧图像中检测到目标2,用蓝色方框跟踪标识;图8(f)在C2的第8 084帧图像中检测到目标2,该目标是C2中第3个目标。由图8(c)(d)(g)(h)可以看出:C1和C2实现了对目标1、2的跟踪和传递。

图7 地铁站出入通道无重叠区域的相邻2台摄像机检测视域

图8 两个行人在相邻摄像机视域实现目标传递

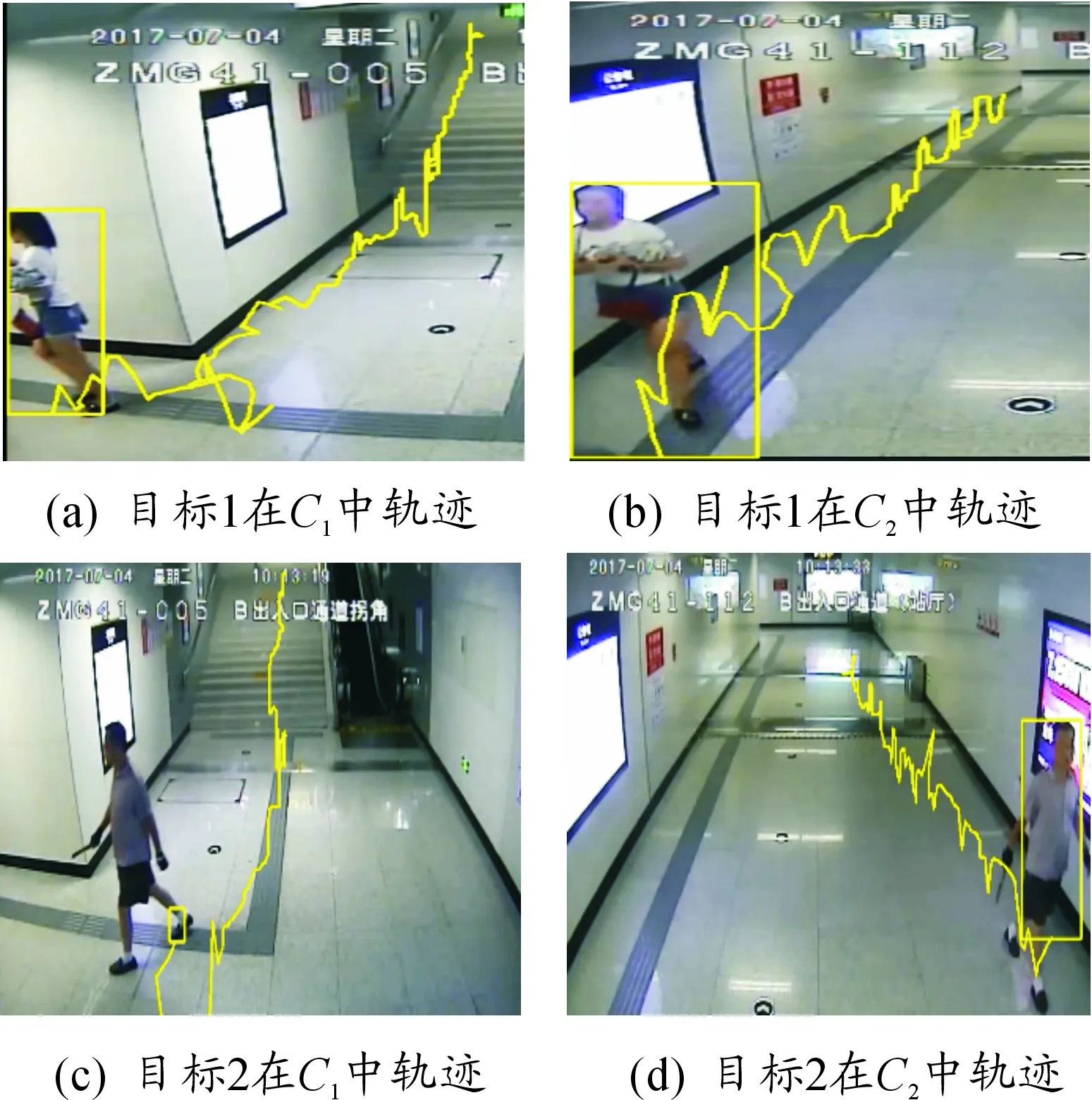

为进一步明确移动目标在地铁站通道内的活动轨迹,图9(a)(b)给出了目标1在摄像机C1和摄像机C2中的移动轨迹,图9(c)(d)给出了目标2在摄像机C1和C2中的移动轨迹。由此可知,在本文提出算法背景下,均可获取任何进出地铁站行人的移动轨迹图,从而实现对其移动规律、乘车习惯等方面的跟踪监控。

图9 移动目标在C1和C2之间实现轨迹跟踪

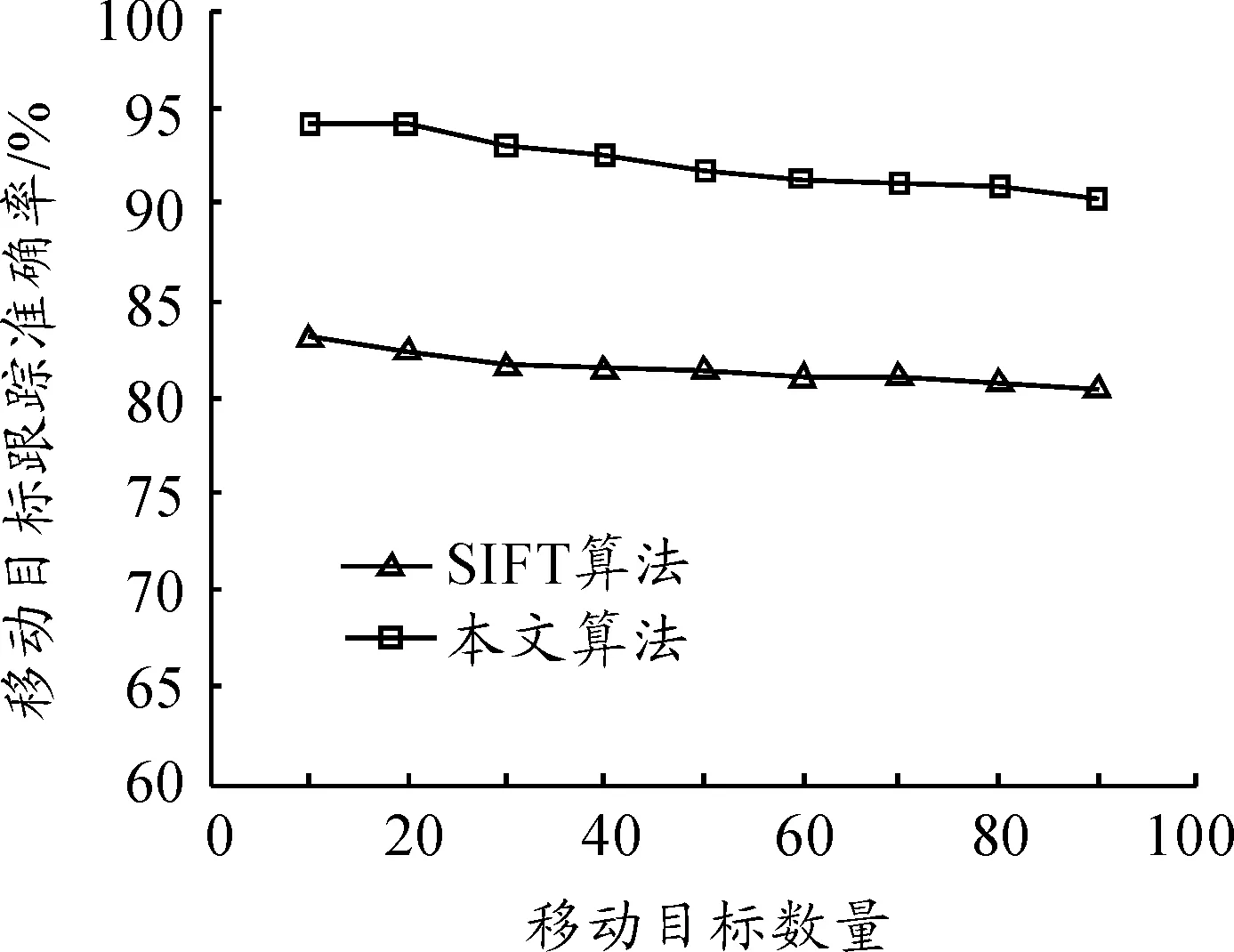

由于SIFT算法对移动目标的尺度缩放、旋转、亮度变化保持不变性,同时对视角变化、仿射变换、噪声也保持一定程度的稳定性,为进一步检验本文算法对移动目标的跟踪成效,以SIFT算法在单一摄像机视域内对移动目标的跟踪成效为比较对象,给出了行人数量由10增至90时,本文算法与SIFT算法对移动目标跟踪时的准确率变化情况,见图10。由此可知,本文提出的算法对移动目标跟踪的准确率明显高于单一摄像机直接使用SIFT算法的目标跟踪效果。同时不难发现,随着移动目标数量的增多,移动目标之间相互遮挡现象明显增多,跟踪难度加大,2种算法的跟踪准确率均呈下降趋势。

图10 本文算法与单摄像机直接使用SIFT算法时跟踪移动目标的效果比较

4 结束语

本文分析了地铁站出入通道视频监控摄像机的视域特点,以行人经过相邻2台摄像机为例,将其移动方向、身高宽度比、行走速度、着装特征作为匹配要素,有效实现了对同一移动目标的轨迹跟踪,对地铁站内多摄像机自动跟踪可疑人员及其行为具有借鉴意义。但随着地铁站出入通道行人数量的增加,多摄像机协调跟踪移动目标的难度进一步加大,解决该问题成为下一步研究的工作重点。