FCW系统目标检测距离精度测试与研究

2018-10-22张仪栋游国平牛成勇

曾 杰, 王 戡, 张仪栋, 游国平, 牛成勇

(1.重庆车辆检测研究院 国家客车质量监督检验中心, 重庆 401122; 2.汽车主动安全测试技术重庆市工业和信息化重点实验室, 重庆 401122)

先进驾驶辅助系统(ADAS)在车辆上的大量应用,可有效减少道路交通事故[1]。前向碰撞报警(FCW)系统主要通过对道路前方的目标车辆进行检测,计算出相应的碰撞危险等级,采用碰撞时间(TTC)判断警告时机,并通过视觉、声音、触觉等方式警告驾驶员进行避碰操作[2-4]。通常,FCW系统发出碰撞预警的时间TTC的阈值是根据自车车速和前方目标车辆的运动状态综合确定,因此目标检测距离的精度对预警时间的准确性和稳定性影响较大。现阶段的营运客车FCW系统执行标准为JT/T 883-2014[5],该标准中对报警距离精度的要求应不大于5%或1 m,而ISO 15623:2002和GB/T 33577-2017中对报警距离精度的要求却都为不大于15%或2 m[6]。大量测试发现,基于视觉的FCW系统大多数都满足JT/T 883-2014中的报警TTC的要求,而不满足报警距离精度的要求;基于雷达的FCW系统大多数都能满足JT/T 883-2014中的报警TTC和报警距离精度的要求。因此,对基于视觉的FCW系统的目标检测距离精度进行深度测试和研究,为基于视觉的FCW系统研发及相关标准的制定和修订提供参考。本文采用不同的测试车速、测试距离和减速度,针对分别使用视觉和视觉与毫米波雷达融合的FCW系统探测距离精度进行深度测试,测试场景为CCRs 、CCRm、 CCRb 3种,以研究不同传感器类型的目标检测距离精度在FCW系统中的应用情况。

1 基于视觉FCW系统测距原理

视觉系统相较于毫米波雷达成本更低、近距识别率高、能分辨目标与车道线的相对位置,但是环境适应性较差、算法复杂、识别效率低[7-8]。常见的视觉FCW系统主要依靠单目视觉系统进行目标检测,主要采用基于机器学习、深度学习、图像特征等算法进行目标检测[9]。常见的视觉测距方法如下。

1.1 车辆底部阴影远近测距

如图1(a)所示,该方法首先通过对图像进行处理,获得车辆底部阴影在道路上的位置,随后以该阴影还原车辆的宽度信息,最后通过大量标定试验拟合出一条非线性的测距曲线[10]。该曲线的变量为车辆底部阴影的y坐标,输出为车距信息。

1.2 目标像素大小测距

如图1(b)所示,目标车辆的像素轮廓大小随车距的增大而减小,车距与车辆目标区域像素尺寸呈现出多项式的关系。通常通过拟合车辆目标区域像素尺寸、面积与车距的多项式曲线,从而获得一条测距曲线实现测距[11-12]。

(a) 基于底部阴影测距

(b) 基于像素大小测距

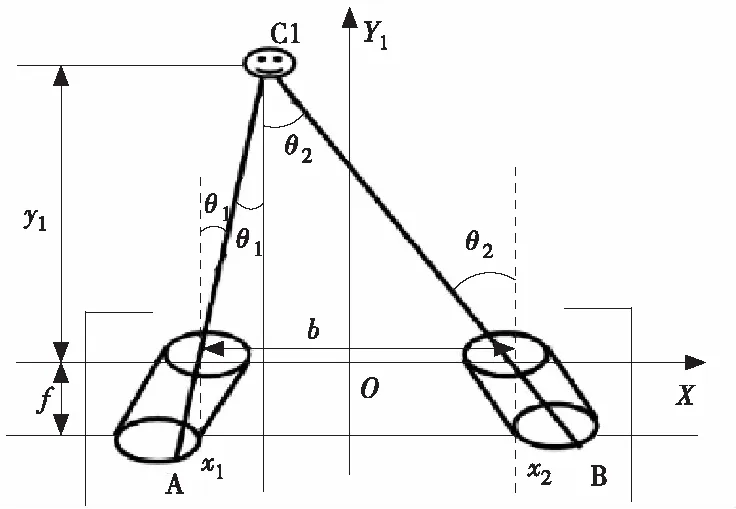

1.3 双目摄像头测距

双目摄像头目标测距方法,主要是利用2个独立的摄像机进行障碍物定位,模拟人眼视觉测距的原理。基于双 CCD 立体摄像头的障碍物定位原理可以简化为如图2所示的平面模型[13],探测距离y1可以通过相似三角函数关系解算。该方案的测距精度与相机的性能、目标距离、相机间距等因素有关,因此合理选择主要参数,对精度影响较大。目前大多数量产车规级的视觉测距主要是采用单目视觉方案,基于多种测距算法组合的方式进行,以有效保障测距精度。

图2 双目视觉测距原理示意图

2 FCW系统在固定场景报警时间

为保证在各个测试场景中试验车辆的车速、车距、减速度满足测试条件要求,采用英国ABD驾驶机器人、前后车协调通信系统、高精度GPS定位基站等试验设备,并选择构建CCRs 、CCRm、 CCRb 3种场景所需要的较长直线试验道路。

2.1 FCW系统预警时间现状

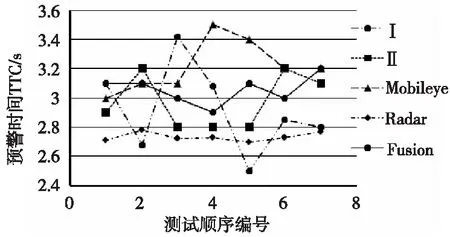

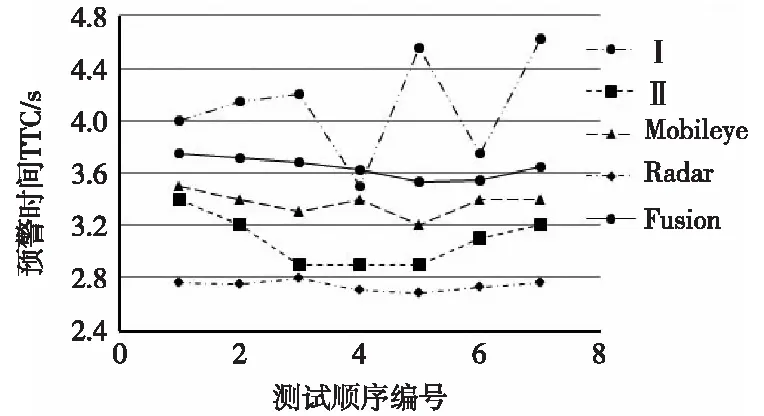

笔者在FCW系统测试方面开展了大量工作,积累了较多的试验数据,选取了Mobileye、某型单目视觉系统Ⅰ和Ⅱ、雷达与单目视觉融合等5种方案。根据JT/T 883-2014中的试验方法和性能评价指标对FCW系统测试结果进行评价,被测试的各型FCW系统都能达到标准规定的报警TTC指标。Mobileye在3种测试场景下的标准差均比单一雷达的方案大,报警TTC数据的稳定性相对较差,而雷达与视觉的融合方案的数据稳定性整体比Mobileye更好,但仍然比单一雷达方案差。Mobileye的报警TTC数据稳定性均比某型单目视觉系统Ⅰ和Ⅱ好,但单一雷达系统报警时间的安全裕度均设计更低,更接近报警TTC时间要求的临界值,对比结果如图3和图4所示。

2.2 测试数据分析

本文在试验数据的处理中,使用误差的标准差用以评价误差精度的数据离散程度,以误差的平均值评价误差的大小。

试验数据中,根据设备的CAN报文进行解析,选取对应时刻的数据点进行采样,数据点的数量随相对车速增大而减少。本文分别对基于单目视觉和基于单目视觉与毫米波雷达信息融合的FCW系统进行了测试,基于视觉的最大探测距离未限定,而基于雷达与视觉融合系统的距离报文限定在90 m的范围之内。

2.2.1 基于视觉的FCW系统测试分析

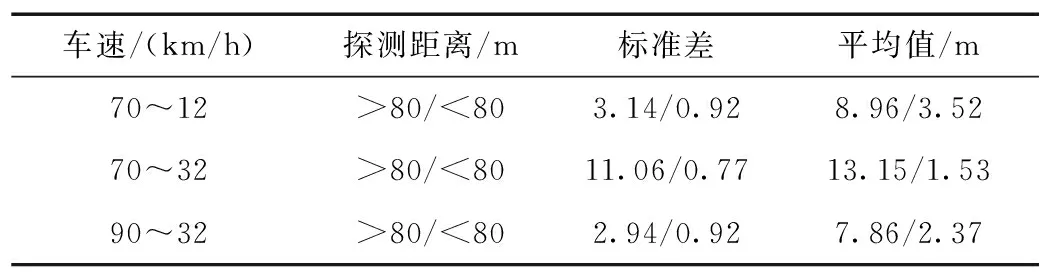

CCRs前车静止场景的测试结果见表1,在探测距离大于80 m时,距离误差的标准差和误差平均值比探测距离小于80 m的范围大。随着试验车速增加,相对速度变大,距离误差的标准差和误差平均值都逐渐增大。低速时误差的标准差较高速时小,测距较为稳定。

CCRm前车慢行场景的测试结果见表2,探测距离大于80 m时,探测距离精度较低,误差标准差较大,测距稳定性较差。在小于80 m的区间内,探测距离精度和稳定性随着相对车速的增大而降低。

a) CCRs场景

b) CCRm场景

c) CCRb场景

图4 预警时间标准差对比

车速/(km/h)探测距离/m标准差平均值/m50>80/<801.49/1.414.83/2.7260>90/<902.03/1.013.56/2.7970>80/<802.49/1.8210.52/4.3280>80/<802.48/2.016.67/5.69

表2 CCRm测试结果对比

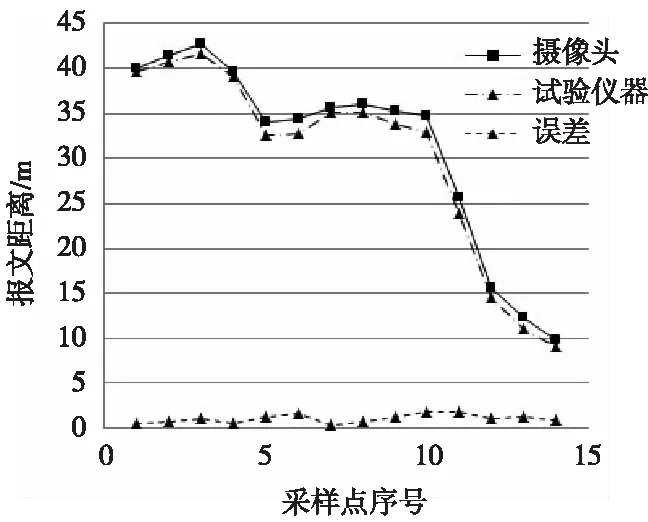

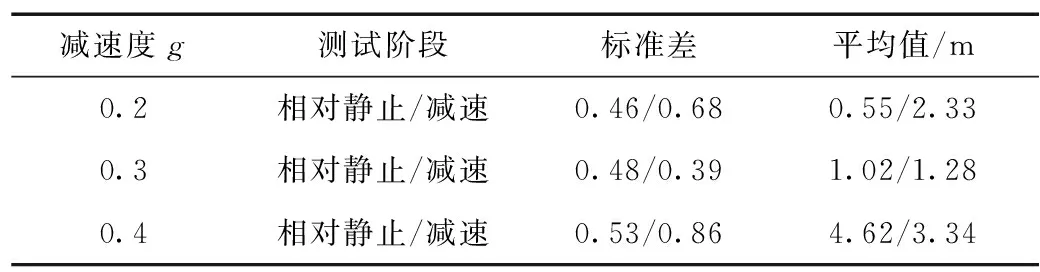

CCRb前车制动场景的测试结果见表3,图5为0.3g的前车减速度场景。在车辆相互进入稳定的相对距离并保持相同车速时,相当于车辆静止时对前方车辆检测,此时相对运动状态保持稳定,测距精度较高。当前方车辆突然以固定的减速度进行持续减速时,相对车速逐渐加大,测距精度降低。同时,随着前方车辆减速度增大而测距精度降低,并且测距的稳定性也降低。

图5 CCRb前车减速度0.3g测试结果

减速度g测试阶段标准差平均值/m0.2相对静止/减速0.46/0.680.55/2.330.3相对静止/减速0.48/0.391.02/1.280.4相对静止/减速0.53/0.864.62/3.34

2.2.2 基于雷达与视觉融合的FCW系统测试分析

雷达+摄像头信息融合系统的测试结果见表4。在CCRs前车静止场景下,车速小于60 km/h时,远距探测距离精度较车速大于60 km/h工况差;在60~20 m区间内的距离探测精度较其他区间更高,探测距离数据稳定性更好。

表4 CCRs测试结果

雷达与视觉融合的FCW系统CCRm前车慢行场景的测试结果见表5。在探测距离大于60 m时,12 km/h与32 km/h的车辆移动相比,12 km/h 的前车移动速度探测距离精度更高。在探测距离小于60 m时,12 km/h与32 km/h的前车移动速度的探测距离精度误差不大。

表5 CCRm测试结果

雷达与视觉融合的FCW系统CCRb前车制动场景的测试结果见表6。图6为0.3g的前车减速度场景。在车辆相互进入稳定的相对距离并保持相同车速时,在减速前的阶段探测距离精度水平与摄像头处于相同水平。当前方车辆突然以固定的减速度进行持续减速时,减速度的大小对测距精度影响作用不大。

图6 CCRb-减速度0.3g测试结果

减速度g测试阶段标准差平均值/m0.2相对静止/减速0.53/0.141.26/0.220.3相对静止/减速0.41/0.310.92/0.520.4相对静止/减速0.33/0.240.43/0.27

2.3 两种FCW系统对比分析

对比分析上面两种FCW系统的试验结果可知,在90 m 的目标测距范围内,雷达与视觉信息融合FCW系统的目标检测距离精度,在各个工况下的性能都优于单目摄像头的FCW系统,并且融合系统更倾向于采用雷达的目标检测距离,从而使得测距精度较高,测距精度的波动也更小。基于雷达与视觉融合的FCW系统,应着重优化两种传感器信息融合的构架,取长补短,远距目标测距的权重应更倾向于雷达;而小于90 m内,应合理分配权重和融合构架,减少数据延迟造成测距误差的影响。

3 结束语

现阶段的FCW系统预警能力都能满足相关标准要求,但预警时间重复性不高。基于视觉的FCW系统目标距离检测精度对相对车速、前车减速度、相对距离较为敏感,主要受测距算法、数据计算延时影响,从而造成测距精度较差。基于视觉与雷达信息融合的FCW系统目标距离检测精度表现与毫米波雷达性能相似,但应优化雷达于视觉信息融合构架,以降低前车减速工况下由于数据处理延迟造成的误差。