基于无人机可见光图像Haar-like特征的水稻病害白穂识别

2018-10-19褚桂坤张宏建刘双喜黄信诚高发瑞张春庆王金星

王 震,褚桂坤,张宏建,刘双喜,黄信诚,高发瑞,张春庆,王金星

基于无人机可见光图像Haar-like特征的水稻病害白穂识别

王 震1,2,褚桂坤1,张宏建1,刘双喜1,2,黄信诚3,高发瑞3,张春庆4,王金星1,2※

(1. 山东农业大学机械与电子工程学院,泰安 271018;2. 山东省园艺机械与装备重点实验室,泰安 271018;3. 济宁市农业科学研究院,济宁 273013;4. 山东农业大学农学院,泰安 271018)

实现稻田精准植保的关键是自然环境下病变区域的准确识别。为实现大面积稻田中白穗的精确识别,该文提出一种小型多旋翼无人机水稻病害白穂识别系统,该系统以无人机平台作为图像采集、处理和识别的基础,首先对白穗图像提取Haar-like特征,其次以Adaboost 算法进行白穗训练识别。以4类Haar-like特征及其组合构建弱分类器,用采集的稻田白穗和背景共700个样本点训练生成强分类器。所得强分类器对测试集中65幅图像中的423个白穗样本点进行识别验证,结果表明:白穗识别率可达93.62%,误识别率为5.44%,该方法可有效抑制一般的稻叶遮挡、稻穗黏连以及光照等复杂背景的影响,适合于自然环境下的稻田白穗现场识别。

无人机;算法;病害;水稻白穗;Haar-like 特征

0 引 言

白穂是稻田中常见的一种影响稻米产量和品质的病虫害特征,严重时可造成稻田大面积减产,严重地区白穂率可达50%[1],在白穂形成早期对稻田进行病虫害防治是预防白穂大面积发生的最佳时期。目前稻田白穂的识别还是以人工肉眼观察为主,且白穂早期的呈现往往具有局簇性[2]。在大面积稻田种植中,人工观测法很难准确全面的识别到早期形成的白穂。小型多旋翼无人机是近几年迅速发展起来的农情观测手段,尤其适用于田间环境不易于人工进入的农田区域。

白穂发生早期的识别,关键是对白穂和正常稻穗的准确区分、识别以及白穂发生位置的定位。在农田环境中,目标识别一般基于颜色或者形态特征等算法进行。目标识别的颜色空间主要有RGB、HSI和La*b*;形态特征识别主要采用支持向量机(SVM)、神经网络算法、遗传模糊神经网络算法等模式识别方法[3-7]。颜色模型方面,谢忠红等[8]提出了一种基于改进圆形随机 Hough 变换的快速类圆果实目标检测方法;蔡建荣等[9]应用球体HSI颜色系统描述成熟西红柿的颜色,利用Otsu算法自动获取分割阈值,提取目标区域,分割效果显著;詹文田等[10]利用颜色空间多个通道构建不同的弱分类器,再通过样本训练得到一个强分类器,对田间猕猴桃进行识别,识别率高达96.7%。模式识别方面,宋怀波等[11]利用-means聚类算法将果树图像分为树叶、枝条和果实3个类别,然后利用形态学方法对果实目标进行处理,得到目标边缘并进行轮廓跟踪,有效识别到遮挡的苹果,平均定位误差为4.28%;李昕等[12]提出的人工免疫网络识别的多特征融合识别方法,利用偏好免疫算法进行多特征有效融合,使油茶果的识别率达到了93.9%;赵源深等[13]提出了一种基于非颜色编码的西红柿识别算法,使成熟西红柿的识别率达到了93.3%。在稻穗识别方面,刘占宇等[14]提出了一种基于学习矢量量化神经网络的水稻白穗和正常穗的高光谱识别方法,在稻穗离体识别试验中,识别精度可达100%;刘占宇等[15]还通过测定稻穗室内高光谱反射率,对稻穗的健康状态进行了分类,分类精度也达到了理想效果,但该方法不适于稻田实时识别;白晓东[16]提出了一种基于稻穗颜色特征检测、梯度直方图检测以及卷积神经网络提升的水稻抽穗期自动检测方法,该方法可在稻田中识别出新生稻穗,满足农气观测需要,对于病害稻穗未做相关研究。

综上所述,从农田目标识别的研究来看,不管是基于颜色特征,还是形态特征的农田目标识别算法,都得到了较高的目标识别率,但是各算法之间也存在着特征能力描述和识别速度之间互斥矛盾的不足之处[17-18]。从识别手段来看,多数目标识别可做到无损识别,图像采集多以地面随机多点方式采集,图像质量较高却难以覆盖大面积农田目标,高光谱采集虽可进行大面积信息获取,却难以满足高精度识别要求,存在识别覆盖度与识别精度之间的矛盾。

为平衡农田目标识别过程中,特征描述能力与识别速度之间、识别覆盖度与识别精度之间的矛盾,本文提出一种利用小型多旋翼无人机机载高分辨率相机采集稻田图像,基于Haar-like特征和AdaBoost学习算法[19-20]的稻田白穂识别方法,并通过试验研究Haar-like特征描述能力与AdaBoost学习过程中训练次数对识别算法性能的影响,以期达到快速准确识别稻田白穂的效果。迄今为止,尚未看到有关利用小型多旋翼无人机图像进行水稻白穂识别的研究报道,本文提出的基于小型多旋翼无人机图像和Haar-like特征的稻田水稻白穂识别,将为稻田无人机精准施药提供参考。

1 材料与方法

1.1 白穂样本图像获取

采集山东省济宁市陈庄农林科技试验站“圣稻19”水稻齐穗期至成熟期图像供试。2015年至2017年期间,每年8月-10月采集稻田白穂图像建立试验样本图像库。以多旋翼无人机SPREADING WINGS S900平台(如图1所示)为采集设备,设备具体参数见表1。

1.多旋翼无人机 2.相机云台 3.工业CDD数字相机4.GPS和指南针

表1 试验设备参数

稻田图像采用对无人机航拍视频流进行帧提取的方式进行采集。首先利用小型多旋翼无人机沿预定航线进行视频拍摄,然后通过各项参数计算提取图像的间隔帧数,最后通过premiere软件提取有效图像。提取到的有效图像按照时序拼接处理可还原出整个稻田图像[21],进而建立试验样本库,进行白穗识别,实现无人机大面积稻田白穗的识别。另外,多旋翼无人机自带GPS定位导航系统,如图1所示,从而可获得无人机航拍时的坐标,计算可得提取样本的位置信息,从而定位白穗的具体位置。稻田图像提取计算公式如下

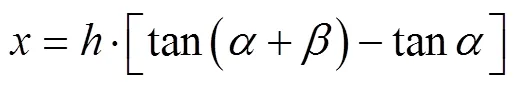

式中为单帧图像实际拍摄宽度,m;为相机盲区视角,(°);为相机视角,(°);为无人机航拍水平飞行速度,m/s;为无人机距作物冠层垂直高度,m;为帧提取时间,s;0为航拍视频流速率,帧/s;为2张有效图像之间帧图像数。视频流采集示意图如图2所示。

注:α为相机盲区视角,(°);β为相机视角,(°);v为无人机飞行速度,m·s-1。

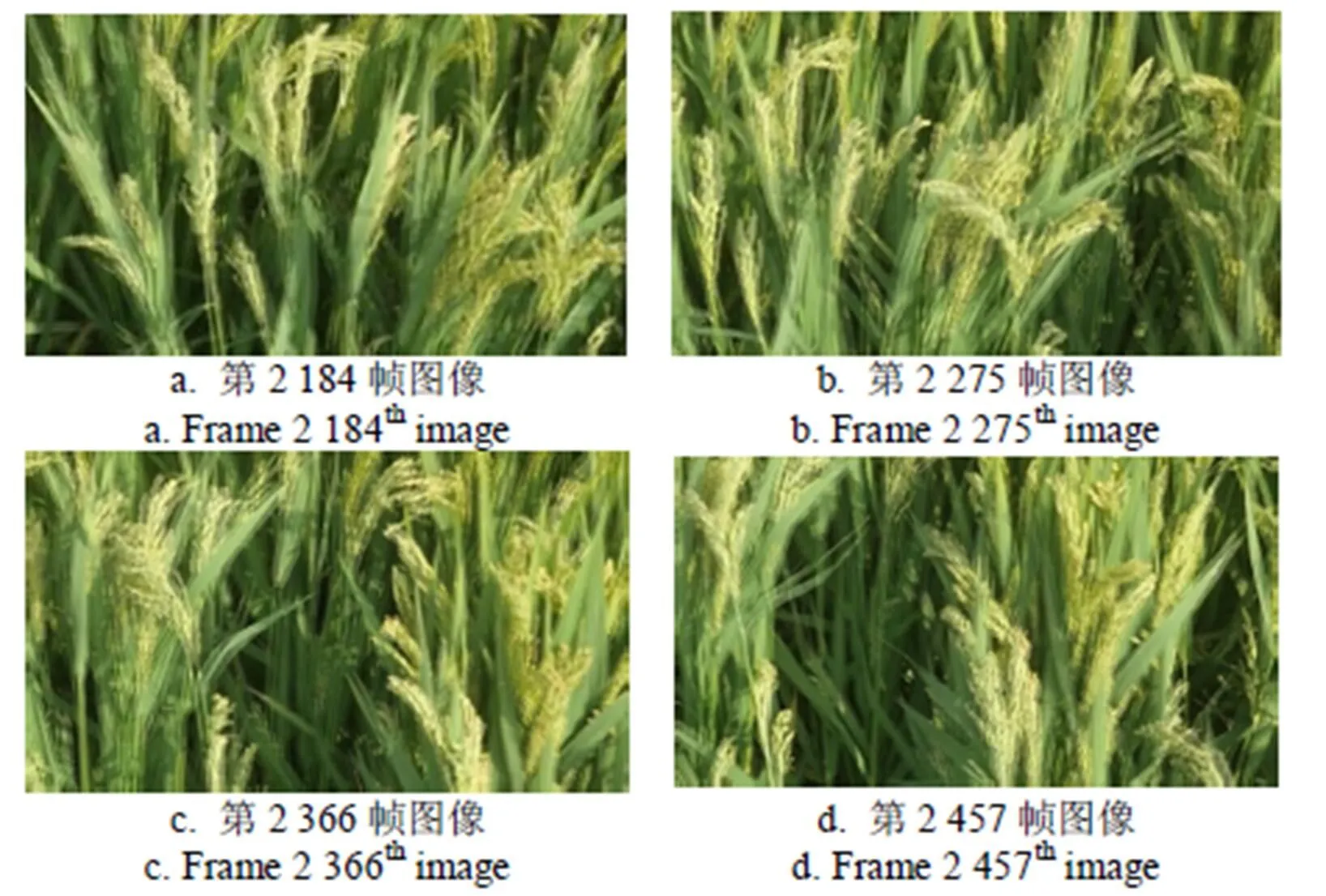

采样过程中,设定无人机航拍视频流速率0=25帧/s,无人机飞行速度=1 m/s,航拍飞行高度=1.5 m,相机视角=54°,视频格式为MPEG-4,为规避无人机旋翼下旋气流影响拍摄效果,拍摄过程中利用云台遥控器固定相机中轴线与地面垂直夹角为45°进行拍摄,即+0.5=45°,故=18°。以上数据带入式(1)~式(3)计算可知,单帧图像实际拍摄宽度=3.64 m,帧提取时间=3.64 s。所以每隔3.64×25=91帧图像提取一帧作为试验样本图像。图3为视频流拆解的帧图像,图3为按照91帧间隔规则提取的第2 184、2 275、2 366、2 457帧图像;图4为图3中4帧提取图像的拼接效果图,图像方向为无人机行进方向。因无人机风力和扰动影响,拼接图像存在一定的误差,但对于单幅提取的帧图像进行算法处理没有太大影响。由航拍飞行高度=1.5 m,相机视角=54°,可计算出相机视角至地面的中垂线距离为1.5 m/cos45°=2.12 m,进而可计算相机视角幅宽为2.12 m×tan27°×2=2.16 m,再由无人机飞行速度=1 m/s可知,无人机每小时可进行识别作业面积为2.12 m× 1 m/s×3 600 s=7 632 m2,发挥了无人机大面积作业的快速、高效优势。

图3 视频流拆解的帧提取图像

图4 图3中4帧提取图像的拼接图像

利用多旋翼无人机进行稻田白穗图像采集,较传统人工采集和田间固定设备采集而言,具有效率高、采集图像连续、应用面积大等特点。图像包含位置信息,可对目标进行精确定位,是无人机采集图像与传统方式采集图像的最大区别和优势。因用于白穗识别的图像是由固定帧间隔提取而来,且图像中含有位置坐标信息,使得本文提出的算法可有效的检测和定位大田中的白穗。虽然利用Haar-like特征提取和AdaBoost学习算法进行目标识别已成熟应用于较多领域,但基于位置信息和大田作业来说,本文提出的算法只适用于小型多旋翼无人机获取的视频流信息。无人机采集的稻田原始图像需要进行压缩、切割、归一化、背景分离、阈值分割、去除噪声等预处理操作后用于Haar-like特征提取和AdaBoost学习算法,最终进行白穗识别。

1.2 白穂图像

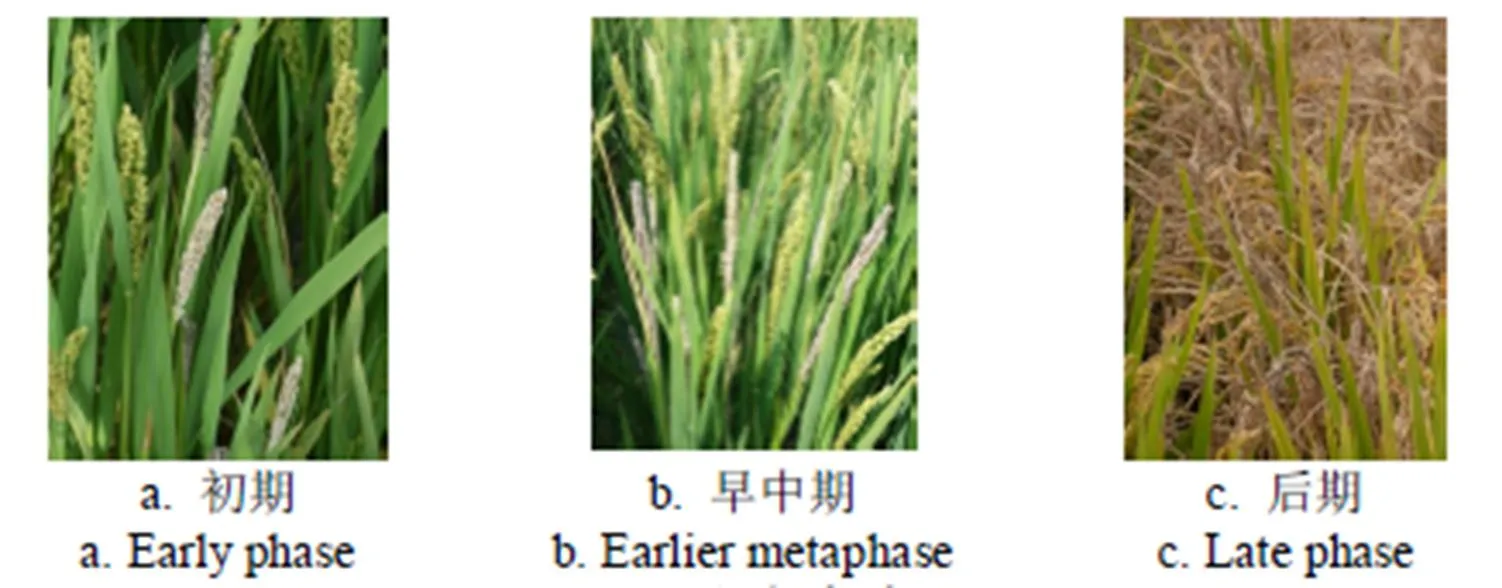

稻田白穗的发生由多种病害或者虫害引起,病虫害发生之初一般危害单株或少量几株水稻,并具有传播性。随着寄主植株危害程度加深,养分枯竭,转移至临近植株进行危害并繁衍,若未进行防治可造成大面积白穗现象发生。图5为白穗发生初期至后期的水稻表征图,本文主要针对图中5a、5b阶段进行样本采样研究,此阶段白穗危害并没有大面积发生,使用无人机进行早期识别并防治,可预防白穗大面积发生。对于c阶段,白穗已经大面积发生的状况,防治已失去时效性,防治效果不明显。

图5 白穗危害表征图

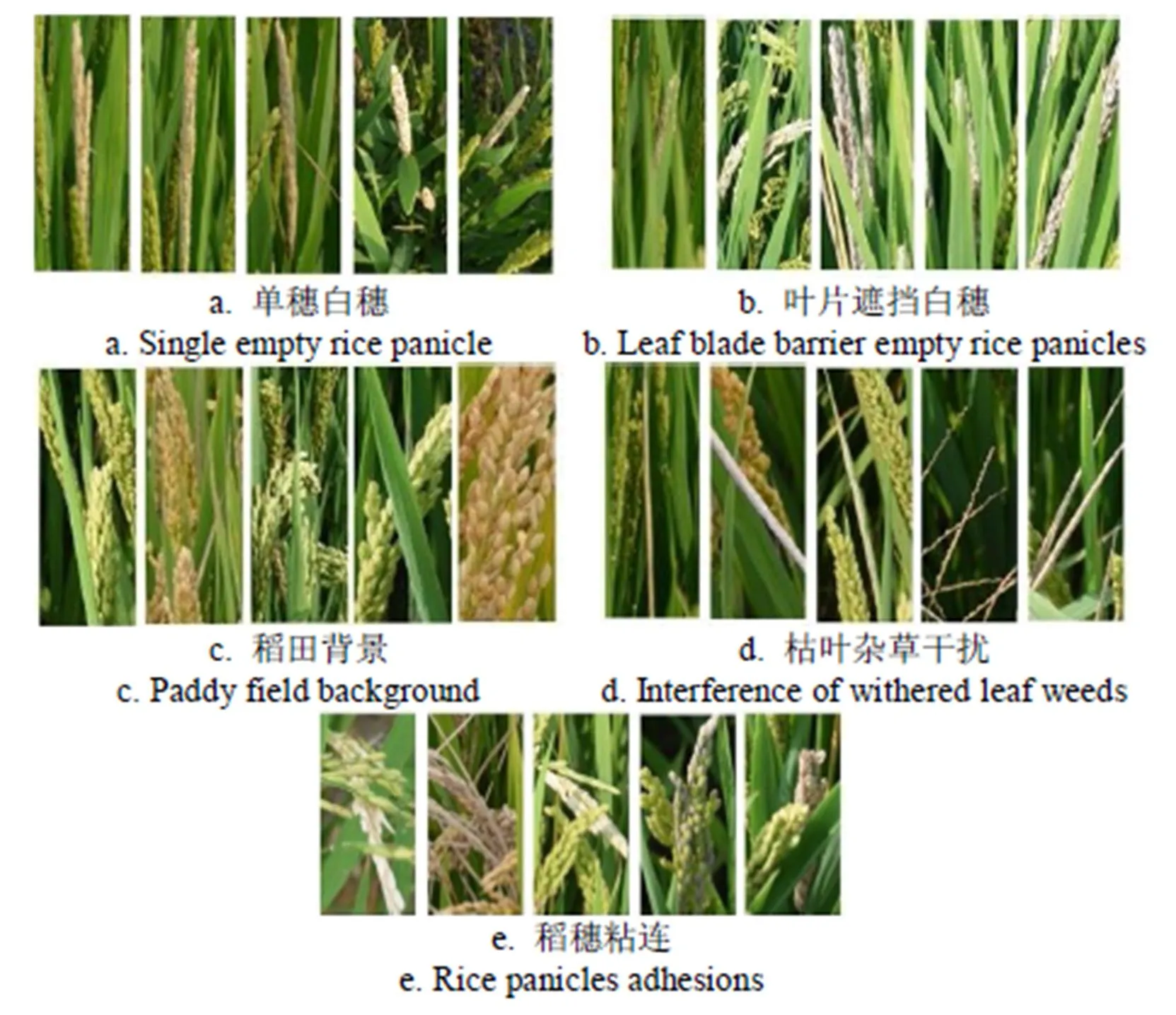

本研究主要采集水稻齐穗期至成熟期发生的白穂图像,利用多旋翼无人机SPREADING WINGS S900平台,在稻田中获取自然条件下的水稻白穂图像,无人机飞行高度在1~1.5 m之间,采集时间集中在每天的10:00~14:00。如图6所示,为了训练和测试研究提出的水稻白穂识别算法,所选取的水稻白穂图像除了考虑光照影响外,还需要包括叶片遮挡、稻穗粘连或者复杂背景等干扰因素。为了方便计算将图像分辨率压缩为640×480 像素,存储为jpg格式。

图6 图像采集各种干扰条件

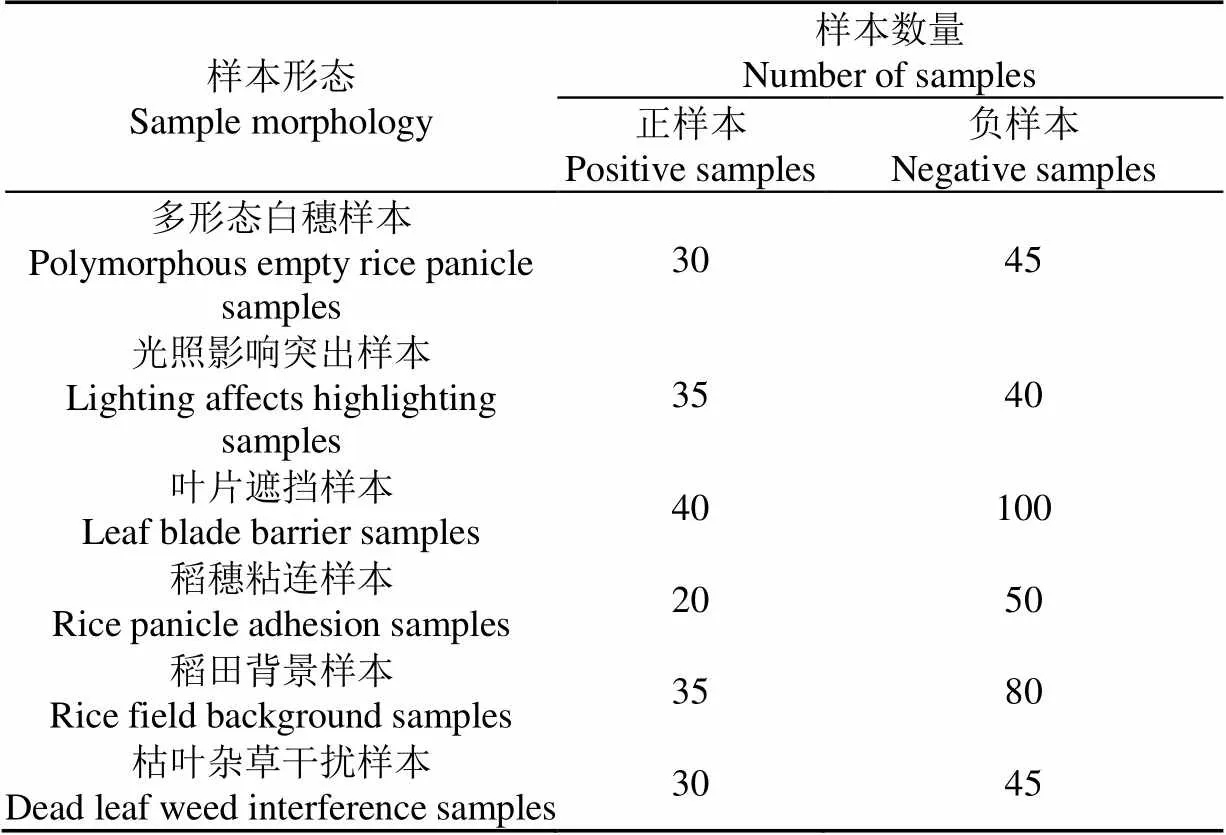

试验期间共采集350幅水稻齐穗期至成熟期的稻田现场图像,将图像中的285幅做为训练集,在训练集图像中选取包括白穂各种形态、光照、遮挡、粘连以及背景等干扰因素在内的700个样本点,以保证训练集的包容性;剩余65幅图像作为测试集,从中选取800个样本点做为测试集样本。表2为训练集和测试集中包含的各种形态的样本数量,图7列出了部分的正负样本图像。

1.3 Haar-like特征提取

Haar-like特征是是计算机视觉领域一种常用的特征描述算子,是用于物体识别的一种数字图像特征。Haar-like特征值反映了图像的灰度变化情况,通过改变特征模板的大小和位置,可在图像子窗口中穷举出大量的特征,达到辨别目标物的目的。基于Haar-like特征识别一副待检图像中是否含有白穂,首先要对图像进行Haar-like特征提取,然后对白穂特征集和背景特征集进行训练建立分类器。考虑到特征集的丰富性和识别速度,本文设计了4类Haar-like特征矩形:A类为边缘特征、B类为线性特征、C类为中心特征、D类为一种扩展Harr-like特征,如图8所示。

表2 样本集数量

图7 训练样本集举例

图8 Haar-like特征矩形示意图

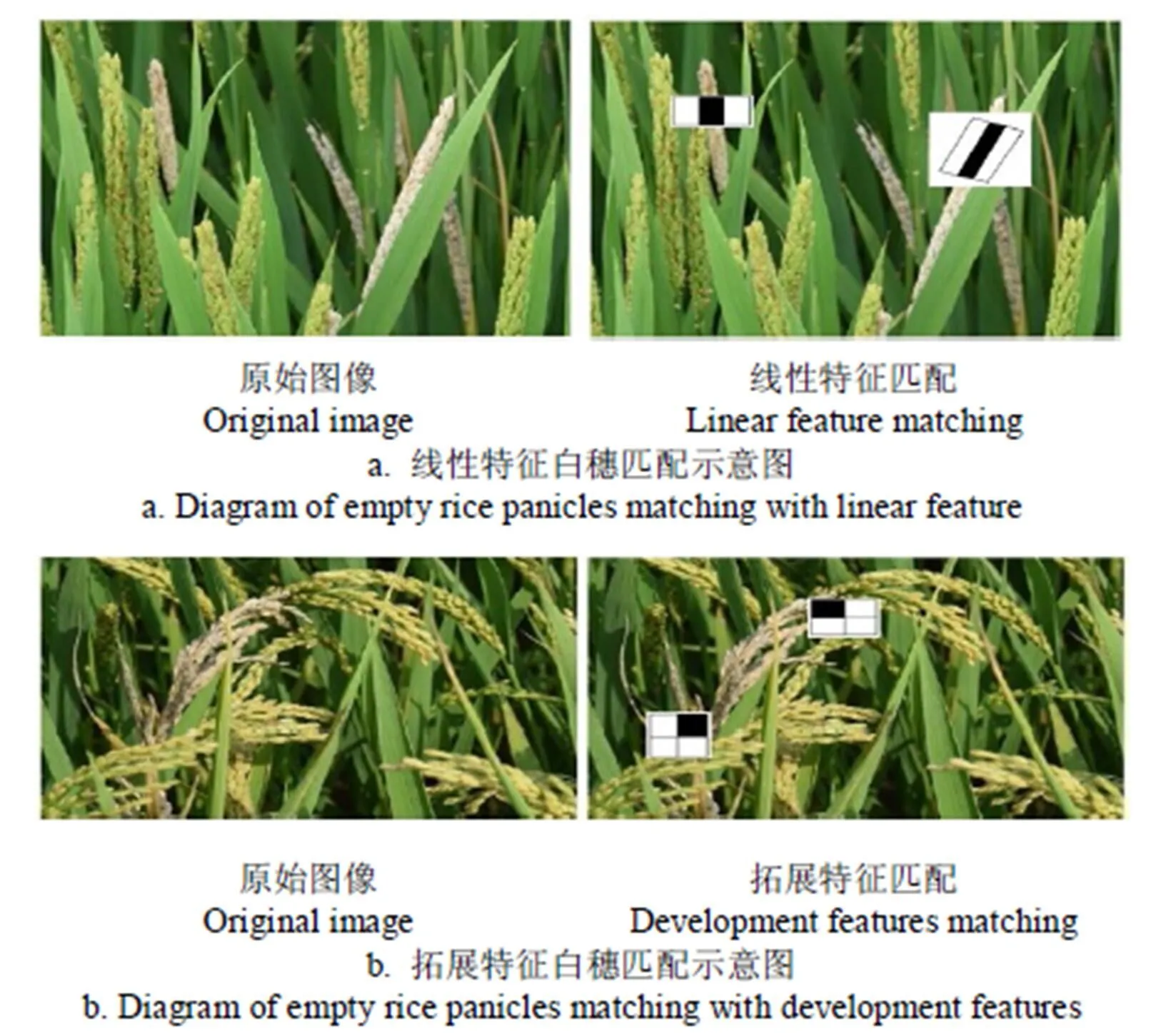

图9为线性特征和扩展特征在白穂图像中的部分匹配说明。由图9a可知,线性特征对于图像中垂直和倾斜的白穂局部灰度区域范围变化的描述较为精确,白穂两侧边缘邻域部分的灰度比中间部分的灰度更深,线性特征对于单穗白穂的特征提取十分有效;图9b所示,对于多穗白穗杂乱交差、粘连等情形,可利用扩展特征进行有效描述。

图9 两组特征在图像上的部分匹配

在进行Haar-like 特征提取时,将样本图像归一化到24像素×24像素的同一个尺度上。由Haar-like特征个数计算公式和其中×为图像大小,×为矩形特征大小,表示矩形特征在水平和垂直方向的能放大的最大比例系数,=+,可知A类特征矩形每组生成51 664个特征,B类特征矩形每组生成28 056个特征,C类特征矩形生成9 985个特征,D类特征矩形每组生成37 600个特征。

1.4 积分图计算和Adaboost分类学习

获取矩形特征之后,对特征值进行计算,为提高计算速度,强化算法实时性,引入积分图算法实现Haar-like 特征的快速提取[22]。

提取的Haar-like 特征输入到Adaboost进行训练学习,Adaboost是一种迭代算法,其通过改变数据分布来实现,根据每次训练集中每个样本的分类是否正确,以及上次的总体分类的准确率,来确定每个样本的权值。将修改过权值的新数据集送给下层分类器进行训练,最后将每次训练得到的分类器融合起来,作为最终的决策分类器[23-24]。学习过程中将每一个基于Haar-like特征的判别阈值作为一个弱分类器,通过Adaboost算法学习,得到样本分布权重不同的测试样本集,每次训练学习都会加大误判样本的权重,减小分类正确样本的权重。将改变分布权重的样本和其他新样本构成新的训练样本集,进行下一次的学习训练。经过次迭代循环后,会得到个弱分类器,将个弱分类器的权重进行级联最终得到强分类器[25]。

经过Adaboost算法训练学习后,得到的强分类器将各级循环迭代中各级弱分类器的误判率降至最低。将待识别样本所提取的Haar-like 特征值作为强分类器的输入,强分类器根据特征值权值给出一个判断是否为水稻白穂的评估值,当为1时表示分类结果为水稻白穂,若等于−1,则该检测样本不是水稻白穂。

2 试验结果与分析

2.1 试验环境

试验硬件环境为Intel(R) Pentium(R) CPU G3220 3.00 GHz,软件环境为Windows 7,VS2010,Intel OpenCV 2.4.3。水稻白穗样本库中共收集350张图像,其中正样本190张,负样本160张。试验中,选取155张正样本和130张负样本作为训练集,应用训练集的420个正样本点和280个负样本点训练学习生成强分类器,另外剩余的35张正样本图像和30张负样本图像作为测试集,即285张训练集图像、65张测试集图像。训练过程中,强分类器的检测率设定为0.91,误判率设为0.000 1;单层弱分类器检测率设定为0.95,目标误判率设为0.3;特征窗口大小设置为24×24。

2.2 Haar-Like特征性能分析

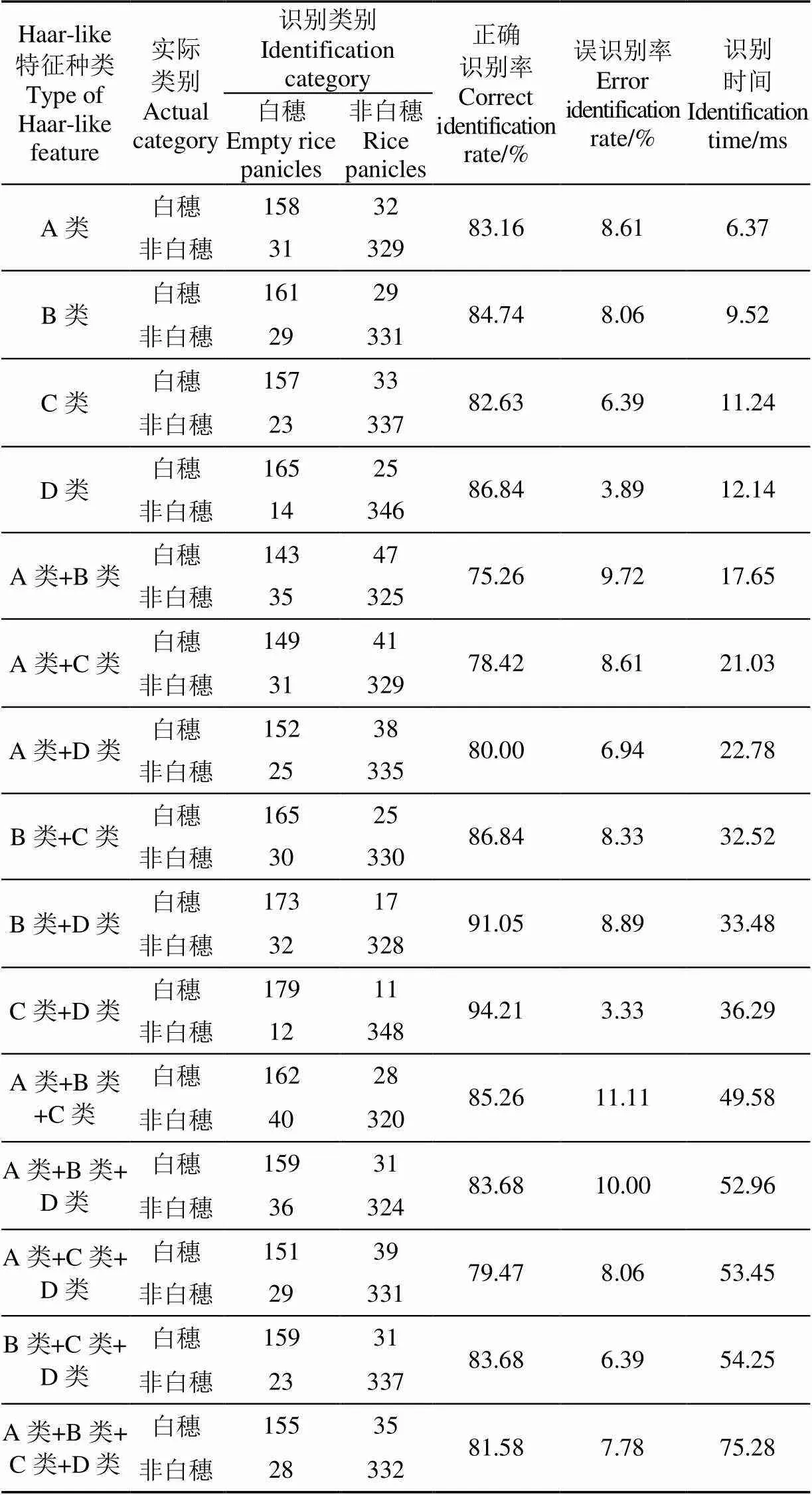

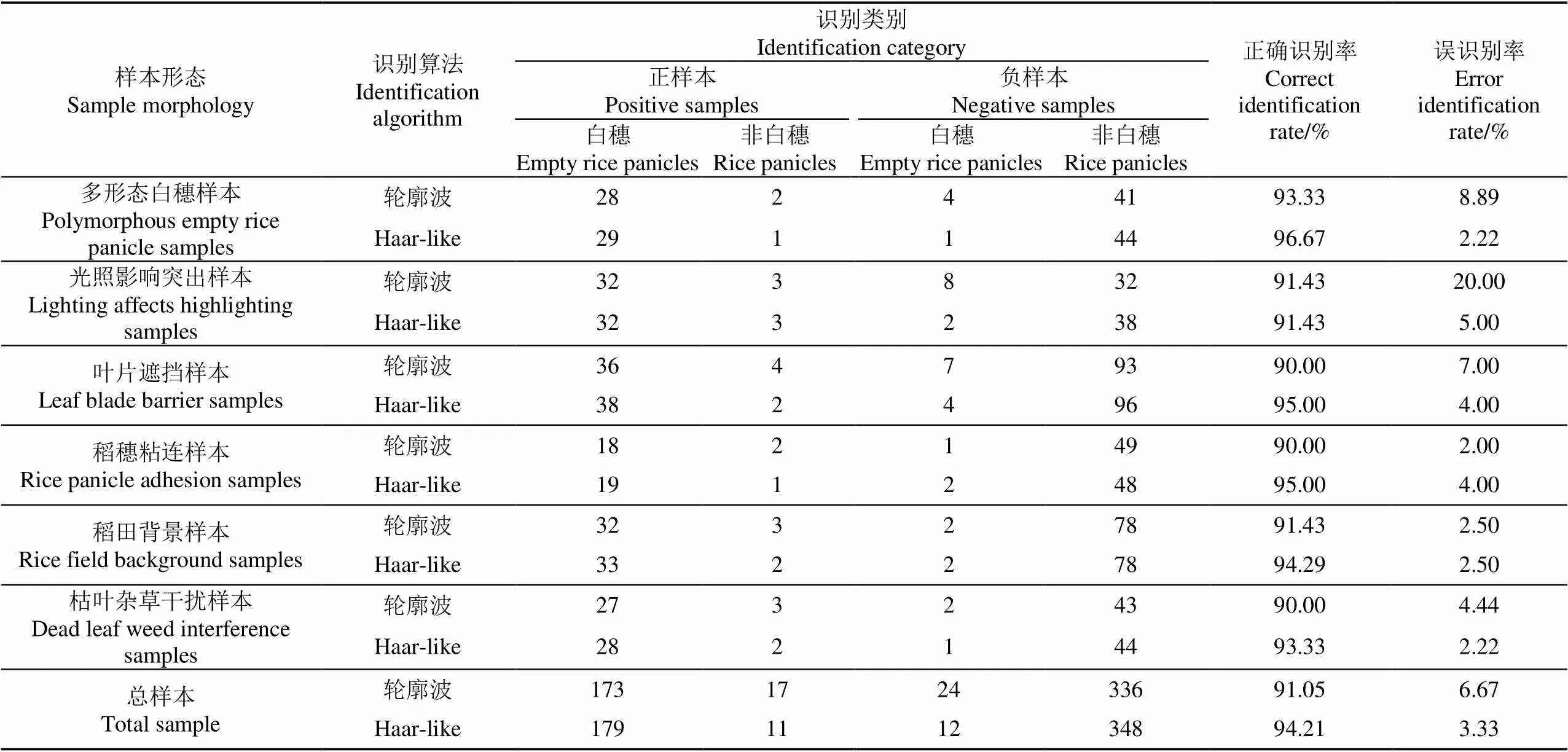

本文设计了4类不同的Haar-like特征,为试验不同特征对白穗识别性能的贡献,设计了4种Haar-like 特征组合的对比试验,包括独立特征试验和多种特征组合试验。试验中将白穗正确识别率和误识别率作为各特征识别贡献性能的评价指标,选取测试集中550个样本进行测试,其中190个白穗样本,360个非白穗样本,各种形态的样本数量如表3所示,试验结果如表4所示。

表3 样本集数量

由表4可看出,本文提出的4种Haar-like 特征都具有80%以上的白穗识别率,不同特征的组合试验中,C类+D类组合特征正确识别率最高,误识别率最低,分别为94.21%和3.33%;其余特征组合试验正确识别率和误识别率与4种Haar-like 特征单独试验性能相当,甚至低于单独特征试验。由试验数据得知,第10组试验C类+D类特征是4种Haar-like 特征及其组合特征中分类性能最好的,因此本文识别算法采用C类+D类Haar-like 组合特征。

表4 Haar-like 特征种类对白穗识别的贡献

注:A类为边缘特征,B类为线性特征,C类为中心特征,D类为扩展特征。

Note: Class A is marginal feature; Class B is linear feature; Class C is central feature; Class D is extended feature.

2.3 AdaBoost算法性能优化试验

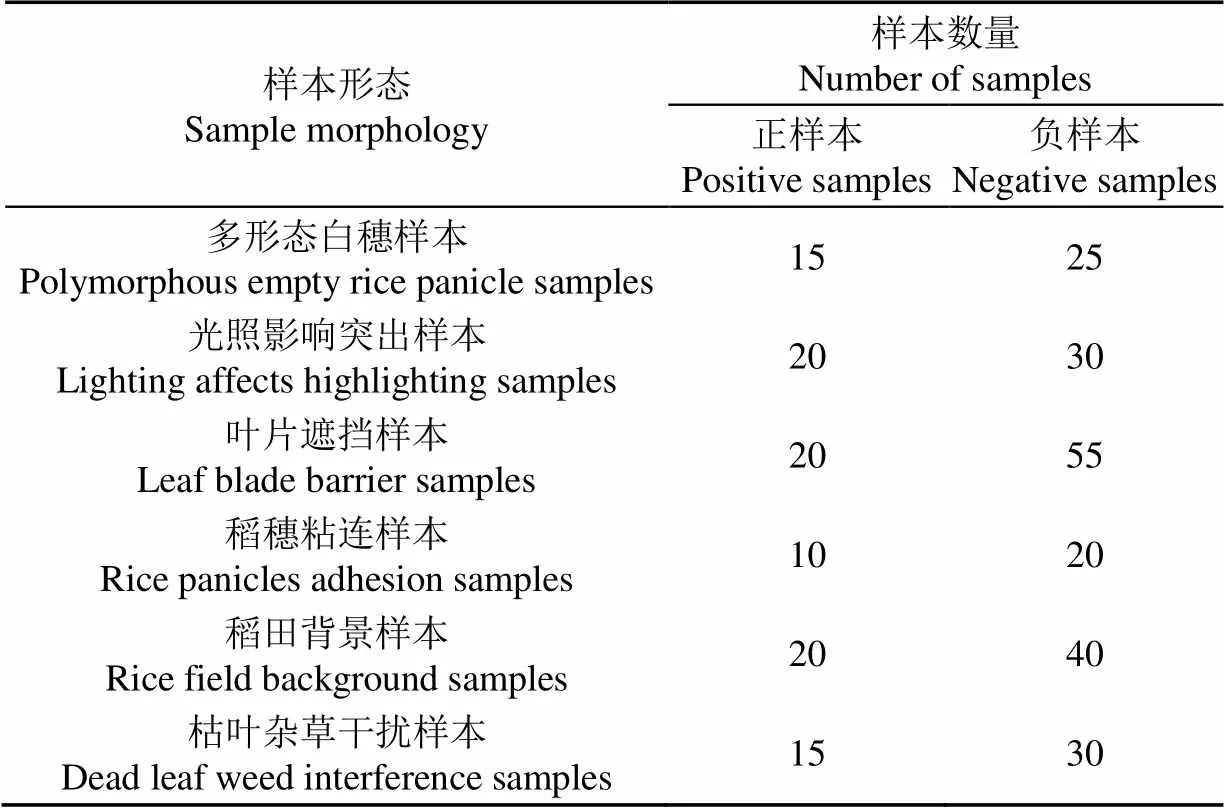

Haar-like特征描述能力与AdaBoost学习过程中训练次数共同决定着稻田白穂识别算法的优劣,Haar-like某一类特征或者多类特征的组合在AdaBoost学习过程中并不是训练次数越多,识别性能越高,相反在达到一定的训练次数后,识别率不但不会增加,反而会因训练次数的增加影响识别时间,进而降低目标识别效率。因此本文针对Haar-like特征分类性能最好的C类+D类特征组合进行了AdaBoost训练次数试验,以期在保证识别率的前提下确定最少的训练时间,达到最好的识别效果。试验中选取300个样本进行试验,其中100个白穗样本,200个非白穗样本。在样本选取上,参阅多篇AdaBoost文献[26-29],正负样本比例设置在1∶1.5~1∶3之间,数量不固定。本次试验样本基本参照了本文2.2节表3的测试集样本,并进行了一定比例的缩减,另外为了保证试验结果的可靠性,验证算法的鲁棒性,样本中人为选取了多组具有典型特征的样本,最终形成了100个白穗样本,200个非白穗样本,共300容量的试验样本集。各种形态的样本数量如表5所示,不同训练次数的对比试验结果如表6所示。

表5 样本集数量

表6 AdaBoost训练次数对比试验(C类+D类)

由C类+D类特征组合的训练次数对比试验数据可知,训练次数在25 000次以下时,随着训练次数的增加,分类器的分类性能会逐渐提高,但当训练次数在25 000~50 000次之间时,正确识别率基本不增加,误识别率减小也不明显,而识别时间增加显著,降低了识别效率。因此,对于C类+D类特征组合的AdaBoost学习,在当前试验训练样本容量情况下,训练次数选择25 000次为最佳。

2.4 水稻白穂在线识别试验

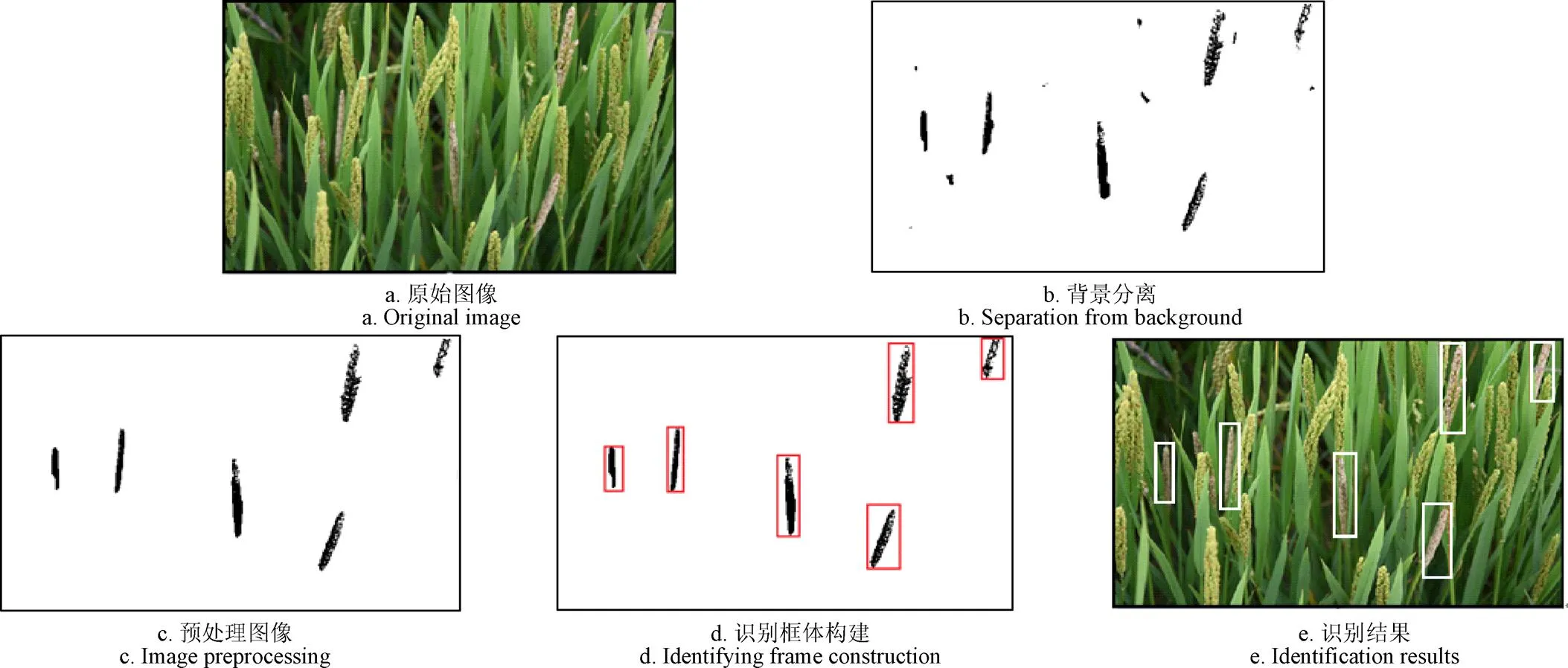

利用经过AdaBoost训练学习得到的强分类器对测试集中的65张图像进行在线识别试验。经统计,65张无人机拍摄的稻田图像中,包含了423个白穂样本。首先对待识别图像进行背景分离、阈值分割、去除噪声等预处理操作,然后进行窗口检测、积分图计算、Haar-like特征提取等操作,最后将Haar-like特征输入到强分类器中进行分类判别,输出识别结果。图10为试验过程中一副含有白穂的样本图像识别过程。

图10 图像预处理及识别结果

试验结果表明,65张包含了多种白穂形态、光照影响、叶片遮挡、稻穗粘连以及背景干扰等的图像中的423个白穂样本,有396个白穂样本能够被识别,正确识别率达到93.62%;背景图像中有23处被误识别为白穂,误识别率为5.44%。白穂未识别和误识别的情况如图11所示。图11a所示为因光照强烈造成的白穗误识别,红色框图为识别到的白穗。对照图11a可看出,图11b图中右下角2个红色框图所标识的白穗为误识别,原因为无人机拍摄时,其飞行姿态和拍摄角度使得正常稻穗反射强光所致。而对于图片上部的4株白穗因光照均匀,无明显反射现象,均能正确识别。因此在强光照射下,个别稻穗因反射强光而呈现高亮区域,造成误识别;图11b中白色框图内标识为未识别到的目标白穂,因稻穗粘连遮挡严重所致,对于稻穗粘连不严重的图像可以达到正确识别的效果;图11c中白色框图标识为未识别到的白穂,因目标物被稻叶遮挡严重所致,而对于最左边红色框图标识的白穗,因其被稻叶遮挡不严重可以被识别。分析以上错误识别原因,后续算法改进中应着重考虑强光干扰和拍摄角度的配合,以及稻叶、稻穗遮挡等干扰情况,近一步提高识别算法的性能。

图11 白穗误识别和未识别示意图

2.5 轮廓波对比试验

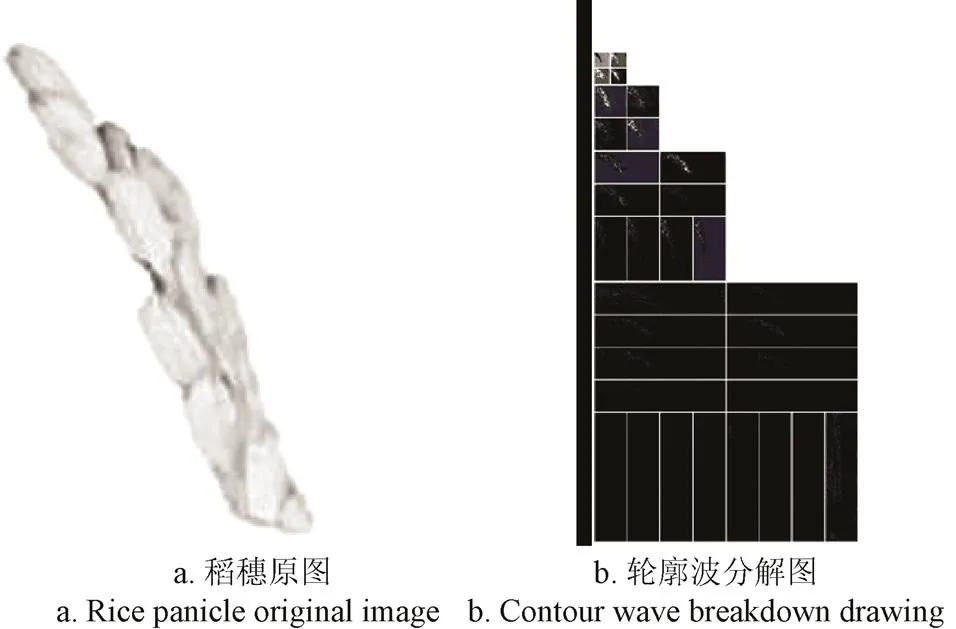

为进一步验证本算法的有效性,采用2.2节Haar-Like特征性能分析所用样本(样本数量如表3所示),应用轮廓波纹理识别算法进行对比试验。轮廓波特征提取识别算法是现有研究中应用较为广泛,识别精度较高的算法之一,可以很好的捕捉各种角度的图像边缘特征,具有旋转不变性的纹理特征提取特点,尤其适用于多角度、多方向样本图像的特征提取[30-32]。试验中,轮廓波特征提取时,分解层次为4,取分解的各高频子带的能量和低频子带的均值及标准差作为识别特征,采用AdaBoost机器学习进行分类识别。图12为某一样本稻穗的轮廓波分解图,试验结果如表7所示。

图12 稻穗原图与轮廓波分解图

表7 轮廓波对比试验

由表7知,相同试验样本情况下,轮廓波识别算法的白穗正确识别率为91.05%,误识别率为6.67%;C类+D类Haar-like 组合特征识别算法白穗正确识别率为94.21%,误识别率为3.33%。试验结果表明,C类+D类Haar-like 组合特征识别算法在白穗正确识别率和误识别率上均优于轮廓波识别算法。在光照影响突出的样本中,轮廓波误识别率高达20%,显著高于Haar-like 组合特征识别算法。针对此试验结果,对比试验中将轮廓波特征造成误识别的样本再次利用Haar-like特征识别算法进行识别,试验结果显示,轮廓波识别算法对强光照图像样本的误识别相对较多,图13列出了轮廓波识别算法中误识别的部分非白穗样本图像,而这些样本有一部分在Haar-like特征识别算法中并未造成误识别(框图中为轮廓波算法因强光照误识别的正常稻穗),表明在强光干扰下轮廓波识别算法较Haar-like特征识别算法的识别能力明显不足。

注:框图中为轮廓波算法因强光照误识别的正常稻穗。

3 结 论

本文以小型多旋翼无人机为采集平台,对采集到的稻田图像进行预处理后作为研究对象,提出了一种基于Haar-like特征和AdaBoost学习的稻田白穂识别算法,并进行验证试验,试验结果和结论如下:

1)针对小型多旋翼无人机现场采集的稻田图像,提出了基于AdaBoost算法的水稻白穗识别方法,该方法引入4类Haar-like特征,构建一个强分类器。试验表明4类Haar-like特征及其组合特征中,C类+D类Haar-like 组合特征对分类器性能提升强于其他特征。

2)本文提出的,C类+D类Haar-like 组合特征可以有效的抑制绝大多数的稻田背景、稻叶遮挡、稻穗黏连等复杂情况的影响,在测试集样本容量为550的情况下(正样本190个,负样本360个),稻田白穗的正确识别率和误识别率分别为94.21%和3.33%,不过对于高强度光照和严重遮挡情况下的识别,算法还有待进一步优化和提高。

3)同轮廓波特征算法进行对比试验表明,C类+D类Haar-like 组合特征识别效果优于轮廓波特征识别。利用C类+D类Haar-like 组合特征,经过AdaBoost训练学习得到的强分类器对测试集中的65张图像,423个白穂样本进行在线识别试验。结果表明:白穗识别率可达93.62%,误识别率为5.44%。

[1] 高春庭. 水稻白穗的发生原因及其防治措施[J]. 科学种养,2011(10):29.

Gao Chunting. The cause of the occurrence of rice white panicle and its control measures[J]. Scientific Farming Magazine, 2011(10): 29. (in Chinese with English abstract)

[2] 刘占宇,孙华生,黄敬峰. 基于学习矢量量化神经网络的水稻白穗和正常穗的高光谱识别[J]. 中国水稻科学,2007,21(6):664-668.

Liu Zhanyu, Sun Huasheng, Huang Jingfeng. Classification of empty and healthy panicles in rice plants by hyperspectral reflectance based on learning vector quantization (LVQ) neural network[J]. Chinese J Rice Sci, 2007, 21(6): 664-668. (in Chinese with English abstract)

[3] 宋怀波,张卫园,张欣欣,等. 基于模糊集理论的苹果表面阴影去除方法[J]. 农业工程学报,2014,30(3):135-141.

Song Huaibo, Zhang Weiyuan, Zhang Xinxin, et al. Shadow removal method of apples based on fuzzy set theory[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2014, 30(3): 135-141. (in Chinese with English abstract)

[4] 赵川源,何东健,乔永亮. 基于多光谱图像和数据挖掘的多特征杂草识别方法[J]. 农业工程学报,2013,29(2):192-198.

Zhao Chuanyuan, He Dongjian, Qiao Yongliang. Identification method of multi-feature weed based on multi-spectral images and data mining[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2013, 29(2): 192-198. (in Chinese with English abstract)

[5] 周天娟,张铁中,杨丽,等. 基于数学形态学的相接触草莓果实的分割方法及比较研究[J]. 农业工程学报,2007,23(9):164-168.

Zhou Tianjuan, Zhang Tiezhong, Yang Li, et al. Comparison of two algorithms based on mathematical morphology for segmentation of touching strawberry fruits[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2007, 23(9): 164-168. (in Chinese with English abstract)

[6] Hayashi S, Ganno K, Ishii Y, et al. Robotic harvesting system for eggplants[J]. Japan Agricultural Research Quarterly, 2002, 36(3): 163-168.

[7] Van Henten E J, Van Tuijl B A J, Hemming J, et al. Field test of an autonomous cucumber picking robot[J]. Biosystems Engineering, 2003, 86(3): 305-313.

[8] 谢忠红,姬长英,郭小清,等. 基于改进Hough变换的类圆果实目标检测[J]. 农业工程学报,2010,26(7):157-162. Xie Zhonghong, Ji Changying, Guo Xiaoqing, et al. An object detection method for quasi-circular fruits based on improved Hough transform[J]. Transactions of the Chinese Society of Agricultural Engineering(Transactions of the CSAE), 2010, 26(7): 157-162. (in Chinese with English abstract)

[9] 蔡健荣,赵杰文. 自然场景下成熟水果的计算机视觉识别[J]. 农业机械学报,2005,36(2):61-64.

Cai Jianrong, Zhao Jiewen. Recognition of mature fruit in natural scene using computer vision[J]. Transactions of the Chinese Society of Agricultural Machinery, 2005, 36(2): 61-64. (in Chinese with English abstract)

[10] 詹文田,何东健,史世莲. 基于Adaboost算法的田间猕猴桃识别方法[J]. 农业工程学报,2013,29(23):140-146.

Zhan Wentian, He Dongjian, Shi Shilian. Recognition of kiwifruit in field based on Adaboost algorithm[J]. Transactions of the Chinese Society of Agricultural Engineering(Transactions of the CSAE), 2013, 29(23): 140-146. (in Chinese with English abstract)

[11] 宋怀波,何东健,潘景朋. 基于凸壳理论的遮挡苹果目标识别与定位方法[J]. 农业工程学报,2012,28(22):174-180.

Song Huaibo, He Dongjian, Pan Jingpeng. Recognition and localization methods of occluded apples based on convex hull theory[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2012, 28(22): 174-180. (in Chinese with English abstract)

[12] 李昕,李立君,高自成,等. 基于偏好人工免疫网络多特征融合的油茶果图像识别[J]. 农业工程学报,2012,28(14):133-137.

Li Xin, Li Lijun, Gao Zicheng, et al. Image recognition of camellia fruit based on preference for ai NET multi-features integration[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2012, 28(14): 133-137. (in Chinese with English abstract)

[13] 赵源深,贡亮,周斌,等. 番茄采摘机器人非颜色编码化目标识别算法研究[J]. 农业机械学报,2016,47(7):1-7.

ZhaoYuanshen, Gong Liang, Zhou Bin, et al. Object recognition algorithm of tomato harvesting robot using non-color coding approach[J]. Transactions of the Chinese Society of Agricultural Machinrey, 2016, 47(7): 1-7. (in Chinese with English abstract)

[14] 刘占宇,孙华生,黄敬峰. 基于学习矢量量化神经网络的水稻白穗和正常穗的高光谱识别[J]. 中国水稻科学,2007,21(6):664-668.

Liu Zhanyu, Sun Huasheng, Huang Jingfeng. Classification of empty and healthy panicles in rice plants by hyperspectral reflectance based on learning vector quantization(LVQ) neural network[J]. Chinese J Rice Sci, 2007, 21(6): 664-668. (in Chinese with English abstract)

[15] 刘占宇,祝增荣,赵敏,等. 基于主成分分析和人工神经网络的稻穗健康状态的高光谱识别[J]. 浙江农业学报,2011,23(3):607-616. Liu Zhanyu, Zhu Zengrong, Zhao Min, et al. Hyperspectral discrimination of different health conditions in rice panicles based on principal component analysis and artificial neural network[J]. Acta Agriculture Zhejiangensis, 2011, 23(3): 607-616. (in Chinese with English abstract)

[16] 白晓东. 基于图像的水稻关键发育期自动观测技术研究[D]. 武汉:华中科技大学,2014. Bai Xiaodong. Image-based Automatic Observation Technology for Critical Growth Stages of Rice[D]. Wuhan: Huazhong University of Science & Technology, 2014. (in Chinese with English abstract)

[17] Kyosuke Yamamoto. On plant detection of intact tomato fruits using image analysis and machine learning methods[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2014, 14(7): 12191-12206.

[18] Sengupta S, Lee W S. Identification and determination of the number of immature green citrus fruit in a canopy under different ambient light conditions[J]. Biosystems Engineering, 2014, 117(1): 51-61.

[19] 刘世晶,王帅,陈军,等. 基于改进主成分分析和AdaBoost算法的运动虾苗识别方法[J]. 农业工程学报,2017,33(1):212-218.

Liu Shijing, Wang Shuai, Chen Jun, et al. Moving larval shrimps recognition based on improved principal component analysis and AdaBoost[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017, 33(1): 212-218. (in Chinese with English abstract)

[20] 文学志,方巍,郑钰辉. 一种基于类Haar特征和改进AdaBoost分类器的车辆识别算法[J]. 电子学报,2011,39(5):1121-1126.

Wen Xuezhi, Fang Wei, Zheng Yuhui. An algorithm based on Haar-like features and improved Adaboost classifier for vehiclerecognition[J]. Acta Electronica Sinica, 2011, 39(5): 1121-1126. (in Chinese with English abstract)

[21] Anandhi D, Valli S. An algorithm for multi-sensor image fusion using maximum a posteriori and nonsubsampled contourlet transform[J]. Computers & Electrical Engineering, 2018, 65: 139-152.

[22] Gatica G, Best S, Ceroni J, et al. Olive fruits recognition using neural networks[J]. Procedia Computer Science, 2013, 17: 412-419.

[23] Zhang C X, Zhang J S, Zhang G Y. An efficient modified boosting method for solving classification problems[J]. Journal of Computational & Applied Mathematics, 2008, 214(2): 381-392.

[24] Techo J, Nattee C, Theeramunkong T. Boosting-based ensemble learning with penalty profiles for automatic Thai unknown word recognition[J]. Computers & Mathematics with Applications, 2012, 63(6): 1117-1134.

[25] Duda R O, Hart P E, Stork D G. 模式分类[M]. 李宏东,姚天翔,等译. 北京:机械工业出版社,2003:383-387.

[26] 师黎,吴敏,张娟. 基于小训练样本的AdaBoost人脸检测[J].计算机工程,2011,37(8):199-201. Shi Li, Wu Min, Zhang Juan. AdaBoost face detection based on few training samples[J]. Computer Engineering, 2011, 37(8): 199-201. (in Chinese with English abstract)

[27] Farias G, Dormido-Canto S, Vega J, et al. Adaboost classification of TJ-II Thomson Scattering images[J]. Fusion Engineering & Design, 2017, 123: 759-763.

[28] Li L, Wang C, Li W, et al. Hyperspectral image classification by adaboost weighted composite kernel extreme learning machines[J]. Neurocomputing, 2018, 275: 1725-1733.

[29] Al-Shemarry M S, Li Y, Abdulla S, et al. Ensemble of adaboost cascades of 3l-Lbps classifiers for license plates detection with low quality images[J]. Expert Systems with Applications, 2018, 92: 216-235.

[30] Jiang Y, Liu C, Ma J. BYY harmony learning of t-mixtures with the application to image segmentation based on contourlet texture features[J]. Neurocomputing, 2016, 188: 262-274.

[31] Biswas S, Sil J. An efficient face recognition method using contourlet and curvelet transform[J]. Journal of King Saud University-Computer and Information Sciences, 2017(10) , https://doi.org/10.1016/j.jksuci.2017.10.010.

[32] Amorim P, Moraes T, Fazanaro D, et al. Electroencephalogram signal classification based on shearlet and contourlet transforms[J]. Expert Systems with Applications, 2017, 67: 140-147.

Identification of diseased empty rice panicles based on Haar-like feature of UAV optical image

Wang Zhen1,2, Chu Guikun1, Zhang Hongjian1, Liu Shuangxi1,2, Huang Xincheng3, Gao Farui3, Zhang Chunqing4, Wang Jinxing1,2※

(1.,,271018,; 2.,271018,; 3.,273013,; 4.,,271018,)

Empty rice panicles are a common pest and disease characteristic in rice fields that affects the rice yield and quality. In order to achieve accurate prevention and control of pests and diseases in rice fields, in this study, a multi-rotor UAV-loaded industrial CCD digital camera was used as the image acquisition platform to rapidly and accurately identify and locate the empty rice panicles in large area rice fields based on the Haar-like feature extraction and Adaboost training algorithm. We used the method of UAV aerial photography technology to perform video capture of large area rice fields on a scheduled route. The interval frame number of the sample image was calculated by parameters such as the flight speed of the UAV, aerial video speed, aerial altitude, and the angle of camera, then the video of the rice field was processed by image disassembly, frame extraction, image mosaic, etc. to achieve efficient and rapid acquisition of image information of large area rice fields. The training sample database and the test sample database for the test were finally formed according to the position information of the rice field coordinate in the frame image extracted by the image extraction interval frame number. After many preprocessing operations, such as compression, cutting, normalization, background separation, threshold segmentation, noise removal, etc., the images in the training sample database and the test sample database were applied in the Haar-like feature extraction and AdaBoost training. In this study, we designed four kinds of Haar-like features, such as edge feature of class A, linear feature of class B, center feature of class C and extension feature of class D, these four kinds of Haar-like features and their combination features were rapidly extracted by the integral diagram calculation, then input the extracted Haar-like features into Adaboost training. During the calculation process, we took each discrimination threshold based on the Haar-like features as a weak classifier to give iterative cycle training, after T times iterative cycles. Then T weak classifiers were obtained, and the strong classifier was obtained after cascading the weights of the T weak classifiers. After the Adaboost training, the obtained strong classifier minimized the misjudgment rate of weak classifiers at all levels in each cycle of iteration. We then took the Haar-like eigenvalue extracted by the unrecognized samples as the input of the strong classifier, based on eigenvalue weight, the strong classifier gave a assessed value H to judge whether it was the empty rice panicles or not. When the H was 1, it meant that the classification result was empty rice panicles. When the H was -1, the tested sample was not the empty rice panicles. In this way, identification of empty rice panicles was realized. In order to ensure the diversity and adequacy of the test samples, the influence of the interference factors such as various forms of the empty rice panicles, lighting, shielding, adhesion and background etc. were fully considered. Two hundred and eight five images and a total of 700 positive and negative samples in the training sample database were used for Haar-like feature extraction and AdaBoost learning training. Sixty five images and a total of 800 positive and negative samples in the test sample database were used to verify the performance of strong classifier. The experimental results showed that among the four Haar-like features and their combined features, the class C and class D Haar-like combined features had better performance in improving classifiers than other features. The strong classifiers generated by this combined features were then used to identify the 423 empty rice panicles samples in the test, among which, three hundred and ninety six were identified, and the recognition rate was 93.62%. Our results demonstrated that this method could effectively inhibit the influence of complex backgrounds such as the rice leaves shielding, rice panicles adhesion and lighting etc., and it was also suitable for field identification of empty rice panicles in natural environment. In the study, this method was compared with algorithms that used texture recognition, such as shear waves, contour waves, curve waves, etc. The experiment showed that this method has significant advantages both in the accuracy and the speed of recognition.

unmanned aerial vehicle; algorithms; diseases; empty rice panicles; Haar-like feature

10.11975/j.issn.1002-6819.2018.20.010

TP391.41

A

1002-6819(2018)-20-0073-10

2018-04-03

2018-07-05

国家公益性行业农业科研专项(201303005);山东省现代农业产业技术体系创新项目;山东省“双一流”奖补资金资助(SYL2017XTTD14)

王 震,讲师,博士生,主要从事精准农业信息化研究。Email:wangzhenxky@sdau.edu.cn

王金星,博士生导师,主要从事农业机械化工程研究。Email:jinxingw@163.com

王 震,褚桂坤,张宏建,刘双喜,黄信诚,高发瑞,张春庆,王金星. 基于无人机可见光图像Haar-like特征的水稻病害白穂识别[J]. 农业工程学报,2018,34(20):73-82. doi:10.11975/j.issn.1002-6819.2018.20.010 http://www.tcsae.org

Wang Zhen, Chu Guikun, Zhang Hongjian, Liu Shuangxi, Huang Xincheng, Gao Farui, Zhang Chunqing, Wang Jinxing. Identification of diseased empty rice panicles based on Haar-like feature of UAV optical image[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(20): 73-82. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2018.20.010 http://www.tcsae.org