基于改进YOLO的双模目标识别方法研究∗

2018-04-26黄杰军明德烈

黄杰军 呼 吁 周 斌 明德烈

(1.华中科技大学自动化学院 武汉 430074)(2.北京航天自动控制研究所 北京 100854)

1 引言

可见光成像和红外成像是目前最常用的两种成像方式,它们不同的成像方式决定了它们对目标具有不一样的成像特性。充分利用和结合可见光、红外成像的优点,扬长避短,对提高自动目标识别系统侦查能力具有重大意义。

与红外相机相比,可见光相机成像分辨率高、目标纹理信息丰富,成像尺寸也相对较大。然而,可见光的波长范围是:0.38μm~0.78μm[1],当探测环境出现大雾天气或有烟雾弹等干扰时,可见光成分被大幅甚至全部吸收。因此,仅凭可见光相机往往难以探测目标。

相反,红外成像具有不同的工作机理,它靠接受物体的红外辐射而成像。红外辐射,波长为0.78μm~1000μm。大气、烟云等吸收可见光和近红外线,但是对3μm~5μm和8μm~14μm的热红外线却是透明的。利用这两个“大气窗口”[2~4],人们可以在完全无光的夜晚,或是在烟云密布的环境,清晰地观察到前方的情况。但是,红外相机成像分辨率较低,通常只能获取目标外轮廓,难以获得目标精细纹理信息,因此很难对目标进行细致的分析。

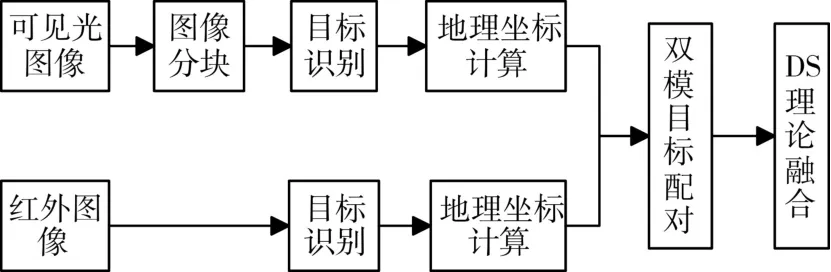

本文使用YOLO[5]来完成红外、可见光目标预测,并输出目标类型和后验概率,根据相机成像参数以及飞行器载体GPS航迹信息反算目标地理位置,进行进一步的两模目标配对和决策级融合。本文所设计的红外、可见光双模目标识别算法框架如图1所示。

图1 红外、可见光双模目标识别算法框架

2 基于YOLO的目标识别算法

YOLO[5](You Only Look Once)实时目标检测算法由Joseph Redmon等于2016年5月提出。目标检测方法从 R-CNN[6]到 Fast R-CNN[7],再到 Faster R-CNN[8],四个基本步骤(候选区域生成,特征提取,分类,位置精修)被统一到一个深度网络框架之内。YOLO利用单一的卷积神经网络,直接从像素到目标包围框和类概率输出,实现了端到端的优化,避免了冗长的处理流程。

YOLO将输入图像分为S×S的网格。每个包围框包含5个预测值:x,y,w,h以及置信度,其中(x,y)是包围框的中心坐标,(w,h)分别是包围框的宽度和高度。置信度表示预测框与人工标定的真实框的IOU(交集和并集的比值)。因此对于一幅图像,神经网络共有S×S×(B×5+C)个输出。YOLO使用一个卷积神经网络来实现上述的算法模型,该神经网络有24个卷积层以及2个全连接层。

为验证算法可行性,分别挑选了200张红外和可见光某港口图像序列作为样本,并人工标记出某个船舶目标作为训练对象。

在测试阶段,使用的红外图像尺寸为640*512,可见光图像尺寸为2332*1752。YOLO算法进入卷积层前会将图像尺寸压缩到448*448,红外图像原始尺寸与该尺寸相当,可以直接输入到检测器中。但可见光图像尺寸与YOLO算法处理尺寸相去较远,YOLO对小目标的检测与识别并不敏感。如果直接将原始可见光图像输入到检测器中,在图像压缩过程中,较小目标纹理信息会丢失,导致目标难以检测。本文提出将图像交错分块的方法,将原始图像切割为四个小图像来分别处理。如图2所示,原始图像W*H被分为ABCD四个部分,ABCD四个矩形框尺寸相同,矩形框大小计算公式如下:

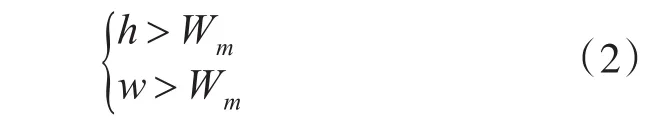

其中x=A,B,C,D。h和w由目标最大尺寸决定,设目标在可见光图像中的最大像素尺寸为Wm×Wm,则h和w的取值约束条件为

图2 可见光图像分块处理示意图

3 红外、可见光双模决策级融合算法

为了将红外、可见光图像中的目标融合输出,需要将两模中的目标进行配对确认是否为同一目标。本文提出使用反算定位的方法,先根据飞行器GPS信息和相机参数,分别反算出目标的地理位置,然后利用红外、可见光图像目标的地理位置进行目标配对,从而进行融合。通过遍历比较红外图像中目标的位置与可见光图像中目标的位置,若两者欧式距离小于一定值,认为它们是同一个目标。判断准则如下:

3.1 反算定位算法

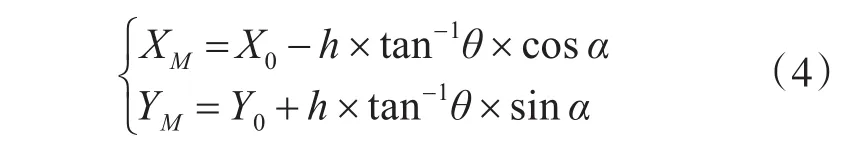

假定通过捕获定位后,目标在实时图上的位置为(X2,Y2)。令ROW为实时图行数,COL为实时图列数,则实时图中心的坐标为(ROW/2,COL/2)。令ϕ为纵向视场角,φ为横向视场角,α为方位角,θ为俯仰角,h为视点P的高度。利用相机的内部参数(相机张角、成像像素尺寸)、外部参数(相机空间位置、相机的光轴指向),通过三角关系可以结算出实时图中心点的大地坐标:

其中(XM,YM)是实时图中心点大地坐标,(X0,Y0)是观测点(相机位置)大地坐标。

反算定位的算法实现如下:

1)计算(X2,Y2)与光轴瞄准点在大地坐标系下沿进入方向的偏移量(L1,L2)

(1)纵向距离L1

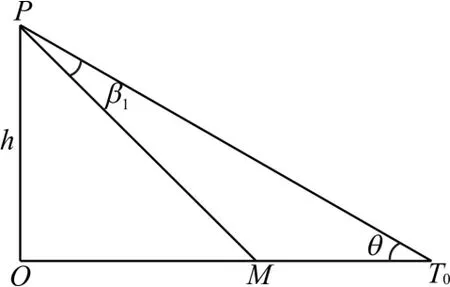

图3 光轴瞄准点T0与目标在飞行方向纵轴上的投影M之间的位置关系图

如图3,令 MT0=L1,则

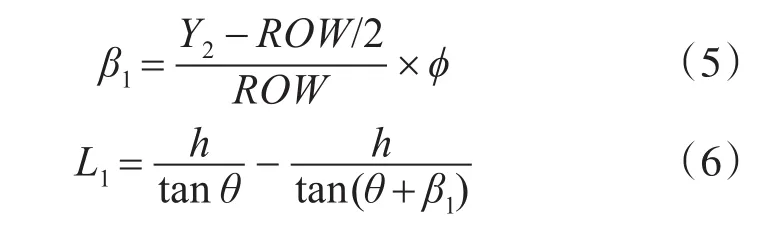

(2)横向距离L2

图4 光轴瞄准点T0与目标在飞行方向横轴上的投影N之间的位置关系图

如图 4,令 T0N=L2,则

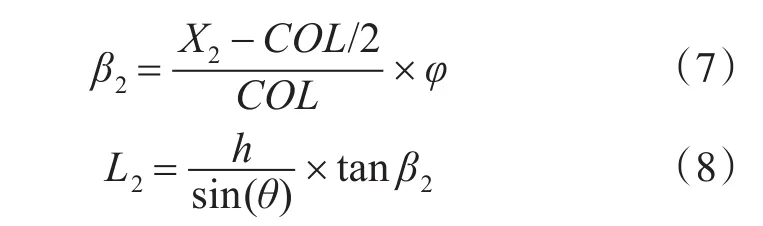

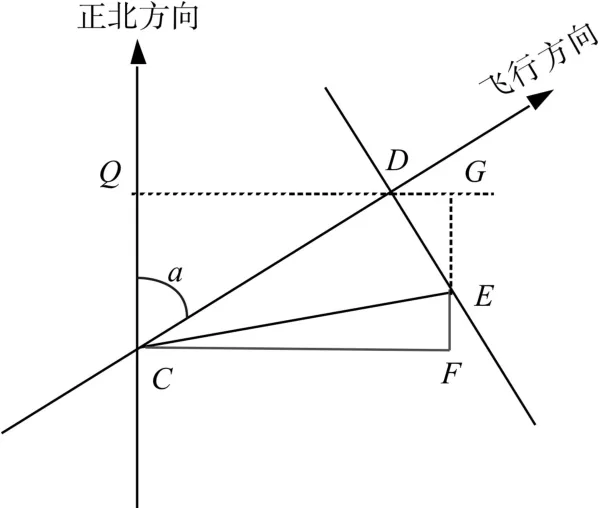

2)由 L1,L2计算在正北方向上的投影量dx2,dy2

图5 正北方向与飞行方向示意图

如图 5,令 CD=L1,DE=L2,则 ∠EDG=α ,CF=dx2,FE=dy2,则

由于在大地坐标系下,利用相机的内部参数,通过三角关系可以解算出实时图中心点的大地坐标 (XM,YM),因此,由上述计算出的 dx2,dy2即可得到目标在大地坐标系中的位置(XT,YT)。

3.2 基于DS证据理论的双模融合

证据理论由Dempster于1967年提出,后由其学生Shafer进行了完善,因此又称Dempster-Shafer证据理论[9],简称为DS理论。在识别框架[10]Θ 中,设A表示Θ的任一子集,用m表示基本信任函数,则m(A)是事件A的基本信任分配值,应满足以下条件:

其中,使得m(A)>0的A被称作焦元。

根据Dempster-Shafer合成规则,识别框架Θ上的有限个mass函数[11]m1,m2,···,mn的合成规则为

其中K为归一化常数,

本文研究红外、可见光目标识别的两模决策级融合问题,则mass函数个数为2,若只讨论船舶目标识别,则识别框架中有一个子集。

4 实验结果与分析

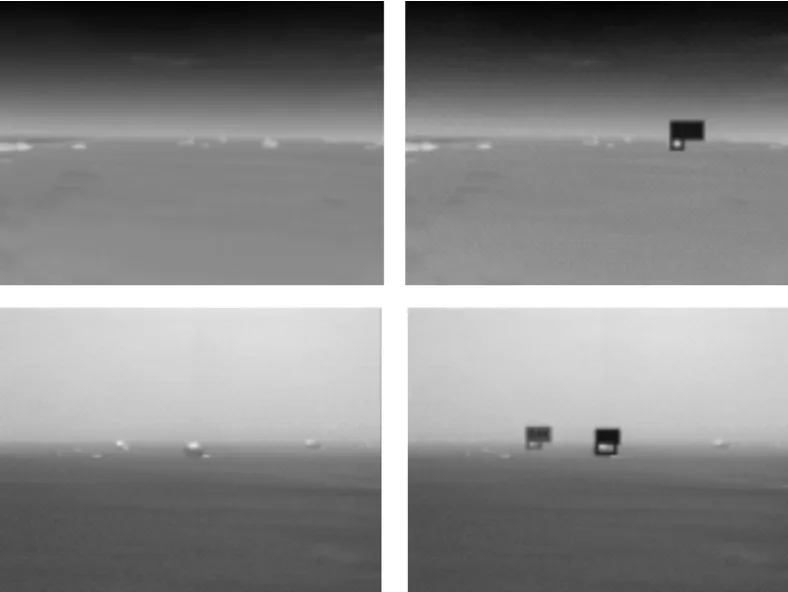

图6 远景目标识别实验

本文选取某港口船舶入港部分图像序列进行实验,经YOLO分类器进行目标识别,输出目标测外矩形框和后验概率。下面是部分实验结果。其中红外图像尺寸为640*512,可见光图像尺寸为2332*1752。

表1 远景目标识别DS证据理论融合

图7 近景目标识别实验

表2 近景目标识别DS证据理论融合

5 结语

本算法基于卷积神经网络实现了红外、可见光双模目标识别,并使用DS证据理论完成目标识别概率的融合,扬长避短,有效提高了系统综合识别能力。本算法采用的卷积神经网络方法实现了端到端的目标识别过程,只需要将数据增广,再次训练,就可以应用到新的场景中,具有适应能力强、容易拓展等优点。

[1]杨维,倪陶,黎昌金.可见光波长的另一种测量方法[J].内江师范学院学报,2013,28(8):35-37.YANG Wei,NI Tao,LI Changjin.Another Method for Mea⁃suring the Wavelength of Visible Light[J].Journal of Nei⁃jiang Normal University,2013,28(8):35-37.

[2]陈衡.常用红外大气窗口光谱通带的平均透射率[J].激光与红外,1979(1):3-5.Chen Heng.The Average Transmittance of Spectral Bands of Infrared Atmospheric Window[J].Laser&Infrared,1979(1):3-5.

[3]杜永成,杨立,孙丰瑞.细水雾在大气窗口波段的光谱与谱带辐射特性规律[J].红外与激光工程,2014,43(4):1052-1056.DU Yongcheng,YANG Li,SUN Fengrui.Spectral And Spectral Characteristics of Water Mist in the Atmospheric Window Band[J].Infrared and Laser Engineering,2014,43(4):1052-1056.

[4]Zhao Bolin,Han Qingyuan,Zhu Yuanjing.A Study on Ab⁃sorption Characteristics of the Atmospheric Window in Mi⁃crowave Band[J].Advances in Atmospheric Sciences,1985,2(1):28-34.

[5]Redmon J,Divvala S,Girshick R,et al.You Only Look Once:Unified,Real-Time Object Detection[J].Comput⁃er Science,2016:779-788.

[6]Girshick R,Donahue J,Darrell T,et al.Rich Feature Hi⁃erarchies for Accurate Object Detection and Semantic Seg⁃mentation[J].2014:580-587.

[7]Girshick R.Fast R-CNN[C]//IEEE International Confer⁃ence on Computer Vision.IEEE,2015:1440-1448.

[8]Ren S,He K,Girshick R,et al.Faster R-CNN:Towards Real-Time Object Detection with Region Proposal Net⁃works.[J].IEEE Transactions on Pattern Analysis&Ma⁃chine Intelligence,2016:1.

[9]Yager R R.On the Dempster-Shafer framework and new combination rules[J].Information Sciences,1987,41(2):93-137.

[10]Murphy C K.Combining belief functions when evidence conflicts[J].Decision Support Systems,2000,29(1):1-9.

[11]Yang Y,Han D,Han C.Discounted combination of un⁃reliable evidence using degree of disagreement[J].Inter⁃national Journal of Approximate Reasoning,2013,54(8):1197-1216.