基于重要性加权的结构稀疏跟踪方法*

2018-02-05梁贵书牛为华李宝树

梁贵书,牛为华,李宝树,李 强,赵 鹏

(1.华北电力大学电力工程系,河北 保定 071003;2.华北电力大学计算机系,河北 保定 071003;3.河北省电力公司,石家庄 050021)

视觉跟踪是计算机视觉研究领域中的一个重要课题,广泛的应用于智能监控、视觉导航和人机交互等领域。国内外的许多研究者们做了大量视觉跟踪问题的研究,并提出了许多可行的跟踪算法。依据目标表观模型的建模方法,可以将当前的跟踪方法分为三类[1]:生成式跟踪方法,如Mei[2]通过求解1最小化问题实现跟踪目标,zhang[3]提出将目标跟踪视为多任务稀疏学习问题,Xu[4]提出了结构化局部稀疏外观模型,郭[5]利用拟蒙特卡罗模拟退火算法解决极大似然概率多假设中多目标的优化求解问题;判别式跟踪方法,如Babenko[6]利用多样例学习进行目标跟踪,Kalal[7]提出了跟踪学习检测;混合式跟踪方法,如Zhong[8]利用稀疏协同模型的鲁棒目标跟踪算法,彭[9]将视觉显著性与动态模板匹配相结合从而进行目标识别。这些方法在一定程度上提高了目标跟踪的效果。然而,在复杂多变的自然场景中实现对表观变化的目标进行鲁棒的跟踪依然存在很多困难,包括场景光照的变化、目标旋转、局部遮挡、目标的形态以及尺度的变化等。因此,本文针对视觉跟踪的难点,提出了一种基于重要性加权的结构稀疏跟踪方法,通过常用视觉跟踪的评价指标精确度以及时间效率验证了提出新方法的有效性。

1 结构稀疏字典

结构稀疏表示[10-11]是在局部稀疏表示的基础上提出来的,能够融合局部信息和全局信息对目标进行稀疏表示。设X为一归一化后的目标图像,根据事先给定块的大小和步长,分块按照从上到下、从左到右的方式进行,记局部图像为xk∈Rm×1,k=1,2,…,K,m和K分别为局部图像块的维度和数量。为了得到各局部块在字典上的稀疏表示,将每个局部块的字典构造当作一个单独的问题。记xk对应的局部稀疏字典为Dk,Dk由模板中与xk处于相同位置局部图像构成,所以可以完整地描述xk的表观。本文用于字典学习的模板由10个目标模板和10个背景模板组成。因目标图像中各局部块均有一个相应的局部字典,因此xk可以由字典Dk表示为

xk=αkDk+ek

(1)

式中:αk是xk在字典Dk上的稀疏系数,ek是xk在字典Dk上的分解残差。目标图像X的结构稀疏字典由所有局部块的字典组成,即D=[D1,D2,…,DK]。每个局部块对应目标图像的一个区域,所有的局部块一起可以描述目标的整个结构。稀疏字典构造的过程如图1所示。

图1 结构稀疏字典的构造过程

2 重要性加权

当目标区域被分块处理后,通过表达局部块的局部特征来描述目标的表观。本文根据局部图像在描述表观时所起的作用对其进行加权处理,使稳定区域的权重值大,容易发生变化的区域权重值小。图2为局部区域加权示意图,将目标区域分为16个子块,每个子块的权重分别为w1,w2,…,w16,若子块1、2和5被遮挡而变的不稳定,相应地,w1、w2和w5将获得较低的权重。本文根据局部图像的重建残差来定义每个局部块的重要性。

图2 局部重要性加权示意图

(2)

则目标局部图像xk在字典Dw上的重建残差为

ek=‖xk-Dwβk‖2

(3)

令目标局部图像xk的权重为

wk=exp(-ek)

(4)

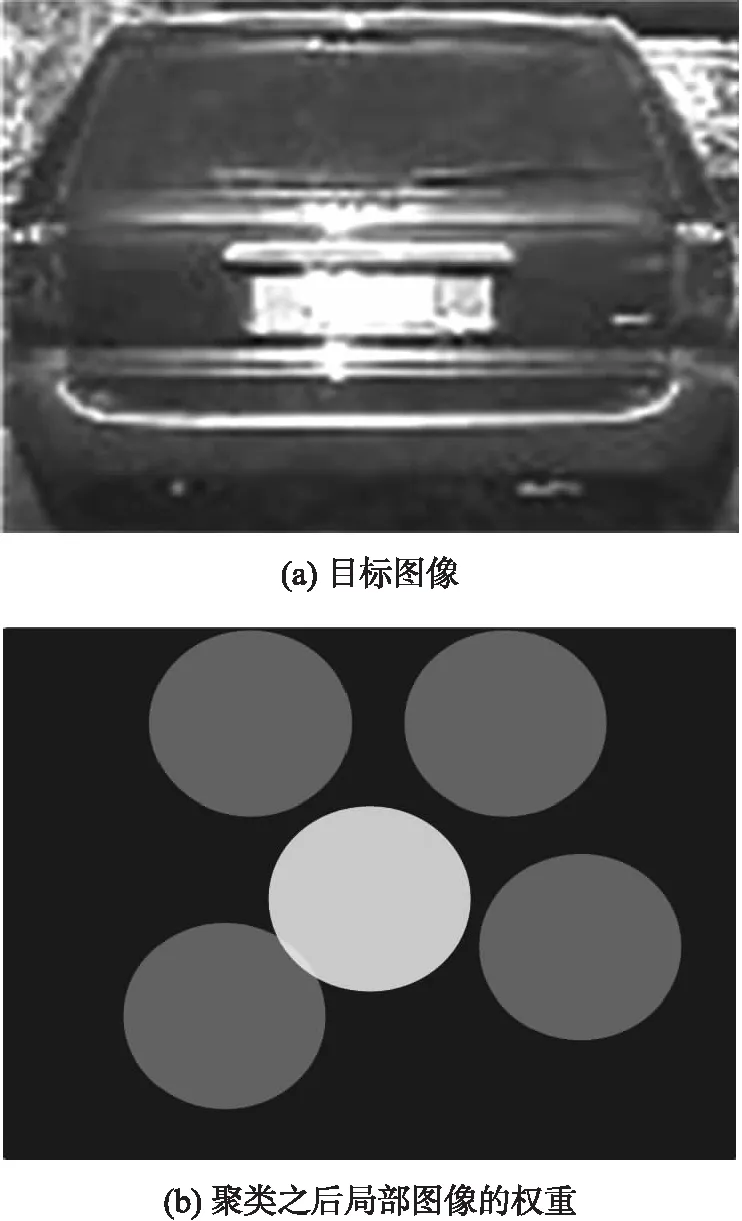

则目标图像的权重矢量W=[w1,w2,…,wK]∈R1×K,W中的值描述了各局部图像的稳定性。权重值越大表示该区域越稳定,该局部图像在目标表观建模中就越重要。图3(a)是归一化后的目标图像,图3(b)显示了该图像的权重分布示意图,灰色代表权重值较小,白色代表权重值较大。为了降低跟踪漂移发生的可能性,仅在视频图像序列的首帧构造一次目标的权重字典。当更新目标模型时,计算当前跟踪结果的局部块在权重字典上的重建残差,对目标的权重矢量进行更新。

图3 目标图像的权重分布示意图

3 重要性加权结构稀疏跟踪算法

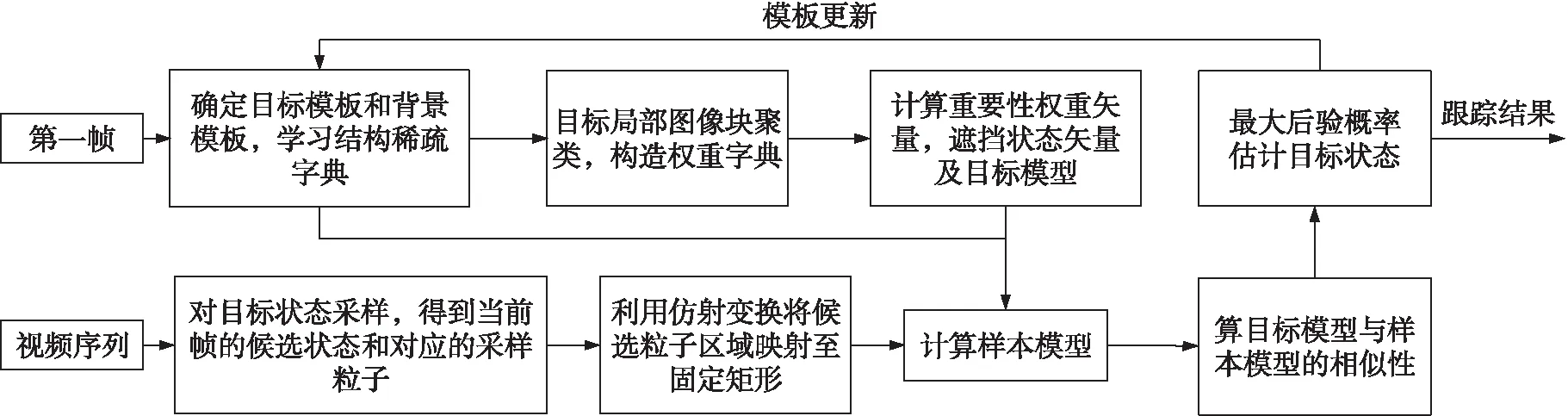

视觉跟踪中,观测模型通常表示为样本与目标间的相似度,表明采样状态是跟踪结果的概率。图4给出了算法的跟踪流程。

3.1 重要性加权结构稀疏模型

图4 重要性加权结构稀疏跟踪算法流程

3.2 构建相似性函数

在跟踪过程中,根据上节的方法对当前所有采样样本建立样本模型,设第i个样本的表观模型为Ci,为度量目标模型B与样本模型Ci之间的相似程度,视模型为直方图,根据直方图相交定义二者间的相似性函数F为

(5)

(6)

式中:ek由式(3)计算,表示第k个图像的残差。φ为遮挡检测阈值。加入该值后,B与Ci间的相似性函数为

(7)

式中:μ为归一化参数,式(7)利用稀疏表示系数之间的相似关系来计算目标模型与样本模型间的相似度,利用遮挡检测排除遮挡的干扰。

3.3 模板更新策略

通过目标模型对跟踪结果的表达程度,来判断模板是否需要更新。令Ft为第t帧时的目标模型与当前跟踪结果的相似值,Ft由式(7)确定,则由式(8)来判断模板是否需要更新

(8)

式中:θ1为更新下限阈值,用来避免产生错误的更新。θ2为更新上限阈值,用来减少产生不必要的更新。对于跟踪中图像序列的每一帧,由式(7)和式(8)对当前模型的表达能力进行判断。若符合更新的条件,则进行模板更新;否则,直接跟踪下一帧。

3.4 跟踪算法流程

P(St|St-1)=N(St;St-1,Σ)

(9)

式中:N表示高斯分布函数,Σ表示方差矩阵,它的形式为对角矩阵并且对角元素是仿射变换的参数。由式(9)可对第t帧的目标状态进行采样。目标的观测模型P(ot|st)建模为式(7)所示的相似性函数

(10)

目标在第t帧的状态根据最大后验概率估计确定,即

(11)

4 实验比较分析

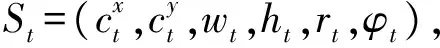

为了评估本文算法的跟踪性能,在Benchmark平台上的51个公开的标准视频序列上进行跟踪实验,并挑选了6个典型的挑战性视频序列的部分跟踪结果进行展示。所选的视频序列如表1所示,分别为:Faceocc1,Faceocc2,Car4,Bolt,Coke,Deer。这些视频序列覆盖了绝大多数挑战性场景,例如遮挡、运动模糊、光照变化、目标尺寸及形态变化、目标发生旋转以及复杂背景等。

每个图像样本经过仿射变换被映射到32 pixel×32 pixel的矩阵空间;利用600个粒子对目标的真实状态进行了逼近;局部图像块的尺寸为8 pixel×8 pixel,即局部块的维度m为64;分块步长为8 pixel,按照从上到下,从左到右的顺序对目标图像进行分块,则每个目标图像包含的局部块的数量K为16;聚类中心个数c设置为10;遮挡检测阈值φ设置为0.05;更新阈值θ1和θ2分别为30和50;相似性函数中的归一化参数μ设置为0.5。为了验证本文方法的优越性,对比分析了MTT[3]、ASLA[4]、MIL[6]、TLD[7]、SCM[8]。

表1 视频及其挑战性因素

4.1 定性分析

通过算法在处理局部遮挡、姿态变化、光照与尺度变化及背景杂波等问题时的跟踪结果来定性分析算法的跟踪性能。

从图5中图像序列Faceocc1跟踪结果来看,对于目标重复遮挡情况,TLD的跟踪不稳定,在200帧左右偏离了目标的实际位置,在第300帧左右又恢复了正确的目标跟踪;ASLA始终未能恢复正确的目标跟踪;MIL在600帧左右之后,产生了较严重的跟踪漂移;SCM和MTT在该视频序列上从始至终获得了较好的跟踪结果;本文方法取得了更准确的跟踪结果。

图5 视频序列部分跟踪结果

从图5中图像序列Faceocc1跟踪结果来看,对于目标旋转和遮挡情况,由于MIL和MTT方法仅考虑全局信息,当目标发生旋转和遮挡时,会产生漂移;ASLA虽然使用结构稀疏模型建模目标,但是它对局部图像的处理是等权重的,在第718帧之后偏离了目标的位置;SCM采用混合模型描述目标,但是遮挡对模型的影响也会干扰到模型的性能,在第700帧左右发生了尺度估计的偏差;本文方法能够适应变化较好,取得了更准确的跟踪结果。

从图5中图像序列Car4跟踪结果来看,对于光照变化和尺度变化情况,TLD在第241帧左右产生了较严重的跟踪漂移,在第431帧左右又恢复了正确的跟踪目标;MIL表现较差,在第241帧左右就几乎丢失目标,之后也始终未能恢复准确的定位跟踪;MTT方法到第241帧左右开始出现较大的跟踪误差,直到跟踪结束也没有恢复对目标状态的正确估计;本文方法和ASLA、SCM在整个视频序列上都表现了良好的跟踪性能。

从图5中图像序列Bolt跟踪结果来看,对于局部遮挡和严重姿态变化情况,TLD、MIL、MTT、ASLA和SCM无法处理目标频繁的姿态变化,因此在跟踪开始后不久就完全失去了目标的真实状态。其中,TLD在第100帧左右产生漂移;MIL、MTT、ASLA和SCM在第15帧左右就产生了较大的跟踪误差,之后丢失目标;本文方法在整个视频上都保持了准确的跟踪。

从图5中图像序列Coke跟踪结果来看,对于光照变化同时又伴随快速移动、平面旋转等复杂性挑战情况,MIL在第20帧左右因Coke罐平面移动而产生跟踪误差,在第40帧左右因严重遮挡而再次偏离了目标的真实位置;ASLA在第40帧左右丢失目标;SCM和MTT虽然开始能够保持对目标的跟踪,但是在第190帧之后发生了偏移;TLD跟踪目标发生漂移;本文方法保持了准确的跟踪。

从图5中图像序列Deer跟踪结果来看,对于运动模糊、快速运动和背景杂波等情况,ASLA和SCM在第10帧时目标模型失效,跟踪发生偏移;MIL在第38帧左右,目标图像由于模糊而失去清晰的边界时,不能准确地描述目标当前的表观,导致跟踪产生误差。TLD在第10帧到第18帧之间、第24帧到第34帧之间发生跟踪漂移;本文方法保持了准确的跟踪。

本文方法采用结构稀疏模型同时对目标的局部信息和结构信息建模,并且通过加权处理增强模型对表观变化的鲁棒性,经过加权处理后,目标模型排除了不稳定的局部区域的干扰,增强了模型对目标表观变化的适应能力,而在模板更新阶段的遮挡检测机制也提升了目标模型对遮挡的处理能力。因此,在目标出现遮挡、旋转、光照变化、尺度变化、姿态变化、快速移动、运动模糊及背景杂波等情况下仍能对其进行有效的描述,降低了跟踪中出现严重漂移的可能。

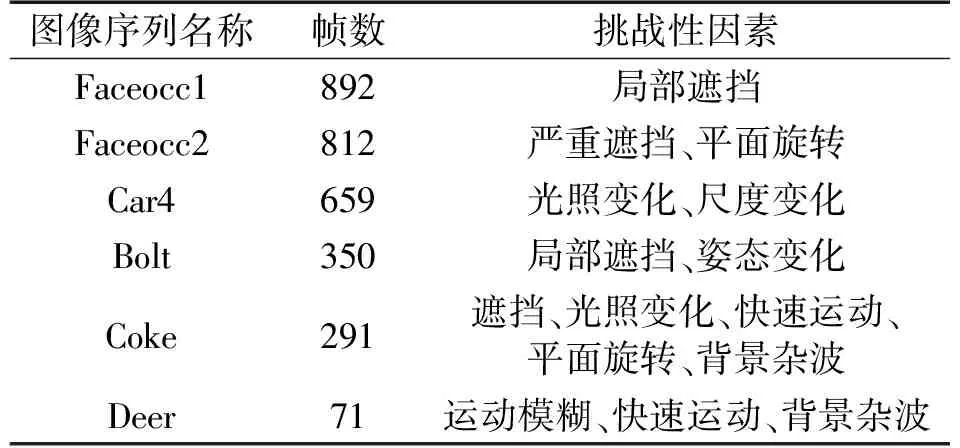

4.2 定量分析

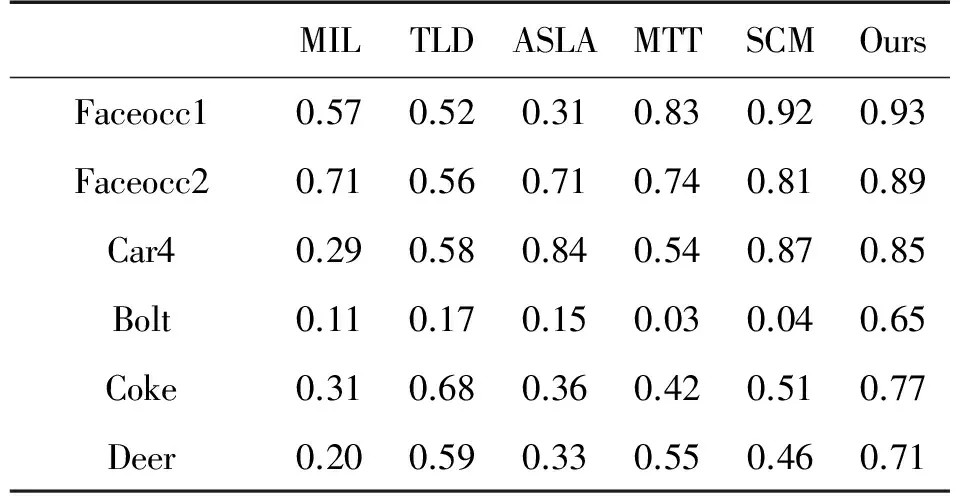

图6 各挑战性因素的TRE成功率曲线

为了能够更为客观地评价跟踪算法的性能,需要制定合理的评价准则。本文采用成功率标准来定量分析跟踪效果,即计算跟踪的重叠覆盖率,该重叠覆盖率考虑了目标的尺度和姿态,能够表明每个算法的跟踪稳定性。已知每帧的跟踪结果RT和真实值RG,则重叠覆盖率定义为:score=area(RT∩RG)/area(RT∪RG),其中符号∩和∪分别代表两个区域的交集和并集,area(·)为区域内像素的个数。当score值大于设定的重叠阈值t0时,则认为该方法在当前图像帧中成功跟踪目标。本文方法和其他对比方法在Benchmark中的51个测试视频序列上进行了定量分析。表2给出了包括本文方法在内的6种方法在测试视频序列上的平均重叠覆盖率。

从表2中的数据可知,本文方法在绝大多数测试视频上都获得了最大的平均重叠覆盖率,这充分证明了该算法的有效性。

表2 各种跟踪方法的重叠覆盖率均值

图6给出了在背景杂波、光照变化、平面内旋转、遮挡、尺度变化和形态变化挑战性因素下跟踪方法在测试图像序列上的时间鲁棒性评估标准TRE(Temporal Robustness Evaluation)成功率曲线,为清晰起见,仅显示排名前6位的跟踪方法的跟踪性能曲线。

从图6所示的跟踪结果曲线可知,本文方法能够充分利用目标局部图像间的结构信息,从而对目标的表观变化具有更强的适应性;对局部区域的加权处理,使得该方法能够有效地捕捉到目标的表观变化;在跟踪过程中,遮挡检测的更新机制,减轻了遮挡对跟踪的影响。因此,本文方法有较好的跟踪准确性和鲁棒性。

5 结论

本文在粒子滤波框架下,提出了一种基于重要性加权的结构稀疏跟踪算法。该方法通过引入仿射变换,使跟踪结果能更好地描述目标的状态;采用结构稀疏表示对目标表观建模,利用了背景判别信息、目标图像局部信息和它们之间的结构信息,减轻了模型退化;根据在表达目标表观时所起的作用,对每个局部图像进行加权处理,进一步提高了目标模型的鲁棒性;在模板更新阶段,通过带有遮挡检测机制的模板更新策略对目标模板进行在线的更新以避免跟踪漂移,从而使得该算法能够更好的适应目标表观的变化。但是,本文方法在光照变化和尺度变化的同时,跟踪性能略差,如何进行混合多种挑战因素的图像序列跟踪是继续研究的目标。

[1] 齐苑辰,吴成东,陈东岳,等. 基于稀疏表达的超像素跟踪算法[J]. 电子与信息学报,2015(3):529-535.

[2] Mei X,Ling H B. Robust Visual Tracking UsingL1Minimization[C]//IEEE International Conference on Computer Vision,Kyoto,Japan,2009:1436-1443.

[3] Zhang T,Ghanem B,Liu S,et al. Robust Visual Tracking Via Multi-Task Sparse Learning[J]. International Journal of Computer Vision,2013,101(2):367-383.

[4] Xu J,Huchuan L,Ming-Hsuan Y. Visual Tracking Via Adaptive Structural Local Sparse Appearance Model[C]//IEEE Conference on Computer Vision and Pattern Recognition,2012:1822-1829.

[5] 郭云飞,滕方成,曾泽斌. 基于QS-ML-PMHT的多目标无源协同定位方法[J]. 传感技术学报,2016,29(11):1753-1758.

[6] Babenko B,Yang M X,Belongie S. Visual Tracking with Online Multiple Instance Learning[C]//IEEE Conference on Computer Vision and Pattern Recognition,Miami FL,USA,2009:983-990.

[7] Kalal Z,Matas J,Mikolajczyk K. P-N Learning:Bootstrapping Binary Classifiers by Structural Constraints[C]//IEEE Conference on Computer Vision and Pattern Recognition,2010:49-56.

[8] Zhong W,Lu H C,Ming-Hsuan Y. Robust Object Tracking Via Sparsity-Based Collaborative Model[C]//IEEE Conference on Computer Vision and Pattern Recognition,Providence,USA,2012:1838-1845.

[9] 彭玉青,李木,高晴晴,等. 基于动态模板匹配的移动机器人目标识别[J]. 传感技术学报,2016,29(1):58-63.

[10] Tianzhu Z,Si L,Changsheng X,et al. Structural Sparse Tracking[C]//IEEE Conference on Computer Vision and Pattern Recognition,Boston,USA,2015:150-158.

[11] 侯跃恩,李伟光,四库,等. 基于排名的结构稀疏表示目标跟踪算法[J]. 华南理工大学学报(自然科学版),2013,41(11):23-29.

[12] Elhamifar E,Sapiro G,Sastry S. Dissimilarity-Based Sparse Subset Selection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2016,38(11):2182-2197.