基于ARAT与视触融合的E手套康复评估与训练系统

2017-08-08李玉赵翠莲费森杰罗林辉上海大学机电工程与自动化学院上海市智能制造及机器人重点实验室上海市200072

【作 者】李玉,赵翠莲,费森杰,罗林辉上海大学机电工程与自动化学院 上海市智能制造及机器人重点实验室,上海市,200072

基于ARAT与视触融合的E手套康复评估与训练系统

【作 者】李玉,赵翠莲,费森杰,罗林辉上海大学机电工程与自动化学院 上海市智能制造及机器人重点实验室,上海市,200072

针对目前用于手功能评估系统的可穿戴式传感数据手套装置结构复杂、灵活性和实用性低下问题,该文为激发患者的主动运动功能,提出了一种基于视触融合的可穿戴式压力传感数据手套装置(EGET系统)。首先,介绍了用于评估手功能的上肢动作研究测试理论,其基本的测试流程及评分准则;其次,分别描述了视觉信息和触觉信息的处理过程,以及视触融合的手功能评估测试方法,实现对患者训练过程的数字化记分和评估;最后,选择10位脑卒中患者使用EGET系统进行手功能测试与评估,并与医生评分进行对比分析,采用EGET系统自动评分相对医生评分的最大相对误差率为8%,平均相对误差率为4%,说明EGET系统能够实现预期的目标。

上肢动作研究测试理论;手功能;评估;视觉;触觉;数据手套

0 引言

手部主要负责运动功能中精细的活动和工作,其灵活程度和运动准确性、与人体日常生活能力、生活质量以及社会活动密切相关。在医疗康复中,脑卒中偏瘫患者存在手部运动功能障碍,帕金森病患者伴有手部震颤、运动迟缓,也会导致手部运动功能障碍;手部功能障碍成为目前康复训练及医学评估的难点问题[1]。鉴于手部复杂多样的运动需求,国内外大量的研究一直致力于设计更好的可穿戴式装置和数据处理方法。

Arata J等[2]与Ma Z等[3]采用外骨骼式机器人手套,检测抓取过程中手的弯曲角度和抓取力,但手套结构复杂,降低了数据手套的灵活性和实用性。Borghetti M等[4]和Carbonaro N等[5]设计的可穿戴式数据手套,采用压阻式传感器检测手指的活动参数,评估手部的日常活动能力,便于穿戴,但其数据信号转换消耗时间较长且传感器易于磨损。Pei-Chi Hsiao等[6]采用加速度传感器、陀螺仪、磁力计和压力传感器等多种传感器设计的数据手套,用于评估手部功能,但数据量大,处理相对复杂。

针对这些问题,本文为激发患者的主动运动功能,提出一种基于视触融合的方法,视觉信息作为全局信息,在空间上跟踪手部和抓取物的同时表达两者间的过程关系,触觉信息作为局部信息,用于弥补视觉空间信息受光线和遮挡等导致的复杂手部抓握动作的数据丢失。视触信息的互补,实现手抓取物移动过程的数字化评估,并将其形成的软硬件系统应用在脑卒中患者的手功能评定上。

1 基于视触融合的EGET系统

E手套康复评估与训练(Electronic Grove Evaluation & Training, 简称EGET)系统是一套针对手功能障碍患者的康复评估与训练的软硬件平台,它以临床医学上的上肢动作研究测试评估量表为基础,将目标检测和跟踪技术、压力传感器采集技术、数据集成技术与康复训练方法相结合,形成了一套软硬结合,可视化评估与训练的康复系统。

1.1 基于ARAT的抓握评估流程

上肢动作研究测试理论(Action Research Arm Test,ARAT)是针对手部运动功能的常用测试评估方法之一[7],与其他常用的评定方法相比,ARAT更关注全方位日常生活中的手功能,并对抓握对象的类型与尺寸也进行了分类和量化。近年来,国内外学者已利用临床案例验证了ARAT的可靠性和有效性[8]。ARAT的测试分为抓、握、捏和粗大运动(将手放置于头后,将手放置于头顶,用手碰嘴巴)四部分共19小项,每项为4级评分,总分为57分。在此基础上,文献[9]提出了更加规范与详细的ARAT评分理论,进行每个小动作时,用时不超过60 s:

(1)当整个动作能够正确完成时,并且用时在5 s内,得3分;

(2)用时在5 s到60 s之间时,得2分;

(3)当整个动作不能正确完成时,得1分;

(4)当完全不能进行任何动作或者不能移动模型时,得0分。

ARAT的抓握对象皆为有标准尺寸的规则几何物体,包括长方体、球体和圆柱体等,如图1所示,模型采用木质材料所制。

图1 ARAT模型Fig.1 ARAT model

本系统采用ARAT中抓和握两部分测试,包含8个小项,共记24分。图2所示为EGET系统手功能评估流程,先进行抓动作,包含6个小动作,分别抓边长为10 cm、2.5 cm、5 cm、7.5 cm的正方体以及直径为7.5 cm的球体和边长为10 cm×2.5 cm×1 cm的长方体;握动作包含三个小动作,分别握直径为5 cm、2.5 cm、1 cm的圆柱体,测试过程中记录项目种类、时间、路径等过程数据,测试结束后打印得分报表。

图2 EGET系统抓握判定测试流程Fig.2 Grasp test flow of EGET system

1.2 基于视触融合的手抓握评定

触觉信息是人类通过手或皮肤与周围物体相接触时感受到的物体的一些状态,如冷暖、外形轮廓和表面粗糙度等。触觉研究的物理信息有接触滑动产生的力大小、接触物表面的温度、触时的压力大小等[10]。通过触觉传感器的信息反馈,能够保证被抓取物体的“软”抓取,而且还可以获取物体的其他信息。Liu H等[11]采用薄膜压力传感器实现物体的分类。Basim Hafidh等[12]采用力敏电阻压力传感器和特殊材料手套制成数据手套F-Glove,用于帮助病人更有效地抓取物体。

目前,针对触觉、听觉、视觉模式之间的信息集成的研究比较多,利用多模式信息之间的互补性和冗余性,使机器人能获得更加全面的外界信息。

本文采用基于视触融合的方法,评估手部抓握动作过程。图3为EGET系统的硬件结构,包含单摄像头、ARAT模型、数据手套、PC机和训练框架等。视觉子系统与触觉子系统分别来自于不同的采集单元,视觉子系统采用分辨率为640×480的彩色摄像头,获取手部抓握目物的训练图像;触觉子系统采用可穿戴的数据手套,实时采集抓握过程中的压力数据,根据人手尺寸分别设计成大和小两种手套。数据手套为多层结构,表面附有彩色标志点,外层与内层采用柔软的棉质手套,压力传感器与数据采集线封装于中间层。压力传感器采用压阻式薄膜传感器,放置于抓握的接触部位。数据采集卡和放大器封装于一体,可通过绷带固定于手臂上,结构简单,且便于穿戴。如图4所示。

图3 EGET系统硬件设备Fig.3 Hardware equipment of EGET system

图4 数据手套Fig.4 Data glove

视觉模块,采用Camshift反馈码本模型的手抓取物跟踪方法,实现多个不同颜色物体的实时跟踪,并获取目标物和手部的实时位置和速度数据,其基本步骤如下[13]:

(1)读入一帧视频图像,在矩形窗口区域上利用码本模型提取前景运动目标,排除背景颜色的干扰;

(2)利用Camshift算法跟踪前景区域中的目标,得到目标的矩形窗口;

(3)矩形窗口的位置利用运动估计预测和尺寸扩大,作为下一帧目标跟踪的搜索窗口;

(4)把所有目标位置预测和尺寸扩大之后矩形窗口的并集反馈为下一帧码本模型前景提取的图像处理区域。

触觉模块根据ARAT模型的尺寸和质量,将训练所用的8个ARAT模型分为三大类;利用加权融合算法对采集的压力数据进行归一化处理,通过实验的方法,得出每一类模型的接触压力阈值,其分别为[14]:0.8,0.5,0.1。

采用的视觉和触觉集成的软硬件系统结构如图5所示,由压力传感器1、压力传感器2和压力传感器3获取触觉压力数据,触觉压力数据经过放大器放大处理之后,再经过采集卡采集、处理并且上传到计算机,计算机对触觉压力数据进行加权集成算法处理。由单摄像头采集到的视觉数据直接上传到计算机,经过Camshift算法得到模型跟踪矩形框的长宽数据,获取相应的模型压力阈值,根据集成的压力值进行抓握判断。抓握判定计算如下,设抓握状态为S:if (F >f ) then S=1, or S=0。

图5 视触集成系统结构Fig.5 Integrated system architecture of visual and tactile fusion

2 EGET系统的实验验证

以某医院接受康复治疗的脑卒中患者为研究对象,选择10位脑卒中偏瘫患者参与使用EGET系统,进行手功能康复评估与训练。其中8位男性,2位女性,均已签署知情同意书。

2.1 测试方法

对10位患者在未穿戴数据手套和穿戴数据手套的情况下进行抓握判断实验,首先由研发者演示整个抓握流程,患者在旁边观看,之后由患者进行抓握判断测试,医生和EGET系统同时记录抓握数据与评分。

2.2 测试结果

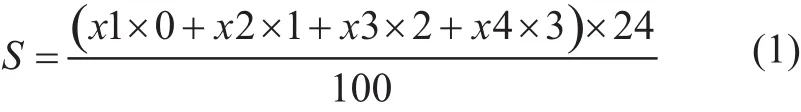

设测试过程中得0分、1分、2分、3分的次数,分别为x1,x2,x3,x4,每位病人的总得分即为S,则:

根据公式(1)计算10位患者医生评估的总得分和EGET系统评估总得分,分别记为S1,S2,则EGET系统评分与医生评分之间的相对误差率η为:

10位患者的医生评估总得分、EGET系统评估总得分以及两者之间的相对误差率分别如图6所示。可知:两者之间的最大相对误差率为8%,平均相对误差率为4%,说明EGET系统能够实现预期的目标。

图6 患者得分对比图Fig.6 Patient score comparison chart

3 结论

本文提出了采用多种传感器即通过压力传感器获取触觉数据与通过单摄像头获取的视觉数据的视触融合的信息处理来判断人手抓握运动,以临床上用于评估手功能的ARAT测试流程及评分准则,形成EGET系统实现手功能康复和训练过程的数字化。并以10位脑卒中患者在未穿戴数据手套和穿戴数据手套的情况下进行抓握判断实验,分别采用EGET系统和医生对抓握训练进行评分,得出EGET系统自动判断的结果相比于研发者判断结果的最大相对误差率为8%,平均相对误差率为4%。研究结果表明:基于视触融合的手功能抓握评估方法能够实现预期的目标。实验中也发现,偶尔会出现数据手套传感器与使用者接触不良,手套上标志点被遮挡无法实时跟踪手部信息等问题。此外,EGET系统中还可以进一步研究手指弯曲时各关节的角度、对指捏力等信息。

[1] Gabriele W, Renate S. Work loss following stroke[J]. Disabil Rehabil, 2009, 31(18): 1487-1493.

[2] Arata J, Ohmoto K, Gassert R, et al. A new hand exoskeleton device for rehabilitation using a three-layered sliding spring mechanism[C]// Robotics and Automation (ICRA), 2013 IEEE International Conference on. IEEE, 2013: 3902-3907.

[3] Ma Z, Ben-Tzvi P, Danoff J. Hand rehabilitation learning system with an exoskeleton robotic glove[J]. IEEE Trans Neural Syst Rehabil Eng, 2016, 24(12): 1323-1332.

[4] Borghetti M, Sardini E, Serpelloni M. Sensorized glove for measuring hand finger flexion for rehabilitation purposes[J]. IEEE Trans Instrum Meas, 2013, 62(12): 3308-3314.

[5] Carbonaro N, Dalle Mura G, Lorussi F, et al. Exploiting wearable goniometer technology for motion sensing gloves[J]. IEEE J Biomed Health Inform, 2014, 18(6): 1788-1795.

[6] Hsiao P C, Yang S Y, Lin B S, et al. Data glove embedded with 9-axis IMU and force sensing sensors for evaluation of hand function[J]. EMBS, 2015: 4631-4634.

[7] Lyle R C. A performance test for assessment of upper limb function in physical rehabilitation treatment and research[J]. Int J Rehabil Res, 1981, 4(4): 483.

[8] 瓮长水, 王军, 王刚, 等. 上肢动作研究量表在脑卒中患者中的信度[C]// 全军中医药骨伤学术会议, 2009: 868-869.

[9] Yozbatiran N, Der-Yeghiaian L, Cramer S C. A standardized approach to performing the action research arm test[J]. Neurorehabil Neural Repair, 2008, 22(1): 78-90.

[10] 董艳茹. 机器人触觉传感器的分析与研究[D]. 燕山大学, 2010.

[11] Liu H, Greco J, Song X, et al. Tactile image based contact shape recognition using neural network[C]// Multisensor Fusion and Integration for Intelligent Systems. IEEE, 2012: 138-143.

[12] Hafidh B, Al Osman H, Alowaidi M, et al. F-Glove: A glove with force-audio sensory substitution system for diabetic patients[C]// IEEE International Symposium on Haptic Audio Visual Environments and Games. IEEE, 2013: 34-38.

[13] 赵翠莲, 王洪, 范志坚, 等. 基于Camshift反馈码本模型的手抓取物跟踪方法[J]. 计算机科学, 2015, 42(12): 297-301.

[14] Guo J, Zhao C L, Li Y, et al. The design of E glove hand function evaluation device based on fusion of vision and touch[M]. Singapore: Springer, 2017.

E Glove Evaluation & Training System Based on ARAT and Fusion of Visual and Tactile Information

【 Writers 】LI Yu, ZHAO Cuilian, FEI Senjie, LUO Linhui

Shanghai Key Laboratory of Intelligent Manufacturing and Robotics, School of Mechatronic Engineering and Automation, Shanghai University, Shanghai, 200072

upper limb action research test theory, hand function, evaluation, visual, tactile, data glove

TP391.9;R49

A

10.3969/j.issn.1671-7104.2017.04.003

1671-7104(2017)04-0244-04

2017-02-07

上海市科学技术委员会重点科技攻关项目(13DZ1941607)

赵翠莲,E-mail:clzhao@shu.edu.cn

【 Abstract 】Aiming to solve the problem of complex structure, low flexibility and practicability for a wearable sensing data glove device of hand function evaluation system, this paper presented a wearable pressure-sensing data glove device based on visual and tactile fusion, which can stimulate the active motor function of patients. Firstly, it introduced the upper limb action research test theory, the basic test flow and the grading rules that used to evaluate the hand function. Secondly, it described the processing flow of visual and tactile information, and the hand function evaluation test method of visual and tactile fusion, which was used to achieve digital score and evaluation of the patient training process. Finally, ten patients with stroke were enrolled into the EGET system for hand function test and evaluation. The results were compared with the doctors'. The maximum relative error is 8%, and the average relative error is 4%, which means that EGET system can achieve the expected goal.