基于改进加权算法的实时图像数据融合研究

2017-06-28方赵林葛春霞秦绪佳

方赵林,彭 洁,葛春霞,秦绪佳

(浙江工业大学 计算机科学与技术学院,浙江 杭州 310023)

基于改进加权算法的实时图像数据融合研究

方赵林,彭 洁,葛春霞,秦绪佳

(浙江工业大学 计算机科学与技术学院,浙江 杭州 310023)

在三维重建、多维数据融合和信息可视化分析等领域中,针对实时视频图像数据拼接融合的过程中常出现的拼接缝隙问题,提出了一种改进的加权融合实时图像拼接方法.该方法将视频拼接问题转化为视频对应帧图像的融合问题,通过利用SURF算法对特征数据点进行提取与匹配,对图像使用RANSAC算法和LM算法求其几何变换矩阵,再根据变换矩阵进行图像插值拼接,对拼接线区域图像内容进行加权处理完成视频图像融合.在进行图像融合处理时,提出了基于拼接线一侧加权融合和基于原图内容的加权融合算法.实验结果表明:该方法实现的拼接融合速度快、效果较好,适用于对速度和拼接效果均有要求的场景视频拼接和实时数据呈现.

视频拼接;加权融合;实时;无缝拼接

在对信息化系统产生的多维数据进行融合的过程中,常需要处理实时图像数据的拼接融合问题.图像拼接是指把具有重叠区域的两幅或多幅小视域的图像拼接成一幅无缝隙的大视域图像[1],其中待拼接图像可以是同一场景在不同时间、角度、信息采集系统上获得,这一技术被广泛地用在数据分析、数字视频、虚拟现实技术等领域.由于视频是由大量静态的图像数据拼接而成,因此视频拼接的核心是图像拼接[2].纵观现有的关于图像拼接的研究,常规的图像拼接方法为满足观测的需要,主要注重拼接质量,而忽视了拼接实时性[3].然而,与图像拼接的相比,视频拼接更看重实时性.由于视野范围、光照变化和尺度缩放等因素会影响获取的视频质量,所以视频拼接的研究重点是在确保视频拼接有高效的实时性的同时还具有较好的拼接效果.针对动态视频拼接技术,一般利用LM算法计算待配准图像之间的几何变换关系,然后利用变换关系进行视频帧图像的配准与拼接[4].2001年Hsu等[5]提出了一种将运动物体和场景分离技术统一起来的视频图像拼接算法,该算法通过Melin变换计算运动参数,利用帧差法检测出运动物体,对视频帧图像拼接,并将分离出的运动物体合成到拼接视频序列中.2009年Lin等[6]提出一种基于HashMap的特征匹配的快速视频拼接算法,该算法先采用具有旋转不变特性的SURF特征检测算法检测特征点,然后进行HashMap的特征匹配,提高了特征匹配的速度.针对虚拟漫游系统的实时视频拼接,陈夏艳等[7]提出通过提取场景的距离特征,利用序贯相似性检测算法来确定出图像的重叠区域.同时为提高图像拼接质量,可先进行消除镜头畸变,再对图像拼接融合[8].针对视频图像的全景拼接,范菁等[9]提出基于显著性区域来生成带约束关键帧的全景图,并利用CUDA进行优化.在拼接融合领域,一般的拼接方法均是对重叠区域进行加权融合,其融合效果较差.目前较好的融合方法是基于最佳缝合线方法[10],但最佳缝合线方法往往计算量大,不适合视频实时拼接融合.针对实时视频拼接,通过深入研究,使用基于拼接线一侧的加权融合算法和基于原图内容的加权融合算法,较好地克服了传统加权融合算法中出现拼接线的不足,实现对图像的高质量、快速度的融合拼接.

1 视频图像实时拼接

大场景的视频拼接应用中,常采用多系统进行数据采集,然后拼接成一个大场景的视频.在同一环境中,数据采集位置通常固定不动,每对图像拼接帧间的变换矩阵是相同的.因此,一般只需选择一对拼接帧来计算拼接矩阵,其他帧对与此类似,直到达到实时拼接同步播放的效果.

1.1SURF算子

SURF算子在SIFT算子的基础上进行了改进[11],它对关键点周围的局部领域信息进行统计,将其作为局部特征来描述,而这种特征跟尺度大小是没关系的,是一种基于尺度不变特征的图像局部描述算子.

1.1.1 尺度空间的生成

在生成金字塔尺度空间时,SURF需不断增大盒子滤波器模板和积分图像,计算Hessian矩阵响应来快速生成尺度空间.构建尺度空间需使用Hessian矩阵探测器检测斑点,通过高斯LaplacianLog探测器的响应值进行判断否存在斑点.当斑点的形状和通过Laplacian函数生成的形状趋势基本一致时,并且利用图像和高斯二阶导数卷积得到的Laplacian响应值也达到最大,便可判定其为斑点.在斑点检测过程中,关键点在于使用高斯二阶微分计算得出Hessian矩阵,其定义为

(1)

这里,假设p(x,y)表示任一像素点位置,σ为高斯卷积尺度参数,那么图像中的Hessian矩阵可表示为

(2)

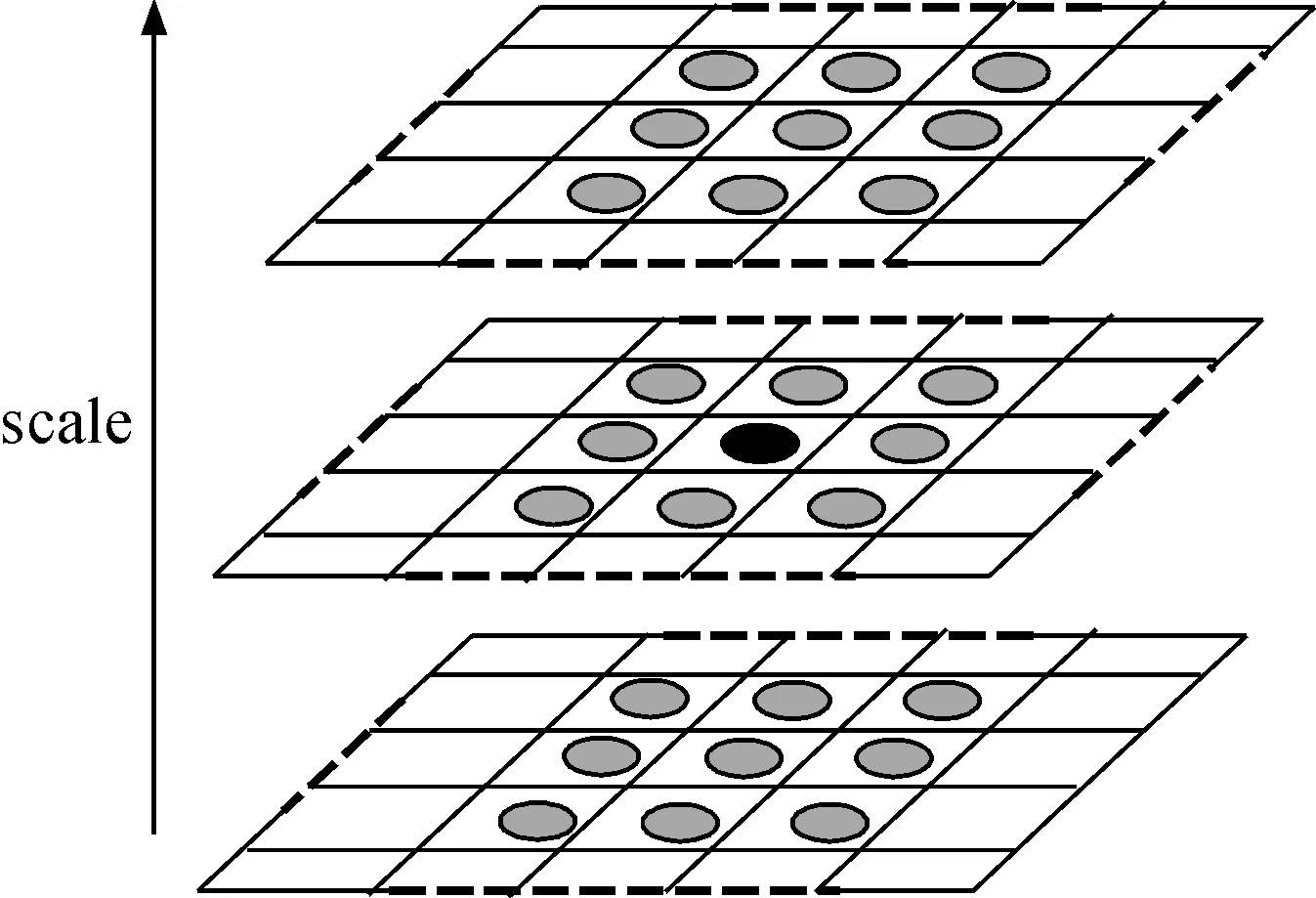

1.1.2 定位极值点

为了在图像及不同尺寸中找出极值点的精确位置,采用3×3×3邻域的非极大值抑制.通过计算图像像素点的Det(H)值可以初步确定图像的局部极值点位置,将该点邻域周围26个点的Det(H)值与该点的Det(H)进行比较,发现均比该点大,则可初步确定该点为初始特征点.具体判定过程如图1所示.

图1 极值点判定Fig.1 Extremum point decision

1.1.3 确定特征点主方向

以特征点为中心,从其不同方向中选取一个作为主方向,即使发生旋转,特征向量仍保持一定的稳定性.通过引入Harr小波[12],计算出特征点在x和y方向上的梯度响应值,确定其主方向.假设特征点所在的尺度空间单位大小用s表示,以样本的特征点为圆心画一个半径为6 s的圆形范围,取所有Harr小波尺寸不大于4 s特征点的梯度响应值.此外,特征点权值应根据特征点到圆心的距离来判定,距离圆心越近其权值越大,反之越小.为保证整个圆形区域都包括在内,设置了6个60°的扇形窗口,分别计算各扇形窗口的Harr小波响应值的累加和(mw,θw),计算公式为

(3)

(4)

通过累加6个扇形区域的矢量和得到mw,则mw最大的区域的方向就是最终主方向,其中,主方向θ可确定为

θ={θw|max(mw)}

(5)

1.1.4 生成SURF特征点描述符

确定了特征点的主方向后,需生成SURF特征点的具体描述符.首先把特征点作为中心,沿主方向在中心位置处选取20 s×20 s的正方形窗口区域,并在区域内计算Harr小波梯度响应值.计算响应值过程中,首先将20 s×20 s的大窗口区域划分为4×4个子窗口,然后在各个子窗口内,分别计算在x和y方向的Harr小波梯度响应值dx和dy.最后计算各个窗口在x轴和y轴的Harr小波响应值dx和dy的累加值以及在x轴和y轴的图像灰度值变化极性的信息|dx|和|dy|的累加值.最终各子窗口均得到一个四维特征矢量V,也称为特征点描述符,具体表示为

V=(∑dx,∑|dx|,∑dy,∑|dy|)

(6)

由上,在20 s×20 s的正方形窗口区域内共生成的特征描述符有4×4×4=64位.而且当图像发生旋转、分辨率变化和受光照不均时生成的SURF特征描述符均具有稳定性.

1.2RANSAC配准

对于两个特征点描述符间,使用SURF算法计算其欧氏距离,假设某个特征点描述符为qi,与qi的欧氏距离由近至远的特征描述符分别记为qi1和qi2.当r0=qi/qi1与r1=qi/qi2的比值小于阈值,说明匹配正确,即将点(qi,qi1)看做输入图像的成功匹配点.虽然该方法方便快捷,但有一定的弊端,它会产生误匹配,通过RANSAC算法得到图像变换矩阵H将会有效减少误匹配的点对,具体流程如下:

1)首先随机选取4组匹配点作为一个随机样本并计算该样本的几何变换矩阵H,然后计算与H变化趋势一致且距离不大于d的匹配点数,即内点数.在经过多次采样之后,如果内点数不相等,则选择内点数最多的变换矩阵H作为变换矩阵的初值,否则选择内点标准差最小的变换矩阵H作为变换矩阵的初值.

2)通过将几何变换矩阵H迭代,为全部内点重新估计H,利用LM算法使代价函数达到最小化.

3)使用上一步得到的变换矩阵H定义附近搜索的区域,进而达到使特征点精确匹配的效果.

4)重复迭代步骤2,3直到匹配点数目稳定为止.

2 改进的加权融合算法

进行图像融合操作,关键要处理好多图像间的重叠区域,使形成一幅完整平滑的大视域图像.在实时视频拼接的过程中,视频融合不仅要求满足最基本的画面质量,还要求满足一定的实时性.因此改进的加权融合算法的目标就是在不改变融合质量的同时,尽量缩短融合拼接的时间开销.

2.1 融合插值思想

进行图像融合操作的前提是图像配准,图像配准首先对配准图像进行平移、缩放、旋转等几何空间变换的处理,同时计算从配准图像空间投影到基准图像空间的变换矩阵.由于经过空间变换后的配准图像会丢失部分图像信息,这会直接导致图像失真或是模糊不清,为改善这一状况,采取图像插值技术对原图进行处理.在一般的应用中,线性插值技术不但能够满足图像高质量的基本需求,而且算法简单,运行速度相对较快;而非线性插值技术虽然可以满足图像高质量的需求,但是算法复杂,运行速度相对慢,所以该算法并不适宜用在对时间要求比较严格的场景中.

传统的图像拼接算法一般在图像配准后使用渐入渐出式加权平均融合算法[13]和双线性插值算法来完成图像拼接的基本融合过程.加权融合算法的公式为

(7)

式中:d1(x,y),d2(x,y)分别为加权系数,两者和等于1.上述组合算法仅适用某些拼接的场景,但当某些图像的空间几何变换较大时,仍旧会存在一条较明显的拼接缝.

传统的加权融合算法的优点是算法简单、运行速度快,常适用在对时间要求严格的场景中,但该算法运行过程中偶尔会出现不稳定,图像有锯齿状拼接线的现象.针对加权融合算法中出现的拼接线现象,提出了一种基于拼接线一侧的加权融合和基于原图内容的加权融合的改进算法.该算法证实了双线性插值算法并没有完全解决边缘不平滑的问题,从而解释了拼接线出现的原因,进而提出了利用拼接线一侧的内容和原图内容重新对拼接线进行插值的一种改进的算法.

2.2 基于拼接线一侧的加权融合算法

基于拼接线一侧的加权融合算法具体思路如下:计算拼接后图像的拼接线的位置,然后在加权融合时,若遇到拼接线像素点,则将参考图像的像素点的值直接赋值给对应的拼接线像素点上,否则就利用传统的加权融合算法处理.之所以将参考图像的像素点的内容直接赋值给拼接线像素点,是因为参考图像的内容较真实且未做过任何的几何变换,而经过图像变换的配准图像的边缘处(即拼接线)存在不平滑的现象,因此在对拼接线处进行的加权平均融合时仅取参考图像一侧的像素点,舍弃误差较大的配准图像的边缘.由于在进行视频拼接时,图像除了拼接线处,其他区域基本不受光照等因素的影响,因此在使用加权融合算法对拼接线处进行平滑性的过渡处理后,不会出现因二次插值引起再次出现拼接线的现象.该算法的具体步骤如下:

1) 计算拼接线.由于在视频拼接过程中,经过几何变换后图像的边缘线仍是直线,所以加权融合算法中出现的拼接线也一定是直线.本算法假设拼接线的方程式是y=kx+b,首先对原图像的4个顶点进行图像变换,然后对产生的新顶点坐标进行计算便可得到该拼接线的方程.

2) 选择合适的阈值判定.确定了拼接线方程之后,接下来重点是寻找该拼接线内的像素点,假设某像素点的坐标为(i,j),判定该像素点是否在拼接线内,其公式为

|j-(ki+b)|<θ

(8)

其中:θ代表要判定的像素点是否在拼接线内的阈值,其取值范围为[1,2],θ值不能太大也不能太小.若θ过小,拼接线不能完全覆盖锯齿区域;若θ过大,拼接线区域过大可能会导致产生新的拼接线.因此,选择一个合适的阈值是寻找拼接线内像素点的关键.

3) 在拼接线区域选择一侧图像内容.如果像素点在拼接线区域内,就把参考图像的像素直接赋值给与拼接结果图对应的拼接线像素点,如果不在拼接线区域内,则按照传统的加权融合算法对图像进行图像融合操作.

2.3 基于原图内容的加权融合算法

基于原图内容的加权融合算法的具体思路,首先利用原图像对配准后图像的边缘处进行插值处理,接着再对边缘插值后的配准图像和参考图像进行传统的加权平均融合处理.该算法在消除配准图像边缘的锯齿误差的基础上进行加权融合,由于对原图进行插值后可能会出现新的拼接缝,这种做法能对新拼接缝进行加权融合,大大降低了新拼接线出现的概率.该算法的具体步骤如下:

1) 计算拼接线.

2) 选择合适的阈值判定.

3) 对拼接线处进行原图内容插值.如果像素点在在拼接线区域内,即在配准图像的边缘处,则可以利用图像变换矩阵的逆运算,把原图位置的像素点值赋值给与之对应的配准图像上的点.

4) 加权融合两幅图像.对配准图像进行原图内容插值操作后,再将其与参考图像进行渐入渐出式加权平均融合处理,就得到由两幅图像融合拼接而成的无缝隙的整体图像.

3 实验结果及分析

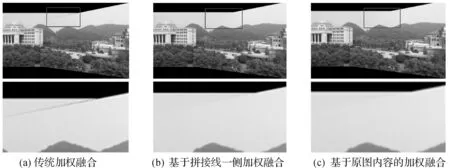

通过使用Visualstudio2010软件在PC机上对算法进行了实现.图2为输入视频,图3(a~c)为分别采用传统加权融合算法、基于拼接线一侧加权融合算法和基于原图内容的加权融合算法对图2的两个输入视频进行拼接后的融合效果图,其中划线方框内出现的虚线是拼接产生的拼接缝隙.图3中第2行是第1行图中划线方框部分的局部放大图.

图2 输入视频Fig.2 Input videos

图3 不同加权融合算法的视频拼接结果Fig.3 Videos stitching result with different weighted fusion algorithms

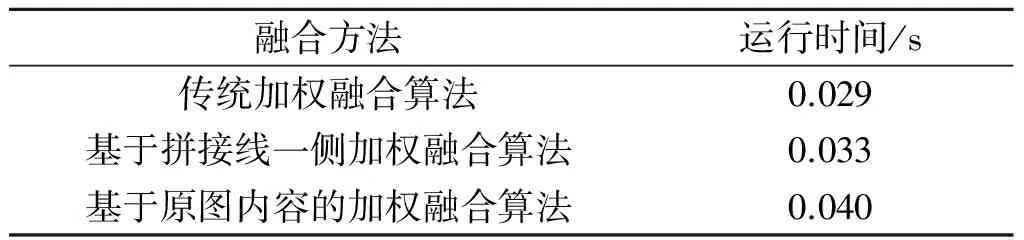

通过对比观察图3中的融合效果图,尤其是各融合图中的画框区域,我们发现改进后加权融合算法不但具有融合效果较好、明显消除拼接线和拼接区域的图像亮度一致等优势,而且没有造成因二次插值导致的新拼接线现象的出现.此外,由于计算拼接线的时间是线性时间,而且在对图像重叠区域加权融合时仅需增加判断像素点是否在拼接线区域内这一步.表1数据说明基于拼接线一侧的加权融合算法在提高了图像融合效果的同时几乎没有增加额外时间.而基于原图内容的加权融合算法由于采用了渐入渐出式加权平均融合处理,运行代价略有增加,但整合效果更好.

表1 不同加权融合算法性能分析

Table 1 Performance analysis of different weighted fusion algorithms

融合方法运行时间/s传统加权融合算法0.029基于拼接线一侧加权融合算法0.033基于原图内容的加权融合算法0.040

可见,基于拼接线一侧的加权融合算法和基于原图内容的加权融合算法,改进了传统的加权融合算法,融合效果好、速度快,非常适用在实时视频拼接中.

4 结 论

基于SURF特征匹配算法提出并改进了传统的加权融合视频拼接方法,通过提取图像的SURF特征点,进行特征匹配以及计算特征点的几何变换矩阵来求得输入图像的重叠区域,最后利用提出的改进算法进行图像融合.对于要求速度快且融合质量比传统融合方法略高的应用,可采用基于拼接线一侧的加权融合算法,对于要求融合质量高的场合,可采用基于原图内容的加权融合算法.对于数据采集面固定的视频,只要取一个视频对应帧来计算变换矩阵,其他视频帧的拼接变换采用同一变换矩阵,然后进行加权融合,可达到实时拼接和融合.实验证明,改进加权融合算法在实时视频拼接的图像融合过程中耗时较少,并且可得到的拼接效果良好的实时视频.

[1] ZOMET A, LEVIN A, PELEG S, et al. Seamless image stitching by minimizing false edges[J]. IEEE transactions on image processing,2006,15(4):969-977.

[2] LI Jing, XU Wei, ZHANG Jianguo, et al. Efficient video stitching based on fast structure deformation[J]. IEEE transactions on cybernetics,2015,45(12):2707-2719.

[3] 王小强,陈临强,梁旭.实时全自动视频拼接方法[J].计算机工程,2011,37(5):291-292.

[4] SZELISKI R. Video mosaics for virtual environments[J]. Computer graphics & applications,1996,16(2):22-30.

[5] HSU C T, TSAN Y C. Mosaics of video sequences with moving objects[J]. Signal processing-image communication,2004,19(1):81-98.

[6] LIN Wu, HONG Jingxin, ZHANG Hao, et al. A fast feature-based video mosaic[C]//6th International Symposium on Multispectral Image Processing and Pattern Recognition. YiChang: SPIE,2009:49-55.

[7] 陈夏艳,伍先达.基于距离特征的自适应阈值视频拼接算法[J].模式识别与人工智能,2010,23(5):727-730.

[8] 刘畅,金立左,费树岷,等.固定多摄像头的视频拼接技术[J].数据采集与处理,2014,29(1):126-133.

[9] 范菁,吴佳敏,叶阳,等.带显著性区域约束的高效视频全景拼接方法[J].浙江工业大学学报,2015,43(5):479-486.

[10] 秦绪佳,王琪,王慧玲,等.序列遥感图像拼接的最佳缝合线融合方法[J].计算机科学,2015,42(10):306-310.

[11] BAY H, ESS A, TUYTELAARS T, et al. Speeded-Up robust features (SURF)[J]. Computer vision & image understanding,2008,110(3):346-359.

[12] JIN G, YAN Y, WANG W, et al. Optical harr wavelet transform for image feature extraction[C]//International Conference on Mathematical Imaging: Wavelet Applications in Signal and Image Processing. San Diego: SPIE,1993:371-380.

[13] BERT P J, ADELSON E H. A multiresolution spline with application to image mosaics[J].ACM transactions on graphics,1997,2(4):217-236.

(责任编辑:刘 岩)

Improved weighted algorithm for real-time image fusion

FANG Zhaolin, PENG Jie, GE Chunxia, QIN Xujia

(College of Computer Science and Technology, Zhejiang University of Technology, Hangzhou 310023, China)

In various fields including 3D reconstruction, multidimensional data fusion and information visualization, in the stitching process of real-time video data, the splicing gap problem often appears. An improved weighted fusion algorithm for real-time video stitching is presented. In this algorithm, the problem of video stitching is transformed into the corresponding frame images stitching. The image stitching algorithm is based on SURF (Speed Up Robust Features). Firstly, SURF is used for extracting and matching feature points. Then, the geometric transform matrix of image based on RANSAC(Random Sample Consensus) algorithm and LM (Levenberg-Marquard) algorithm is calculated. Interpolation operation is performed for stitching the images with the transform matrix. Finally, the image content of the stitching region is weighted to complete the stitched image fusion. In the fusion process, the merging line side based weighted fusion and image content based weighted fusion methods are proposed. Experimental results show that the proposed fusion algorithm has the advantages of fast processing speed and good effect, and it is suitable for the scene video stitching and real-time data presentation with requirement of the stitching speed and the effect.

videos stitching; weighted fusion; real-time; seamless stitching

2016-12-28

国家自然科学基金资助项目(61672462);浙江省科技计划资助项目(2016C33165);浙江省高校实验室工作研究项目(ZD201608);浙江省教育技术研究规划课题(2016JB005)

方赵林(1972—),男,浙江诸暨人,高级工程师,研究方向为图像数据处理、网络技术及应用,E-mail:fzl@zjut.edu.cn.

TP391

A

1006-4303(2017)03-0325-05