边缘和对比度增强的NSST域红外与可见光图像融合

2017-03-22吴冬鹏毕笃彦马时平何林远

吴冬鹏,毕笃彦,马时平,何林远,张 跃

边缘和对比度增强的NSST域红外与可见光图像融合

吴冬鹏1,毕笃彦1,马时平1,何林远1,张 跃2

(1. 空军工程大学 航空航天工程学院,陕西 西安 710038 2. 中国人民解放军93787部队,北京 100076)

为了将红外图像的全局信息与可见光图像的细节信息进行有效结合,进一步提高融合后图像的质量,提出了一种同时增强图像边缘细节和对比度的非下采样剪切波变换(NSST)域红外和可见光图像融合方法。首先,通过平移不变剪切波将图像分解成为低频子带与高频子带,通过全局显著性图分析图像的对比度信息;利用改进型局部显著度图分析图像局部边缘信息。针对不同频带系数,结合边缘信息和对比度信息对频带系数进行融合,最后,利用逆变换得到最终的融合图像。大量实验结果表明,本文方法在提高图像整体对比度的同时增强了图像的边缘细节表现能力,优于现有的基于小波变换,非下采样轮廓波变换(NSCT)和显著度图等几种图像融合方法。

图像融合;红外图像;可见光图像;非下采样剪切波变换(NSST);显著性图;对比度增强;边缘增强

0 引言

图像融合是将多个图像信息加以综合,以获取关于图像对象更加准确的描述[1],随着传感器技术的不断发展,多源图像融合能够发挥不同传感器之间的优势,得到内容更加丰富,信息更加全面的融合图像。其中,红外与可见光图像融合近几年因其在多个领域的作用被越来越多的学者研究。

红外图像具有很强的目标指示性,能够避免遮挡,烟雾等环境的干扰,具有强对比度;可见光图像具有丰富的背景信息,细节信息,但其易受环境干扰。因此,如何有效结合两种传感器的信息,同时避免虚假信息是这一问题的关键。

在早期的研究中,融合方法主要有加权法,主成分分析法等基于空域的方法,但这类方法局限于空间中像素点的处理,容易产生频谱混叠,不能同时兼顾图像的整体信息与细节信息;随着多分辨率分析技术的发展,越来越多的方法被运用到这一领域,Pajares[2]等利用小波进行融合,但是方向信息表现不足,不能很好地反映图像边缘;Do[3]等人提出了轮廓波(Contourlet)变换,刘坤等人[4-5]也基于轮廓波提出了一些融合方法,但是轮廓波自身构造过繁,运算复杂度高,针对这一不足,Guo[6-7]等提出了剪切波(Shearlet)变换,实现了图像的最优的多分辨率分析,非下采样剪切波变换(NSST)[8]是对剪切波变换的改进,能够克服伪吉布斯现象的产生,是图像进行不同频带融合的最佳工具[9]。

多尺度工具的运用能够很好地在不同的频带上处理图像信息,但是融合规则相对较简单,不能同时对图像的对比度和细节信息进行增强,得到的融合图像不利于后期人眼和计算机处理,因此,基于人眼视觉机制的融合规则研究也越来越受到重视。

随着对人眼视觉机制的研究,其中的显著性信息越来越多地被运用在图像处理,图像检测等领域,早期的视觉机制下的显著性检测方法由Itti[10]等人提出,主要是基于空间,亮度等信息;但是对于灰度图像,更多的应该考虑其频带信息。文献[11]中,Meng等人直接利用显著性信息和感兴趣点作为测度函数,图像显著性目标得到很好的表现,但是其目标边缘细节处理不够明显,造成目标边缘模糊;文献[12]中,Zhang等人将显著性分析与NSST结合,但是其在融合时分离了显著性与NSST,没有考虑红外与可见光图像间的信息的互补性,使得融合结果不能同时考虑图像的对比度与边缘信息。

为同时增强图像对比度与边缘细节信息,提高融合后图像的质量,本文提出了一种边缘与对比度增强的基于NSST域红外和可见光图像信息互补融合算法。对不同源图像分别进行非下采样剪切波变换;基于对比度与边缘信息兼顾和信息互补原则对高低频子带系数分别进行融合,充分发挥显著性分析的优势,提高融合图像质量效果。

1 基本理论

1.1 平移不变Shearlet波变换理论

Shearlet变换理论由经典的仿射系统理论[6]发展而来,能够有效地将几何算法与多尺度分析方法进行结合。在二维空间中,仿射系统可以表示为式(1):

式中:∈2(2),是可积空间;代表实数集合,表示整数集合。和为2×2维的可逆矩阵,且|det|=1。在仿射系统中,对任意函数∈2(2),若()都满足紧支撑条件:

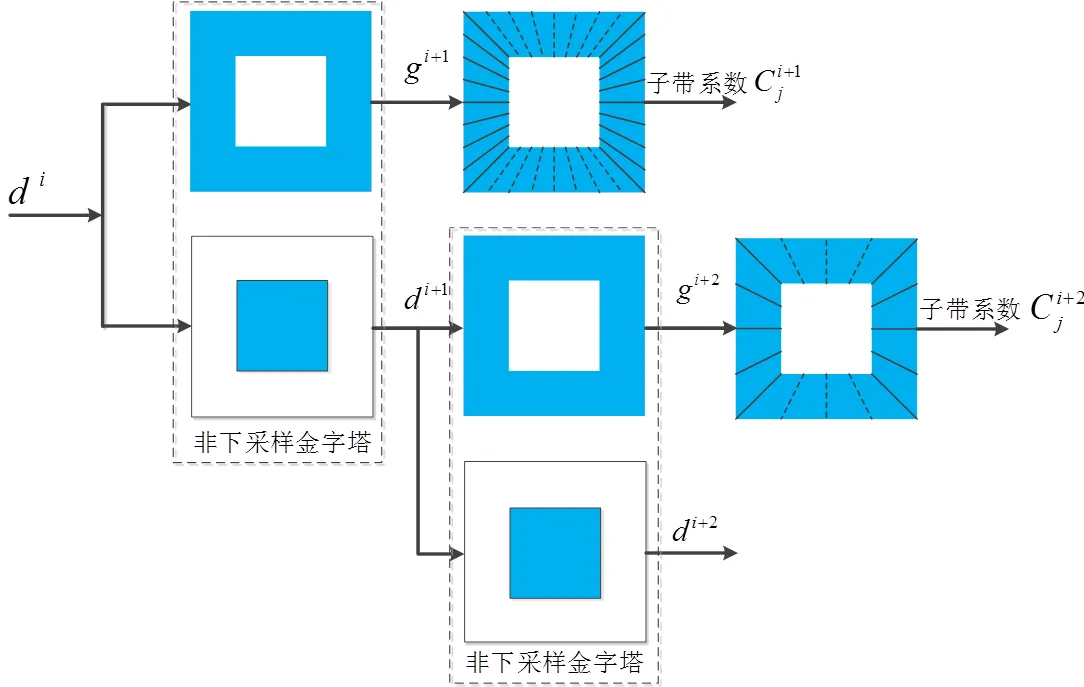

则称,l,k为合成小波。当=0=[, 0; 0,1/2]且=0=[1, s; 0, 1]时,这种特殊的合成小波称为剪切波。此时,矩阵称为各向异性膨胀矩阵,控制图像的尺度变换;矩阵称为剪切矩阵,控制图像各尺度中的子带方向。一般情况下,=4,=1。NSST的离散化过程主要是利用多尺度分解和方向局部化两个步骤,分别利用非下采样金字塔和非下采样剪切滤波器完成。

图1展示了一幅图像经过剪切波变换在频域内的展示图,从图1可以看出图像经过剪切波能够在不同的尺度上进行处理,并且能够表现不同的方向信息。

图1 图像经非下采样剪切波变换示意图

1.2 显著性图构建理论

Itti[10]等众多学者最早提出了在空间域中显著性图的构造法,能够很好地考虑图像的空间结构信息以及光照等因素的影响,但是图像的不同频带信息易混叠。对于灰度图像,针对空域构建显著度的不足,将显著性图的构造方法转移到频域更易分析图像的高低频子带特性[13-15],文献[15]的方法能够构造图像的不同类型显著度图。

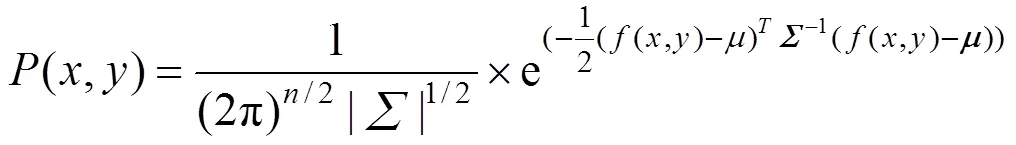

式中:()=[1(,) ,…,f (,)]是点(,)在每层特征图中对应的特征值;=[((,)-)((,)-)]为所有特征图的协方差矩阵;=[1,E,…,E]为期望向量,E为特征图T的期望。

通过式(4),构建全局显著性图:

式中:I×表示高斯低通滤波,防止构建的显著度矩阵中出现噪声,全局显著度图取5;运算是为了确保熵矩阵中值为正数,若为零则替换为矩阵中非零的最小值;运算是为了对计算结束的显著度图进行归一化操作。

局部显著性图的构建利用多层特征图进行简单加和:

2 本文融合算法

在利用显著度图对多源图像进行融合时,文献[13]中采用直接加权法则,易造成细节信息的丢失,文献[14]利用显著度图进行融合前的预处理,能够显示出显著性目标,但是不能同时考虑高低频信息的完整性。针对高低频子带间信息的差异,基于对比度和边缘增强的原则提出更加针对性的融合规则。针对低频系数,增强融合后图像的对比度信息;针对高频子带,首先改进局部显著性图,分析源图像间边缘的相关性,增强边缘细节。图2给出了整体融合规则流程图。

2.1 低频融合规则

通过平移不变剪切波变换将一幅图像分解,得到与原图像大小相同的低频近似图像。图像的低频信息携带了图像场景的主要对比度与全局信息,因此,在融合低频信息时将全局显著性图作为衡量标准,有助于图像特定目标的显示并能够提高图像对比度信息。低频融合规则构建如下:

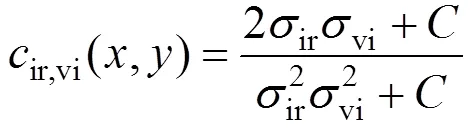

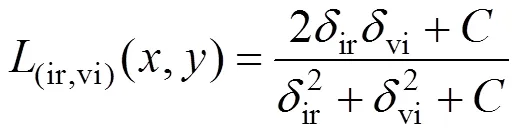

首先构造红外与可见光图像的对比度间的相似度函数:

式中:ir、vi分别表示了红外与可见光图像在点(,)处局域窗口的标准差;为一常数,为了避免出现分母为零的情况出现。该值越大,表明两幅图像的相关性越大,此时这一区域的对比度在两幅图像中处于相似水平,不易作为提升区域;相反,值越小,两幅图像间相关性越小,该区域在两幅图像中对比度有较大差异,这类点正是需要进行对比度增强的关键点。本文选取一阀值用来控制低频融合规则的选择,经实验发现的最佳取值为0.6:

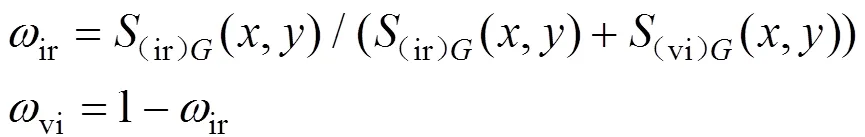

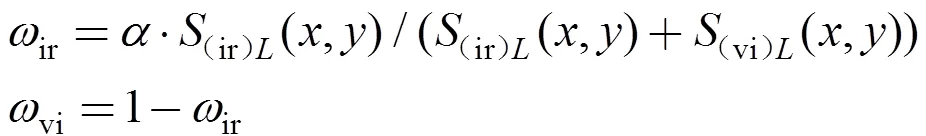

公式(7)表示了当相关性值处于不同区间时采用的不同的融合规则,具有更强的针对性,其中两者的权重利用全局显著度图来进行衡量,如式(8):

2.2 基于Kirsch算子的局部显著图改进

在文献[16]中,局部显著性图的构建直接利用了简单加和的原则,如公式(5)所示,对特征值求加和,能够将图像局部的显著性区域进行表示,但是因为这样处理,局部区域细节信息丢失严重,如图3(a)和(c)所示,原局部显著性图只能捕获到图像局部的显著性点,并没有将局部边缘细节信息进行保留。

为保留图像局部边缘信息,同时体现图像显著性,在局部显著性图构建时引入局部方向模型[14]对进行边缘检测,同时将模型的边缘信息与局部显著性信息进行结合。得到同时表示局部显著度又保持边缘信息的显著性图。

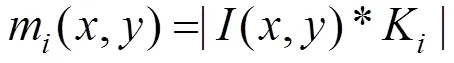

局部方向模型中,能够很好地展现图像整体边缘的是Kirsch算子,利用算子算法,实现对图像的多方向的边缘检测:

式中:(,)表示以(,)为中心的3×3的图像块,与Kirsch算子K进行卷积运算,得到的响应值记做m()。

通过阀值来确定边缘特征并且将边缘特征合并得到完整多方向性的图像边缘,如式(10)和式(11):

通过两式,将图像边缘进行完整表示,并且具有很好的多方向性。

通过(,)改进局部显著度图,是局部显著度图能够保留图像局部细节边缘信息,增强融合后图像的细节表现能力。

通过公式(12),局部显著度图能够将连续边缘保留在显著性图中,在对高频子带处理时,能够尽可能多地融合边缘信息,提高融合后图像质量。

通过图3的对比发现,改进后的显著图能够很好的将图像的边缘信息通过Kirsch算子进行保留,验证了改进后局部显著图的有效性。

2.3 高频融合规则

高频信息在图像中表现为图像的边缘与细节,与低频信息类似,高频系数的融合应该能够更好地保存图像的细节边缘信息,将两种传感器的信息进行互补。融合高频信息前应先选择信息互补区域。

红外与可见光局部显著性图表示为:S=[ S(ir)1, …,(ir)L, … ,(ir)L]与(vi)L=[(vi)L1, …,(vi)L, …,(vi)L]。为了更有利地融合高频部分系数,首先对显著性图之间的相关性进行定量计算,显著度图相关性的计算如公式(13):

图3 改进后局部显著图与原显著图对比

式中:r和vi分别表示像素点(,)与其距离为1的像素点的标准差,则(ir,vi)(,)表示为两图像之间的相关性。当相关性较大时,标明此点所在区域在两幅图像中同时具有较好的边缘特性,此时选取较大值者;若相关性较小,则需要对两幅图像的此区域高频系数进行融合,得到更好的高频系数,如公式(14):

权重系数的计算如式(15),其中为分区权重,如表1所示。

表1 a的取值

经过式(15)得到了融合后图像的高低频系数,通过平移不变剪切波的逆变换,可以得到融合后的高质量图像。

3 实验结果与分析

为了验证本文算法的有效性,在MATLAB 2014a平台(处理器为Intel core 双核,主频3.2GHz,内存4GB)上,将本文算法与基于小波、NSCT、显著度、NSCT-显著度和NSST五种融合算法结果进行比较,比较发现本文算法在提高图像整体对比度的同时能很好地保留细节信息。如图4、图5所示,本文分别展示了两组实验的对比结果。选择已经配准好的红外与可见光图像作为实验数据,实验参数设置在NSST中,方向分解级数取3,各层带通方向子带数目为8,8,16。采取主观评价与客观评价两种方法对融合结果进行评价。

3.1 主观评价

图4能够很好地体现本文算法在展示细节边缘时的有效性。

从第一组实验结果比较分析可得,如图4所示,本文算法在提高图像整体对比度的同时能够很好地表现细节图像;观察图像右上方交通灯区域展示了本文方法在处理多方向性细节边缘时,能够很好地保留细节信息,圆形边缘更加平滑;观察右下角人物区域显示了算法在处理人物边缘时,相比较小波以及基于NSST算法,能够更好地抑制边缘的黑色光晕,相比较单独的显著度算法和NSCT-显著度,对边缘的刻画更加精细;图中左上角文字区域可以看出本文算法在处理对比度与边缘时的共同作用,与基于显著度算法相比,文字细节更清晰,而且相比较基于NSCT和基于NSCT-显著度算法,避免了过度融合,更加适合人眼和计算机处理。

从图5比较可以看出,本文算法相比较基于小波、基于显著度、基于NSCT等算法,对背景图像的对比度进行了很好的提升,观察实验图像中的背景,可以看出本文算法具有更好的对比度,对背景的刻画更加清晰。

相比较基于NSST的算法,整体图像对比度的提升不明显,但是船只的局部细节边缘得到了很好的增强,显著性目标表现明显。验证了本文算法在提升对比度的同时能够对图像的细节进行很好的增强,验证了本文算法的有效性。

通过两组实验,验证了本文算法在提高整体对比度方面以及增强图像细节上的有效性,相比较传统的5种算法,结合了多分辨率分析与显著度分析的优势,提高了对比度,同时避免了因提高显著性区域而引起的细节不足,增强了细节信息,取得了较好效果。

3.2 客观评价

为了更加客观地比较各个融合结果的有效性,本文选取几组常用评价指标[17-19]来对本文算法与之前算法进行比较。边缘强度能够很好地体现融合后图像细节信息量,对于边缘效果的衡量比较客观;图像清晰度主要是评价融合后图像整体的对比度与显著性信息;信息熵用来衡量融合后图像中信息的丰富程度。实验结果如表2所示。

图4 第一组不同融合方法比较

对表2所示的结果进行分析,可以看出本文算法在两组试验中,结果均处于较优状态,边缘强度对比中,第一组实验结果表明本文算法具有较大优势,结果显示经过多尺度变换的算法如小波、轮廓波与剪切波变换效果均有增强,但是本文算法更有效,虽然小波算法结果更优,结合图像清晰度与信息熵进行分析,由于其具有噪声导致评价结果偏高;第二组实验边缘强度的结果均优于其他5种算法,更加说明了本文算法有效性。在图像清晰度的对比中,可以得到本文算法在两组试验中结果均处于最优,通过数据比较可知,多尺度工具的选择能够有效提高最终融合图像的清晰度,而本文在NSST的基础上结合显著性理论,能够更加有效提高图像质量。信息熵体现了融合后图像的信息量,通过对比可知,在第一组实验中,本文结果并没有处于最优,但是结合数据分析可知,6种算法为同一数量级,相差较小,对于图像信息量的评价也容易受到噪声干扰,在第二组实验中本文结果处于最优,综合考虑,本文算法在信息量保留方面具有较好的效果。

结合3种客观评价对6种算法的比较,可以得出较客观结论,即本文算法在图像边缘以及整体对比度上达到了较好效果,验证了算法的有效性。

4 结论

本文提出了一种增强对比度和边缘的NSST域多源图像融合新算法,相比较传统的融合算法,很好地克服了整体图像对比度以及细节不足的缺点。文中的融合算法对于低频子带强调图像的全局对比度与显著性信息,提高了图像整体的对比度与显著性目标辨识度;对于高频子带部分分析了图像的局部显著性,结合边缘分析提出了改进构造方法,在分析局部显著性的同时能够刻画边缘细节信息。融合规则从互补两种源图像的信息角度考虑对红外与可见光图像进行融合,有效地提高了融合后图像的质量。主观以及客观结果均验证了本文算法的有效性。

图5 第二组不同融合方法比较

表2 融合结果量化比较

[1] Waxman A, Gove A, Fay D, et al. Color night vision: opponent processing in the fusion of visible and IR imagery[J]., 1997, 1(10): 1-6.

[2] Pajares G, Manuel J. A wavelet-based image fusion tutorial[J]., 2004, 37: 1855-1872.

[3] Do M N, Vetterli M. The contourlet transform: an efficient directional multi resolution image representation[J]., 2005, 12(14): 2091-2106.

[4] 刘坤, 郭雷, 常威威. 基于Contourlet变换的区域特征自适应图像融合算法[J]. 光学学报, 2008, 28(4): 681-686.

LIU Kun, GUO Lei, CHANG Weiwei. Regional feature self-adaptive image fusion algorithm based on contourlet transform[J]., 2008, 28(4): 681-686

[5] 张蕾, 金龙旭, 韩双丽, 等. 采用非采样Contourlet变换与区域分类的红外和可见光图像融合[J]. 光学精密工程, 2015, 23(3): 810-818

ZHANG Lei, JIN Longxu, HAN Shuangli, et al. Fusion of infrared and visual images based on non-sampled contourlet transform and region classification[J]., 2015, 23(3): 810-818.

[6] Guo K H, Labate D, Lim W, et al. Wavelets with composite dilations and their MRA properties[J]., 2006, 20: 202-236.

[7] Easley G, Labate D. Sparse directional image representations using the discrete shearlet transform[J]., 2008, 25: 25-46.

[8] WANG Lei, LI Bin, TIAN Lianfang. EGGDD: An explicit dependency model for multi-modal medical image fusion in shift-invariant shearlet transform domain[J]., 2014: 29-37.

[9] Lim W. Nonseparable shearlet transform[J]., 2013, 22(5): 2056-2065.

[10] Itti L, Koch G, Niebur E. A model of saliency-based visual attention for rapid scene analysis[J]., 1998, 20(11): 1254-1259.

[11] MENG F, GUO B, SONG M, et al. Image fusion with saliency map and interest points[J]., 2016, 177: 1-8

[12] ZHANG B, LU X, PEI H, et al. A fusion algorithm for infrared and visible images based on saliency analysis and non-subsampled Shearlet transform[J]., 2015, 73: 286-297.

[13] LI J, Levine M D, AN X J, el at. Visual saliency based on scale space analysis in the frequency domain[J]., 2013, 35(4): 996-1010.

[14] LI Z Q, FANG T, HUO H.A saliency model based on wavelet transform and visual attention[J]., 2010, 53(4): 738-751.

[15] Imamoglu N, LIN W, FANG Y. A saliency detection model using low-level features based on wavelet transform[J]., 2013, 15(1): 96-105.

[16] 彭海, 赵巨峰, 冯华君, 等. 基于区域显著性的双波段图像融合方法[J]. 浙江大学学报: 工学版, 2012, 46(11): 2109-2115.

PENG Hai, ZHAO Jufeng, FENG Huajun, et al. Dual band image fusion based on region saliency[J].:, 2012, 46(11): 2109-2115.

[17] 张立保, 章钰. 基于显著性分析的自适应遥感图像融合[J]. 中国激光, 2015, 42(1): 1-8.

ZHANG Libao, ZHANG Yu. A new adaptive fusion method based on saliency analysis for remote sensing images[J]., 2015, 42(1): 1-8.

[18] 林森, 张俊宇, 郭金玉, 等. 局部方向模式在非接触掌纹识别中的应用[J]. 仪器仪表学报, 2015, 36(1): 201-208.

LIN Sen, ZHANG Junyu, GUO Jinyu, et al. Application of local directional pattern in non-contact palmprint recognition[J]., 2015, 36(1): 201-208.

[19] 张小利, 李雄飞, 李军. 融合图像质量评价指标的相关性分析及性能评估[J]. 自动化学报, 2014, 40(2): 306-315.

ZHANG Xiaoli, LI Xiongfei, LI Jun. Validation and correlation analysis of metrics for evaluating performance of image fusion[J]., 2014, 40(2): 306-315.

Infrared and Visible Image Fusion Based on Improved Saliency Map in NSST Domain

WU Dongpeng1,BI Duyan1,MA Shiping1,HE Linyuan1,ZHANG Yue2

(1. Institute of Aeronautics and Astronautics, Air Force Engineering University, Xi¢an 710038, China; 2. The 93787 Unit of PLA, Beijing 10076, China)

For the effective combination of global information of infrared image with detail information of visible image, and further improvement in the quality of the fused image, a fusion method of infrared and visible image based on enhancing contrast and edge of image in non-subsampled Shearlet transform(NSST) domain is proposed. Firstly, the image is decomposed to get the low frequency coefficients and the high frequency coefficients, and the image’s information of contrast is analyzed by global saliency map; the image’s information of edge is analyzed by improved local saliency map. For the different bands, the coefficients are fused using the information of contrast and edge, and the fused image is reconstructed by inverse NSST. A large number of experimental results show that the proposed method enhance the details in the fused image, while preserving the contrast of the image. And it is superior to the existing fused methods such as the method based on wavelet transform, non-subsampled Contourlet transform(NSCT), and the on saliency map and so on.

image fusion,infrared image,visible image,non-subsampled Shearlet transform (NSST), saliency map,contrast enhancement,edge enhancement

TP391

A

1001-8891(2017)04-0358-07

2016-08-28;

2016-09-19.

吴冬鹏(1993-),男,山西运城人,硕士研究生,研究方向是红外与可见光图像融合。E-mail:wdp_image@126.com。

国家自然科学基金(61372167),国家自然科学基金(61379140),国家自然科学基金(61301233)。