主动光立体标靶检测及其在工业机器人位姿测量中的应用

2016-10-19郑泽龙

张 旭 郑泽龙

1.上海大学,上海,200072 2.上海市智能制造及机器人重点实验室,上海,200072

主动光立体标靶检测及其在工业机器人位姿测量中的应用

张旭1,2郑泽龙1

1.上海大学,上海,2000722.上海市智能制造及机器人重点实验室,上海,200072

基于工业机器人位姿视觉测量方法提出了用主动光立体标靶进行机器人末端位姿测量的方法。以主动红外光代替反光标志点,以主动光图案特征代替亮度特征作为表达位置信息的形式,设计了六面体主动光标靶。通过合理设置特征面图案,使立体标靶特征面提供蕴含空间几何约束的信息,并在此基础上设计了特征面识别算法。在室内环境、室外环境、混合光环境等实验条件下,该算法可实现对主动标靶健壮的识别和定位。在高精度四轴移动平台上的测量误差评价实验表明:运用该标靶的立体视觉系统在0.5~3 m工作范围内平均位置误差为0.0857 mm,平均姿态误差为0.1086°,满足机器人位姿测量的要求。最后在YASKAWA的Motoman-MH80六轴机械臂上进行了机器人末端位姿的测量实验,验证了该方法的可行性和高效性。

机器人位姿测量;视觉测量;特征识别;主动光立体标靶

0 引言

机器人位姿测量指的是测量机器人末端(特指机器人的末端法兰中心)相对于测量坐标系或机器人基座坐标系的位置和姿态。获取机器人测量位姿对机器人有着重要的意义。如在用视觉伺服控制机器人进行装配时需要视觉系统实时反馈机器人的位姿,从而控制机器人进行装配[1];再比如对工业机器人D-H参数标定时关键一步就是要获得多组机器人的测量位姿,从而进行标定工作[2-4]。现今获取机器人测量位姿的方法很多,常用的测量方法可以简单分为接触式和非接触式。

接触式测量方式要求测量设备必须直接与测量目标接触,如球杆仪[5]、拉线式传感器[6]等设备,但通常情况下,这种接触式的测量在机械臂上实施起来难度大,操作也较为复杂且测量范围较小。非接触式测量有激光、超声波、红外和视觉传感以及多种方法融合的测量技术,激光跟踪仪是较为常用的测量设备[7],激光跟踪仪具有测量精度高、测量范围大等优点,但缺点也很明显,即不方便搬运、价格昂贵。在满足所需精度的情况下,测量的效率和成本是机器人末端姿态测量必须考虑的问题,因此,视觉检测成为较为常用的非接触测量方式。视觉测量方法需要在机器人上安装特定的视觉标靶,常用的标靶类型有平面标定板[8-9]或表面具有反光标记点的标靶[10-11]。选用平面视觉标定板作为标靶的方式不具有实时性,一般都需要先拍完图片再通过手动选择感兴趣区域(ROI)的方式才能获取位姿,获取效率低,同时因为只有一个面,所以测量的范围较为有限;而用反光标记点的标靶,虽然可以做到实时获取位姿,但反光标记点在实际使用中反射效果受工作距离的影响较大,并且需要从复杂的环境光中提取特征圆,使得特征圆的检测更加复杂,稳定性也较差,特别是在有较多镜面反射或强光现场尤为明显。

综合考虑以上测量方法的优势和不足,本文提出了一种用主动光立体标靶测量机器人末端位姿的方法。所用主动光立体标靶是利用红外光提供可供识别的光源图形,通过相应的特征识别算法识别特征图形以获取立体标靶在测量坐标系下的测量位姿,继而通过位姿变换获得机器人末端位姿。该方法只要获取安装在机器人末端的立体标靶的图片便能立即获得机器人的末端姿态,操作方便,测量效率高,同时具有较高的测量精度。

1 主动光立体标靶及其视觉检测算法

1.1主动光立体标靶

工业机器人的工作范围较大,要求所设计的立体标靶在机器人运动范围内各个角度都能可视,所以本文的立体标靶为六面体结构,其中标靶的多个面上都提供了可供识别的特征圆的组合图形(立体标靶上有特征图形的面以下简称特征面)。

为了提供位姿信息,特征面上的特征图形设计成由7个大圆、3个小圆组成的组合图形,如图1所示。其中7个大圆作为特征圆,用来构建标靶特征面的固连坐标系,3个小圆作为辅助识别特征(图1b)。立体标靶的每个特征面上都定义了对应的固连坐标系,这里统一说明:1号大圆的圆心为坐标系的原点,1号大圆到3号大圆的向量为X轴,1号大圆到5号大圆的向量为Y轴。

(a)整体机构

(b)特征图形

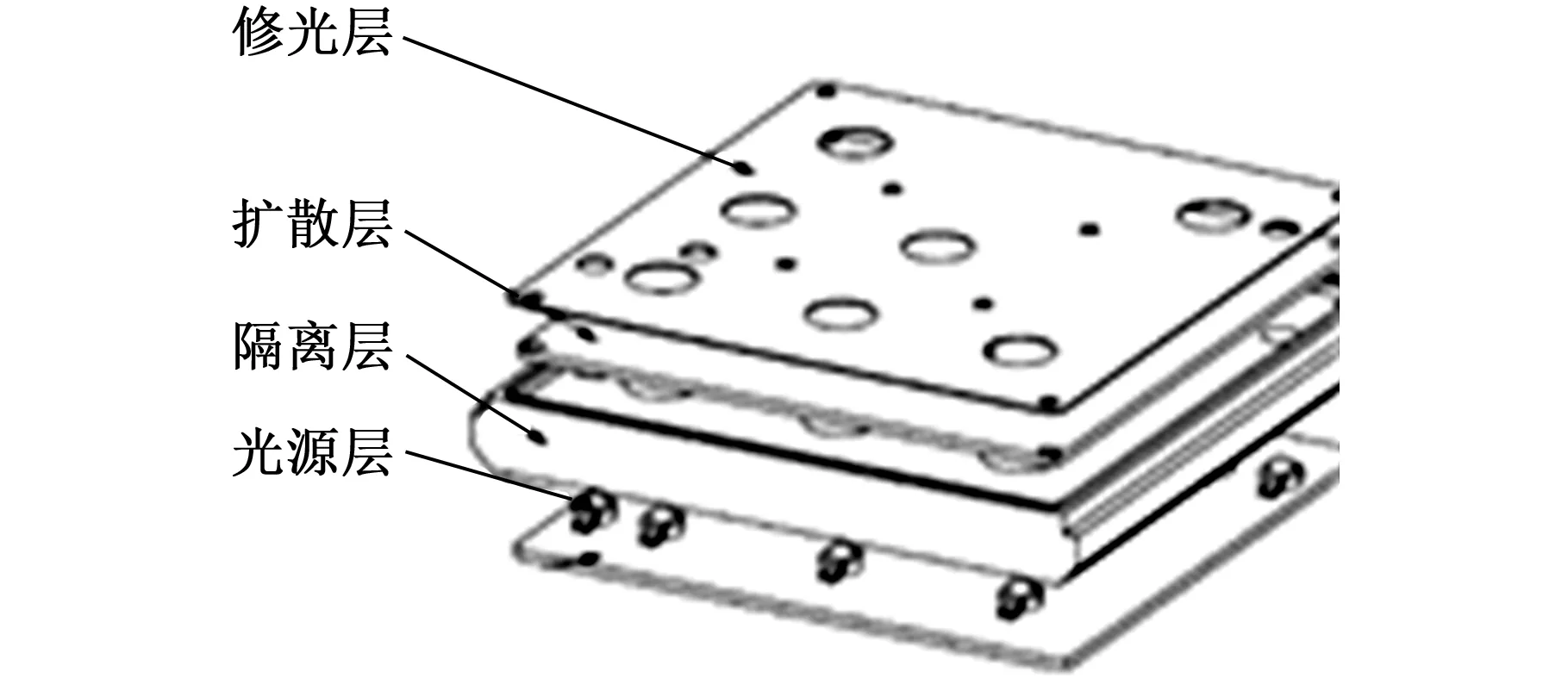

(c)四层均匀光结构图1 主动光立体标靶

标靶的每个特征面上都有可供识别的特征图形,所以其上的特征图形除了携带位姿信息外同时还应携带所在特征面的面编号信息,以区别不同的特征面,如图1b所示,用c号小圆相对7号大圆的位置关系来提供标靶的面编号信息,图中c号小圆的5个位置分别代表了5个特征面(为了方便表述,下文用FAC_i (i=1,2,…,5)表示立体标靶的第i号特征面)。通过这种方式,立体标靶的每个特征面便能提供位姿信息和面编号信息。

在用主动光产生特征圆的过程中,光源亮度不均将直接导致特征检测精度下降,为此本文提出用图1c所示的四层的结构来解决光源成像不均的问题。四层结构从下到上依次为:光源层、隔离层、扩散层和修光层。光源层用于提供红外光源,光源选用波长为850nm、发光角度为120°的红外LED灯珠;隔离层用于隔离灯珠,扩大灯珠的发光角度;扩散层为光扩散板,光扩散板可通过化学和物理的手段,利用光线在行进途中遇到两个折射率相异的介质时,发生折射、反射与散射的物理现象,实现入射光充分散色,以此产生光学扩散的效果,使光源均匀;修光层为有较高加工精度的金属薄片,在其上用激光雕刻的方法雕刻出标靶的特征图形,然后将其覆盖在扩散板上以获得所需要的特征图形。

如上所述立体标靶的最终结构如图1a所示,其中5个面为特征面,每个特征面都是图1c所示的四层结构,另外一个面用于连接机器人和固定LED供电电路。

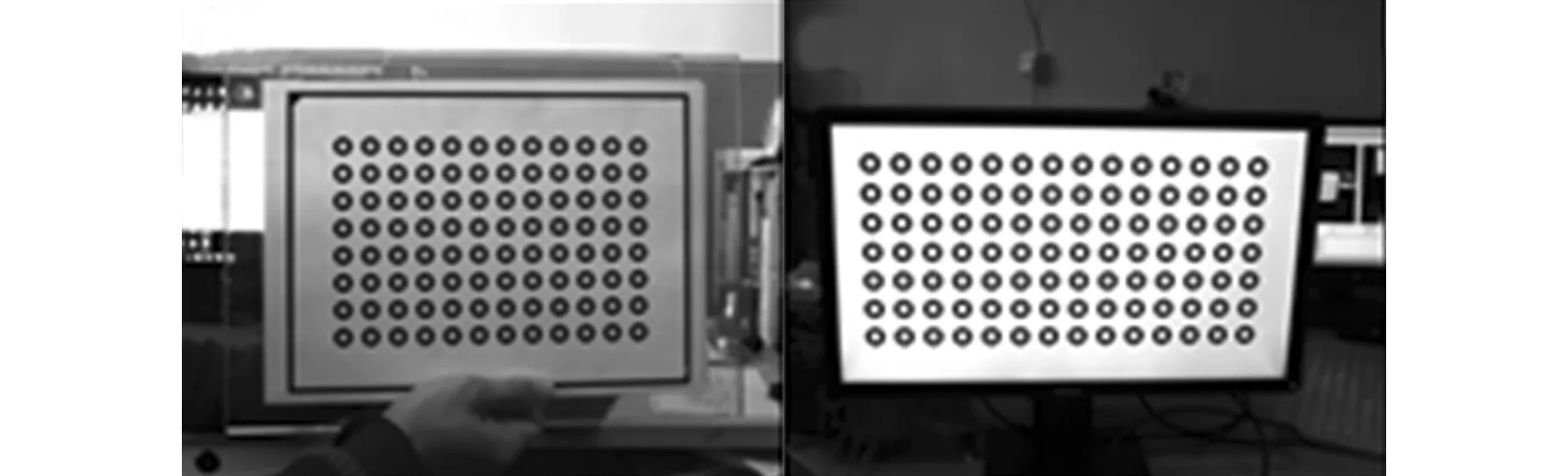

通过在相机镜头前加装带通为850nm的滤波片,在室内环境下可以将大部分环境干扰滤除,图2所示即为标靶实物的成像效果,可以看出特征圆的亮度十分均匀且形状规整。

图2 立体标靶的成像效果

1.2标靶特征面检测算法

用视觉测量的方法获取标靶位姿时,必须对立体标靶上用于提供位姿信息的特征面进行检测识别,检测算法流程如下。

(1)图像预处理。图像预处理主要进行图像滤波和图像二值化,用高斯滤波的方式滤除图像噪点。立体标靶的红外光强大于环境中的850nm辐射光强,主动光斑相对环境具有较大的对比度,设定阈值对图像进行二值化以分离目标和背景。

(2)特征圆提取。为了从环境中准确获取目标特征圆,滤除环境光干扰,以提高后期进行特征圆识别的效率和准确率,就必须对图像的轮廓特征进行过滤。这里采用三个过滤条件:①轮廓所占像素数。特征圆在测量范围内其轮廓长度为有限值,而非巨大背景或散乱噪声产生的轮廓。②轮廓长短轴比值。圆特征经过透视投影,在摄像机上成像为椭圆,轮廓经椭圆拟合后可获得椭圆长轴、半轴,计算长短轴比值并同设定的阈值比较,滤除倾斜角度过大的特征圆。③椭圆面积。根据拟合后的椭圆面积和原轮廓所占像素数的差值滤除非椭圆特征的环境干扰。具体流程如图3所示。

图3 特征圆提取、筛选过程

(3)确定特征圆标号。①查找1号大圆。根据1号大圆和两个环绕小圆的尺寸位置约束(图1b),可找出1号大圆。②查找a号、b号小圆,确定参考方向向量。为了找出其他的大圆,需先定义三个参考方向:X、Y轴方向和45°方向。这里用1号大圆的两个环绕小圆定义参考向量,所以先要辨识这两个环绕小圆。建立1号大圆到两小圆的矢量,分别用V1=(x1,y1,0)和V2=(x2,y2,0)表示。由图1b可知a号小圆位于-X轴方向,b号小圆位于Y轴方向,将V1和V2叉乘,以叉乘后的向量的z值的正负来辨识a号、b号小圆。识别出a号、b号小圆后,分别求从1号大圆圆心到a号小圆圆心、从1号大圆圆心到b号小圆圆心、a号小圆圆心到b号小圆圆心的矢量作为参考方向,即X、Y轴方向和45°方向,分别用Vx、Vy、V45表示。③查找2~7号大圆,更新参考方向向量。根据上一步定义的Vx、Vy、V45分别找出在这些方向向量上的圆,并根据其同1号大圆的距离关系确定编号。这样可识别出每个方向上各有三个大圆,用最小二乘法将三个方向上的大圆圆心分别拟合成直线,作为新的方向向量,更新Vx、Vy、V45方向参考向量。④查找c号小圆,确定面编号。根据标记号为7的大圆及其小圆特征点距离约束,识别标记号为7的大圆的环绕小圆点,并计算标记号为7的大圆到小圆点的方向Vc,将Vc分别与Vx、Vy、V45进行叉乘,然后找出叉乘所得向量的z值最小的向量,以此来判断同Vc共线或接近共线的向量,再将两个向量点乘,判断两向量是同向还是反向,从而确定该组特征点所在面。

通过以上检测算法,立体标靶在各种环境中都能取得较高的检测效率和稳定性,图4所示为标靶实际检测效果。

(a)室内环境下的检测效果

(b)室外环境下的检测效果图4 标靶检测算法的检测效果

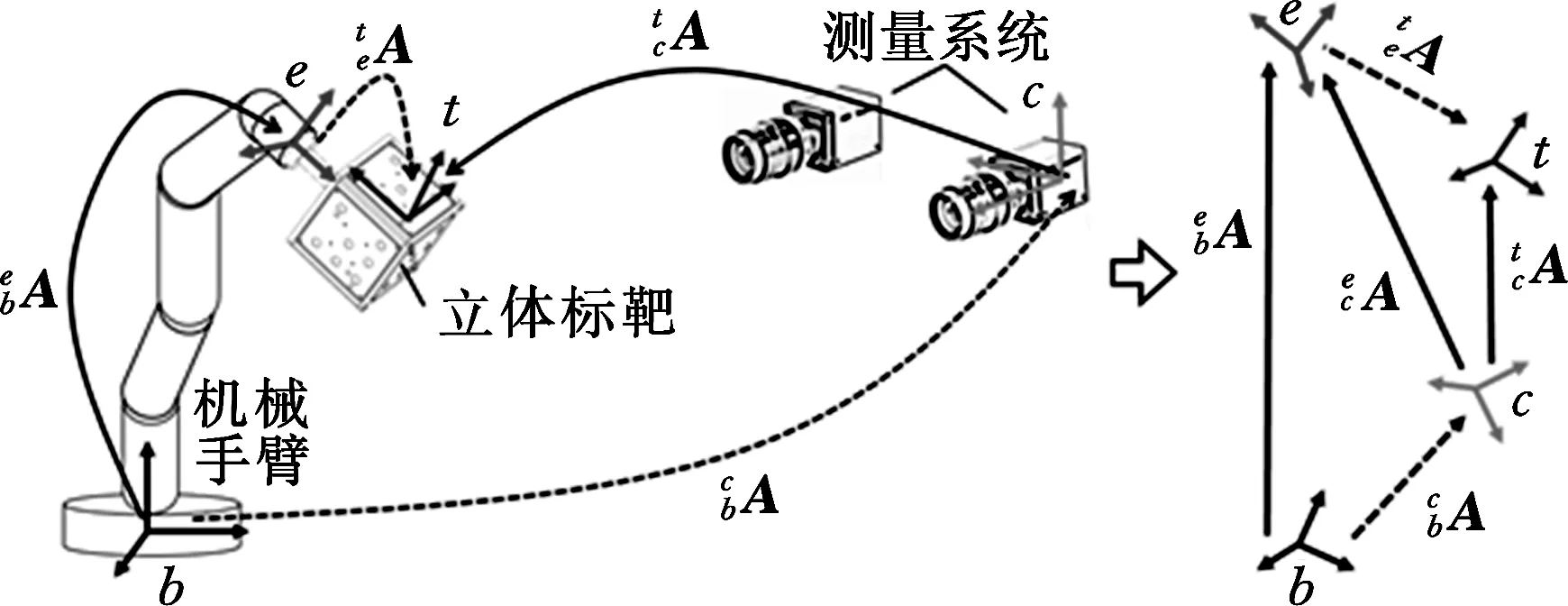

1.3机器人位姿测量方法

机器人末端的位姿信息包括了旋转和平移。所以这里用4×4的齐次矩阵A来描述位姿信息,如下式所示:

(1)

式中,R为3×3的矩阵,表示位姿的旋转量;T为3×1的矩阵,表示位姿的平移量。

在双目立体视觉测量中,当已知空间中某点在左右相机图像中的对应点时就可以确定该点在相机测量坐标系下的三维信息。通过标靶特征检测算法识别出左右相机图片上的特征圆后,根据特征圆标号信息确定对应性,便可得到立体标靶上的特征圆圆心的三维信息,用Pi=(xi,yi,zi)T来表示第i号特征圆圆心在双目系统坐标系下的三维坐标,用a1、a2分别表示从1号特征圆圆心到3号特征圆圆心和从1号特征圆圆心到5号特征圆圆心的向量,则有

(2)

对a1、a2两向量单位正交化,有

(3)

定义β1、β2分别为标靶特征面坐标系的X、Y轴,所以Z轴 β3=β1⊗β2。可得标靶特征面坐标系在测量位姿的旋量R=[β1β2β3],平移量T=P1,由此可得标靶特征面的测量位姿为

(4)

(5)

立体标靶有多个特征面,所以可能会出现多个特征面同时出现在相机视野中,此时,标靶识别算法会进行特征面判断,如果能识别到FAC_1,则不对其他特征面做位姿计算;如果无FAC_1,则对出现在视野中的特征面求位姿并通过式(5)分别转化成FAC_1的位姿,然后对获得的多个FAC_1的位姿求平均作为FAC_1的位姿。

(6)

(a)测量中的位姿传递关系(b)位姿传递链简图图5 位姿传递关系

2 立体标靶的标定和检测算法的鲁棒性分析

2.1立体标靶特征检测算法的鲁棒性分析

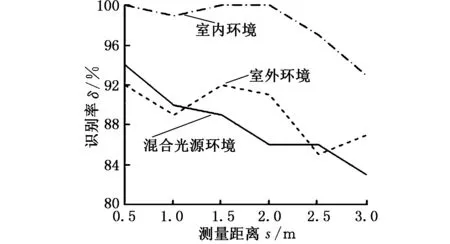

根据1.2节的标靶检测方法编写算法并进行算法鲁棒性实验。分别在室内环境、室外环境、混合光源环境(在室外环境中加入人工光源干扰)下进行实验。将标靶放置在离相机0.5~3 m的工作距离内,每隔0.5 m拍摄100张样张进行识别统计,以测试标靶识别算法在不同环境不同测量距离下的识别效果,得到的识别结果如图6所示,可以看出:在室内环境中,在工作距离内识别率基本都能达到100%,平均识别率为98.1%;在室外和混合光的环境下识别率有所下降,平均识别率分别为89.33%和88.00%,这是因为室外光和混合光的实验环境是选择在有强太阳光直射的场地进行的,而实际的机器人测量基本都是室内进行的,室外环境下的实验只作为算法鲁棒性评价之用,在实际测量中并无实际参考价值。室内环境下在0.5~3 m的测量范围内98.1%的识别率证明了识别算法具有较高的鲁棒性,符合实际测量要求。

图6 立体标靶识别算法在不同测量距离和不同测量环境下的识别率

2.2立体标靶的标定

如上文所述,要对标靶进行检测需先知道标靶特征面在FAC_1坐标系下的位姿,标靶的这些参数在设计标靶时便已确定,但由于标靶在制作过程中存在加工误差和装配误差,所以在使用立体标靶前需要对其进行特征面相互位姿关系的标定。随着摄影测量技术的发展,摄影测量的精度已经基本能满足一般的精度测量要求,所以本文采用双目测量的方法对立体标靶的特征面相互位姿关系进行标定。

2.2.1双目立体视觉系统的标定

用双目视觉测量的方法对标靶的参数进行标定前,需对双目系统进行标定。双目测量系统的标定包括每个相机内参数的标定以及两相机相对位姿的标定(或称相机外参数标定)。相机标定技术已经相当成熟,主要以Tsai[13]的两步法和张正友[14]的平面标定法为代表,本文采用张正友的标定方法进行相机标定。相机标定过程中一个关键步骤是选用标定板,通常的做法是将标定图片打印出来,贴到表面光洁度和平面度较好的平板上,如图7a所示,这种方法标靶的精度并不高。为了保证标定精度,本文采用LCD屏幕显示的标靶(图7b),用LCD屏幕产生标定图片的精度能得到较好的保证[15]。

(a)打印的标定板 (b)用LCD显示屏显示标定图片图7 标定板的选用

(7)

即

(8)

根据式(8)求得的Bi可计算出特征圆之间距离,将其同标准距离比较,从而确定双目测量系统在不同距离的测量误差。因为LCD的制作精度已能达到0.05 μm[15],所以可以认为用屏幕显示的标靶特征圆的相互位置就是标准值。因此用相机测量出的特征圆的相互位置与LCD屏幕显示的特征圆的真实相互位置之差便可认为是双目测量系统的测量误差。图8所示为通过这种方法得到的相机在不同距离下的测量误差。在0.5~3 m的工作范围内整体平均误差为0.0728 mm,从图8的曲线可看出标定后的测量系统具有较高的测量精度和稳定性。

图8 双目系统在不同测量距离下的测量精度

2.2.2立体标靶特征面相互位姿关系的标定

为了标定这些变换矩阵,要求左右相机的图像中必须都能清晰地呈现两个待标定的特征面。为了保证标定精度,画面中特征面的法向与相机的Z向夹角不能过大(小于60°)。例如:如果要标定1号特征面和2号特征面的变换关系,必须保证在左右相机中都能同时检测到这两个特征面,如图9所示。按上述要求分别获取所要标定面的标定图片。

(a)左相机图片 (b)右相机图片图9 标定标靶特征面相对位姿关系标定图片

通过双目测量的方法获得标定图片上特征圆圆心在相机坐标系下的坐标值后,继而获得其所在特征面在相机坐标系下的位姿矩阵,它可表示为

(9)

(10)

将式(9)代入式(10)可计算出标靶其他特征面在FAC_1坐标系下的位姿矩阵,最终标定结果如表1所示。

表1 特征面相对位姿关系标定结果

注:矩阵中前3×3中的数值为角度,单位为rad;最后1列的前3个值为位移,单位为mm。

3 机器人位姿测量实验

3.1立体标靶位姿测量误差评价实验

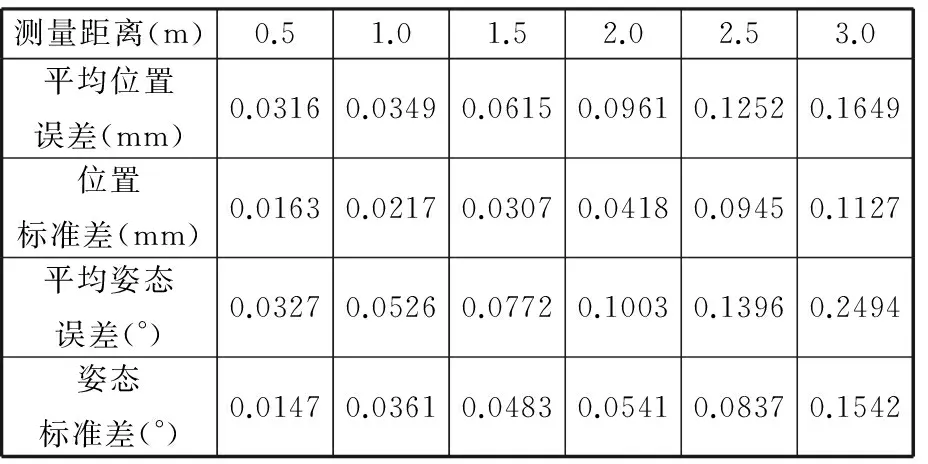

用标靶进行实际测量前,需要对标靶的位姿的测量误差进行评价,本文在高精度的四轴移动平台上进行立体标靶的位姿测量误差评价实验(图10),所用移动平台为ZOLIX的四轴移动平台,位姿精度可达0.01 mm。将测量系统分别置于离移动平台0.5 m,1 m、1.5 m、2 m、2.5 m、3 m工作距离处,将标靶特征面固定在移动平台上,在每个测量距离处让平台移动50次固定值并获取每次移动的标靶图片,获得标靶的位置信息,将获得的位置同前一次的测量结果求相对位姿,便可得到相邻两次测量的标靶在测量坐标系下的位置的改变量(即通过测量系统获得工作台的每次移动的移动量),将这个值同移动台固定的移动距离5 mm进行比较得两个距离的差。50次的测量可以得到50个差值,对这些差值求平均值,作为评价立体视觉系统在此测量深度下的测量误差的指标。移动双目系统到下一个测量位置,进行同样的操作,从而可获得不同测量深度下的测量误差。采用同样的方法,让移动平台在每个位置处旋转固定角度,得其测量的姿态误差,由上述实验可评估该方法在不同的测量距离下获取机器人末端姿态的误差,如表2所示。由表2中的数据可得在0.5~3 m的工作范围内,立体标靶实际测量中的平均的位置误差为0.0857 mm,平均姿态误差为0.1086°,满足机器人位姿测量的要求。

图10 立体标靶位姿获取精度评价实验现场

测量距离(m)0.51.01.52.02.53.0平均位置误差(mm)0.03160.03490.06150.09610.12520.1649位置标准差(mm)0.01630.02170.03070.04180.09450.1127平均姿态误差(°)0.03270.05260.07720.10030.13960.2494姿态标准差(°)0.01470.03610.04830.05410.08370.1542

3.2末端位姿测量实验

为了验证用主动光立体标靶获取工业机器人测量位姿方法的可行性和效率,我们在安川的Motoman_MH80六轴机械臂上进行了机器人位姿获取实验,将主动光立体标靶安装在机械手臂的末端法兰上,将测量系统置于离基座3 m处进行测量,实验现场如图11所示。控制机械臂绕任意轴走一个空间圆轨迹,测量系统每隔适当角度获取标靶图片,并进行特征检测,获得立体标靶的位姿,再通过手眼标定的结果进行位姿变换,继而得到机械臂的末端执行器的测量位姿,将其与机械臂的指令位姿进行对比。本次实验中,机械臂末端执行器的测量位姿与指令位姿的最大距离偏差为4.2721 mm,平均距离偏差为2.6905 mm。这是由于机械臂的绝对定位精度较低造成的,一般未经标定的工业机器人的绝对精度只能维持在2~3 mm水平[16]。由此可见本文测量方法能够准确地获取机械臂末端的测量姿态,为机器人的标定或通过视觉伺服引导机器人进行精密装配等工作提供有力的支持。同时,实验过程中,该方法在获得机器人末端位姿时,获取标靶图片后便能马上获得机器人的末端位姿,具有很高的测量效率,所以该方法也可用于机器人的实时轨迹跟踪。

图11 六轴机械臂末端位姿测量实验现场

4 结论

(1)提出了一种用主动光立体标靶获取工业机器人末端的测量位姿的方法,所用主动光立体标靶通过四层均光结构可以获得亮度均匀、特征图形准确的光源特征的六面体视觉标靶,通过特定的检测算法可以在多种工作环境中对立体标靶进行准确识别和定位。

(2)在室内测量环境中,在0.5~3m的工作距离内识别成功率可达到98.1%,即便在有较强环境干扰的室外环境和混合光源环境下也能达到89.33%和88.00%的识别率。

(3)为了避免立体标靶的机加工和装配产生的误差对姿态测量的影响,用双目测量系统对立体标靶特征面的位姿关系进行了标定。

(4)测量精度是该方法是否切实可行的一个重要指标,本文通过实验评价了该方法在实际的位姿测量中的测量精度,得到该方法在0.5~3m的测量范围内测量的平均位置误差为0.0857mm,平均姿态误差为0.1086°,可以满足机器人位姿测量的要求。

(5)在六轴机械臂上的位姿获取实验中,得到该测量方法不仅可以准确获取机械臂的姿态,同时具有较高的测量效率的结论,因此除了用其进行机器人的标定或通过视觉伺服引导机器人进行精密装配等工作外也可以进行机器人的实时轨迹追踪。当然该方法有其局限性,对于视觉测量方法,测量精度会随着测量距离的增大而变差,所以该方法用于大行程的机械臂(臂展超过2m的机械臂)的测量并不合适,同时测量精度仍有提高的空间,这取决于相机的标定精度和标靶的标定精度。后期工作中,将进一步提高该测量方法的测量精度并将其应用在机器人的标定和轨迹跟踪中。

[1]张建中, 何永义, 李军. 机器人装配视觉定位应用研究[J]. 机电工程, 2011, 28(8): 934-937.

ZhangJianzhong,HeYongyi,LiJun.ApplicationResearchofVision-locationinRoboticAssemblyEquipment[J].Mechanical&ElectricalEngineer-ing, 2011, 28(8): 934-937.

[2]王东署. 工业机器人标定技术研究[D]. 沈阳:东北大学, 2006.

[3]龚星如. 六自由度工业机器人运动学标定的研究[D]. 南京:南京航空航天大学, 2012.

[4]王琨. 提高串联机械臂运动精度的关键技术研究[D]. 合肥:中国科学技术大学, 2013.

[5]OtaH,ShibukawaT,TooyamaT,etal.ForwardKinematicCalibrationMethodforParallelMechani-smUsingPoseDataMeasuredbyaDoubleBallBarSystem[C]//Proc.ParallelKinematicMachines.Paris, 2000: 57-62.

[6]段广洪,张辉,周潜,等. 刚体空间姿态测量装置及其测量方法:中国,200410009083.7[P]. 2004-05-12.

[7]赵伟. 基于激光跟踪测量的机器人定位精度提高技术研究[D].杭州:浙江大学, 2013.

[8]查弘文. 基于立体视觉的测量机器人的标定与测量规划[D].南京:南京航空航天大学, 2013.

[9]郭剑鹰,吕恬生.基于主动视觉的机器人末端姿态测量[J].上海交通大学学报, 2003, 37(5): 715-719.GuoJianying,LüTiansheng.RobotEnd-effectorPoseMeasurementwithActiveVision[J].JournalofShanghaiJiaotongUniversity, 2003, 37(5): 715-719.

[10]LundbergI,BjörkmanM, ögrenP.IntrinsicCameraandHand-eyeCalibrationforaRobotVisionSystemUsingaPointMarker[C]//HumanoidRobots(Humanoids), 14thIEEE-RASInternationalConferenceon.Madrid,Spain,IEEE, 2014: 59-66.

[11]秦大辉, 毛婷, 刘建军. 基于双目立体视觉的手持式光笔三坐标测量系统[J]. 制造技术与机床, 2011 (8): 133-136.QinDahui,MaoTing,LiuJianjun.Studyon3D-coordinateMeasuremntTechnologyUsingHandholdLight-penBasedonBinocularStereo-scopicVisionSystem[J].ManufacturingTechnology&Machi-neTool, 2011 (8): 133-136.

[12]张云珠. 工业机器人手眼标定技术研究[D]. 哈尔滨: 哈尔滨工程大学, 2009.

[13]TsaiRY.AVersatileCameraCalibrationTechniq-ueforHigh-accuracy3DMachineVisionMetrol-ogyUsingOff-the-shelfTVCamerasandLenses[J].IEEEJournalofRoboticsandAutomation, 1987, 3(4): 323-344.

[14]ZhangZhengyou.AFlexibleNewTechniqueforCameraCalibration[J].PatternAnalysisandMachineIntelligence,IEEETransactionson, 2000, 22(11): 1330-1334.

[15]SongZ,ChungR.UseofLCDPanelforCalibra-tingStructured-light-basedRangeSensingSystem[J].InstrumentationandMeasurement,IEEETransactionson, 2008, 57(11): 2623-2630.

[16]赵亮. 基于旋量的SCARA工业机器人精度研究[D].杭州:浙江大学, 2011.

(编辑袁兴玲)

Active Light Stereo Target Detection and Its Applications in Industrial Robot’s Pose Measurement

Zhang Xu1,2Zheng Zelong1

1.Shanghai University,Shanghai,200072 2.Shanghai Key Laboratory of Intelligent Manufacturing and Robotic,Shanghai,200072

A visual method with an active light target was proposed to obtain the positions and orientations of robots herein. First, the active light stereo target adopted active infrared light instead of reflective markers and employed shape features instead of brightness features to encode the location informations. Second, the stereo structure was designed to provide the spatial geometric constraint information. The active light target owned five feature planes to expand the visibility no mater what pose. Third, a detection method of feature planes was proposed. The proposed feature detection method was testified under different situations, such as indoor illumination environments, the direct solar radiation at outdoor square and the mixed illumination environments. The experimental results confirmed the feasibility and reliability of the proposed method. Forth, the precision of the proposed visual method was verified in a high precision platform. The experimental results show the average position error is as 0.0857 mm and the average orientation error is as 0.1086° in measuring distance ranging from 0.5~3 m. Finally, the pose measurement of a YASKAWA robot arm, Motoman-MH80, was conducted and the experimental results confirmed the feasibility and efficiency of the proposed method.

full pose measurement of industrial robot; visual measurement; feature detection; active light stereo target

2015-08-31

国家自然科学基金资助项目(51205244);机械系统与振动国家重点实验室课题资助项目(MSV2015010);上海市教育委员会科研创新资助项目(2014Z10280034)

TP241.2

10.3969/j.issn.1004-132X.2016.19.007

张旭,男,1982年生。上海大学机电工程与自动化学院副教授、博士。主要研究方向为深度信息获取和计算机视觉。郑泽龙,男,1989年生。上海大学机电工程与自动化学院硕士研究生。