应用颜色与光流特征的粒子滤波的视频跟踪

2016-04-11宋佳声戴乐阳集美大学轮机工程学院福建省船舶与海洋工程重点实验室福建厦门361021

宋佳声,戴乐阳(集美大学轮机工程学院,福建省船舶与海洋工程重点实验室,福建厦门361021)

应用颜色与光流特征的粒子滤波的视频跟踪

宋佳声,戴乐阳

(集美大学轮机工程学院,福建省船舶与海洋工程重点实验室,福建厦门361021)

摘要:在视频跟踪系统中,为了在连续帧的图像空间中找到移动目标的坐标、速度、大小以及旋转等状态信息,并且为了克服单一特征表征造成的可分性差的问题,提出了在3层粒子框架下的基于颜色和运动特征的滤波算法.首先,分析并提出了目标候选模式和原型之间的颜色特征和光流特征的相似度测量方法.然后,通过首层位置粒子的衍生算法使得颜色与光流特征应用于不同层次的粒子中,从而解决了多特征测量的融合问题.实验结果表明,本算法在无遮挡时能够不丢失地跟踪目标,正确地估计目标状态,并据此自适应地调整跟踪窗口的位置、大小和方向;在有遮挡时,算法能正确地预测目标位置并在目标重新出现后能够及时捕捉目标继续跟踪;本算法的位置跟踪的相对误差精度约10%.

关键词:目标跟踪;粒子滤波;颜色模型;光流模型;层次粒子结构

基于视频的目标跟踪广泛应用于军事、交通管理和安防监控等领域.在20世纪60年代,贝叶斯理论被首次应用于随机滤波理论之中[1].随后,蒙特卡罗采样方法的引入得到了粒子滤波,从而使得贝叶斯滤波能够实现在线的参数或状态估计[2].Doucet证明了粒子滤波的收敛性[3-4],Gorden等[5]提出的自助法解决了重采样问题,很快它便被应用到了视频跟踪领域[6-7].总体而言,这方面的研究围绕以下两个基本的问题展开.第一,目标表观建模.有的称之为匹配问题,就是在所有可能的目标中识别(估计)出目标的运动信息.其主要内容是在某个特征空间中对目标原型与候选目标进行相似性测量.常被采用的特征有轮廓[8-9]、颜色[10-12]、纹理[13]、特征点[14]、特征子图等.因采用单一特征的视频跟踪常面临候选目标可分性差的问题,故而多采用融合多种特征的表观模型[15-17].本文采用了颜色和光流特征作为表观模型,与文献[16]不同的是,本文并不需要计算粒子区域的光流直方图,也不需讨论融合模型的权值自适应设计,而是将颜色与光流的计算分属为两个不同层次的问题.第二,目标运动建模.其目的都是希望所建立的运动模型能够给出在下一帧图像中目标的可能状态,为目标的状态估计提供先验知识.本文将目标状态(位置、大小、方向)分解为3个层次的粒子结构,采用参数可调的二阶回归模型对顶层的位置粒子运动建模,然后,据此设计相应的目标自适应的跟踪算法.

1 视频跟踪系统的分析与建模

1.1状态转移模型

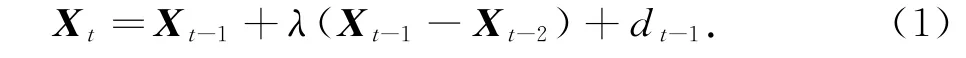

图1(a)表示了在图像坐标下的目标跟踪窗口,或者称为观测窗口.随着目标移动而自适应地“拖拽”窗口,使得被跟踪目标始终位于观测窗口内,并根据目标的大小与姿态调整窗口的尺寸与角度.目标运动参数为:位置(xt,yt)、速度xtyt)、观测窗口尺寸(rt, ct)及其与坐标轴的夹角θt.

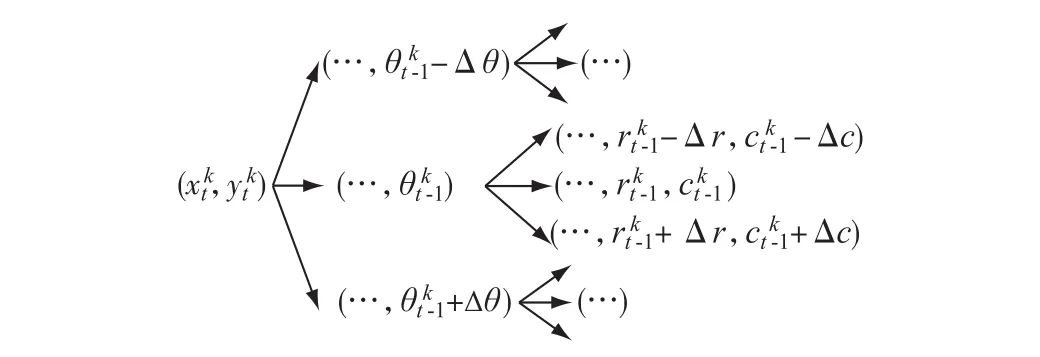

为降低状态空间的维数,将状态向量St分解为3个层次的粒子,分别对应位置、方向、大小.首先,考虑首层位置粒子,即目标质心点(观测窗口中心),采用如式(1)二阶回归模型建模,其中Xt=[xt,yt]T,dt-1为过程噪声,λ为0.5~1之间的速度因子.其次,考虑目标的旋转粒子,即姿态变化,以每一个位置粒子为中心旋转观测窗口的角度,并且在不同角度下分别选择不同尺寸的粒子.图1(b)所示每一个状态粒子下产生了18个搜索粒子,对不同的角度、尺寸进行搜索.故形成3个层次的粒子:底层进行目标大小搜索,中间层进行姿态(角度)搜索,顶层确定目标的具体位置.

图1 在图像空间的跟踪窗口和层次粒子Fig.1 Tracking window and hierarchic particles in image space

1.2状态观测模型

1.2.1基于颜色值的特征提取与相似性测量

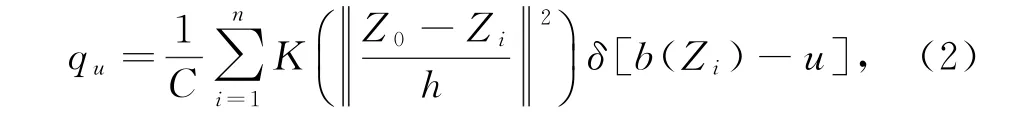

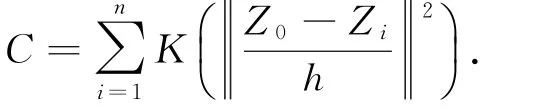

根据文献[10]提出的核函数直方图,将模式中的每个像素投影到特征空间的特征向量乘一个[0,1]内的系数.受此启发提出以下颜色值特征提取方法.首先,将每个通道的颜色值范围[0,255]压缩到[0,7].然后,模式特征向量Q的第u个特征值计算如式(2).

其中

所谓相似测量,就是考察原型模式与候选模式之间的相似性.将原型的特征向量记为Q,候选模式的特征向量记为P,某一个粒子对应的候选模式与原型模式之间的Bhattacharyya距离定义为如下形式:d=,其中的系数定义为

最后,将距离转化为[0,1]内的概率,即当前模式的似然概率:

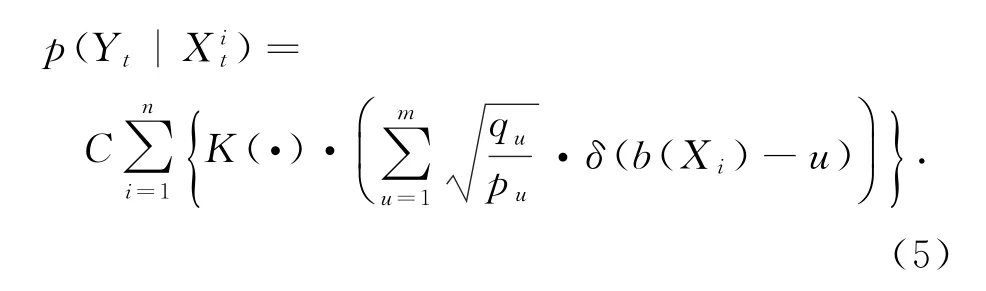

这里存在的主要问题是,计算所得的各候选模式的似然概率过于接近[16,18].为了找到区分度更高的似然函数,通过对式(3)在真值附近的一阶泰勒展开式分析得到式(5).其中,pu≠0;若pu=0,则取p(Yt| Xit)=0,C为归一化常数.它考虑了观测窗口中像素的位置和颜色特征:在模式的每一个像素点所对应的特征下,都将两者相应的特征值相除并乘以其位置系数,如此遍历所有像素.

1.2.2基于运动的特征提取及相似性测量

光流是当图像传感器与目标物体之间有相对运动时图像空间中亮度模式变化的速度.文献[18]提出了光流直方图并在此基础上分析某区域的运动方向与强度,受此启发并为了简化光流算法的计算量,计算观测窗口内的总光流矢量如下:

首先,获取观测窗口范围内的连续的2帧(即t与t-1时刻的图片),按照Horn-Schunck算法[19]计算观测窗口的光流场{[ui,j,vi,j]T},i,j在观测窗口内取值.然后,对光流场中所有光流矢量求和并按固定比例κ缩小,得到观测窗口内在t时刻的总光流矢量:

最后,根据观测窗口的总光流矢量计算它在跟踪窗口坐标中的角度,并转化为[0,90°]内的夹角ρt,据此作为相似性比较的依据,取值最小者作为粒子对应跟踪窗口角度.

1.2.3模式原型特征的更新

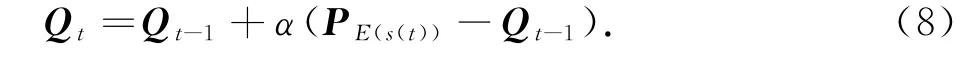

环境或者目标自身的改变都会引起模式原型特征的变化,相应的原型特征向量需要实时更新.更新的依据一般是模式的观察值或者估计值.考虑到粒子滤波输出就是系统状态的贝叶斯最优估计,从理论上讲它是比所有粒子更加接近于真值.因此,在任意t时刻,选取滤波器输出的状态估计值所对应的模式特征PE(s(t))与目标原型特征Qt进行比较,当其相似性大于某个设定阀值时,则按式(8)更新;当小于阀值时,说明出现了丢失目标或者目标被遮挡的情况,则不更新模式原型.

2 跟踪算法的设计

2.1粒子恶化与重采样技术

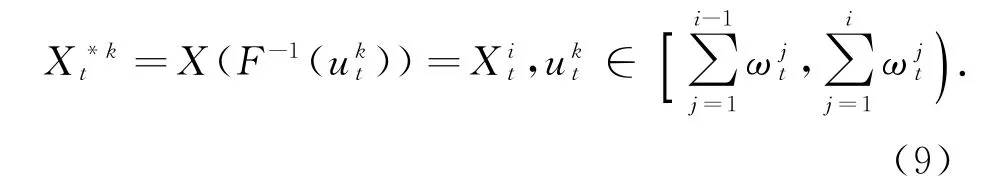

粒子滤波器经过多次迭代之后会出现权重恶化的现象.为了解决这个问题,可对粒子实施重采样算法.具体的重采样算法主要有多项式分布重采样、系统重采样、分层重采样以及残差重采样,各种重采样的定义和比较见文献[3,20].这里采用的是多项式分布重采样算法.产生在[0,1]内服从均匀分布的Ns个随机数,对任一个ukt,通过t时刻的粒子{Xit,的累积质量函数的反函数曲线,找到对应的粒子就是新的粒子,即得.由于每一个新采样的粒子出现的机会均等,所以新粒子的权重都是1/Ns.这一过程如式(9)所示.

2.2跟踪算法流程

本文跟踪算法流程如图2所示.在跟踪初始,选定跟踪目标的最小矩形区域(跟踪窗口),据此初始化目标状态参数,并根据式(2)计算模式原型的颜色特征向量Q0.将状态向量中的位置信息作为首层状态粒子.根据均匀的先验分布,在(x0,y0)周围采样Ns个粒子,得到粒子滤波器初始状态

在下一帧时,将系统的状态转移概率模型(式(8))作为重要性函数,产生新的Ns个粒子,得到首层粒子的预测值,并据图3所示向下衍生:自左而右为粒子衍生,自右而左为粒子参数求解过程.中间层粒子是根据首层粒子位置在3个不同角度下搜索目标,根据式(7)选取最优角度;底层粒子进一步在所在位置中采用不同尺寸搜索,根据式(5)选取最优尺寸.按图2自右而左计算最终得到第k个粒子的状态同理计算其他粒子.利用式(5)计算这Ns个粒子的似然概率并归一化为相应的权值,得的粒子滤波器,其中首层粒子为

图3 粒子的衍生过程Fig.3 Particle derivative process

根据所得到的Ns个状态值估计系统此刻的状态值.根据E(st)获取模式比较它与原型的相似性,并据此决定是否更新原型.若更新,则按照式(8)计算其特征作为新的目标原型特征;否则进一步判断目标是否消失.若未消失,则进入重采样进程;否则,退出.实验中,当观测窗口内的颜色特征与原型特征相似度小于0.7时,认为此时观测窗口内已经没有被跟踪目标,即目标丢失.其中,重采样据式(9)执行,获得新的粒子滤波器,其中首层粒子滤波器为.最后,根据新的首层粒子在下一帧传播以重复上述过程.

3 实验结果与分析

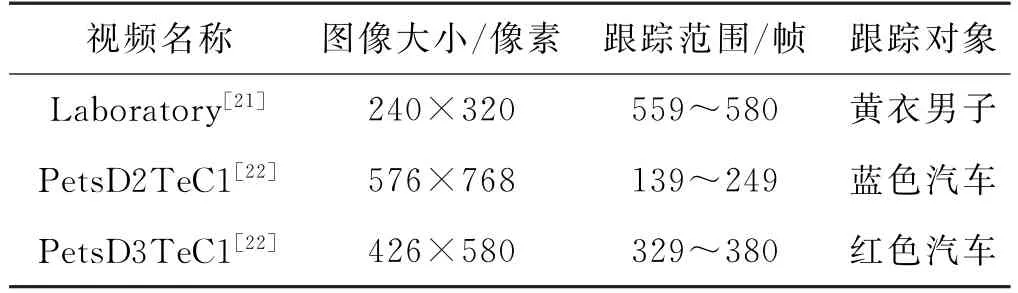

在实验中,算法的首层粒子数Ns等于20,程序均采用MATLAB 7.1编写,表1是跟踪视频资料.

3.1行人跟踪实验

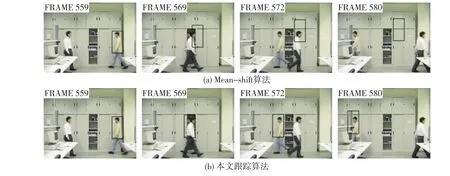

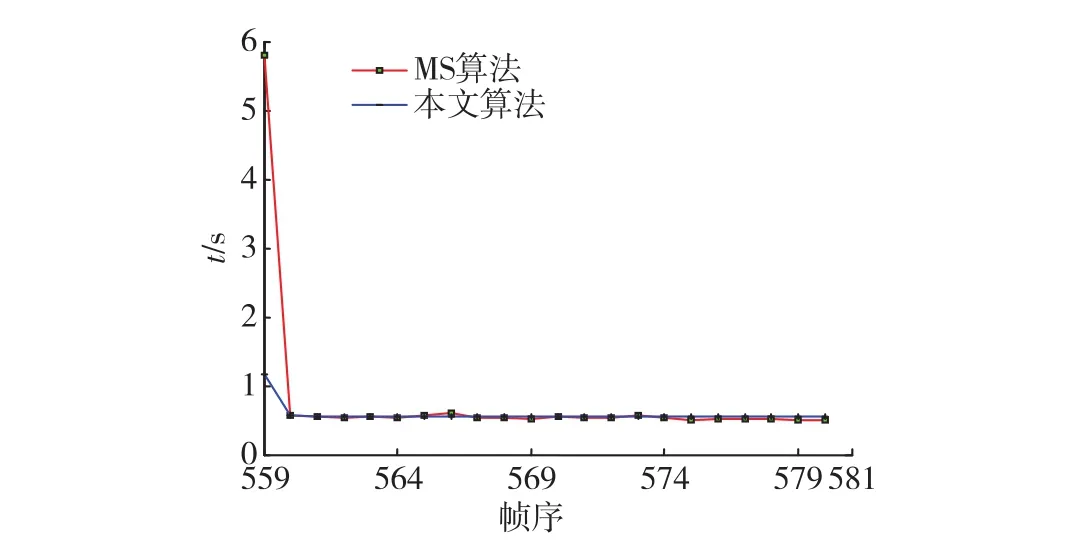

采用了2种不同的算法对Laboratory进行了实验,实验段为Laboratory的559~580帧.图4(a)的图片是采用Mean-shift算法(相应的实验程序编写根据文献[10]),图4(b)的图片是采用本文跟踪算法的实验结果.水平方向的跟踪轨迹如图5,算法在每一帧的耗时如图6所示.

表1 实验视频大小及跟踪范围Tab.1 Video sizes and the tracking frames

由图4与图5可知,在遮挡发生(即第569帧)时, Mean-shift算法错误地估计目标位置,且此后彻底丢失了目标.本文算法不但能在遮挡时正确估计目标位置,且在遮挡消除后迅速的捕捉到目标而继续跟踪(误差均值15像素,误差最大值28像素).由图6可知,运行时间上的区别主要体现在首帧的初始化过程,Mean-shift为5.79 s,本文算法为1.17 s,在此后的跟踪过程每帧耗时基本相同,平均每帧耗时分别为0.55和0.54 s.

3.2汽车跟踪实验

行驶的车辆在不同的帧中所呈现的角度和大小有很大的差异,本实验目的在于应用本文算法估计目标车辆的位置、大小和角度.目标的速度由目标中心的帧间差估计.

实验的跟踪效果如图7所示.黑色矩形是状态估计的输出:矩形的中心、对角线以及与X轴的夹角分别对应于目标的位置、目标大小以及运动方向.跟踪窗口能够根据当前帧中目标的状态自适应第调整窗口的位置、大小和方向.目标基准数据源于库中的Gruand Truth文件.

图4 行人实验跟踪结果Fig.4 Experimental results of people tracking

图5 水平方向跟踪轨迹比较Fig.5 Comparison of path tracking along X-axis

图6 跟踪时间比较Fig.6 Comparison of tracking time per frame

为衡量跟踪精度,对跟踪误差进行了统计:以目标在图像空间的质心作为实际位置,统计矩形中心对它的偏差,得到表2所示的统计结果.表中的相对误差值(相对误差=绝对误差值(像素)÷目标半径(跟踪窗口半径))考虑了目标尺寸的大小变化.从表2可知, 2种视频中跟踪误差的绝对值差异明显,PetsD3TeC1的绝对误差较PetsD2TeC1大,这是由于目标像素大小不同引起的:PetsD2TeC1中目标半径变化过程为63~91;PetsD2TeC1半径变化范围:149~90.比较2个视频的相对误差数据,在2个方向上的相对值都比较接近.所以,这里选择相对误差值作为跟踪精度的衡量指标,即选用考虑了目标尺寸的相对误差作为跟踪精度的衡量尺度.据表1可知,本文算法的平均跟踪误差约为10%.

图7 汽车跟踪实验结果Fig.7 Experimental results of vehicle tracking

表2 PetsD2TeC1与PetsD3TeC1的运动目标位置跟踪误差统计结果Tab.2 Statistical results of position-tracking error in the two video:video 2 and 3.

4 结 论

在贝叶斯滤波的框架下,本文详细分析了视频跟踪系统的状态转移模型与状态观测模型,提出了基于运动目标颜色与运动特征的粒子滤波自适应跟踪算法.

首先,从目标颜色特征的角度,在对颜色特征向量之间Bhattacharyya距离分解的基础上提出了一种新的相似性计算方法.其次,从运动特征的角度提出,通过连续2帧的光流分析检测目标运动方向进而确定观测窗口的旋转角度,并以此作为不同粒子的相似性测量依据.在跟踪算法方面,从贝叶斯滤波理论与蒙特卡洛方法出发,结合视频跟踪特点提出了粒子的3层设计结构,减少了系统状态维数的设计,并且精简了粒子数量.最后,设计了2种场景的实验:人体跟踪与遮挡情况下的跟踪、刚体(汽车)运动跟踪踪.试验中采用的20个首层粒子都能得到满意的实验效果.在没有遮挡的情况下,滤波估计输出的观测窗口都能够找到被跟踪目标,并且根据目标的变化自适应地调整跟踪窗口的大小和方向;在有遮挡的情形下也能够正确地估计出目标状态,并且在遮挡消除目标重新出现后,算法能够很快捕捉到并继续跟踪.实验证明,本文算法能够正确估计视频中被跟踪目标的状态,位置的相对误差约为10%.

参考文献:

[1] HO Y,LEE R.A Bayesian approach to problems in stochastic estimation and control[J].Automatic Control, IEEE Transactions on,1964,9(4):333-339.

[2] KITAGAWA G.Non-Gaussian state-space modeling of nonstationary time series[J].Journal of the American Statistical Association,1987,82(400):1032-1041.

[3] DOUCET A,GODSILL S,ANDRIEU C.On sequential Monte Carlo sampling methods for Bayesian filtering[J]. Statistics and Computing,2000,10(3):197-208.

[4] CRISAN D,DOUCET A.Convergence of sequential Monte Carlo methods[R].Cambridge:University of Cambridge,2000.

[5] GORDON D,SMITH F M.Novel approach to nonlinear and non-Gaussian Bayesian state estimation[J].IEEE Proceedings-F,1993,140(2):107-113.

[6] ISARD M A.Visual motion analysis by probabilistic propagation of conditional density[D].Oxford:University of Oxford,1998.

[7] KUN W,LIU X P.Visual object tracking based on filtering methods[C]∥2011 IEEE Instrumentation and Measurement Technology Conference (I2MTC).Hangzhou,China:IEEE,2011:1-6.

[8] 宋佳声,胡国清,焦亮.改进的几何活动轮廓演化及其在目标跟踪中的应用[J].华南理工大学学报(自然科学版),2015,42(1):72-78.

[9] LI C,XU C,GUI C,et al.Distance regularized level set evolution and its application to image segmentation[J]. IEEE Transactions on Image Processing,2010,19(12): 3243-3254.

[10] COMANICIU D,RAMESH V,MEER P.Kernel-based object tracking[J].Pattern Analysis and Machine Intelligence,IEEE Transactions on,2003,25(5):564-577.

[11] VALISKA J,MARCHEVSKY S,KOKOSKA R.Object tracking by color-based particle filter techniques in videosequences[C]∥Proceedings of 24th International Conference Radioelektronika.Bratislava,Slovak Republic: IEEE,2014:1-4.

[12] KIM S H,KIM J H,HWANG Y B,et al.Object tracking using KLT aided mean-shift object tracker[C]∥Control,Automation and Systems(ICCAS),2014 14th International Conference on.Gyeonggi-do,South Korea: IEEE,2014:140-145.

[13] DIWAKAR M,PATEL P K,GUPTA K,et al.Object tracking using joint enhanced color-texture histogram [C]∥2013 IEEE Second International Conference on Image Information Processing(ICIIP).Waknaghat, Shimla,H.P.,India:IEEE,2013:160-165.

[14] 牛长锋,陈登峰,刘玉树.基于SIFT特征和粒子滤波的目标跟踪方法[J].机器人,2010,32(2):241-247.

[15] LU X,SONG L,YU S,et al.Object contour tracking using multi-feature fusion based particle filter[C]∥Proceedings of the 2012 7th IEEE Conference on Industrial Electronics and Applications.Singapore:IEEE,2012: 237-242.

[16] 田隽,钱建生,李世银,等.应用自适应多测量融合粒子滤波的视场跟踪[J].光学精密工程,2010,18(10): 2254-2261.

[17] SONG J,HU G.Multi-feature visual tracking using adaptive unscented kalman filtering[C]∥The 2013 Sixth International Symposium on Computational Intelligence and Design.Hangzhou,China:IEEE,2013:197-200.

[18] 管志强,陈钱.基于光流直方图的云背景下低帧频小目标探测方法[J].光学学报,2009,28(8):1496-1501.

[19] HORN B,SCHUNCK P.Determining optical flow[J]. Artificial Intelligence,1981,17:185-203.

[20] HOL J D,SCHON T B,GUSTAFSSON F.On resampling algorithms for particle filters[C]∥2006 IEEE Nonlinear Statistical Signal Processing Workshop. Cambridge,UK:IEEE,2006:79-82.

[21] The Imagelab Laboratory of University of Modena and Reggio Emilia.Video surveillance online repository[DB/ OL].[2015-01-30].http:∥www.openvisor.org.

[22] Computation Vision Group of University of Reading.Performance evaluation in tracking for surveillance(PETS) [DB/OL].[2015-01-30].http:∥ftp.pets.rdg.ac.uk.

Particle Filtering Based on Color and Optical-flow Features for Video Tracking

SONG Jiasheng*,DAI Leyang

(Fujian Provincial Key Laboratory of Naval Architecture and Ocean Engineering, School of Marine Engineering,Jimei University,Xiamen 361021,China)

Abstract:For purposes of finding targets'state information,such as coordinates,speeds,sizes,and rotation,and to tackle the poor discrimination of color features of different patterns,the filtering algorithm of the three-level-particle frame,based on color and optical-flow features,is proposed for video tracking systems.First,the similarity measuring methods of color and optical-flow features between the target's candidate pattern and its prototype is analyzed and proposed.Then,the color and optical-flow features are applied into different levels of the hierarchic particle filter by the first level position particle's derivative process,which resolves the problem of multi-feature measuring fusion.Experimental results indicate that the proposed algorithm estimates the target's state correctly and tracks the target's state with no failure by adjusting the tracking window's position,size,and rotation adaptively,when there is no occlusion.Furthermore,the algorithm predicts the target's position correctly under occlusion and catches the position shortly when the occlusion disappears.Finally,the algorithm's precision of position tracking is approximately 10% of relative errors.

Key words:target tracking;particle filtering;color model;optical flow model;hierarchy particle structure

*通信作者:songjsh@jmu.edu.cn

基金项目:交通部应用基础研究项目(2015329815220);福建省教育厅科研项目(JA14175)

收稿日期:2015-06-01 录用日期:2015-10-08

doi:10.6043/j.issn.0438-0479.2016.02.023

中图分类号:TP 391.4

文献标志码:A

文章编号:0438-0479(2016)02-0285-06

引文格式:宋佳声,戴乐阳.应用颜色与光流特征的粒子滤波的视频跟踪[J].厦门大学学报(自然科学版),2016,55(2):285-290.

Citation:SONG J S,DAI L Y.Particle filtering based on color and optical-flow features for video tracking[J].Journal of Xiamen University(Natural Science),2016,55(2):285-290.(in Chinese)