教师TPACK结构真的合理吗?

——基于测量的TPACK理论反思

2016-03-10李雪情张哲王以宁

李雪情张哲王以宁

(1.东北师范大学 计算机科学与信息技术学院,吉林 长春 1 30117 2.东北师范大学 传媒科学学院,吉林 长春 1 30117)

教师TPACK结构真的合理吗?

——基于测量的TPACK理论反思

李雪情1张哲1王以宁2

(1.东北师范大学 计算机科学与信息技术学院,吉林 长春 1 30117 2.东北师范大学 传媒科学学院,吉林 长春 1 30117)

TPACK是目前国际上较为流行的描述教师技术整合知识结 构的理论框架。该理论自提出以来,由于其结构框架的不确定性饱 受争议。近期,西奥多・科帕查(Theodore J.Kopcha)、安妮・奥滕伯瑞特-莱夫特威奇(Anne Ottenbreit-Leftwich)、吉韫・荣格(Jiyoon Jung)和德里亚・贝斯尔(Derya Baser)采用多样化案例研究方法,通过检验施密特(Schmidt)等人在2009年开发的TPACK测量量表和哈里斯(Harris)等人在2010年开发的TPACK评价量规这两种最为常用的TPACK测量方法的聚合效度和区分效度,对TPACK理论框架的有效性进行了实证研究。该项研究的研究对象为27名职前教师。研究结果表明,TPACK框架中无论是相似结构的聚合效度还是不同结构之间的区分效度均呈现低水平。针对此问题,研究者提出了一些关于重新审视测量方法和TPACK框架本身的建议。

整合技术的学科教学法;TPACK;教师教育;技术整合

一、引言

2006年,米什拉(Mishra)和科勒(Koehler)把整合技术的学科教学法知识(TPACK)作为一个框架,认为TPACK可以提高教师使用技术的能力和促进教与学。但是,自从引入此框架,众多研究者对TPACK框架的有效性和合理性提出了质疑。2011年,格雷汉姆(Graham)曾指出了与模型的有效性(即TPACK结构不容易被定义或区分)和可预测性有关的问题: TPACK的不同维度之间的界限不清晰,并指出,“研究人员想高效地理解和有效地测量TPACK结构,他们必须清楚地了解PCK”[1]。2009年,安格里(Angeli)和瓦兰奈德(Valanides)认为TPACK模型在研究或教学实践应用中太复杂[2]。2010年,阿查波特(Archambault)和巴奈特(Barnett)同样指出,引进技术知识到PCK框架给已经不清的教学法和学科知识界限增加更多的困惑[3]。2013年 ,布兰特利-迪亚(Brantley-Dias)和厄特梅尔(Ertmer)认为如果将知识结构分成七个不同的部分,我们几乎不可能有区别地描述每一个结构[4]。

为了评估教师之间TPACK能力,研究人员已经开发了若干个注重有效性和可靠性的测量方法。但是,相关研究人员发现TPACK测量方法也是有问题的,这是由于对TPACK结构定义不清楚造成的[5]。另外一些人研究发现使用TPACK测量方法获得的调查结果在一致性上存在问题。[6]

评估TPACK理论框架的有效性的一种方法是检查相关联的测量方法的建构效度。建构效度是指某种测量工具是否能真正衡量它意图去测量的理论结构,建构效度分为两个子类:聚合效度和区分效度。

基于以上研究背景,西奥多・科帕查(Theodore J.Kopcha)、安妮・奥滕伯瑞特-莱夫特威奇(Anne Ottenbreit-Leftwich)、吉韫・荣格(Jiyoon Jung)和德里亚・贝斯尔(Derya Baser)做了一项研究,主要检验基于两种TPACK测量方法的聚合效度和区分效度水平。研究者主要依据以下3个问题开展此项研究:

1.在不同结构中,每一种测量方法怎么区分?

2.在每个类似的结构中,这些测量方法怎样聚合?

3.针对每一个相似的结构,在案例内或不同的案例间将会产生什么样的聚合模式?

二、理论基础

(一)TPACK维度

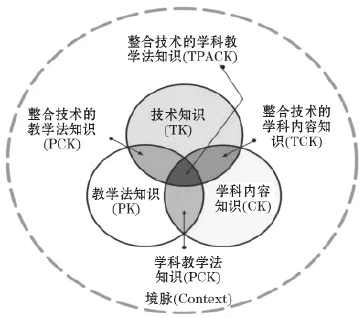

Mishra和Koehler提出把整合技术的学科教学法知识(TPACK)作为一个概念框架,它由七个不同的结构组成。这些结构是三个主要知识的相互作用:技术(TK)、内容(CK)和教学法知识(PK)。该框架是建立在舒尔曼(Shulman)教学内容知识(PCK)的基础上。舒尔曼把PCK定义为促进教学的特定学科内容知识,如一个人的课程知识、评估知识、特定科目概念误解的知识和为促进内容学习的技术知识[7]。随着人们对教育中的技术整合越来越有兴趣,学者们开始考虑技术将如何被纳入PCK框架[8]。

将TK添加到PCK知识中,我们将形成另外三个主体知识:技术—内容(TCK)、技术教学(TPK)和技术学 科教学法知识(TPACK)。Mishra、Koehler和施密特(Schmidt)把TK和CK的交集或者TCK描述为用技术知识以解决具体学科内容问题[9]。TK和PK的交集或TPK,是在某次教学中使用技术的知识,以改善教学方法和不受学科内容约束地提高使用教学技术的效率。TPACK最终的结构,代表了一个人在给定的学科内容领域中使用技术的丰富的教学法知识,如图1。

图1 整合技术的学科教学法知识(TPACK)框架

(二)TPACK测量方法

两个最常用的测量TPACK的方法: 一个是关于教师的知识自我报告式测量,一个是基于教学计划或教师的课堂观察的观察式测量[10]。一些学者认为使用这两个测量方法可以提高与TPACK研究相关的效度。[11]来源于同一理论的两个测量方法应该可以以相似的方式提供理论依据和基本结构,这是合乎逻辑的。[12]在TPACK案例中,这将意味着类似的结构应该是密切相关的(例如,如果用一种测量方法测量的TPK分数是高分,那么用另一个测量方法测量TPK时也是高分)并且表现出相同结构的类似证据。相反,不同的结构应该表现更明显的区别(例如,用一种测量方法测量的TPK分数与用相同或类似的测量方法测量的TCK的分数可以反映出不同的东西)。

2012年,霍弗(Hofer)和格兰德(Grandgenett)研究了8个在职教师的TPACK能力,主要利用了Schmidt等人在2009年开发的TPACK测量量表及三个学期内的访谈和课程教学计划的内容分析,他们发现这些测量方法的测量结果在得分上不一致[13]。2012年,阿格耶(Agyei)和基恩格威(Keengwe)使用五种不同的测量方法测量104个数学职前教师TPACK能力,其中包括Schmidt等人在2009年开发的TPACK测量量表和哈里斯(Harris)等人在2010年开发的TPACK评价量规这两种测量方法,结果发现建立一个可靠的TPACK评估是有困难的[14]。随着课程的开展,虽然调查结果显示教师在技术上变得娴熟和教学法上越来越有经验,但是教师的PK和PCK调查分数随时间呈现下降的趋势。这些研究表明,在实践中区分具体TPACK结构是有困难的。

在已有的关于TPACK测量的成熟的测量方法中,研究人员已经证实了这些问题。 在他们的一个TPACK研究的探索性因素分析中,2010年,Archambault和Barnett发现,尽管对TPACK的每个维度都已经创建了不同的题目,但是他们的调查题目仍然只加载到了一个单一的结构上。[15]Harris等人最终得出结论:TPACK的七个维度中只有四个可以使用他们的教学规划评价量规进行评价[16]。这两项研究表明了在他们寻找可以测量七个TPACK结构的测量工具时,研究人员遇到的困难。随着研究人员继续创造新的测量工具,这些困难也越来越明显。在已有的不同的TPACK测量方法中,2012年,Koehler等人报道少于10%的研究可以提供有效性的证据,并且这其中只有31%可以提供可靠性证据。研究者认为“在这个领域的所有的研究人员应该关心这种情况”。与TPACK结构的透明度相关联的问题呼吁我们必须严格评估TPACK框架及与它相关联的测量方法。

(三)聚合效度和区分效度

2008年,特罗克姆(Trochim)和唐纳利(Donnelly)提出,建构效度分为两个子类:聚合效度和区分效度。聚合效度的 建立是通过检查在相关的测量方法中类似的结构是否有联系,以及这些相似的结构是怎样联系的。[17]区分效度的建立是通过检查使用相同的测量方法在不同结构中是否有着明显的区别或检查不同的测量方法之间是否有明显的区分。这两个子类必须都存在才可以建立结构效度。如果基于同一理论基础的测量方法缺乏聚合,也无法区分,这表明该测量方法在其理论基础方面有更深层次的问题。

1988年,莱曼(Lehmann)解释了聚合效度和区分效度如何进行评估,即只需要证明一个结构的多样化的测量方法有两大特征:1.相关的;2.与其他结构的测量方法相比,彼此间有更多的相互关系。[18]换句话说,我们用同样的或不同的测量方法去测量不同的结构(如TCK相比TPK和TPACK)和相同的结构(如TPK相比TPK),两种测量方法的得分在测量相同的结构时应该表现出高水平的一致性。

三、研究方法

Theodore J.Kopcha等研究者采用混合的方法以多案例形式开展研究,用定量和定性分析来剖析案例中的模式。研究者主要围绕上面提出的3个问题进行定量和定性分析。定量数据包括使用Schmidt等人在2009年开发的TPACK测量量表和Harris等人在2010年开发的TPACK评价量规所获得的分数,定性数据来自结业文档的叙述。研究者一共调查了27个修读过一个学期的技术整合课程的基础教育职前教师。Schmidt等人开发的TPACK测量量表和Harris等人开发的TPACK评价量规是研究者使用的两种TPACK测量工具:Schmidt等人开发的测量量表是对教师TPACK知识进行问卷调查,Harris等人开发的评价量规主要评估在课程结束时形成的教案以确定教师的TPACK知识。两种测量工具的测量分数与鉴别特定的案例是有关系的,并且在这些案例中,两种测量方法之间的分数是一致或不一致的。这两项调查都会在课程的最后一周完成,与此同时教师们也会在那个时候提交完他们的教学设计方案和结业电子档案。在课程结业电子档案中,研究者还采用了整体叙事分析以阐明聚合的本质或在这些特殊的案例中测量方法间聚合的缺乏。

(一)参与人员

研究中共有27名参与者,其中24名来自小学教育专业,其他3名来自儿童早期教育专业。所有参与者都在中西部一所大学就读过一个学期的初级技术整合课程。参与者中新生占74%,大二学生占11%,大三学生占15%。完成本课程是参加教师教育项目的先决条件。

研究人员的角色是变化的。两个研究者是研究的参与者,他们参与课程的开发和传递。另有两个研究者没有参与课程,但他们是职前教师中技术整合和TPACK方面专家。

(二)教学情境

该课程有四个与TK、TPK、TCK和TPACK的结构一致的主要目标。本课程的目的是用各种教育软件展示技术技能(TK),设计能在课堂上利用技术的教学活动(TPK),选择并创建特定内容的教学技术资源(TCK),并计划一节技术整合的课程(TPACK)。在整个过程中,职前教师完成一些活动,这些活动要表明他们掌握了在具体的学科领域内不同类型的教育软件(TCK)及具体的技术整合概念和实践应用(TPK和TPACK)。学生在这过程中完成三个主要的目标。这些包括课程规划细节和课程结业文档的构建。

1.教学设计方案

学生完成两个教学设计方案,这两个设计方案使他们参与技术整合的决策。在每一个设计中,我们为学生呈现教学情境,这些情境激励他们围绕内容和环境条件整合技术。对每一个设计方案,学生需要完成一个详细的课程教学计划以便解决问题、列出详细的课堂教学程序和指导这门课程顺利开展教学方法。每个计划包括一个解释教学决策(TPK和TPACK)的基本原理和提供与课程输出相关的产品例子(TCK)。通过创设具体情境的规划文件,学生在课程期中和期末分两次完成教学方案的设计。

2.课程结业的电子档案袋

在电子学档中,学生创建了一个学习园地,包括多个能表现自己最好学习效果的作品。作为文档的一部分,学生应该拥有一个可以展示他们教学实践中技术应用情况和教学设计方案的学习园地。学生要进行深入的反思,这些反思概括了他们对TCK、TPK和TPACK的看法。

(三)数据收集工具

研究者使用两种流行的TPACK测量方法收集数据:Schmidt等人在2009年开发的TPACK测量量表和Harris等人在2010年开发的TPACK评价量规。研究者也依据一些案例开展了课程结业文档的全面分析,并且在这些案例中,两种测量方法表现出在同一TPACK结构中高水平聚合或低水平聚合。

1.Schmidt测量量表

Schmidt等人在2009年开发的五点式李克特TPACK测量量表被广泛地用来评估pk-6职前教师的在各种学科领域的知识。该量表包括了与TPACK七个子结构(例如,TK、CK、PK等)相一致的47道题目。量表开发后,Schmidt等人以165名小学教育专业的职前教师为研究对象,对量表进行了信度和效度检验。结果显示TPACK七个组成部分(即TK、CK、PK等)的内部一致性(Cronbach’s Alpha系数)介于0.75到0.89之间。弗伦克尔(Fraenkel)和瓦伦(Wallen)认为该系数高于0.70 即可表明量表具有较好的内部一致性。

2.Harris评价量规

Harris等人在2010年开发了一种在许多存在技术整合问题的K12在线课程或教学单元中得以证实的TPACK的评价量规。该评价量规的主要评价对象为TPACK结构中的TCK、TPK和TPACK三类知识元素,为对其进行评价,研究者建立了以下四个标准,并采用四点式量表作为评价方式。

课程目标和技术。为教学所选择的技术与课程目标(TCK)一致吗? (等级:强烈一致,一致,部分一致,不一致)

教学策略与技术。技术支持教学策略(TPK)吗?(等级:最佳的支持,支持,最低限度的支持,不支持)

技术选择。在制定的教学设计方案内选择适当技术(TPACK)。(等级:示范的,适当的但不是模范,稍微合适的,不适当的)

适合的。在制定的教学设计方案内,内容、教学方法和技术的整合(TPACK)程度如何?(等级:非常适合,适合,在某种程度上适合,不适合)。

Harris等人借助于15个训练有素、经验丰富的评估者以两个不同的实验确定了评价量规的可靠性和有效性。基于这项研究的参与者,内部一致性程度是0.93。

3.整体分析叙事

研究人员创建了一个叙事(400—600字),它详细地列出了课程结业文档的作品中可以体现TCK、TPK和TPACK能力的详细证据。课程结业的电子文档包含作品,这些作品既反映职前教师的知识(例如,他们对TPACK的详细的反思),也反映他们运用知识(例如,含有内容、策划文档和探索性网站等的原创视频)的能力。以这种方式与调查和评价量规测量方法相比,整体分析叙事更详细地提供教师TPACK能力的证明,但在某种程度上,它们是相一致的。

(四)分析

描述性统计是依据调查和评价量规的平均得分计算,这是针对所有参与者的TCK、TPK和TPACK的结构。评价量规分数通过把Harris评价量规应用到教学设计而获得,这些规划文件与该课程结束时完成的职前教师的教学设计方案相关。为了提高结果的一致性和数据可靠性,其中两个研究人员独立评估所有的教案设计,然后与另外两个研究人员共同商讨,达成统一意见。[19]

要回答前两个 研究问题,研究者依据调查和评价量规的平均得分计算斯皮尔曼(Spearman)等级秩序相关性,目的是为在TCK、TPK和TPACK结构的等级排序中决定测量方法间的一致性。每当与相同的结构有关的相关性分数很小时,即0.30或更小[20],我们需要进一步研究Spearman等级秩序相关性以评估在两个测量方法之间的高的聚合水平或低的聚合水平。两种类型的案件被确定为清晰一致和不一致性。一致性案例在两种测量方法的分数上有两个特征: 1.平均值上来说,接近或超过一个标准偏差;2.平均值上来说,接近或低于一个标准偏差。显然,对于不一致的案例,从平均值上,在一个测量方法上的分数是接近或超过一个标准偏差,在另一个测量方法上的分数接近或低于平均值的一个标准偏差。

要回答第三个研究问题,我们要对案例进行全面分析,在一个或多个结构中,这些案例呈现出明显的一致或不一致性(聚合或缺乏聚合)。通过一个独立编码和建立共识的迭代过程,每个案例都开发400—600字叙事[21]。迭代过程关注建立在TK、TCK、TPK和TPACK结构上的例子的一致性。

这些结构中,研究人员遇到了建立TCK样本的相当大的困难。研究人员发现很难区分具体学科内容问题(例如,学习数学中的分数概念)和使用技术解决这些问题的教学实践(例如,我们使用一组数字分数条,以一种可视化的方式来证明数学的推理)。对于全面的分析,研究人员不采用Harris等人的定义,因为这一定义更侧重于满足具体的内容标准。每个研究人员随后又检查另一个研究者的叙述和文档,并创建25—50字的包含确认或修正说明的概括。这种双编码的形式增强了结果的一致性[22]。

研究人员进行了案例内和不同案例间的分析,以确定跨越个体案例情况的模式。每个人的案例情况和数据(即Schmidt测量量表、量规、叙述概要)被组织成一个矩阵,以帮助分析。案例情况按一致性类型进一步划分,以帮助分离出一些模式,这些模式能说明这些测量方法间关系的本质和与这些方法相关的基本理论。在整个过程中,基于多个数据源和一致的成员检查,研究人员从案例内和不同案例间的分析中剖析出他们的研究结果。评分者间信度在不同案例分析中不能被统计测试,但通过建立共识和对差异达成一致而解决。

四、研究结论

通过对数据的分析,Theodore J.Kopcha等人进行了激烈的讨论,研究者们得出以下结论。

(一)这些测量结构中,Spearman等级秩序相关性暗示了低水平的聚合和区分。Schmidt测量量表和Harris评价量规分数在超过四分之一的案例中是一致的,以及在类似的TPACK结构之间的相关性很弱。

(二)在每一个测量方法中,不同TPACK结构显示出中度相关性。TCK、TPK和其他的与技术相关的TPACK结构之间是很难区分的。

(三)在大多数不一致的案例中,与Schmidt测量分数相比,全面分析更支持评价量规分数。虽然许多职前教师都能够在他们的结业档案反思中清楚地表述对TPACK的理解,但是他们很难设计出使用技术的教学设计文件,这些技术是适合特定受众和支持内容标准的。这可能暗示,Schmidt测量分数更好地反映了教师关于TPACK的想法,而不是他们实际知道或使用这些知识做什么。

(四)Schmidt调查问卷题目缺乏具体性,这降低了测量的准确性和有效性,并增加了偏差[23]。所以,增加Schmidt调查题目的具体水平可能是必要的,以便更准确地评估在特定具体的环境中教师实际上能做什么和不能做什么。关于评价量规,在每一个评价量规水平中,提供每个TPACK结构特定的环境的例子是增加测量方法灵敏性和更准确地描绘职前教师TPACK的一种方法。

(五)这项研究表明这两种测量方法在许多方面是有效的和可靠的,研究中提到的较低的聚合和区分水平不全是测量方法的责任。 穆泽(Mouza)等人指出,Schmidt测量方法是“开发迄今最成熟的工具,可以用来收集大样本的职前教师的定量数据”[24]。在很多方法中,整体分析在很多方面支持评价量规分数的有效性。在开发过程中,由于对信度和效度的强调,Schmidt测量量表和Harris评价量规都被TPACK的开创作者高度认可[25]。

(六)这两个测量方法之间的不一致水平应该被预期。每种测量方法以不同的方式提供了职前教师TPACK证据,而且自我评估的知识并不总是准确地反映一个人的实际能力。然而,在两个测量方法间期待相对的一致性水平是不合理的,甚至准确的一致性是不可能达到的。

(七)在实践中,大量的TPACK结构正在使TPACK框架的应用变得复杂化[26]。研究中的一致性和清晰度的缺乏需要我们进一步研究框架本身结构的本质,并有目的地将对TPACK结构中所有元素的关注减少为对由TK、TPK和TPACK组成结构或TPACK独立成为知识结构的关注,以便更好地评估教师队伍中有意义的技术整合能力。我们要想使TPACK框架更加完善(即使TK、TPK和TPACK更加突出):第一,框架要较好地反映教师教育项目的结构;第二,教师教育者要更加关注教师在实际中运用知识的能力。

五、启示

Theodore J.Kopcha等人的这项研究是在小样本量的情况下展开的,局限在职前教师教育背景下,这些问题使结果推广受到限制。但是,他们迈出了以经验为主研究TPACK框架的第一步。如果要想获得既简约又有包容性的理论,我们需要精炼框架。未来的研究可以通过对较复杂的大群体参与者的统计分析或通过与具体结构和研究方法相关的方差评估继续产生测量方法或相关的测量方法的聚合和区分效度证据。

[1]Abbitt,J.T.(2011).Measuring technological pedagogical content knowledge in preservice teacher education:a review of current methods and instruments.Journal of Research on Technology in Education,43(4),281.

[2]Angeli,C.,& Valanides,N.(2009).Epistemological and methodological issues for the conceptualization,development,and assessment of ICTeTPCK: advances in technological pedagogical content knowledge (TPCK).Computers & Education,52(1),154e168.

[3][15]Archambault,L.M.,& Barnett,J.H.(2010).Revisiting technological pedagogical content knowledge: exploring the TPACK framework.Computers & Education,55(4),1656e1662. http://dx.doi.org/10.1016/j.compedu.2010.07.009.

[4][26]Brantley-Dias,L.,& Ertmer,P.A.(2013).Goldilocks and TPCK: is the construct “just right?”.Journal of Research on Technology in Education,46(2),103e128.

[5]Brantley-Dias,L.,Kinuthia,W.,Shoffner,M.B.,de Castro,C.,& Rigole,N.J.(2007).Developing Pedagogical Technology Integration Content Knowledge in Preservice Teachers:A Case Study Approach.Journal of Computing in Teacher Education,23(4),143e150.

[6][14]Agyei,D.D.,& Keengwe,J.(2012).Using technology pedagogical content knowledge development to enhance learning outcomes.Education and Information Technologies,1e17. http://dx.doi.org/10.1007/s10639-012-9204-1.

[7]Shulman,L.S.(1986).Those who understand: knowledge growth in teaching.Educational Researcher,4e14.

[8]Pierson,M.E.(2001).Technology integration practice as a function of pedagogical expertise.Journal of Research on Technology in Education,33(4),n4.

[9]Schmidt,D.A.,Baran,E.,Thompson,A.D.,Mishra,P.,Koehler,M.J.,& Shin,T.S.(2009).Technological pedagogical content knowledge (TPACK):the development and validation of an assessment instrument for preservice teachers.Journal of Research on Computing in Education,42(2),123.

[10][25]Koehler,M.J.,Shin,T.S.,& Mishra,P.(2012).How do we measure TPACK? Let me count the ways.In Educational technology,teacher knowledge,and classroom impact: A research handbook on frameworks and approaches (pp.16e31).

[11]Cavanagh,R.F.,& Koehler,M.J.(2013).A turn towardspecifying validity criteria in the measurement of Technological Pedagogical Content Knowledge (TPACK).Journal of Research on Technology in Education,46(2),129e148.

[12][17]Trochim,W.M.,& Donnelly,J.P.(2008).Research methods knowledge base (3rd ed.).Mason,OH: Atomic Dog Publishing.

[13]Hofer,M.,& Grandgenett,N.(2012).TPACK development in teacher education: a longitudinal study of preservice teachers in a Secondary MA Ed.program.Journal of Research on Technology in Education,45(1),83e106.

[16]Harris,J.,Grandgenett,N.,& Hofer,M.(2010).Testing a TPACK-based technology integration assessment rubric.Society for Information Technology & Teacher Education International Conference,(1),3833e3840.

[18]Lehmann,D.R.(1988).An alternative procedure for assessing convergent and discriminant validity.Applied Psychological Measurement,12(4),411e423.http://dx.doi. org/10.1177/014662168801200409.

[19]Fraenkel,J.R.,& Wallen,N.E.(2006).How to design and evaluate research in education.McGraw-Hill.

[20]Cohen,J.(1988).Statistical power analysis for the behavioral sciences.Routledge Academic.

[21]Baxter,P.,& Jack,S.(2008).Qualitative case study methodology: study design and implementation for novice researchers. The Qualitative Report,13(4),544e559.

[22]Krefting,L.(1991).Rigor in qualitative research: the assessment of trustworthiness.The American Journal of Occupational Therapy,45(3),214e222.http://dx.doi.org/10.5014/ ajot.45.3.214.

[23]Desimone,L.M.(2009).Improving impact studies of teachers’professional development: toward better conceptualizations and measures.Educational Researcher,38(3),181.

[24]Mouza,C.,Karchmer-Klein,R.,Nandakumar,R.,Ozden,S. Y.,& Hu,L.(2014).Investigating the impact of an integrated approach to the development of preservice teachers’ technological pedagogical content knowledge (TPACK).Computers & Education,71,206e221.

(责任编辑 杜丹丹)

Is the Teachers’ TPACK Reasonable?—Based on the Reflection on the Theory of TPACK Measured

LI Xueqing1,ZHANG Zhe1,WANG Yining2

(1.School of Computer Science and Information Technology,Northeast Normal University,Changchun,Jilin,China 130117; 2.School of Media Science,Northeast Normal University,Changchun,Jilin,China 130117)

Now,Technological Pedagogical Content Knowledge (TPACK) is a very popular conceptual framework that describes teachers’ technology integration knowledge structure internationally.Since the introduction of the theory,it is controversial due to the uncertainty of its structure.Recently,Theodore J.Kopcha,Anne Ottenbreit-Leftwich,Jiyoon Jung and Derya Baser adopted diversified case study method and did a empirical study towards the effectiveness of TPACK theoretical framework through examining the convergent and discriminant validity of these two most common used TPACK measurement methods,namely,the TPACK rubrics explored by Schmidt et al.in 2009 and Harris et al.in 2010.The research object of this study is twenty-seven pre-service teachers.The research results revealed that convergent validity of similar structure and discriminant validity of different structures in TPACK all present low levels.To solve this problem,the researchers put forward some suggestions on re-examining the measurement methods and the TPACK framework itself.

discipline teaching method of integration technology;TPACK;teacher education;technology integration

G434

A

2096-0069(2016)01-0009-07

2015-12-17

本文获得东北师范大学教师教育研究基金重点项目“卓越教师素质结构实证研究”,东北师范大学教师教育研究基金一般项目“卓越教师培训能力迁移影响因素实证研究”, 东北师范大学教师教学发展基金项目“面向高水平复合型传媒人才UGMR创新培养模式的实践型教师共同体建设”(课题号15T1JGJ004)资助。

李雪情(1990— ),女,河南商丘人,东北师范大学计算机科学与信息技术学院硕士研究生,研究方向为计算机教育应用;张哲(1988— ),女,黑龙江哈尔滨人,东北师范大学计算机科学与信息技术学院博士研究生,研究方向为教师教育技术;王以宁(1957— ),男,吉林长春人,东北师范大学传媒科学学院教授,博士生导师,研究方向为新媒体教育应用和教师教育技术。