三维人脸表情识别研究与进展

2016-02-27潘志庚

严 政,潘志庚

(杭州师范大学数字媒体与人机交互研究中心,浙江 杭州 311121)

三维人脸表情识别研究与进展

严政,潘志庚

(杭州师范大学数字媒体与人机交互研究中心,浙江 杭州 311121)

摘要:随着人机交互与情感计算的快速发展,人脸表情识别已经成为研究热点.二维人脸表情图像对于姿态变化与光照变化不具备鲁棒性,为了解决这些问题,研究者们使用三维人脸表情数据进行表情分析研究.本文在前人工作的基础上,对三维人脸表情识别中的对齐与跟踪、表情数据库、特征提取等方面进行综述.指出人脸表情识别的热点与趋势以及存在的局限,并对未来发展进行了展望.

关键词:情感计算;表情识别;三维表情识别;表情特征提取

0引言

近20年来,国内外学者对人类行为的自动化理解作了很多的研究,它在心理学、人机交互、医疗与安全领域有广泛的应用.由于在情感计算、学习适应性教学系统和医疗健康管理中的重要作用,人类行为理解成为下一代计算机系统中的必要功能[1].

现有的人机交互领域中,对人类行为进行理解与交互的设备通常为传统的键盘与鼠标,这种设备局限使得体验过程中更需要用户强调其显式指令而忽略隐式指令(如用户情绪状态的变化).但是在人际互动中,用户情绪状态的变化却是一个不可忽略的基本元素,一些情绪状态会激发人的行为,而另外一些则使人际交流中的意义更加丰富.因此,传统的忽略隐式指令的人机交互方式在不经意间疏漏了大部分的有效信息,这也导致这种交互方式过于死板、不人性化,无法具备日常的社交能力.

人脸表情是用户情绪状态外化中不可忽略的一项,是人类情感交流手段中最强力、自然的一种,也是隐式指令中最有效的通道.人们通过表情可以表达强调、不关心、困惑、中意等意图,并能够实现与周边环境的互动[2].众所周知,过去20年这个研究领域在学术界颇受关注[3].与先前人脸表情识别综述相比[4-7],本文在对二维人脸表情识别现状进行分析之外,主要对三维人脸表情识别中的对齐与跟踪、表情数据库、特征提取与分类等方面进行分析.大多数现有二维人脸表情识别的实现方式如下:1)对精心摆拍的极端情绪图像进行训练和测试;2)对一小部分的原型表情进行识别;3)对FACS编码的人脸表情AU进行识别.

在前人的研究成果中,对6种原型表情摆拍图像的自动检测都获得了较高的准确率,可是由于自发表情在外观与时序上与之有较大差别,所以检测非实验室环境下的表情仍然比较难.另外,大多表情数据库只包含了在高度可控的情况下进行拍摄的摆拍表情图片,这些照片仅包括愤怒、恶心、恐惧、高兴、悲伤和惊喜这6种原型表情.近些年来,研究者的方向开始转为对自发表情及人脸表情AU进行检测分析,但由于局限性的存在,大部分系统对光照、遮挡、人脸外观(妆容和头发)等拍摄条件的变化仍然较为敏感.

根据识别结果进行划分,可以将当前研究方向分为两类:第一类是以原型表情为识别结果的,第二类是以人脸表情运动单元(AU)作为识别结果的.

自从人脸表情识别受到关注以来,大部分研究[8-12]专注于对原型表情进行识别,只有少量的研究[13-15]涉及非原型表情.而对非原型表情的研究包括外观状态如疲劳,也包括心理状态如赞同、担忧、感兴趣、思考、困惑等.现今针对人脸AU识别[16-18]的研究成果较几年前显著增加.其中Wang[8]通过构建空间域模板来识别姿态和自发性原型表情,定义了几何特征并通过其找出了摆拍表情与自发性表情的差别.Gonzalez[19]通过隐半马尔可夫模型用于进行AU的动态识别.虽然大多数现有自动人脸表情识别工作[9-12]都是针对基于摆拍的极端表情图像,但最近仍有一部分工作[8][20-21]研究自发人脸表情数据的自动识别分析.其中有许多研究[21-22]从自发表情而不是原型表情中提取特征训练模型识别人脸AU,也有一些研究[8]试图明确地找出自发表情与摆拍表情的区别.Valstar[23]首先通过对表情速度、强度、持续时间和脸部肌肉运动的相关性建模,将摆拍表情与自发表情分离开来.

1三维人脸表情识别

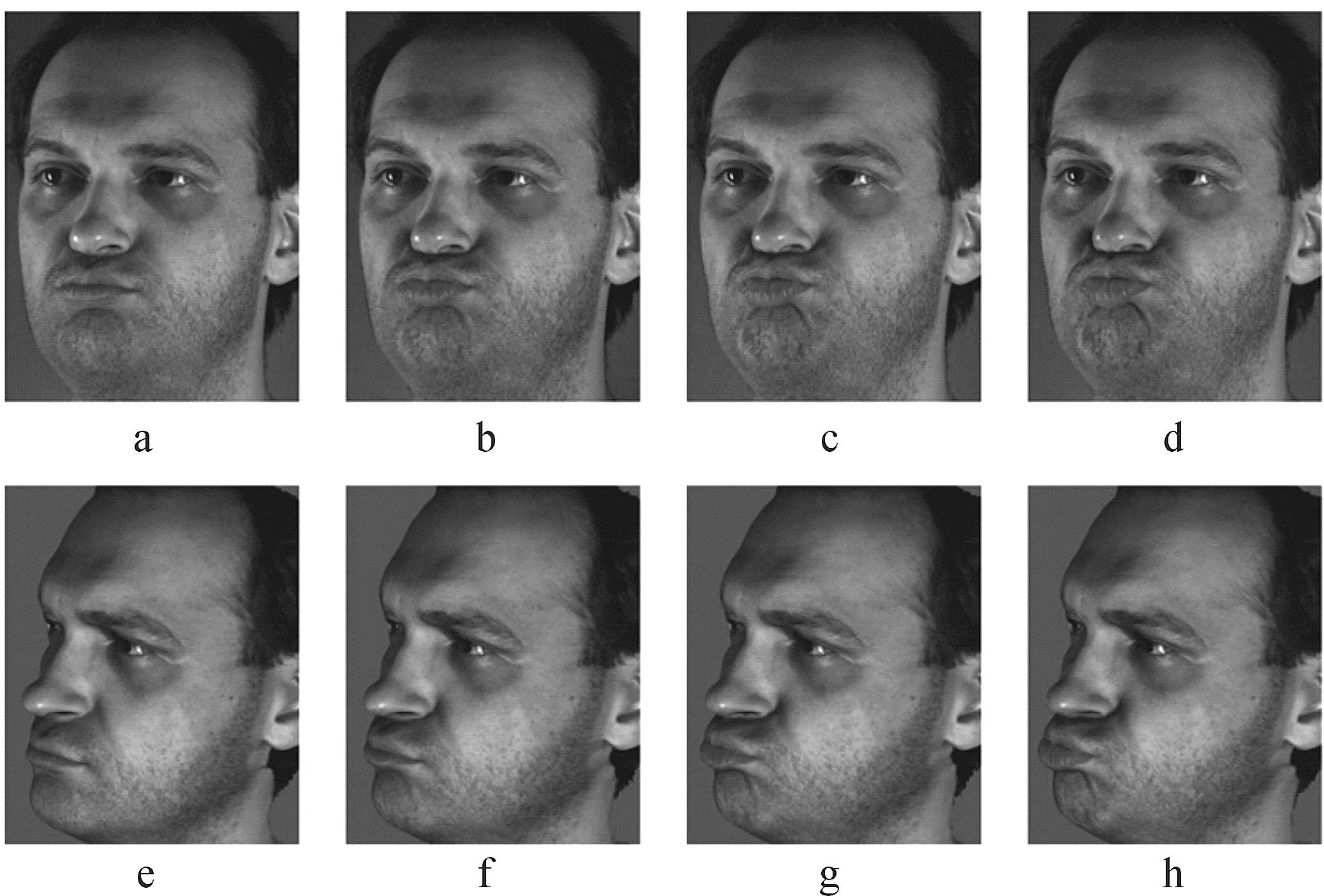

由于二维摄像机无法获取人脸表面的平面信息,所以单视角二维人脸表情的检测分析难以充分挖掘人脸信息.充分挖掘全部人脸信息需要多个二维摄像机同时拍摄,应用场景受到限制.为了解决这个问题,研究者们尝试使用三维数据进行检测和分析.通过在AU识别领域使用三维数据,可以检测人脸表面的轻微深度变化.如图1所示,在二维正面图像中,AU18(嘴唇皱起)很难与AU10+AU17+AU24(嘴唇上升、下巴上升及唇下压)区分开来,而在三维图像中则会变得容易区分.近期学界在结构光、立体摄影及立体测光方面的研究成果也使获取三维人脸结构和动作更为便利.

图1 二维和三维中捕捉到的AU 18,(a)-(d)是二维正面图像,(e)-(h)为三维重建数据Fig. 1 AU 18 captured with 2D camera (a)-(d) and 3D camera (e)-(h)

典型的三维人脸表情识别的流程如图2所示,首先对三维模型进行预处理,使用去噪、补洞等增强方法;然后对三维人脸进行对齐与跟踪;接着选用特征提取方法进行特征提取;最后使用特征分类方法进行判定.

图1 典型三维人脸表情识别流程Fig. 1 Typical work flow of 3D facial expression recognition

1.1 三维人脸的对齐与跟踪

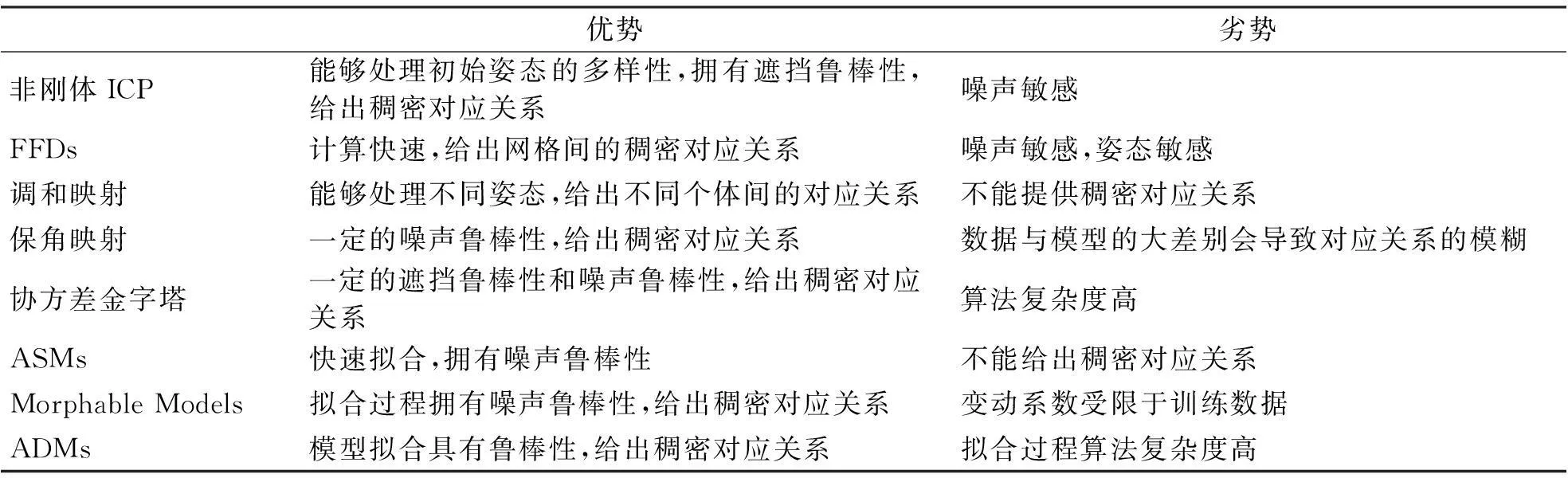

因为特征提取依赖于不同的人物能否定位到人脸的同一位置,以及能否在人脸上找到特定点的移动,所以准确的排列和跟踪算法至关重要.人脸网格间的稠密对应关系也同样重要,通过它们才能在不同人物和帧间跟踪人脸网格的运动.对于刚体的对齐,根据ICP算法(Iterative close point)[24],在不需要进行大规模的矩阵转置运算的情况下,就可以实现两个相似网格间的对齐算法.不过,对于非刚体对齐,则需要进行全对齐、稠密对应关系和跟踪,这些都需要更加复杂的算法.解决非刚体对齐的算法包括基于ICP的非刚体算法[25]、FFDs(Free-form deformations)[26]、调和映射[27]、保角映射[28]、ASM(Active shape model)[29]、协方差金字塔[30].算法对比见表1.

ICP(Iterative close point)是在三维人脸表情分析中被广泛使用的三维刚体对齐算法.不过,ICP的形式仅仅适合刚体变换,对于不同的人物和表情,ICP算法无法在网格中找到点的全对应关系.因此需要一个算法来生成全稠密对应关系的映射或非刚体变换.Amberg[25]提出了一种非刚体的ICP算法,这个算法引入一个刚度值,控制每一次迭代中变换的程度.

FFDs是另一族用于非刚体注册的算法,由Rueckert[29]提出.该算法的特点是通过操纵控制点的单元网格来使物体变形.首先对原网格中的单元网格通过一个最优化过程,在目标网格上进行注册,接着在变形中使用B样条插值,在两个三维网格中建立点对点的映射.Wang[26]使用该算法将粗糙的脸部网格拟合到表情序列的第一帧,Sandbach[27-28]则使用该算法在三维表情图像序列中追踪人脸网格的运动.Tsalakanidou[31-32]使用了ASM主动形状模型来实现对人脸特征点的追踪.

表1 三维人脸对齐与跟踪算法比对

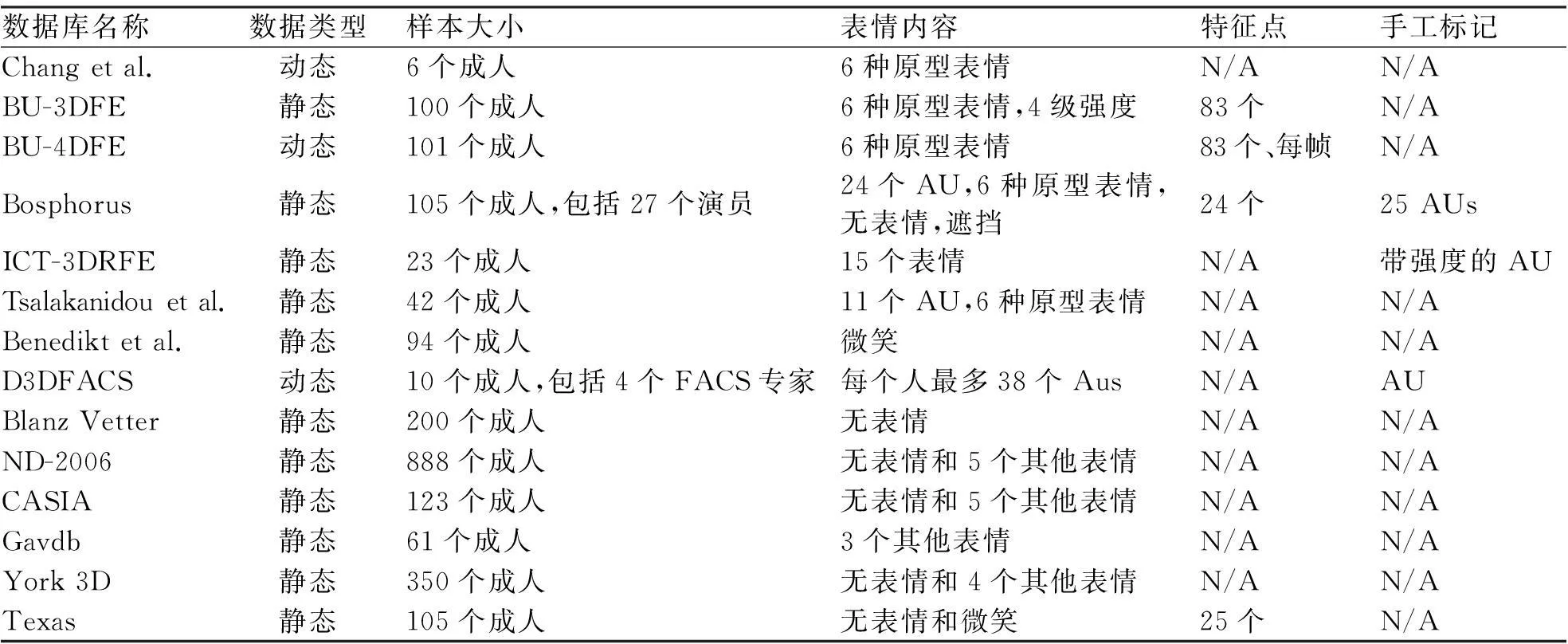

1.2 三维人脸表情数据库

过去20年间,研究者们建立了三维人脸数据库用于进行人脸建模和人脸识别.各个数据的比较见表2.Chang[33]通过使用结构光投射采集建立了第一个三维人脸表情数据库,其中包括6个人物,每个人物拥有6种原型表情.BU-3DFE数据库是首个成体系的人脸表情数据库[34],也是第一个可以用于人脸表情识别的数据库.它包含了100个人物以4种不同强度、6种原型表情表现的三维人脸.这些模型根据人物脸部的大小,由20000到35000不等的多面体构成,此数据库还包含了每个人脸模型的83个脸部特征点坐标作为补充数据.

BU-4DFE[35]是首个包含三维人脸表情序列的数据库,使用DI3D动态人脸捕捉装置,对101个人物进行表情捕捉.此数据库包含了6种原型表情的三维表情序列,其中每段都持续4 s左右.这个库的视频具有25/s的帧率及35000个顶点,可惜并没有提供AU信息.

另一个包含静态三维人脸表情模型的公开数据库是Bosphorus数据库[36].这个数据库通过Inspeck Mega Capturor II 3D设备,对105个人物进行多姿态、表情和遮挡环境下的模型采集.每个人物都演绎了6种原型表情及24种AU,并对24个AU进行了手工标记.该数据库中,图像大小为1600*1200,三维人脸模型包含35000个顶点,随库附带24个对鼻尖、眼角等人脸特征点的手工标记.

最近公布的ICT-3DRFE[37]数据库包含了在不同光照条件下的超高清三维数据,可以用于测试自动三维人脸表情识别系统的性能.该数据库包含了23个人物各15种表情,而每个模型包含1200000个顶点,对于每一段表情序列,都添加了人工标记的AU信息,根据肌肉活跃的程序给定0到1之间的强度值.

表2 三维人脸表情数据库比较

1.3 三维人脸表情特征提取

三维人脸表情识别的主流研究方向[38-42][20,43]是对静态三维人脸表情数据进行识别,不过最近有一些研究者开始对动态三维人脸表情数据[35][44-45]进行识别.静态表情数据与动态表情数据的不同导致了特征提取方法间的巨大区别,下文将对这两种特征提取方法分别进行叙述.

1.3.1静态三维表情识别

静态三维表情识别可以应用许多特征提取方法,包括距离特征、基于斑纹的特征、主动形状模型、二维纹理特征,对这些特征进行分类可以识别原型表情和AU.

1) 距离特征:距离特征是静态三维表情识别中使用最广泛的表情特征,它是通过对特定脸部特征点求距离所得.与二维几何方法跟踪脸部基准点类似,当三维脸部发生形变时,特征将发生变化.BU-3DFE表情库提供了83个脸部特征点的坐标,这些点的坐标以及它们的距离被广泛应用在静态三维人脸表情分析中.其中Soyel[38]使用了6种距离公式,对BU-3DFE中11个人脸特征点的位置提取特征并分类,获得了91.3%的准确率.Tang[39]在人脸特征点距离的基础上,提出了FAPUS(Facial Animation Parameter Units)距离,取得了95.1%的准确率.

2) 基于斑纹的特征:基于斑纹的特征是另一种使用广泛的表情特征,通常使用斑纹特征可以获得网格每个点周围的形状信息,也可以获得每个脸部特征点周围的形状信息.Wang[19]在网格中的每个点上使用多项式光滑斑纹,并将其作为输入去计算特征,在包含6种原型表情的自建库中取得了83.6%的准确率.

3) 形变模型:形变模型拥有众多变种,可以用于身份建模、表情建模,或者同时对两者建立混合模型.Ramanathan[46]提出了形变表情模型MEM,可以对特定个体的一系列不同表情进行建模.Zhao[47]提出了SFAM模型用于识别表情,通过使用多尺度LBP特征作为图像表征,在BU-3DFE表情库上达到87.2%的平均识别率.

4) 二维纹理特征:通过将三维模型数据映射到二维图像,可以提取出该三维模型对应的二维纹理特征.Berretti[48]使用三维人脸网格的深度图,将图像x、y坐标的深度值作为二维纹理特征,然后通过SIFT算法提取特征,在BU-3DFE表情库中取得了78.4%的平均识别率.Vretos[49]首先对整个图像的深度信息进行直方图均衡化,然后使用Zernike矩进行分类,在BU-3DFE和Bosphorus库上分别取得了73.0%和60.5%的表情识别率.

1.3.2动态三维表情识别

动态三维表情识别即使用三维表情模型序列而非单个或者多个静态三维表情模型进行的表情识别.Chang[33]使用特征点追踪表情变化过程中三维网格的形变.Yin[44]首先使用三维运动特征进行人脸表情分析,他使用一个形变模型追踪帧之间的变化,计算运动向量,对其提取特征进行分类,在BU-4DFE表情库上取得了80.2%的准确率.

1.4 三维人脸表情特征分类

三维人脸表情识别中使用的特征提取和特征分类方法通常与二维人脸表情识别中使用的方法类似,这里不再赘述.

2总结

从表情识别的发展现状来看,有以下几个热点和趋势:识别效率和速率提高,不断有新的识别方法和改进方案被提出;从针对摆拍的表情识别往针对自发表情的识别发展;二维表情识别无法处理出平面信息,三维表情识别正在成为研究热点;从针对静态图像的表情识别转为针对动态图像序列的表情识别;从对6种原型表情的识别转为对更精细的AU、特殊表情的识别发展.另外,表情识别还存在以下的不足:缺乏对复杂光照、姿态、遮挡的表情识别研究;自发表情数据库不足;对混合表情、非基本表情的研究欠缺深度.

鉴于以上分析,笔者认为在人脸表情识别领域,虽然基础研究已经相当丰富,已经取得了可喜的成绩,但和人类出众的表情识别能力相比,仍有相当大差距,表情识别暂时难以获得商业上的应用.在未来的人机交互中,计算机对隐式信息的理解必然是情感计算的重点,而人脸表情又包含了最多的人类隐式信息,表情识别必将在未来人机交互及情感计算中占据重要的地位.

参考文献:

[1] PANTIC M, NIJHOLT A, PENTLAND A, et al. Human-Centred Intelligent Human? Computer Interaction (HCI2): how far are we from attaining it?[J]. International Journal of Autonomous and Adaptive Communications Systems,2008,1(2):168-187.

[2] AMBADY N, ROSENTHAL R. Thin slices of expressive behavior as predictors of interpersonal consequences: a meta-analysis[J]. Psychological bulletin,1992,111(2):256-274.

[3] PAUL S, PETER A, PIETROBON N, et al. Visual and spectrophotometric shade analysis of human teeth[J]. Journal of Dental Research,2002,81(8):578-582.

[4] 王志良,陈锋军,薛为民.人脸表情识别方法综述[J].计算机应用与软件,2004,20(12):63-66.

[5] 薛雨丽,毛峡,郭叶,等.人机交互中的人脸表情识别研究进展[J].中国图象图形学报,2009,14(5):764-772.

[6] 孙蔚,王波.人脸表情识别综述[J].电脑知识与技术,2012,8(1):106-108.

[7] 王大伟,周军,梅红岩,等.人脸表情识别综述[J].计算机工程与应用,2014,50(20):149-157.

[8] WANG S F, WU C L, HE M H, et al. Posed and spontaneous expression recognition through modeling their spatial patterns[J]. Machine Vision and Applications,2015,26(2):219-231.

[9] FARAJZADEH N, PAN G, WU Z H. Facial expression recognition based on meta probability codes[J]. Pattern Analysis and Applications,2014,17(4):763-781.

[10] YANG M X, ZHENG S M, LI Y. Facial expression recognition based on LBP and SVM decision tree[C]//IIICFC. 2015 International Industrial Informatics and Computer Engineering Conference. Atlantis:Atlantis Press,2015:651-655.

[11] SIDDIQI M H, ALI R, KHAN A M. Human facial expression recognition using stepwise linear discriminant analysis and hidden conditional random fields[J]. IEEE Transactions on, Image Processing,2015,24(4):1386-1398.

[12] JIA Q, GAO X K, GUO H, et al. Multi-layer sparse representation for weighted LBP-patches based facial expression recognition[J]. Sensors,2015,15(3):6719-6739.

[13] GU H S, JI Q. An automated face reader for fatigue detection[C]//6th IEEE International Conference on.Automatic Face and Gesture Recognition, Proceedings.[S.l]: IEEE,2004:111-116.

[14] JI Q, LAN P, LOONEY C. A probabilistic framework for modeling and real-time monitoring human fatigue[J]. IEEE Transactions on, Systems, Man and Cybernetics, Systems and Humans,2006,36(5):862-875.

[15] KALIOUBY R E, ROBINSON P. Real-time inference of complex mental states from facial expressions and head gestures[M]//Real-time vision for human-computer interaction. NewYork:Springer US,2005:181-200.

[16] VAN DER MAATEN L, HENDRIKS E. Action unit classification using active appearance models and conditional random fields[J]. Cognitive processing,2012,13(Suppl2):507-518.

[17] GIRARD J M, COHN J F, JENI L A, et al. Spontaneous facial expression in unscripted social interactions can be measured automatically[J]. Behavior research methods,2015,47(4):1136-1147.

[18] ALKAWAZ M H, MOHAMAD D, BASORI A H, et al. Blend Shape Interpolation and FACS for Realistic Avatar[J]. 3D Research,2015,6(1):1-10.

[19] WANG J, YIN L J, WEI X Z, et al. 3D facial expression recognition based on primitive surface feature distribution[C]//2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. [S.l.]:IEEE,2006,2:1399-1406.

[20] RAMANATHAN S, KASSIM A, VENKATESH Y V, et al. Human facial expression recognition using a 3D morphable model[C]//2006 IEEE International Conference on Image Processing. Atlanta:IEEE,2006:661-664.

[21] HE S, WANG S E, LYU Y P. Spontaneous facial expression recognition based on feature point tracking[C]//2011 Sixth International Conference on Image and Graphics. Hefei:IEEE,2011:760-765.

[22] BARTLETT M S, BRAATHEN B, SEJNOWSKI T J, et al. A prototype for automatic recognition of spontaneous facial actions[C]//Advances in neural information processing systems.[S.l]: NIPS,2002:1271-1278.

[23] VALSTAR M F, PANTIC M, AMBADAR Z, et al.Posed facial behavior: automatic analysis of brow actions[C]//Proceedings of the 8th international conference on Multimodal interfaces. NewYork:ACM,2006:162-170.

[24] BESL P J, MCKAY N D. Method for registration of 3-D shapes[M]//Schenker P S. Control paradigms and Data Structures. Boston:International Society for Optics and Photonics,1992:586-606.

[25] AMBERG B, ROMDHANI S, VETTER T. Optimal step nonrigid ICP algorithms for surface registration[C]//IEEE Conference on Computer Vision and Pattern Recognition. Minneapolis:IEEE,2007,1-8:1491-148.

[26] WANG Y, GUPTA M, ZHANG S, et al. High resolution tracking of non-rigid motion of densely sampled 3D data using harmonic maps[J]. International Journal of Computer Vision,2008,76(3):283-300.

[27] SANDBACH G, ZAFEIRIOU S, PANTIC M, et al. A dynamic approach to the recognition of 3d facial expressions and their temporal models[C]//2011 IEEE International Conference on Automatic Face & Gesture Recognition and Workshops. Santa Barbara:IEEE,2011:406-413.

[28] SUN Y, CHEN X C, ROSATO M, et al. Tracking vertex flow and model adaptation for three-dimensional spatiotemporal face analysis[J]. IEEE Transactions on Systems, Man and Cybernetics: Systems and Humans,2010,40(3):461-474.

[29] RUECKERT D, SONODA L I, HAYES C, et al. Nonrigid registration using free-form deformations: application to breast MR images[J]. IEEE Transactions on Medical Imaging,1999,18(8):712-721.

[30] SAVRAN A, SANKUR B TAHA, BILGE M. Comparative evaluation of 3D vs. 2D modality for automatic detection of facial action units[J]. Pattern recognition,2012,45(2):767-782.

[31] TSALAKANIDOU F, MALASSIOTIS S. Real-time facial feature tracking from 2D+3D video streams[C]//3DTV Conference.[S.l.]:IEEE,2010:1-4.

[32] TSALAKANIDOU F, MALASSIOTIS S. Real-time 2D+3D facial action and expression recognition[J]. Pattern Recognition,2010,43(5):1763-1775.

[33] CHANG Y, VIEIRA M, TURK M, et al. Automatic 3D facial expression analysis in videos[M].ZHAO W U, GONG S G, TANG X O. Analysis and Modelling of Faces and Gestures. Berlin:Springer,2005:293-307.

[34] YIN L J, WEI X Z, SUN Y, et al. A 3D facial expression database for facial behavior research[C]//7th International Conference on Automatic face and gesture recognition. Southampton:IEEE,2006:211-216.

[35] YIN L J, CHEN X C, SUN Y, et al. A high-resolution 3D dynamic facial expression database[C]//8th IEEE International Conference on Automatic Face & Gesture Recognition. Amsterdam:IEEE,2008:1-6.

[37] STRATOU G, GHOSH A, DEBEVEC P, et al. Effect of illumination on automatic expression recognition: a novel 3D relightable facial database[C]//2011 IEEE International Conference on Automatic Face & Gesture Recognition and Workshops. Santa Barbara:IEEE,2011:611-618.

[38] SOYEL H, DEMIREL H. Facial expression recognition using 3D facial feature distances[M]. KAMEL M, CAMPILHO A. Image Analysis and Recognition. Berlin:Springer Berlin Heidelberg,2007:831-838.

[39] TANG H, HUANG T S. 3D facial expression recognition based on properties of line segments connecting facial feature points[C]//8th IEEE International Conference on Automatic Face & Gesture Recognition. Amsterdam:IEEE,2008:110-115.

[40] LI X L, RUAN Q Q, MING Y E. 3D facial expression recognition based on basic geometric features[C]//IEEE 10th international confence on signal processing proceedings. Beijing:IEEE,2010:1366-1369.

[41] TEKGUC U, SOYEL H, DEMIREL H. Feature selection for person-independent 3D facial expression recognition using NSGA-II[C]//24th International Symposium on Computer and Information Sciences. Guzelyurt:IEEE,2009:35-38.

[42] SHA T, SONG M L, BU J J, et al. Feature level analysis for 3D facial expression recognition[J]. Neurocomputing,2011,74(12):2135-2141.

[43] SRIVASTAVA R, ROY S. 3D facial expression recognition using residues[C]//TENCON 2009-2009 IEEE Region 10 Conference.Singapore:IEEE,2009:1160-1164.

[44] YIN L J, WEI X Z, LONGO P, et al. Analyzing facial expressions using intensity-variant 3D data for human computer interaction[C]//18th International Conference on Pattern Recognition. Hongkong:IEEE,2006,1:1248-1251.

[45] ROSATO M, CHEN X C, YIN L J. Automatic registration of vertex correspondences for 3D facial expression analysis[C]//2nd IEEE International Conference on Biometrics: Theory, Applications and Systems. Arlington:IEEE,2008:223-229.

[46] WAN S H, AGGARWAL J K. Spontaneous facial expression recognition: a robust metric learning approach[J]. Pattern Recognition,2014,47(5):1859-1868.

[47] ZHAO X, HUANG D, DELLANDRÉA E, et al. Automatic 3D facial expression recognition based on a Bayesian Belief Net and a Statistical Facial Feature Model[C]//20th International Conference on Pattern Recognition. Istanbul:IEEE,2010:3724-3727.

[48] BERRETTI S, AMOR B B, DAOUDI M, et al. 3D facial expression recognition using SIFT descriptors of automatically detected keypoints[J]. The Visual Computer,2011,27(11):1021-1036.

[49] VERTOS N, NIKOLAIDIS N, PITAS I. 3D facial expression recognition using Zernike moments on depth images[C]//2011 18th IEEE International Conference on Image Processing. Brussels: IEEE,2011:773-776.

第15卷第1期2016年1月杭州师范大学学报(自然科学版)JournalofHangzhouNormalUniversity(NaturalScienceEdition)Vol.15No.1Jan.2016

The Researches and Progress of 3D Facial Expression Recognition

YAN Zheng, PAN Zhigeng

(Digital Media & Interaction Research Center, Hangzhou Normal University, Hangzhou 311121, China)

Abstract:With the fast development of human-computer interaction, the recognition of facial expression has already become the research focus. 2D facial expression images do not have the robustness of posture change and illumination variation. In order to solve these problems, researchers use 3D facial expression data to analyze expression. Basing on the prophase work, this survey summarizes the registration and tracing, expression data and feature extraction in 3D facial expression recognition. The focus, trend and limitation of facial expression recognition are put forward, and the future development is discussed.

Key words:affective computing; facial expression recognition; 3D facial expression recognition; facial expression feature extraction

文章编号:1674-232X(2016)01-0088-07

中图分类号:TP391.4

文献标志码:A

doi:10.3969/j.issn.1674-232X.2016.01.017

通信作者:潘志庚(1965—),男,教授,博士,主要从事虚拟现实与人机交互研究.E-mail:zgpan@cad.zju.edu.cn

基金项目:国家科技支撑计划项目(2013BAH24F00); 国家科技支撑计划项目(2015BAK04B05).

收稿日期:2015-04-16