心理学研究中的可重复性问题:从危机到契机*

2016-02-02胡传鹏过继成思宋梦迪彭凯平

胡传鹏 王 非 过继成思 宋梦迪 隋 洁 彭凯平

(1清华大学心理学系, 北京 100084)

(2 Department of Experimental Psychology, University of Oxford, Oxford, OX1 3UD, UK)

1 引言

可重复性(replicability)是判断科学研究结果是否可靠的重要标准(Schmidt, 2009), 然而可重复性问题困扰着科学研究的许多领域(Begley &Ellis, 2012; Chang & Li, 2015; Ioannidis, 2005;Tajika, Ogawa, Takeshima, Hayasaka, & Furukawa,2015)。早在2005年, 就有研究者指出, 大部分研究结果可能都是不可靠的(Ioannidis, 2005), 有些研究领域的可重复率只有 11% (Begley & Ellis,2012)。最近Nature杂志对1500多名研究者的调查也表明, 90%接受调查的研究者认为, 在科学界存在着可重复危机(Baker, 2016)。近年来可重复性问题在心理学中也日益受到关注(Schooler, 2014;Spellman, 2015)。由于心理学研究对法律和政策的影响(胡传鹏, 邓晓红, 周治金, 邓小刚, 2011),可重复性问题对政策甚至是法律产生的影响也受到关注(Chin, 2014)。因此, 心理学研究者近年来积极地讨论可重复性问题的原因及对策, 这些努力的结果不仅正在改变心理学研究的格局, 也为其他研究领域应对可重复问题提供良好的借鉴。

心理学研究者对可重复性问题的关注始于2011年初, 康奈尔大学心理学家Daryl Bem在社会心理领域顶级期刊Journal of Social and Personality Psychology(JPSP)上发表关于预知未来的研究(Bem, 2011; Miller, 2011), 但重复实验却未能得到与其相同的结果(Galak, LeBoeuf, Nelson, &Simmons, 2012; Ritchie, Wiseman, & French, 2012)。不久, Simmons, Nelson和 Simonsohn (2011)在Psychological Science上发表了题为《False Positive Psychology》的论文, 揭示心理学研究中假阳性过高的现象及原因, 引起广泛重视。同年11月, 荷兰心理学家Diederik Stapel数据造假事件被曝光,在心理学研究领域更是投下了重磅炸弹。调查显示, 其职业生涯的137篇论文中, 有55篇数据均属造假, 其中不乏顶级期刊如Science和JPSP发表的论文。调查报告指出, 此造假事件除了Stapel个人的原因外, 心理学研究方法与审稿标准的严谨性不足也难辞其咎, 对心理学研究领域提出了责难(Alberts, 2011; Enserink, 2012; Ten for 2011)。 随后, 大量重复实验均未能重复先前研究的结果(如Doyen, Klein, Pichon, & Cleeremans (2012)和Lurquin 等(2016), 以及 PsychFileDrawer: http://psychfiledrawer.org/上的大量报道), 使得心理学研究的科学性受到质疑(Pashler & Wagenmakers,2012)。至此, 可重复危机(replication crisis)的说法受到广泛关注(Schooler, 2014; Yong, 2012)。

面对可重复性问题, 心理学研究者积极地分析其原因、探索其对策:不仅在学术期刊中组织专刊对可重复性问题进行讨论(Barch & Yarkoni,2013; Pashler & Wagenmakers, 2012; Spellman,2012, 2013), 也召开关于可重复性问题的专题研讨会(如英国心理学会组织的 Open Debate on Replication and Reproducibility in Psychological Science)。这些关于可重复性问题的讨论, 可能成为心理学学科发展的重要契机。充分了解这些变化对未来的研究有着重要的参考价值。本文旨在分析可重复性问题的现状, 探讨可重复性问题的原因和解决方案, 希望能在此基础上, 促进学术期刊、一线研究人员以及教学工作者对这一问题的了解与关注, 从而能够更好地应对。

2 可重复性问题的现状

虽然早已有研究者指出可重复性标准在心理学研究中的重要性(Schmidt, 2009), 但重复研究并未受到重视。对心理学文献的分析表明, 重复研究仅占全部文献量的 1.07%(Makel, Plucker, &Hegarty, 2012)。对2000年到2002年在精神病领域的83篇高引用率文献进行分析也表明, 其中40篇文献未得到任何的重复(Tajika et al., 2015)。正由于重复研究的缺乏, 研究者无法准确评估整个心理学领域的可重复性状况。为了解决这一问题,研究者试图采用大规模重复实验直接重复已发表研究, 以评估心理学领域的可重复性现状。

2.1 大规模直接重复实验的努力

尽管完全精确的重复在哲学上是不可能的(Earp & Trafimow, 2015), 但是尽可能贴近原实验进行直接重复(direct replication), 能够相对直观地对已有研究的可重复性进行评估。然而, 要对整个心理学研究领域进行大规模的重复实验, 仅靠单个研究团队很难实现。在此背景之下, Nosek等创立了开放科学中心(Center of Open Science,COS)。该中心创建了开放科学框架(Open Science Framework, OSF)平台, 使得全世界的研究者可以合作进行实验, 大规模重复实验也成为可能。作为初步的尝试, COS组织了“多实验室项目”(Many Labs Project, 以下称为ML2014)。该项目选取13个经典的社会心理学效应进行重复, 由多个实验室的研究者共同完成。该项目共收集到了美国和其他地区的36批数据(25个实验室样本, 11个线上样本, 共6344名被试), 其结果显示, 11个效应得以重复(99%置信区间不包括0) (Klein et al., 2014)。

为了对整个心理学研究领域进行有代表性的重复, COS开展了“心理学研究可重复性项目”(Reproducibility Project: Psychology, RPP)。该项目选取2008年发表在Psychological Science、Journal of Personality and Social Psychology和Journal of Experimental Psychology: Learning, Memory, and Cognition三本期刊上的100篇论文, 包括社会心理学、认知心理学等众多心理学领域。每个实验由一个参与团队认领后, 与原文章作者联系以获取材料, 并在OSF上提前注册研究信息。2015年,RPP项目参与者以 Open Science Collaboration(OSC)团队作者之名, 将 RPP的结果发表在Science杂志上, 结果显示 64个重复实验未能得到显著结果, 且得到显著结果的实验也出现平均效应量下降的现象。根据项目团队的评定, 重复成功率为39% (Open Science Collaboration, 2015)(以下简称OSC2015)。

OSC2015的发表, 产生了巨大的影响, 其试图对心理学研究领域的可重复性问题进行评估的努力, 表现出了心理学研究者的自我反思, 体现了科学研究中的自我纠正。一方面, 这种自我纠正受到了广泛的赞扬(Nature News, 2015; Science News Staff, 2015), 但另一方面, 关于该项目是否客观准确, 还存在着一些争议。

2.2 关于大规模直接重复实验的争议

Gilbert, King, Pettigrew 和 Wilson (2016)对OSC2015的结论提出质疑。他们指出, OSC2015存在三个方法问题, 导致其过低地估计心理学的可重复性。首先, Gilbert等(2016)指出, OSC2015未考虑到误差(error)对重复实验的影响。即使对100个真实存在的效应进行重复, 由于抽样误差等原因, 重复实验的结果也有 5%的可能落在原实验的95%置信区间之外2。此外, OSC2015在抽样以及其他实验操作上并未完全忠于原实验, 可能进一步提高重复失败的基线。Gilbert等(2016)基于多实验室项目的数据(ML2014)指出, 如果以重复实验的效应量是否落在原实验效应量 95%置信区间作为衡量重复实验是否成功的指标,OSC2015可能的最大重复成功率为65%。即单纯地由于误差的影响, OSC2015中的100个实验中有多于34个实验从统计上讲“注定”是要失败的。其次, Gilbert等(2016)指出, OSC2015实验的统计检验力不足, 因为每个实验只重复了一次, 而不是像 ML2014那样重复了多次。再次, OSC2015的重复实验可能存在偏见, 因为有 31%实验的原作者并未支持重复实验的程序, 而这些未得到原实验作者支持的实验, 重复成功率远低于那些得到原实验作者支持的实验。

针对 Gilbert等(2016)的批评, OSC团队的部分作者进行了反驳(Anderson et al., 2016)。首先,Anderson等(2016)指出, 以置信区间为重复实验的指标, 如果仅由于误差的存在, 期望的重复成功率大约为78.5%。但OSC2015的实际重复正确率仅为 39%, 远低于 78.5%, 因此重复失败有误差之外的原因。其次, Anderson等(2016)指出,Gilbert等(2016)将OSC2015与ML2014进行比较具有误导性, 有三个方面的原因:(1) ML2014中,以效应量的置信区间为指标, 重复实验效应量置信区间低于或高于原实验置信区间的比例相当,而OSC2015中只有5%的重复实验的置信区间超过了原实验; (2) Gilbert等(2016)使用ML2014中将同一实验在不同地点进行重复时的变异应用于OSC2015中, 但未考虑到 ML2014中因重复地点导致的变异在不同的实验之间存在差异:能够重复的实验具有较高的跨地点的变异性, 而无法重复的实验的跨地点变异较小。如果将ML2014中重复成功的跨地点变异应用于 OSC2015中未重复成功的实验中, 这将夸大重复的成功率; (3) ML2014选择的是心理学中经典的效应, 因此重复的成功率高, 而OSC2015则是选择高影响因子杂志中具有代表性的研究。如果使用与 ML2014中相似的方法对一些具有代表性的研究进行重复, 得到的结果与OSC2015是相似的(见Many Labs第三阶段的重复实验结果(Ebersole et al., 2016))。此外,Anderson等(2016)也指出, 在 OSC2015中确实存在着由于统计检验力不够而无法检测出真实效应的现象, 主要的原因在于重复实验的样本估计是基于原研究的效应量, 而原研究报告的效应量由于出版偏见等原因有所夸大, 因此难以估计出有足够检验力的样本量。

心理学研究的可重复性问题对于整个心理学研究领域来说至关重要, OSC2015发表以后, 研究者仍然在进一步探索重复失败的原因。例如,van Bavel, Mende-Siedlecki, Brady和Reinero (2016)对OSC2015的公开结果进行了分析, 让被试对被重复实验的背景敏感性(contextual sensitivity)进行评估, 他们发现, 被评估为背景敏感性高的研究更不容易被重复出来。这个结果一方面说明重复实验中可能没有考虑到原研究中未报告的关键操作, 另一方面, 也提示研究者需要对自己研究的背景敏感性进行报告, 避免过度解读实验结果。此外, 有不少研究者正在开展提前注册的重复实验, 重复研究的流程也正在标准化, 以减少重复实验的研究者与原实验作者之间的冲突(Brandt et al., 2014; Kahneman, 2014)。还有研究者试图从统计方法来对当前心理学的可重复性进行评估,例如 Schimmack (2014)提出了可重复指数(R-index)的概念, 可以对一定数目的文献进行可重复性估计, 但此方法还有待于进一步检验。

从某种程度上说, 心理学中是否存在“重复危机”目前还没有定论。但无论“可重复危机”一词是否恰当, 当前心理学研究者对可重复问题的讨论仍将具有深远的影响。

3 可重复性问题的原因

面对心理学研究的可重复性问题, 许多心理学研究者积极反思其原因, 努力寻找对策。从理论上讲, 重复失败无外乎两个原因:要么原研究是假阳性, 要么重复研究是假阴性。近年的实证研究表明, 心理学研究的失败重复, 很大程度上是由于原研究的假阳性过高。而这种过高的假阳性, 又与当前心理学研究中方法与实践的不严谨密切相关, 最明显的表现是研究实践中的可疑研究操作(John, Loewenstein, & Prelec, 2012; Simmons et al., 2011), 而出版偏见和对虚无假设检验的过度依赖则是造成研究者采用可疑研究操作的深层原因 (Cumming, 2014; Ioannidis, 2008)。

可疑研究操作(questionable research practices)指研究者在研究过程中, 采用不合理的手段来达到统计上的显著(即通常所说的p< 0.05), 也称为p值操纵(p-hacking) (Ioannidis, 2008; John et al.,2012; Joober, Schmitz, Annable, & Boksa, 2012)。主要的可疑操作包括条件性选择样本量、选择性报告数据或采用多个小样本研究而避免进行一个大样本实验。条件性选择样本即在研究中, 不根据统计检验力的方法来计算样本量, 而是收集数据的同时对数据进行分析, 根据当前结果是否显著来决定是否停止收集数据。根据统计结果增加样本量, 会使假阳性的概率增加从0.05增大为7.7%(Simmons et al., 2011), 而根据结果停止收集数据,则会使样本量减少, 降低研究统计效力, 造成一种效应量“通胀”的现象, 使得后续研究很难得到显著结果或者效应量减小(Ioannidis, 2008)。调查显示, 72%的心理学家会在分析数据之后决定是否收集更多的数据, 还有 36%的心理学家承认在取得想要的结果后便停止数据收集(John et al.,2012)。选择性报告数据则指选择性报告因变量、自变量或为得到显著结果而排除数据。这种做法会增加结果的假阳性(Simmons et al., 2011)。在实际的研究中, 这种现象并不少见:40%或以上的研究没有完整报告全部实验条件, 70%或者更多的研究未报告全部结果变量(Franco, Malhotra, &Simonovits, 2016; John et al., 2012)。此外, 还有一种可疑的研究操作是采用多个小样本、低统计效力的研究, 选择其中的阳性结果进行报告, 而不是进行一个大样本量、统计效力高的研究。这种做法同样造成效应量“通胀”, 降低研究的可重复性(Bakker, van Dijk, & Wicherts, 2012)。

研究者之所以进行可疑研究操作, 可能是论文发表过程中的出版偏见。出版偏见(也叫做文件抽屉效应, file drawer effect)是指学术杂志更倾向于发表具有统计显著性(如,p< 0.05)的结果, 而没有统计显著的“零结果”(null results)只能放在研究者的抽屉之中(Ferguson & Heene, 2012; Rosenthal,1979)。无论是文献分析(Fanelli, 2010)、元分析(Bakker et al., 2012)、调查研究(Franco, Malhotra,& Simonovits, 2014)还是新统计方法(如p-curve分析)的分析(Simonsohn, Nelson, & Simmons, 2014;Simonsohn, Simmons, & Nelson, 2015), 均表明在心理学领域及相关领域存在严重的出版偏见(Ioannidis,Munafò, Fusar-Poli, Nosek, & David, 2014; Kühberger,Fritz, & Scherndl, 2014), 而且可能是各个研究领域中最严重的(Fanelli, 2010)。出版偏见最为直接的消极后果是迫使研究者得到阳性结果以发表论文。迫于职业发展的压力, 研究者可能会采用可疑的研究操作来得到统计上显著的结果。出版偏见的存在, 筛选掉了阴性的结果, 夸大文献中报告的效应量, 从而导致后续的重复实验无法得到统计上显著的结果或者效应量严重减小。

可疑研究操作和出版偏见, 均与心理学研究中对虚无假设显著性检验(Null Hypothesis Significance Test, NHST)的过度依赖甚至误用有关。NHST是心理学界最主流的统计方法(Cumming et al., 2007; Sterling, Rosenbaum, & Weinkam,1995), 但是其存在不少问题(见 Bakan (1966)、Cohen (1988)、焦璨和张敏强(2014), 详细的总结见Kline (2004))。NHST主要从两方面影响研究的可重复性:第一, NHST中以p值是否小于 0.05作为统计显著性的二分思维方式, 严重地影响了学术期刊中的出版偏见, 继而导致了研究者的可疑研究操作(Gadbury & Allison, 2012; Kirk,2008)。第二,p值本身随着抽样变化较大, 不适合作为重复研究的统计指标(Cumming, 2014; Halsey et al., 2015) (见图1)。更严重的是, 大部分研究者对p值所代表的含义并不能正确地理解。向调查者询问关于p值所代表的含义时, 即使是心理统计学方向的老师, 也只有 20%的人能够对关于p值的 6个论断全部进行正确的判断(Gigerenzer,2004; Haller & Krauss, 2002; Oakes, 1986), 对国内心理学专业学生的调查也得到相似的结果(图2)。正是由于对p值所代表含义存在着诸多的误解,美国统计学会(American Statistical Association,ASA)最近发布的正式声明, 明确指出p值无法用来表明某个研究假设是否正确, 不能使用p值作为唯一的指标进行科学的决策3美国统计学会在关于p值的申明中指出的关于p值的6个原则, 具体如下:1. p值可以表明数据与某个特定统计模型之间不相容程度(P-values can indicate how incompatible the data are with a specified statistical model)。2. p值不能衡量研究假设为真的概率, 也不能衡量数据仅由随机因素造成的概率(P-values do not measure the probability that the studied hypothesis is true, or the probability that the data were produced by random chance alone)。3. 科学结论、商业或政策上的决策, 不应仅取决于p值是否达到了某个特定的阈值(Scientific conclusions and business or policy decisions should not be based only on whether a p-value passes a specific threshold )。4. 在完整报告和透明的基础上才能做出合理的推论(Proper inference requires full reporting and transparency )。5. p值或统计显著性并不能用来衡量效应的大小和结果的重要性(A p-value, or statistical significance, does not measure the size of an effect or the importance of a result.)。6. p值本身并不能衡量模型或假设的可信度(By itself, a p-value does not provide a good measure of evidence regarding a model or hypothesis)。(Wasserstein &Lazar, 2016)。

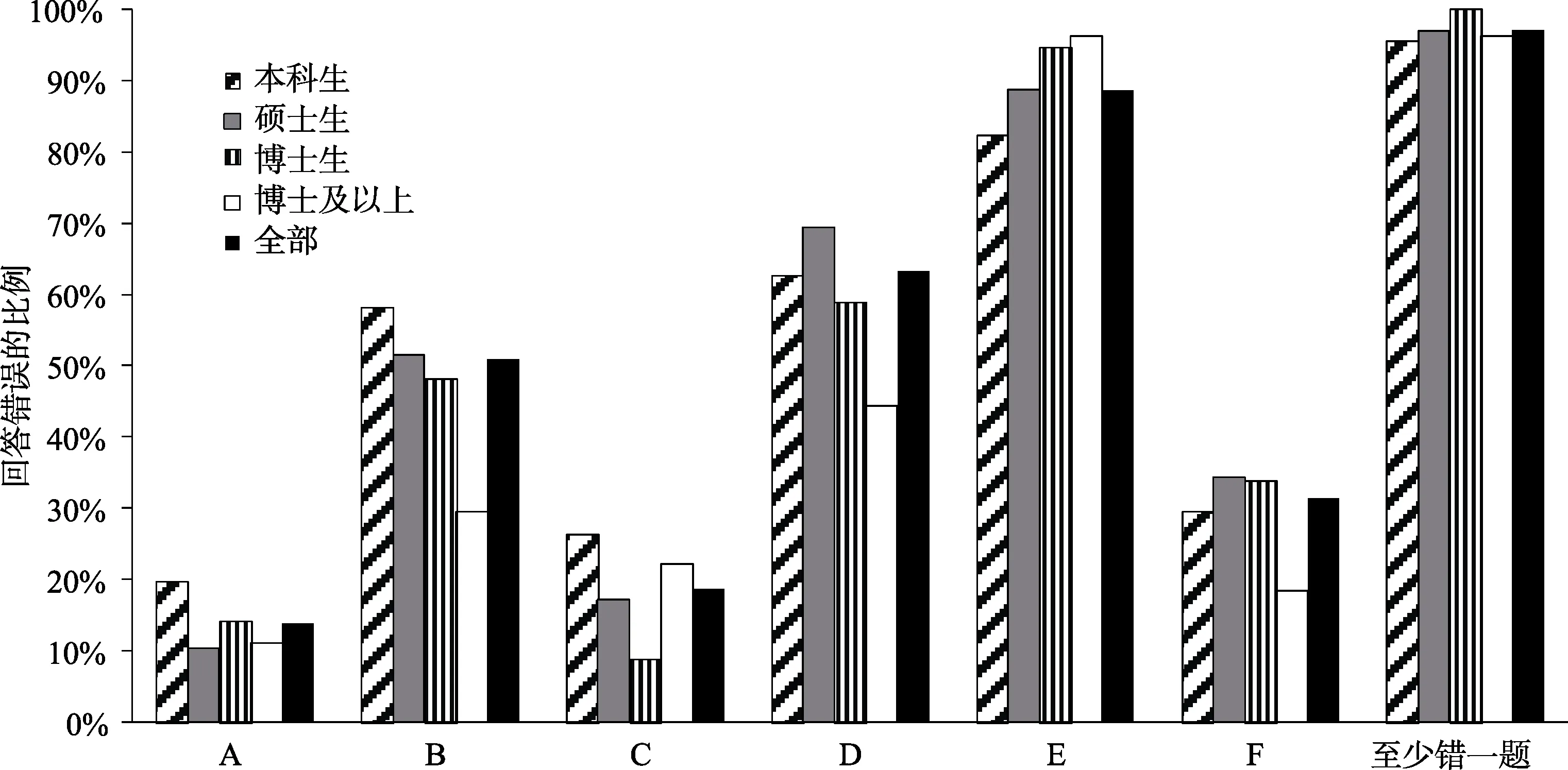

图2 对p值理解错误的比例。假定p = 0.01情况下, 参与者对6个关于p值的论断理解情况。6个关于p值的论断为: A, 你完全证否了零假设; B, 你发现了零假设为真的概率; C, 你完全证明实验假设; D, 你可推断出实验假设为真的概率; E, 你可以得知, 你拒绝零假设时犯错的概率; F, 如果重复多次实验, 99%实验结果显著。调查数据来自本科生(91名)、硕士研究(134名)和博士生(56名)以及取得博士学位的同行(27名) (见电子版补充材料1和补充材料3)。

对可重复性问题原因的分析表明, 可疑研究操作是导致心理学研究假阳性率高的直接因素,而出版偏见和对虚无假设的过度依赖则是背后深层的原因。这三个原因主要解释了原研究假阳性所导致的重复研究失败, 但也有研究者指出, 重复实验本身的统计检验力不够而导致的假阴性,也可能是重复失败的重要原因(Maxwell, Lau, &Howard, 2015; Vankov, Bowers, & Munafò, 2014),包括大规模的重复实验项目也可能存在这个问题(Etz & Vandekerckhove, 2016)。 还有研究者指出,由于心理学研究中变量非常微妙, 因此直接的重复可能无法得到原有的效应, 关键是要对原研究中变量操纵进行重复(Stroebe & Strack, 2014)。此外, 研究者自身的认知偏差等原因也可能导致研究的结果难以重复(Nuzzo, 2015)。可重复性问题背后复杂的原因表明, 要解决这个问题, 心理学研究需要从多个角度改进。

4 解决可重复性问题——新的统计方法

由于NHST是可重复性问题背后的主要原因之一, 因此不少研究者建议使用新的统计指标来替代NHST或者对其进行补充。这些新的方法包括贝叶斯取向(Bayesian)的假设检验(Wagenmakers,Wetzels, Borsboom, & van der Maas, 2011)、稳健的统计方法(robust statistics) (Erceg-Hurn & Mirosevich,2008; Wilcox, 2011)和基于估计的统计方法(estimates-based statistics) (Cumming, 2014)等。其中基于估计的统计从 60年代起即被研究者所推荐(Cohen, 1962, 1988, 1994), 也是美国心理学会(包括APA和APS)推荐使用的统计指标(American Psychological Association, 2010; Cumming, 2014;Wilkinson, 1999)。在可重复性问题受到关注之后,基于估计的统计再次受到重视, 正逐渐成为论文必须报告的统计指标(Cumming, 2014; Eich, 2014)。

基于估计的统计与NHST的主要区别是采用量化而非二分的思维方式来看待研究, 其将单个研究看作是一次随机抽样得到的结果。对研究结果的分析中, 使用量化的统计指标而不是二分的显著性检验。具体而言, 基于估计的统计鼓励在单个的研究中报告效应量(effect size, 又译为效果量)及其置信区间(confidence intervals, CIs), 使用元分析对多个研究的效应量进行综合以得到对真实效应更加准确的估计, 推进心理学中知识的累积(Cumming, 2012, 2014)。

4.1 效应量及其置信区间

效应量(effect size)指研究者感兴趣的任何效应的量(Cumming, 2012), 这些量可以是原始单位,也可以是标准化的量(见表)。单个研究中得到的效应量, 是根据样本数据对总体效应量进行的点估计, 而效应量的置信区间则是对总体效应量的区间估计。与p值相比, 效应量及其CIs有三个方面的优势:第一, CIs比p值稳定, 一个重复研究的效应量大约有83.4%可能会落在原实验95%的CIs(图 1) (Cumming & Maillardet, 2006); 第二, 作为一种量化的统计指标, 效应量及其CIs比p值更能让研究者正确理解统计结果(Coulson, Healey,Fidler, & Cumming, 2010); 第三, 效应量及其CI是元分析的基础, 因此对于心理学中的知识积累至关重要。

关于效应量指标及其计算的文献非常多(Cooper,Hedges, & Valentine, 2009; Fritz, Morris, & Richler,2012; Grissom & Kim, 2012; Kelley & Preacher,2012; Lakens, 2013; 胡竹菁, 2010; 胡竹菁, 戴海琦, 2011; 卢谢峰, 唐源鸿, 曾凡梅, 2011; 郑昊敏,温忠麟, 吴艳, 2011)。但因缺乏对效应量深入理解和便利的计算工具, 报告效应量的研究并不多(Fritz et al., 2012)。而效应量的CI则更受到忽视,极少有心理学论文报告效应量的置信区间(Fritz et al., 2012; Kieffer, Reese, & Thompson, 2001)。其主要原因, 可能在于效应量的统计分布比较复杂,导致对CI的理解(见电子版补充材料 1)和计算比较困难。

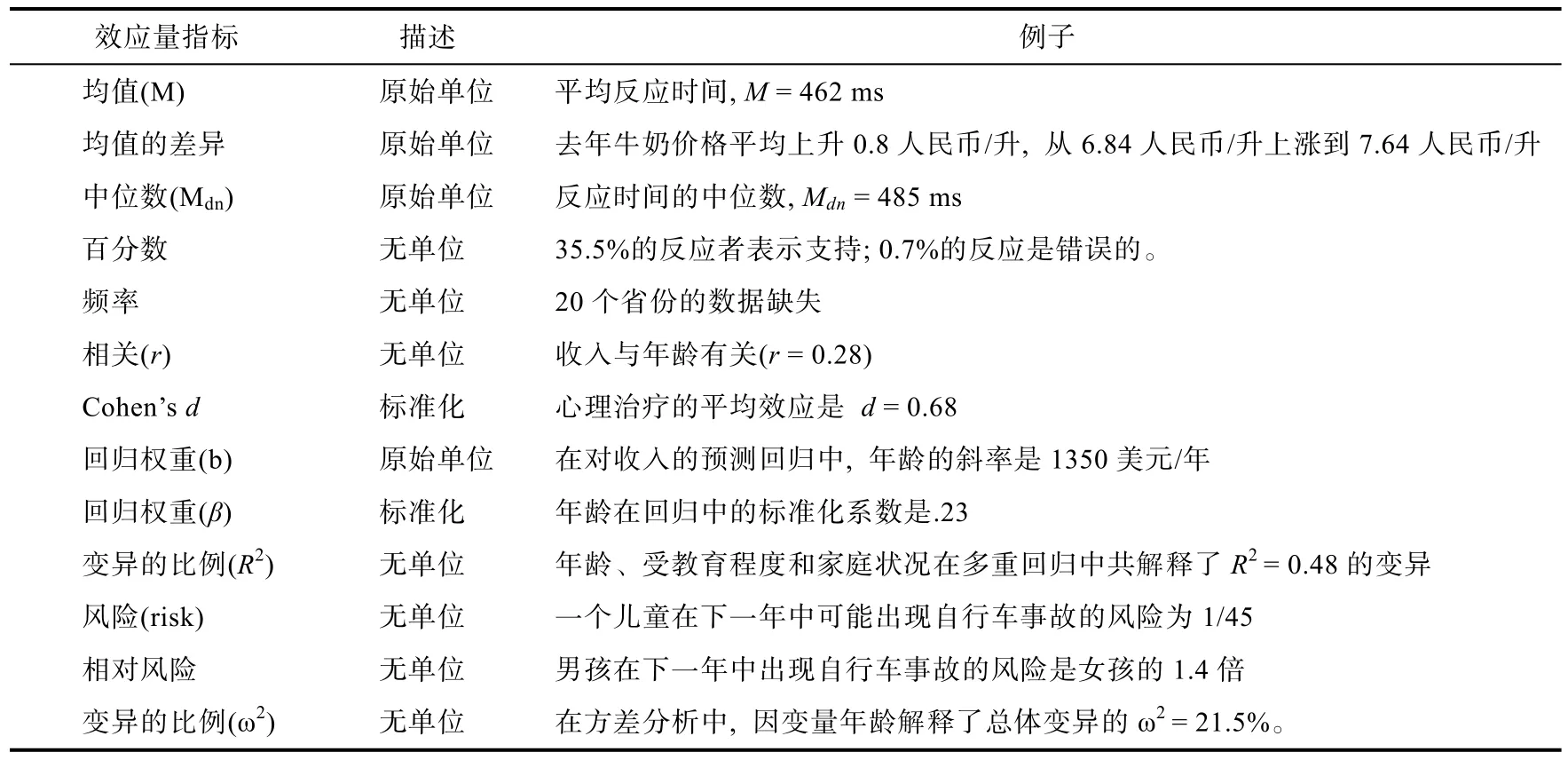

表1 常见的效应量指标(翻译自Cumming (2014))

在可重复性问题冲击之下, 研究者开始试图解决这些问题。一方面, 研究者梳理效应量及其置信区间的意义、计算公式、适应条件以及正确解读的方式(关于心理学领域最常用的效应量指标 Cohen’sd和 eta squared (η2)的计算方法与适用的条件、效应及其置信区间的解读, 见电子版补充材料 2); 另一方面开发出便利的工具以方便研究者在实际研究中使用(关于效应量及其置信区间的计算工具, 见电子版补充材料 2), 以帮助研究者更好地使用效应量及其置信区间。

4.2 元分析

元分析是基于估计的统计从单个研究向多个研究的自然扩展。通过联合多个研究的结果, 元分析方法不仅扩大样本量, 提高统计检验力, 还可以缩小置信区间的范围, 对总体效应量的估计更加精确(Cumming, 2012)。正是由于元分析方法的这些优势, 元分析越来越受到研究者的重视(Fox, Lancaster, Laird, & Eickhoff, 2014; Ioannidis,Fanelli, Dunne, & Goodman, 2015; 胡传鹏, 邸新,李佳蔚, 隋洁, 彭凯平, 2015)。

传统上, 研究者常将元分析等同于对现有研究进行的大规模综合分析, 但实际上元分析也可以是小规模的, 两个研究即可进行元分析。这种小规模的元分析可以将研究者自己进行的几个实验结合起来, 或者将自己的研究与前人研究结合起来, 综合更准确地估计总体的效应量。与NHST相比, 这种小规模的元分析的优势之处在于不需要p值的显著即可以进行, 只需要得到效应量及其置信区间即可。例如, Tuk, Zhang和Sweldens(2015)进行了 18个关于自我控制的实验, 只有两个实验达到统计的显著, 但对18个实验的元分析结果表明, 他们的实验操纵确实有效应。

但是对元分析及其结论也需要持谨慎态度。首先是需要注意模型的选择, 即选择固定效应模型还是随机效应模型。固定效应模型假定每个样本的均值相同, 随机误差造成了这些样本均值之间的差异, 其元分析的结果不适合推广到未包括在元分析之中的研究; 而随机效应模型则考虑到样本之间的差异, 其结果更具有可推广性, 因此选择随机效应模型会更加现实。其次, 元分析需要注意出版偏见对元分析结果的影响。虽然可以通过些统计方法对出版偏见进行校正, 从而对总体的效应量进行更加准确的估计, 但是这些方法能够在多大程度上校正出版偏见还需要进一步研究。最后, 由于元分析涉及到多个研究的数据, 不管是在数据选择还是在模型参数上, 都存在着比较灵活的做法, 元分析也可以用来支持公认不太可能的结论(如Bem, Tressoldi, Rabeyron, & Duggan(2015))。因此对元分析的结论也需要持谨慎的态度(van Elk et al., 2015)。

5 解决可重复性问题——公开、透明和开放的研究标准

可重复性问题的另两个主要原因在于研究实践中的可疑研究操作和论文发表的出版偏见, 因此不少研究者提出采用更加公开、透明与开放的研究标准(Carp, 2013; LeBel et al., 2013; Miguel et al.,2014; Nosek & Lakens, 2014; Simmons et al., 2011;朱滢, 2016), 从研究开始之前到研究结束以及论文发表过程中, 均保持公开、透明和开放。2014年, 促进科研公开与透明委员会(Transparency and Openness Promotion Committee, TOP)召开会议,提出从8个方面来衡量学术期刊的透明程序(Nosek et al., 2015), 虽然不是所有学术期刊均接受这一标准, 但包括Science在内的诸多学术期刊开始采用TOP的标准(McNutt, 2016)。TOP标准主要从以下三个方面来促进研究的公开、透明和开放:提前注册(preregistration)、完整公开(disclosure)和开放数据与材料(open data and materials)(Miguel et al., 2014; Nosek et al., 2015)。

5.1 提前注册

提前注册指的研究者在开始实验之前, 公开注册自己的研究, 这个要求对于许多研究者来说,是全新的、非常严格的要求(Asendorpf et al., 2013;Miguel et al., 2014)。提前公开地注册可以减少研究者实验操作以及数据分析方面的自由度, 还能公开报告主要研究结果, 减少出版偏见带来的问题(Kaplan & Irvin, 2015)。此外, 提前注册研究包括研究者对数据的假设, 可以避免研究者在研究结果分析之后, 根据结果修改研究假设, 将探索性的研究写成验证性研究(Wagenmakers, Wetzels,Borsboom, van der Maas, & Kievit, 2012)。实际上,在美国的医药领域, 已经有法律规定进行药物试验之前必须进行公开的注册(Miguel et al., 2014)。针对可重复性问题, 研究者开始重视提前注册的价值和作用, 开始搭建公开注册平台(如 https://osf.io和 https://aspredicted.org/)。

提前注册应该包括研究的关键信息。例如,Van’t Veer和 Giner-Sorolla (2015)指出, 提前注册应该包括如下几个部分:第一, 研究假设, 包括采用变量之间的关系来描述研究假设、理论与其预期之间的关系、交互作用的方向以及操纵变量的影响; 第二, 方法部分, 包括研究设计, 计划使用的样本量(选择样本量的规则、这些样本量将从何处获得、以及做出这样选择的原因和终止实验标准)、数据排除标准和研究的程序; 第三, 数据分析计划, 包括相关变量及其计算方法、统计技术、变量与协变量以及关系、多重分析方法, 及使用非NHST时, 报告理由。

目前, 提前注册研究较多地应用于重复研究之中(Chambers, Dienes, McIntosh, Rotshtein, &Willmes, 2015; Nosek & Lakens, 2014)。一些学术期刊(如Perspective in Psychological Science、Cortex、Psychological Science等)鼓励研究者提前注册自己的研究(Chambers et al., 2015; Lindsay,2015), 越来越多的研究者在 OSF上注册自己的研究, 以保证其研究的可靠性。

5.2 完整公开

完整公开指完整地报告研究过程和数据结果,让读者充分了解作者在研究过程中的决策和意图。完整公开可以帮助后续研究者更加深入了解研究过程或者进行重复实验, 同时有助于研究者自律。可重复性问题出现后, LeBel 与同事创办致力于完整公开的平台(PsychDisclosure:http://psychdisclosure.org), 鼓励研究者报告对于重复研究来说至关重要的四个方面内容(LeBel et al.,2013)。

第一, 报告结果分析中被排除掉的数据以及排除标准(Eich, 2014; LeBel et al., 2013; Simmons et al., 2011)。也就是说, 如果作者删除了部分观测数据, 则必须报告未删除这些数据时的分析结果,使得读者了解删除数据对整个结果产生的影响,要求作者对删除的数据进行合理的解释。第二,报告研究中所有测试的实验条件(conditions), 包括操纵不成功的实验条件(Eich, 2014; LeBel et al.,2013; Simmons et al., 2011)。这一点要求作者报告全部的实验变量, 不管该实验变量是否与作者的预期一致。第三, 报告所有的观测数据(observations)以及条目(Eich, 2014; LeBel et al., 2013)。即研究者不能只报告收集的数据中的一小部分, 而是报告全部的数据, 即使只是简单列出这些变量。如果分析中有协变量, 必须报告没有协变量时的结果。第四, 报告如何确定样本量以及停止收集数据的条件(Brown et al., 2014; Eich, 2014; LeBel et al.,2013; Simmons et al., 2011)。作者必须在收集数据前就确定停止收集数据的标准, 并在文中报告该标准。这意味着作者需要报告统计效力的计算或者事前规定的标准。

图3 研究过程中符合公开、透明和开放原则的研究操作(上)以及可疑研究操作(下)。

目前, 这四方面内容已经逐渐纳入到学术期刊审稿的要求之中, 例如Psychological Science于2015年开始要求作者报告这些信息(Eich, 2014),而Journal of Experimental Social Psychology也于2016年也开始类似的要求4详见:http://www.journals.elsevier.com/journal-of-experimentalsocial-psychology/news/jesp-editorial-guidelines/。

5.3 开放数据与材料

开放数据与材料是指在实验结束或者论文发表之后, 研究者公开自己的实验数据与材料, 与其他研究者共享。随着互联网以及数据存储技术的进步, 开放数据已经相对容易实现, 不少研究领域开始开放数据, 如神经成像研究(Eickhoff,Nichols, van Horn, & Turner, 2016; Poldrack &Gorgolewski, 2014; Zuo et al., 2014)。

可重复性问题的出现, 让心理学研究者意识到开放数据的重要性。一些学术期刊开始要求作者开放原始数据。2015年起,Cognition杂志对投稿到该刊的文章结果报告作出了新的要求, 需要作者公开全部的原始数据(Sloman, 2015)。Psychological Science则增加了两个标识:“开放数据标识(Open Data badge)”和“开放材料标识(Open Materials badge)”, 分别用来认证那些在将数据或研究材料开放的文章(Eich, 2014)。最近的分析表明, 自从增加了开放数据和开放材料的标识之后,Psychological Science上提供开放数据和开放材料的研究迅速增加, 表明这种方式非常有效(Kidwell et al., 2016)。

对于研究者而言, 开放数据与材料带来额外的负担:将数据和材料整理成为可以分享的形式需要额外的时间和精力, 却没有任何明显的回报。因此, 如何激励研究者共享自己的数据是未来讨论的一个重点(Nosek et al., 2015)。

总之, 可重复性问题之后, 研究者已经达成共识, 从开始到结束均保持公开、透明和开放(见图 3), 有助于减少研究者的自由度, 减少研究中可疑研究操作, 从而降低假阳性。

6 总结与建议

可重复性问题广泛存在于科学研究的各个领域, 心理学研究者为解决此问题所进行努力, 使其成为了心理学研究进步的一个契机, 让心理学的研究方法与实践更合理与透明, 符合信息时代科学研究的新趋势。OSF、PsychoFileDrawer和PsychoDisclosure等网站的出现, 成为公开心理学研究结果的新平台; 新统计软件如 JASP、ESCI及大量 R工具包的出现, 使得新统计方法更加易于使用; “出版前独立重复” (Pre-Publication Independent Replication, PPIR)开始出现(Schweinsberg et al., 2016), 意味着研究者开始将重复验证作为研究的一部分。更重要的是, 主流学术期刊的审稿政策也正在发生变革(Eich, 2014; Trafimow &Marks, 2015), 将统计方法和研究实践上的革新巩固下来。

当然, 心理学研究的变革还只是刚刚开始,要加强心理学研究的可重复性, 需要将这些变革深入到心理学的各个方面。首先, 最重要的是学术界政策性的变革, 其核心是学术期刊审稿政策和对研究者奖赏方式的变革。这种政策性的变革,将改变心理学研究的导向, 引导整个研究领域的人力、物力与财力的方向。最近 Smaldino和McElreath (2016)对学术论文中假阳性的比例进行演化模拟, 他们发现, 如果学术界中仅奖励阳性结果, 将最终导致大部分的学术论文是假阳性结果, 而重复实验只能减缓这个过程。目前主流的心理学期刊中, 要求作者进行完整报告开始成为基本要求(见上一部分5.2小节)。同时, 不少学术期刊已经开始鼓励作者进行提前注册、公开数据与实验材料等(Eickhoff et al., 2016; McNutt, 2014;Miguel et al., 2014), 未来可能会成为强制性的要求。此外, 在政策上如何奖励阴性结果、避免出版偏见也在探索之中。一些期刊(如Attention,Perception, & Psychophysics)开始尝试类似基金申请的审稿体系, 允许研究者首先提交研究计划,根据其理论意义和内容进行评审; 如果评审通过,那么无论之后实际实验的结果如何, 都会发表,这样鼓励研究者对有意义的问题进行探索。

其次, 一线的心理学研究者, 可能需要根据新的统计标准与研究实践的规范来调整自己的实际研究工作, 以实际行动来加强心理学研究的可靠性。一方面, 研究者要改变以 NHST为主导的思维方式, 在研究设计和数据分析时, 采用更加合理的统计方法如基于估计的统计、贝叶斯统计或者稳健统计(见上第四部分)。另一方面, 从研究计划到研究的实施、数据的分析, 均采用更加合乎公开、透明和开放原则的操作(见图3)。这些调整可能需要研究者付出大量的努力, 但这不仅可以提高自己研究的质量、适应论文发表的新标准,也为提高心理学的可靠性贡献力量。

最后, 可重复性问题给心理学研究方法的教学带来机遇与挑战, 心理学的教育工作者需要及时跟进。一方面, 心理统计学需要重视对 NHST原理及其缺陷的理解, 同时加强对基于估计的统计方法及其他统计方法的学习(胡竹菁, 董圣鸿,张阔, 2013), 如Nature Methods在线出版了介绍基本统计知识的专题5http://www.nature.com/collections/qghhqm。另一方面, 在研究方法或者研究伦理的教学中, 强调可疑研究操作(John et al., 2012)的潜在危害, 避免在未来的研究中进行p值操纵。

自Ioannidis (2005)指出大部分已发表论文可能是假阳性结果的之后, 可重复性的问题成为多学科关注的焦点问题之一(Peng, 2009), 关于可重复性问题的讨论也经常见诸学术期刊6如 nature关于可重复性问题的合集 http://www.nature.com/nature/focus /reproducibility/index.html。在诸多研究领域中, 心理学研究者率先进行大规模重复实验, 并在审稿政策上提倡并执行提前注册、完整报告和开放数据。这些努力不仅有助于加强心理学研究的可靠性, 还为其他学科的同行提供借鉴。例如, 最近OSF与Science Exchange合作, 展开癌症生物学的可重复项目(The Reproducibility Project: Cancer Biology) (Errington et al., 2014)。而Science将于2017年采用公开和透明的审稿标准(McNutt, 2016), 也得益于心理学研究者关于可重复性问题的研究和讨论。

致谢:感谢匿名审稿专家对本文提出的宝贵意见;感谢University of Oklahoma宋海荣老师、清华大学孙沛老师、北京师范大学孔祥祯同学和西南大学谢超同学在本文写作中提供的帮助; 感谢牛津大学语言学系周北南博士、诺丁汉大学心理学系温韫同学在本文英文摘要写作中提供的帮助。

胡传鹏, 邓晓红, 周治金, 邓小刚. (2011). 神经法学: 年轻的认知神经科学与古老的法学联姻.科学通报, 56(36),3041–3053.

胡传鹏, 邸新, 李佳蔚, 隋洁, 彭凯平. (2015). 神经成像数据的元分析.心理科学进展, 23(7), 1118–1129.

胡竹菁. (2010). 平均数差异显著性检验统计检验力和效果大小的估计原理与方法.心理学探新, 30(1), 68–73.

胡竹菁, 戴海琦. (2011). 方差分析的统计检验力和效果大小的常用方法比较.心理学探新, 31(3), 254–259.

胡竹菁, 董圣鸿, 张阔. (2013). 《心理统计学》教学内容的新探索.心理学探新, 33(5), 402–408.

焦璨, 张敏强. (2014). 迷失的边界: 心理学虚无假设检验方法探究.中国社会科学,(2), 148–163.

卢谢峰, 唐源鸿, 曾凡梅. (2011). 效应量: 估计、报告和解释.心理学探新, 31(3), 260–264.

郑昊敏, 温忠麟, 吴艳. (2011). 心理学常用效应量的选用与分析.心理科学进展, 19(12), 1868–1878.

朱滢. (2016). “开放科学 数据共享 软件共享”, 你准备好了吗?.心理科学进展, 24(6), 995–996.

Alberts, B. (2011). Editorial expression of concern.Science,334(6057), 760.

American Psychological Association. (2010).Publication manual of the American Psychological Association(6th ed.). Washington, DC: American Psychological Association.

Anderson, C. J., Bahník, Š., Barnett-Cowan, M., Bosco, F. A.,Chandler, J., Chartier, C. R., ... Zuni, K. (2016). Response to comment on “Estimating the reproducibility of psychological science”.Science, 351(6277), 1037.

Asendorpf, J. B., Conner, M., De Fruyt, F., De Houwer, J.,Denissen, J. J. A., Fiedler, K., ... Wicherts, J. M. (2013).Recommendations for Increasing replicability in psychology.European Journal of Personality, 27(2), 108–119.

Bakan, D. (1966). The test of significance in psychological research.Psychological Bulletin, 66(6), 423–437.

Baker, M. (2016). 1,500 scientists lift the lid on reproducibility.Nature, 553, 452–454.

Bakker, M., van Dijk, A., & Wicherts, J. M. (2012). The rules of the game called psychological science.Perspectives on Psychological Science, 7(6), 543–554.

Barch, D. M., & Yarkoni, T. (2013). Introduction to the special issue on reliability and replication in cognitive and affective neuroscience research.Cognitive, Affective, &Behavioral Neuroscience, 13(4), 687–689.

Begley, C. G., & Ellis, L. M. (2012). Drug development:Raise standards for preclinical cancer research.Nature,483(7391), 531–533.

Bem, D. J. (2011). Feeling the future: Experimental evidence for anomalous retroactive influences on cognition and affect.Journal of Personality and Social Psychology,100(3), 407–425.

Bem, D. J., Tressoldi, P. E., Rabeyron, T., & Duggan, M.(2015). Feeling the future: A meta-analysis of 90 experiments on the anomalous anticipation of random future events[version 1; referees: 2 approved](1188). Retrieved June 12,2016, from http://f1000research.com/articles/4-1188/v2

Brandt, M. J., IJzerman, H., Dijksterhuis, A., Farach, F. J.,Geller, J., Giner-Sorolla, R., ... van't Veer, A. (2014). The replication recipe: What makes for a convincing replication?Journal of Experimental Social Psychology, 50, 217–224.

Brown, S. D., Furrow, D., Hill, D. F., Gable, J. C., Porter, L.P., & Jacobs, W. J. (2014). A duty to describe: Better the devil you know than the devil you don’t.Perspectives on Psychological Science, 9(6), 626–640.

Carp, J. (2013). Better living through transparency: Improving the reproducibility of fMRI results through comprehensive methods reporting.Cognitive, Affective, & Behavioral Neuroscience, 13(3), 660–666.

Chambers, C. D., Dienes, Z., McIntosh, R. D., Rotshtein, P.,& Willmes, K. (2015). Registered reports: Realigning incentives in scientific publishing.Cortex, 66, A1–A2.

Chang, A. C., & Li, P. (2015).Is economics research replicable? sixty published papers from thirteen Journals say "usually not". Paper presented at the Finance and Economics Discussion Series 2015–083, Washington.Retrieved June 12, 2016, from https://www.federalreserve.gov/econresdata/feds/2015/file s/2015083pap.pdf

Chin, J. M. (2014). Psychological science’s replicability crisis and what it means for science in the courtroom.Psychology, Public Policy, and Law, 20(3), 225–238.

Cohen, J. (1962). The statistical power of abnormal-social psychological research: A review.The Journal of Abnormal and Social Psychology, 65(3), 145–153.

Cohen, J. (1988).Statistical power analysis for the behavioral sciences(2nd ed.). New York: Routledge.

Cohen, J. (1994). The earth is round (p<.05).American Psychologist, 49(12), 997–1003.

Cooper, H., Hedges, L. V., & Valentine, J. C. (2009).The handbook of research synthesis and meta-analysis(2nd ed.). New York: Sage.

Coulson, M., Healey, M., Fidler, F., & Cumming, G. (2010).Confidence intervals permit, but do not guarantee, better inference than statistical significance testing.Frontiers in Psychology, 1, 26.

Cumming, G. (2008). Replication andpintervals:Pvalues predict the future only vaguely, but confidence intervals do much better.Perspectives on Psychological Science,3(4), 286–300.

Cumming, G. (2012).Understanding the new statistics:Effect sizes, confidence intervals, and meta-analysis. New York: Routledge.

Cumming, G. (2014). The new statistics: Why and how.Psychological Science, 25(1), 7–29.

Cumming, G., Fidler, F., Leonard, M., Kalinowski, P.,Christiansen, A., Kleinig, A., ... Wilson, S. (2007). Statistical reform in psychology: Is anything changing?Psychological Science, 18(3), 230–232.

Cumming, G., & Maillardet, R. (2006). Confidence intervals and replication: Where will the next mean fall?Psychological Methods, 11(3), 217–227.

Doyen, S., Klein, O., Pichon, C.-L., & Cleeremans, A.(2012). Behavioral priming: It's all in the mind, but whose mind?PLoS One, 7(1), e29081.

Earp, B. D., & Trafimow, D. (2015). Replication, falsification,and the crisis of confidence in social psychology.Frontiers in Psychology, 6, 621.

Ebersole, C. R., Atherton, O. E., Belanger, A. L., Skulborstad, H.M., Allen, J. M., Banks, J. B., ... Nosek, B. A. (2016).Many Labs 3: Evaluating participant pool quality across the academic semester via replication. Retrieved June 12,2016, from https://osf.io/csygd

Ten for 2011. [Editorial]. (Dec 22nd, 2011),Nature, 480(7378),414.

Eich, E. (2014). Business not as usual.Psychological Science,25(1), 3–6.

Eickhoff, S., Nichols, T. E., van Horn, J. D., & Turner, J. A.(2016). Sharing the wealth: Neuroimaging data repositories.NeuroImage, 124(Pt B), 1065–1068.

Enserink, M. (2012). Final report on Stapel also blames field as a whole.Science, 338(6112), 1270–1271.

Erceg-Hurn, D. M., & Mirosevich, V. M. (2008). Modern robust statistical methods: An easy way to maximize the accuracy and power of your research.American Psychologist,63(7), 591–601.

Errington, T. M., Iorns, E., Gunn, W., Tan, F. E., Lomax, J.,& Nosek, B. A. (2014). An open investigation of the reproducibility of cancer biology research.eLife, 3.doi:10.7554/eLife.04333

Etz, A., & Vandekerckhove, J. (2016). A bayesian perspective on the reproducibility project: Psychology.PLoS One, 11(2),e0149794.

Fanelli, D. (2010). “Positive” results increase down the hierarchy of the sciences.PLoS One, 5(4), e10068.

Ferguson, C. J., & Heene, M. (2012). A vast graveyard of undead theories: Publication bias and psychological science’s aversion to the null.Perspectives on Psychological Science,7(6), 555–561.

Fox, P. T., Lancaster, J. L., Laird, A. R., & Eickhoff, S. B.(2014). Meta-analysis in human neuroimaging: Computational modeling of large-scale databases.Annual Review of Neuroscience, 37(1), 409–434.

Franco, A., Malhotra, N., & Simonovits, G. (2014). Publication bias in the social sciences: Unlocking the file drawer.Science, 345(6203), 1502–1505.

Franco, A., Malhotra, N., & Simonovits, G. (2016).Underreporting in psychology experiments: Evidence from a study registry.Social Psychological and Personality Science, 7(1), 8–12.

Fritz, C. O., Morris, P. E., & Richler, J. J. (2012). Effect size estimates: Current use, calculations, and interpretation.Journal of Experimental Psychology: General, 141(1),2–18.

Gadbury, G. L., & Allison, D. B. (2012). Inappropriate fiddling with statistical analyses to obtain a desirable p-value: Tests to detect its presence in published literature.PLoS One, 7(10), e46363.

Galak, J., LeBoeuf, R. A., Nelson, L. D., & Simmons, J. P.(2012). Correcting the past: Failures to replicate psi.Journal of Personality and Social Psychology, 103(6),933–948.

Gigerenzer, G. (2004). Mindless statistics.The Journal of Socio-Economics, 33(5), 587–606.

Gilbert, D. T., King, G., Pettigrew, S., & Wilson, T. D. (2016).Comment on “Estimating the reproducibility of psychological science”.Science, 351(6277), 1037.

Grissom, R. J., & Kim, J. J. (2012).Effect sizes for research:Univariate and multivariate applications(2nd ed.). New York: Routledge.

Haller, H., & Krauss, S. (2002). Misinterpretations of significance: A problem students share with their teachers.Methods of Psychological Research Online, 7(1), 1–20.Retrieved June 12, 2016, from https://www.metheval.uni-jena.de/lehre/0405-ws/evaluatio nuebung/haller.pdf

Halsey, L. G., Curran-Everett, D., Vowler, S. L., & Drummond,G. B. (2015). The ficklePvalue generates irreproducible results.Nature Methods, 12(3), 179–185.

Ioannidis, J. P. A. (2005). Why most published research findings are false.PLoS Medicine, 2(8), e124.

Ioannidis, J. P. A. (2008). Why most discovered true associations are inflated.Epidemiology, 19(5), 640–648.

Ioannidis, J. P. A., Fanelli, D., Dunne, D. D., & Goodman, S.N. (2015). Meta-research: Evaluation and improvement of research methods and practices.PLoS Biology, 13(10),e1002264.

Ioannidis, J. P. A., Munafò, M. R., Fusar-Poli, P., Nosek, B.A., & David, S. P. (2014). Publication and other reporting biases in cognitive sciences: Detection, prevalence, and prevention.Trends in Cognitive Sciences, 18(5), 235–241.

John, L. K., Loewenstein, G., & Prelec, D. (2012). Measuring the prevalence of questionable research practices with incentives for truth telling.Psychological Science, 23(5),524–532.

Joober, R., Schmitz, N., Annable, L., & Boksa, P. (2012).Publication bias: What are the challenges and can they be overcome?Journal of Psychiatry & Neuroscience: JPN,37(3), 149–152.

Kühberger, A., Fritz, A., & Scherndl, T. (2014). Publication bias in psychology: A diagnosis based on the correlation between effect size and sample size.PLoS One, 9(9),e105825.

Kahneman, D. (2014). A new etiquette for replication.Social Psychology, 45(4), 310–311.

Kaplan, R. M., & Irvin, V. L. (2015). Likelihood of null effects of large NHLBI clinical trials has increased over time.PLoS One, 10(8), e0132382.

Kelley, K., & Preacher, K. J. (2012). On effect size.Psychological Methods, 17(2), 137–152.

Kidwell, M. C., Lazarevi, L. B., Baranski, E., Hardwicke, T.E., Piechowski, S., Falkenberg, L.-S., ... Nosek, B. A.(2016). Badges to acknowledge open practices: A simple,low-cost, effective method for increasing transparency.PLoS Biology, 14(5), e1002456.

Kieffer, K. M., Reese, R. J., & Thompson, B. (2001).Statistical techniques employed inAERJandJCParticles from 1988 to 1997: A methodological review.The Journal of Experimental Education, 69(3), 280–309.

Kirk, R. E. (2008). The importance of effect magnitude. InHandbook of research methods in experimental psychology(pp. 83–105). Oxford: Blackwell Publishing Ltd.

Klein, R. A., Ratliff, K. A., Vianello, M., Adams, R. B.,Bahník, Š., Bernstein, M. J., ... Nosek, B. A. (2014).Investigating variation in replicability: A “many labs”replication project.Social Psychology, 45(3), 142–152.

Kline, R. B. (2004). What's wrong with statistical tests—and where we go from here. InBeyond significance testing:Reforming data analysis methods in behavioral research.Washington, DC: American Psychological Association.

Lakens, D. (2013). Calculating and reporting effect sizes to facilitate cumulative science: A practical primer fort-tests and ANOVAs.Frontiers in Psychology, 4, 863.

LeBel, E. P., Borsboom, D., Giner-Sorolla, R., Hasselman, F.,Peters, K. R., Ratliff, K. A., & Smith, C. T. (2013).PsychDisclosure.org: Grassroots support for reforming reporting standards in psychology.Perspectives on Psychological Science, 8(4), 424–432.

Lindsay, D. S. (2015). Replication in psychological science.Psychological Science, 26(12), 1827–1832.

Lurquin, J. H., Michaelson, L. E., Barker, J. E., Gustavson,D. E., von Bastian, C. C., Carruth, N. P., & Miyake, A.(2016). No evidence of the ego-depletion effect across task characteristics and individual differences: A preregistered study.PLoS One, 11(2), e0147770.

Makel, M. C., Plucker, J. A., & Hegarty, B. (2012).Replications in psychology research: How often do they really occur?Perspectives on Psychological Science, 7(6),537–542.

Maxwell, S. E., Lau, M. Y., & Howard, G. S. (2015). Is psychology suffering from a replication crisis? What does“failure to replicate” really mean?American Psychologist,70(6), 487–498.

McNutt, M. (2014). Journals unite for reproducibility.Science, 346(6210), 679.

McNutt, M. (2016). Taking up TOP.Science, 352(6290),1147.

Miguel, E., Camerer, C., Casey, K., Cohen, J., Esterling, K.M., Gerber, A., ... van der Laan, M. (2014). Promoting transparency in social science research.Science, 343(6166),30–31.

Miller, G. (2011). ESP paper rekindles discussion about statistics.Science, 331(6015), 272–273.

Nature News. (2015). 365 days: Nature’s 10. Nature,528(7583), 459-467.

Nosek, B. A., Alter, G., Banks, G. C., Borsboom, D., Bowman, S.D., Breckler, S. J., ... Yarkoni, T. (2015). Promoting an open research culture.Science, 348(6242), 1422–1425.

Nosek, B. A., & Lakens, D. (2014). Registered reports: A method to increase the credibility of published results.Social Psychology, 45(3), 137–141.

Nuzzo, R. (2015). How scientists fool themselves – and how they can stop.Nature, 526(7572), 182–185.

Oakes, M. (1986).Statistical inference: A commentary for the social and behavioural sciences. Chichester: Wiley.

Open Science Collaboration. (2015). Estimating the reproducibility of psychological science.Science, 349(6251), 943.

Pashler, H., & Wagenmakers, E. J. (2012). Editors’introduction to the special section on replicability in psychological science: A crisis of confidence?Perspectives on Psychological Science, 7(6), 528–530.

Peng, R. D. (2009). Reproducible research and biostatistics.Biostatistics, 10(3), 405–408.

Poldrack, R. A., & Gorgolewski, K. J. (2014). Making big data open: Data sharing in neuroimaging.Nature Neuroscience,17(11), 1510–1517.

Ritchie, S. J., Wiseman, R., & French, C. C. (2012). Failing the future: Three unsuccessful attempts to replicate Bem's‘retroactive facilitation of recall’ effect.PLoS One, 7(3),e33423.

Rosenthal, R. (1979). The file drawer problem and tolerance for null results.Psychological Bulletin, 86(3), 638–641.

Schimmack, U. (2014). Quantifying statistical research integrity: The Replicabilty-Index. Retrieved June 12, 2016,from http://www.r-index.org/uploads/3/5/6/7/3567479/introduction_to_the_r-index__14-12-01.pdf

Schmidt, S. (2009). Shall we really do it again? The powerful concept of replication is neglected in the social sciences.Review of General Psychology, 13(2), 90–100.

Schooler, J. W. (2014). Metascience could rescue the‘replication crisis’.Nature, 515, 9.

Schweinsberg, M., Madan, N., Vianello, M., Sommer, S. A.,Jordan, J., Tierney, W., ... Uhlmann, E. L. (2016). The pipeline project: Pre-publication independent replications of a single laboratory's research pipeline.Journal of Experimental Social Psychology.

Science News Staff. (2015). Science's Breakthrough of the Year 2015: Runners-up. Science, 350(6267), 1458-1463.

Simmons, J. P., Nelson, L. D., & Simonsohn, U. (2011).False-positive psychology: Undisclosed flexibility in data collection and analysis allows presenting anything as significant.Psychological Science, 22(11), 1359–1366.

Simonsohn, U., Nelson, L. D., & Simmons, J. P. (2014).P-curve: A key to the file-drawer.Journal of Experimental Psychology: General, 143(2), 534–547.

Simonsohn, U., Simmons, J. P., & Nelson, L. D. (2015).BetterP-curves: MakingP-curve analysis more robust to errors, fraud, and ambitiousP-hacking, a reply to Ulrich and Miller (2015).Journal of Experimental Psychology:General, 144(6), 1146–1152.

Sloman, S. A. (2015). Opening editorial: The changing face of Cognition.Cognition, 135, 1–3.

Smaldino, P. E., & McElreath, R. (2016). The natural selection of bad science. Retrieved June 12, 2016, from http://arxiv.org/abs/1605.09511

Spellman, B. A. (2012). Introduction to the special section on research practices.Perspectives on Psychological Science, 7(6), 655–656.

Spellman, B. A. (2013). Introduction to the special section on advancing science.Perspectives on Psychological Science, 8(4), 412–413.

Spellman, B. A. (2015). A short (personal) future history of revolution 2.0.Perspectives on Psychological Science,10(6), 886–899.

Sterling, T. D., Rosenbaum, W. L., & Weinkam, J. J. (1995).Publication decisions revisited: The effect of the outcome of statistical tests on the decision to publish and vice versa.The American Statistician, 49(1), 108–112.

Stroebe, W., & Strack, F. (2014). The alleged crisis and the illusion of exact replication.Perspectives on Psychological Science, 9(1), 59–71.

Tajika, A., Ogawa, Y., Takeshima, N., Hayasaka, Y., &Furukawa, T. A. (2015). Replication and contradiction of highly cited research papers in psychiatry: 10-year follow-up.The British Journal of Psychiatry, 207(4), 357–362.

Trafimow, D., & Marks, M. (2015). Editorial.Basic andApplied Social Psychology, 37(1), 1–2.

Tuk, M. A., Zhang, K., & Sweldens, S. (2015). The propagation of self-control: Self-control in one domain simultaneously improves self-control in other domains.Journal of Experimental Psychology: General, 144(3), 639–354.

van Bavel, J. J., Mende-Siedlecki, P., Brady, W. J., &Reinero, D. A. (2016). Contextual sensitivity in scientific reproducibility.Proceedings of the National Academy of Sciencesof the United States of America, 113(23), 6454–6459.

van Elk, M., Matzke, D., Gronau, Q. F., Guang, M.,Vandekerckhove, J., & Wagenmakers, E.-J. (2015). Metaanalyses are no substitute for registered replications: A skeptical perspective on religious priming.Frontiers in Psychology, 6, 1365.

Van’t Veer, A. E., & Giner-Sorolla, R. (2015). Public template for pre-registration. Retrieved June 12, 2016,from https://osf.io/k5wns/

Vankov, I., Bowers, J., & Munafò, M. R. (2014). On the persistence of low power in psychological science.The Quarterly Journal of Experimental Psychology, 67(5),1037–1040.

Wagenmakers, E.-J., Wetzels, R., Borsboom, D., & van der Maas, H. L. J. (2011). Why psychologists must change the way they analyze their data: The case of psi: Comment on Bem (2011).Journal of Personality and Social Psychology,100(3), 426–432.

Wagenmakers, E.-J., Wetzels, R., Borsboom, D., van der Maas, H. L. J., & Kievit, R. A. (2012). An agenda for purely confirmatory research.Perspectives on Psychological Science, 7(6), 632–638.

Wasserstein, R. L., & Lazar, N. A. (2016). The ASA's statement onp-values: Context, process, and purpose.The American Statistician, 70(2), 129–133.

Wilcox, R. (2011).Modern statistics for the social and behavioral sciences: A practical introduction. Boca Raton,FL: CRC Press.

Wilkinson, L. (1999). Statistical methods in psychology journals: Guidelines and explanations.American Psychologist,54(8), 594–604.

Yong, E. (2012). Replication studies: Bad copy.Nature,485(7398), 298–300.

Zuo, X.-N., Anderson, J. S., Bellec, P., Birn, R. M., Biswal, B.B., Blautzik, J., ... Milham, M. P. (2014). An open science resource for establishing reliability and reproducibility in functional connectomics.Scientific Data, 1, 140049.