CD-MST初始阶段模块组建方法比较*

2016-02-01高椿雷罗照盛喻晓锋彭亚风郑蝉金

高椿雷 罗照盛 喻晓锋 彭亚风 郑蝉金

(1江西师范大学心理学院; 2江西师范大学初等教育学院, 南昌 330022)

1 引言

认知诊断评价(Cognitive Diagnosis Assessment,CDA)更细粒度的评价学生对知识的掌握情况并给出详细的诊断信息。它的实施包含6个过程, 1)评价目标的确定, 2)确定诊断目标所涉及的认知属性及属性间的层级关系, 3)认知诊断测验的正式编制,4)属性及属性层级关系的验证, 5)正式测试及诊断信息的获取, 6)诊断结果报告及针对性的补救措施的制作(涂冬波, 蔡艳, 丁树良, 2012; DiBello, Roussos,& Stout, 2007)。CDA穿插在教与学的过程中, 是一种风险相对较低、用于改进教学的测验方式, 为教师补救教学、学生自我学习提供依据。当前对于CDA的研究主要包括:模型的开发、参数的估计方法、项目功能差异、属性的在线标定和计算机化自适应测验(Wang & Douglas, 2015; 蔡艳, 涂冬波,2015; 詹沛达, 李晓敏, 王文中, 边玉芳, 王立君, 2015;郭磊, 郑蝉金, 边玉芳, 2015; 罗照盛等, 2015; Xin& Zhang, 2014; Kaplan, de la Torre, & Barrada, 2015;王卓然, 郭磊, 边玉芳, 2014; Mao & Xin, 2013; Chen,Xin, Wang, & Chang, 2012)等。

现阶段主要的测验形式包括纸笔测验(或使用计算机实行的纸笔测验)、计算机化自适应测验(Computerized Adaptive Testing, CAT)和多阶段自适应测验(Multi-stage Testing, MST)。纸笔测验历史千年, 易于组卷、实施简单, 但是它存在着测验长度长、实施不灵活、效率低下等问题; CAT是“量体裁衣”的理想化的测验方式, 针对每位被试的能力水平给予最适合的题目, 因此可以随时安排考试, 缩短测验节约时间。CAT在提高测验效率的同时存在着许多风险, 如项目的过度曝光、考生无法返回检查修改和内容平衡等; MST是纸笔测验和CAT的折中, 在简短的纸笔测验基础上自适应化, 它部分的解决了CAT的缺点, 如考生在模块内可以返回检查和修改,更容易实现内容平衡等, 相对于CAT, 它损失了测验效率(Kim, 1993; Luecht & Nungester, 1998; Patsula, 1999)。

2 相关概念和问题的提出

2.1 MST

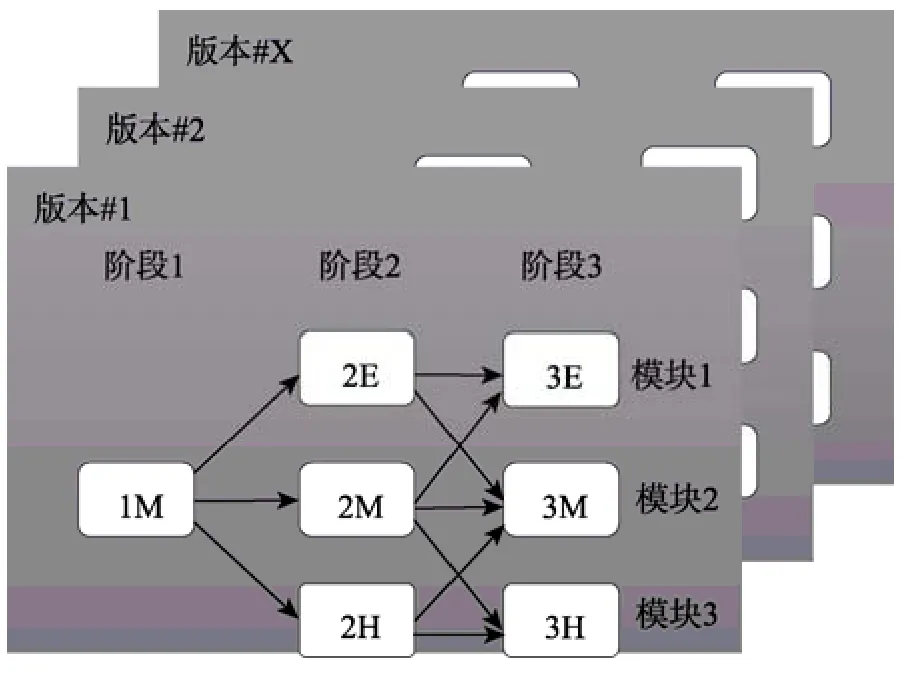

MST包含一些主要的概念, 如模块(module)、阶段(stage)、测验版本(panel)和路由规则(routing rules)等。具有相似统计特征和内容特性的项目组成模块,包含不同统计特征的模块组成阶段, 几个阶段组成测验版本, 为了满足曝光控制, 具有相似特征的测验版本组成题库。路由规则是将被试从一个阶段自适应到下一个阶段的方法。MST是纸笔测验和CAT的折中, 它具有纸笔测验的特点, 在测验实施之前项目组成项目集, 这些项目集称为模块, 类似于一些简短的纸笔测验; 同时MST具有自适应的特点, 模块是根据项目的参数组合起来的, 不同能力水平的被试完成同自己能力水平匹配的模块, 并根据完成的情况选择下一模块。这一过程体现了自适应的思想。

图1为一个典型的MST测验, 该测验共有从1,2…X个测验版本, 测验版本之间是平行的。每个测验版本包括3个阶段, 第一阶段称为路由阶段(routing stage), 第二和第三阶段均有容易、中等和困难三个模块(1-3-3测验版本设计)。在第一阶段中根据被试的作答获得临时能力估计值, 选择第二阶段难度水平同被试能力相匹配的某个模块, 并获得被试临时能力估计值; 同理选出第三阶段的模块并获得最终的被试能力估计值。在整个测验中仅有两个自适应点, 分别是第一阶段进入第二阶段时的自适应和第二阶段进入第三阶段时的自适应。在测验的实施过程中, 不允许被试从上一阶段的最容易模块路由到下一阶段的最高难度模块, 因为这将增加测量误差, 并且在实际测验中, 这种情况不太可能发生。图1中1M+2E+3E就是某一被试所完成的整个测验。

图1 1-3-3 MST测验版本设计

由图1可知, CAT是MST的一个特例。CAT是项目水平上的自适应测验, MST则是模块水平上的自适应测验。

Jodoin, Zenisky和Hambleton (2006)、Hambleton和Xing (2006) 在研究了MST的路由规则、测验版本设计和决策的准确性等内容后认为, MST具有心理测量学上的诸多优势, 它在形式上接近线性测验,在精度上接近CAT, 测验开发者能够更好的利用题库, 更容易满足内容约束。它还有一些其他的优势,如允许测验组织者预先检查, 实施灵活, 允许考生返回修改和检查(Yan, Lewis, & von Davier, 2014)。自上世纪90年代以来MST的研究主要集中在以下几个方面:影响因素的研究(Kim, 1993; Patsula, 1999;Zenisky, 2004; Jodoin et al., 2006; Macken-Ruiz, 2008);自动化组卷技术(Luecht, 1998; Kim, Chung, Dodd,& Park, 2012; Han, 2013; Park, Kim, Chung, & Dodd,2014); 项目曝光控制(Edwards, Flora, & Thissen,2012; Wang, Zheng, & Chang, 2014)等。

在MST的组卷中, 根据预定目标, 项目组成模块, 模块组成测验版本。本研究将初始阶段项目组成模块的过程称为初始阶段模块组建。

现阶段, MST主要建构在项目反应理论(Item Response Theory, IRT)的基础上, von Davier和Cheng(2014)提出了具有认知诊断功能的MST (Cognitive Diagnostic Multi-Stage Testing, CD-MST), 并对CDMST的实施提出了意见和想法。

2.2 CD-MST

CD-MST是CDA和MST的结合, 它将具有认知诊断功能的项目组成模块呈现给被试, 采用自适应的方式将被试路由到同被试知识状态匹配的模块。CD-MST有很多优势。它同时具备了认知诊断功能和自适应的特点; 因为预先组卷, CD-MST允许组织者预先检查试卷, 更容易做到内容平衡和曝光控制, 提高题库的利用率; 在模块内, CD-MST允许考生返回检查和修改, 能有效缓解考生的紧张焦虑情绪(Patsula, 1999)。当然, 随着自适应频次的减少, CD-MST的判准率较具有认知诊断功能的计算机化自适应测验(Cognitive Diagnosis Computerized Adaptive Testing, CD-CAT)也有所降低。

MST同CAT的重要区别在于预先组卷。预先组卷的优势在于测验的组织者在测验实施前可以检查试卷, 能够更好的利用题库, 容易满足内容约束等, 它充分体现了测验组织者的能动性。在MST中, 一旦确定了测验版本设计, 平行的测验版本的组建通常包括两个过程:首先是根据每个模块设定的难度锚(difficulty anchors)和测验信息函数目标从题库中找到符合要求的项目组成模块(Zheng, Wang,& Chang, 2014); 然后将模块组建成测验版本。组建平行的测验版本主要有两种方式(Luecht & Nungester,1998):自下而上(bottom up)和自上而下(top down)。自下而上(Luecht, Brumfield, & Breithaupt, 2006)方式的平行性是通过模块的平行保证的。将许多平行模块混合匹配生成大量的平行的测验版本, 一般来说, 当题库和约束是可行的时候, 自下而上的方式是很容易实现的。自上而下(Belov & Armstrong,2005; Breithaupt & Hare, 2007)方式在组建模块时可以考虑也可以不考虑平行, 在测验版本水平上进行新一轮的优化实现平行和满足非统计约束。

CDA不同于IRT, 在IRT中, 被试的能力水平和项目的难度是在相同量尺上, 它们都是连续变量,这使得基于IRT的MST依据难度和测验信息函数进行组卷成为可能。CDA中被试的知识状态是离散偏序集合, 项目的难度难以界定, 适用于IRT的MST的组卷方法不能应用于CD-MST。CDA中被试知识状态是有限的, 这使得穷尽所有可能知识状态成为可能。因此本研究将CD-CAT的选题策略用于CD-MST的预先组卷中, 这与von Davier和Cheng (2014)的观点一致。主要的思想是使用信息量进行组卷, 采用蒙特卡洛(Monte Carlo)模拟将所有可能的知识状态下的试卷预先组好。测验开始时,被试完成初始阶段的项目, 根据被试作答使用知识状态估计方法估计临时的知识状态, 根据临时知识状态计算预先组建模块的信息量, 选择出信息量最大或最小的模块(根据信息量指标确定取最大值或最小值)作为被试下一阶段将要完成的模块。依次循环, 获得最终知识状态估计。

2.3 问题的提出

对于CD-MST来说, 初始阶段模块组建方法更加重要。相对于CD-CAT, CD-MST的自适应频次更少, 第一阶段的判准率将极大影响后面对被试的最终知识状态的估计。因此, 提出新的初始阶段模块组建方法对CD-MST有更重要的意义。CD-MST不仅需要项目参数, 还关注每个项目考查的不同属性, 这两者对测验的判准率都有影响。因此在初始阶段模块组建中考虑项目参数和项目考查的属性。

本文借鉴CD-CAT的初始项目选取方法, 根据CDA和MST自身特点, 提出了7种CD-MST初始阶段模块组建方法, 并采用模拟研究对7种方法的判准率进行了比较, 这些方法也可以作为CD-CAT初始项目选取方法。

3 研究方法和采用的认知诊断模型

3.1 CD-MST初始阶段模块组建方法

初始项目选取方法是CD-CAT的一个重要组成内容。在现有研究中, CD-CAT初始项目选取通常采用3种方法。第一种是同CAT相同, 随机从题库中选取初始项目, 这种方法没有考虑认知诊断所特有的项目属性。Xu, Chang和Douglas (2003, April)就是采用了该方法。第二种方法是随机分配被试一种知识状态, 根据该知识状态和CD-CAT的选题策略选择第一个项目, 这种方法从第一题开始进入选题状态, 是现阶段CD-CAT主要的起始方法(Cheng,2009; Kaplan et al., 2015; Wang et al., 2014)。第三种方法是涂冬波、蔡艳和戴海崎(2013)所提出的“T阵法”。该方法根据可达矩阵是测验实现对每个属性诊断的充分必要条件(丁树良, 杨淑群, 汪文义,2010)的思想, 保证在CD-CAT的初始阶段尽可能实现对每个属性的诊断, 从而提高测验的判准率。

借鉴CD-CAT的初始阶段项目选取方法, 根据CDA和MST自身特点, 提出了以下7种CD-MST初始阶段模块组建方法。

3.1.1 随机法

随机法是指采用随机的方法从题库中选取项目作为CD-MST初始阶段模块, 在选取项目的时候不考虑项目参数和项目所考察的属性。这种方法简单快速。

3.1.2 选题策略法

选题策略法是指根据随机分配的知识状态和信息量选取出CD-MST初始阶段所需项目进行模块组建, 如本研究中采用PWKL进行模块组建, 根据知识状态和PWKL信息量从题库中选取出当前知识状态下PWKL信息量最大的一部分项目, 如初始阶段项目数是5, 则选取出PWKL信息量最大的5题组成第一阶段模块。

3.1.3 R*矩阵法

可达矩阵(Reachability Matrix, R矩阵)是指能够描述属性之间所具有的直接关系、间接关系和自身关系的矩阵。如果测验包含K个属性, R矩阵是K行*K列的矩阵。丁树良、汪文义和杨淑群(2011)认为R矩阵可以用于指导认知诊断测验的编制, 同时也可以用于认知诊断测验的组卷。在CD-MST初始阶段模块组建时考虑R矩阵是指在选取项目时考虑项目和属性的关系属于R矩阵所描述的关系; 当初始阶段的项目个数同R矩阵的项目个数不是一一对应时, 如属性个数为5个, 则R矩阵是5*5的矩阵, 初始阶段项目个数是6个时, 则在采用R矩阵的项目后, 再随机从R矩阵中选择一个项目组成初始阶段项目。当初始阶段项目个数小于属性个数时, 如初始阶段项目个数是4个, 属性个数为5个, 则随机考察其中的4个属性。本研究将这种方法称为R*矩阵法。R*矩阵法能够实现在初始阶段对每个属性的考察, 保证了Q矩阵的完备性,提高初始阶段的判准率。

以上3种方法是借鉴CD-CAT的初始阶段项目选取方法。

3.1.4 基于经典测量理论的项目区分度 (Classified Test Theory item discrimination, CTTID)法

在MST中, 第一阶段通常采用难度水平为中等的题目(Kim, Moses, & Yoo, 2015)。在CDA中,虽然模型众多, 但是都考虑项目参数。因此, 在初始阶段项目的选取时考虑项目参数是有必要的。项目的区分度是指项目对所测内容的区分能力。良好区分度的项目能够将不同水平的被试区分开来。在该项目上水平高的被试得高分, 水平低的被试得低分。在CTT中, 使用鉴别度指数计算项目的区分度。Rupp, Templin和Henson (2010)依据该思想计算CDA中项目的区分度是

Templin和Henson (2006)曾指出, 在DINA模型中, 一个质量较好的项目应该具有较小的s和g参数。s和g越小, 表示失误和猜测的概率越小, 判准率越高。依据CTTID计算出的DINA模型的项目的区分度吻合了这一思想。因此根据CTTID方法选取出区分度最高的那部分项目组成CD-MST初始阶段模块。

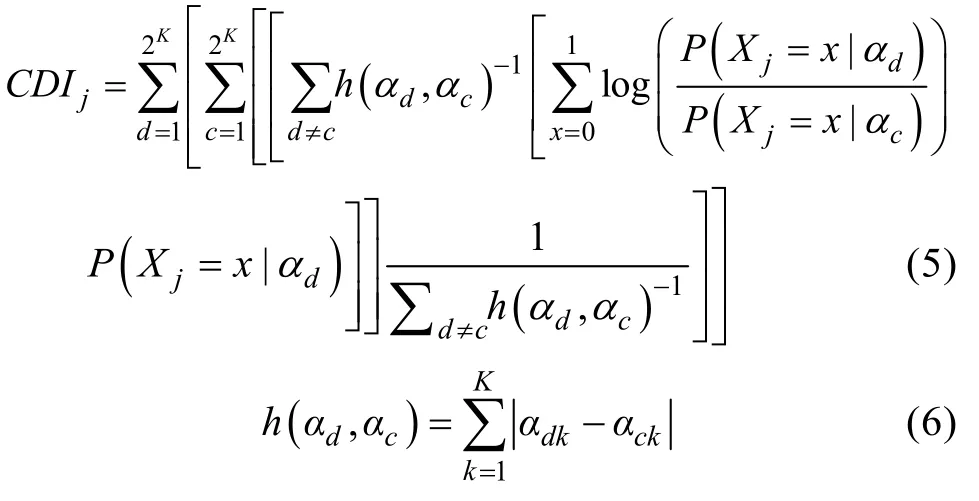

3.1.5 认知诊断区分度指标 (Cognitive Diagnosis Index, CDI)法

上一方法采用经典测量理论的思想计算项目的区分度, 这种方法易于计算。但是这种易于计算依赖于模型。为了克服这个困难, 本研究使用Henson和Douglas (2005)提出的CDI作为另外一种区分度指标计算方法。

Chang和Ying(1999)指出在初始阶段应使用区分度参数较低的项目, 因为测验之初对被试的能力估计不准确。CDI既是选题指标也是区分度指标,在作为选题指标时, CDI不依赖于初始知识状态,因此在测验初期优于其他方法, 适用于初始阶段的选题。作为区分度指标, CDI针对每个项目有区分度值, 这个值不依赖于被试的知识状态和后验估计结果。如前所述, 在CD-MST中由于自适应频次更少, 需要在初始阶段判准率更高, CDI用于CD- MST初始阶段模块组建方法会更加有效。

3.1.6 CTTID和R*相结合的方法(CTTIDR*法)

项目参数和项目所考察的属性是CDA中影响测验效率的重要因素。CD-MST需要依靠项目参数、被试在项目上的属性的掌握情况估计知识状态。CTTID法是根据CTT计算区分度的方法推广到了CDA中。这种方法是在项目参数层面计算区分度, 没有考虑项目所考察的属性。为了提高测验的效率, 需要同时考虑项目所考察的属性。R*矩阵法能够保证Q矩阵的完备性, 将R*矩阵和CTTID相结合, 既保证了项目质量又保证了对属性的全面诊断。因此将CTTID法和R*矩阵法相结合作为CD-MST初始阶段模块组建方法。

3.1.7 CDI和R*相结合的方法(CDIR*法)

CDI从属性的角度上计算项目的区分度。在初始阶段, CDI法选取的项目考查的属性并不确定,也就是说不能保证每个属性都被考察到。为了保证在初始阶段就尽可能实现对每个属性的诊断, 在选取出CDI最大的项目的基础上考虑R*矩阵的方法,将CDI的方法和R*方法相结合。这种方法在项目区分度最大的基础上同时保证初始阶段实现了对所有属性的诊断。作为第七种CD-MST初始阶段模块组建的方法, 称为CDIR*法。

3.2 CD-MST除初始阶段以外的模块的组建方法

如前所述, 应用于CD-CAT的选题方法同样适用于CD-MST中模块的组建(von Davier & Cheng,2014)。鉴于PWKL是判准率较高且使用较广的一种信息量计算方法, 本文使用PWKL进行CD-MST除初始阶段以外的模块的组建。

PWKL是在KL信息量的基础上对被试知识状态的后验分布进行加权(Cheng, 2009)。其数学表达式是

CDA中属性独立的条件下属性个数决定知识状态个数, 如属性个数为5, 则有2=32种知识状态, 根据每种知识状态可以计算出PWKL信息量最大的模块作为预先组好的模块。在施测中根据信息量来选择所需要的模块。

3.3 采用的认知诊断模型

DINA (deterministic inputs, noisy “and” gate)模型在上百种认知诊断模型中受到较多的关注。DINA模型是非补偿模型, 相对于别的模型来说, 它的参数较少, 模型简单易于解释。其数学表达式为:

4 模拟研究:不同项目质量下CD-MST初始阶段模块组建方法比较

本研究使用MATLAB自编程序进行模拟实验。CD-MST共有3个阶段, 每个阶段5个项目, 测验包含15个题目。初始阶段模块组建方法分别采用之前所介绍的随机法、选题策略法、R*矩阵法、CTTID法、CDI法、CTTIDR*法和CDIR*法。第二阶段和第三阶段采用PWKL信息量组建模块, 根据信息量选取出同当前被试知识状态估计值最匹配的模块。估计被试知识状态采用最大后验方法(Maximum A Posterior, MAP)。

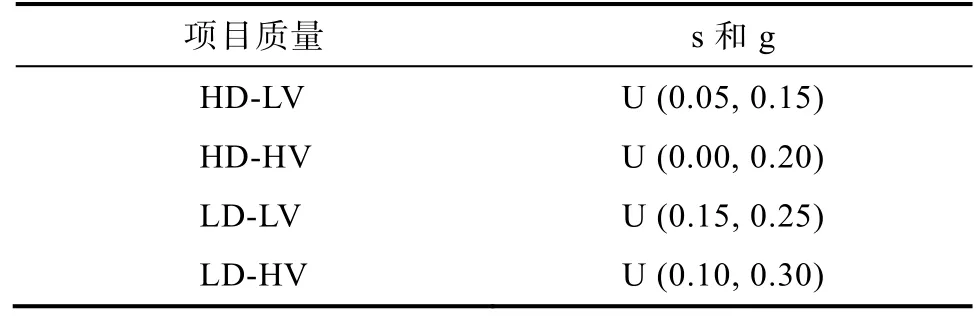

4.1 生成题库

de la Torre, Hong和Deng (2010)研究表明题库的项目质量影响测验的判准率。为此在生成项目参数时参照Kaplan等(2015), 考虑项目区分度(high discrimination, HD)和方差(variance)。项目质量分为高区分度(high discrimination, HD)、低区分度(low discrimination, LD)、高方差(high variance, HV)和低方差(low variance, LV), 四者组合产生4种实验条件,HD-LV, HD-HV, LD-LV, LD-HV。项目参数服从均匀分布。HD-LV的s和g服从于U (0.05, 0.15), HD-HV的s和g服从于U (0.00, 0.20), LD-LV的s和g服从于U (0.15, 0.25), LD-HV的s和g服从于U (0.10,0.30)。区分度高和区分度低的题库中, s和g的均值分别是0.1和0.2。方差高和方差低的题库中, s和g的取值的区间宽度分别为0.2和0.1。因为每次生成的题库不同, 为了减少随机误差, 整个实验重复10次, 取10次的平均值作为最终结果。

表1 项目参数

认知诊断模型采用DINA模型, 属性独立的条件下, 属性个数为5, 共有31种可能的项目考查模式,每种考查模式有40个项目, 每个题库有1240个项目。

4.2 模拟被试知识状态和作答反应

被试知识状态服从于均匀分布, 共3000人。当属性个数为5时, 可能的知识状态是32种, 采用简单随机抽样的方式抽取3000个作为被试知识状态。

模拟被试作答反应:根据被试知识状态的真值、项目参数的真值、使用DINA 模型的项目反应函数, 计算被试正确作答该项目的概率, 并将该概率值同[0, 1]区间的均匀分布的一个随机数相比较,若大于该随机数, 则被试在该项目上的作答为1,反之为0。

4.3 评价指标

评价指标采用属性平均判准率(Attribute Correct Classification Rate, ACCR)和模式判准率(Pattern Correct Classification Rate, PCCR)。

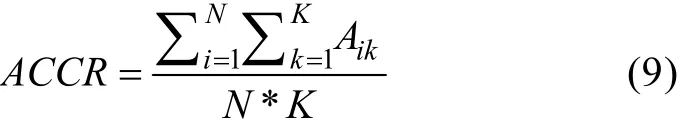

ACCR的公式是

K

表示属性个数,N

是被试个数。A

表示第i

个被试在第k

个属性上的估计值和真值一致。ACCR越大表示属性的平均判准率越高。PCCR的公式是

P

代表第i

个被试知识状态的估计值和真值一致。PCCR越大表示对于整个知识状态的估计越准确。5 实验结果

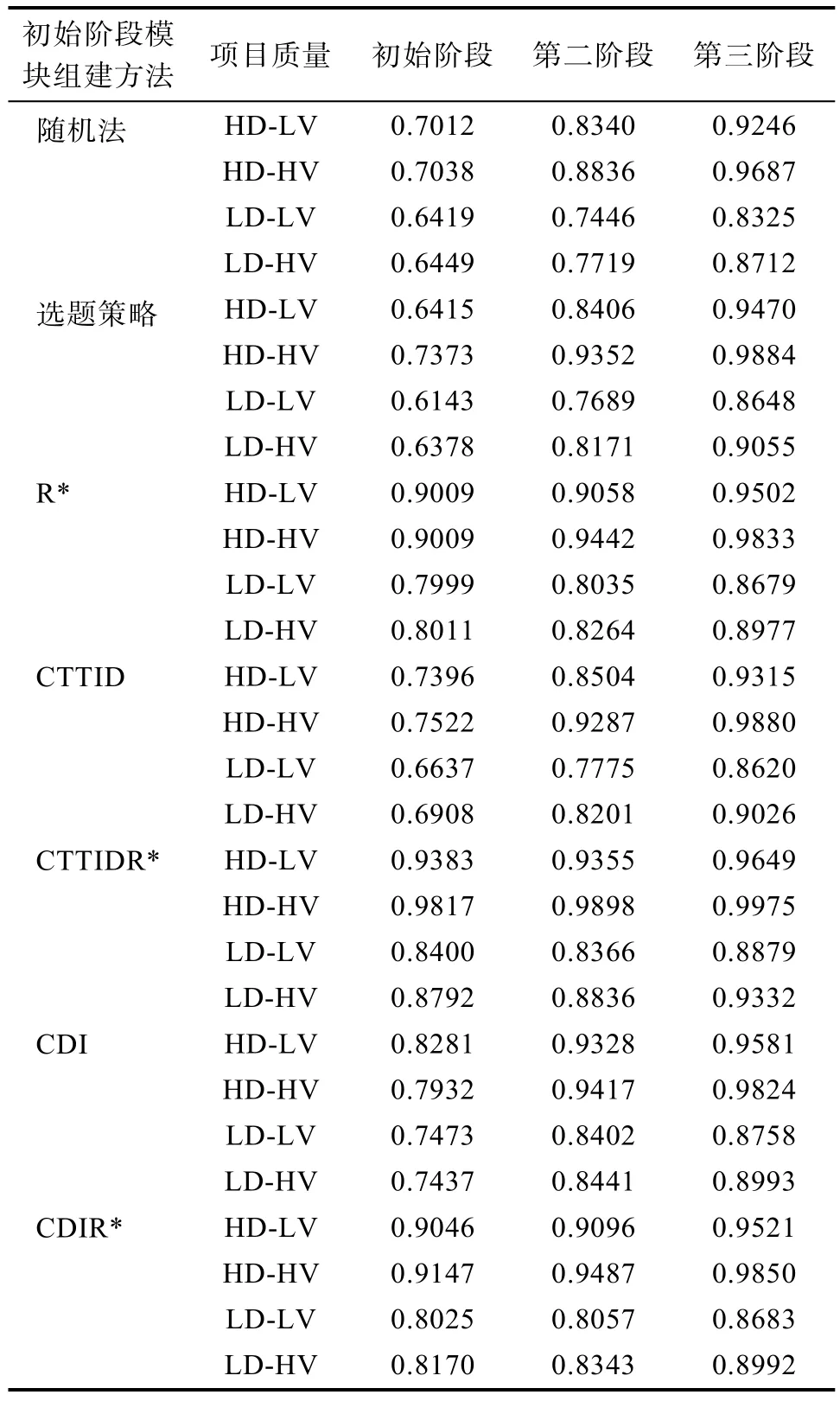

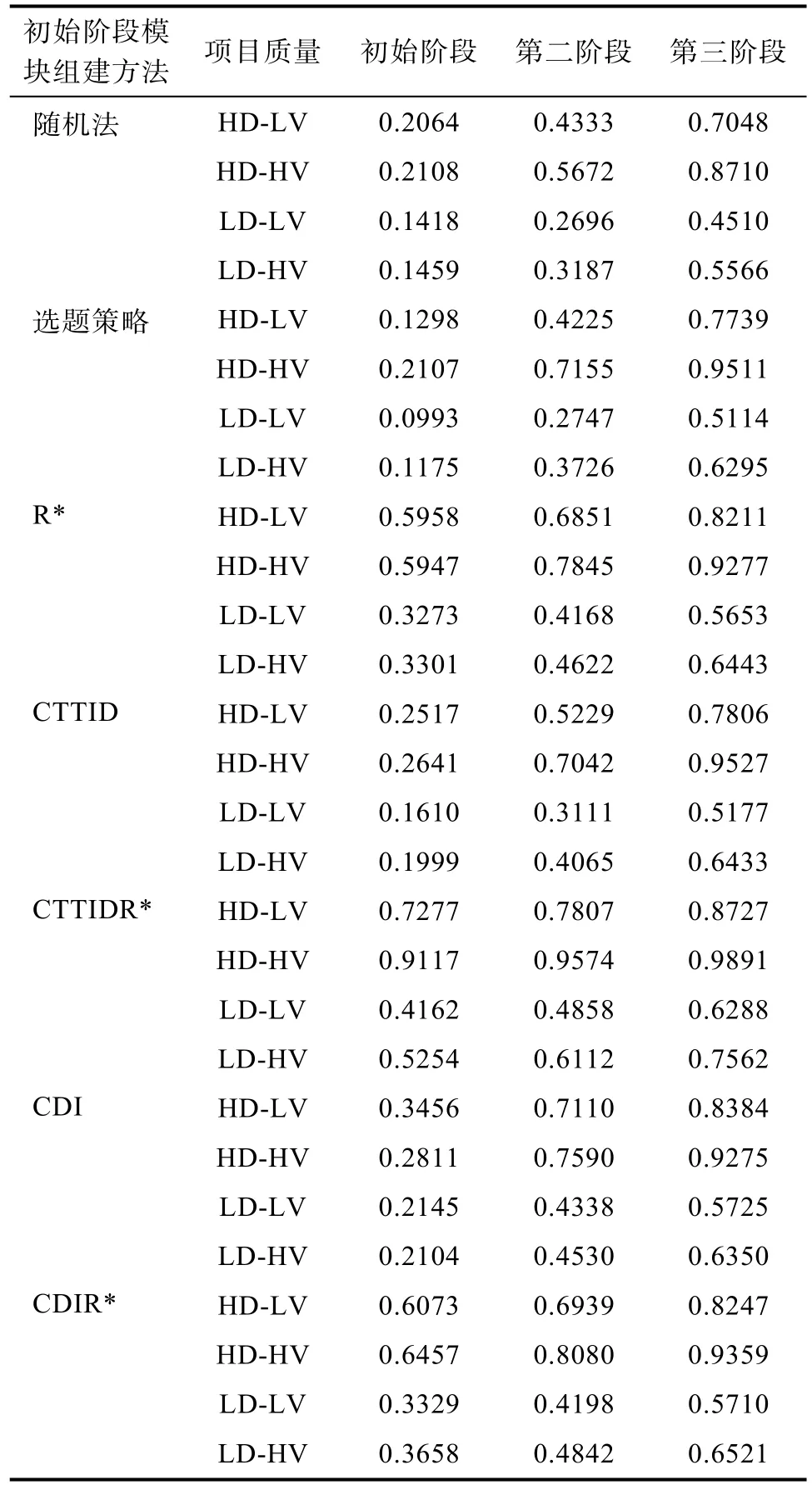

表2和表3是7种初始阶段模块组建方法的结果。现阶段CDA的研究主要分析PCCR, 为了保持一致本文着重分析PCCR, ACCR只作为参考。

表2 七种初始阶段模块组建方法ACCR结果

表3 七种初始阶段模块组建方法PCCR结果

总体上来看, 含有R*矩阵的方法在所有题库下都具有优势, 尤其是CTTIDR*法优势更加明显。

当被试完成初始阶段的模块后, 7种初始阶段模块组建方法的结果差异较大, 其中CTTIDR*法最好, CDIR*法次之, 其次是R*矩阵法, CDI法,CTTID法, 随机法, 选题策略法最差。含有R*矩阵的方法同其他4种方法相比判准率更高, CTTIDR*法在所有题库质量下都显著高于其他方法, CDIR*法和R*矩阵法结果较为接近。在整个测验结束时,由于测验长度的增加, 7种方法的判准率逐渐接近,含有R*矩阵方法的优势缩小。即使这样, CTTIDR*法仍然高于其他6种方法。

从题库角度来说, 项目质量对测验判准率影响较大。HD-HV情况下, 判准率最高, HD-LV次之,LD-HV较差, LD-LV最差。以CTTIDR*法为例, 在整个测验结束时PCCR分别是HD-HV是0.9891,HD-LV是0.8727, LD-HV是0.7562, LD-LV是0.6288, 四者的差异较大。

为了更加清晰的说明问题, 以下对4种题库下7种方法的判准率逐个进行分析。

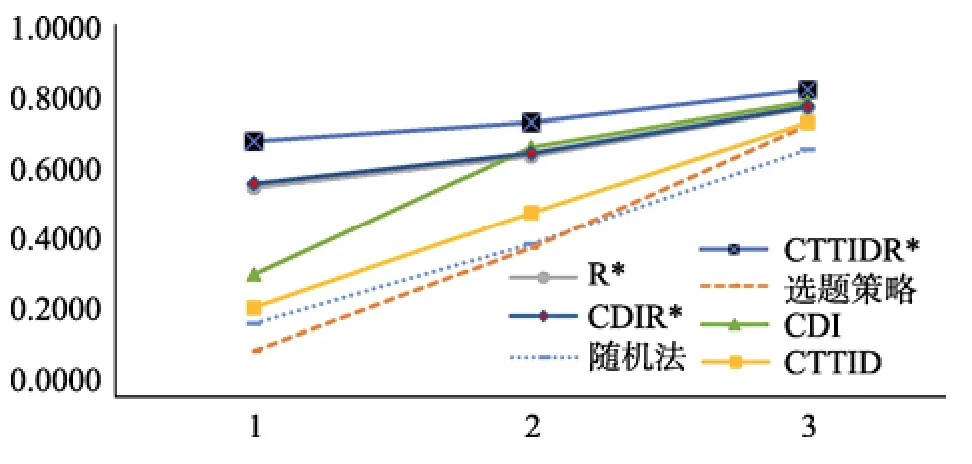

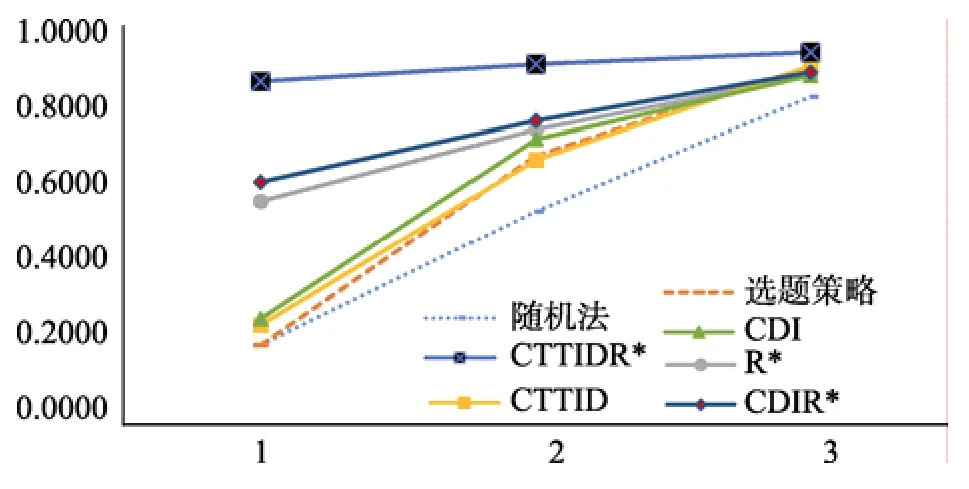

从图2可以发现,当被试完成初始阶段模块后,前3种方法的结果较为接近, 判准率比其它4种方法高了0.25以上。前3种方法分别是CTTIDR*法、CDIR*法和R*矩阵法, 它们都是包含R*矩阵的方法, 说明R*矩阵对判准率有较大影响。这3种方法中, CTTIDR*法显著高于其他两种方法, CDIR*法和R*矩阵法没有差异。随着测验长度和阶段数的增加, 所有方法的PCCR越来越接近, CDIR*、R*和CDI方法几乎没有差异。CTTIDR*法仍然比其他方法高了0.05以上。

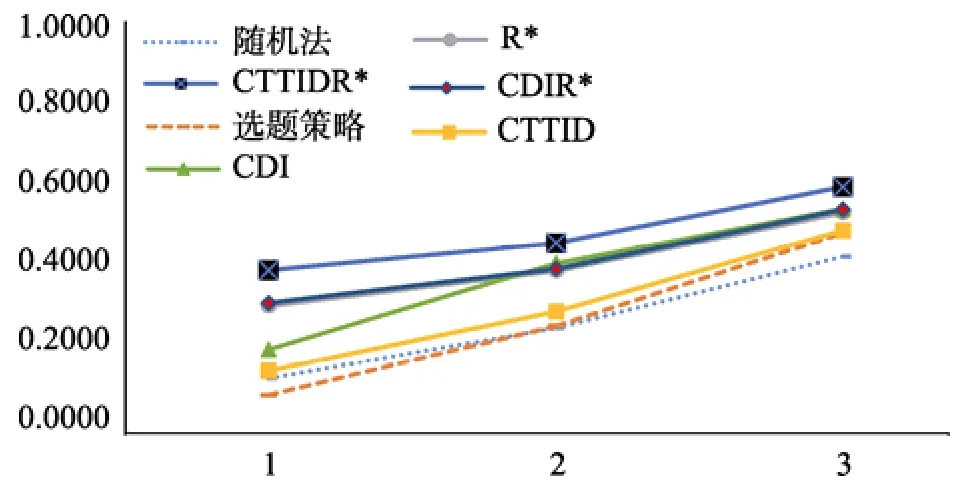

从图3可以发现,在HD-HV下, 当被试完成初始阶段的模块后, 含有R*矩阵的方法比其他方法提高了0.3。CTTIDR*法在初始阶段结束后已经达到了0.9117。由于天花板效应, 之后阶段的提高较小, 最终的判准率是0.9891, 比处于第二位的选题策略法高了0.0380。

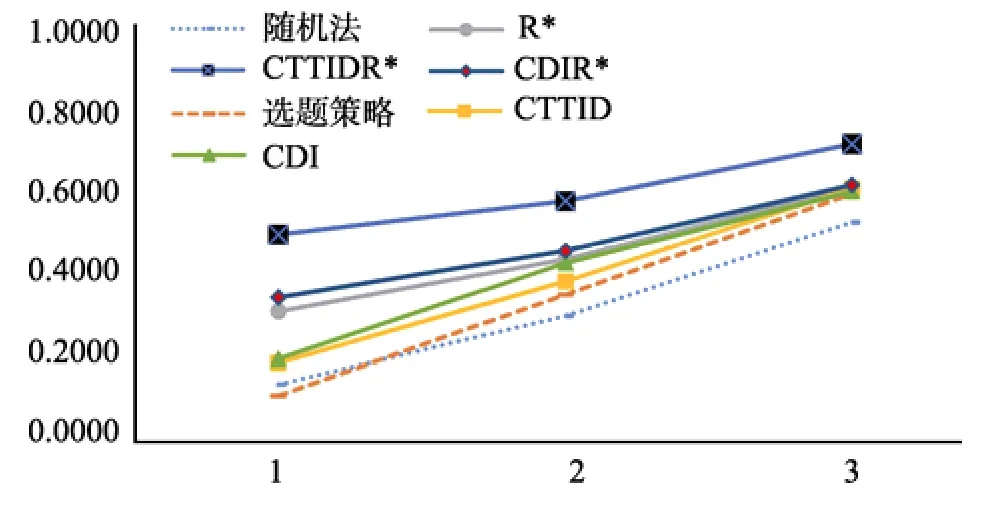

从图4可以发现,在LD-LV下, 得到的结果与之前两种题库质量基本相同。在初始阶段结束后,含有R*矩阵的方法显著高于其他4种方法。在整个测验结束后, CTTIDR*法仍然显著优于其他方法。

图2 HD-LV下7种初始阶段模块组建方法的PCCR

图3 HD-HV下7种初始阶段模块组建方法的PCCR

图4 LD-LV下7种初始阶段模块组建方法PCCR

图5 LD-HV下7种初始阶段模块组建方法的PCCR

从图5可以发现,在LD-HV下, 当被试完成初始阶段模块后, 含有R*矩阵的方法显著高于其他4种方法。整个测验结束时, CTTIDR*法比其他方法高了0.1, 选题策略法、R*矩阵法、CTTID法、CDI法和CDIR*法结果接近。

6 讨论与展望

CD-MST是对CDA有效地推广和应用, 同时扩大了MST的适用范围。对于CD-MST细节问题的研究很有必要, 初始阶段模块组建方法就是其中之一。初始阶段模块组建方法对于CD-MST更加重要, CD-MST是以模块的形式进行组建并施测的,初始阶段的项目数量和质量会影响初始阶段项目结束后的判准率和下一阶段模块选取的准确性。本研究在CD-CAT初始项目选取的基础上提出了7种CD-MST初始阶段模块组建方法, 采用模拟研究比较了这7种方法的判准率。

这些初始阶段模块组建方法在提高测验判准率的同时增加了优质项目的曝光率, 致使题库使用不均匀。在以后的研究中可以尝试把曝光控制的方法同初始阶段模块组建方法结合起来达到控制曝光的目的, 或者是采用平行模块的方式解决该问题。

CD-MST作为一种新的认知诊断测验方式, 有诸多问题需要研究。如预先组卷问题。在MST中通常根据项目参数进行组卷, CD-MST由于是在认知诊断的基础上进行组卷, 需要考虑项目参数、项目考查的属性等问题, 单纯依靠项目参数组卷的效果很差。本研究根据信息量进行组卷, 这种方法穷尽了所有可能的知识状态。是否存在着别的更简便的组卷方式是值得研究的问题。

本文提出的7种CD-MST初始阶段模块组建方法不但可以应用于CD-MST, 也可以推广至CD- CAT。选题策略法作为CD-CAT中最常用初始项目选取方法在CD-MST中表现很一般, 尤其是在初始阶段结束时, 其判准率甚至低于随机法。使用的选题策略法是PWKL, 该方法在测验开始之前随机分配被试一种知识状态, 这种知识状态通常是错误的, 在错误的知识状态基础上选出来的项目通常同被试真实知识状态相距甚远, 因此在初始阶段采用PWKL效果并不理想。本研究提出了3种含有R*矩阵的初始阶段模块组建方法, 其中CTTIDR*法显著高于其他方法, 该方法应用于CD-CAT是否能得到较好的结果还需进一步研究。

Belov, D. I., & Armstrong, R. D. (2005). Monte Carlo test assembly for item pool analysis and extension.Applied Psychological Measurement, 29

(4), 239–261.Breithaupt, K., & Hare, D. R. (2007). Automated simultaneous assembly of multistage testlets for a high-stakes licensing examination.Educational and Psychological Measurement,67

(1), 5–20.Cai, Y., & Tu, D. B. (2015). Extension of cognitive diagnosis models based on the polytomous attributes framework and their Q-matrices designs.Acta Psychologica Sinica, 47

(10),1300–1308.[蔡艳, 涂冬波. (2015). 属性多级化的认知诊断模型拓展及其Q矩阵设计.心理学报, 47

(10), 1300–1308.]Chang, H. H., & Ying, Z. (1999).a

-stratified multistage computerized adaptive testing.Applied Psychological Measurement, 23

(3), 211–222.Chen, P., Xin, T., Wang, C., & Chang, H. H. (2012). Online calibration methods for the DINA model with independent attributes in CD-CAT.Psychometrika, 77

(2), 201–222.Cheng, Y. (2009). When cognitive diagnosis meets computerized adaptive testing: CD-CAT.Psychometrika, 74

(4), 619–632.de la Torre, J., Hong, Y., & Deng, W. L. (2010). Factors affecting the item parameter estimation and classification accuracy of the DINA model.Journal of Educational Measurement, 47

(2), 227–249.DiBello, L. V., Roussos, L. A., & Stout, W. (2007). Review of cognitively diagnostic assessment and a summary of psychometric models. In C. R. Rao & S. Sinharay (Eds.),Handbook of statistics, 26: Psychometrics

(pp. 979–1030).Amsterdam, Netherlands: Elsevier. Ding, S. L., Yang, S. Q.,& Wang, W. Y. (2010). The importance of reachability matrix in constructing cognitively diagnostic testing.Journal of Jiangxi Normal University (Natural Science),34

(5), 490–494.[丁树良, 杨淑群, 汪文义. (2010). 可达矩阵在认知诊断测验编制中的重要作用.江西师范大学学报(自然科学版),34

(5), 490–494.]Ding, S. L., Wang, W. Y., & Yang, S. Q. (2011). The design of cognitive diagnostic test blueprints.Journal of Psychological Science, 34

(2), 258–265.[丁树良, 汪文义, 杨淑群. (2011). 认知诊断测验蓝图的设计.心理科学, 34

(2), 258–265.]Edwards, M. C., Flora, D. B., & Thissen, D. (2012). Multistage computerized adaptive testing with uniform item exposure.Applied Measurement in Education, 25

(2), 118–141.Guo, L., Zheng, C. J., & Bian, Y. F. (2015). Exposure control methods and termination rules in variable-length cognitive diagnostic computerized adaptive testing.Acta Psychologica Sinica, 47

(1), 129–140.[郭磊, 郑蝉金, 边玉芳. (2015). 变长CD-CAT中的曝光控制与终止规则.心理学报, 47

(1), 129–140.]Hambleton, R. K., & Xing, D. H. (2006). Optimal and nonoptimal computer-based test designs for making pass-fail decisions.Applied Measurement in Education, 19

(3), 221– 239.Han, K. T. (2013).MSTGen

: Simulated data generator for multistage testing.Applied Psychological Measurement,37

(8), 666–668.Henson, R., & Douglas, J. (2005). Test construction for cognitive diagnosis.Applied Psychological Measurement,29

(4), 262–277.Jodoin, M. G., Zenisky, A., & Hambleton, R. K. (2006).Comparison of the psychometric properties of several computer-based test designs for credentialing exams with multiple purposes.Applied Measurement in Education,19

(3), 203–220.Kaplan, M., de la Torre, J., & Barrada, J. R. (2015). New iem selection methods for cognitive diagnosis computerized adaptive testing.Applied Psychological Measurement, 39

(3),167–188.Kim, H. (1993).Monte Carlo simulation comparison of two-stage testing and computer adaptive testing

(Unpublished doctorial dissertation). University of Nebraska, Lincoln.Kim, J., Chung, H., Dodd, B. G., & Park, R. (2012). Panel design variations in the multistage test using the mixedformat tests.Educational and Psychological Measurement,72

(4), 574–588.Kim, S., Moses, T., & Yoo, H. (2015). A comparison of IRT proficiency estimation methods under adaptive multistage testing.Journal of Educational Measurement, 52

(1), 70– 79.Luecht, R. M. (1998). Computer-assisted test assembly using optimization heuristics.Applied Psychological Measurement,22

(3), 224–236.Luecht, R. M., & Nungester, R. J. (1998). Some practical examples of computeradaptive sequential testing.Journal of Educational Measurement, 35

(3), 229–249.Luecht, R. M., Brumfield, T., & Breithaupt, K. (2006). A testlet assembly design for adaptive multistage tests.Applied Measurement in Education, 19

(3), 189–202.Luo, Z. S., Yu, X. F., Gao, C. L., Li, Y. J., Peng, Y. F., Wang,R., & Wang, Y. T. (2015). Item selection strategies based on attribute mastery probabilities in CD-CAT.Acta Psychologica Sinica, 47

(5), 679–688.[罗照盛, 喻晓锋, 高椿雷, 李喻骏, 彭亚风, 王睿, 王钰彤.(2015). 基于属性掌握概率的认知诊断计算机化自适应测验选题策略.心理学报, 47

(5), 679–688.]Macken-Ruiz, C. L. (2008).A comparison of MST and CAT based on the GPCM

(Unpublished doctorial dissertation).University of Texas, Austin.Mao, X. Z., & Xin, T. (2013). The application of the Monte Carlo approach to cognitive diagnostic computerized adaptive testing with content constraints.Applied Psychological Measurement, 37

(6), 482–496.Park, R., Kim, J., Chung, H., & Dodd, B. G. (2014). Enhancing pool utilization in constructing the multistage test using mixed-format tests.Applied Psychological Measurement,38

(4), 268–280.Patsula, L. N. (1999).A comparison of computerized-adaptive testing and multistage testing

(Unpublished doctorial dissertation). University of Massachusetts at Amherst.Rupp, A. A., Templin, J., & Henson, R. A. (2010).Diagnostic measurement: Theory, methods, and application.

New York:The Guilford Press.Templin, J., & Henson, R. A. (2006). Measurement of psychological disorders using cognitive diagnosis models.Psychological Methods, 11

(3), 287–305.Tu, D. B., Cai, Y., & Ding, S. L. (2012).Cognitive diagnosis:Theory, methods and application

. Beijing, China: Beijing Normal University Publishing Group.[涂冬波, 蔡艳, 丁树良. (2012).认知诊断理论、方法与应用

.北京: 北京师范大学出版集团.]Tu, D. B., Cai, Y., & Dai, H. Q. (2013). Item selection strategies and initial items selection methods of CD-CAT.Journal of Psychological Science, 36

(2), 469–474.[涂冬波, 蔡艳, 戴海崎. (2013). 认知诊断CAT选题策略及初始题选取方法.心理科学, 36

(2), 469–474.]von Davier, M., & Cheng, Y. (2014). Multistage testing using diagnostic models. In D. L. Yan, A. A. von Davier, & C.Lewis (Eds.),Computerized multistage testing: Theory and applications

(pp. 219–227). New York: CRC Press.Wang, C., Zheng, C. J., & Chang, H. H. (2014). An enhanced approach to combine item response theory with cognitive diagnosis in ddaptive testing.Journal of Educational Measurement, 51

(4), 358–380.Wang, S. Y., & Douglas, J. (2015). Consistency of nonparametric classification in cognitive diagnosis.Psychometrika, 80

(1),85–100.Wang, Z. R., Guo L., & Bian, Y. F. (2014). Comparison of DIF detecting methods in cognitive diagnostic test.Acta Psychologica Sinica, 46

(12), 1923–1932.[王卓然, 郭磊, 边玉芳. (2014). 认知诊断测验中的项目功能差异检测方法比较.心理学报, 46

(12), 1923–1932.]Xin, T., & Zhang, J. H. (2014). Local equating of cognitively diagnostic modeled observed scores.Applied Psychological Measurement, 39

(1), 44–61.Xu X. L., Chang, H. H., & Douglas, J. (2003, April).A simulation study to compare CAT strategies for cognitive diagnosis.

Paper presented at the annual meeting of National Council on Measurement in Education, Montreal,Canada.Yan, D., Lewis, C., & von Davier, A. A. (2014). Overview of computerized multistage tests. In D. Yan, A. A. von Davier,& C. Lewis (Eds.),Computerized multistage testing:Theory and applications

(pp. 3–20). New York: CRC Press.Zenisky, A. L. (2004).Evaluating the effects of several multistage testing design variables on selected psychometric outcomes for certification and licensure assessment

(Unpublished doctorial dissertation). University of Massachusetts,Amherst.Zhan, P. D., Li, X. M., Wang, W. C., Bian Y. F., & Wang, L. J.(2015). The multidimensional testlet-effect cognitive diagnostic models.Acta Psychologica Sinica, 47

(5), 689– 701.[詹沛达, 李晓敏, 王文中, 边玉芳, 王立君. (2015). 多维题组效应认知诊断模型.心理学报, 47

(5), 689–701.]Zheng, Y., Wang, C., & Chang H. H. (2014). Overview of test assembly methods in multistage testing. In D. Yan, A. A.von Davier, & C. Lewis (Eds.),Computerized multistage testing: Theory and applications

(pp. 87–100). New York:CRC Press.