基于YCbCr的自适应混合高斯模型背景建模*

2015-03-19殷苌茗周书仁

黄 玉,殷苌茗,周书仁

(长沙理工大学计算机与通信工程学院,湖南 长沙410004)

1 引言

运动目标检测,即检测当前图像和背景图像中对应像素点的差异,选择合适阈值判定该像素为前景运动目标。它是运动分析、视频监控的关键步骤,也是最基础和底层的步骤,其检测结果的好坏直接关系到后续分析处理的优劣和实用性。目前,常用的运动目标检测算法主要有帧差法[1]、光流法、背景差分法。背景建模是背景差分法的核心环节。

Stauffer C 与Grimson W[2]提出了混合高斯MoG(Mixture of Gaussians)背景模型方法,利用在线估计更新模型,能较好地处理光照变化和背景混乱运动的干扰等产生的影响,但它所耗费的庞大计算量限制了这种模型在实时性很强的系统中的应用。文献[3]用实验证明该经典MoG 方法对噪声情况的处理效果很一般。Kaewtrakulpong P等[4]对MoG 方法进行改进,使用两个阶段的学习方案对参数进行更新,但由于检测阶段的更新速度较小且恒定,模型仍不能很好地适应背景变化。Zivkovic Z[5]提出了一种自适应选择高斯成分个数的方法对MoG 进行改进,较大地提高了计算时间和性能,但其对收敛速度没有明显改进。Lee D S[6]引入另一变量对学习速率进行计算,提高了收敛速度和精确率,但容易将运动较慢、面积较大的目标学习为背景,导致目标检测不完整。王永忠等[7]提出了一种新的混合高斯模型高斯成分个数的自适应选择策略,能够加快建模速度,实现实时效果。

本文对MoG 进行改进,提出一种基于YCbCr的自适应混合高斯模型背景建模方法:将建模颜色空间从RGB转换到YCbCr,采用自适应选择策略来确定混合高斯模型的高斯成分个数,按照新的关键字变量的值对高斯成分进行排序。将提出的建模方法应用于运动目标检测,实验结果表明,相较于MoG 方法,本文提出的方法应用于运动目标检测中能取得更准确的检测结果,能更好地处理噪声的影响,耗时更少。

2 混合高斯背景建模

文献[2]提出的混合高斯背景模型的基本思想是,用K(一般取3~5)个高斯分布的混合对每个像素建模,并对高斯分布的均值和方差进行在线更新。在前景检测过程中,如果图像像素点与被选为背景模型的高斯成分相匹配,则该像素点归类为背景点,相反地,则被认为是前景点。t时刻视频序列中第i个像素点Xi,t的概率可以用K个高斯分布表示:

其中,η(Xi,t,μi,k,t,Σi,k,t)是高斯分布函数,μi,k,t为均值,Σi,k,t为协方差矩阵,ωi,k,t为权重。

当有新的图像帧到来时,将其中的每个像素与该像素处已存在的K个高斯分布逐一匹配检验,若满足:

则说明当前像素点Xt与混合高斯模型中第k个高斯分布相匹配,反之则不匹配。其中,λ为一常量,通常取2.5~3.5,σk,t为标准差。对匹配的第k个高斯分布的参数按下式更新:

其中,α为自定义的学习速率(通常取0.005),ρ为参数学习速率。匹配时,Mk,t+1取1,否则取0。不匹配的高斯分布的权值更新依旧为式(3)所示,但其均值和方差不变。

若构建该像素的所有高斯分布中不存在与Xt相匹配的高斯分布,则将Xt作为均值赋给权重最小的高斯分布,并对该高斯分布重新赋以较小的权重和较大的方差。

按照ωk,t/σk,t从大到 小对K个 高 斯 分 布 进 行排序,满足:

的前Bt个分布选为背景模型,T为权重阈值。将每个像素值与背景模型进行匹配测试,若匹配,则该像素点为背景点,否则该像素点为前景点。

3 基于YCbCr的自适应混合高斯模型

YCbCr空间有极其稳定和独立的亮度通道,最适合用于处理噪声。改进的混合高斯模型高斯成分个数的自适应选择策略和对前景检测中排序关键字的计算的改进能够提升效率,改善算法实时性。初始化模型时,一般用采集到的第一帧图像中各像素点的彩色向量值初始化构建该像素的K个高斯分布的均值,并对每个高斯分布指定较大的标准差σinit(通常为30)和较小的权重winit(0.05)。因为,初始化的高斯模型是一个并不准确的模型,需要不停地缩小它的范围,更新它的参数值,从而得到最可能的高斯模型。将方差设置大些,则能将尽可能多的像素包含到一个模型之中,从而获得最有可能的模型。

3.1 转换至YCbCr颜色空间建模

MoG 中采用RGB 颜色空间进行背景建模,RGB颜色空间的分量与亮度密切相关,只要亮度改变,三个分量都会随之改变,且三个分量不是独立的。所以,RGB颜色空间适合于显示系统,却并不适合于图像处理。因此,很多作者使用其他颜色空间建模,以获得更鲁棒的效果,类似的有:文献[8]使用YUV 颜色空间,文献[9]使用HSV 颜色空间等。

本文方法采用YCbCr颜色空间进行背景建模。在YCbCr颜色空间中,Y分量表示图像的亮度信息,Cb和Cr分量分别表示蓝色和红色分量。亮度信息和色度信息相互独立,Cb和Cr分量不受亮度的影响。文献[10]指出YCbCr颜色空间是最适合用于分割算法的颜色空间,它对噪声最不敏感,因为它具有强稳定性和更独立的颜色通道。因此,选择YCbCr颜色空间作为运动目标颜色特征,能更好地处理噪声。

采用公式(8)将颜色空间由RGB 转换为YCbCr:

3.2 自适应选择策略

在MoG 中,混合高斯模型高斯成分个数K是一个固定的常量,每个像素拥有相同数目的高斯成分。但是,在背景场景中,大部分像素的模态是不一样的。文献[6]通过实验得出结论:动态区域建模需要使用更多的高斯成分,即:相同的室外场景,包含了树枝和灌木随风晃动的像素的高斯成分数目比其他不是表示这些晃动的像素的高斯成分数目多。所以,设置一个固定大小的高斯成分个数来表示场景背景是不合理的,不能确切地描述实际场景状态。若每个像素使用自适应的高斯成分个数,就会减少计算量,加快建模速度,从而提升检测速度。

文献[7]中提出的自适应策略采用的原理是:随着参数的不断更新,混合高斯模型中长时间与场景匹配的高斯成分的权重会越来越大,不匹配的高斯成分的权重会越来越小。在选择背景模型时,由于会选择权重与标准差之比较大的几个高斯成分作为表示背景的分布,所以权重逐渐变小的高斯成分会逐渐成为前景模型。当某个高斯分布的权重小于初始权值,且该高斯成分的权重与方差之比小于初始化时的权重与方差之比时,该高斯成分将会被排在新的初始化的高斯成分之后,将这样的高斯成分称为过期高斯成分,在背景模型更新时删除它们。

此自适应策略方法可以显著地提高背景建模的速度,有效地节约运算资源,但是它仍然有缺陷。当某一高斯分布的权值和权值与方差的比都小于其对应的初始值时,该高斯分布会被删除,但有可能下一帧图像该高斯分布又被增加进来,这样会影响正常的背景建模,降低系统的鲁棒性。所以,本文对此自适应策略进行改进,修改其高斯分布丢弃制度,对过期高斯分布的判别公式如下所示:

其中,cIE为某一高斯分布的最新匹配帧距当前帧的帧数;N为预先设定的阈值(通常N≥1),表示该高斯分布在连续N帧中都没有匹配的像素点。

改进的自适应策略的步骤如下:

步骤1 初始化时,给场景中每个像素的混合高斯模型都只设置一个高斯成分,将每个像素点的所有高斯成分的cIE初始化为0。

步骤2 增加新的高斯成分:随着场景的变化,当某个像素的混合高斯模型不能与当前像素匹配时,为该像素的所有高斯成分的cIE加1。如果该像素混合高斯模型中的高斯成分个数没有达到设定的最大值Kmax(一般设置为3),则自动地增加一个以当前像素值为均值的初始高斯成分;否则用以当前像素值为均值的新的高斯成分代替该像素混合高斯模型中排在最后的高斯成分。

步骤3 删除过期的高斯成分:在每次模型更新完成后,根据式(9)判断每个像素混合高斯模型中的最后一个高斯成分是否过期,如果过期则删除。

3.3 前景检测方法

利用混合高斯模型进行前景检测包括三个阶段:(1)排序:原始MoG 中,一般设置排序关键字变量为sortkey,令它等于ωk,t/σk,t,根据它对K个分布进行排序;(2)通过背景阈值T标记高斯成分;(3)使用匹配测试将当前像素分类。

由于混合高斯模型中长时间与场景匹配的高斯成分的权重会越来越大,不匹配的高斯成分的权重会越来越小,而权值越大的高斯成分,其为背景模型的概率越大,反之亦然。各高斯成分的方差的大小表示该高斯成分的稳定性程度,方差越小越稳定,反之亦然。所以,本文对前景检测中的排序方法中的排序关键字变量sortkey的值设置如下:

这样便能在排序之时确保权值大的高斯分布定会被选为背景模型,从而获得最可能的高斯模型,减少sortkey的计算量,节约计算成本。

4 实验结果与分析

为验证本文方法的性能,实验在Pentium(R)Dual CPU T3200 2GHz、内存为2GB的PC机上运行,在Windows XP Professional SP3操作系统中VS2010环境下结合OpenCV 编程,采用多个视频序列[11~13]进行测试,并与经典MoG[2]比较。实验中所使用的参数为:Kmax=3;ωinit=0.05;σinit=30;α=0.005;T=0.7;λ=3.5;N=5。

4.1 室内场景检测分析

一般室内环境的背景相对比较简单和稳定,除灯光照射条件剧烈变化和窗口阳光照射变化影响外,像素值不会发生很大的波动,所以室内背景的获取相对较容易。

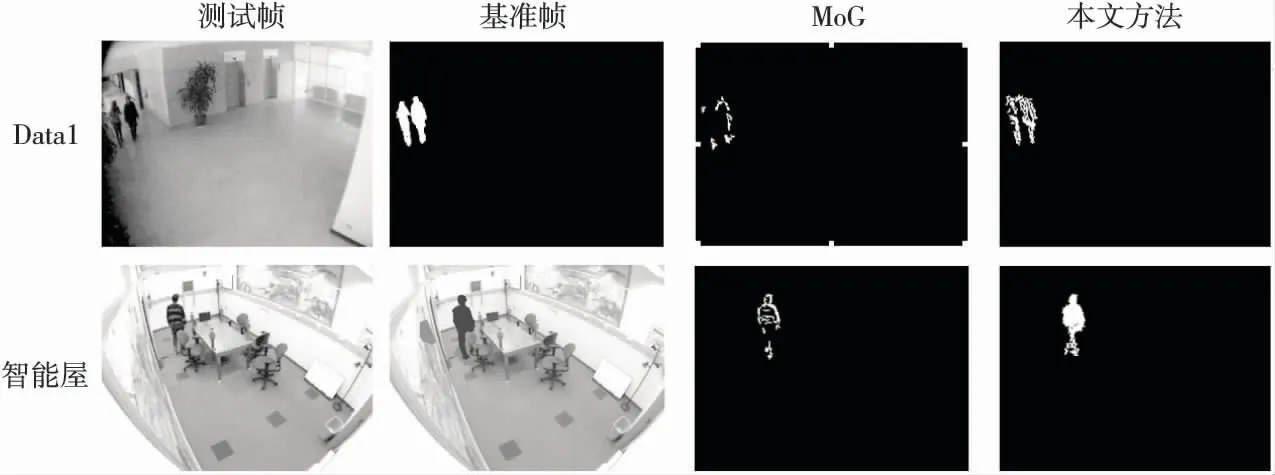

此处室内场景测试用了两个视频序列。序列1为IPPR Dataset[11]中的data1 序列,长300 帧,图像大小为320×240像素,包含多个运动目标,目标有交错及遮蔽现象;序列2为ATON Dataset[12]中的智能屋视频,长298帧,图像大小为320×240像素,它是一室内测试视频,噪声水平中等,人的运动阴影很难辨别。

图1显示了本文方法与MoG 方法对室内场景进行运动目标检测的比较,其中,测试帧分别为data1序列的第113帧、智能屋视频中的第108帧,所有检测结果均未做后处理。从图1中可以看出,MoG 方法能够实现目标检测,但其效果不佳,获得的运动目标轮廓很稀疏,有许多空洞。相比之下,本文方法能抑制噪声的影响,更好地将前景与背景分割,获得更完整的运动目标。

4.2 室外场景检测分析

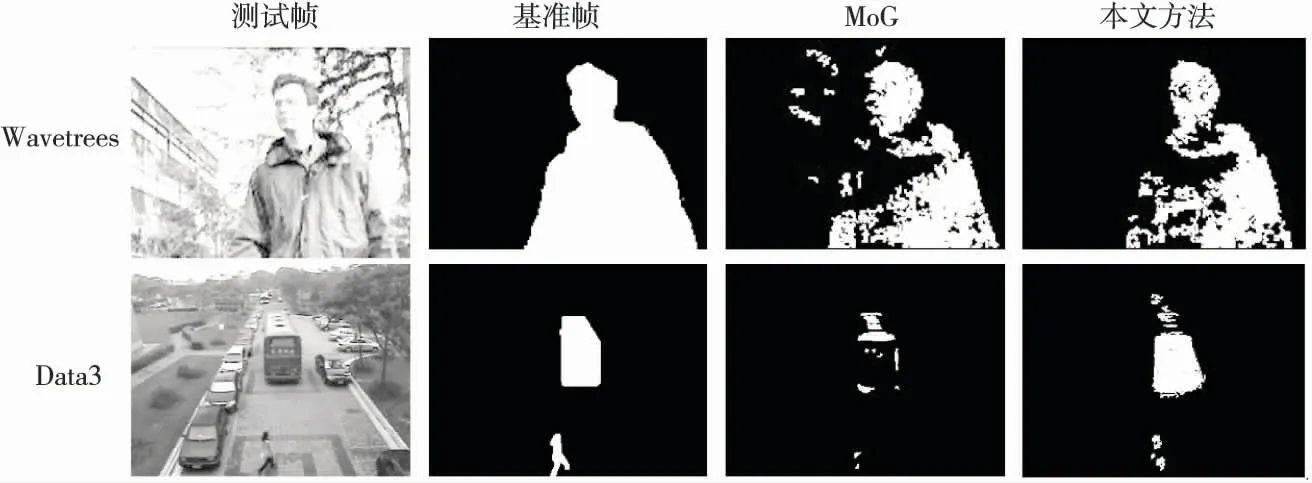

室外场景一般较室内场景复杂许多,很多时候包含了许多其他运动的背景,如树枝或灌木随风摇摆。为验证本文方法对室外场景的良好检测性能,此处选择了两个视频序列进行实验。

序列1 为Wallflower Dataset[13]中 的Wavetrees序列,长286帧,图像大小为160×120像素,包含动态变化的背景;序列2 为IPPR Dataset[11]中的data3序列,长300帧,图像大小为320×240像素,包含多个运动目标,目标有交错及遮蔽现象,且傍晚时分环境光线有变化。

图2显示MoG 方法与本文方法对室外场景进行检测的比较。图中的测试帧分别为Wavetrees序列中的第247帧和data3 序列的第39帧。可以看出,MoG 方法会将摇晃的树枝误检为前景目标,且其检测出的前景目标有较多空洞;本文方法的检测结果更准确,更能适应背景的轻微运动,可获得更清晰完整的前景目标。

Figure 1 Moving targets detection results of indoor scenes图1 室内场景运动目标检测结果

Figure 2 Moving targets detection results of outdoor scenes图2 室外场景运动目标检测结果

4.3 时间耗费分析

本文方法最大的特点在于提升了背景建模的速度,表1列出了采用本文方法与MoG 方法对四个视频序列进行运动目标检测的耗时。可以看出,不论场景的复杂与简单,不论视频序列是大还是小,本文方法的耗时都比MoG 方法的少许多。

Table 1 Time-consuming comparison of two kinds of detect methods表1 两种方法检测耗时比较 s

5 结束语

本文方法是针对经典MoG 方法以耗时计算为代价获取可观的效果而提出来的。实验结果表明,本文方法显著提高了建模效率和目标检测的速度,能够达到实时要求。同时,本文方法没有以牺牲检测效果为代价来获取速度的提升,除不能很好地处理突然的光照变化和阴影之外,它能够更好地抑制噪声和背景中的动态变化的影响,且检测到的运动目标信息更完整,空洞现象更少。

[1] Meier T,Ngun K N.Video segmentation for content-based coding[J].IEEE Transactions on Circuits and Systems for Video Technology,1999,9(8):1190-1203.

[2] Stauffer C,Grimson W.Adaptive background mixture models for real-time tracking[C]∥Proc of Computer Vision and Pattern Recognition(CVPR),1999:246-252.

[3] Brutzer S,Höferlin B,Heidemann G.Evaluation of background subtraction techniques for video surveillance[C]∥Proc of Computer Vision and Pattern Recognition(CVPR),2011:1937-1944.

[4] Kaewtrakulpong P,Bowden R.An improved adaptive background mixture model for real-time tracking with shadow detection[C]∥Proc of the 2nd European Workshop on Advanced Video Based Surveillance Systems,2001:1-5.

[5] Zivkovic Z.Improved adaptive Gaussian mixture model for background subtraction[C]∥Proc of International Conference on Pattern Recognition,2004:28-31.

[6] Lee D S.Effective Gaussian mixture learning for video background subtraction[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2005,27(5):827-832.

[7] Wang Yong-zhong,Liang Yan,Pan Quan,et al.Spatiotemporal background modeling based on adaptive mixture of Gaussians[J].ACTA Automatica SINICA,2009,35(4):371-378.(in Chinese)

[8] Fang X,Xiong W,Hu B,et al.A moving object detection algorithm based on color information[C]∥Proc of International Symposium on Instrumentation Science and Technology,2006:384-387.

[9] Sun Y,Li B,Yuan B,et al.Better foreground segmentation for static cameras via new energy form and dynamic graph-cut[C]∥Proc of the 18th International Conference on Pattern Recognition(ICPR 2006),2006:49-52.

[10] Kristensen F,Nilsson P,Öwall V.Background segmentation beyond RGB[C]∥Proc of ACCV’06,2006:602-612.

[11] IPPR Dataset[EB/OL].[2013-02-16].http://archer.ee.nctu.edu.tw/contest/.

[12] ATON Dataset[EB/OL].[2013-02-13].http://cvrr.ucsd.edu/aton/shadow/.

[13] Wallflower Dataset[EB/OL].[2013-02-13].http://research.microsoft.com/users/jckrumm/WallFlower/TestImages.htm.

附中文参考文献:

[7] 王永忠,梁彦,潘泉,等.基于自适应混合高斯模型的时空背景建模[J].自动化学报,2009,35(4):371-378.