基于深度敏感特性的立体质量评价模型

2014-12-01兰诚栋杨秀芝

兰诚栋,杨秀芝,陈 建

(福州大学物理与信息工程学院,福建 福州350108)

随着3D电视的兴起和发展,立体视频技术引起了广泛的关注.立体视频增加了深度效果,使观众体验更加生动的视觉观感,但实际应用中存在立体视频数据量大、资源缺乏和立体感知效果差等问题,因此立体视频的压缩编码和处理技术成为3D电视能否成功的关键,而这些算法性能的改进提高,都需要通过评价立体图像质量的优劣来确定.评价立体图像质量的方法分为主观评价和客观评价2种.主观评价方法的结果更加准确,但需要组织专门人员进行观测,价格昂贵且耗时.客观质量评价方法通过构建数学模型对图像质量进行计算,不仅过程简单方便,而且还可作为权衡优化结果的代码加入到算法中,从而提高编码和处理算法的性能,是评价立体图像质量的重要方法.目前国际上,2D图像客观质量评价方法已经发展了二十几年,而3D图像客观质量评价方法还处于初期研究阶段.2008年,Benoit等[1]扩展了传统2D图像客观质量评价方法,引入表示左右两图差异的视差图,将视差图的失真值与左右图客观质量的平均值进行线性结合,最终的值表示立体图像质量.该方法在传统2D图像客观质量基础上增加考虑了深度质量,但是没有讨论视差图对于深度质量的影响.2009年,Yang等[2]提出将图像质量和立体感知分开评价,通过左右图相减得到的绝对视差图来判断图像立体感,用视差图的失真表示立体感知客观质量.该方法计算简单,但是仅仅用实验表明绝对视差图对立体感的作用,缺乏相关理论分析.2010年,Yasakethu等[3]通过将深度图分割成不同的深度平面,结合了相邻深度平面相对距离失真、深度平面内容感知的一致性和深度图的结构误差3个方面来评价立体客观质量.该方法利用了深度图中不同深度平面的特性及相互关系,但对深度平面与立体质量的相关性没有具体分析.2011年,Sarikan等[4]同样将深度图分割成不同的深度平面,利用SSIM对层、帧、序列3个级别进行了加权计算,将深度图的评价扩展到了立体视频质量评价.2012年,韩国延世大学的Kim等[5]认为运动索引因素和深度因素是立体图像质量的重要信息,因此将两者结合起来产生权重图,加入到均方误差(MSE)公式中来计算最终的客观质量值.同年,Lebreton等[6]深入分析了产生立体感知的原理,对视差图的生成,深度图分割和空时域信息的运用都做出具体讨论分析,从而提出了立体视频深度感知评价算法.

从上述文献分析可知,当前对于立体图像客观质量的评价可分为左右视图的2D图像质量和深度感知质量.传统2D图像质量评价方法比较成熟,不做讨论,本文主要关注立体图像的深度感知质量评价方法.对于深度的评价主要利用视差图或深度图来进行,目前对于视差图的生成,视差图分割以及运动信息的结合都做出了详细讨论.但是,目前的评价方法直接利用视差图或深度图失真来计算客观质量值,而事实上深度图与立体感并非简单线性关系,本文从最小可觉察误差 (just noticeable difference,JND)模型和深度值映射角度,建立深度图像素值与立体质量的关系,在前沿深度质量评价模型基础上增加映射关系,从而更精确地评价立体图像的深度感知质量.

1 基于深度图的立体图像质量评价模型

在传统立体图像和视频的深度感质量评价中,以视差作为评价深度感的依据,视差反映了左右眼观看同一目标物时产生的差异,观测者可以依据视差感知到目标物距离,它是引起深度感的主要因素.在实际应用中,视差往往转化成8位的深度值,以深度图的形式保存.颜色附加深度(MVD)的视频格式[7]正是以这种方式保留深度信息,它是MPEG和ITU联合组织目前正在制定的视频标准,在这种视频格式中的每个颜色图(或称纹理图)都附带自身的深度图,深度图表示对应颜色图的深度信息.因此,深度图将存在于未来的视频数据中,以它作为立体图像的深度质量评价依据是合适的选择,深度图像素值的特性可以反映立体感知的质量.

深度图像素值与深度感知之间不是简单的线性关系,简单的像素值计算并不能反映深度质量,像素的位置和像素值的幅度都会影响人眼深度立体感判断.首先,人眼对视网膜中央凹的内容最清晰[8],也就是对关注区域深度感最强;其次,人眼对不同的景深距离的敏感度是不同的[9],感知的目标对象距离屏幕越远,人眼的深度敏感度越弱而深度感越强;最后,对于出屏(负视差)和入屏(正视差)的感知程度也不同,出屏部分舒适性范围比入屏部分小[10].前沿的立体视频质量评价方法[6]认为整帧图像的深度感主要取决于人眼感兴趣区域,在评价之前进行了区域分割,通过计算人眼关注区域的深度值特性来评价图像深度感.但是,该方法对于感兴趣区域内的像素值到深度感质量值的过程使用线性映射,没有区分对待不同像素值的敏感度特点,这导致该方法获得的深度感评价值与实际人眼感知不一致.由于深度图像素值到人眼深度感之间是非线性映射关系,深度值并不能直接代表深度感知,它与深度值所包含的敏感度信息是相关的.因此,本文引入人眼对深度的JND来构建敏感度模型.文献[9]指出在不同模拟深度级的JND深度(Just noticeable difference in depth,JNDD)值不一样:模拟深度级离屏幕越远,JNDD值越大,人眼的深度敏感性越弱;模拟深度级离屏幕越近,JNDD值越小,人眼的深度敏感性越强.这里JNDD是指人眼可以感觉到深度变化的阈值.如果深度值的变化落在原始深度的JNDD范围内,不会影响人眼深度感知的变化.因此,本文根据JNDD值与人眼深度敏感性之间的关系,在深度感质量评价中,利用原始深度的可觉察阈值,并构建代表人眼深度感知程度的敏感性因子,进而反映视差值和实际深度感评价值之间的非线性对应关系.

2 基于深度敏感性的立体图像质量评价算法

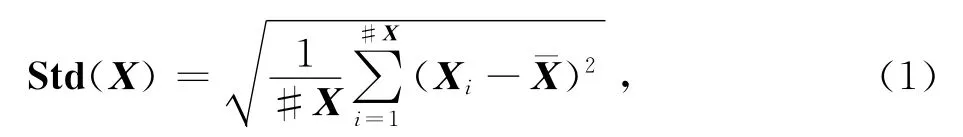

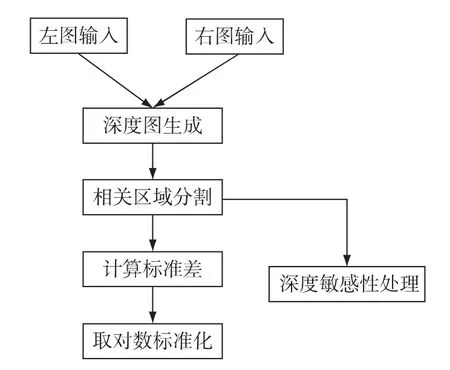

在立体图像的客观质量评价方法中,分析影响立体图像视觉效果的因素,准确地提取反映立体图像深度质量的特征信息,是建立有效质量评价方法的前提和基础.当前MVD视频格式是MPEG标准制定的方向,因此,本文方法首先利用左右视图提取了表征立体视觉信息的深度图作为评价依据.接着,对深度图运用图像分割算法进行聚类分割,挑选人眼关注的区域,然后对所选区域的深度值做特征统计处理,并且在这一过程考虑了人眼深度敏感特性对深度感的影响,最后,结合时域的特征信息计算视频序列深度质量值.因此,模型的总体框架包含以下4个主要步骤:1)生成深度图;2)深度相关区域的分割;3)所选择区域的特征统计;4)视频深度质量值计算.下面我们主要讨论前3个具体步骤,视频质量评价方法可以将连续相邻多帧图像的深度质量估计值进行平均[6].

深度图的生成.这个模块的目标是提取一个表示双眼线索的差异,称为双眼视差.最精确的方式是在拍摄期间从摄像机采集视差信息.但是目前,很少原始视频中包含深度图的信息,必须从2个视图中去估计.MPEG提供的深度估计参考软件(DERS)可以估计深度图.该软件需要至少3种不同的视点输入,才可以提供精确的深度图.如果我们通过图割[11]算法先对图像进行对象分割,则两个视点输入也可以半自动生成较精确的深度图.

深度相关区域分割.由于人眼的深度线索需要结合相关对象在左右图中的位置,该步骤假定观测者使用吸引他们注意力的区域或对象来判断3D图像的深度.该步骤提取图像中视差和面积都较大的区域,这些区域提供更多相对深度信息,更可能被人眼用来判断场景的深度.在实践中,引入均值漂移[12]算法对前后背景区域进行聚类分割,根据景深距离阈值和区域大小选取前景区域作为深度相关性区域.

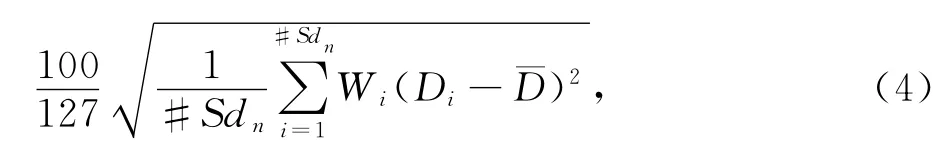

提取双目特性用于整个序列深度感估计.由于深度的层次性有助于以相对的方式评价立体视觉感知,因此场景中不同对象间的视差变化可用于深度估计.本算法用标准差表示深度层次性,公式定义为:

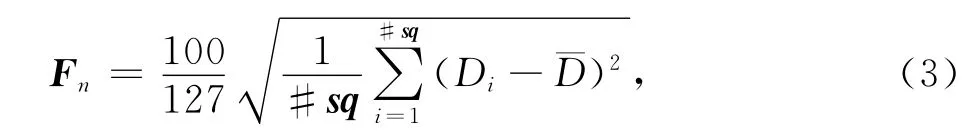

其中,X表示图像区域像素值组成的向量,#X表示X向量元素个数,Xi表示第i个元素,¯X表示向量元素的平均值.为了标准化深度质量评价值的单位,假设深度变化范围不超过全深度的一半(全深度范围是0~255),并将数值范围设在主观评价值的相同区间[0,100]内,那么标准差结果需乘以标准化因子因此,对于深度相关区域像素值组成的向量sq,序列第n帧的深度质量预估值Fn如下:

图1 深度质量估计算法框图Fig.1 The diagram of depth quality estimation algorithm

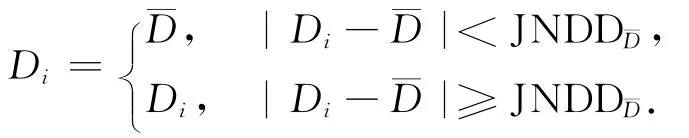

为了提高深度图用于立体感质量评价的精确性,我们引入一种基于深度敏感特性的处理方法,整体算法描述如图1所示.标准差是计算每个深度值与平均深度值的差异,但是当深度值变化小于JNDD阈值时,人眼无法判别到立体感变化,因此,标准差计算之前需要将每个深度值依据JNDD阈值进行预处理,则公式(1)变为:

其中:

在不同深度级,人眼的深度敏感性不同.深度值离屏幕越近,人眼对该深度值的变化越敏感,该深度变化对立体感的贡献也越大,而这时JNDD越小.因此,我们在立体感质量评价模型中增加表示深度级影响人眼深度敏感性的权重因子,假设该权重因子与JNDD成反比,则深度质量可表示为:

其中,

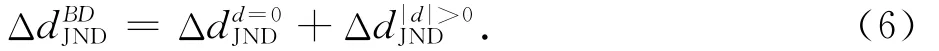

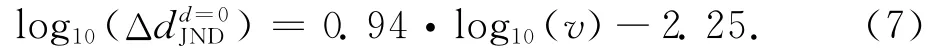

k表示比例系数,JNDDi表示在深度Di的最小可觉察误差,它受观看距离和初始模拟深度的影响[9].模拟深度是指观看到的对象与显示器屏幕的实际距离.近切平面和远切平面是立体显示器的2个特性,它们定义了在显示器的前面和后面最大可能的模拟深度.考虑到观看距离和初始模拟深度级对JNDD的影响,JNDD通用模型如公式(6)所示.根据公式(6),双眼视差的JNDD定义为,它是观看距离对JND影响和 模 拟 深 度 级 对 JND 影 响2个 值之和:

JNDD与双眼差异的感知变化随着观看距离而呈线性变化[9].文献[9]基于实验数据近似给出了公式(7):

其中,Δdd=0JND表示当初始模拟深度为零(d=0)时的JNDD值,v表示观看距离,单位为m.

可见,Δdd=0JND与观看距离成正比.根据公式(7),JNDD随着观看距离而变化,观看距离越远,JNDD值越大.此外,初始深度d和JNDD之间的关系为:

其中,Δd|d|>0JND表示当初始深度不为零时的JNDD,Kω表示韦伯常数,该值可以通过深度恰可觉察的实验来确定经验值.韦伯定律指出在一个更大的原始刺激下,需要更大的刺激差异用于感知刺激改变,这里双眼差异被视为刺激,它表明了一个原始刺激和感知明显改变的刺激之间的关系.

3 实验与结果

为了验证基于深度敏感性立体质量评价算法的有效性,本实验以主观质量评价值作为比较参考目标,判断该模型预测结果与人眼主观感知的一致程度.

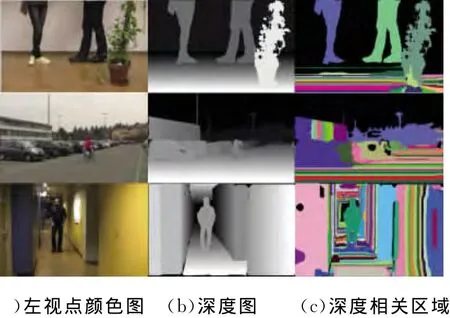

考虑测试序列的标准、权威和公开,本文利用瑞士洛桑理工大学(EPFL)的3D立体视频库[13],该库包含了不同深度的立体视频,这些视频经过严格的主观测试得出了视频库的主观质量值.本次实验考虑测试序列的差异性和算法的适用性,选取了立体视频库中的室内和室外场景Feet、Bike和Hallway的15种不同立体感的测试序列,我们生成出不同的深度图,并在计算客观质量值时选取深度相关区域.测试序列的左视图、深度图和深度相关区域如图2所示.

图2 场景左视图、深度图和深度相关区域2 The left view image and the depth map of scenes

EPFL实验室的主观实验是按照ITU组织制定的ITU-R BT.500-11[14]建议书来进行操作的.具体的实验环境为:显示屏:46寸偏振立体显示器(Hyundai S465D),观看距离:2m,评测等级:5级(优、良、中、差、劣),测试人数:20人,年龄分布:24~37岁,平均年龄27岁,评测方法:单刺激方法.

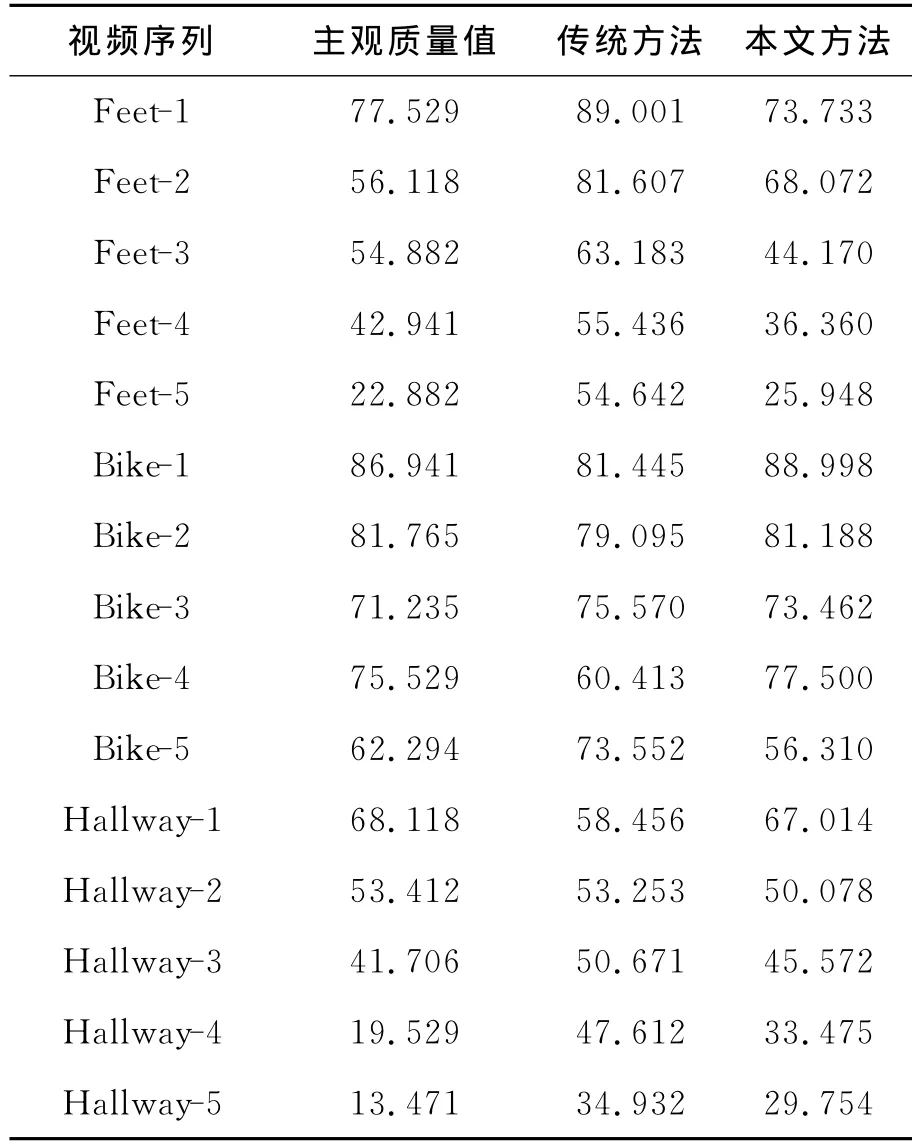

本实验主观结果采用EPFL实验室给出的实验结果,可参见表1中测试序列的主观值(DMOS).客观质量的评价对具有不同深度感的测试视频序列,首先使用深度图生成方法获得深度图,接着分别采用立体视频深度感知评价算法和基于深度敏感性的客观质量评价模型来计算得出测试序列的客观质量值.相比于上述传统方法,本文方法将人眼对深度图像素值的深度敏感性加入计算质量值.在实验中,我们通过主观验证测试最小可觉察阈值,取得模型中Kw经验值为0.15,k取2.

通过以上实验,获得的实验数据如表1所示,其中分别列出了15个测试序列的立体感主观质量值、传统方法预测客观值和本文方法预测的客观值.

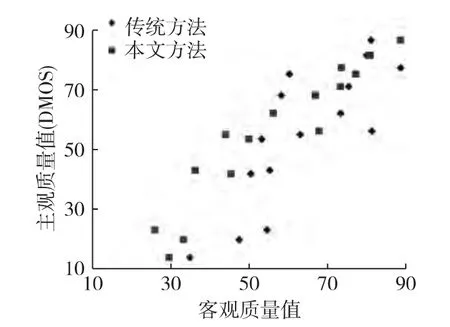

图3为不同测试序列的2种评价算法的散点图.从图3可以看出,相比于传统方法,本文方法的结果更靠近对角直线,说明客观模型与主观感知的相关性更好,客观评价值越接近主观值,更符合人眼看到的视觉效果.

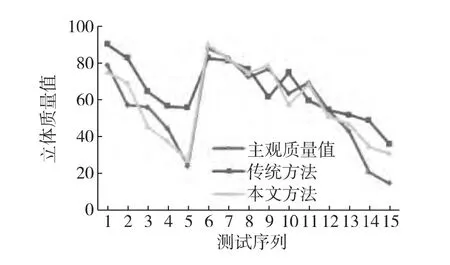

图4为不同测试序列的主观质量值和客观质量值的折线图.可以看出,相比于传统方法,本文方法预测的客观质量值的变化趋势与主观值更为相符.

表1 Feet测试序列的主观值和客观值Tab.1 The subjective and objective values of the Feet test sequences

图3 主观和客观质量值比较的散点图Fig.3 The scatter diagram of comparison of subjective and objective quality values

为了更好地考察所提出模型的性能,本文采用2个评价指标来定量比较传统方法和本文方法的性能:

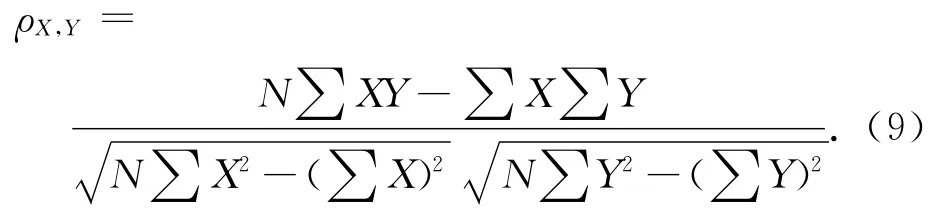

1)线性相关系数(CC),用Pearson线性相关系数[15]来反映客观评价模型预测的精确性,其表达式为:

图4 测试序列立体质量折线图Fig.4 The broken line graph of stereoscopic quality values of the test sequences

Pearson相关系数是用来表明客观评价模型所得的预测值与主观质量评价实验得到的DMOS之间的相关性强弱,其取值范围为[-1,1],绝对值越接近1,客观评价模型的评价值越接近主观值.

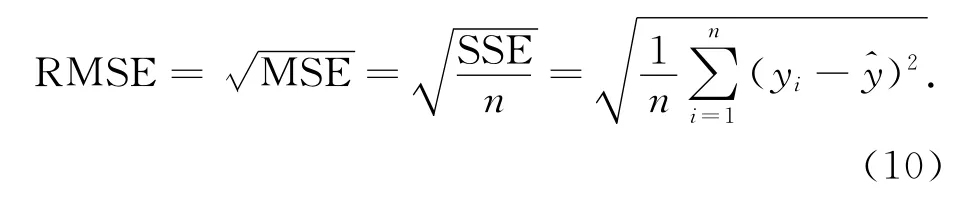

2)均方根误差(RMSE),在评价客观模型性能时还经常用RMSE来衡量,其表达式为:

RMSE是用来衡量客观质量值和主观质量值之间的偏差.RMSE值越小,客观评价值和主观评价值越一致,则客观算法模型的性能就越好.

如表2所示,实验结果表明本文的客观评价模型相比于传统方法在相关性和均方误差上都有了较大提高,尤其是室外场景的结果与主观质量值非常接近,其准确性取得了较大改善,因此本文的客观评价模型在评价立体视频质量时具有较大优势.

表2 客观评价模型的性能比较Tab.2 The performance comparison of objective evaluation methods

4 结 论

本文描述了一种基于深度敏感度的立体视频评价方法.该方法针对前沿深度质量评价模型对于像素值到深度感质量值过程使用线性映射,没有区分对待不同像素值的敏感度特点,导致获得的深度感评价值与实际人眼感知不一致的问题,提出引入深度最小可觉察误差反映人眼的深度敏感性,进而根据敏感度模型映射不同像素值对人眼深度感的作用.该方法通过实验测试有效,结果显示所提出的方法比传统方法有较大提高,该方法可进一步应用于视频压缩和处理算法中.另外,本文深度相关区域的选取是依据景深距离和区域大小,而实际相关区域主要是人眼关注的感兴趣区域,人眼关注度模型等方法可被引入进一步提高评价结果的精确性.

[1]Benoit A,Le Callet P,Campisi P,et al.Using disparity for quality assessment of stereoscopic images[C]∥Proceedings of the 15th IEEE International Conference on Image Processing.San Diego:IEEE,2008:389-392.

[2]Yang J,Hou C,Zhou Y,et al.Objective quality assessment method of stereo images[C]∥3DTV Conference:The True Vision-Capture,Transmission and Display of 3DVideo.Potsdam:IEEE,2009:1-4.

[3]Yasakethu S L P,De Silva D,Fernando W A C,et al.Predicting sensation of depth in 3Dvideo[J].Electronics letters,2010,46(12):837-839.

[4]Sarikan S S,Olgun R F,Akar G B.Quality evaluation of stereoscopic videos using depth map segmentation[C]∥Quality of Multimedia Experience,2011Third International Workshop on.Mechelen:IEEE,2011:67-71.

[5]Kim D,Ryu S,Sohn K.Depth perception and motion cue based 3Dvideo quality assessment[C]∥Broadband Multimedia Systems and Broadcasting,2012IEEE International Symposium on.Seoul:IEEE,2012:1-4.

[6]Lebreton P,Raake A,Barkowsky M,et al.Evaluating depth perception of 3Dstereoscopic videos[J].IEEE Journal of Selected Topics in Signal Processing,2012,6(6):710-720.

[7]Fehn C.A 3D-TV system based on video plus depth information[C]∥Signals,Systems and Computers,2004.Conference Record of the Thirty-Seventh Asilomar Conference on.[S.l.]:IEEE,2003:1529-1533.

[8]Ho C C,Wu J L,Cheng W H.A practical foveation-based rate-shaping mechanism for MPEG videos[J].Circuits and Systems for Video Technology,IEEE Transactions on,2005,15(11):1365-1372.

[9]De Silva V,Fernando A,Worrall S,et al.Sensitivity analysis of the human visual system for depth cues in stereoscopic 3-D displays[J].Multimedia,IEEE Transactions on,2011,13(3):498-506.

[10]International Telecommunication.Subjective methods for the assessment of stereoscopic 3dtv systems[EB/OL].[2012-03-11].http:∥www.itu.int/rec/R-REC-BT.2021/cn

[11]Kolmogorov V,Zabin R.What energy functions can be minimized via graph cuts[J].Pattern Analysis and Machine Intelligence,IEEE Transactions on,2004,26(2):147-159.

[12]Comaniciu D,Meer P.Mean shift:a robust approach toward feature space analysis[J].Pattern Analysis and Machine Intelligence,IEEE Transactions on,2002,24(5):603-619.

[13]Goldmann L,De Simone F,Ebrahimi T.Impact of acqui-sition distortions on the quality of stereoscopic images[C]∥Fifth International Workshop on Video Processing and Quality Metrics for Consumer Electronics-VPQM 2010.Scottsdale:[s.n.],2010:13-15.

[14]Recommendation I.Methodology for the subjective assessment of the quality of television pictures[EB/OL].[2013-12-11].http:∥office.kbs.co.kr/tri/wp-content/uploads/sites_20101117.pdf.

[15]Chikkerur S,Sundaram V,Reisslein M,et al.Objective video quality assessment methods:A classification,review,and performance comparison[J].Broadcasting,IEEE Transactions on,2011,57(2):165-182.