基于全景影像的增强地理现实配准方法研究

2014-08-25陈令羽贾奋励宋国民

陈令羽,贾奋励,宋国民

(信息工程大学 地理空间信息学院,河南 郑州 450000)

基于全景影像的增强地理现实配准方法研究

陈令羽,贾奋励,宋国民

(信息工程大学 地理空间信息学院,河南 郑州 450000)

介绍基于全景序列影像的增强地理现实构造方法,分析地理现实、地理空间数据以及全景序列影像三要素间的关系和研究的趋势。结合柱面投影理论实现地理空间数据到全景序列影像的转换,完成由虚拟空间向真实空间的定位配准,并给出一种用于验证可行性的非平均特征点采样方法,为进一步研究提供理论基础。

增强地理现实;地理空间数据;全景序列影像;定位配准;可行性验证

增强地理现实以增强现实技术为支撑、以地理空间数据为基础,可以将计算机生成的具有地理定位的图形、文字注释等虚拟信息与使用者看到的地理现实有机融合起来,为使用者提供一种全新的感官复合的视觉效果,以扩展人类认知、感知世界的能力。它具有可量算、可交互、全方位等特点,将主体人、现实世界以及由计算机生成的数字世界无缝结合在一起,改变以往人与现实世界、数字世界的交流与交互模式,扩展基于位置的地理空间信息服务模式,为与地理空间关系密切的各行业,如导航、智能交通、指挥训练等提供全新的作业模式。增强地理现实是虚拟现实技术的一个重要分支和延续,为人类的空间认知提供更加优越的工具,将会是GIS发展的最高阶段[1-3]。

全景序列影像是指包括全景视频与具备重叠区域的系列全景图像在内的数字影像(流),其以数字全景图技术为支撑,能够拍摄摄像装置周围 360°的影像(视频),并将其无缝拼合在一起,以某种方式展现出来[4]。全景序列影像在提供全方位视觉信息的同时,能够提供动态的实时信息。作为对真实世界最直观形象的一种表达方式,全景序列影像在虚拟现实系统中得到广泛的应用,Google Earth 已将全景图与虚拟地球捆绑在一起,在全景图的拍摄点提供图像显示与有限的漫游,增强用户体验的真实感。增强地理现实是虚拟地理现实进一步发展的结果,两者间具有一定程度上的相通性,全景序列影像也可以为增强地理现实提供最真实的地理信息数据资源。基于全景影像的增强地理现实系统,可以为人类的空间认知提供更加先进的工具,是一项复杂的技术,涉及多个学科领域的问题,其中空间配准是最基本的要求。

1 基于全景影像增强地理现实系统的空间配准

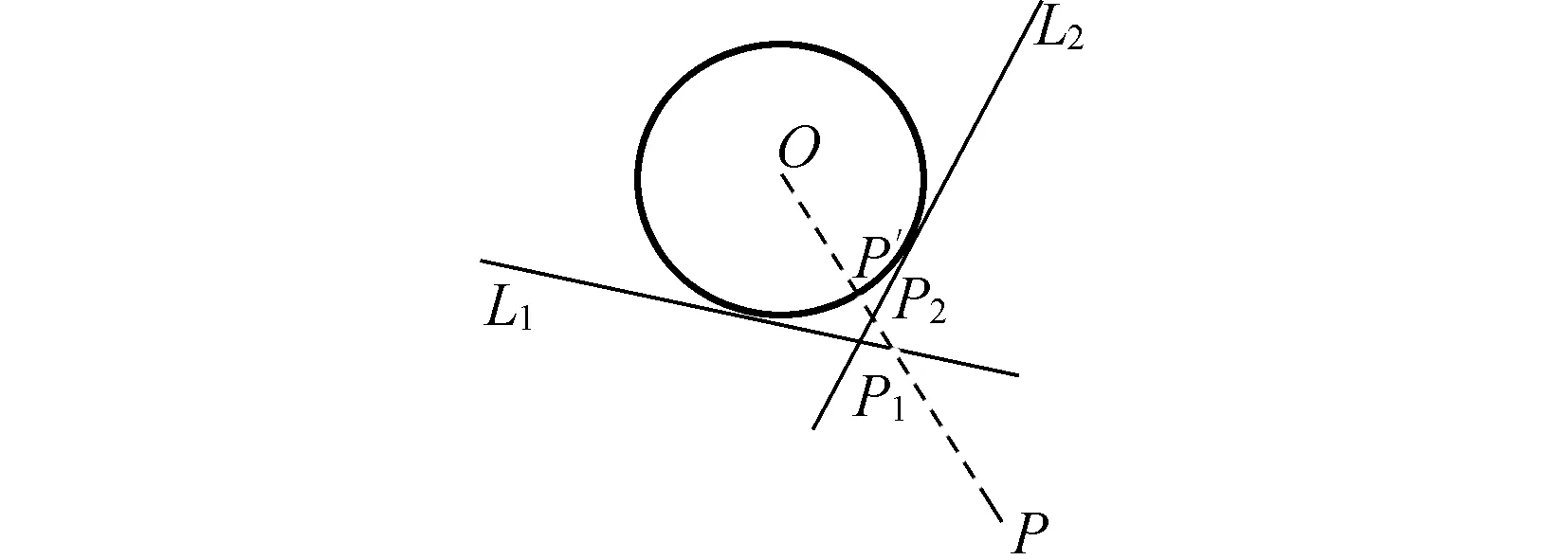

基于全景序列影像的增强地理现实是比较简单的一种增强现实系统,仅靠地理空间数据与摄像装置生成的全景序列影像相匹配,将真实场景与计算机生成的虚拟物体有机合成并显示在终端设备上即可。其中,最核心的3个要素为地理空间数据、地理现实以及全景序列影像,其关系如图1所示。

图1 核心要素间的关系

基于全景序列影像的增强地理现实系统的本质是通过地理现实,实现地理空间数据和全景序列影像的虚实结合。由图1可以看出,地理现实是连接地理空间数据和全景序列影像的唯一纽带。将地理空间转换到全景序列影像上是基于全景序列影像进行增强地理现实的关键技术之一,两者间能够精确配准的前提条件是地理空间数据和全景序列影像都能表达严格意义上的地理现实,特别是有精确的位置坐标转换关系,其中主要包括两个方面的内容:①地理现实和地理空间数据的转换关系。地理空间数据是根据由数学方法确定的数学法则和综合法则记录空间地理现实的载体,是传统测绘学重点研究的内容[5]。关于地理空间数据与地理现实关系的研究,已经形成相当完备的理论基础,可以为实现地理现实和地理空间数据之间的相互转换提供技术支撑;②地理现实和全景序列影像的转换关系。全景序列影像是通过摄像装备对周围大场景进行拍摄拼接后的真实再现,目前的主要研究大多集中在全景序列影像的拼接融合上[6-12],缺乏对地理现实空间到全景序列影像空间对应关系问题的研究,这也是将地理空间转换到全景序列影像上的主要技术瓶颈。

2 地理现实到全景序列影像的坐标转换

地理现实到全景序列影像的坐标转换,就是根据地理现实的空间坐标确定其在全景序列影像中相应像素坐标的过程,是地理现实到全景序列影像地位配准的主要内容,也是增强地理现实系统实现的重要基础。首先需要将地理现实所在的场景坐标根据摄像机的姿态信息转换成摄像机坐标,然后根据摄像机的焦距等将其转换成图像坐标,最后通过相片的分辨率等信息计算出像素坐标,同时需要对结果进行纠正。其中所涉及到的各种摄像机信息,都可以由摄像机的标定来提供,如图2所示。

图2 地理现实到全景序列影像的坐标转换

2.1 摄像机标定

在进行地理空间到平面全景的变换之前,首先需要进行摄像机的标定,确定摄像机的内部参数(焦距、相机畸变参数、相机的中心位置以及缩放比率等)和外部参数(相机的姿态,包括位移向量和旋转矩阵)。通过摄像机的标定,不仅可以确定摄像机的各种参数,同时还可以根据场景中若干已知点和图像中的对应关系,利用外部参数确定运动中摄像机在某一时刻的空间位置,在本文中设计的方法中可以作为GPS信号较弱区域确定摄像机位置的辅助方法。目前,在计算机视觉领域,摄像机可以采用不借助任何标定物的自标定技术,仅凭图像特征点间的对应关系就可以确定出相机的内外参数。但在全景影像摄制过程中,由于多摄像机系统的相机单元具有不同的姿态参数且拍摄出的影像具有较大的变形,因此基于多组照片直接进行标定非常困难。可行的方法是借助于其它设备,如全站仪等获得标记点的空间坐标,采用传统的摄像机标定方法(如RAC两步标定法[13])标定每个摄像机,并进而获取全景摄像机系统的坐标转换参数。

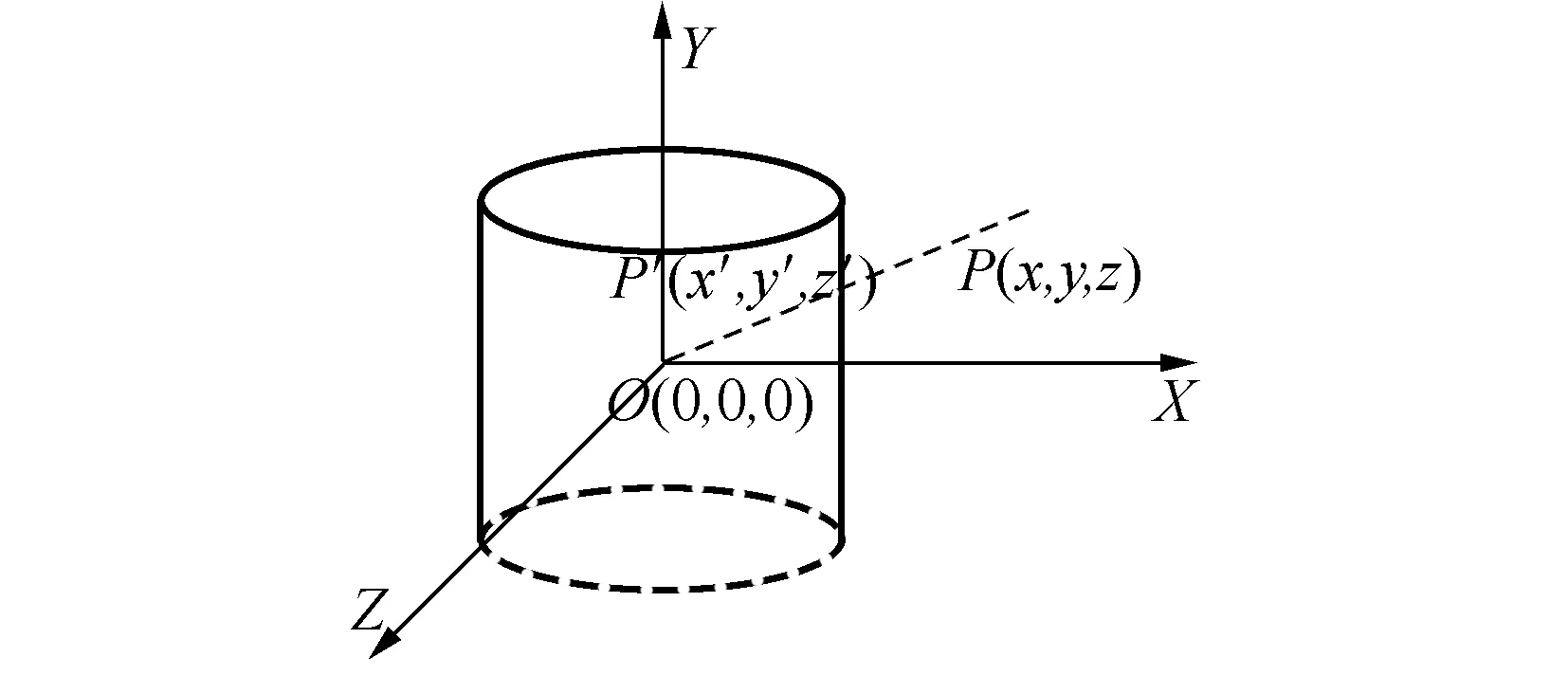

2.2 现实空间到柱面全景的转换关系

常用的全景图主要有柱面全景和球面全景图两种类型。理想状态下,地理现实应该通过360°的摄像机直接转换到柱面或球面空间上,但目前全景图数据主要依靠单个摄像机在同一位置多角度直接拍摄、多个摄像机联合拍摄等方式,然后对形成的影像进行360°拼接生成[14]。一般不同角度上拍摄的单幅照片要求有一定的重合区域,以方便拼接。由于采集的这一组照片是摄像机在不同角度上拍摄的,不在一个投影平面上,相互间存在一定的夹角,直接拼接会造成视觉的不一致性,例如分割在两幅照片上的同一条直线拼接变成折线。为了保持地理现实中物体的空间约束关系,需要将所有投影平面归化到同一坐标系下,构造柱面全景就需要将其投影到柱面上。以图3为例,地理实体P首先被在位置O的相机捕捉在相片L1或L2上,然后通过柱面投影转绘到360°的圆柱面上,变成柱面全景的一部分。但是分析图3可以得到,位置O处的摄像机将地理实体摄录在相片L上,然后投影到柱面上的过程可以近似看成由地理实体直接映射到柱面上,即使地理实体在相邻相片上重复出现,其柱面投影点也是一样的。例如地理实体P在L1,L2上的点P1,P2投影到柱面时都为P′。

图3 地理现实到全景序列的投影关系

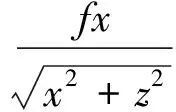

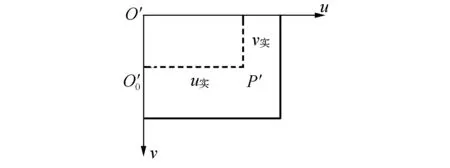

问题的关键转化为将空间点P(X,Y,Z)转化为由柱面展开平面中的点P′(u,v),即根据空间点的场景坐标,计算出其在全景图中像素点的位置(像素坐标),如图4所示。

图4 世界坐标下的投影关系

图4中,点O为摄像机所在位置。为了方便计算,首先需要将大地坐标系下的点P转换到以相机位置O为中心的相机坐标系中。

式中:R为3×3的正交单位矩阵;T为三维平移向量,可以根据点O和P的实际场景坐标确定。

空间点位置表示是在一种直角大地坐标系中,摄像机的位置可以根据其自身携带的GPS定位仪或摄像机标定获取其在同一世界坐标中的位置坐标(X0,Y0,Z0)。摄像机坐标系是以摄像机为中心的三维直角坐标系,其原点就是摄像机的光心,XY平面位于焦平面上,Z轴垂直于XY平面和光轴重合。结合摄像机标定的结果和两种坐标系的定义方式可以得出两个坐标系在3个方向上的旋转角依次为α,β,γ,则有

其中,

r11=cosαcosγ+sinαsinβsinγ,

r12=sinαcosβ,

r13=-cosαsinγ+sinαsinβcosγ,

r21=-sinαcosγ+cosαsinβsinγ,

r22=cosαcosβ,

r23=cosαcosγ+cosαsinβcosγ,

r31=cosβsinγ,

r32=-sinβ,

r33=cosβcosγ.

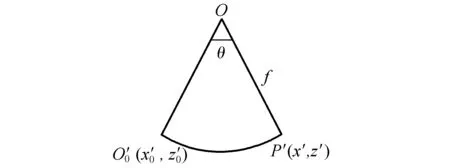

问题转化为在同一摄像机坐标系下空间某一点p求解透过透视投影在全景柱面上P′的位置,如图5所示。

图5 摄像机坐标下的投影关系

在相机坐标系中,全景圆柱面方程为

x′2+z′2=f2.

其中f为相机的焦距。直线OP中P′有

x′=tx,

y′=ty,

z′=tz.

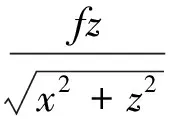

其中H为圆柱面的高度。计算全景像素坐标,为

式中:u′,v′表示相片的分辨率;W,H表示圆柱展开面的宽度和高度,则du和dv为尺度因子,表示两个方向上1个单位距离含有的像素个数。

基于球面全景的转换方式可以由柱面方法类似推导得出。

图6 柱面全景展开示意图

图7 弧形展开示意图

2.3 纠变模型

本文提到的现实空间点转换到全景序列的方法采用的是线性模型,假定现实空间点、像点以及摄像机的光心在同一直线上。但由于摄像机制作工艺以及镜头的畸变等因素,具体成像模型并不是严格的线性关系。为了保证地理空间数据记载的地理现实能够准确映射到全景图上,必须对其进行畸变纠正。

摄像机镜头产生的畸变主要有径向畸变、离心畸变以及薄棱镜畸变等3种。后两种畸变产生的原因主要是因为相机和镜头在装配过程中定位不准造成的,一般不需要进行考虑。径向畸变是由光学镜头径向曲率的变化所引起的变形,使得空间直线投影到平面时有可能会变成曲线,造成图像点的偏移,而且离中心点越远,产生的扭曲变形就越大。因为径向模型为一种几何畸变,可以建立以下纠正模型:

u′=u+k1u(u2+v2)+ρu(u,v),

v′=v+k2v(u2+v2)+ρv(u,v).

式中:k1u(u2+v2)和k2v(u2+v2)表示的是径向畸变;k1和k2指的是径向畸变参数,可以由摄像机标定求得;ρu(u,v)和ρv(u,v)表示设置过程中产生的其它畸变。

根据计算得出的地理现实到像素坐标的转换关系,结合地理空间数据记录的位置信息,将其一一对应,就可以完成地理空间到全景序列影像的定位配准。

3 可行性采样检验分析

全景序列影像是由多幅图像经过投影拼接而成,在处理的过程中可能会经过其他一些处理,改变严格意义上地理现实与图像平面间的对应关系。为了验证某种情况下全景序列影像采用该方法能否用像素坐标合理准确地表示地理现实,客观评价地理实体到全景序列影像坐标转换质量,可以通过非平均分布特征点采样分析的方式进行验证。通过比较特征采样点处计算得出的像素坐标是否与地理现实匹配来进行评价。采样比较的要求主要有两点:①全景序列影像是在某一位置对周围地理现实的360°复制,表达了真实场景中的所有信息,而空间地理数据仅是对最主要的地理现实进行抽象,因此只需要保证全景序列影像中主要地理现实的像素坐标准确,特征部位的采样点应多于非特征部位;②地理现实到全景影像转换误差不可避免,应当允许采样点比较时正确通过具有一定的容差空间,设定正确匹配的误差阈值。根据摄像机工作原理,相同大小的地理现实根据距离远近在影像中表现的尺度不同:距离越近,表示的越详实,占用的像素越多,反之亦然。因此设定的误差阈值也应当有所不同,近处的误差阈值要小于远处的误差阈值,具体差别可根据其像素的表达能力确定。若某一像素所表达的地理现实尺度是另一像素表达地理现实尺度的n倍,则其允许的误差阈值仅是这一像素允许值的1/n,例如某全景影像表达近处地理现实的分辨率是1m,表达远处地理现实的分辨率为10 m,当地理现实映射到全景影像上时,误差1个像素,近处实际仅相差1m,远处实际相差10 m。同时远处地理现实在进行全景图映射时更容易出现偏差,所以在进行地理空间和全景影像配准时,应尽可能选择全景图中定位精度更好、表达内容更详实的主要特征。图8是一个具体的全景图采样点分布选取示例。

图8 全景影像采样点分布示例

图8是车载全景相机在某一点拍摄拼接的全景序列影像,其中办公楼为主要的特征地理现实。为了评价使用上文方法实现地理现实到该全景序列影像定位配准的质量,选取如图8所示5个特征点(根据实际需要选择采样点个数,这里仅为说明方法的可行性),其中A,B,C3点表示主要地理现实的特征部位,是进行增强地理现实定位配准过程中重点关注的采样点,D,E是其他位置的辅助特征点。利用GPS确定5个点的地理位置,计算理论上其在全景影像中的位置,根据各采样点到镜头之间的距离确定允许的误差。计算得出各个点的像素坐标与实际影像中的差异,若在该点上允许的误差范围内,则表示在该点处配准有效,否则匹配不通过[15]。

在实际操作中,样本空间越大,越有助于验证结果的准确性[16]。根据实际精度需求和采样点验证通过的几率来确定采用该方法配准有效。

4 结束语

基于全景序列影像的增强现实系统涉及到全景序列影像采集、数据准备、场景显示和交互等各个过程。地理现实与全景影像的转换关系是实现这些过程的基础,只有通过建立两者间合适的转换模型,实现地理现实与全景序列影像上位置关系的精确配准,才能将各种地理空间数据和信息正确绘制在全景序列影像中,达到增强地理现实的作用。本文提供的地理现实和全景序列的转换关系是在一种比较理想的状态下给出的,假设摄像机在不同角度拍摄的照片在进行全景拼接时不再进行其他处理,能够精准无缝融合在一起。在实际配准过程中,单幅照片可能由于拼接方式的不同需要进行特殊变换,但这并不影响本方法适用的普遍性。

[1]游雄. 战场环境仿真[M]. 北京:解放军出版社,2012.

[2]高俊. 作战空间认知的新手段——“虚拟现实”与测绘保障[J]. 军事测绘,1994,3(4):3-7.

[3]GOODCHILD M F. Augmenting Geographic Reality [J], ESRIIndia, Bangalore[EB/OL]. http:∥www.csiss.org/aboutus/presentations/files/goodchild_boulder_sept02.pdf, 2010-08-20.

[4]P MILGRAM, F KISHINO. A taxonomy of mixed reality visual displays[A]. IEICE Transactions on Information Systems[C], Vol. E77-D, No. 12:1321-1329, 1994.

[5]王家耀,孙群,王光霞,等. 地图学原理与方法[M]. 北京:科学出版社,2006.

[6]姜丽凤. 全景图拼接关键技术的研究[D]. 济南:山东理工大学, 2008.

[7]杨红喆. 基于特征点的全景图生成技术的研究[D]. 南宁:广西大学,2008.

[8]SZELISKI R.Video mosaics for virtual environments[J]. Computer Graphics and Applications. 1996: 22-30.

[9]魏超,刘智,王番,等. 压缩感知理论及其在图像融合中的应用[J]. 测绘工程,2013,22(2):30-33.

[10]S SMITH,J BRADY. A new approach to low-level image process, International Journal of Computer Vision [J], 1997,23,(1):45~78.

[11]龚平. 基于点特征的全景图合成方法研究[D]. 长沙:湖南师范大学,2005.

[12]方贤勇. 图像拼接的改进算法[J]. 计算机辅助设计与图形学学报,2003(11):1362-1365.

[13]R Y TSAI.A versatile camera calibration technique for high-accuracy 3D machine vision metrology using off-the-shelf TV cameras and lenses[J].IEEE Journal of Robotics and Automation, RA-3(4),August 1987:323-344.

[14]张欣. 全景拼接的关键技术研究[D]. 哈尔滨:哈尔滨工业大学,2012.

[15]张万强,赵俊三,唐敏.无人机影像构建三维地形研究[J].测绘工程,2014,23(3):36-41.

[16]娄博,耿则勋,魏小峰,等.利用属性图的遥感数据与GIS数据松驰标号匹配[J].测绘科学,2014,39(7):136-139.

[责任编辑:张德福]

Study of registration method in augment geographical reality based on panorama

CHEN Ling-yu, JIA Fen-li, SONG Guo-min

(Institute of Surveying and Mapping, Information and Engineering University, Zhengzhou 450000, China)

It introduces the construction method of augment geographical reality based on panorama, and analyses the relationship and trend of research among the geographical reality, geospatial data and panorama. According to the theory of cylindrical projection, it provides a transition method from geospatial data to panorama, and realizes the registration from the virtual space to reality space. Then, a non-average sampling method for feasibility verification is given, which can make a theoretical foundation for the further study.

augment geographical reality; geospatial data; panorama; registration; feasibility verification

2013-09-27,2014-08-26补充更新

国家自然科学基金资助项目(41101437;41371382);国家863计划资助项目(2013AA12A202)

陈令羽(1987- ),男,博士研究生.

P208

:A

:1006-7949(2014)10-0004-05