双视角下多特征信息融合的步态识别

2013-11-26李一波李昆

李一波,李昆

(沈阳航空航天大学自动化学院,辽宁沈阳110136)

步态识别是生物特征识别领域一个具有广阔应用前景的研究方向,旨在根据人们走路的姿势进行身份的识别,具有远距离、非侵犯性、易于感知、难于伪装等特点[1].鉴于步态识别的诸多优势及其在智能监控、人机交互等领域的应用前景,广大科研工作者积极投入相关的研究当中[2].近年来,随着对步态识别研究的深入,涌现出许多算法.根据视角数目的不同,步态研究可分为单视角和多视角.单视角研究是指对单个视角下的视频序列进行特征提取和识别.由于单视角下的步态序列存在遮挡、视角局限性等影响因素,所能提供的步态信息有限,因此特征选取至关重要.Kusakunniran等[3]提出了加权二值模式(weighted binary pattern,WBP)的方法;张浩等[4]提出了加权动态时间规整(dynamic time warping,DTW)距离的自动步态识别算法;Bashir等[5]提出了基于光流场的步态特征表示方法.针对单视角研究存在的不足,人们发展出了基于多视角的步态识别方法,对多个视角下的步态序列展开研究.多视角能消除图像中的遮挡影响,提供更多的步态信息,形成不同视角之间的步态信息互补.Kusakunniran等[6]为了解决视角变化对步态识别造成的影响,提出了基于视角转换模型(view transformation model,VTM)的交叉视觉和多视角步态识别算法;赵永伟等[7]提出了基于多特征和多视角信息融合的步态识别方法;刘海涛[8]引入立体视觉的方法,构造了以三维人体轮廓的质心为参考中心的三维人体轮廓描述子(3D body contour descriptor,3D-BCD).

多视角能提供更多的步态信息,但如何有效利用这些信息是一个研究难点.本文尝试从双视角对步态识别开展研究,选取正面视角和侧面视角的步态序列作为研究对象,各自独立地获取特征,利用融合策略进行双视角下的步态识别.

1 双视角步态识别算法

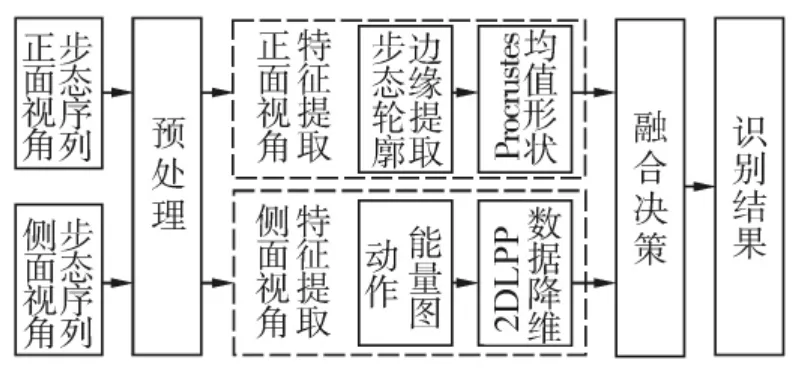

双视角步态识别的整体流程如图1所示.首先对正面视角和侧面视角的步态序列进行预处理,得到单连通人体轮廓图形,然后针对正面视角的人体轮廓特征和侧面视角人体行走的动态特征分别进行Procrustes均值形状和动作能量图(active energy image,AEI)计算,并对动作能量图采用二维局部保留映射(two-dimensional locality preserving projections,2DLPP)进行降维,最后对2个视角的识别结果进行决策融合达到最终识别的目的.

图1 双视角下多特征信息融合的步态识别Fig.1 Flow chart of gait recognition of multiple feature information fusion under dual-view

1.1 预处理

预处理是步态识别中的重要步骤,它的目的在于将人体轮廓从背景中提取出来.在构建背景时采用中值法,选取连续N帧图像像素的中值作为背景图像的像素值,即背景图像b可通过式(1)获取.

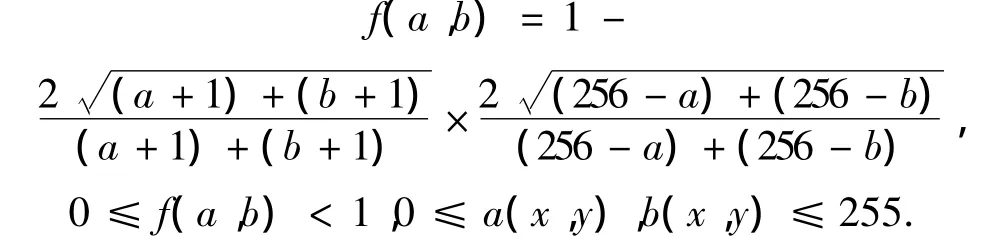

选用文献[9]中的方法进行差分和二值化:

式中:a(x,y)与b(x,y)分别是当前图像和背景图像在像素(x,y)处的灰度值,该函数可根据背景图像的亮度来检测其敏感性变化[9].对二值化处理后得到的运动目标进行形态学处理即可得到单连通人体目标区域,如图2所示.

图2 双视角下单连通人体目标区域Fig.2 The simply connected human target area of two views

1.2 特征提取

由于不同视角下所获取的步态序列所表达的信息不同,因此对正面视角和侧面视角采用不同的特征进行表示.

1.2.1 正面视角

正面视角采用Procrustes均值形状对步态进行表征.Procrustes均值形状分析法是方向统计学中一种特别流行的方法,非常适用于编码二维形状,并提供了一种好的工具来寻找一组形状的均值形状[10].

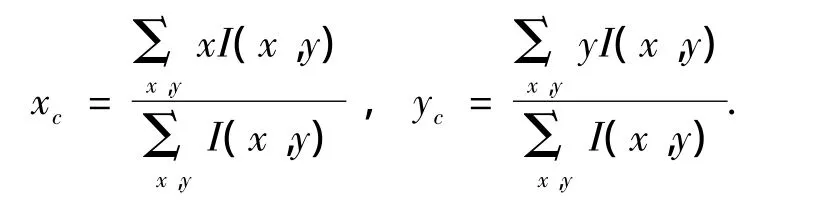

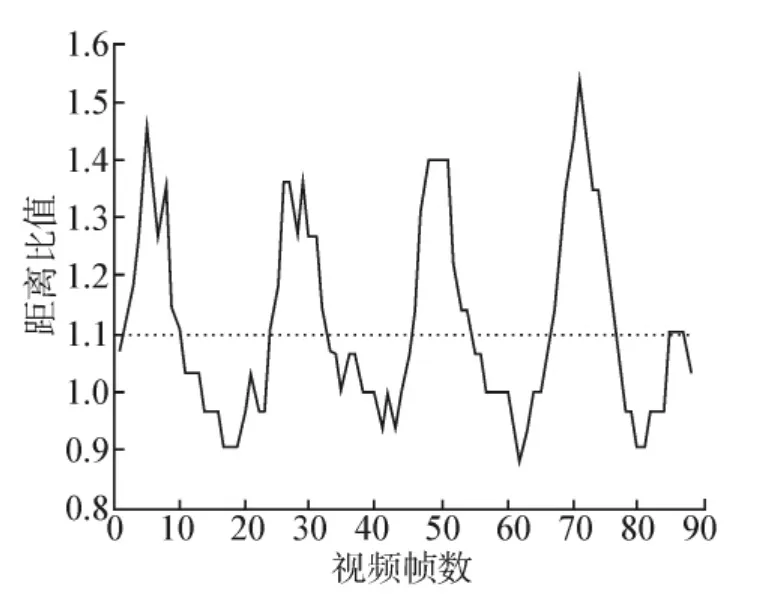

正面视角的步态序列存在着从小到大的变化过程[11],需要进行归一化处理,以步态周期最后一帧人体轮廓的大小作为归一化的标准.此外,从正面观察,人体质心存在周期性的左右偏离,因此采用质心到人体轮廓外接矩形左右两侧的距离比进行周期检测.人体质心计算公式为:

对一段视频序列的周期检测如图3所示,从图中可以看出该步态序列的步态周期在24帧左右.

图3 正面视角步态周期检测Fig.3 Gait cycle detection of the front view

由于Canny算子具有很好的边缘检测性能,不容易受噪声干扰,能够检测到真正的弱边缘,使用2种不同的阈值能分别检测强边缘和弱边缘,并且当弱边缘和强边缘相连时,才将弱边缘包含在输出图像中[12],因此采用Canny算子提取轮廓线.对提取的轮廓线,用等角度间隔采样对选取的2个连续周期的轮廓线进行采样.等角度间隔采样首先需要把轮廓点的直角坐标(x,y)转化成以人体质心为原点的极坐标,然后以相同的角度θ=360/N(N为预定的采样点数)对轮廓点序列进行采样,轮廓线采样如图4(b).

图4 正面视角轮廓线提取及采样Fig.4 The contour extraction and sampling of front view

采样后的轮廓线可描述为k个复数组成的向量,即 Z=[z1z2… zk]T,其中:zi=xi+jyi,(xi,yi)是轮廓线采样后的坐标.一个步态周期含有n帧图像,则可得到n个这样的复数向量,计算配置矩阵,则S的最大特征值对应的特征向量即为所求的Procrustes均值形状,如图 5 所示,图中给出了3个不同目标的 Procrustes均值形状.

图5 正面视角Procrustes均值形状Fig.5 The Procrustes mean shape of front-view

1.2.2 侧面视角

选用动作能量图(AEI)[14]作为侧面视角的步态特征.对于给定的步态序列F={f0,f1,…,fN-1},ft表示第t帧图像,N表示单周期步态序列的帧数,首先计算相邻2帧间的帧差图:

图6 侧面视角动作能量图计算Fig.6 The calculation of side-view active energy image

图7 不同目标的动作能量图Fig.7 Active energy image of different objectives

对得到的AEI采用二维局部保留映射(2DLPP)[15]进行降维.2DLPP 是基于矩阵的子空间学习方法,它能够保留原始图像中的空间结构并且能缓解“维数灾难”问题.

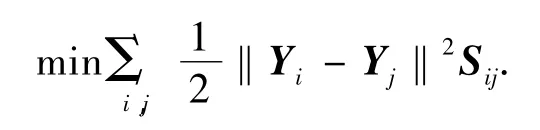

对于给定的一组 AEI图像 Ai(i=1,2,…,N),其大小为m×n,2DLPP的目标函数是

式中:Yi=Aiv,v是n维转移向量;Sij是相似矩阵,其定义为:当Ai是Aj的k近邻或者Aj是Ai的k近邻时,Sij=exp{- ‖Ai- Aj‖2/t};否则 Sij=0,t和 k是2个合适的常量.经过运算,目标函数可以转化为,其中 AT=,L=D-S是一个拉普拉斯矩阵,D是一个对角矩阵表示矩阵的克罗内克乘积,Im是m阶单位矩阵.为了移除嵌入中的任意缩放因子,添加限制条件:

因此最小化问题转化为

运用拉格朗日乘数法,将式(2)转化为g(a,λ)=vTATLAv+λ(1-vTATDAv).那么式(2)的解可通过求∂g/∂v=0得到,因此转换向量v可以通过求解式(3)的特征值问题获得.

让 v1,v2,…,vd表示式(3)的d个最小特征值0≤λ1≤λ2≤…≤λd对应的单一正交解向量.那么转移矩阵v=[v1v2… vd],每一幅AEI图像Ai的投影为 Yi=Aiv,i=1,2,…,N.

1.3 识别算法

首先计算步态特征X对各自训练步态序列c的隶属度,计算公式为

式中:b>1是一个常数,可以控制聚类结果的模糊程度.然后取2个视角下隶属度之和最大的样本作为最终的识别结果,即

2 实验结果与分析

本文使用的是中科院自动化所提供的DatasetB多视角数据库[16]中的正面视角样本和侧面视角样本进行实验.该数据库是一个大规模多视角的步态库,共有124个人,每个人有11个视角(0°,18°,…,180°),在3种行走条件下(普通条件、穿大衣、携带包裹条件)采集得到.

步态人体轮廓序列的提取采用背景减除法.正面视角采用Canny算子对人体轮廓提取轮廓线,大约420个点,并对轮廓线进行等角度间隔采样,得到210个点的固定长度,然后利用2个周期的轮廓采样点计算Procrustes均值形状;侧面视角利用轮廓的宽高比确定步态周期,计算一个完整周期的动作能量图,在利用2DLPP对动作能量图进行降维时,选取前20个最小特征值对应的单一正交解向量作为转换矩阵.

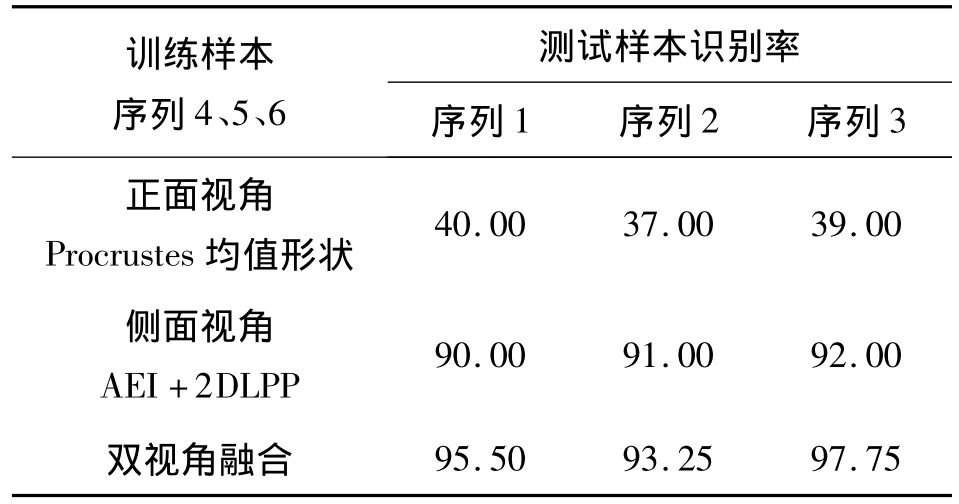

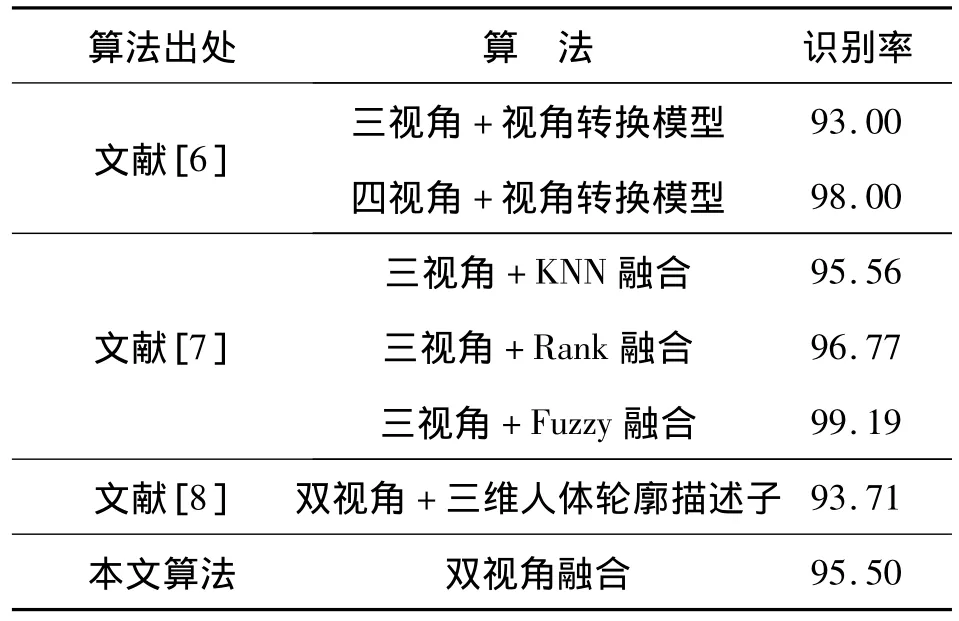

实验选取普通行走条件的样本库对算法进行验证.DatasetB数据库中普通行走条件的样本共有6组,选取正面视角和侧面视角下其中的任意3组作为训练集,用剩下3组作为测试集分别进行测试.训练时,对相应视角提取对应的特征,存入训练样本库中;识别时,先计算正面视角和侧面视角各自测试步态序列的隶属度,取2个视角下隶属度之和最大的样本作为最终识别结果.分别采用数量为40和100的样本进行实验,所获得的平均识别率如表1所示,本文所提方法与其他方法的识别率对比见表2.表2中文献[6]采用了神经网络构造视角转换模型;文献[7]在每个视角下进行了3种特征融合,然后再进行多视角融合;文献[8]采用了立体视觉的研究方法,构建了三维人体轮廓描述子.

表1 本文算法的正确识别率Table 1 The correct recognition of proposed algorithm%

表2 识别结果对比Table 2 Comparison of recognition results %

从表2中可以看出,本文方法的识别率高于文献[8]双视角的识别率,与文献[6-7]的三视角识别率相当,这是因为动作能量图能很好地表征侧面视角的动态特征,而Procrustes均值形状又能够对正面视角的轮廓整体特征进行较好的表示,通过对两者的融合可以提升单视角下对应特征的识别率.同时本文的整个计算过程简单,计算量较小,3个测试序列从特征提取到最终识别的平均运算时间如图8所示.

图8 测试样本平均运算时间Fig.8 The average computation time of test sample

3 结束语

本文提出了一种在双视角下多特征融合的步态识别算法,实验数据证明了正面视角和侧面视角融合识别的有效性,也说明了对于双视角的步态识别,可以通过寻找合适的特征表示,来提高识别的快速性和准确性.另外将多视角的步态识别研究具体化,更贴近实用,并且还提出了正面视角质心到人体轮廓最小外接矩形左右两侧的距离比进行周期检测的方法.在CASIA步态数据库上进行的实验验证了算法的有效性,获得了较高的识别率,并且计算量较小.但是该算法还存在许多需要改进的地方:正面视角的步态轮廓边缘线很容易受到噪声干扰,需要对预处理算法进行优化;2DLPP在求取转换矩阵时需要所有训练样本参与计算,对训练样本数量的变化较为敏感.未来的工作重点在于扩展算法的通用性,使其能适应各种视角的情况,解决在背包、穿大衣等复杂行走条件下的识别问题.

[1]NIXON M S,CARTER J N,NASH J M,et al.Automatic gait recognition[C]//IEEE Colloquium on Motion Analysis and Tracking.London,UK,1999:1-6.

[2]王科俊,侯本博.步态识别综述[J].中国图象图形学报,2007,12(7):1153-1160.WANG Kejun,HOU Benbo.A survey of gait recognition[J].Journal of Image and Graphics,2007,12(7):1153-1160.

[3]KUSAKUNNIRAN W,WU Qiang,LI Hongdong,et al.Automatic gait recognition using weighted binary pattern on video[C]//Proceedings of the 2009 Sixth IEEE International Conference on Advanced Video and Signal Based Surveillance.Genova,Italy,2009:49-54.

[4]张浩,刘志镜.加权DTW距离的自动步态识别[J].中国图象图形学报,2010,15(5):830-836.ZHANG Hao,LIU Zhijing.Automated gait recognition using weighted DTW distance[J].Journal of Image and Graphics,2010,15(5):830-836.

[5]BASHIR K,XIANG Tao,GONG Shaogang.Gait representation using flow fields[C]//The British Machine Vision Conference.London,UK,2009:113.1-113.11.

[6]KUSAKUNNIRAN W,WU Qiang ,ZHANG Jian,et al.Cross-view and multi-view gait recognitions based on view transformation model using multi-layer perceptron[J].Pattern Recognition Letters,2012,33(7):882-889.

[7]赵永伟,张二虎,鲁继文,等.多特征和多视角信息融合的步态识别[J].中国图象图形学报,2009,14(3):388-393.ZHAO Yongwei,ZHANG Erhu,LU Jiwen,et al.Gait recognition via multiple features and views information fusion[J].Journal of Image and Graphics,2009,14(3):388-393.

[8]刘海涛.基于立体视觉的步态识别研究[D].合肥:中国科学技术大学,2010:47-52.LIU Haitao.Gait recognition based on stereo vision[D].Hefei:University of Science and Technology of China,2010:47-52.

[9]王亮,胡卫明,谭铁牛.基于步态的身份识别[J].计算机学报,2003,26(3):353-360.WANG Liang,HU Weiming,TAN Tieniu.Gait based human identification[J].Chinese Journal of Computers,2003,26(3):353-360.

[10]WANG Liang,NING Huazhong,HU Weiming.Gait recognition based on Procrustes shape analysis[C]//Proceedings of the International Conference on Image Processing.Rochester,New York,USA,2002,3:433-436.

[11]高海燕,阮秋琦.正面视角的步态识别[J].智能系统学报,2011,6(2):119-125.GAO Haiyan,RUAN Qiuqi.A gait recognition method based on front-view[J].CAAI Transactions on Intelligent Systems,2011,6(2):119-125.

[12]阮秋琦.数字图像处理[M].北京:电子工业出版社,2007:204-209.

[13]杨静,阮秋琦,李小利.基于频谱分析的Procrustes统计步态识别算法[J].智能系统学报,2011,6(5):432-439.YANG Jing,RUAN Qiuqi,LI Xiaoli.A Procrustes statistical gait recognition algorithm based on spectrum analysis[J].CAAI Transactions on Intelligent Systems,2011,6(5):432-439.

[14]ZHANG Erhu,ZHAO Yongwei,XIONG Wei,et al.Active energy image plus 2DLPP for gait recognition[J].Signal Processing,2010,90(7):2295-2302.

[15]CHEN Sibo,ZHAO Haifeng,KONG Min,et al.2D-LPP:a two-dimensional extension of locality preserving projections[J].Neurocomputing,2007,70(4/5/6):912-921.

[16]WANG Yuan,YU Shiqi,WANG Yunhong,et al.Gait recognition based on fusion of multi-view gait sequences[C]//Proceedings of International Association of Pattern Recognition International Conference on Biometrics.Hong Kong,China,2006:605-611.