基于Fairmot的交通违法行为算法研究

2025-02-15施凯斌李文书

摘 要:在监测交通违法行为的检测任务中,传统的人工监控与基础传感器方法因准确性和实时性存在局限而面临挑战。通过引入多目标跟踪技术,可以显著提升检测效率和系统识别的准确性。文章提出了一种针对车辆信息的多目标跟踪算法,使用MAU-DLA34(MixedAttentionUnit-DeepLayerAggregation34)作为主干网络,替换传统的DLA34主干网络。在处理高密度交通和复杂交互情况下,该算法的表现出色,AP达到73.6%,MOTA为82.9%,IDF1为79.3%,明显优于传统方法和其他深度学习方法,如JDE、DeepSort、CenterTrack等。该算法有效减少了身份切换,确保了对交通参与者的精准且连续跟踪。

关键词:多目标跟踪;目标检测;Fairmot;交通违法行为

中图分类号:TP391.41 文献标志码:A

0 引言(Introduction)

随着城市交通系统的快速发展和机动车保有数量的急剧上升,交通违法行为已成为影响道路安全和交通秩序的重要因素。传统的交通违法行为检测方法依赖人工监控或基础的自动化技术,不仅效率低下,而且难以应对复杂多变的交通环境[1]。多目标跟踪(Multi-ObjectTracking,MOT)[2]技术能够高效地在视频序列中同时监测和分析多个移动目标的轨迹和行为。通过使用准确的多目标跟踪技术,机器能够实时捕捉并分析目标之间的相互作用和运动模式,从而做出更加智能的决策和反应。这不仅显著降低了对人力资源的依赖性,减轻了监控人员的工作负担,而且提高了交通违法行为管理的科学性和系统性,为确保道路交通安全、维护良好的交通秩序做出了重要贡献[3]。

1 研究现状(Researchstatus)

1.1 多目标跟踪

多目标跟踪的主要目标是在视频序列中实时跟踪多个移动对象。在这个过程中,系统需要初始化跟踪对象的位置,然后持续跟踪它们的运动轨迹,并在对象进入或离开视野时更新跟踪状态。当前,基于深度学习的多目标跟踪技术主要分为两种,即基于检测后跟踪(Tracking-by-Detection,TBD)的方法和基于联合检测跟踪(JointDetectionandTracking,JDT)的方法。

(1)基于检测后跟踪的方法

TBD首先使用深度学习模型独立地从每一帧视频中检测出所有感兴趣的对象,其次将这些检测到的对象与已存在的跟踪轨迹进行关联,从而实现对每个对象的持续跟踪[4]。这种方法的关键在于检测的准确性和后续的数据关联策略,而如何有效地将当前帧的检测结果与现有的跟踪轨迹正确匹配,则是该方法面临的主要挑战。

(2)基于联合检测跟踪的方法

与TBD不同,JDT尝试通过一个统一的框架同时处理检测和跟踪任务。这种方法通常依赖于一个单一的深度学习模型,该模型不仅要学习如何识别对象,而且要学习如何跟踪对象在视频中的运动[5]。JDT的主要优势是其内部的信息共享机制,即检测和跟踪共享特征与计算资源,这种机制可以带来更高的运行效率和改进的跟踪性能,特别是在对象被遮挡和相互作用频繁的场景中。

1.2 国内外研究现状

2016年,BEWLEY等[6]基于TBD的框架提出SORT(SimpleOnlineandRealtimeTracking)方法,首先利用独立的目标检测器从视频帧中识别出各个目标,其次通过计算检测得到的边界框与已存在跟踪目标的交并比(IoU)实现数据关联。关联过程采用匈牙利算法优化匹配结果,随后应用线性卡尔曼滤波器对每个跟踪目标的状态进行预测和更新,以实现对目标的持续跟踪。随后,WOJKE 等[7] 对SORT 进行改进,并提出了DeepSORT方法,即使用深度学习生成的外观特征,增强传统的SORT算法。在检测阶段,DeepSORT使用卷积神经网络提取目标的特征;在数据关联阶段,除了使用基于IoU的匹配策略,还引入了一个基于外观特征的匹配策略,允许算法更准确地区分不同的目标,特别是在遮挡和交互频繁的场景中。为了提高检测效率,WANG 等[8]提出JDE(JointDetectionandEmbedding)方法,它通过单一的神经网络同时执行目标检测和外观特征提取任务,以实现对目标的检测和跟踪。这种方法采用端到端的训练策略,不仅能够在每一帧视频中识别出目标,而且能生成每个目标的特征嵌入,用于衡量不同目标之间的相似度。为了降低Anchor-Based基于锚框的方法带来的误差,ZHANG等[9]提出Fairmot方法,该方法使用Anchor-Free无锚框的检测策略和混合式损失函数,使其在处理拥挤场景中的跟踪任务时表现出色,有效地减少了身份切换和遮挡的问题。随着Transformer[10]在视觉领域的不断发展,Transformer也走进了多目标跟踪领域。MEINHARDT 等[11]于2020年提出Trackformer,这是一种结合了Transformer架构的多目标跟踪方法,该方法使用一个端到端的Transformer模型,在视频帧中直接预测目标的边界框和相应的ID,通过跟踪每个目标的嵌入向量来管理跟踪的身份,使用自注意力机制捕获目标之间复杂的相互作用,从而实现精确且鲁棒的多目标跟踪,尤其是在动态变化和目标密集的场景中。

2 改进Fairmot模型(ImprovedFairmotmodel)

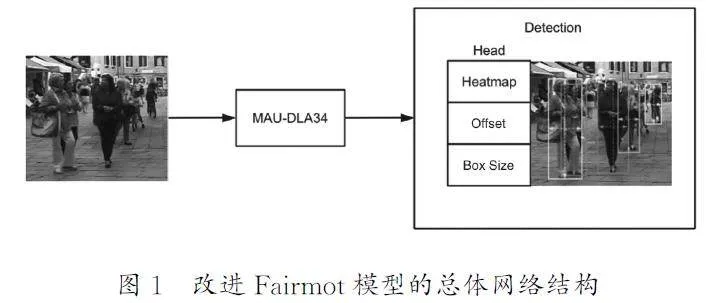

2.1 模型结构

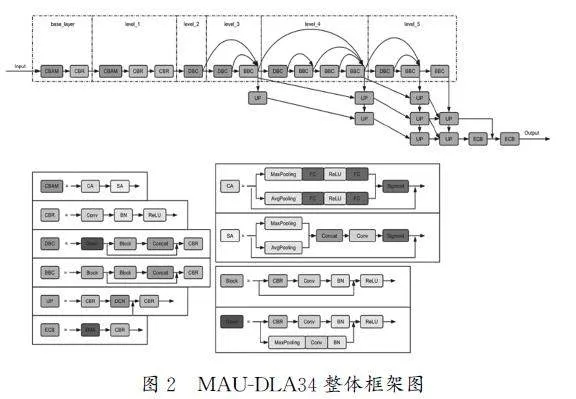

改进Fairmot模型的总体网络结构如图1所示。首先,该模型将图像传入MAU-DLA34主干网络中进行深度特征提取。其次,这些特征被传入模型的最终阶段,该阶段包括3个检测头,它们综合前述特征处理步骤提取的信息,产生最终的目标检测结果。MAU-DLA34模块是在DLA34的基础上进行了网络结构的改良。在执行目标检测任务时,MAU-DLA34网络通过改变其结构的方式以高效地提取目标特征。利用下采样技术从不同层级捕获目标特征,确保每个层级的关键信息被准确提取,同时利用全局池化在层与层之间传递信息,以最大限度地减少特征信息的丢失。

在特征上采样的阶段,MAU-DLA34采用了可变形卷积,而不是传统的2D卷积,这一改进显著扩展了模型的感受野,允许网络更灵活地适应目标形状和尺寸的变化。此外,结合了注意力机制的模块进一步优化了特征提取过程,使得网络能够集中处理对检测任务至关重要的目标特征。

MAU-DLA34网络的最终阶段包括Heatmap、Offset、BoxSize3个检测头。Heatmap使用热图来预估目标中心的位置,Offset用于计算对象中心的偏移程度,BoxSize负责锚定目标边界框的高度与宽度,这种结构使得MAU-DLA34网络在提取复杂图像中的目标信息时,能获得较高的准确性和效率,特别是在处理多尺度和变形目标方面展现出显著的优势。

2.1.1 优化模块流程

MAU-DLA34整体框架图如图2所示,在MAU-DLA34网络结构中,初始阶段包括基础层(base_layer)和第一层(level_1),这两个部分负责对输入图像执行初步的特征提取;此外,在两层结构中添加了CBAM 注意力机制模块,旨在增强网络对输入图像特征的细致捕捉能力。在base_layer中,CBAM 的引入让网络能够从最初的输入中区分出最有信息量的特征,并开始形成关于图像内容的初步理解;在level_1中,CBAM 的引入进一步细化了特征的选择过程,聚焦于增强对已识别初步特征的语义理解。

输入图像的高度为H ,宽度为W ,经过初步提取后,得到的特征图维持与输入图像相同的空间尺寸,即高度和宽度不变,F1可用F1=H ×W 表示。

随后,第一层级(level_1)的输出特征图会被传递到下一层级(level_2)。在这一过程中,特征图会经历一个下采样操作,通常表示为S 操作。下采样的目的是减小特征图的空间维度,同时扩展了特征的感受野,从而能够捕获更广泛的上下文信息。下采样操作后,输出特征图的尺寸变为原来的1/S,如果下采样率S 为2,则特征图的空间尺寸会缩减为原始高度和宽度的一半,即输出特征图F2的尺寸为

F2=H/S ×W/S(1)

从level_2的输出继续向下传递,数据流动进入更深层的级别,即level_3到最终的level_5层。在这个过程中,每一层都会对其输入进行下采样处理,以捕获更加抽象和全局的特征表示。输出特征图Fi的尺寸为

Fi= H/S×2i-2× W/S×2i-2 (2)

到达level_5时,我们采取了一个特别的策略:不同于之前的层级,其中上采样步骤直接将特征图的尺寸还原至最终大小,首先特征图被上采样到原尺寸的S 倍,这里S 等于2,即每个维度的大小变为原先的两倍。上采样后的特征图被输入一个高效的多尺度注意力模块中,输出O1。该模块通过聚焦关键空间区域和多尺度信息,进一步细化和优化特征图,增强网络对特征的语义解析能力。这样的处理能确保特征图捕捉到不同层次的细节。其次将特征图与O1进行融合,这一步骤能使模型整合多层次的内容,进一步丰富特征信息。最后采用另一个高效的多尺度注意力模块进行处理,确保在输出之前,模型能够充分提取和利用图像中的多尺度特征与全局上下文信息。

2.1.2 加入可变形卷积

在MAU-DLA34网络中,采样流程涉及迭代和分层的特征聚合。迭代深度聚合策略负责结合来自不同阶段的特征,而分层深度聚合则整合各个阶段内的基本模块,确保了在语义和空间层面上的特征融合。在随后的上采样步骤中,使用可变形卷积取代传统的2D卷积,这一变化增强了网络上采样后对目标形状变化的适应性,并扩展了感受野。

在DLA结构中,DLAUP模块用于执行网络上采样任务,而IDAUP模块则用于上采样过程中的多层次特征融合。通过上采样和下采样的交替进行,网络最终输出了经过多次调整后的特征图。这些操作优化了网络的特征提取和处理性能,为识别和分析任务提供了细致的特征表示,最后输出的特征图尺寸为

Ff =H/S ×W/S(3)

2.2 损失函数设计

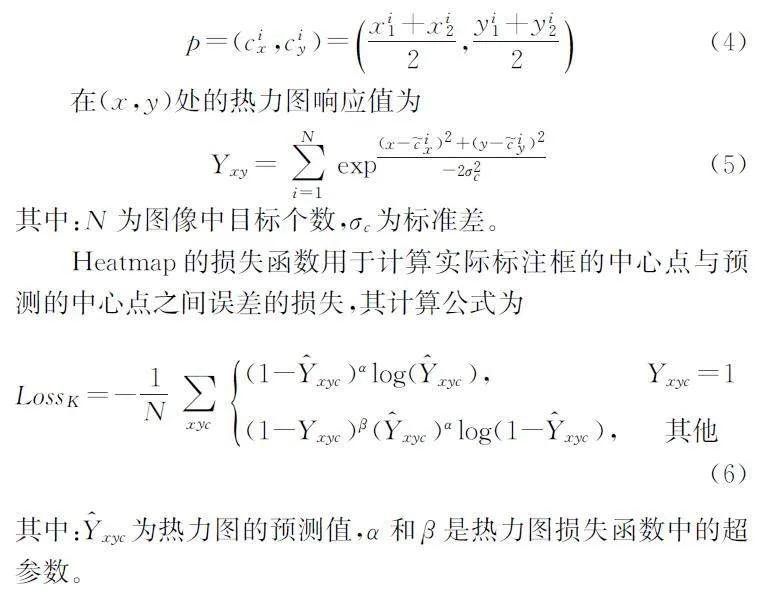

2.2.1 Heatmap

Heatmap分支通常用于确定各类目标中心点的位置。每个标注框的坐标点为bi=(xi1,yi1,xi2,yi2),标注框的中心点位置为

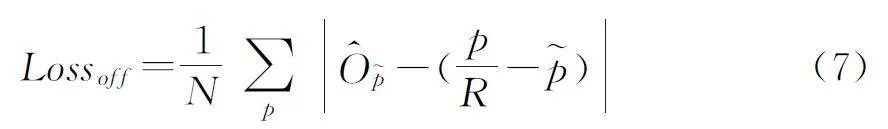

2.2.2 Offset

Offset分支的主要作用是预测来自Heatmap的信息,以增强目标定位的精确性。模型采用L1损失函数度量预测中的中心点偏差,并以此构建损失函数,其计算公式为

其中:检测框中心点的坐标用p 表示,p 是p 下采样后的坐标,预测的Offset值为O^~p ,p/R -~p 表示中心点的误差。

2.2.3BoxSize

BoxSize分支是负责预测关键点检测框的宽度和高度,采用L1函数构建损失函数,其计算公式为

其中:s^pk 为预测的尺寸,对于每个标注框,目标k 坐标为(x1,y1,x2,y2),中心点坐标为pk =((x1+x2)/2,(y1+y2)/2),Sk为目标的真实尺寸,用Sk=(x2-x1,y2-y1)计算。

2.2.4 总损失

综合考虑检测网络的输出,网络的整体性能依赖于Heatmap、Offset、BoxSize3个方面预测的准确度。综合3个方面的性能,研究人员分别为它们定义损失函数:Lossk、Losssize、Lossoff 。通过为这些损失赋予特定的权重并进行求和,可以形成网络的综合总损失,具体如公式(9)所示。采用加权损失的方法,使得模型在训练阶段能够依据各预测任务的重要程度进行均衡考量,确保模型在目标检测的各个方面都能获得优化。

Lossdet=Lossk+λsizeLosssize+λoffLossoff (9)

3 实验设计(Experimentaldesign)

3.1 数据集

UA-DETRAC是一个专为交通监控场景定制的公开数据集,广泛应用于车辆检测与跟踪领域。该数据集收集了在中国北京和天津的24个不同地点通过摄像机拍摄的大量视频素材,全面涵盖了多样化的真实交通环境,包括各种天气状况、交通密度和丰富的车辆类型等,为评估和比较不同的车辆检测与跟踪算法提供了一个具有挑战性和代表性的基准。

该数据集涵盖了多种交通场景,包括高速公路和十字路口,拍摄时间跨越白天和夜晚,并包含晴天、阴天和雨天等不同天气条件。数据集包含超过10小时的视频,总计超过14万帧图像,标注了大约8250辆车辆。每辆车都有详细的标注信息,包括边界框、车辆类型和遮挡情况。此外,数据集还提供了车辆的轨迹信息,非常适合用于评估跟踪算法。

3.2 评价指标

实验使用了3个关键的评估标准:AP平均精度指标、CLEAR指标[12]和ID度量[13],这3个评估标准共同构成了对跟踪算法表现的全方位评价。

实验使用了3个关键的评估标准:AP平均精度指标、CLEAR指标[12]和ID度量[13],这3个评估标准共同构成了对跟踪算法表现的全方位评价。

AP=∫10P(R)d(R) (10)

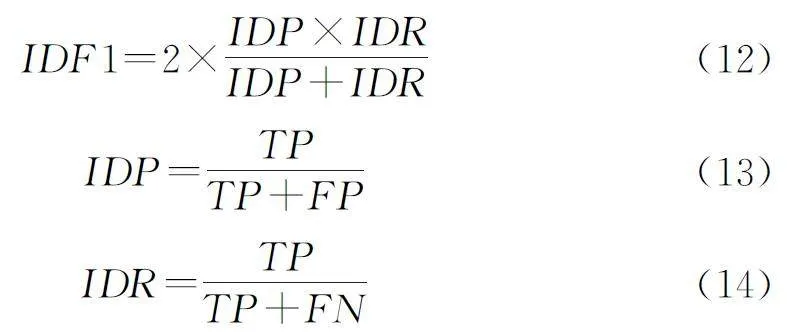

CLEAR指标主要由两个部分组成,即多目标跟踪准确率(MOTA)和多目标跟踪定位精度(MOTP),这两者分别评估了跟踪算法的准确性和目标定位的精确度。MOTA是通过综合考量误报、遗漏以及ID交换次数等多个因素来定义的,旨在全面反映跟踪过程中的总体错误率。MOTA的计算公式如下:

其中:FNt、FPt和IDSt分别代表在时间t 的漏检数量、误检数量和身份交换次数,GTt是时间t的真实目标数量。

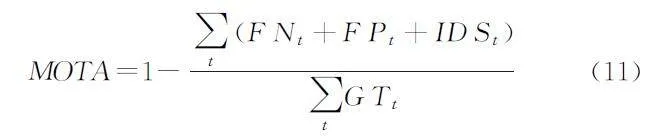

ID度量主要由ID精确度(IDP)、ID召回率(IDR)和IDF1分数(IDF1)3个部分构成,这些指标专注于评价跟踪算法在维持目标身份一致性方面的性能。IDF1由公式(12)表示,IDP由公式(13)表示,IDR由公式(14)表示:

3.3 训练流程

数据集的图像首先经过数据增强处理,包括随机翻转、随机缩放(比例范围为0.5~1.5)以及裁剪操作,随后将图像尺寸统一调整为1088×608。将数据集的80%作为训练集,剩余的20%作为测试集进行实验。在网络训练过程中,使用Adam作为优化算法,设置批处理大小为12,总共进行60个训练周期,其中前30个周期的学习率为1e-4,第31到第60个周期的学习率调整为1e-5。实验选用了UA-DETRAC数据集作为训练基础。

4 实验结果(Experimentalresult)

4.1 对比实验

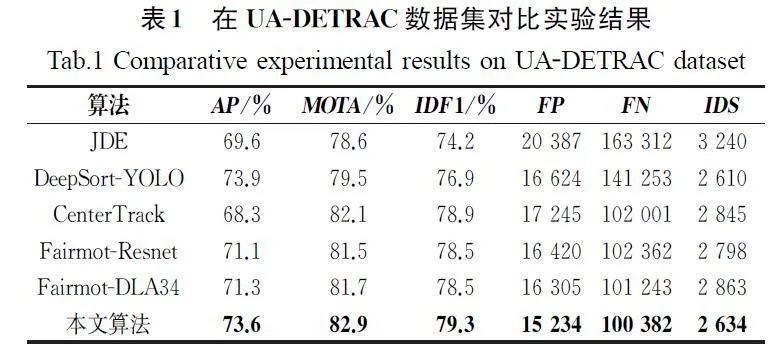

将提出的MAU-DLA34算法与其他经典算法在UADETRAC数据集上进行对比实验,采用评价指标主要有AP、MOTA、IDF1、FP、FN、IDS。在UA-DETRAC 数据集上,MAU-DLA34算法与其他经典算法在以上评价指标上的对比实验结果见表1。

通过将JDE、DeepSort-YOLO、CenterTrack、Fairmot-Resnet、Fairmot-DLA34几种不同的跟踪方法与本文的方法进行比较分析,本文提出的方法在UA-DETRAC数据集上的表现突出。由表1中的数据可知,相较于Fairmot-DLA34版本,本文提出的方法在关键评估指标上取得了较好的结果:AP提升了2.3百分点,MOTA提升了1.2百分点,IDF1提升了0.8百分点,相较于Fairmot-Resnet版本,本文提出的方法AP提升了2.5百分点,MOTA提升了1.4百分点,IDF1提升了0.8百分点。在与CenterTrack进行比较时,尽管两者的MOTA和IDF1相差不大,但是本文提出的方法在AP指标上有显著的提升。相对于DeepSort-YOLO,尽管本文提出的方法在AP指标上略低,但在MOTA和IDF1两个指标上显示出优越性。从总体来看,本文提出的算法有效提升了车辆多目标跟踪任务的准确性。

4.2 消融实验

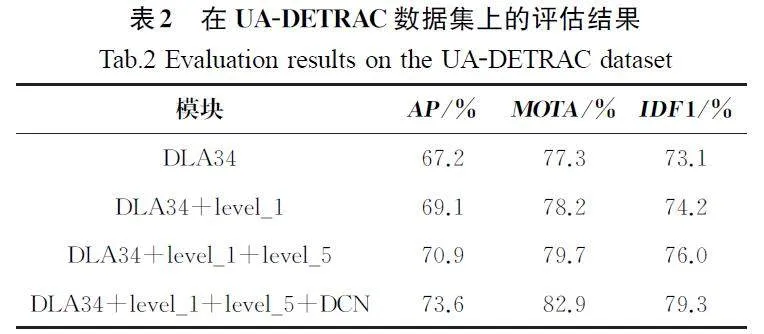

为了深入探究MAU-DLA34模块通过融合DCN(DenselyConnectedNetworks)及其优化后的网络架构对整体模型性能的增强效果,本研究选择UA-DETRAC数据集进行验证,对所提出算法进行消融实验,并通过精度指标AP、MOTA、IDF1具体展示算法性能。在UA-DETRAC数据集上的评估结果见表2。

通过将注意力机制引入DLA34网络的基础层(base_layer)和第一层(level_1),使网络对原始图像特征的提取能力得到了增强,AP从67.2%增加至69.1%,MOTA提升了0.9百分点,IDF1提升了1.1百分点;对第五层(level_5)的网络结构进行调整并引入高效的多尺度注意力模块后,使网络能更有效地关注感兴趣的区域,进一步提升了对关键特征的捕获,AP从69.1%提升至70.9%,MOTA提升了1.5百分点,IDF1提升了1.8百分点;将可变形卷积应用于网络的上采样过程中,提高了模型对遮挡形变目标的特征提取能力,扩大了上采样感受野,AP由70.9%提升至73.6%,MOTA提升了3.2百分点,IDF1提升了3.3百分点。

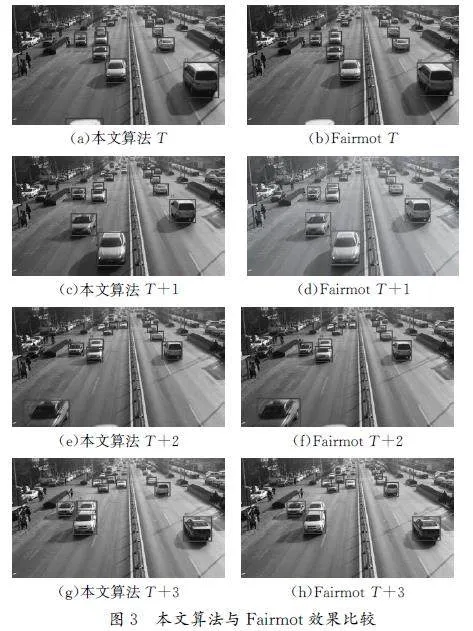

将本文提出的算法与标准Fairmot进行了对比。其中,图3(a)为本文提出的算法在T 时刻的跟踪图像,图3(b)为Fairmot算法在T 时刻的跟踪图像。图3(c)和图3(d)则是T+1时刻时两种算法的对比图像,以此类推。通过对比相同时刻的图片可以看出,本文提出的算法在处理快速移动目标方面具有优势,并且在跟踪的连续性和稳定性方面表现出色。在处理小目标车辆时,本文提出的算法在ID切换数方面表现较好。标准Fairmot在跟踪小目标时,容易因目标外观变化和被遮挡导致ID切换。此外,在车辆被遮挡时,两种算法都出现了ID切换,但本文提出的算法的切换次数明显更少,表明本文提出的算法在处理遮挡问题上更加稳健,能够保持跟踪的连续性。

5 结论(Conclusion)

本文对原有的Fairmot算法进行了深度改进,将骨干网络从DLA34更换为MAU-DLA34。这一改进引入了更加高效的特征提取网络和优化的数据关联机制,显著提高了多目标跟踪的精确度。新算法在处理小目标和快速移动目标方面表现出色,尤其是在复杂的城市交通场景中,确保了高效稳定的目标跟踪性能。但是,该算法仍存在一定的局限性,特别是在应对动态多变、复杂的交通环境,以及不同地区特有的交通状况时,该算法的适应性和泛化能力尚需进一步提升。

参考文献(References)

[1]牛筱涵.交警非现场执法优化研究[D].开封:河南大学,2022

[2]WANGGA,SONG ML,HWANGJN.Recentadvancesinembeddingmethodsformulti-objecttracking:asurvey [J/OL].(2022-05-22)[2024-03-12].https:∥arxiv.org/abs/2205.10766.

[3]陈佳.自动驾驶环境感知中的目标跟踪与轨迹预测研究[D].北京:北京科技大学,2023.

[4]何星华.基于检测的无人机多目标跟踪算法研究及应用[D].成都:电子科技大学,2023.

[5]刘文强,裘杭萍,李航,等.深度在线多目标跟踪算法综述[J].计算机科学与探索,2022,16(12):2718-2733.

[6]BEWLEYA,GEZY,OTTL,etal.Simpleonlineandrealtimetracking[C]∥IEEE.ProceedingsoftheIEEE:2016IEEE International Conference on Image Processing (ICIP).Phoenix:IEEE,2016:3464-3468.

[7]WOJKEN,BEWLEY A,PAULUSD.Simpleonlineandrealtimetracking withadeepassociation metric[C]∥IEEE.ProceedingsoftheIEEE:2017IEEEInternationalConferenceonImageProcessing (ICIP).Beijing:IEEE,2017:3645-3649.

[8]WANGZD,ZHENGL,LIUYX,etal.Towardsreal-timemulti-objecttracking[C]∥Springer.ProceedingsoftheSpringer:European Conference on Computer Vision.Cham:SpringerInternationalPublishing,Virtual:Springer,2020:107-122.

[9]ZHANGYF,WANGCY,WANGXG,etal.FairMOT:onthefairnessofdetectionandre-identificationinmultipleobjecttracking[J].Internationaljournalofcomputervision,2021,129(11):3069-3087.

[10]VASWANI A,SHAZEERN,PARMARN,etal.Attentionisallyouneed[J].Advancesinneuralinformationprocessingsystems,2017,30:5998-6008.

[11]MEINHARDT T,KIRILLOV A,LEAL-TAIXÉL,etal.Trackformer:multi-objecttrackingwithtransformers[C]∥IEEE.ProceedingsoftheIEEE:2022IEEE/CVFConferenceonComputerVisionandPatternRecognition.NewOrleans:IEEE,2022:8844-8854.

[12]BAIHX,CHENGWS,CHUP,etal.Gmot-40:abenchmarkforgenericmultipleobjecttracking[C]∥IEEE.ProceedingsoftheIEEE:2021IEEE/CVFConferenceonComputerVisionand Pattern Recognition.Virtual:IEEE,2021:6719-6728.

[13]RISTANIE,SOLERAF,ZOUR,etal.Performancemeasuresandadatasetformulti-target,multi-cameratracking[C]∥Springer.EuropeanConferenceonComputerVision.Cham:SpringerInternationalPublishing,Amsterdam:Springer,2016:17-35.

作者简介:

施凯斌(1998-),男(汉族),湖州,硕士生。研究领域:计算机视觉,图像处理。

李文书(1975-),男(汉族),杭州,教授,博士。研究领域:计算机视觉,图像处理。