基于DQN 算法的预制构件生产线排产优化问题研究

2024-12-01刘松林

摘要:针对预制构件生产线排产优化问题,提出了一种基于DQN算法的预制构件生产线排产优化方法。本文以最小最大完工时间和最小化能耗为评价指标,建立了预制构件生产车间的数学模型,并运用DQN算法对预制构件生产线排产优化问题进行求解,同时,由于DQN算法在解决本问题时无法给出即时回报,使得算法训练结果过于振荡不稳定,因此设计密集奖励,使最后的探索学习结果趋于稳定。通过与多种算法进行对比试验,证明了该方法适用于预制构件生产线排产优化问题。

关键词:预制构件;生产排产;生产线;DQN算法;目标优化

中图分类号:TP311 文献标识码:A

文章编号:1009-3044(2024)32-0104-03 开放科学(资源服务)标识码(OSID) :

0 引言

在预制构件生产过程中,解决多约束预制构件生产线排产问题是构件生产企业提高核心竞争力的最佳途径[1],由于不同排产方案的生产时间和总能耗不同,因此,找到最优的生产方案能够节约时间和能耗,减少生产成本。预制构件生产优化为NP-hard问题,无法在理想的时间内用精确方法得到全局最优解[2]。而且,当问题约束趋于复杂时,求解一定规模问题的全局最优生产方案会更加困难[3]。目前在对装配式建筑预制构件调度问题优化求解时,解的质量根据使用算法的性能而不同[4]。因此,根据所求问题选择适合的算法,在理想的时间内得到较为满意的可行解在实际过程中尤为重要。

1 模型建立

1.1 问题描述

在模具数量和养护窑数量有限的约束下,预制构件生产车间中,构件的生产过程普遍需要经过六个工序的加工,其中第一阶段是支模工序段,构件在工序段进行模具模台的组合分配,第二个阶段是预制构件的钢筋和混凝土浇筑,第三个阶段是蒸养工序,该阶段进行构件的养护工作,构件在养护窑内进行加工过,不同类型的构件所需养护时间不同,不同时刻进入养护窑的构件养护时间也不同,导致蒸养工序具有复杂的生产特点。第四个阶段是拆模工序段,在该工序对之前模具模台组合分配后的构件进行拆解,最后一个阶段是成品修整和检查。只有当整个模台上布置的所有预制构件该工序操作完成后才能移动到下一个工序,且一个工序有多个加工设备可供选择,每个设备的加工时间和能源消耗可能不同。通过合理安排模台之间的生产排序,优化生产线的性能指标。

1.2 参数设置

1.3 约束条件

公式(1)表示不同序号的模台在不同工序上进行加工,其结束时间等于该模台在该工序开始加工的时间与该模台在该工序所需加工时间的和。

公式(2)表示工件在进入下一道工序加工之前,必须先完成本道工序的加工任务。

公式(3)表示工件只能在一个工序中的一个加工工位上进行加工。

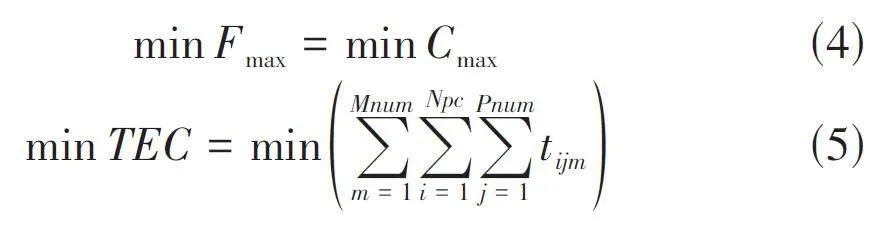

1.4 全局优化目标

预制构件生产线生产排产问题可以描述为:单日生产订单下达要生产的构件数量,然后对构件进行预处理分析构件的类型和尺寸,对构件进行模具模台的组合分配,将同种规则的构件进行放置到同一个模台搭配,然后每个模台依次经过预制构件生产线的所有工序进行加工生产,其中某些工序可以有多个加工机器同时进行生产,但是机器的数量不是无限的,同时在生产过程中每个模台上的构件都要按工序的先后顺序进行加工,每个工序上的时间根据模台上的构件进行运算,通过合理有效地排产获得最小化完工时间和最小化总能耗,使资源合理安排,保证能耗的最小损失。

基于以上的描述,以最小化预制构件完工时间和最小化总能耗为目标建立数学模型,如下所示目标函数:

2 基于DQN算法的预制构件生产线排产优化方法

2.1 状态空间

状态量共有3个:工序Pr,构件已完成加工量Fn,所选择的加工机器Ma。如[(1,2),(2,1),(6,1) ]为预制构件的位置信息矩阵,该矩阵表明在工序1机器2、工序2 机器1和工序6机器1处有预制构件在进行加工。如[ Pr,Fn,Ma ]为预制构件的完工量信息矩阵,在某时刻t的状态矩阵St如[1,0,1],0表示完成加工,1表示正在进行加工。

2.2 动作空间

通过上面针对预制构件生产线的数学建模所描述的情况,本算法的动作定义为下一个预制构件分配到哪个工序的哪个机器上加工,表2为预制构件生产线排产系统的动作空间。

2.3 回报函数

本文针对预制构件生产线的排产优化问题,旨在优化目标,实现最小化完工时间和机器负载。为了有效地设计奖励函数,我们依据了优化目标的设定。在我们的假设中,工件的各工序单位加工量都是相同的。因此,随着机器加工时间的增加,机器负载也相应增加。为了准确衡量机器的总负载量,我们采用了机器有效加工时间作为指标来表示:

在DQN算法的学习过程中[5],状态对应着动作空间中的可选操作,然而,并非每个状态下的动作都是合法的。举例来说,当状态处于已经在某一个工序上的其中一个机器进行加工时,状态不允许继续选择在该机器上进行加工,因为该工序上的这个机器正在被使用。如果算法在学习时仍然选择错误的机器进行加工,则这被视为非法操作,获得负反馈。通过学习避免相同的情况再次发生,因此奖励函数可依据如公式(7)所示。

2.4 算法设计流程

本节将采用ε 贪婪探索策略结合设计瞬时奖励的DQN算法来解决本文的预制构件生产线排产优化问题,具体设计流程如下:

步骤1:创建DQN网络,预制构件生产线排产优化模型的状态矩阵作为DQN网络的输入,输入状态矩阵后可以输出这个状态下所有动作的Q值;

步骤2:创建ε - greedy 策略得到最优动作和随机动作;

步骤3:建立数据集;

步骤4:从经验池中取出随机数据来用于训练神经网络;

步骤5:配置网络训练相关参数将Q现实网络参数复制给Q目标网络;

步骤6:分创建目标网络和评估网络;

步骤7:计算Q值。网络输入状态,输出动作的Q值;

步骤8:定义动作接口,对应的是经验池中的动作;

步骤9:定义损失函数计算方法,并设计随机梯度方法降低损失函数。

3 仿真实验

3.1 构造仿真数据

通过企业调研获取实际案例数据,基于本团队在预制构件生产企业实施MES项目迭代应用过程,对生产线中各类生产数据抽取,以及对生产管理人员的生产运作经验,并对构件生产相关数据进行加工整理,得到如表3所示构件生产数据信息,同类构件不再重复列出。根据生产工厂实际情况,依照一条生产流水线班组配置的资源可知,养护窑容量最多允许同时放置6个模台。

3.2 仿真结果分析

1) 评价指标分析

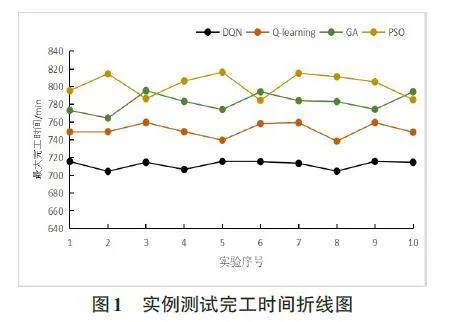

为验证基于DQN算法的预制构件生产线排产优化方法在解决具有多种复杂约束排产问题的有效性,通过与以前学者们采用的粒子群优化算法[6](ParticleSwarm Optimization,PSO)、遗传算法[7] (Genetic Algo⁃rithm,GA)和Q学习算法[8](Q-learning)在解决预制构件生产线排产优化问题中的性能进行对比。从表4可以看出,采用DQN算法其主要评价指标最小化最大完工时间F max为715,加工能耗TEC 为23 673,相比于采用PSO、GA和Q-learning算法对于解决预制构件生产线排产问题具有较好的效果,说明基于DQN算法应用在求解预制构件生产线排产优化问题时能取得更好的优化效果。

图1和图2分别为4种算法分别运行10次所得的完工时间和生产线总能耗图,从图可以看出,应用PSO算法和GA算法进行仿真实验得到结果曲线波动较大,算法的稳定性较差。应用Q-learning算法虽然较前两种算法在优化效果和所得结果稳定性上有所提高,但是相对于DQN算法在加工工时的优化上效果较差,应用DQN算法在进行仿真训练后获得的评价指标最小最大完工时间的平均值为712,是4种算法中平均值最小的,同时应用DQN算法相比于其他三种算法不仅优化效果更好,且其排产结果的稳定性也是4 种算法中最好的。

4 结论

本文描述了预制构件生产车间具有约束复杂、工艺流程和设备选用灵活的特点,以最小化完工时间和最小化能耗为优化目标对预制构件生产车间排产问题进行了数学建模,提出了基于DQN算法求解预制构件生产线排产优化问题,详细介绍了DQN算法的具体实现,最后再通过实例进行仿真实验与其他算法的测试结果进行了对比,得出了DQN算法在处理预制构件生产线排产优化问题上可以优化最小化最大完工时间,并且能够减少能源损耗,验证了本章提出的DQN算法在处理预制构件生产线排产优化问题上的有效性和优越性。

参考文献:

[1] 李大洲.装配式建筑构件生产过程质量控制措施[J].江苏建材,2023(6):3-4.

[2] 陈继文,张译匀,高晓明,等.基于改进遗传算法的PC构件生产调度优化[J].机械设计与制造工程,2024,53(1):95-99.

[3] 刘福磊,邓晓平,于海洋,等.多资源约束下的预制构件生产调度优化与资源再配置[J].软件,2024,45(3):22-29,73.

[4] 董全德,李泓锋.混凝土预制构件多产线生产养护时间优化[J].住宅与房地产,2023(2):54-57.

[5] 史殿习,彭滢璇,杨焕焕,等.基于DQN的多智能体深度强化学习运动规划方法[J].计算机科学,2024,51(2):268-277.

[6] DAI Z,LIU X,ZHANG L,et al.Enhancing SRTM DEM correc⁃tion accuracy with a PSO-RF method utilizing ICESat-2/ATLAS data[J].Academic Journal of Engineering and Technol⁃ogy Science,2023,6(11).

[7] CAO J E,CAO P L,WEN C D,et al.Multi-objective niching quantum genetic algorithm-based optimization method for pneumatic hammer structure[J].Expert Systems with Applica⁃tions,2024,238:122047.

[8] MOMENIKORBEKANDI A,ABBOD M.Intelligent scheduling based on reinforcement learning approaches:applying advanced Q-learning and state-action-reward-state-action reinforce⁃ment learning models for the optimisation of job shop schedul⁃ing problems[J].Electronics,2023,12(23):4752.

【通联编辑:梁书】

基金项目: 辽宁省重点研发计划项目(2020JH2/10100039);辽宁省教育厅高等学校基本科研项目重点项目(LJKZ0583);辽宁省科技厅应用基础研究计划(20221300253)