基于农业大数据和深度学习的稻田杂草识别

2024-11-07高发瑞古华宁张巧玲王秋云黄信诚李烜堃管宪鲁高国良

摘要:为在稻田中准确高效识别杂草,从而支持选择性喷药或机器人除草,基于农业大数据技术和深度学习技术提出改进的YOLO v8杂草检测模型,即采用CBAM(convolution block attention module)注意力机制来增强YOLO v8网络对复杂环境中杂草特征的提取能力,同时使用EIOU(expected intersection over union)+DFL(distribution focal loss)提高YOLO v8检测框的回归效率,并通过模型对比试验验证了改进YOLO v8模型的有效性。结果表明,改进YOLO v8模型在测试集上的均值平均精度(mean average precision,mAP)达到98.2%,相比YOLO v8提高了4.4百分点,且在参数量和计算量方面仅有微小增加。相比YOLO v3、YOLO v4、YOLO v5、YOLOX、YOLO v7,其mAP分别提高24.8、21.9、14.8、21.3、8百分点。在模拟不同光照条件的测试中,改进YOLO v8模型表现出较强的泛化能力,精度(precision,P)、召回率(recall,R)和mAP保持在88.1%以上。此外,在测试环境复杂的条件下,改进YOLO v8模型对6种杂草的识别显示出卓越的鲁棒性和泛化能力,P达到94.2%以上,R达到95.7%以上,AP均达到95.2%以上。综上,本研究提出的改进YOLO v8具有更少的参数和计算量,同时克服了现有稻田中杂草识别方法的局限性,可为稻田中的杂草控制工作提供技术支持。

关键词:稻田;杂草识别;农业大数据;深度学习;YOLO v8模型;鲁棒性;泛化能力

中图分类号:TP391.41;S126 文献标志码:A

文章编号:1002-1302(2024)18-0215-07

收稿日期:2024-05-28

基金项目:山东省水稻产业技术体系济宁综合试验站建设项目(编号:SDAIT-17-11);山东省科技特派员创新创业及科技服务乡村振兴典型案例项目(编号:2022DXAL0117);国家重点研发计划(编号:2022YFD2001501)。

作者简介:高发瑞(1982—),男,山东济宁人,硕士,高级农艺师,主要从事水稻栽培育种、农业大数据研究。E-mail:gaofarui@163.com。

通信作者:管宪鲁,博士研究生,主要从事农业信息化及智能化研究,E-mail:guanxl@stu.scau.edu.cn;高国良,硕士,高级农艺师,主要从事水稻栽培育种研究,E-mail:haishuig@163.com。

水稻生产受杂草竞争生长的严重影响,其产量和品质大幅下降[1-2]。传统的除草方法采用人工大面积喷施除草剂,然而这种方式劳动强度大、危险性高[3]。为了提高效率,农业领域逐渐引入了无人机和农机进行喷施农药,但同时也带来了环境污染和食品安全的问题[4]。随着精准农业和绿色农业理念的兴起,研究者们积极探索准确高效的杂草识别方法,以应对环境污染和食品安全问题[5-8]。

传统的基于图像处理的识别方法虽然在一定程度上有效,但在复杂多变的自然环境下存在着诸多问题,如光照条件影响、计算量大和检测速度慢等[9-13]。近年来,卷积神经网络(convolutional neural networks,CNN)等模型在杂草识别领域有很多应用。这些模型能够自动提取图像高级特征,对光照、角度等变化具有强鲁棒性,从而提高了识别的准确性和稳定性。已有多种基于深度学习的杂草识别模型被提出,例如Yu等的CNN模型[14]、Babu等改进的深度残差网络[15]、张乐等提出的Faster R-CNN模型等[16-17]。在稻田杂草识别方面,邓向武等采用多特征融合和深度置信网络[18],李彧等使用U-Net模型实现了高准确度识别[19],Peng等通过改进RetinaNet,提高了模型的鲁棒性和检测速度[20]。

基于图像自动识别水稻田中杂草种类的方法非常有必要,而且图像作为农业大数据的重要部分[21]可以用来进行数据挖掘与分析,从而用于指导农业生产。在大量田间杂草图像数据的支撑下,基于深度学习技术对稻田杂草数据进行特征提取和模型训练对于精准除草具有重要意义。然而,水面反射、土壤背景、不同的生长和光照变化使得这种方法的开发具有挑战性[22]。此外,为了实际应用,还需要考虑模型的计算成本和识别速率。因此,本研究的目的是开发一种轻量级的稻田杂草种类识别模型。为此,本试验的具体目标为收集水稻田中6种主要杂草的数据,建立杂草数据集;通过改进YOLO v8模型,提出一种轻量级的杂草识别模型,并测试该模型的鲁棒性。

1 材料与方法

1.1 数据集构建与预处理

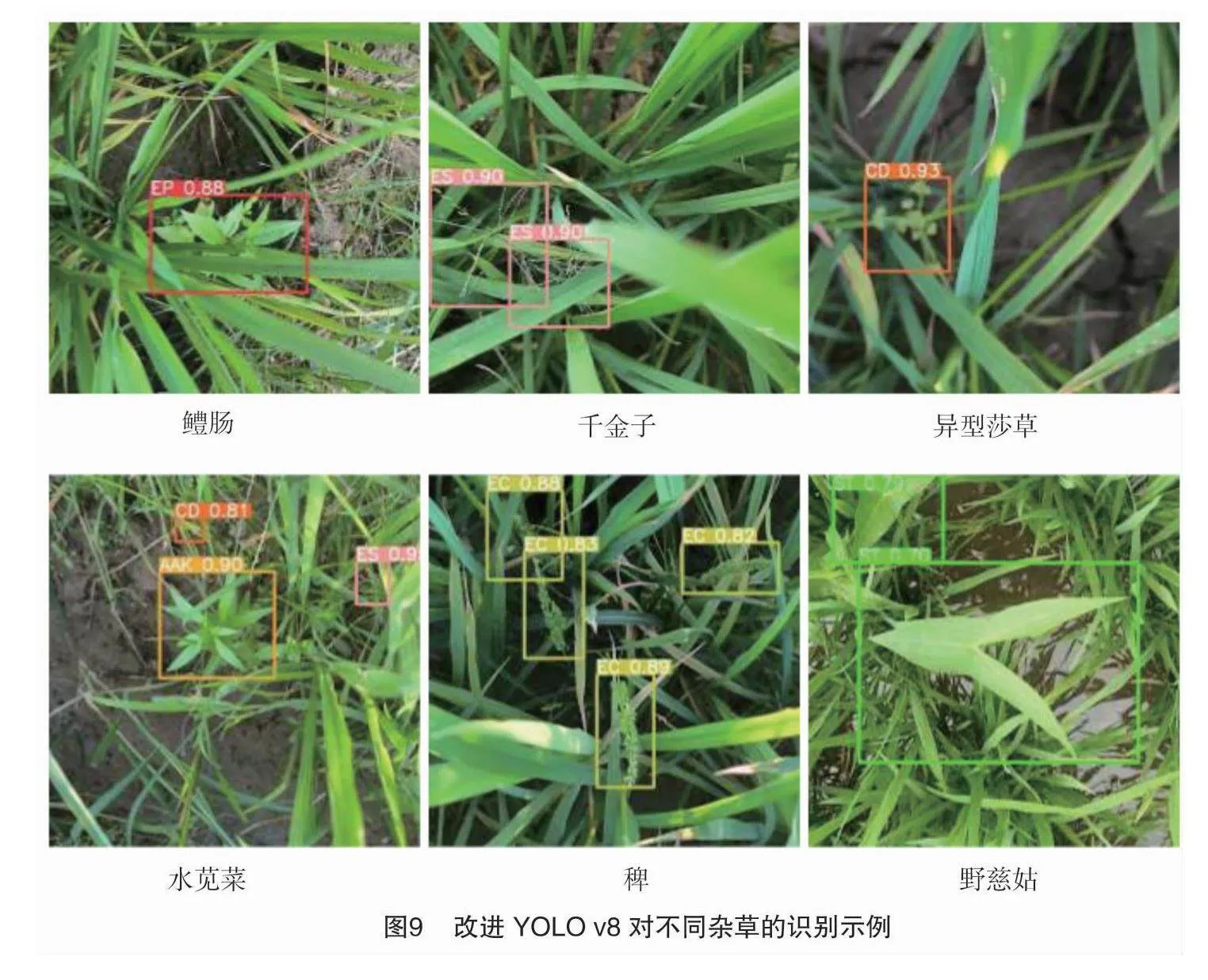

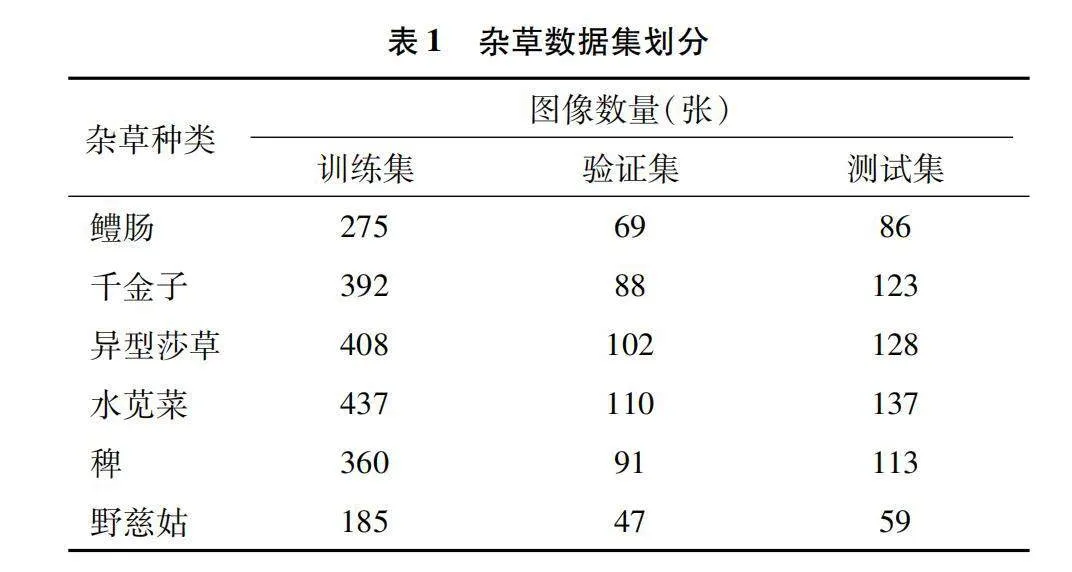

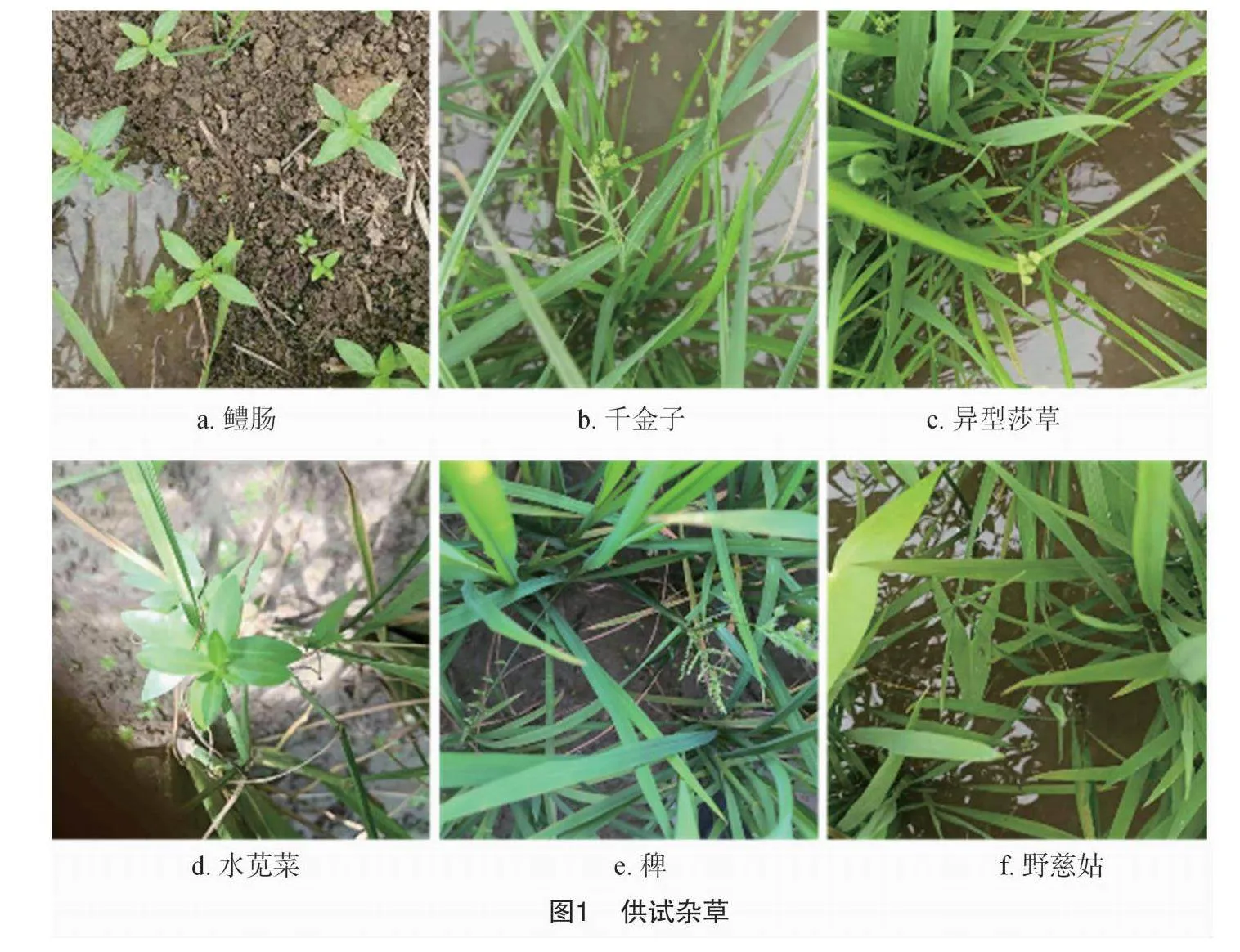

杂草图像是于2022年6—10月在山东省济宁市农业科学研究院水稻试验田中,使用苹果iPhone 11智能手机拍摄的。选取水稻田中的鳢肠(Eclipta prostrata)、千金子(Leptochloa chinensis)、异型莎草(Cyperus difformis)、水苋菜(Ammannia baccifera)、稗(Echinochloa crusgalli)和野慈姑(Sagittaria trifolia)作为研究对象,采集图像并构建了包括3 210张杂草图像的数据集。随后本研究在农艺专家的指导下将数据中的图像划分为相应的杂草类别。图像被裁剪为640像素×640像素(图1),训练集、验证集和测试集的划分如表1所示。

1.2 改进的YOLO v8模型

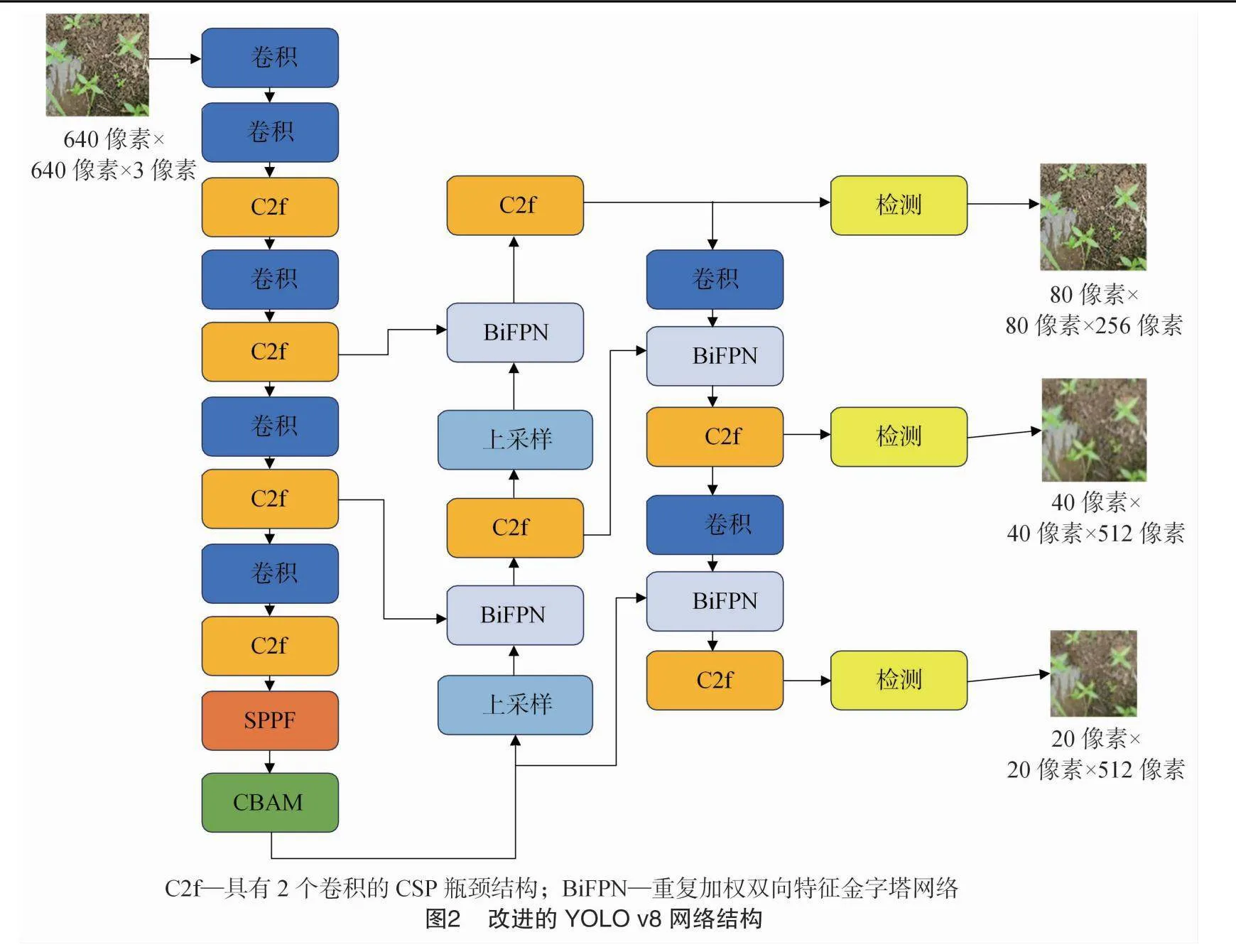

本研究提出了一种改进的YOLO v8检测模型,用于复杂环境中识别水稻田中的杂草。YOLO v8是目前主流的目标检测模型之一,采用基于无锚的检测方法,这意味着它直接预测目标的中心点和宽高比,而不是预测框的位置和大小。这种方法可以减少预测框的数量,并提高检测速度和准确性。其原理可分为两部分:特征提取和目标检测。然而,在实际检测中,在处理图像对象密集、目标之间相互遮挡、对象多尺度检测等问题方面仍存在一些不足[23]。为了解决这些问题,本研究基于YOLO v8进行了一系列改进,如引入CBAM(convolution block attention module)注意力机制、改进损失函数等方法。改进YOLO v8模型的基本架构如图2所示。

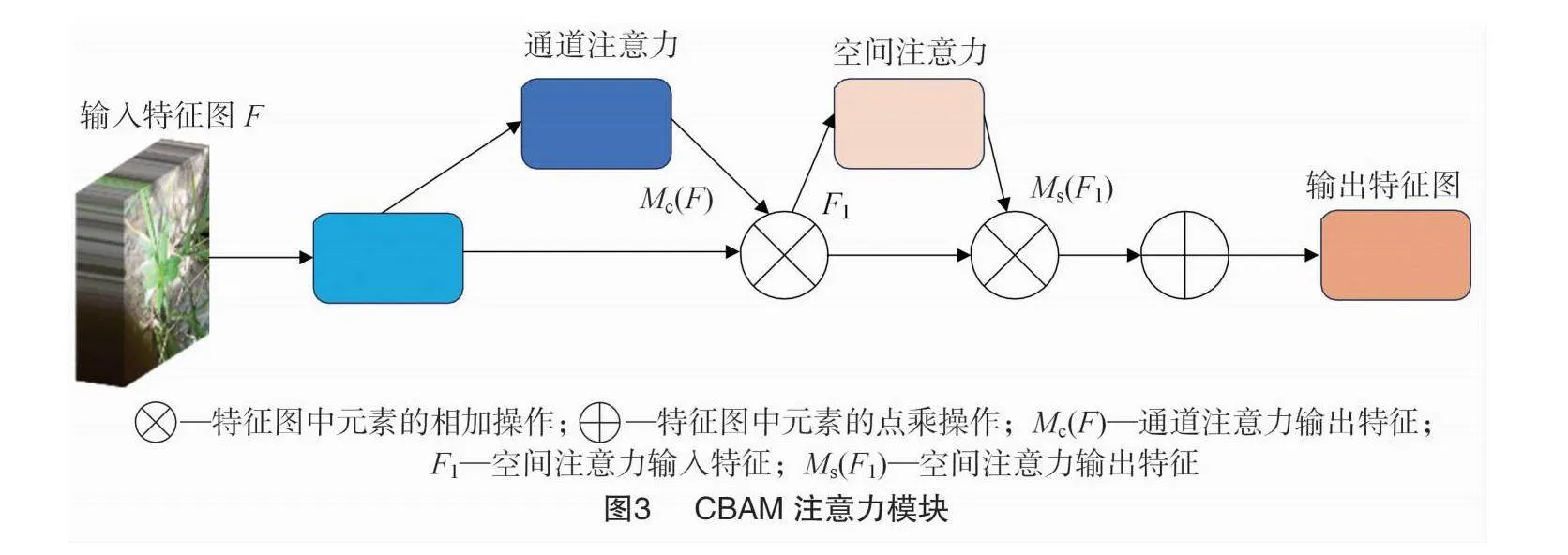

1.3 CBAM注意力机制

在计算机视觉中,增加的注意力机制使图像或特征图的不同部分能够以不同的方式加权。这允许网络在另一个程度上关注特征图的不同区域,从而使网络能够更好地关注感兴趣的目标区域。注意力机制可以增强图像信息提取,提高对检测目标的聚焦。CBAM注意力机制由通道和空间注意力机制组成,其结构如图3所示。给定1个输入特征图,该模块首先沿通道和空间2个维度依次推断注意力权重。接着,将它们与输入特征图相乘,以进行自适应特征修改[24]。在本研究中,CBAM注意力机制被嵌入到SPPF(spatial pyramid pooling fast)模块,进一步增强YOLO v8主干的特征提取能力。

1.4 改进的预测框回归损失函数

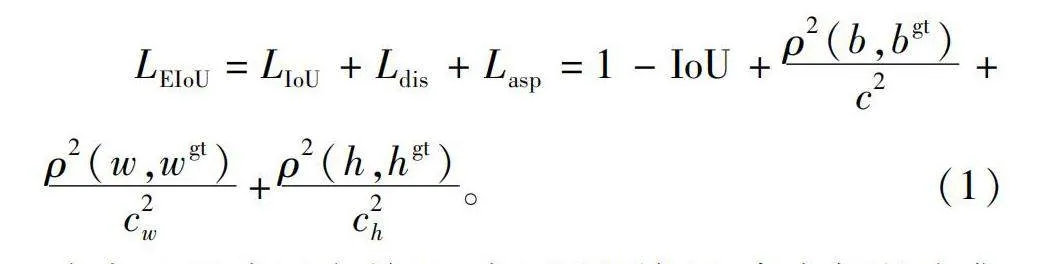

YOLO v8原始的预测框回归损失为CIoU(complete intersection over union)+DFL(distribution focal loss)[25]。如图4所示,CIoU和EIoU(expected intersection over union)在不同的迭代时期所展现出的效果存在明显差异。CIoU预测框的尺度无法快速跟随目标自适应变化,而EIoU的预测框可以快速向真实框拟合。因此,本研究将YOLO v8的损失函数由CIoU改进为EIoU。EIoU的计算过程由3部分组成:IoU损失(LIoU)、中心距离损失(Ldis)和纵横比损失(Lasp)。EIoU损失(LEIoU)可由公式(1)表示:

LEIoU=LIoU+Ldis+Lasp=1-IoU+ρ2(b,bgt)c2+ρ2(w,wgt)c2w+ρ2(h,hgt)c2h。(1)

式中:IoU表示交并比,表示预测框和真实框的交集和并集的比值;ρ为预测框与真实框之间的欧氏距离;b、w、h分别为预测框的中心点、宽度、高度;bgt、wgt、hgt分别为真实框的中心点、宽度、高度;c、cw、ch分别为包含预测框与真实框的最小边界矩形框的对角线长度、宽度、高度。

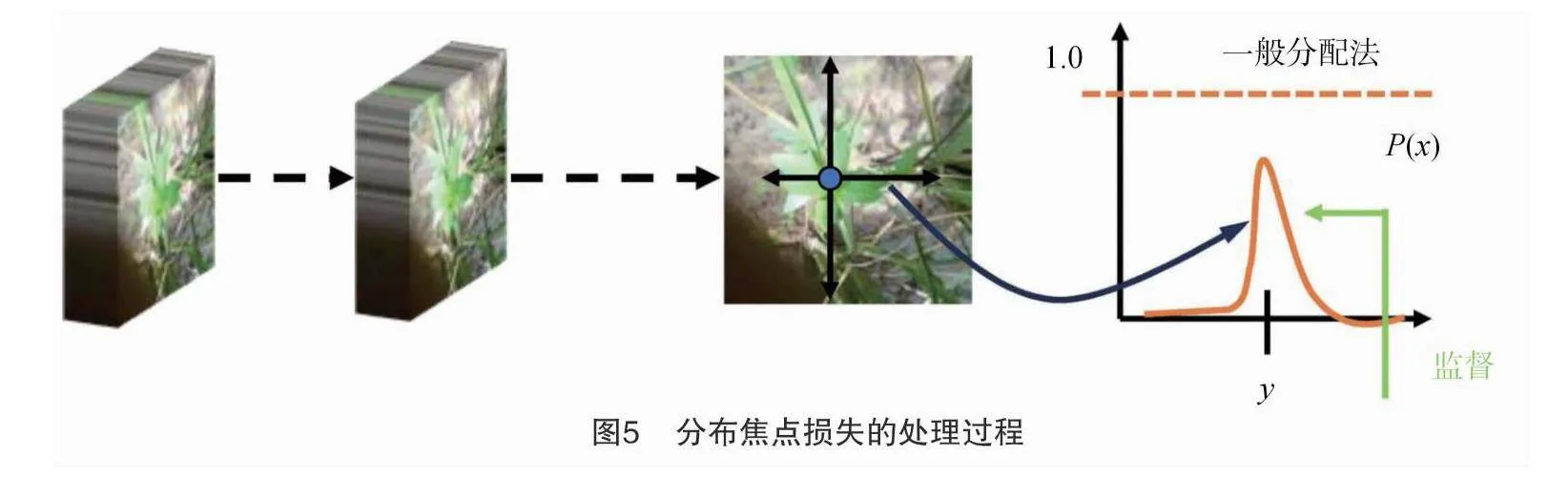

分布焦点损失(distribution focal loss,DFL)的原理在于它同时考虑了分类难度和图像中对象实例的空间分布,建立在焦点损失的基础上,可以通过降低分类良好的例子的损失贡献来解决类别失衡问题。如图5所示,分布焦点损失通过将空间信息(如对象密度图或区域建议)纳入损失计算中。这样,分布焦点损失引导模型能够让网络更快地聚焦于目标y附近的值,以交叉熵的形式去优化目标y最接近的左右2个位置的概率。总的来说,分布焦点损失能够有效地利用空间上下文,增强对象检测模型的稳健性和性能。

1.5 试验环境及模型评估

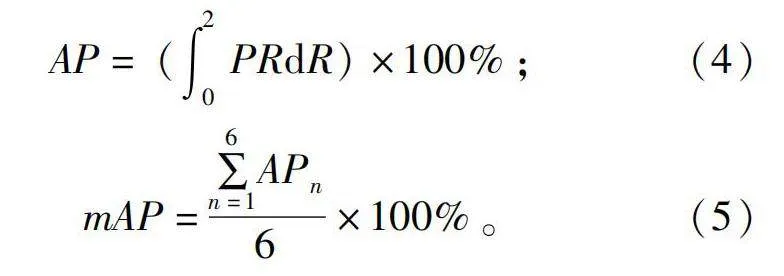

试验所用计算机的GPU型号为NVIDIA RTX3060,并利用CUDA 10.2加快模型收敛速度。模型训练参数设置如下:初始学习率为0.01,批量大小设置为6,训练周期为50个迭代。使用保留的测试集评估改进的YOLO v8模型的杂草识别准确率,同时考虑模型的计算复杂性来评估其性能。模型的评价指标主要如下:精度(precision,P)、召回率(recall,R)、平均精度(average precision,AP)、平均精度均值(mean average precision,mAP)、参数量以及每秒浮点操作数(FLOPs)。这些指标的定义如公式(2)、公式(3)、公式(4)和公式(5)所示。

P=TPTP+FP×100%;(2)

R=TPTP+FN×100%;(3)

AP=(∫20PRdR)×100%;(4)

mAP=∑6n=1APn6×100%。(5)

式中:TP、FP和FN分别表示真正例、假正例和假负例;n表示第n种杂草。

2 结果与分析

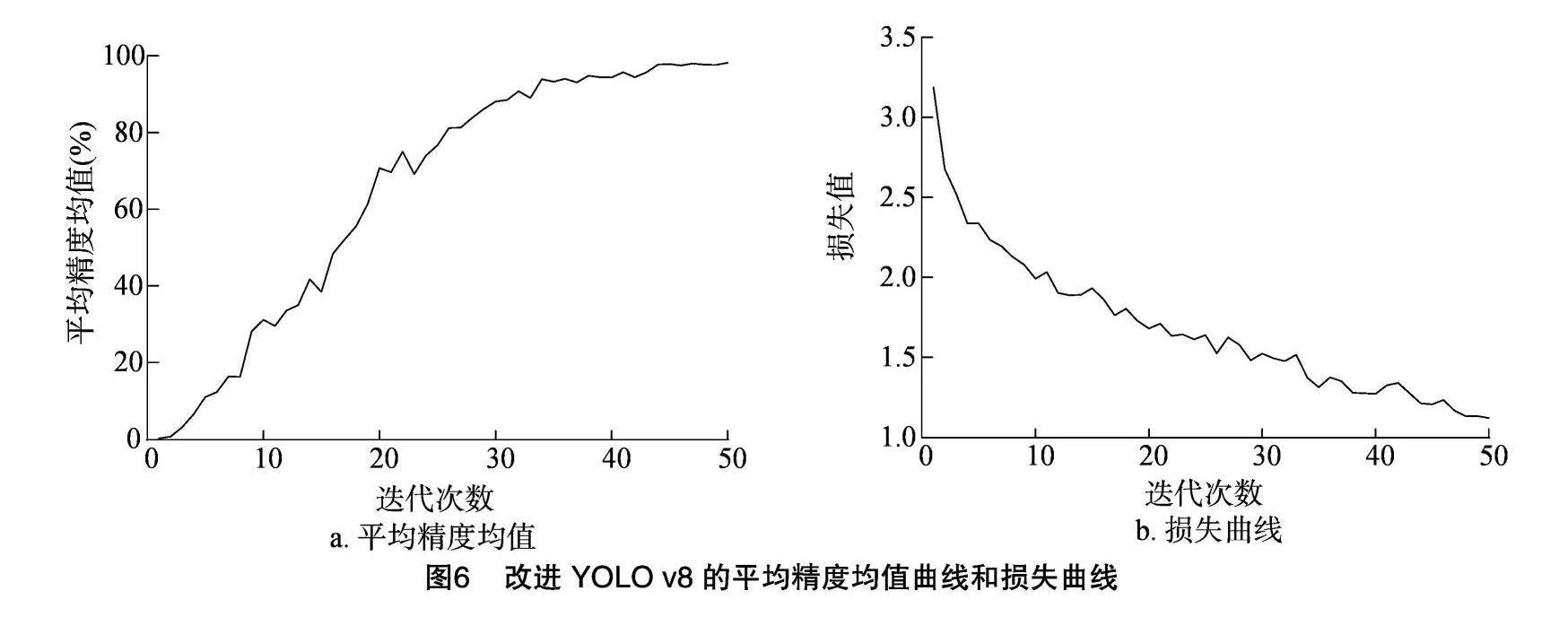

2.1 模型训练过程

如图6-a所示,改进YOLO v8模型的平均精度值均值在大约3次迭代后开始迅速提高,约在50次迭代时,模型的平均精度均值提高至98%左右。如图6-b所示,改进YOLO v8模型的损失值在训练开始即快速降低,在模型训练至50次时降低至1.25以下。训练结果表明,改进的YOLO v8模型在训练过程中表现稳定,模型在训练过程中没有过拟合或欠拟合,并具有较强的泛化能力。

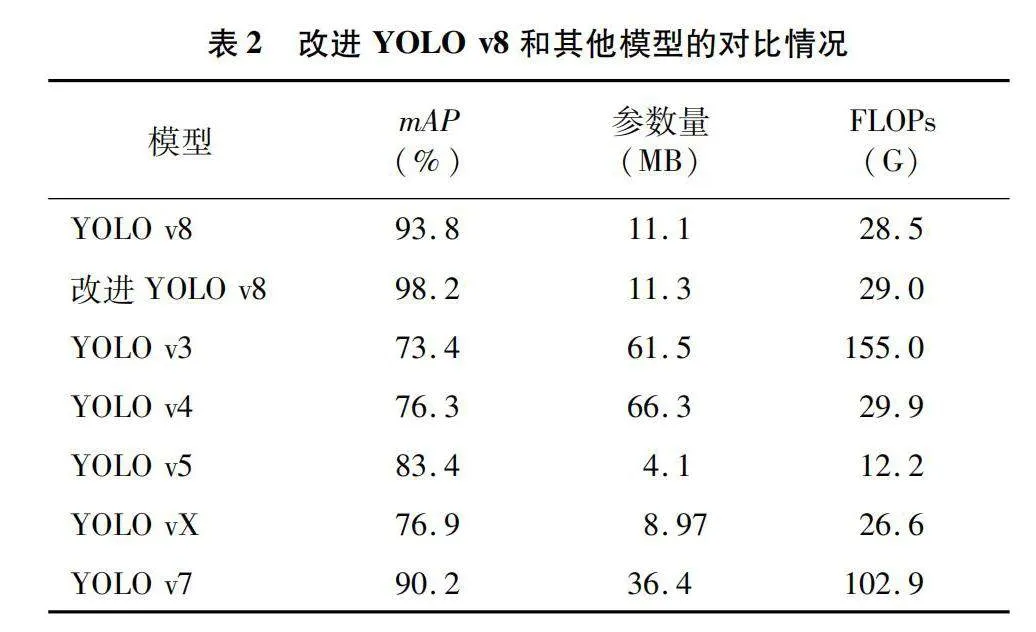

2.2 模型对比试验

模型对比试验可证明改进模型的有效性,因此本研究将提出的改进YOLO v8模型与目前流行的模型进行对比,结果见表2,本研究提出的改进YOLO v8模型的mAP可以达到98.2%,其mAP相比于YOLO v8模型提高了4.4百分点,而参数量和计算量相比YOLO v8仅有微小的增加。此外,本研究提出的改进YOLO v8模型的mAP相比YOLO v3、YOLO v4、YOLO v5、YOLOX、YOLO v7分别提高24.8、21.9、14.8、21.3、8.0百分点,在参数量和FLOPs方面总体来看也具有明显的优势。

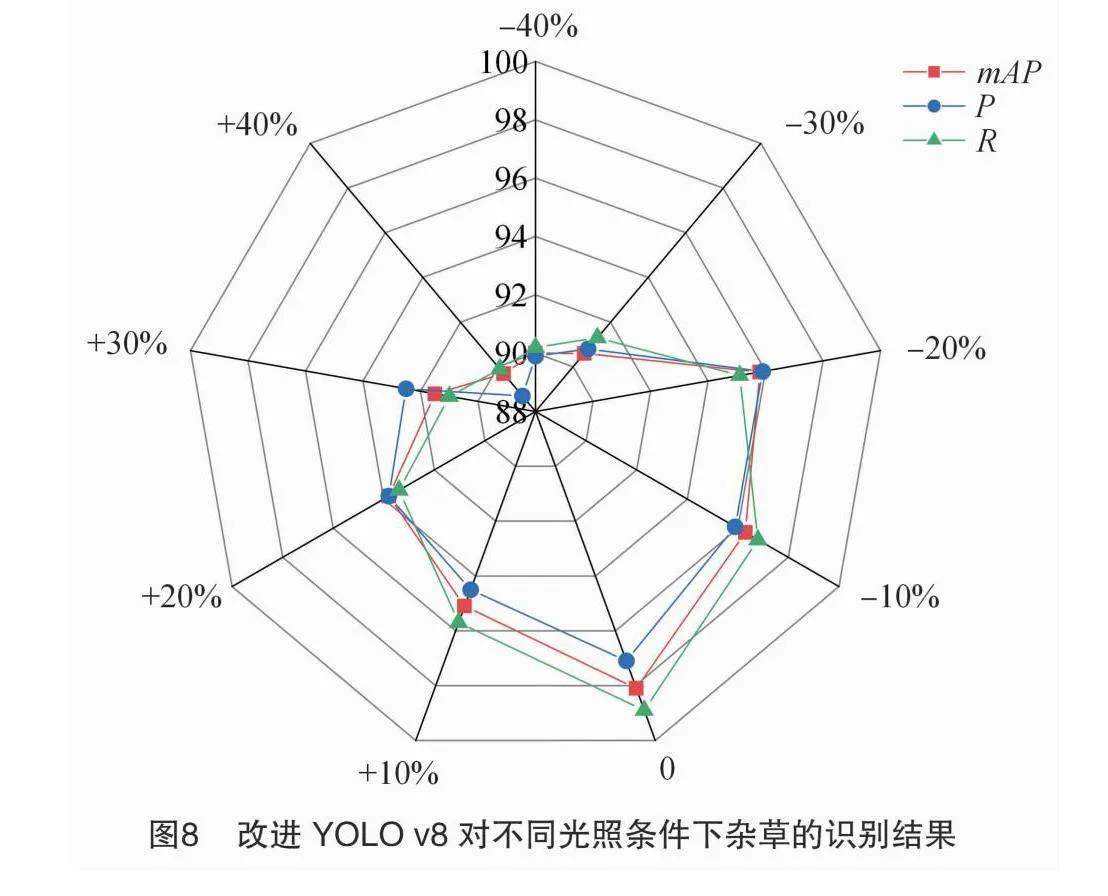

2.3 对不同光照条件下的杂草识别

在多云和晴天的不同光照条件下,杂草的颜色、纹理和形状可能会发生显著变化,导致识别准确度降低。为了验证改进YOLO v8模型对不同光照条件下杂草的识别效果,本研究通过调节测试图像的亮度以模拟不同光照条件测试模型。如图7所示,本研究分别将图像的亮度降低和提高40%来模拟不同光照度。由图8可以看出,在不同光照条件下的杂草所展现的颜色有明显差异,这给模型的识别带来了极大的挑战。图8显示了使用亮度调节后的测试集测试改进YOLO v8模型的结果。可以观察到,当光线变强或变弱时,模型的检测精度有所下降。尽管光照度的变化会影响杂草识别的准确性,但P、R和mAP仍在88.1%以上,这表明改进YOLO v8模型在不同光照条件下具有较强的泛化能力。

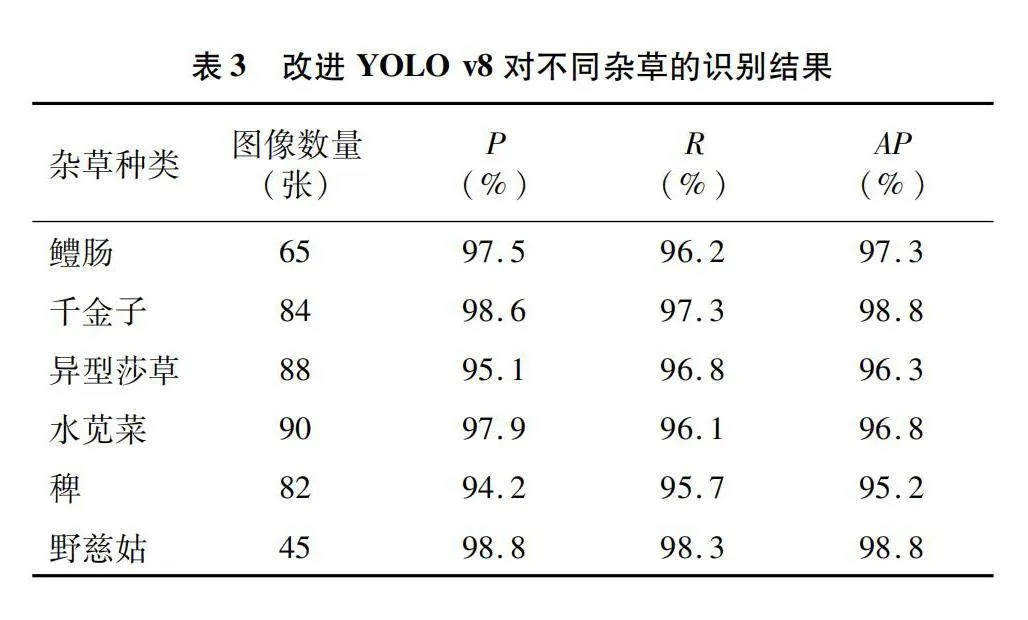

2.4 改进YOLO v8模型的鲁棒性测试

不同杂草在其生长过程中颜色和形态会有显著的变化,而且杂草也经常被水稻叶片所遮挡,这十分考验模型的泛化能力和鲁棒性。如图9所示,本研究使用鳢肠、千金子、异型莎草、水苋菜、稗和野慈姑的图像来测试改进YOLO v8模型的鲁棒性。观察识别结果发现,图像中被水稻叶片遮挡的鳢肠、千金子、稗和野慈姑可以被准确地检测,而且模糊图像中的异型莎草也被准确检测出。当水苋菜、千金子和异型莎草等多种杂草同时存在于同一图像中时,改进YOLO v8模型仍然具有良好的识别能力。而且从表3的识别结果可以看出,改进的YOLO v8对复杂环境中的6种杂草实现了令人满意的识别性能,P达到94.2%以上,R达到95.7%以上,AP均达到95.2%以上,这表明本研究提出的改进YOLO v8模型具有较强的鲁棒性和泛化能力。

3 结论

本研究旨在开发一种轻量级的杂草识别模型。为实现这一目标,本研究基于农h674N6z4XnZB7X0mlLNnSUzIVUwvC1AFh6V0N8TR96Q=业大数据技术和深度学习技术,收集了稻田中的杂草样本,构建了1个杂草数据集,并提出改进YOLO v8模型用于检测稻田杂草。结果表明,改进YOLO v8模型能够准确识别稻田中的杂草种类,对测试集的mAP达到98.2%。改进YOLO v8模型对复杂环境中的杂草具有良好的识别准确率,P均高于94.2%,R均高于95.7%。本研究提出的改进YOLO v8模型在轻量级属性和模型大小等方面优于其他深度学习模型,同时获得了高准确性,因此在精确喷药和智能除草方面具有极高的潜力。

参考文献:

[1]高 婷,王红春,石旭旭,等. 水稻机械化插秧栽培及其草害防除[J]. 江苏农业科学,2013,41(9):60-62.

[2]刘延刚,马宗国,张明红,等. 除草药肥对稻田杂草的防效及水稻生长发育的影响[J]. 山东农业科学,2013,45(3):104-106.

[3]李璐存. 植保技术在小麦高产栽培中的有效应用[J]. 种子科技,2023,41(13):111-113.

[4]安小康,李富根,闫晓静,等. 植保无人飞机施用农药应用研究进展及管理现状[J]. 农药学学报,2023,25(2):282-294.

[5]申继忠,余武秀. 作物保护面临的挑战和新技术进展[J]. 世界农药,2023,45(7):1-18.

[6]张宇泉,曹正伟,锡林图雅. 美国精准农业技术推广经验及对我国启示[J]. 上海农业学报,2020,36(3):119-125.

[7]刘 翔,何人可,季 铁. 基于精准农业的农产品绿色可持续设计研究[J]. 包装工程,2021,42(8):328-333.

[8]方向明,李姣媛. 精准农业:发展效益、国际经验与中国实践[J]. 农业经济问题,2018,39(11):28-37.

[9]Pasqual G M. Development of an expert system for the identification and control of weeds in wheat,triticale,barley and oat crops[J]. Computers and Electronics in Agriculture,1994,10(2):117-134.

[10]AhmadU,Kondo N,Arima S,et al. Weed detection in lawn field using machine vision[J]. Journal of the Japanese Society of Agricultural Machinery,1999,61(2):61-69.

[11]毛文华,王一鸣,张小超,等. 实时识别行间杂草的机器视觉系统[J]. 农业工程学报,2003,19(5):114-117.

[12]沈维政,张长利,刘振恒. 基于计算机视觉的田间杂草识别方法研究[J]. 农机化研究,2006,28(7):163-165.

[13]胡迎思,于 跃,朱凤武. 基于图像处理的田间杂草识别定位技术的研究[J]. 农业与技术,2018,38(3):17-20.

[14]Yu J L,Sharpe S M,Schumann A W,et al. Detection of broadleaf weeds growing in turfgrass with convolutional neural networks[J]. Pest Management Science,2019,75(8):2211-2218.

[15]Babu V S,Ram N V. Deep residual CNN with contrast limited adaptive histogram equalization for weed detection in soybean crops[J]. Traitement du Signal,2022,39(2):717-722.

[16]张 乐,金 秀,傅雷扬,等. 基于Faster R-CNN深度网络的油菜田间杂草识别方法[J]. 激光与光电子学进展,2020,57(2):304-312.

[17]李开敬,许 燕,周建平,等. 基于Faster R-CNN和数据增强的棉田苗期杂草识别方法[J]. 新疆大学学报(自然科学版)(中英文),2021,38(4):450-456.

[18]邓向武,齐 龙,马 旭,等. 基于多特征融合和深度置信网络的稻田苗期杂草识别[J]. 农业工程学报,2018,34(14):165-172.

[19]李 彧,余心杰,郭俊先. 基于全卷积神经网络方法的玉米田间杂草识别[J]. 江苏农业科学,2022,50(6):93-100.

[20]Peng H X,Li Z H,Zhou Z Y,et al. Weed detection in paddy field using an improved RetinaNet network[J]. Computers and Electronics in Agriculture,2022,199:107179.

[21]颜廷国. 农业大数据环境下的农作物病虫害智能化监测预警[J]. 农业工程技术,2023,43(20):51-52.

[22]Rakhmatulin I,Kamilaris A,Andreasen C. Deep neural networks to detect weeds from crops in agricultural environments in real-time:A review[J]. Remote Sensing,2021,13(21):4486.

[23]Yang,S X,Yao J F,Teng G F. Corn leaf spot disease recognition based on improved YOLO v8[J]. Agriculture,2024,14(5):666.

[24]Li J W,Qiao Y L,Liu S,et al. An improved YOLO v5-based vegetable disease detection method[J]. Computers and Electronics in Agriculture,2022,202:107345.

[25]周 涛,王 骥,麦仁贵. 基于改进YOLO v8的实时菠萝成熟度目标检测方法[J/OL]. 华中农业大学学报,2024:1-11(2024-04-24)[2024-05-10]. https://link.cnki.net/urlid/42.1181.S.20240422.1423.006.