NFP-AST:自然特征保留的任意风格迁移模型

2024-10-14赵敏钱雪忠宋威

摘 要:亲和特征提取和自然融合是实现风格迁移的关键。为此,提出一个新的自然特征保留的任意风格迁移模型NFP-AST。通过可逆残差网络在前向和后向推理中对特征二分处理,保证了提取特征亲和性,减少因提取过程造成的图像重建误差。在自适应空间重构模块ASRM中,先通过全局统计信息匹配内容风格特征,接着在融合特征中插值自适应权重捕获细节无偏融合内容风格特征,使风格过渡自然。定性和定量实验研究结果表明,NFP-AST产生的风格化图像与先进方法相比都取得了较好得分,艺术表达更具有视觉冲击力。

关键词:自然特征保留; 可逆残差网络; 特征亲和性; 自适应空间重构; 无偏融合

中图分类号:TP391 文献标志码:A

文章编号:1001-3695(2024)10-043-3183-05

doi:10.19734/j.issn.1001-3695.2023.12.0598

NFP-AST:arbitrary style transfer model for natural feature preservation

Zhao Min, Qian Xuezhong, Song Wei

(School of Artificial Intelligence & Computer Science, Jiangnan University, Wuxi Jiangsu 214122, China)

Abstract:The extraction of affinity features and natural fusion are crucial for achieving style transfer. To address this problem, this paper proposed a novel arbitrary style transfer model, called NFP-AST, emphasizing the preservation of natural features. Through a reversible residual network, it performed binary processing of features in both forward and backward infe-rences, ensuring the extraction of affinity features and reducing image reconstruction errors. In the adaptive space reconstruction module(ASRM), it firstly used global statistical information to match content and style features, followed by interpolating adaptive weights in the fusion features to capture details for unbiased merging of content and style features, resulting in a natural style transition. Qualitative and quantitative experimental results indicate that NFP-AST produces stylized images with better scores compared to state-of-the-art methods, demonstrating enhanced visual impact in artistic expression.

Key words:natural feature preservation; reversible residual network; feature affinity; adaptive spatial reconstruction; unbiased fusion

0 引言

风格迁移通过将两个图像的特征进行融合,创造出具有原始图像内容但呈现出另一张图像风格的全新图像。提取特征要保证准确性,融合特征时需要自然过渡,确保图像看起来和谐统一,没有明显的分界线;生成的艺术图像才会呈现独特而具有吸引力的视觉效果。因此,特征亲和提取还原和自然传递是实现风格化的关键。

Gatys等人[1]首次利用卷积神经网络对图像的高级特征进行可视化,实现了将图像的内容和风格分离并重新组合,解决了早期使用直方图均衡化[2]、滤波器[3]等难以准确进行特征表示的问题,为后续的研究奠定了基础。随着对基于优化算法的改进,实时风格迁移大大提高了风格迁移的效率。现有实时风格迁移算法一部分是基于全局统计[4~7],涉及对两幅图像的统计特征(如二阶全局统计量)进行比较和整合。增加它们的全局特征相似度,从而实现风格迁移。但在处理局部细节、复杂风格方面存在局限性,导致生成的图像质量不尽人意。还有一部分基于局部补丁[8,9],需要编码器提取图像的局部补丁特征,它们可以捕捉到图像的局部纹理和结构信息,根据补丁匹配调整后的局部特征生成新图像,更加注重局部纹理和结构一致性,但是基于局部补丁的方法依赖图像局部特征,缺乏自然感和整体一致性。上述算法大多采用编码器-风格转换模块-解码器框架。预训练的VGG_19[10]作为风格迁移领域高频使用的编解码器,带来了一定的缺陷。VGG_19是一个相对较深的卷积神经网络,其结构和参数固定,难以根据风格迁移需求进行调整,且提取到的一部分高级语义信息不是所需的,在风格迁移过程中需要训练一个结构对称的解码器来将 VGG_19 的特征还原为图像,通过内容损失约束解码器,但是由于编码器中的池化操作会导致空间信息损失,未能有效避免由解码器引起的图像重建误差,会影响合成风格化图像的质量,一定程度上造成了信息丢失。为了减少迁移过程造成的人工伪影,现有方法采用跳跃连接模块[11],或者采用轻量编解码器[12],然而,这些方法都未能有效避免由解码器引起的图像重建误差。在训练对称编解码器的过程中,不能准确且自然地提取特征,导致生成的图像缺乏一些细节和纹理。为了解决这个问题,本文提出了自然特征保留的任意风格迁移模型(NFP-AST)。受文献[13,14]启发,本文使用可逆残差特征提取还原器将特征沿通道维度二分处理,在前向推理中提取亲和特征。它由二分填充模块BSI、级联残差块和挤压块、冗余消除模块RE构成。前向推理中,对特征边缘进行零填充,充分利用边缘像素,减少信息丢失。由于前向推理中产生大量冗余信息,冗余消除模块RE用于压缩信道减少冗余信息,进一步增强特征表达能力。然后通过自适应空间重构模块(adaptive spatial reconstruction module,ASRM)先进行全局匹配,再进行局部细节匹配,生成图像在整体风格上与风格图像保持一致,接着在融合特征中插值自适应权重保留内容语义结构细节,然后二次融合风格统计特征,丰富纹理增添艺术感得到的风格化图像融合更为自然。通过反向推理重建艺术图像,避免图像重建误差。通过大量定性和定量实验研究,本文提出的自然特征保留的任意风格迁移模型产生的艺术图像更加接近艺术家的创作。

本文工作的贡献主要为:

a)现有的风格迁移算法缺乏亲和特征提取还原,无法自然传递造成图像重建偏差。为此,提出了自然特征保留的任意风格迁移模型(arbitrary style transfer network for natural feature preservation,NFP-AST),在特征提取时减少信息丢失,无偏生成艺术图像;

b)引入了可逆残差特征提取还原器,在前向和后向推理中对特征二分处理,保证特征亲和性;在自适应空间重构模块(ASRM)中无偏融合内容风格特征,保留内容语义结构的同时丰富纹理,保证良好的视觉效果;

c)通过大量定性和定量实验证明本文方法与先进的风格迁移算法相比的有效性,表达了不同的艺术创意,拓展了艺术表现的可能性。

1 相关工作

a)图像风格迁移。最初使用非参数的方法来合成自然纹理,只能采用提取的底层特征进行纹理转移。Gatys等人[1]提出基于优化的方法,捕获到高级图像特征,尽管取得了显著的迁移效果,但是通常需要大量的计算资源来进行内容损失和风格损失的最小化。随着神经网络的发展,具有高效性、实时性的快速风格迁移方法被提出。 Huang等人[15]引入一个简单的IN扩展,通过实例归一化和统计信息调整,使得内容图像特征在统计上更接近风格特征。Li等人[16]通过白化操作减少特征之间的相关性,接着使用着色操作,使内容和风格特征在颜色空间上保持一致,但是带来昂贵计算。LinearWCT模型[17]采用可学习的线性变换矩阵提高了效率。Zhao等人[8]采用二次对齐策略保留内容结构,纹理调制器生成风格卷积参数形成精美笔触,以此平衡内容和风格。Park等人[9]提出SAnet,使用修改后的自注意机制学习内容和风格特征之间的映射,根据不同位置特征的长距离依赖关系赋予不同权重,丰富局部风格样式。生成对抗网络的出现为优化风格迁移的视觉质量带来了新的技术途径,如He等人[18]提出ChipGAN,解决中国水墨画中空隙、笔触、水墨的问题,实现了水墨风格迁移。Xu等人[19]提出DRB-GAN,将学习艺术图像集的风格代码建模为动态重参数共享,缩小单个模型中任意样式传输和集合样式传输之间的差异。以上算法都采用编码器-风格转换器-解码器来生成新的艺术图像,不可避免地造成了图像重建误差,不能够很好地进行亲和特征提取还原。

b)可逆网络。随着神经网络结构研究的不断深入,传统编解码器结构存在信息丢失和效率低下的问题,可逆神经网络为风格迁移带来了新的思路。Gomez 等人[20]提出了可逆残差网络,本层激活可由下一层激活计算。Chen等人[21]在此基础上利用可逆卷积生成流,显著改进对数似然。An等人[13]提出了ArtFlow,引入可逆神经流在投影-传输-回归方案中运行,解决了内容泄露的问题。文献[22]使用基于Cholesky分解的无偏线性变换模块,在特征空间中进行无偏风格转移,采用通道细化避免冗余信息积累,但是合成图像不够自然。本文方法利用可逆残差特征提取还原器,确保提取特征亲和性,生成的图像具有良好的视觉效果,包括清晰的纹理、自然的色彩过渡。

2 主要方法

2.1 NFP-AST模型总概

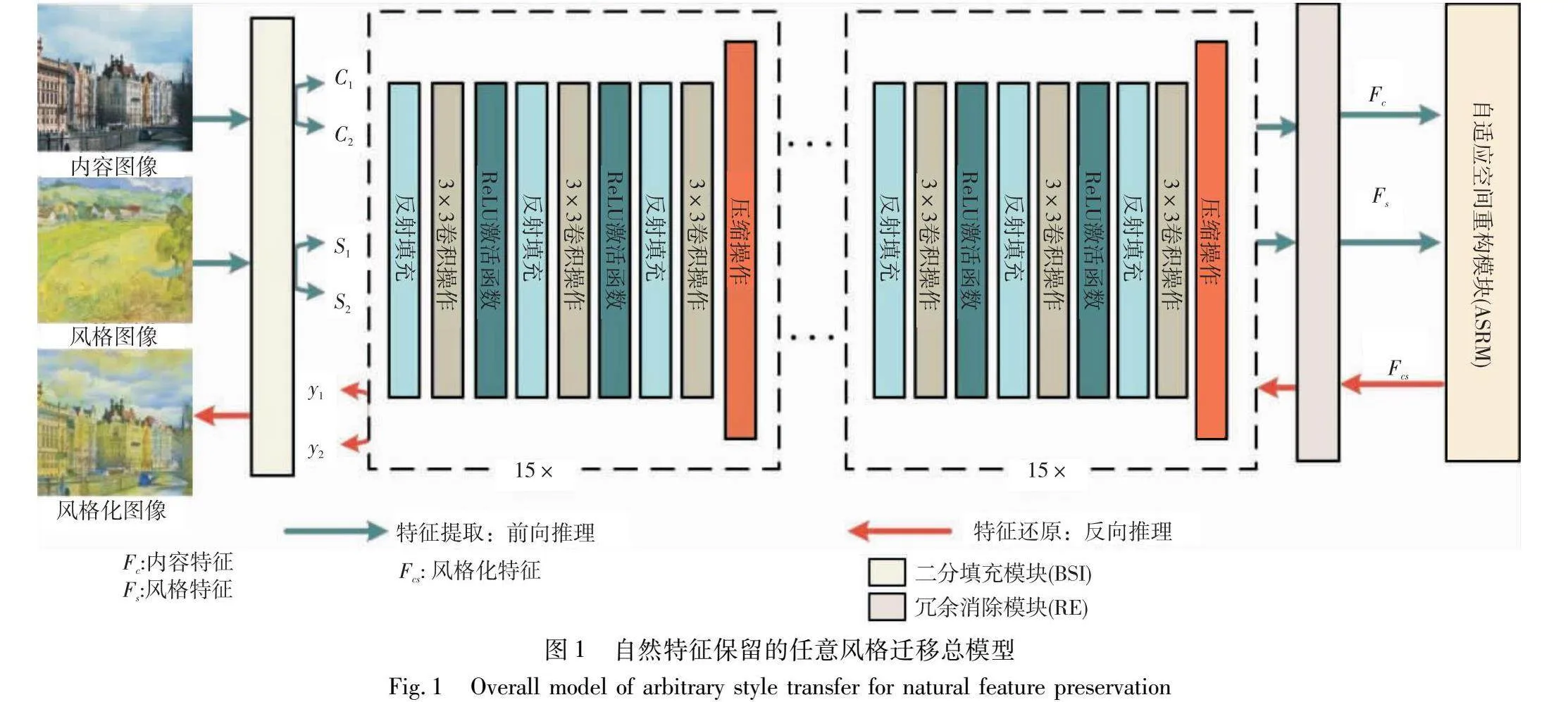

为了亲和特征提取还原和自然传递,本文提出一个自然特征保留的任意风格迁移模型。与现有基于编解码器框架的风格迁移算法不同,NFP-AST模型只由可逆残差特征提取还原器来实现亲和特征的提取和融合特征的重建。如图1所示,NFP-AST模型首先通过基于可逆残差网络前向推理提取内容图像中的基本语义结构和风格图像中的纹理色彩特征,接着传入自适应空间重构模块(ASRM)中,更加自然地融合特征,然后在冗余消除模块协助下通过可逆残差网络反向推理重建风格化图像。

具体步骤如下:

a)前向推理。给定内容图像C和风格图像S,首先通过一个二分填充模块(binary split injection,BSI),沿通道对特征二分处理,接着由可逆残差特征提取器E无损提取亲和内容特征Fc:=E(C1,C2)和亲和风格特征Fs:=E(S1,S2)。

b)特征迁移。自适应空间重构模块(ASRM)在特征空间根据风格图像的统计特征对归一化的内容特征进行调整,然后根据空间感知插值获得自适应权重,进一步在内容风格特征之间进行插值,注入细节,最后得到风格化特征Fcs。

c)反向推理。通过冗余消除模块(redundancy elimination,RE)沿通道去除冗余信息后,可逆残差特征还原器E将风格化特征Fcs逆映射回风格化图像Y。

2.2 可逆残差特征提取还原器

设输入内容图像为C,风格图像为S,编解码器结构在对图像进行压缩编码的过程中可能丢失输入图像中的细节或特征,导致解码器无法准确重建输入图像,为此本文使用可逆残差特征提取还原器E,它由1个二分填充模块、30个级联残差块和挤压块、冗余消除模块构成。前向推理时首先将输入沿通道二分处理,用于增强特征表达能力,更好地捕捉输入图像的不同特征和结构信息;且在特征边缘进行零填充,充分利用边缘像素,减少信息丢失,如式(1)所示。

(C1,C2):=BSI(C), (S1,S2):=BSI(S)(1)

如图1所示,本文每一个可逆残差块都是由3个反射填充层、3个核大小为3×3的卷积层和挤压层构成。挤压层squeeze函数把输入特征通道数增加,空间维度减少,增强捕获特征的局部性,使特征提取时更加关注局部细节,提高提取特征的亲和性。在级联可逆残差块中选用式(2)的映射函数。

Xc1:=C1+F(C2),Xc2:=C2, XS1:=S1+F(S2),Xs2:=S2(2)

其中:函数F是由三个核大小为3的conv层实现。冗余消除模块RE用来减少通道维数,减少前向推理过程的冗余信息,进一步增强特征表达能力。逆向映射函数见式(3),其中函数F同式(2)。

Y2:=fcs2,Y1:=fcs1-F(fcs2)(3)

其中:fcs1 、fcs2是由自适应空间重构模块合成的风格化特征Fcs沿通道二分得到。

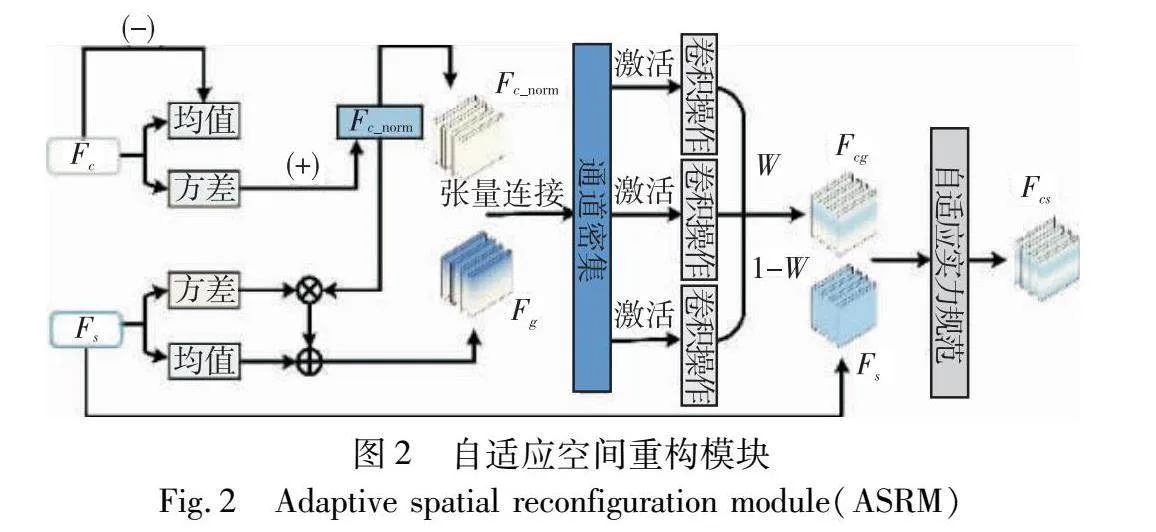

2.3 自适应空间重构模块(ASRM)

此模块用于对提取的亲和内容特征和风格特征自然融合,具体模型结构如图2所示。艺术图像为风格化设定整体基调,内容保持度决定着生成图像与原始内容图像特征空间的距离。对内容图像作归一化处理,减少特征间相关性,更易于增强风格特征的影响。通过式(4)把握整体风格纹理,确保全局内容语义结构完整性。

Fc_norm:=(Fc-mean(Fc))/std(Fc),

Fg:=Fc_norm×std(Fs)+mean(Fs)(4)

其中:mean表示求均值;std表示求特征方差。边界自然过渡才能产生贴近艺术家的创作,为此在信道密集上操作联级特征,使用不同尺度卷积核在归一化内容特征和风格特征上进行插值,以此获得自适应权重,进一步捕获内容特征和风格特征之间相关性,从而添加局部内容细节,如式(5)所示。

F1:=f2(Fc_norm),F2:=f3(Fg), Fcat:=(f1[Fc_norm,Fg]),

w:=(sigmoid{g1(Fcat)}+sigmoid{g2(h1(Fcat))}+sigmoid{g3(h2(Fcat))})/3

Fcg:=clamp(w)⊙F1+clamp(1-w)⊙F2(5)

其中:f1(·)、 f2(·)、 f3(·)是核为1的可学习卷积;[·,·]表示特征级联操作;sigmoid为激活函数;g1是内核1×1的可学习卷积;g2是内核3×3的可学习卷积;g3是内核5×5的可学习卷积;h1表示大小为1个像素的反射填充;h2表示大小为2个像素的反射填充;clamp为张量截断操作,用于提高模型稳定性和收敛性;⊙代表点乘。

确保局部内容细节后,以防内容保留过度失去生动的纹理细节,根据自适应权重插值后重新排列的融合特征fcg执行归一化操作后,再次匹配全局统计风格特征,见式(6)。

Fcg_norm:=(Fcg-mean(Fcg))/std(Fcg)

Fcs:=Fcg_norm×std(Fs)+mean(Fs)(6)

先进行全局匹配再进行局部细节匹配,生成图像在整体风格上与风格图像保持一致,接着在融合特征中插值自适应权重保留内容语义结构细节,然后二次融合风格统计特征,丰富纹理增添艺术感得到的Fcs融合更为自然。

2.4 目标函数

在内容语义结构保留上,大多采用均方误差损失,受文献[22]的启发,本文替换为消光拉普拉斯损失函数,强调相邻帧之间一致性,避免出现突兀变化,可以帮助生成图像在内容上自然过渡纹理,见式(7)。

Lp:=1N∑3c=1Vc[Fcs]TMVc[Fcs](7)

其中:N为像素个数;Vc表示向量化Fcs ;T表示转置操作;M为内容特征Fc的消光拉普拉斯矩阵。消光拉普拉斯损失优势在于可以保持连续性和自然过渡,但计算复杂度会略高一些。特征提取还原模块是可逆的,用可逆网络重构Fcs特征,并与Fc在ASRM中融合得到Fcsc,通过拉近Fcsc和Fc像素差异,减少可逆网络图像重构时产生的伪影,提高生成图像质量和逼真度,采用式(8)作为周期一致性损失。

Lcyc:=‖Fcsc-Fc‖1(8)

在风格上,要解决整个图像的像素差异,选取凸函数让模型容易收敛到较好结果,全局准确传递风格特点,使用式(9)作为损失函数。

Ls:=∑Lsi=1(‖μ(i(Fcs))-μ(i(Fs))‖2+

‖σ(i(Fcs))-σ(i(Fs))‖2)(9)

其中:μ和σ分别表示平均值和标准差;i表示预训练的VGG_19的网络层i,计算风格损失时使用具有相等权重的{ReLU1_1, ReLU2_1, ReLU3_1, ReLU4_1}层。

综上,自然特征保留的任意风格迁移总目标为

Ltotal:=λpLp+λcycLcyc+λsLs(10)

其中:损失项对应权重超参数根据经验设置为λp=60,λcyc =1,λs =1。

3 实验与分析

3.1 实验设置

NFP-AST在PyTorch框架上实现,采用MS-COCO数据集中约8万张真实图像作为内容图像训练集,WikiArt数据集中约8万张不同艺术特点的画作作为风格图像训练集。在训练期间,将所有图像分辨率随机裁剪为256×256的大小,批量大小设置为4个内容风格图像对。使用Adam作为优化器,学习率设置为0.000 1,共需要160 000次线性衰减迭代。在测试期间,可逆残差网络可以处理任何大小的输入图像。涉及的所有实验均在NVIDIA RTX 3060 12GB GPU上进行。

为了评估此方法,将NFP-AST与八种先进的风格迁移算法进行比较,包括SAnet[9]、ArtFlow[13]、AdaIN[15]、IECAST[21]、S2WAT[22]、StyTR2[23]、MicroUST[24]和STTR[25]。所有方法均采用了原文公开的代码,并在相同的默认参数配置下进行了训练。

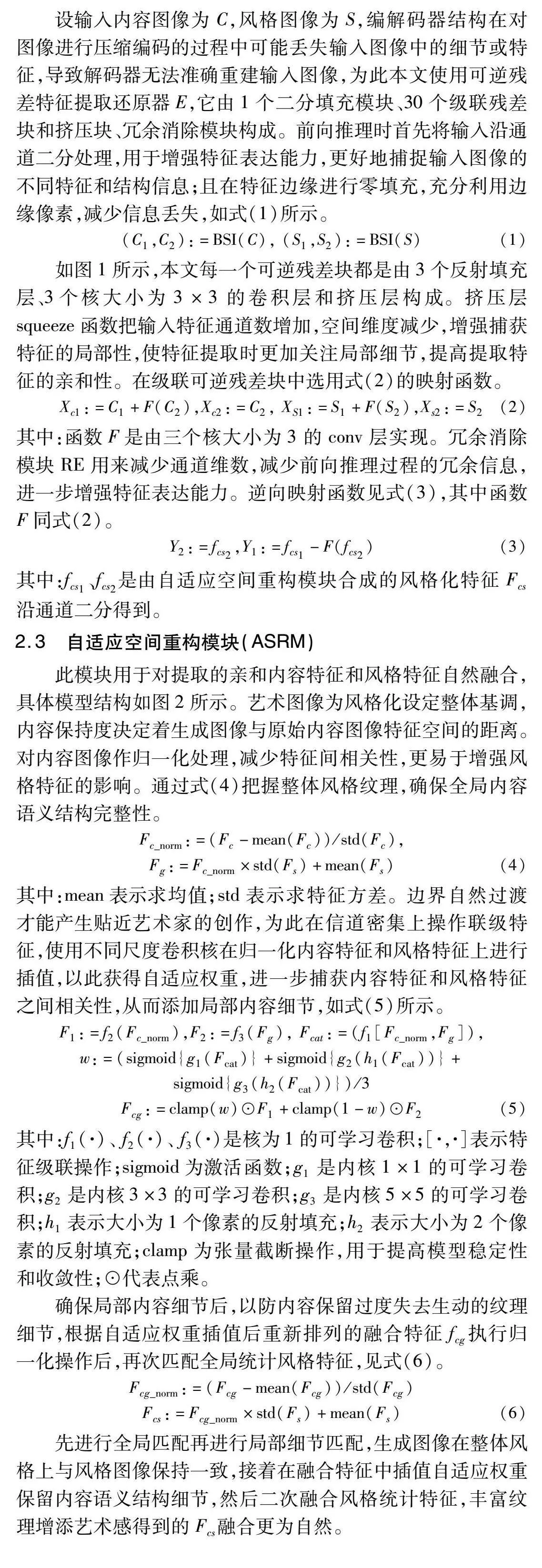

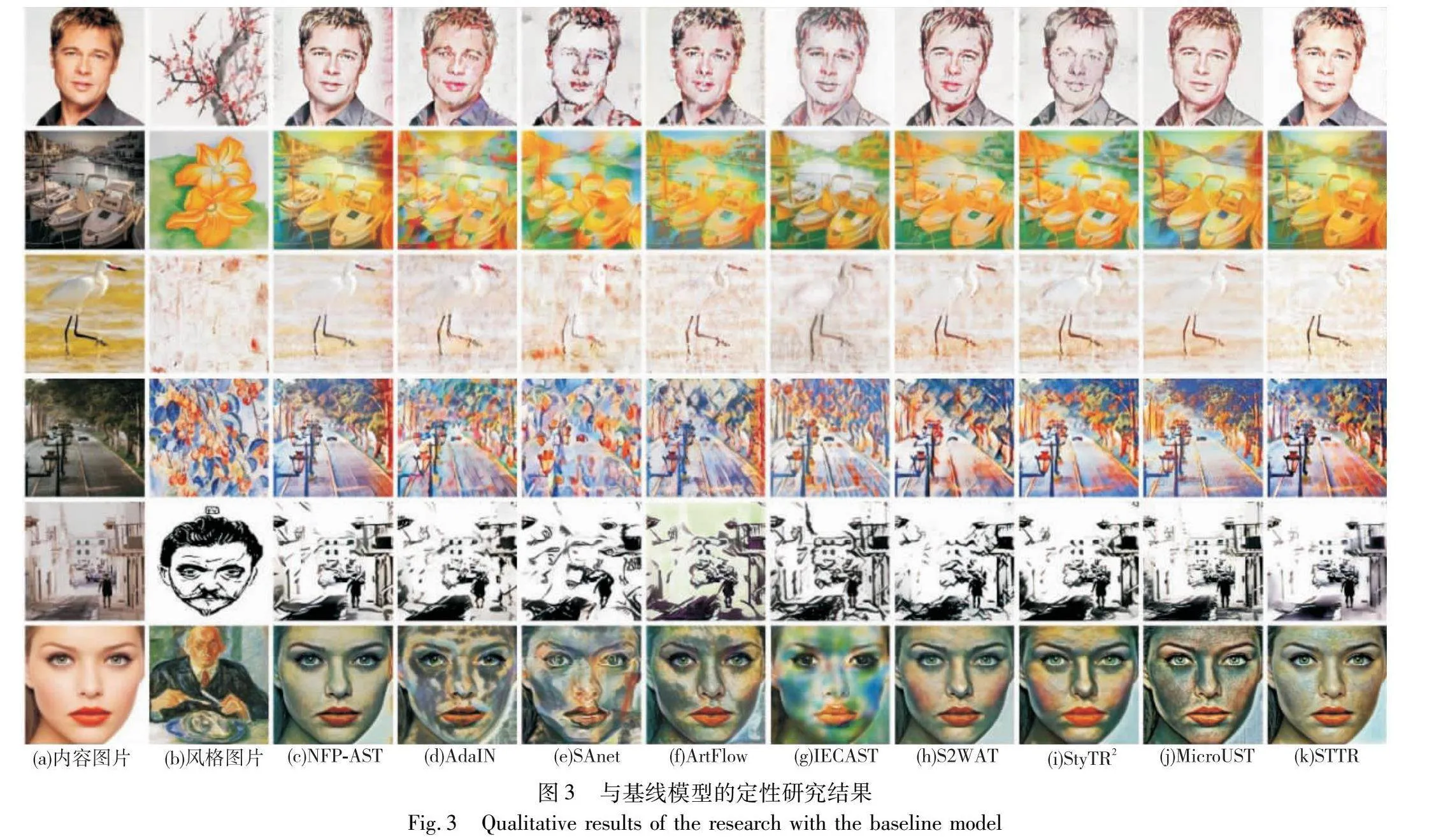

3.2 定性评估

图3展示出定性研究结果。选取了不同类型的内容图像,如人物、动物、建筑等,艺术图像按照不同色彩、风格、主题选取,确保风格迁移多样性。AdaIN在空白背景都带有明显扭曲杂乱的纹理(例如第1行杂乱无章的背景纹理),这种算法采用实例归一化将风格统计特征全局匹配内容,导致纹理无差别散布。S2WAT优化风格局部结构,在纹理上保留细节较多(如第5行建筑物出现和风格图像类似的弯曲纹理),但是内容结构大量丢失。SAnet引入自注意力机制,自适应处理纹理,保留大量风格特征,造成内容语义结构扭曲破坏了画面布局完整性(如第2行错位船头,第5行丧失结构的房屋)。ArtFlow和本文一样采用了可逆网络,由于训练时大量冗余信息未处理,残留其他图像的色彩(如第5行背景中出现了内容和风格图像中不存在的绿色)。StyTR2使用Transformers风格表现优异,有时会破坏内容细节(如第1行中畸形的左眼)。MicroUST使用轻量残差编码器保留了完整内容细节,风格化在笔触方面表现生硬。STTR迁移了绚丽色彩,在内容保留方面有时不可控,产生了不协调的人工伪影(如第4行虚化的树枝)。本文NFP-AST在保留内容细节的同时,引入了和谐的纹理,使画面更加自然,这表明NFP-AST优化了生成图像质量。

3.3 定量评估

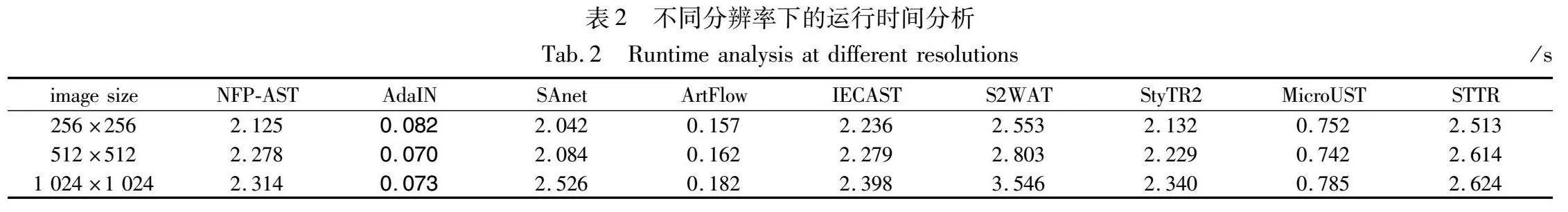

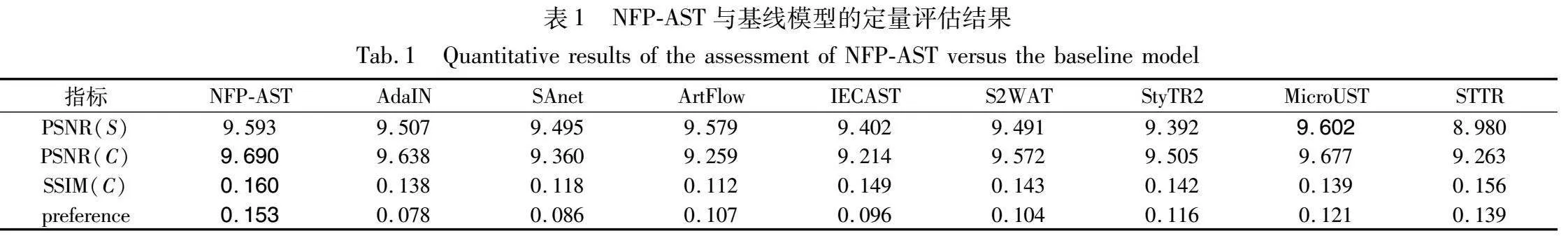

艺术图像鉴赏受个人欣赏喜好和审美影响,为此本文使用1个主观指标(偏好得分preference)和3个客观指标(PSNR、SSIM、效率)以定量评估NFP-AST,表1、2中列出评估结果,最优数据加粗表示。

a)偏好得分。选择不同类别的内容图像10张,风格图像15张,合成150张风格化图像。选择20个内容风格对,将其随机排列展示给50个受试者,每个受试者从中选取偏好的艺术图像,共得到1 000张选票,表1第4行展示选票百分比。结果表明,本文方法获得了最高分数,说明NFP-AST生成的风格化图像更受人们欣赏。

b)PSNR。主要关注图像像素级差异,分别计算风格化图像与原始内容图像和风格图像之间的均方误差来评估图像失真程度。PSNR值越高,表示图像质量越高。如表1第2行所示,本文方法在内容语义结构保留方面表现优异,取得最高分数。Adaconv优化风格局部结构,模型偏向对纹理的处理,如表1第1行所示,NFP-UST仅次于它,说明本文方法在纹理渲染上也有一定建树。

c)SSIM。通过比较图像亮度、对比度和结构相似性来评估图像,主要考虑图像结构信息,SSIM值越高表示两幅图像结构相似性越好,结构保留效果越好。如表1第3行所示,NFP-AST取得最高分数,说明本文的方法在画面结构布局方面表现出色。

b)效率。选取256 px、512 px、1 024 px内容风格图像对,在相同服务器上比较本文方法与7个基线模型的效率,通过计算50个图像对的平均运行时间进行评估。如表2所示,AdaIN通过自适应实力规范化公式融合,用时最短,MicroUST 采用轻量编解码器,减少参数量,效率仅次之。NFP-UST目的为提高视觉质量,同时与其他基线模型效率相当,可以实时处理1 024 px图像,计算效率良好。

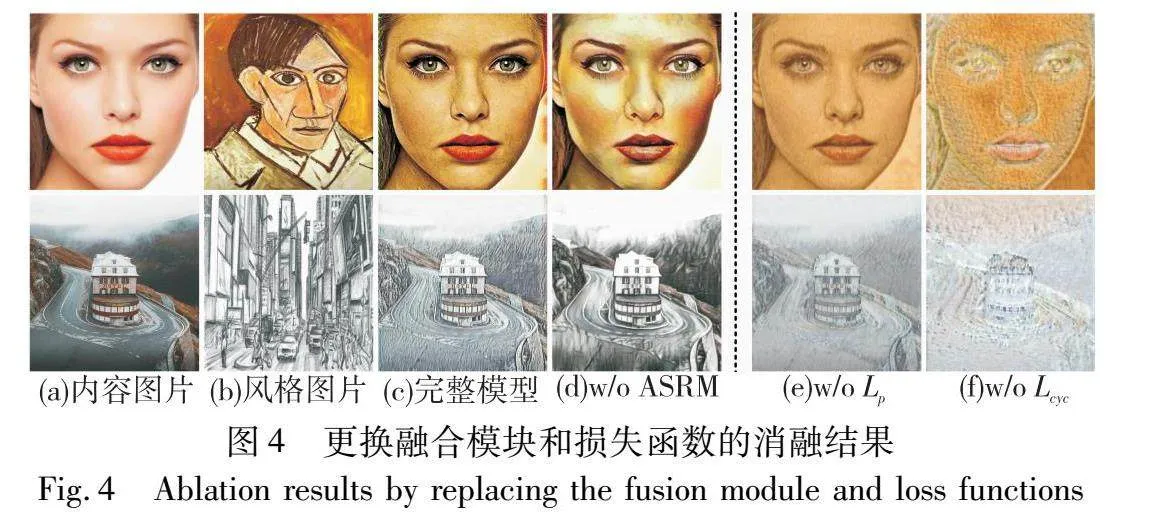

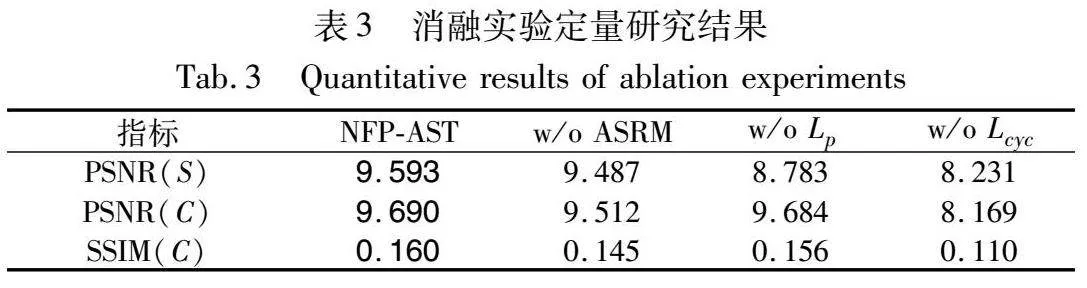

3.4 消融实验

1)自适应空间重构模块(ASRM)

将设计的自适应空间重构模块更换为AdaIN进行无偏特征转换,如图4(d)所示,更换后色彩分布混乱,人脸头部出现杂乱网格,路面也出现不协调纹路。使用ASRM模块进行迁移时解决了上述问题,首先通过全局特征匹配,使整体风格融合协调,后续通过自适应权重在内容风格特征之间进行插值,增添细节。因此,ASRM模块存在使风格化图像表现更为自然。

2)内容损失函数

将消光拉普拉斯损失Lp替换为均方误差损失函数训练网络,如图4(e)所示,两个损失函数均在内容语义结构保留上表现出色,表3中的客观指标两者数值相近,但是本文采用的消光拉普拉斯损失函数益于风格自然传递,在色彩表现方面良好,生成图像艺术更具有视觉冲击力。

3)周期一致性损失

在图4(f)展示了去掉周期一致性损失Lcyc的消融结果。由于提出的网络是可逆的,周期一致性损失优化模型图像重建能力,其内容细节大量丢失,面部五官和楼体结构模糊,且迁移颜色单一,不能保证像素亲和性。表3第5列表示去除后数据都有一定程度下降,证明了Lcyc的有效性。

消融实验定量研究结果如表3所示,最优数据加粗表示,测量消融实验的PSNR和SSIM分数,完整NFP-AST模型均取得较高得分。

4 结束语

本文根据风格迁移任务中亲和特征提取和自然融合这两个关键点,提出了一个新的自然特征保留的任意风格迁移框架NFP-AST。该框架由一个可逆残差特征提取还原器和自适应空间重构模块(ASRM)构成。在可逆残差网络中对内容和风格特征进行二分处理,在前向推理和逆向映射中减少信息冗余,保证提取特征的亲和性,降低了图像重建误差。内容特征和风格特征在自适应空间重构模块中无偏融合,通过融合全局统计信息奠定风格整体基调,后在风格化特征中插值自适应权重,增加局部细节。本文方法使风格过渡自然,使生成图像生动和谐,提高了画面质量。

参考文献:

[1]Gatys L A, Ecker A S, Bethge M. Image style transfer using convolutional neural networks[C]//Proc of the 36th IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2016: 2414-2423.

[2]Fier J, Jamrika O, Lukácˇ M, et al. StyLit: illumination-guided example-based stylization of 3D renderings[J]. ACM Trans on Graphics, 2016, 35(4): article No. 92.

[3]Kwatra V, Schdl A, Essa I, et al. GraphCut textures: image and video synthesis using graph cuts[J]. ACM Trans on Graphics, 2003, 22(3): 277-286.

[4]Chandran P, Zoss G, Gotardo P, et al. Adaptive convolutions for structure-aware style transfer[C]//Proc of the 41st IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2021: 7968-7977.

[5]赵宇欣, 王冠. 基于生成式对抗网络的画作图像合成方法[J]. 计算机应用研究, 2021, 38(4): 1208-1211. (Zhao Yuxin, Wang Guan. Painterly image composition based on generative adversarial net[J]. Application Research of Computers, 2021, 38(4): 1208-1211.)

[6]王伟光, 钱祥利. 基于深度学习的人脸妆容迁移算法[J]. 计算机应用研究, 2021, 38(5): 1559-1562. (Wang Weiguang, Qian Xiangli. Face makeup transfer algorithm based on deep learning[J]. Application Research of Computers, 2021, 38(5): 1559-1562.)

[7]Li Xueting, Liu Sifei, Kautz J, et al. Learning linear transformations for fast image and video style transfer[C]//Proc of the 39th IEEE/CVF Conference on Computer Vision and Pattern Recognition. Pisca-taway, NJ: IEEE Press, 2019: 3809-3817.

[8]Zhao Min, Qian Xuezhong, Song Wei. BcsUST: universal style transformation network for balanced content styles[J]. Journal of Electronic Imaging, 2023, 32(5): 53017.

[9]Park D Y, Lee K H. Arbitrary style transfer with style-attentional networks[C]//Proc of the 39th IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2019: 5880-5888.

[10]Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition [EB/OL]. (2015-04-10). https://arxiv.org/abs/1409.1556.

[11]An Jie, Xiong Haoyi, Huan Jun, et al. Ultrafast photorealistic style transfer via neural architecture search[C]//Proc of AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI Press, 2020: 10443-10450.

[12]Chiu T Y, Gurari Danna. PCA-based knowledge distillation towards lightweight and content-style balanced photorealistic style transfer mo-dels[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2022: 7834-7843.

[13]An Jie, Huang Siyu, Song Yibing, et al. ArtFlow: unbiased image style transfer via reversible neural flows[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2021: 862-871.

[14]Wen Linfeng, Gao Chengying, Zou Changqing. CAP-VSTNet: content affinity preserved versatile style transfer[C]//Proc of the 43rd IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2023: 18300-18309.

[15]Huang Xun, Belongie S. Arbitrary style transfer in real-time with adaptive instance normalization[C]//Proc of IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE Press, 2017: 1510-1519.

[16]Li Yijun, Fang Chen, Yang Jimei, et al. Universal style transfer via feature transforms[C]//Proc of the 31st International Conference on Neural Information Processing Systems. Red Hook, NY: Curran Associates Inc., 2017: 385-395.

[17]Sheng Lu, Lin Ziyi, Shao Jing, et al. Avatar-Net: multi-scale zero-shot style transfer by feature decoration[C]//Proc of the 38th IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2018: 8242-8250.

[18]He Bin, Gao Feng, Ma Daiqian, et al. ChipGAN: a generative adversarial network for Chinese ink wash painting style transfer[C]//Proc of the 26th ACM International Conference on Multimedia. New York: ACM Press, 2018: 1172-1180.

[19]Xu Wenju, Long Chengjiang, Wang Ruisheng, et al. DRB-GAN: a dynamic resblock generative adversarial network for artistic style transfer[C]//Proc of IEEE/CVF International Conference on Computer Vision. Piscataway, NJ: IEEE Press, 2021: 6363-6372.

[20]Gomez A N, Ren Mengye, Urtasun R, et al. The reversible residual network: backpropagation without storing activations[C]//Proc of the 31st International Conference on Neural Information Processing Systems. Red Hook, NY: Curran Associates Inc., 2017: 2211-2221.

[21]Chen Haibo, Zhao Lei, Wang Zhizhong, et al. Artistic style transfer with internal-external learning and contrastive learning[C]//Proc of the 25th Conference on Neural Information Processing Systems. Red Hook, NY: Curran Associates Inc., 2021: 26561-26573.

[22]Zhang Chiyu, Xu Xiaogang, Wang Lei, et al. S2WAT: image style transfer via hierarchical vision transformer using strips window attention [EB/OL]. (2023-12-15). https://arxiv.org/abs/2210.12381.

[23]Deng Yingying, Tang Fan, Dong Weiming, et al. StyTR2: image style transfer with transformers[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2022: 11316-11326.

[24]Wang Zhizhong, Zhao Lei, Zuo Zhiwen, et al. MicroAST: towards super-fast ultra-resolution arbitrary style transfer[C]//Proc of AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI Press, 2023: 2742-2750.

[25]Ke Zhanghan, Liu Yuhao, Zhu Lei, et al. Neural preset for color style transfer[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2023: 14173-14182.