融合大语言模型的三级联合提示隐式情感分析方法

2024-10-14张小艳闫壮

摘 要:隐式情感分析作为情感分析任务的挑战性分支,面临着缺乏明确情感特征、文本语义复杂等问题。受到思维链(chain of thought,CoT)的启发,提出了一种融合大语言模型的三级联合提示隐式情感分析方法(three-level joint prompt-tuning implicit sentiment analysis method incorporating LLMs,TPISA),将大语言模型与本地预训练模型相结合,使用多级推理的方式逐级得出目标的方面、潜在观点,使模型能够更轻松地推理出最终的情感极性。前两级提示利用大型语言模型丰富的世界知识,丰富情感语句的情感信息;然后,将前两级提示得到的方面和潜在意见与上下文连接起来,作为第三级提示的输入。同时构建情感标签词,使预训练的模型能够从标签词汇中获得丰富的语义知识,增强模型的学习能力。实验证明,提出的模型在SemEval14 Laptop和Restaurant数据集上对比当前主流的隐式情感分析模型,取得了5.65和6.72百分点的提升,验证了该方法的先进性。

关键词:隐式情感分析;提示调优;大语言模型;多级推理

中图分类号:TP391 文献标志码:A 文章编号:1001-3695(2024)10-003-2900-06

doi:10.19734/j.issn.1001-3695.2024.01.0021

Three-level joint prompt-tuning implicit sentiment analysis method incorporating LLMs

Zhang Xiaoyan, Yan Zhuang

(School of Computer Science & Technology, Xi’an University of Science & Technology, Xi’an 710600, China)

Abstract:Implicit sentiment analysis as a challenging branch of sentiment analysis tasks faces issues such as lacking explicit sentiment cues and complex text semantics. Inspired by CoT, this paper proposed the TPISA. This method combined large language models with local pre-trained models, employing multi-level reasoning to extract sentiment elements such as aspects and potential opinions, which enables to more easily infer the final sentiment polarity. In the first two levels, it leveraged the extensive world knowledge embedded in LLMs to augment the sentiment information of sentiment sentences. Subsequently, the aspects and potential opinions acquired from these initial levels are interconnected with the context, forming inputs for the third level prompt. Concurrently, it constructed sentiment label words to empower the pre-trained model to assimilate profound semantic insights from the labeled vocabulary, thereby enhancing the model’s learning capacity. The experimental results demonstrate that the proposed model achieves improvements of 5.65 and 6.72 percentage points on the SemEval14 Laptop and Restaurant datasets, respectively, compared to the state-of-the-art models, verifying the progressiveness of this method.

Key words:implicit sentiment analysis; prompt tuning; large language models; multi-level reasoning

0 引言

情感分析长期以来一直是自然语言处理领域的热门研究任务[1~3],广泛应用于舆情监控等领域。该任务面临的主要挑战包括分析需求的多样性和文本语义的复杂性以及舆情信息的时效性。经过十多年的高速发展,情感分析领域产生了多种类型的子任务和主题。到现在,情感分析模型已经可以相当准确地基于给定的情感特征词进行显式情感分析(explicit sentiment analysis,ESA),但由于隐藏的意见特征,隐式情感分析(implicit sentiment analysis,ISA)仍然十分棘手[4,5]。与ESA不同,ISA的研究更具挑战性,因为在ISA任务中,输入文本只包含几乎类似于“中性的”事实描述,没有直接给出明确的观点态度表达。例如,给定一个句子“快去尝尝那个新品吧!”,句子中不会出现任何显式的情感线索词。然而对于这种隐式情感场景,由于不包含任何显式的情感特征词,在ESA任务中取得过优异性能表现的RGAT[6]、BERT-ADA[7]和TransEncAsp+SCAPT[8]等模型都无法取得令人满意的表现[9]。这是因为目前几乎所有的情感分析模型的工作原理基本都是面向特征词的预测,即必须要找准情感特征词才能准确得到预测。因此,如何挖掘出情感语句中隐藏的情感元素,共同构建出一个完整的情感图谱,以此降低隐式情感分析的难度成为了本文研究的方向。

随着对人类推理过程研究的深入,Wei等人在2022年首次提出了CoT的概念,通过一系列中间的推理步骤,使模型在生成推理结果之前先构建出任务的思维逻辑,使模型学会一步一步地输出推理步骤,直至获得最终答案。图1展示了CoT prompting与标准的prompting在ISA任务上的设计流程示例。受此启发,本文认为隐式情感的推理应该是一个渐进的过程,逐步推断情感元素,最终以从容易到难的方式理解情感的极性。

综合上述研究,本文基于prompt的微调方法,设计了一种三级联合提示推理方法(TLJP),从而使模型实现对情感语句的联合推理,在每一级推理过程中分别推断出给定目标的细粒度方面、对该方面的潜在观点,以上最终的极性。通过这种从简单到困难的层级推理,可以逐步引导出整体情感的隐藏上下文,从而更容易地实现对最终极性的预测。为了实现三级联合提示推理方法,丰富的常识知识和强大的分步多级推理的能力是必不可少的。然而,现有的模型并不具备这样的能力,直接将三级联合提示推理方法应用于隐式情感分析任务很可能无法满足性能上的要求。幸运的是,随着自然语言处理领域的预训练模型的发展,通用大语言模型 (large language models,LLMs) 开始展现出卓越的性能[10]。LLMs拥有非常丰富的世界知识,在常识理解方面表现出非凡的能力[11,12]。在此基础上,本文使用大语言模型实现了TLJP中的前两级提示调优,为情感语句标注方面和潜在观点信息,构建了一种融合LLM的两级提示标注架构,有效地减轻了隐式情感分析任务的困难。为了控制模型的搜索空间,实现标签词与情感极性的准确映射,本文的第三级提示采用了一种融合情感知识的情感分析模型进行最终的情感极性分析,该模型设计了由覆盖范围广泛的同义词组成的标签映射词表,使模型充分利用标签词表中丰富的语义特征,从而提升模型的性能[13]。综上所述,本文提出了一个融合大语言模型的三级联合提示隐式情感分析方法(TPISA),该方法的主要贡献有以下三点:

a)本文提出的TLJP为隐式情感分析提供了一种分步多级推理情感极性的解决方案,使用类人脑思维链的方式逐级获取语句三个关键的情感元素,弥补了隐式情感语句情感特征不足的问题。

b)本文充分利用了大语言模型丰富的世界知识和强大的推理能力,以此来推理情感语句的方面和潜在观点,从而增强了模型对多标签情感语句的理解。

c)本文使用prompt-tuning并利用可训练的连续模板微调情感分析任务,同时提出了一种设计方法,通过建立一个包含广泛同义词的标签映射词典,使模型能够更有效地运用这些标签中的丰富语义特征,实现标签词与情感极性的准确映射,进而提高其性能表现。

1 相关工作

在情感分析领域,根据是否有明确的情感特征词,可以将情感分析任务划分为显示情感分析和隐式情感分析。在情感分析任务的实际应用中,显示情感分析仍然是日常生活中主流的分析场景,其中情感相关的表述词在文本中是明确存在的。而在社交媒体平台上,网民的语言表达十分含蓄、不直观,有着大量的隐式情感表达。根据相关研究表明,文本类语句中的隐式情感语句在情感表达中的比例已经超过了30%,是情感表达中十分重要的组成部分[1]。这意味着对ISA研究有着明确且广泛的应用场景,如网络舆情分析、电子商务评论和网络防诈骗等。

针对ISA中缺少情感特征词而造成情感分析难度大的问题,研究人员利用注意力机制、图神经网络和知识增强等方法进行了大量的研究和尝试。Balahur等人[14]基于常识知识库和上下文信息进行隐式情感分析。Shutova等人[15]通过聚类词来识别相应的隐式情感,在此基础上,采用弱监督和无监督的方法来学习隐喻的分布信息,从而识别句子中的隐喻表达。Deng等人[16]应用循环信念传播在实体之间传播情感,并引入了四个规则方案来揭示情感约束。2019年Xiang等人[17]提出了一种基于注意力的神经网络模型,从多个方面来识别隐式极性,而不是传统的注意力机制那样只关注句子的一个特定方面。Wei等人[18]提出了一个具有多极性正交注意的BiLSTM模型来捕捉单词与情绪极性之间的差异,并设计了正交限制来保持优化过程中的差异。Zuo等人[19]结合隐式情感语句的完整语境提出了一种特定语境的异构化图卷积网络框架,通过上下文语义信息来提高隐式情感语句分析的准确性。Li等人[4]引入了大规模的外部知识来研究基于方面的隐式情感分析任务。

作为情感分析的一个关键分支,隐式情感分析已经得到了充分的探索,如上述提到的研究方法,在特定类型的隐式情感分析问题上有着一定的效果提升,但仍然存在着如分类精度低等缺陷,无法实际应用于所有的隐式情感语句。与显示情感分析任务相比,实际的性能表现也不尽人意。与这些方法不同的是,本文提出了融合大语言模型的三级联合提示隐式情感分析方法(TPISA),将大语言模型与本地预训练模型相结合,使用多级推理的方式逐级得出情感语句中隐含的情感元素,从而增强语句中的情感特征,使模型能够更轻松地推理出最终的情感极性,提高隐式情感分析的性能。

2 模型

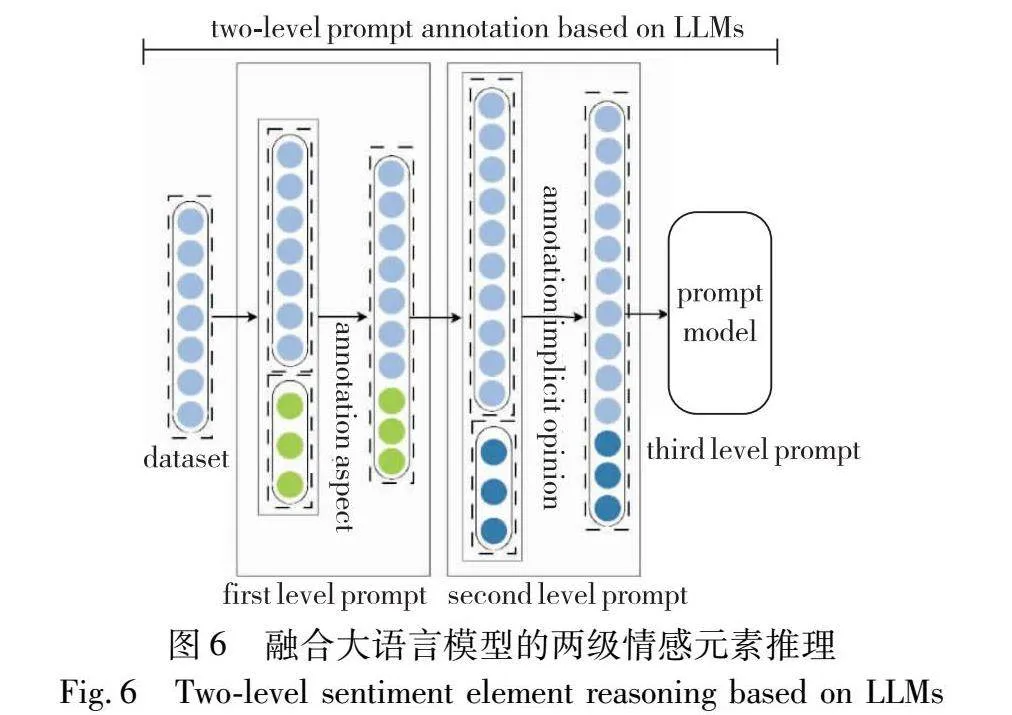

通过对人脑思维过程的研究分析,本文产生了这样的思考:对于例如“这个新手机可以直接放到我的口袋里。”这样的句子,如果情感分析模型能像人类一样,将推断情感极性的过程分解,首先分析出语句可能描述的情感方面“便携性”,然后判断其潜在观点是“好的”,那样最终语句“积极”的极性也可以轻松预测了。根据这样的推理思想,本文设计了三级联合提示推理方法。该方法为情感分析模型处理隐式情感分析任务提供了新思路,以此为基础,本文提出了一种融合大语言模型的三级联合提示隐式情感分析模型。如图1所示,该模型的框架主要包括融合了大语言模型的用于获取情感元素的第一级提示和第二级提示,以及使用了预训练模型进行情感极性分析的第三级提示。在本文中,情感分析任务的定义如下:给定一个句子S,它包含具有给定的目标tT。本文模型的目的是预测目标t在句子S中的情感极性y,即积极的、消极的和中性的(positive, negative and neutral)。

2.1 三级联合提示设计流程

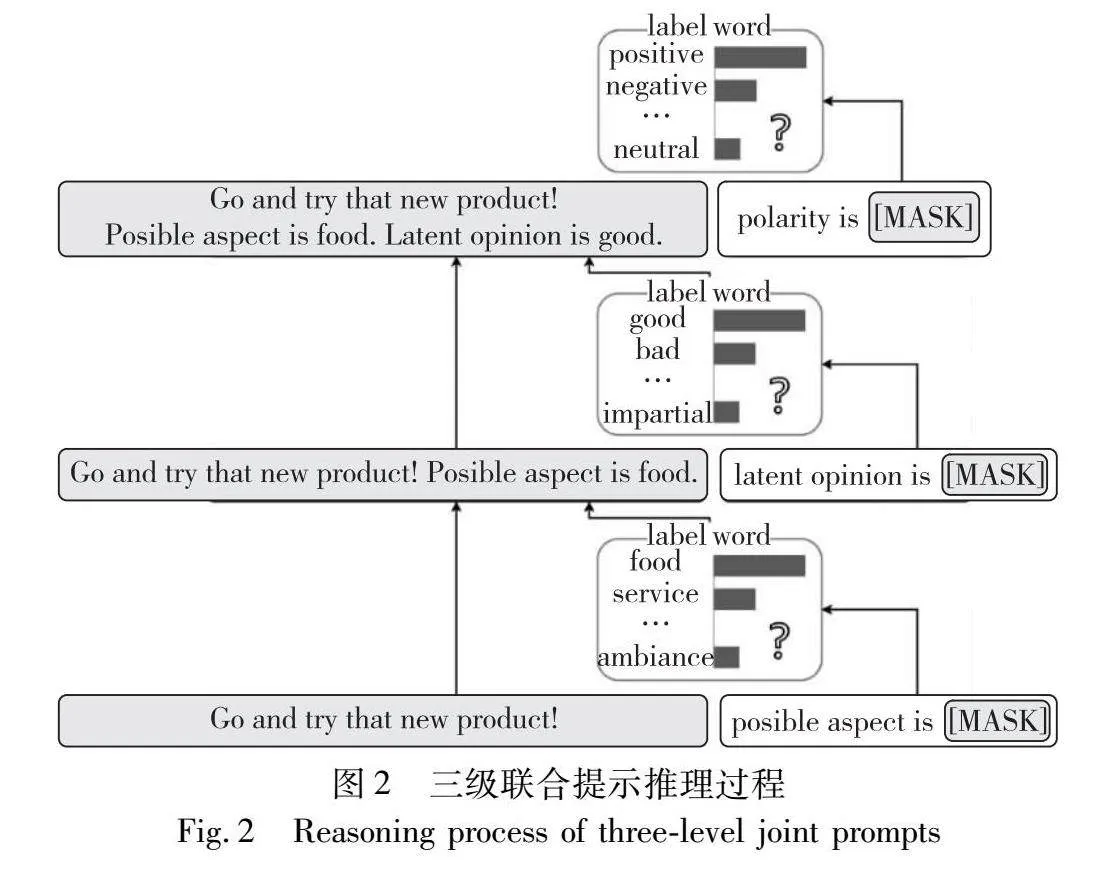

受到人类思维推理过程和思维链式提示(CoT-style prompt)[20,21]的多步推理方法的启发,本文提出了三级联合提示推理方法来逐级推断出情感语句潜在方面、观点和最终的情感极性,图2中展示了该方法的示例。

在本文中,基于prompt机制,每一级提示都会融入前一级的情感知识。这样构造的提示文本不仅增强了模型理解上下文和方面词的能力,而且还实现了情感分析上下游任务的统一,并最大限度地发挥掩码语言模型(masked language model,MLM)的性能。因此本文研究的核心在于在语义上设计一个与情感分析紧密相关的提示模板。具体地,本文首先定义了情感语句可能的方面a和潜在的意见表达式o。详细的三级联合提示文本构造如下:

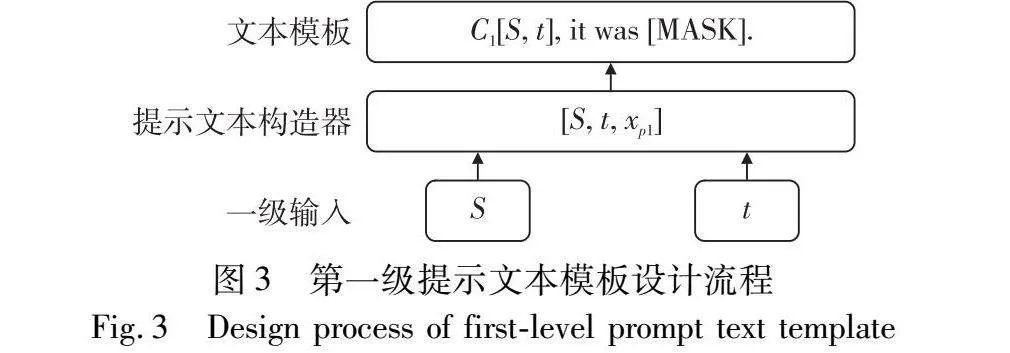

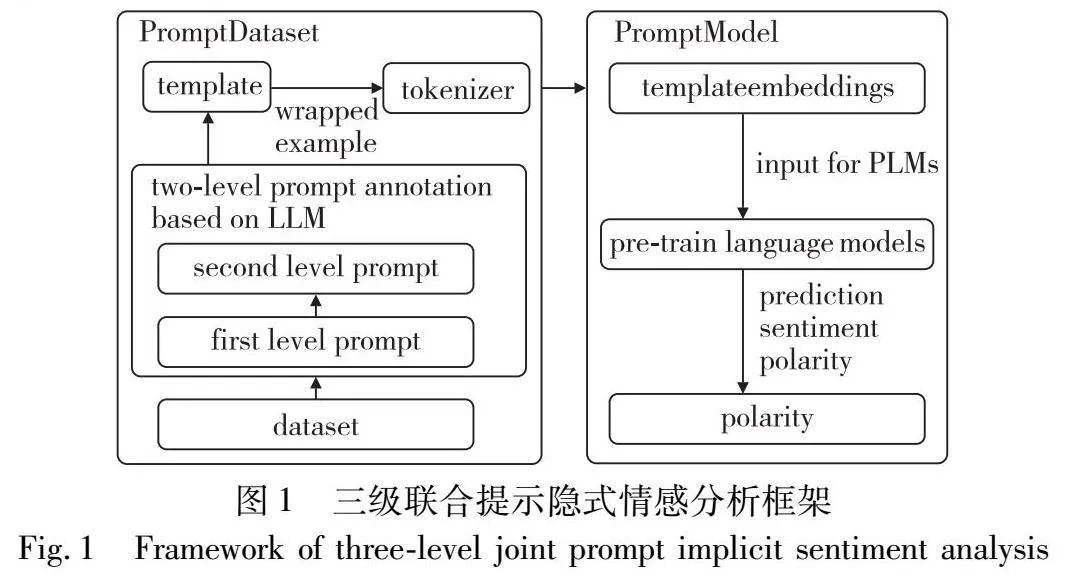

a)第一级。这一级的目标是得到语句S中给定目标t可能的细粒度方面a,将原始输入句子S的上下文语义信息和给定的目标t作为情感知识,根据情感知识构造提示文本。第一级提示的文本模板设计流程如图3所示。

C1是第一级提示的上下文,xp1是根据第一级的情感知识构造的提示文本。这一步可以用式(1)表示。

A=argmax p(a|S,t)(1)

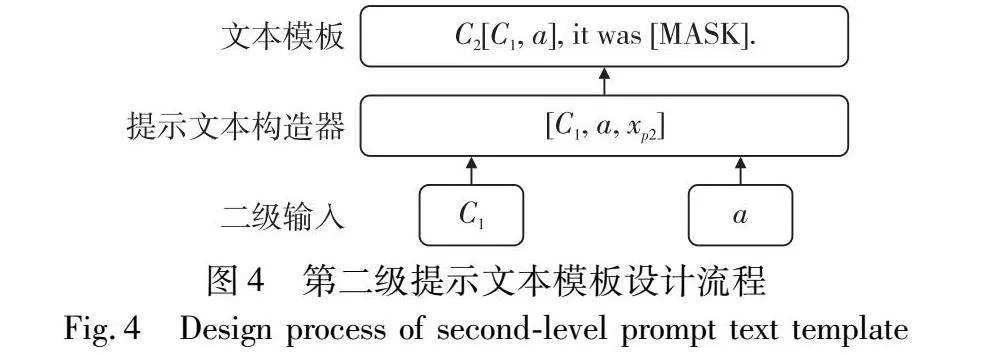

b)第二级。基于C1和第一级提示得到的可能的方面a,继续构造模板,得到语句S中关于目标t的潜在观点o。具体的文本模板设计流程如图4所示。

C2是连接S、t和a的第二级提示的上下文,xp2是根据第二级的情感知识构造的提示文本。通过这一步可以得到语句S中属于方面a的目标t的潜在观点o。这一步可以公式化为

O=argmax p(o|S,t,a)(2)

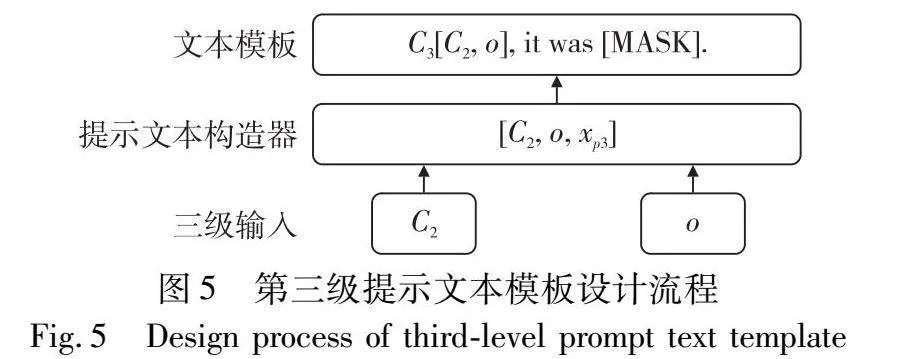

c)第三级。以完整的情感框架(S、t、a和o)作为上下文,构造提示模板,利用模型推断出极性t的最终答案,第三级提示的文本模板设计流程如图5所示。

图5 第三级提示文本模板设计流程

Fig.5 Design process of third-level prompt text template

C3是第三级提示的上下文,xp3是根据第三级的情感知识构造的提示文本。这一步骤可以表示为

=argmax p(y|S,t,a,o)(3)

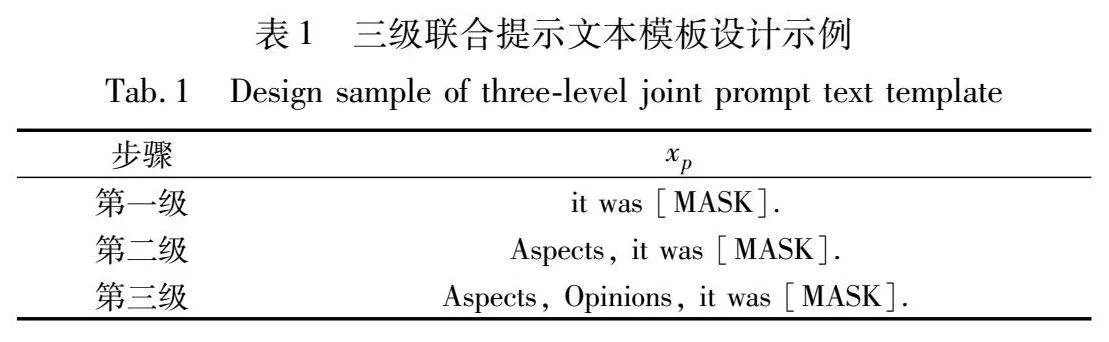

从三级联合提示的文本模板的设计流程可以看出,针对不同领域数据集,提示文本会设计为不同的组成形式,表1中展示了针对SemEval2014 Restaurant数据集的三级联合提示文本模板的部分设计示例。

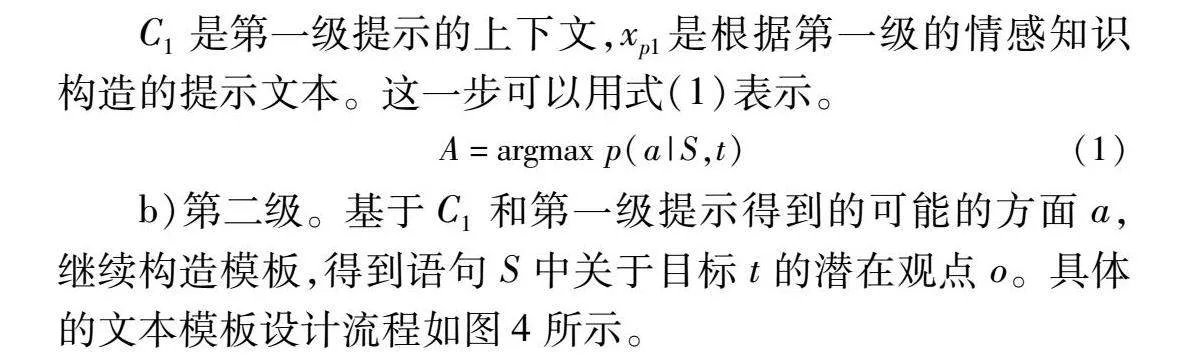

2.2 融合大语言模型的两级情感元素推理

在任务实现过程中,使用提示微调的模型进行三级联合提示的方案并没有带来模型性能上的提升,反而有了明显的下降。这可能是三级联合提示使模型变得过于庞杂,同时情感语句经过多次构建提示模板变得更为复杂,模型难以理解。而三级联合提示又需要强有力的常识推理和多级分步推理的能力。针对上述问题,本文将前两级提示推理过程与第三级提示推理过程分离开来,借助大语言模型LLMs的卓越性能实现对给定情感语句的推理。图6展示了融合大语言模型的前两级情感元素推理结构。

2.2.1 构建大语言模型的提示模版

在融合了LLMs的情况下,本文通过对原三级联合提示模板的改造,构建了新的适应于大语言模型的提示模板,从而相当于为第三级模型构建一个初始的注释数据集。具体的两级提示模板设计流程如下:

第一级。构造提示模板,直接询问LLMs语句S中提及的目标t的方面a是什么:

C1[S]. Which specific aspect of t is possibly mentioned?

第二级。基于S、t和a,构造如下模板,向LLMs询问由第1级提示得到的关于方面a的潜在观点:

C2[C1, A]. Based on the common sense, what is the implicit opinion towards the mentioned aspect of t?

2.2.2 情感元素的推理增强

一个问题越需要深思熟虑的思考和分析,则通往最终答案的推理路径的多样性就越大[22]。而本文研究的隐式情感分析需要的就是复杂的思考和分析过程,因此,隐式情感分析的推理路径应是多样的,而非单一的。本文在模型中引用了Wang等人[23]提出的自一致性机制来保障大语言模型推理的正确性。首先,从模型的解码器中采样,生成不同的推理路径。每个推理路径都可能给出方面a和观点o的不同预测,保留其中置信度高的答案。最后将其应用到下一步的文本输入之中。

2.3 融合情感知识的第三级提示模型

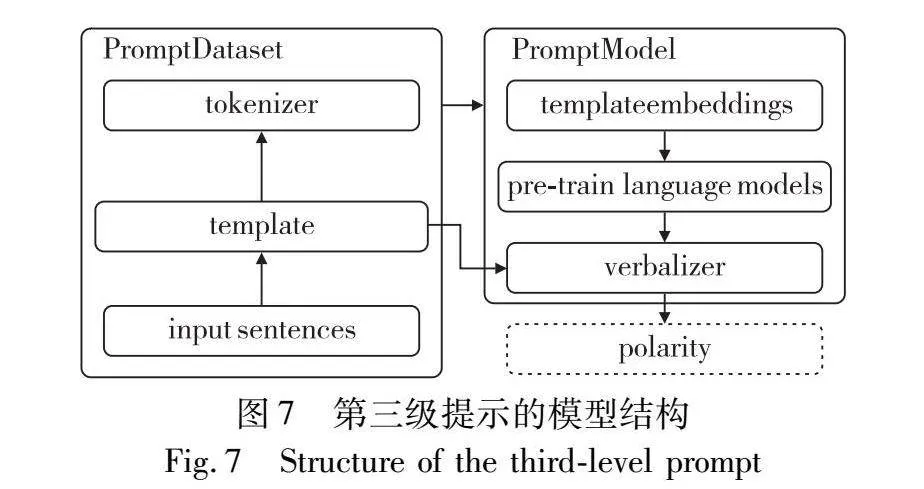

第三级提示是三级联合提示隐式情感分析方法的最后一步,目标是根据前两级提示得到的情感知识,通过构造相应的提示模板,将获得的方面词、潜在观点和提示文本等语义信息进行融合,增强预训练语言模型对输入语句的情感信息的理解,最后经过情感标签词的映射,得出最终的情感极性。尽管大语言模型已经在数据标注、特征提取和尝试推理等领域展现出了强大的性能。但是,大语言模型高昂的运算成本对大规模的文本内容分析构成了巨大的阻碍。同时,本地的预训练语言模型在处理舆情分析等敏感和涉密领域的任务上有着不可替代的优势。因此,本文在第三级提示中,选择使用预训练语言模型进行情感极性的推理。图7展示了第三级提示的模型结构。

深度学习模型与外部知识的结合越来越紧密,利用外部知识可以提高深度学习模型的效果[24]。在第三级提示中,首先基于prompt机制构造提示文本,将它与前两级提示获得的情感元素和情感语句进行融合,然后通过预训练模型获得输入序列的文本向量表示,再经过情感标签词映射层进行情感极性的映射,获得最终的情感分类结果。

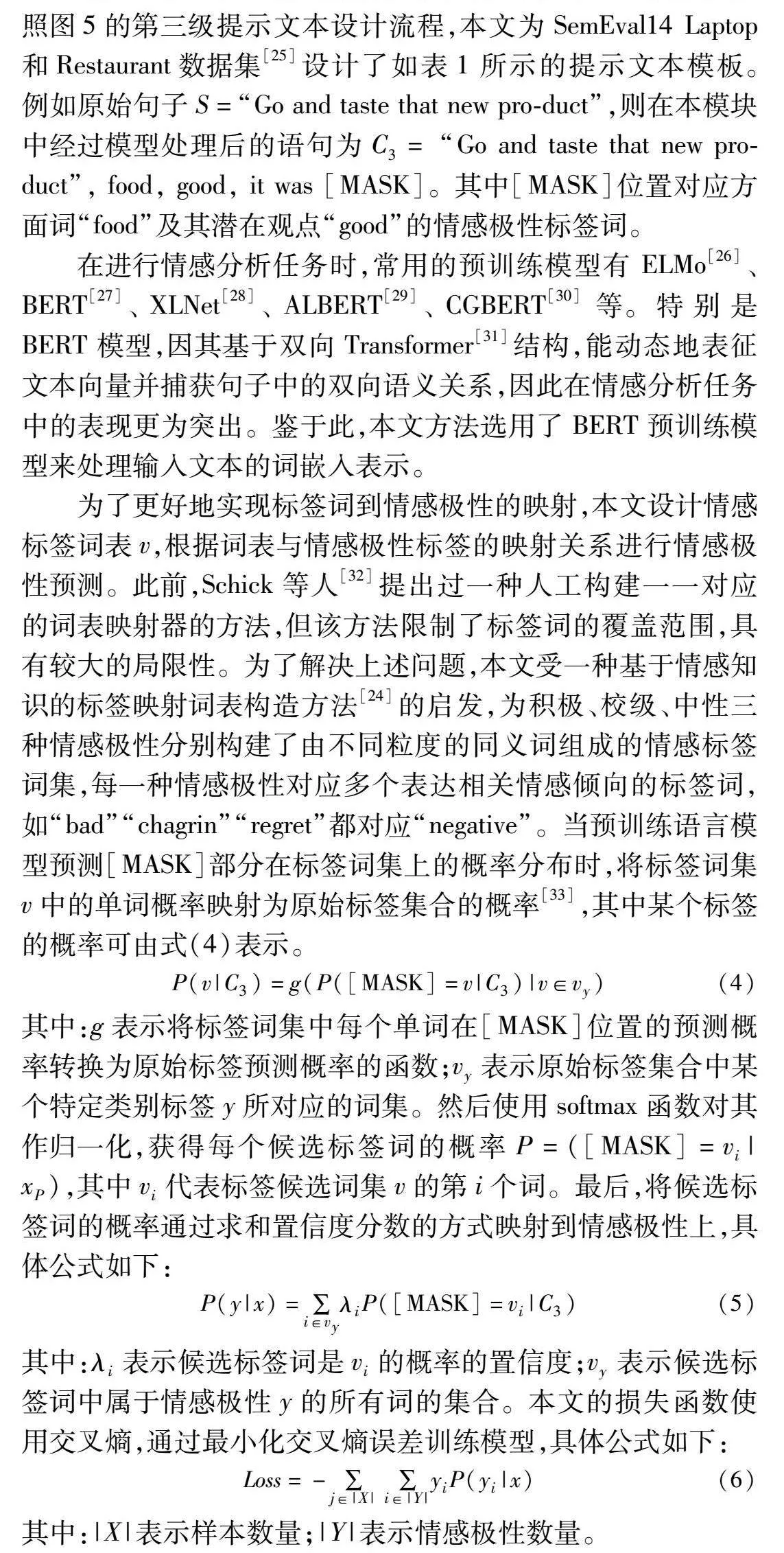

在输入中添加提示文本,提升模型对下游任务的感知能力,可充分激发预训练模型的潜力[13]。因此,结合本文提出的三级联合提示的推理流程,本文中亟待解决的问题就是设计一个在语义上能够满足隐式情感分析任务要求的提示模板。按照图5的第三级提示文本设计流程,本文为SemEval14 Laptop和Restaurant数据集[25]设计了如表1所示的提示文本模板。例如原始句子S=“Go and taste that new pro-duct”,则在本模块中经过模型处理后的语句为C3= “Go and taste that new pro-duct”, food, good, it was [MASK]。其中[MASK]位置对应方面词“food”及其潜在观点“good”的情感极性标签词。

在进行情感分析任务时,常用的预训练模型有 ELMo[26]、BERT[27]、XLNet[28]、ALBERT[29]、CGBERT[30]等。特别是 BERT 模型,因其基于双向Transformer[31]结构,能动态地表征文本向量并捕获句子中的双向语义关系,因此在情感分析任务中的表现更为突出。鉴于此,本文方法选用了 BERT 预训练模型来处理输入文本的词嵌入表示。

为了更好地实现标签词到情感极性的映射,本文设计情感标签词表v,根据词表与情感极性标签的映射关系进行情感极性预测。此前,Schick等人[32]提出过一种人工构建一一对应的词表映射器的方法,但该方法限制了标签词的覆盖范围,具有较大的局限性。为了解决上述问题,本文受一种基于情感知识的标签映射词表构造方法[24]的启发,为积极、校级、中性三种情感极性分别构建了由不同粒度的同义词组成的情感标签词集,每一种情感极性对应多个表达相关情感倾向的标签词,如“bad”“chagrin”“regret”都对应“negative”。当预训练语言模型预测[MASK]部分在标签词集上的概率分布时,将标签词集v中的单词概率映射为原始标签集合的概率[33],其中某个标签的概率可由式(4)表示。

P(v|C3)=g(P([MASK]=v|C3)|v∈vy)(4)

其中:g表示将标签词集中每个单词在[MASK]位置的预测概率转换为原始标签预测概率的函数;vy表示原始标签集合中某个特定类别标签y所对应的词集。然后使用softmax函数对其作归一化,获得每个候选标签词的概率P=([MASK]=vi|xP),其中vi代表标签候选词集v的第i个词。最后,将候选标签词的概率通过求和置信度分数的方式映射到情感极性上,具体公式如下:

P(y|x)=∑i∈vyλiP([MASK]=vi|C3)(5)

其中:λi表示候选标签词是vi的概率的置信度;vy表示候选标签词中属于情感极性y的所有词的集合。本文的损失函数使用交叉熵,通过最小化交叉熵误差训练模型,具体公式如下:

Loss=-∑j∈|X| ∑i∈|Y|yiP(yi|x)(6)

其中:|X|表示样本数量;|Y|表示情感极性数量。

3 实验

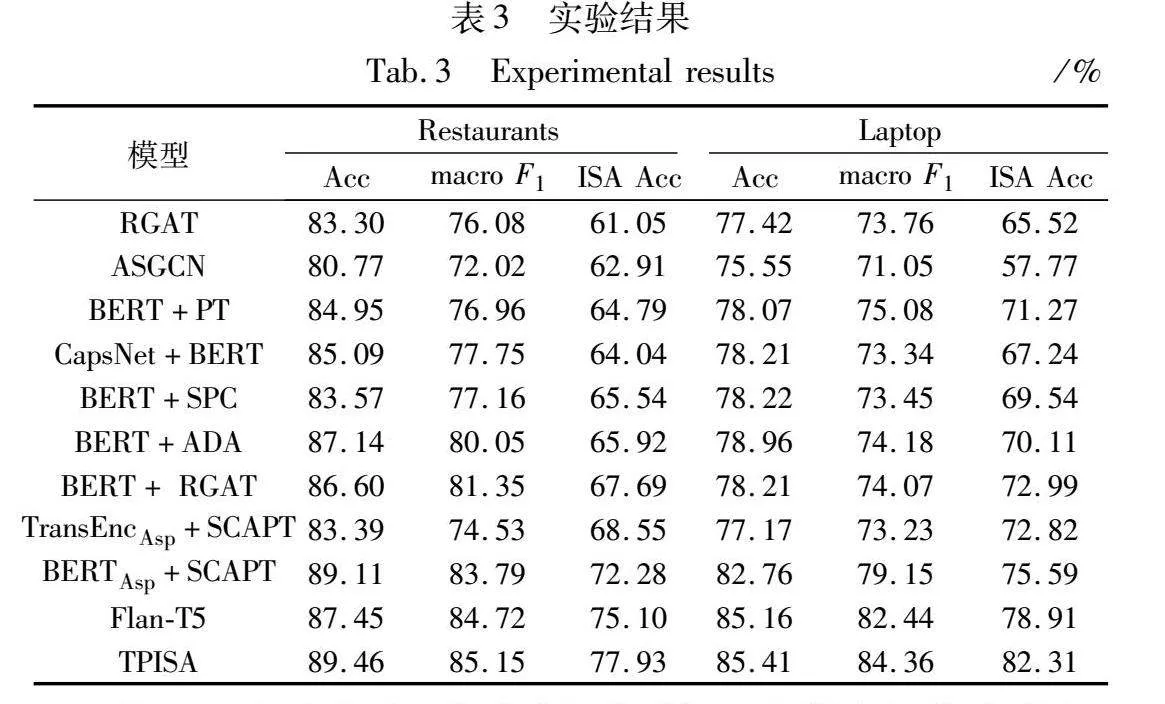

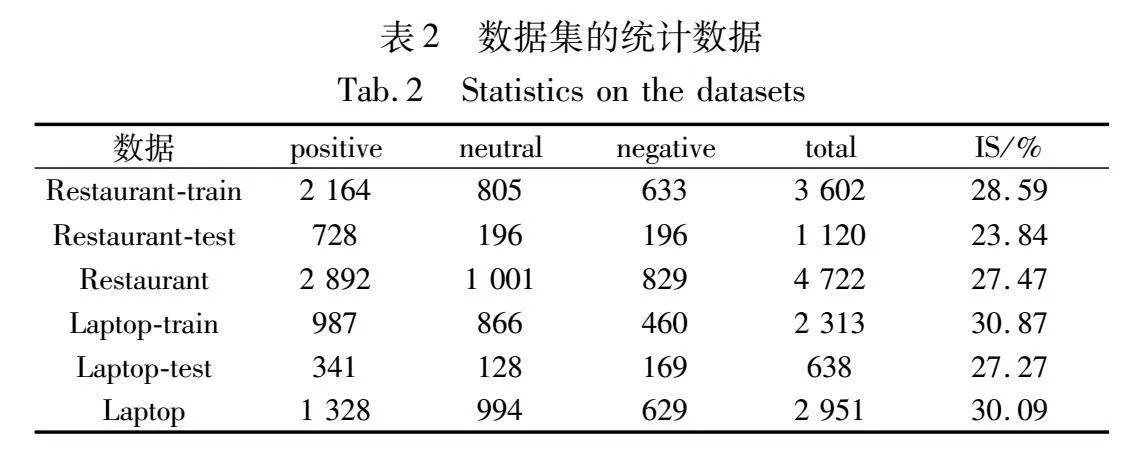

为了验证本文提出的融合大语言模型的三级联合提示隐式情感分析方法的有效性,本文根据Li等人[4]的研究,将基准的SemEval14 Laptop和Restaurant数据集的所有实例分为显式和隐式情感,表2展示了数据集划分的详细信息。同时,得益于 Fan 等人[34]的工作,本文选择的数据集包含了为目标方面注释的意见词。本实验通过将TLJP模型与目前最先进的模型进行对比,以验证该模型的情感分析能力。

3.1 实验配置

本文实验使用了Python 3.8的深度学习库Torch 1.11.1+CUDA113实现。实验使用了ChatGPT[35]作为主干LLM,并通过提示的方式调用API来进行实验测试。为了验证本文提出的方法在隐式情感分类任务上的性能表现,本文采用宏平均值(macro F1)和准确率(accuracy,Acc)作为实验的评价指标;对比模型参考了隐式情感分析领域的相关文献,选取了其中基于注意力机制的模型、基于图神经网络的模型、基于知识增强的模型、基于大规模语料库的预训练模型、其他基于大语言模型的情感分析五类模型中的一些公开的基础模型以及常用的基线模型进行对比实验,它们包括RGAT[6]、ASGCN[36]、BERT+PT[37]、CapsNet+ BERT[38]、BERT+SPC[27]、BERT+ADA[27]、BERT+RGAT[6]、TransEncAsp+ SCAPT[8]、BERTAsp+SCAPT[8]和Flan-T5[39]。

3.2 实验结果与分析

为了验证TPISA模型在隐式情感分析任务上的效果,本文在SemEval14 Laptop和Restaurant数据集上进行了详细的对比实验,表3中展示了具体的实验数据和结果。

从表3中的实验数据分析可以得出,在所有比较模型中,多个基于图神经网络的模型(RGAT、ASGCN)与基于知识增强的模型(BERT+PT、CapsNet+BERT、BERT+SPC、BERT+ADA、BERT+RGAT)的性能均要低于最优性能基线BERTAsp+SCAPT。BERTAsp+SCAPT对大规模的情感方面语料库进行了重新预训练,因此对情感分析表现出了较强的能力。而TPISA模型在SemEval14 Laptop和Restaurant数据集的隐性情感分析任务上,准确率分别达到了77.93%和82.31%,与当前最先进的模型BERTAsp+SCAPT相比,提高了5.65和6.72百分点,这是因为本文模型通过分级推理添加提示文本的方式,由易到难地挖掘输入语句的情感信息,并充分利用了大语言模型丰富的世界知识和强大的推理能力,有效地减轻了隐式情感分析任务的困难。此外,在饮食情感分析任务上,Flan-T5模型表现也十分出色,但仍略逊于本文提出的TPISA,这表明,本文使用GPT获取情感元素的选择是正确的。上述实验结果验证了经过三级提示增强的预训练模型在隐式情感分析任务上的效果表现更加优异,证明了融合大语言模型的方法能降低模型捕获情感信息的难度,说明了本文提出的TPISA方法的有效性。

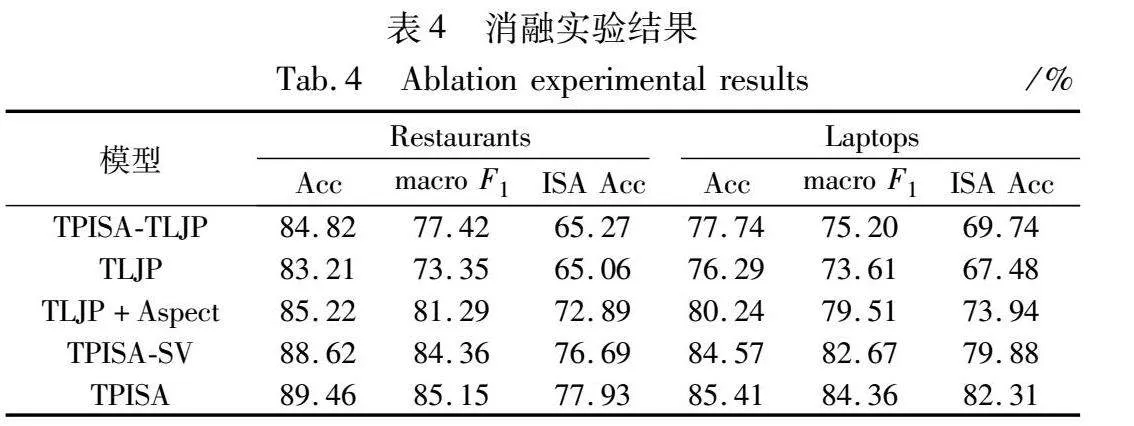

3.3 消融实验

为了验证本文提出的三级联合提示推理方法和融合了大语言模型来获取情感元素的有效性,本文进行了消融实验,实验的具体结果如表4所示。其中,TLJP表示模型中不使用LLMs,仅将三级联合提示推理方法运用到基础的基于prompt的预训练模型中;TPISA-TLJP表示不使用三级联合提示推理方法的模型;TLJP+Aspect表示仅保留第一级和第三级的两级联合提示推理方法的模型;TPISA-SV表示在TPISA模型的基础上,去除掉情感标签词映射(sentiment verbalizer,SV)模块。从表4中可以看出,在不使用三级联合提示方法的模型基础上仅增加一级针对方面的提示推理模型,在最终性能表现有了一定的提高,分别为72.89%和73.94 %,这证明本文通过提示推理增加情感语句的思路是有效的。而仅使用了TLJP,不融合大语言模型的方法在性能上的表现仅为65.06%和6748%,甚至低于只有一级提示的基于prompt的预训练模型TPISA-TLJP的65.27%和69.74%。这可能是因为多级的提示增强虽然增加了情感语句的特征信息,同时也增加了语句结构的复杂度,反而增加了基础模型在情感分析任务上的难度,所以整体上的效果与当前的情感分析模型相比有着明显的下降。因此,本文模型利用大语言模型丰富的常识知识和强大的推理能力进行模型的前两级提示,某种程度上简化了模型整体的复杂性。TPISA-SV的实验结果表明,在去除了SV模块后,模型的性能表现略有下降,这证明了SV模块的有效性。通过多个模块的消融实验,证明了本文方法和模型在隐式情感分析任务上能够有效提升模型的性能,在隐式情感分析任务中有着一定的优势。

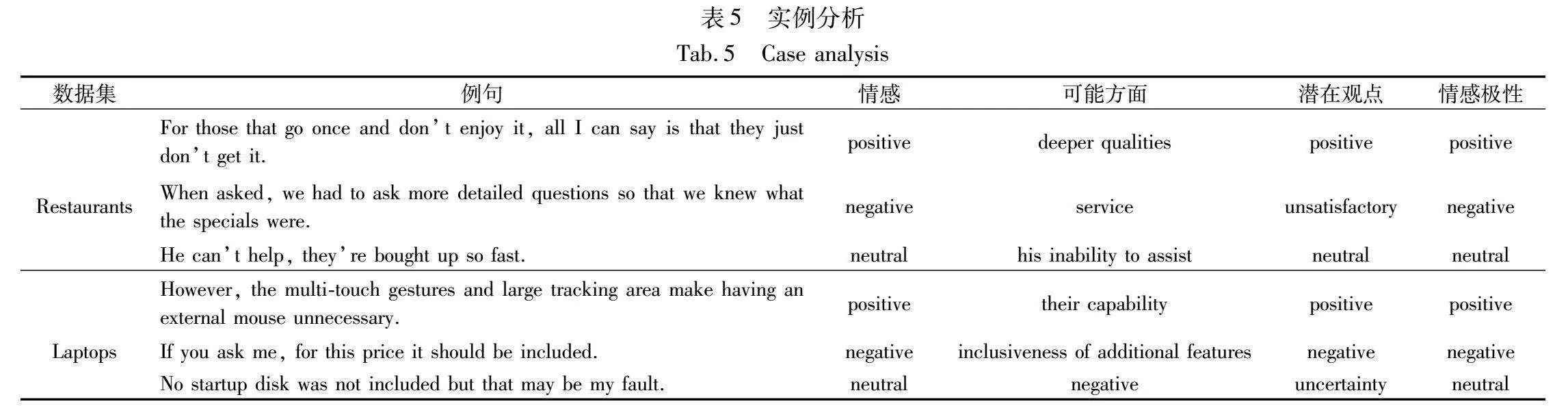

3.4 实例分析

为了进一步分析本文提出的融合大语言模型的三级联合提示隐式情感分析方法在隐式情感分析任务上的有效性,本文在对比模型未正确分析出极性的情感语句中分别选取了情感为积极、消极和中性的六条样例,并对它们在TPISA中的分析过程进行实例分析,具体的对比结果如表5所示。

从表5中可以看出,选取的例句都是缺少直接的情感特征词的语句,这也是它们没有被其他对比模型准确分析出情感极性的重要因素。例如表5中的例句“When asked, we had to ask more detailed questions so that we knew what the specials were.”,TPISA充分利用了大语言模型丰富的世界常识和强大的推理能力,可以十分容易地获取到例句的可能方面“service”和潜在观点“unsatisfactory”,这两点情感元素与原语句形成了带有明显情感特征词的新的情感语句,达到了引入情感知识的效果。进一步到第三级提示中,模型就可以很轻松地分析出情感语句最终“negative”的情感极性了。

通过以上实例分析可以清晰地看到,本文提出的TPISA方法,将语句进行分步分析、逐级挖掘出其中的可能方面和潜在观点,从而丰富情感实例的情感元素,降低最后一级模型处理隐式情感分析任务的难度,最终得到正确的情感极性,在隐式情感分析任务上有着可靠且有效的性能表现。

4 结束语

本文提出了一种融合大语言模型的三级联合提示隐式情感分析方法。该方法旨在通过多级推理的方式,由易到难地逐级推理,并最终得出情感极性。首先利用大语言模型强大的推理能力,通过构建两级提示分两步获得输入语句的方面词和潜在观点;然后构建第三级提示文本,并将其与前两步中获得的情感元素进行拼接,构成新的融合了情感知识的输入,将该语句输入到预训练模型,最终分析得出情感极性,完成隐式情感分析任务。

为了验证该方法的有效性,本文在SemEval14 Laptop和Restaurant数据集上进行了充分的实验。实验结果表明,TPISA比现有的最佳性能基线表现出了更令人印象深刻的性能。总的来说,本文的TPISA为隐式情感分析提供了一种优秀的解决方案。通过精心设计的三级联合提示推理过程,TPISA方法能够更全面、更准确地理解文本中的情感倾向。实验结果也充分证明了本文方法在隐式情感分析任务中的有效性,为未来的情感分析研究提供了新的思路和方法。

参考文献:

[1]Pang Bo, Lee L. Opinion mining and sentiment analysis [J]. Foundations and Trends in Information Retrieval, 2008,2(1-2):1-135.

[2]Dong Li, Wei Furu, Tan Chuanqi,et al. Adaptive recursive neural network for target-dependent twitter sentiment classification [C]// Proc of the 52nd Annual Meeting of the Association for Computational Linguistics. Stroudsburg, PA: Association for Computational Linguistics,2014: 49-54.

[3]Shi Wenxuan, Li Fei, Li Jingye,et al. Effective token graph modeling using a novel labeling strategy for structured sentiment analysis [C]// Proc of the 60th Annual Meeting of the Association for Computational Linguistics. Stroudsburg, PA: Association for Computational Linguistics, 2022: 4232-4241.

[4]Li Zhengyan, Zou Yicheng, Zhang Chong,et al. Learning implicit sentiment in aspect-based sentiment analysis with supervised contrastive pre-training [C]// Proc of Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2021: 246-256.

[5]Wang Siyin, Zhou Jie, Sun Changzhi,et al. Causal intervention improves implicit sentiment analysis [C]// Proc of the 29th International Conference on Computational Linguistics. [S.l.]: International Committee on Computational Linguistics, 2022: 6966-6977.

[6]Wang Kai, Shen Weizhou, Yang Yunyi,et al. Relational graph attention network for aspect-based sentiment analysis [C]// Proc of the 58th Annual Meeting of the Association for Computational Linguistics. Stroudsburg, PA: Association for Computational Linguistics, 2020: 3229-3238.

[7]Rietzler A, Stabinger S, Opitz P,et al. Adapt or get left behind: domain adaptation through BERT language model finetuning for aspect-target sentiment classification [C]// Proc of the 12th Language Resources and Evaluation Conference. [S.l.]: European Language Resources Association, 2020: 4933-4941.

[8]SCAPT-ABSA [EB/OL]. (2022-02-03). https://github.com/tribleave/scapt-absa.

[9]王昱婷, 刘一伊, 张儒清, 等. 基于提示学习的文本隐式情感分类 [J]. 山西大学学报, 2023, 46(3): 509-517. (Wang Yuting, Liu Yiyi, Zhang Ruqing,et al. Learning implicit sentiment via prompt tuning [J]. Journal of Shanxi University:Natural Science Edition, 2023, 46(3): 509-517.)

[10]Ye Junjie, Chen Xuangting, Xu Nuo,et al. A comprehensive capabi-lity analysis of GPT-3 and GPT-3. 5 series models [EB/OL]. (2023-03-18) [2024-03-19]. https://doi.org/10.48550/arXiv.2303.10420.

[11]Paranjape B, Michael J, Ghazvininejad M,et al. Prompting contrastive explanations for commonsense reasoning tasks [C]// Findings of the Association for Computational Linguistics: ACL-IJCNLP 2021. Stroudsburg, PA: Association for Computational Linguistics, 2021: 4179-4192.

[12]Liu Jiacheng, Liu Alisa, Lu Ximing,et al. Generated knowledge prompting for commonsense reasoning [C]// Proc of the 60th Annual Meeting of the Association for Computational Linguistics. 2022: 3154-3169.

[13]张心月, 刘 蓉, 魏驰宇, 等. 融合提示知识的方面级情感分析方法 [J]. 计算机应用, 2023, 43(9): 2753-2759. (Zhang Xinyue, Liu Rong, Wei Chiyu,et al. Aspect-based sentiment analysis method with integrating prompt knowledge [J]. Journal of Computer Applications, 2023 (9): 2753-2759.)

[14]Balahur A, Hermida J M, Montoyo A. Detecting implicit expressions of emotion in text: a comparative analysis[J]. Decision Support Systems, 2021, 53(4): 742-753.

[15]Shutova E, Teufel S, Korhonen A. Statistical metaphor processing [J]. Computational Linguistics, 2013, 39(2): 301-353.

[16]Deng Lingjia, Wiebe J. Sentiment propagation via implicature constraints [C]// Proc of the 14th Conference of the European Chapter of the Association for Computational Linguistics. Stroudsburg, PA: Association for Computational Linguistics, 2014: 377-385.

[17]Xiang Chunli, Ren Yafeng, Ji Donghong. Identifying implicit polarity of events by using an attention-based neural network model [J]. IEEE Access, 2019, 7: 133170-133177.

[18]Wei J, Liao J, Yang Z, et al. BiLSTM with multi-polarity orthogonal attention for implicit sentiment analysis [J]. Neurocomputing, 2020, 383: 165-173.

[19]Zuo Enguang, Zhao Hui, Chen Bo,et al. Context-specific heterogeneous graph convolutional network for implicit sentiment analysis [J]. IEEE Access, 2020, 8: 37967-37975.

[20]Wei J, Wang Xuezhi, Schuurmans D,et al. Chain-of-thought promp-ting elicits reasoning in large language models [J]. Advances in Neural Information Processing Systems, 2022, 35: 24824-24837.

[21]Fu Yao, Peng Hao, Sabharwal A,et al. Complexity-based prompting for multi-step reasoning [EB/OL]. (2023-01-30) [2024-03-19]. https://doi.org/10.48550/arXiv.2210.00720.

[22]Evans J S B T. Intuition and reasoning: a dual-process perspective [J]. Psychological Inquiry, 2010, 21(4): 313-326.

[23]Wang Xuezhi, Wei J, Schuurmans D,et al. Self-consistency improves chain of thought reasoning in language models [C] // Proc of International Conference on Learning Representations. 2023.

[24]Bengio Y, Others. From system 1 deep learning to system 2 deep learning[EB/OL].(2019). https://neurips.cc/virtual/2019/invited-talk/15488.

[25]Pontiki M, Galanis D, Pavlopoulos J,et al. SemEval-2014 task 4: aspect based sentiment analysis [C]// Proc of the 8th International Workshop on Semantic Evaluation. Stroudsburg, PA: Association for Computational Linguistics, 2014: 27-35.

[26]Peters M E, Neumann M, Iyyer M,et al. Deep contextualized word representations [C]// Proc of Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Stroudsburg, PA: Association for Computational Linguistics, 2018: 2227-2237.

[27]Devlin J, Chang M W, Lee K,et al. BERT: pre-training of deep bidirectional transformers for language understanding [C]// Proc of Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Stroudsburg, PA: Association for Computational Linguistics, 2019: 4171-4186.

[28]Yang Zhilin, Dai Zihang, Yang Yiming,et al. XLNet: generalized autoregressive pretraining for language understanding [EB/OL]. (2019)[2024-03-19]. https://doi.org/10.48550/arXiv.1906.08237.

[29]Lan Zhenzhong, Chen Mingda, Goodman S,et al. ALBERT: a lite BERT for self-supervised learning of language representations [EB/OL]. (2019) [2024-03-19]. https://doi.org/10.48550/arXiv.1909.11942.

[30]Wu Zhengxuan, Ong D C. Context-guided BERT for targeted aspect-based sentiment analysis[C]// Proc of AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI Press, 2021: 14094-14102.

[31]Vaswani A, Shazeer N, Parmar N,et al. Attention is all you need [C]// Proc of the 31st International Conference on Neural Information Processing Systems. Red Hook, NY: Curran Associates Inc., 2017:6000-6010.

[32]Schick T, Schütze H. Exploiting cloze-questions for few-shot text classification and natural lbzWXur5oeHnabt1+uuWwCA==anguage inference [C]// Proc of the 16th Conference of the European Chapter of the Association for Computational Linguistics: Main Volume. Stroudsburg, PA: Association for Computational Linguistics, 2021: 255-269.

[33]Hu Shengding, Ding Ning, Wang Huadong,et al. Knowledgeable prompt-tuning: incorporating knowledge into prompt verbalizer for text classification [EB/OL].( 2021) [2024-03-19]. https://doi.org/10.48550/arXiv.2108.02035.

[34]Fan Zhifang, Wu Zhen, Dai Xinyu,et al. Target-oriented opinion words extraction with target-fused neural sequence labeling [C]// Proc of Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Stroudsburg, PA: Association for Computational Linguistics, 2019: 2509-2518.

[35]Ouyang Long, Wu J, Jiang Xu,et al. Training language models to follow instructions with human feedback [J]. Advances in Neural Information Processing Systems, 2022, 35: 27730-27744.

[36]Zhang Chen, Li Qiuchi, Song Dawei. Aspect-based sentiment classification with aspect-specific graph convolutional networks [C]// Proc of Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2019: 4567-4577.

[37]Xu Hu, Liu Bing, Shu Lei,et al. BERT post-training for review rea-ding comprehension and aspect-based sentiment analysis [C]// Proc of Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Stroudsburg, PA: Association for Computational Linguistics, 2019: 2324-2335.

[38]Jiang Qingnan, Chen Lei, Xu Ruifeng,et al. A challenge dataset and effective models for aspect-based sentiment analysis [C]// Proc of Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Proces-sing. Stroudsburg, PA: Association for Computational Linguistics, 2019: 6280-6285.

[39]Chung H W, Hou Le, Longpre S,et al. Scaling instruction-finetuned language models [EB/OL]. (2022) [2024-03-19]. https://doi.org/10.18653/arXiv.2210.11416.