中小学教师数字素养测评问卷的本土化构建

2024-10-11彭红超朱凯歌

摘要:推动教育数字化,教师是中坚力量。教育部2023年发布的《教师数字素养》教育行业标准(简称《标准》),为准确评估我国教师数字素养水平提供了参照。但是仅有标准尚无法有效诊断教师数字素养发展状况,测评工具亦不可少。国内外虽然已有一些教师数字素养评估工具,但并非对标我国《标准》,评估的适切性不高。数字素养包括信息素养和数据素养两大核心内涵,《标准》从数字化意识、数字技术知识与技能、数字化应用、数字社会责任以及专业发展5个维度对我国教师数字素养进行了规定。在结合国际主流数字素养框架对我国《标准》进行详细分析基础上,按照“选用经典+自建补充”的方式构建了我国中小学教师数字素养测评问卷。该问卷依次经历四大环节的验证与修订:用于保障内容效度的专家评估与认知审查、用于保障题项区分度与代表性的项目分析、用于保障结构效度的探索性与验证性因子分析,以及用于保障同类题项聚类效果的收敛效度分析。修订后问卷具备良好的模型拟合度和内部一致性,可用于教师自查、研修项目前后测,以及区域、学校层面的摸排调查。

关键词:中小学教师;数字素养;测评工具;调查问卷

中图分类号:G434 文献标识码:A 文章编号:1009-5195(2024)05-0072-11 doi10.3969/j.issn.1009-5195.2024.05.008

基金项目:2023年度国家社会科学基金教育学重点项目“数字教育背景下的教学范式创新与实践探索研究”(ACA230019);2024年度教育部人文社会科学研究青年基金项目“人机协同教学中教师决策的过程诊断及优化策略研究”(24YJC880105)。

作者简介:彭红超,博士,助理研究员,华东师范大学开放教育学院(上海 200062)。朱凯歌,博士研究生,华中师范大学人工智能教育学部(湖北武汉 430079);讲师,平顶山学院文学院(河南平顶山 430079)。

一、引言

教育数字化转型是推动教育信息化由融合应用向创新发展转变、保障教育优质发展、实现教育强国目标的重要举措。2021年,教育部等六部门发布《关于推进教育新型基础设施建设构建高质量教育支撑体系的指导意见》,提出要“深入应用5G、人工智能、大数据、云计算、区块链等新一代信息技术,充分发挥数据作为新型生产要素的作用,推动教育数字转型”(中华人民共和国教育部,2021)。随后,教育数字化上升为国家战略并被写入党的二十大报告。

推动教育数字化,教师是中坚力量。2023年初,教育部在首届世界数字教育大会上发布《教师数字素养》教育行业标准(以下简称《标准》),这是继《中小学教师教育技术能力标准(试行)》《中小学教师信息技术应用能力标准(试行)》后又一重要标准,对精准评估我国教师队伍的数字素养水平、落实国家教师发展数字化行动具有重要意义。

《标准》解决了“评什么”的问题,但仅有标准还不足以有效诊断教师数字素养发展状况,测评工具亦不可少。纵观国内外研究,目前一些学者、国际组织和国家虽然制定了教师数字素养能力框架和评估工具,但并非对标我国《标准》而开发,评估的适切性不高,这势必给我国教师数字素养的评估及其研训成效的保障带来不便,尤其是对作为教育强国基点(新华社,2023)的基础教育而言。为此,本研究将以《标准》为参照,聚焦中小学教师,研制其数字素养的评价问卷,为准确、便捷地评估中小学教师数字素养提供支持。

二、教师数字素养概述

1.数字素养的发展

因应数字技术的快速发展和广泛应用,数字素养成为继文字、语言、算术之后,每个公民都应该具备的第四大基本素质和能力(Australia Government,2020)。本质上,数字技术是将图文声像等转化为计算机可以识别的二进制来进行运算、加工、存储、传送、传播、还原的技术,如网络通信技术、人工智能等。数字技术及其载体——电子设备的发展推动了数字素养内涵的变迁。

上世纪末,随着计算机网络成为人们获取信息的主要手段,理解并应用计算机进行阅读、写作以及处理更复杂的数字信息成为现实需要,由此数字素养的概念应运而生(Lenham,1995)。此后20年,数字素养的核心内涵逐渐由基本的计算机技能发展为集数字信息处理、数字媒体制作、线上交流与协作为一体的综合能力(UNESCO,2011)。随着人类社会步入大数据时代,如何从大数据中获得有价值的信息并生成深刻的见解成为数字素养的新要求(European Commission,2017a)。近年来,伴随人工智能的快速发展,如何与人工智能联袂、共生成为数字素养培育的新方向(European Commission,2022)。

2.教师数字素养的内涵辨析

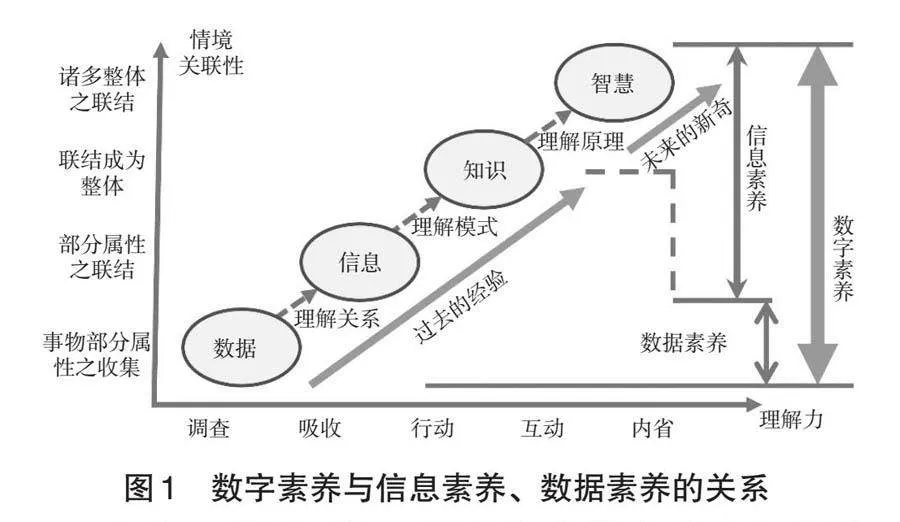

由数字素养的发展来看,数字素养应包括信息素养和数据素养,聚焦到教师的数字素养,亦是如此。教育部发布的《标准》指出,教师的数字素养是教师适当利用数字技术获取、加工、使用、管理和评价数字信息和资源,发现、分析和解决教育教学问题,优化、创新和变革教育教学活动而具有的意识、能力和责任。这里将数据也作为一种数字信息(吴砥等,2020),只不过这种信息是离散的、没有上下文和注解的,而其中提到的解决教育教学问题、优化革新教育教学活动,则是一种基于教师洞见的智慧行为(Insight-Based Wise Action),这种洞见来源于对数字信息中内隐特征(即趋势、规律或模式)的发掘(彭红超等,2018)。综合上述分析,从DIKW(Data-Information-Knowledge-Wisdom)模型(Clark,2012)角度看,教师的数字素养贯穿数据层至智慧层,如图1所示。

信息素养,是个体恰当利用信息技术来获得、管理、表达、整合和评价信息以及建构新知识、分析和解决问题、开展社会交往的态度和能力(中华人民共和国教育部,2018)。本质上,这是一种对数字信息进行审辨性地获得、管理、表达和创新,以作出智慧行为或决策的综合能力。这里的信息通过将数据进行关系连接而形成了某种意义(Wallace,2007),表现为图、文、声、像、表等。从DIKW模型看,数字素养由信息素养、数据素养构成,自下而上涵盖数据、信息、知识和智慧四个层级。数字素养是信息素养的延伸,延伸的部分,即是数据素养。教师数据素养是合理获取、理解、评价、管理教育数据,并将其转化为信息的综合能力(李新等,2019)。这类素养旨在从数据中解析得到可改进教学过程、优化学习成效的证据(触及DIKW模型的知识层)(Mandinach et al.,2016),促使教与学科学化。因此,数据素养也是信息素养的延伸和扩展。从DIKW模型看,这是一种错位下沉式延伸(见图1)。

由以上分析可知,随着教育数字化进程的推进,对教师信息化教学能力的要求发生了变化:由信息素养延展为数字素养,即不但要求教师能够制作课件、使用Office等信息工具,还要求其能够对教育数据进行收集、分析与解读,以及使用诸如智慧黑板、点阵笔、电子班牌等智能化或数字工具,以赋能教育教学实践、优化与创新教学过程。

三、教师数字素养评估框架分析

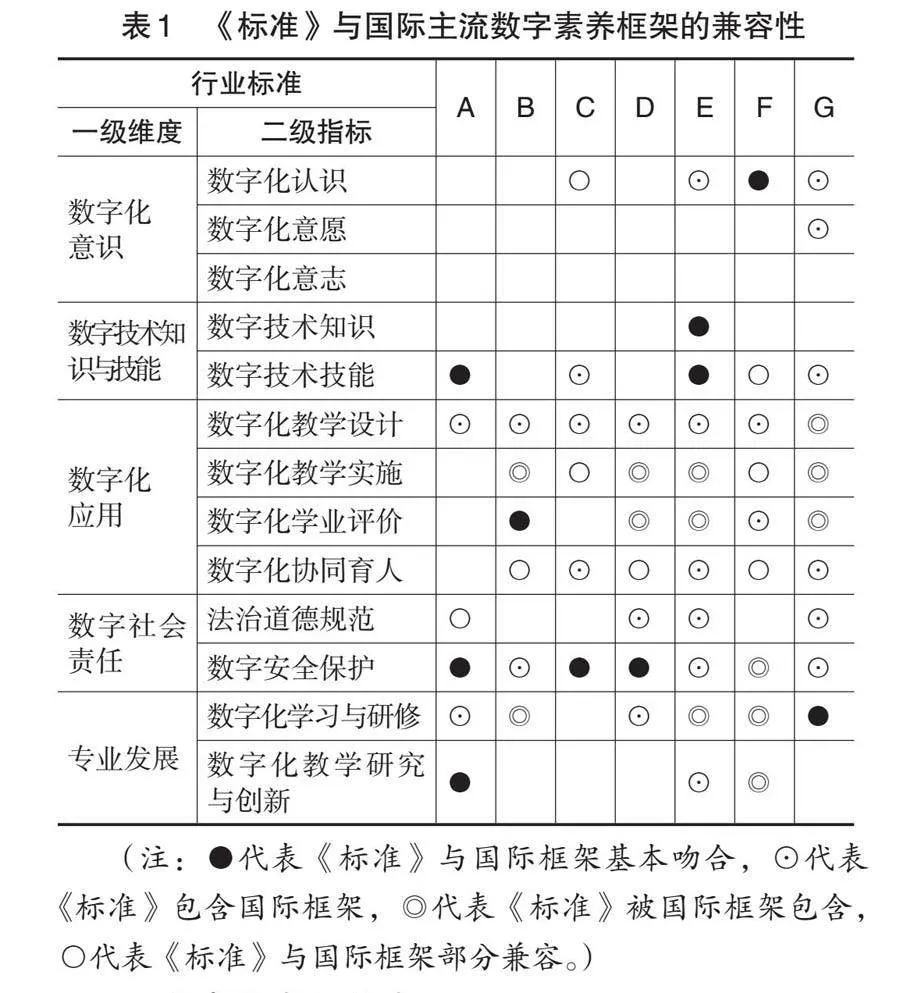

教育部发布的《标准》包括数字化意识、数字技术知识与技能、数字化应用、数字社会责任以及专业发展5个维度,它与UNESCO、欧盟等国际组织以及英国、西班牙等国家发布的教师数字素养评估框架基本兼容,兼容程度如表1所示。其中,A指代UNESCO发布的《教师信息和通信技术能力框架》中的数字素养部分(UNESCO,2018),B指代欧盟委员会发布的《欧盟教育者数字素养框架》(European Commission,2017b),C指代英国教育培训基金会发布的《数字化教学专业框架》(ETF,2023),D指代西班牙国家教育技术和教师培训研究所研制的《教师通用数字素养框架》(INTEF,2022),E指代奥地利国家能力中心研制的《教师素养框架》(Brandhofer et al., 2021),F指代挪威教育和培训部发布的《教师专业数字能力框架》(Kelentrić et al.,2018),G指代我国教育部发布的《中小学教师信息技术应用能力标准(试行)》。由于UNESCO 2018年发布的《全球数字素养技能参考框架4.4.2》、欧盟2022年发布的数字素养框架DigComp2.2均未涉及教育者,这里未有关注。

1.数字化意识维度

数字化意识是客观存在的数字化相关活动在教师头脑中的能动反映,包括有主见的数字化认识、有态度的数字化意愿和有信念的数字化意志三个方面。数字技术应用于教育之初,便因实践效果低于传统教育(OECD,2019),且还产生了数字鸿沟等新型教育公平问题而引发了争议(彭红超等,2023)。在这样的状况下,教师能否正确认识数字技术的价值、能否主动学习和使用数字技术、能否克服数字化教育中遇到的困难,必然成为能否有效开展数字化教育教学的前提条件。《标准》在国际主流的数字素养框架上(仅关注教师对数字技术的价值、重要性的认识),增补了对教师主动性(数字化意愿)和信心信念(数字化意志)的要求。前者对标国家之“教师主动适应信息化、人工智能等新技术变革,积极有效开展教育教学”的新时代教师队伍建设目标(新华社,2018),后者聚焦应对教育数字化转型(如教学模式之创新、范式之重构)面临的挑战与风险。

2.数字技术知识与技能维度

数字技术知识与技能聚焦教师在日常教育教学活动中应了解的数字技术知识与需要掌握的数字技术技能,前者关注数字技术“是什么”,后者关注“如何使用”数字技术。与国际大多数数字素养框架不同,我国《标准》更加强调这一维度的重要性,对教师应具备的数字技术知识更是提出了明确要求:不但要了解常见数字技术的概念、基本原理,也要掌握数字技术资源的选择策略及使用方法。原因主要有二:第一,这是教师实现数字技术与教育教学深度融合的基本要求(吴砥等,2023);第二,教师数字技术知识的缺失会对其素养提升带来显著阻碍,这也是从能力提升工程2.0的实施中吸取的经验:《中小学教师信息技术应用能力标准(试行)》未对教师本身应具备的信息技术知识与技能给予足够关注,造成能力提升工程2.0推进中,教师对智慧学习环境中的能力点望而生畏,培训后很多教师和学校的绩效也没有提升至预期水平。数字技术知识与技能是数字时代教师作为普通公民应具备的基本素养,是常见的数字技术概念、基本原理等通识类知识,而非人工智能算法、大数据挖掘等专识类知识,主要用于支持教师合理选择、适当应用数字技术支持自身教学与发展。

3.数字化应用维度

数字化应用是教师应用数字技术资源开展教育教学活动的能力,包括聚焦有效教学的数字化教学设计、体现需求驱动的数字化教学实施、刻画核心素养的数字化学业评价以及面向全面发展的数字化协同育人。与“数字技术知识与技能”维度关注数字技术本身的操作不同,这里侧重的是技术赋能教育教学的可能性,是教师应具备的专业性质的数字素养。设计作为人类第三智慧(科学、人文分别为第一、二智慧)(柳冠中,2013),是决定技术能否发挥潜能之关键(祝智庭等,2017a)。《标准》在这方面的指标比任何国际框架都全面,不仅关注数字资源的获取、管理与制作,数字化活动的设计,还关注学习情况的数字化分析以及混合环境的创设(国际已有框架一般仅关注了1~2个方面)。例如,与挪威的数字素养框架不同,《标准》要求教师能够创设环境而不只是了解,这是从“停课不停学”中吸取到的经验;与奥地利的框架不同,《标准》将创设的环境聚焦于混合学习环境,以对标“我国未来学习之近景是混合学习”这一教育数字化要义(祝智庭,2020)。

教育数字化追求教学范式重构,其创新发展必然要由智能评测、智能管理等外围场景深入到课堂教学等核心场景,这也是教育信息化2.0的主要任务。《标准》对教师数字化教学实施的要求,集中于课堂教学并指向了教学过程中的深度学习与个性化体验(彭红超等,2021),同时,《标准》也弱化了欧盟、西班牙等框架对学生自主学习的关注,着重强调教师本体的能力。《标准》与欧盟的框架较吻合之处是数字化学业评价,二者均关注评估策略、数据分析与反馈等数据素养的核心内容。数字化协同育人是《标准》对国家健全学校家庭社会协同育人机制重要部署(中华人民共和国教育部,2023)作出的响应,也是教育数字化实现从系统封闭向系统开放转变的主要途径。尽管国际主流的框架并没有在维度上体现这一点,但部分内容中也体现了相关精神。例如,欧盟的框架在专业化参与维度中要求教师能够使用数字技术加强与学习者、父母和社会的沟通,英国的框架在实用技能维度中要求教师培养数字技术应用技能等。

4.数字社会责任维度

数字社会责任是指教师在数字化活动中应该具备的道德修养和行为规范,包括不危害社会的法治道德规范以及不受社会危害的数字安全保护。作为物理实在社会与数字虚拟社会深度融合形成的社会形态,数字社会将社会关系网络化、生产资料数字化,同时也将人们的交往对象扩展至陌生人,由此产生了责任危机(没有责任感是陌生人对陌生人的一般态)(田旭明,2022)。在“大众不知我是谁”以及“网络行为无人监督”的刻板印象下,道德、法律、安全等面临前所未有的挑战。对此,《标准》要求教师作为数字公民的一员,以身作则,自觉规范上网、积极维护网络秩序并做好个人隐私与工作数据等方面的安全防护。虽然国际主流框架均有此方面的要求(见表1),但《标准》将之上升到了“责任”之高度,强调了教师“传道、授业、解惑”之育人使命。此外,相较国际框架,《标准》还有以下特色:第一,聚焦教师自身应具备的数字规范与安全素养;第二,社会维护与自我防护并重。

5.专业发展维度

这里的专业发展关注教师利用数字技术资源促进自身及共同体专业发展的能力,包括面向教学能力提升的数字化学习与研修,以及面向科研能力提升的数字化教学研究与创新。相比2014年的《中小学教师信息技术应用能力标准(试行)》,数字化教学研究与创新是《标准》新增加的要求,这方面UNESCO、奥地利、挪威的框架中也有涉及,特别是挪威还关注对地方课程修改以及对相关政策制定的贡献。数智时代,教育目标正从以知识为本向以素养为本转变,教学要素正从四要素向五要素转变(新增要素为数据),教学主体正从师生二维向师生机三维转变,教学范式正从教学供给驱动向需求驱动转变。面对这些变化,原有的教学模式已力不从心,“教学创新”自然成为教师必备的专业素养。对于数字化学习与研修,《标准》主要继承了2014年的要求,但其与UNESCO、欧盟等国际主流框架不同的是更注重教研对教师专业发展的价值。

四、中小学教师数字素养问卷构建

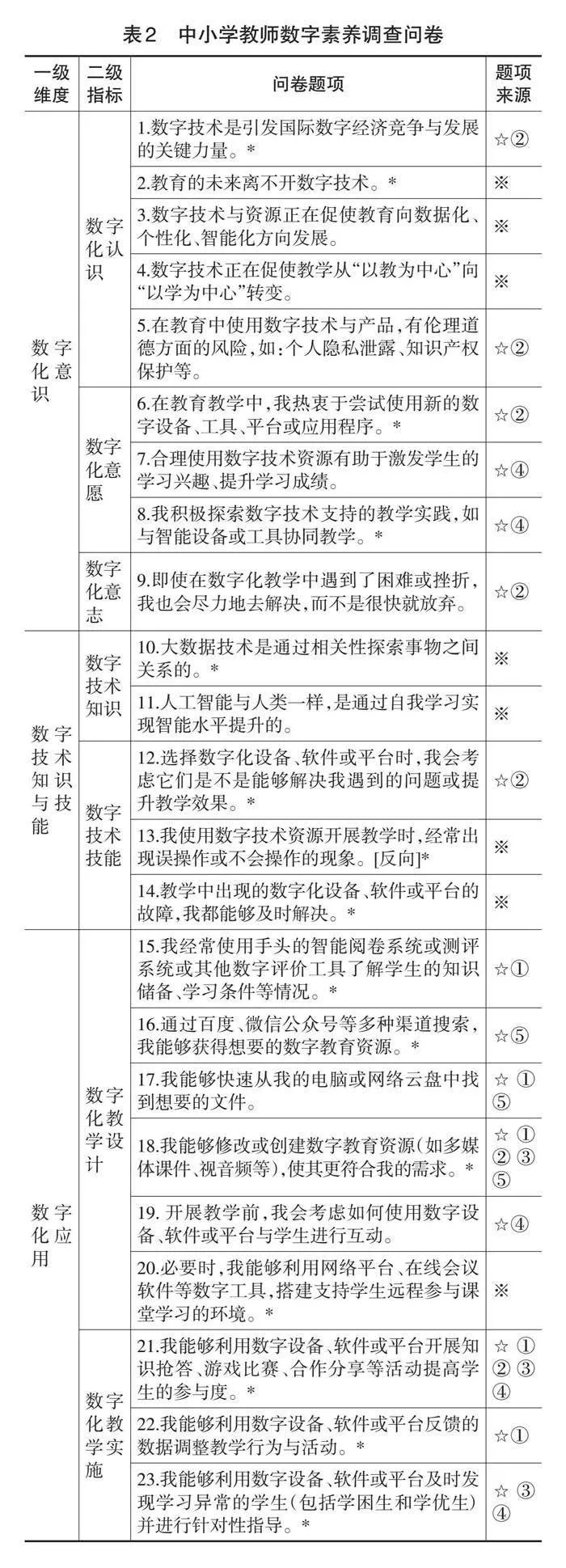

基于上述认识,研究检索国内外相关的问卷,并按照“选用经典+自建补充”题项的方式设计问卷(Li et al.,2015),以保证问卷的质量。

其中,“选用经典”是指依据《标准》各维度的表述,直接或修改后引用已有问卷的相关表述。参考的问卷有5套,包括:(1)Sánchez-Cruzado等人设计的ACDC(Analysis of Common Digital Competences)问卷,这套问卷基于西班牙的《教师通用数字素养框架》设计而成,从知识类别和类别利用率两个视角对教师在信息、内容选择或创建、沟通、安全和问题解决等5个方面的素养进行了评估(Sánchez-Cruzado et al.,2021)。(2)欧盟委员会制定的DigCompSAT问卷(Digital Competence Self-Assessment Tool)。该问卷是针对欧盟公民数字能力的自查工具,由82道题目组成,从知识、技能和态度三个层面对公民的信息和数据素养、沟通与协作、数字内容创作、安全和问题解决等5个维度、21种数字能力进行评估(Clifford et al.,2020)。(3)欧盟委员会面向教育者制定的DigCompEdu(European Framework for the Digital Competence of Educators)问卷(European Commission,2017b)。该问卷由22个题目组成,其中的协同育人题项具有良好的参考价值。(4)Abbiati等人研制的TET-SAT(The Technology-Enhanced Teaching Self-Assessment Tool)问卷(IZA-Institute of Labor Economics,2023)。该问卷涵盖信息通信技术的态度、使用、知识和意识等维度,其中与数字化意愿相关的题项值得参考。(5)Peled开发的用于职前教师数字素养水平自查的SRDL(The Self-Report Digital Literacies)问卷。该问卷由数据收集、数据评估、数据管理、数据处理、团队合作、诚信意识和社会责任等7个领域的54个题项组成(Peled,2021),其中关于法治道德规范的内容值得借鉴。

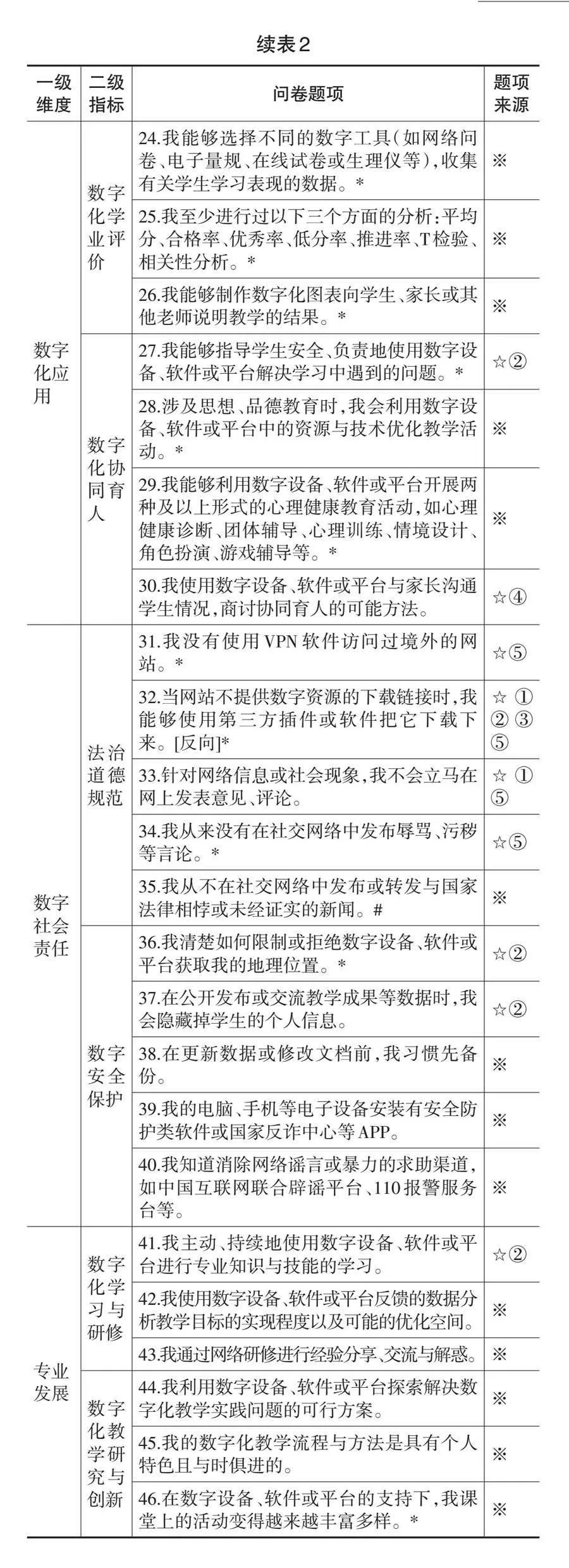

“自建补充”是指对《标准》中数字化意志等没有可参考题项的维度,采用焦点小组法依赖专家群体智慧来补充。最终,形成的问卷主体共有45个题项。问卷采用李克特五级量表法,并用1、2、3、4和5表示题项描述与被调查者情况的符合程度(分别对应非常不同意、不同意、一般、同意、非常同意);反向题采用反向计分,以保持得分与被调查者数字素养水平的一致性。

为保障问卷题项的合理性以及表述的质量,避免试测环节出现系统性偏差,需要对问卷进行事前评估。专家评估是判定问卷整体结构与题项表述是否恰当的重要依据(DeVellis,2012),认知审查是挖掘调查对象对题项的理解与研究者原本意图一致性程度的方法(Willis,2005)。本研究结合上述两种方法对问卷题项进行评估。其中,专家评估采用视频会议形式进行,先向邀请的9名教育数字化专家(副高以上职称占比55.6%)就问卷的设计理念与过程进行讲解,之后请各专家单独根据发放的基本评估表围绕问卷题项的全面性、表述清晰度、有无歧义或多重含义、是否符合中小学教师的专业背景等进行评估,收集各专家的评估数据并按照题项进行统计分析。团队成员根据专家建议讨论、修改或增加相应题项,如此经过两轮修订。认知审查采用半开放式问卷,要求邀请的137名一线优秀教师(来自7个省市、15个学科)就修订后的问卷进行试填写,并对各题项表述的清晰度、倾向性、双重含义、情境适宜性等进行即时反馈。经过专家评估和认知审查,共修正了26个题项,如“数字技术的发展会引发国际数字经济的竞争与发展”修正为“数字技术是引发国际数字经济竞争与发展的关键力量”;并增加1个题项,即“我从不在社交网络中发布或转发与国家法律相悖或未经证实的新闻”。最终形成的中小学教师数字素养调查问卷如表2所示。

五、问卷的信效度检验

1.问卷发放

为验证研制的中小学教师数字素养调查问卷的信度和效度,研究按照方便抽样(Handy Sampling)(林崇德,2003)的方式发放网络问卷,并通过在问卷中置入“此题为指定选项题,请选择非常不符合”等指示题,剔除无效样本,解决网络问卷容易出现的不认真作答问题(Dunn et al.,2018)。最终共回收来自东部(上海、山东)、中部(河南、江西、山西)和西部(广西、云南、陕西、内蒙古)地区9个省份的有效问卷690份,参与调查的教师涵盖城市、乡镇和农村地区,占比分别为28.8%、31.3%和39.9%。其中,男、女教师分别占30.1%和69.9%,教龄段占比分别为18.4%(5年以下)、39.1%(6~15年)、25.0%(16~25年)和17.5%(25年以上),小学、初中和高中分别占55.5%、30.7%和13.8%,中级以下、中级和高级职称分别占27.4%、39.4%和33.2%,涵盖的中小学学科共计15个,具有较好的代表性。

2.项目分析

问卷题项需要具有良好的区分度和代表性以鉴别出被调查者的不同水平。这方面的检验可用项目分析法。本研究分别采用临界比检验和相关性分析的方法进行项目分析。

临界比检验通过T检验计算高低组中各题项得分差异的显著性,检验区分度(李宝敏等,2018),不显著的题项可删除或修改。将有效问卷总得分排名前27%的定为高分组(≥214分)、后27%的定为低分组(≤178分),进行独立样本T检验,结果显示各题项的差异均显著(p<0.05),表明问卷的各题项具有较好的区分度。

相关性分析通过分析各个题项得分与问卷总得分之间的相关程度检验代表性。相关系数在0.3至0.8之间表明题项良好(李爽等,2015)。分析结果显示,仅第13题的相关系数为0.28,小于0.3,删除;剩余各题项的相关系数均落在代表性良好的区间内。

3.信度检验

信度通常采用克隆巴赫Alpha(Cronbach’s α)系数作为评估指标。研究分别对问卷整体和各个维度的内部一致性进行检验。结果显示:问卷整体的Cronbach’s α值为0.98,各个维度的Cronbach’s α值分别为0.90、0.79、0.97、0.89和0.94,均大于0.7,表明问卷的稳定性、内部一致性良好(DeVellis,2012)。

4.效度检验

问卷应能准确测量想要测量的构念实质,即要有良好的效度。内容效度和区分效度等通过上述专家评估、认知审查以及项目分析得以保障,结构效度通常采用探索性因子分析和验证性因子分析进行检验(Gerbing et al.,1996)。前者考查问卷的公共因子数及其与模型维度的关系,后者验证问卷的公共因子结构与整个理论模型的吻合度(Sürücü et al.,2020)。 Hair等人(1998)指出,当子集样本量足够时,可将调查数据随机分为两个子集来估计每个子集的因子模型。据此,本研究将收集到的690份有效问卷随机分为等额的两份(记为样本A和样本B),样本A用于探索性因子分析,样本B用于验证性因子分析。鉴于结构效度主要关注问卷的整体结构,对于测量同一构念特质的题项是否归于同一维度,研究则采用收敛效度分析进行检验。

(1)探索性因子分析

研究首先使用SPSS26.0对样本A进行因子分析的适宜性判断,结果表明:KMO综合值为0.955,处于优秀水平(Kaiser,1974); Bartlett球形度检验χ2=12567.18,P=0.00<0.01,在统计学上具有显著意义,说明对样本A进行探索性因子分析能够得到可靠的结果。随后,研究采用主成分分析法进行探索性因子分析,结果显示:第5、16题出现在其维度外的一个独立因子中,第6、10、12、32、36、38题同时横跨多个因子且因子载荷系数均在0.4以上,第37、40为冗余题,因此这些题项均被删除。

修订后的问卷共有35题,KMO综合值为0.949,Bartlett球形度检验χ2 =10018.33,P=0.00<0.01。再次因子分析表明,共有5个公共因子的特征值大于1.0(如图2所示),第5个特征值之后的曲线趋于平缓。前5个公共因子的累计方差贡献率达到67.25%,大于60%,说明修正后的问卷能够较好地测量出想要测量的构念实质(Hinkin,1998),各因子下题项的载荷系数如表3所示。

(2)验证性因子分析

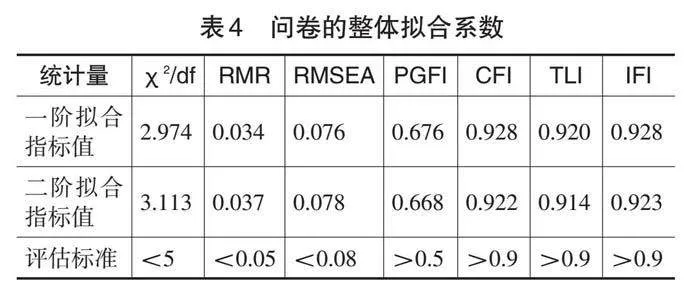

使用AMOS20.0对样本B进行验证性因子分析,分别构建一阶和二阶结构模型以检验问卷结构与其所依据理论模型之间的一致程度 ,具体关注卡方与自由度比值(χ2/df)、残差均方根(RMR)、近似误差均方根(RMSEA)、简效拟合优度指数(PGFI)、比较拟合指数(CFI)、Tucker-Lewis系数(TLI)和增量适配指数(IFI)等指标评估问卷的结构方程模型拟合度(李宝敏等,2018;Hu et al., 1999)。分析结果如表4所示,各个拟合指标均达到评估标准,说明修订后的问卷模型与理论模型的整体拟合度良好。

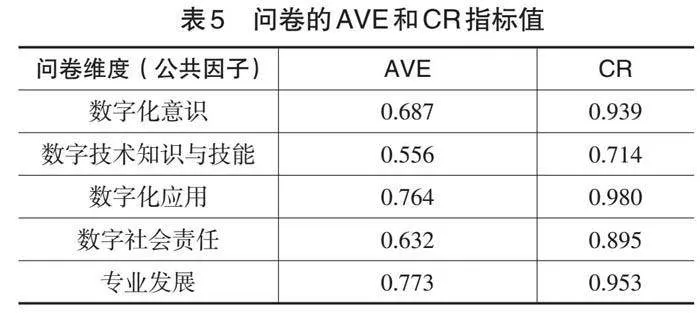

(3)收敛效度分析

采用标准化因子负荷值、平均方差提取值(AVE)和组合信度(CR)三个指标对修订后的问卷进行收敛效度分析。结果显示:问卷各题项的标准化因子负荷值的范围为0.67~0.92,均大于0.6,说明各题项与其公共因子的相关系数处于可接受范围(Carmines et al.,1979) ;AVE值均大于0.5(见表5),说明公共因子的变异被其题项解释的程度良好(Fornell et al.,1981); CR均大于0.7(见表5),说明各公共因子内的题项一致性较强(Bacon et al.,1995)。综合此三个结果,可判定修订后的问卷收敛效度较好。

5.修订后问卷信度检验

采用Cronbach’s α重新检验修订后的问卷,结果显示:问卷整体的Cronbach’s α 值为0.97,信度较高;各维度的Cronbach’s α 值分别为0.92(DC)、0.60(DS)、0.97(DA)、0.86(DR)、0.94(DD),其中,DS维度的信度可接受(Streiner,2003),其余维度的信度较高。

六、结语

本研究系统梳理了数字素养发展脉络,发现数字素养已经从基本技术技能发展成为复杂的综合能力,并具有了数智时代特色。基于DIKW模型辨析数字素养内涵发现,数字素养是信息素养的延伸,延伸的部分,即是数据素养。基于这样的认识,结合国际主流数字素养框架,对我国《标准》进行了详细分析,并以此设计了用于评估我国中小学教师数字素养水平的调查问卷。为了保障问卷的信效度,问卷依次经历了四大环节的验证与修订:用于保障内容效度的专家评估与认知审查、用于保障题项区分度与代表性的项目分析、用于保障结构效度的探索性与验证性因子分析,以及用于保障同类题项聚类效果的收敛效度分析。修订后问卷的Cronbach’s α 为0.97,具有较高的信度。

此问卷的重要特色是简短,只有35个题项,这有利于提高数据的回收率与质量、降低调查研究失败的风险(Kost et al.,2018)。问卷具有良好的普适性,可测评中小学不同学段和学科的教师的数字素养水平。此问卷主要有三种建议使用的场景:一是教师自查。问卷能够为教师绘制自身的数字素养画像,便于个人查漏补缺式发展。使用此问卷测评自身在各维度或指标上的水平,最好将结果按照公式(v-1)×100/4(v是教师的五级量表得分)转换成百分制,以便直观感知自身的素养水平。二是国培等研修项目的前后测。该问卷可助力研训单位开展有针对性的课程与活动,并评估研修后的质量。前后测应随机抽样,后测分析时需排除同时参与前后测的教师样本。三是区域、学校层面的摸排调查,便于其制定宏观政策与发展计划。如可借鉴祝智庭团队提出的个性化学习适配处方策略(祝智庭等,2017b),对于80%以上群体具有的数字素养问题,可考虑组织集中的专项培训并发挥领域专家的智慧打造“头雁”资源;对于不足5%的群体面临的问题,可考虑通过构建教师教学共同体、引导智慧教研活动等策略解决。

本研究也具有一定的局限性。如本问卷不适用于非任课教师,因为问卷对于数字化应用的调查,主要关注的是数字化教学的设计、实施与评价;同时,本问卷的信效度结果,是针对中小学教师反馈的数据分析得到的,问卷对于高校与职教教师群体是否适用,需要进一步验证。后续,本团队将对中小学教师的数字素养开展全国性调研,以明确当前我国中小学教师数字素养的整体水平与培育短板,为国家教师发展数字化行动提供参考。

参考文献:

[1]李宝敏,宫玲玲,祝智庭(2018).在线学习力测评工具的开发与验证[J].开放教育研究,24(3):77-84,120.

[2]李爽,喻忱(2015).远程学生学习投入评价量表编制与应用[J].开放教育研究,21(6):62-70,103.

[3]李新,杨现民,晋欣泉(2019).美国教师数据素养发展现状及其对我国的启示[J].现代教育技术,29(4):5-11.

[4]林崇德(2003).心理学大辞典[M].上海:上海教育出版社:326.

[5]柳冠中(2013).设计是人类未来不被毁灭的“第三种智慧”[J].设计,(12):126-131.

[6]彭红超,祝智庭(2018).人机协同的数据智慧机制:智慧教育的数据价值炼金术[J].开放教育研究,24(2):41-50.

[7]彭红超,祝智庭(2021).面向智慧课堂的灵活深度学习设计框架研制[J].现代远程教育研究,33(1):38-48.

[8]彭红超,祝智庭,郑珊珊(2023).信息化促进基础教育公平发展的测量框架研究[J].电化教育研究,44(9):34-41.

[9]田旭明(2022).数字社会的主要伦理风险及其应对[J].中州学刊,(2):87-93.

[10]吴砥,熊璋,周建华等(2023).落实《教师数字素养》标准[N].中国教育报,2023-04-29(004).

[11]吴砥,朱莎,余丽芹等(2020).中小学生信息素养评价[M].北京:科学出版社:12.

[12]新华社(2018).关于全面深化新时代教师队伍建设改革的意见[EB/OL].[2023-03-31].https://www.gov.cn/zhengce/2018-01/31/content_5262659.htm?eqid=afc6a08e0004bda30000000664

5620a4.

[13]新华社(2023).习近平主持中央政治局第五次集体学习并发表重要讲话[EB/OL].[2023-08-08].https://www.gov.cn/yaowen/liebiao/202305/content_6883632.htm.

[14]中华人民共和国教育部(2018).教育部关于发布《中小学数字校园建设规范(试行)》的通知[EB/OL].[2024-03-11].

http://www.moe.gov.cn/srcsite/A16/s3342/201805/t20180502_334759.html.

[15]中华人民共和国教育部(2021).教育部等六部门关于推进教育新型基础设施建设构建高质量教育支撑体系的指导意见[EB/OL].[2021-07-08].http://www.moe.gov.cn/srcsite/A16/s3342/202107/t20210720_545783.html?eqid07ca7000000056

4756b45.

[16]中华人民共和国教育部(2023).教育部等十三部门关于健全学校家庭社会协同育人机制的意见[EB/OL].[2023-01-17].http://www.moe.gov.cn/srcsite/A06/s3325/202301/

t20230119_1039746.html.

[17]祝智庭(2020).未来学习的近景是混合学习,远景是智慧教育[J].上海教育,(9):22-24.

[18]祝智庭,彭红超,雷云鹤(2017a).解读教育数据智慧[J].开放教育研究,23(5):21-29.

[19]祝智庭,孙妍妍,彭红超(2017b).解读教育大数据的文化意蕴[J].电化教育研究,38(1):28-36.

[20]Australia Government (2020). Digital Literacy Skills Framework[EB/OL]. [2023-10-11]. https://www.dewr.gov.au/foundation-skills-your-future-program/resources/digital-literacy-skills-framework.

[21]Bacon, R., Sauer L., & Young, M. (1995). Composite Reliability in Structural Equations Modeling[J]. Educational and Psychological Measurement, 55(3):394-406.

[22]Brandhofer, G., Miglbauer, M., & Fikisz W. et al. (2021). Das Digi.kompP-Kompetenzmodell[EB/OL]. [2023-11-09].

https://www.virtuelle-ph.at/digikomp/.

[23]Carmines, G., & Zeller, A. (1979). Reliability and Validity Assessment[J]. Beverly Hills Calif, 33(1):775-780.

[24]Clark, D. (2012). Understanding and Performance[EB/OL]. [2023-05-23]. http://www.nwlink.com/~donclark/performance/understanding.html.

[25]Clifford, I., Kluzer, S., & Troia, S. et al. (2020). DigCompSAT: A Self-Reflection Tool for the European Digital Competence Framework for Citizens[EB/OL]. [2023-05-24]. https://op.europa.eu/en/publication-detail/-/publication/8e90a6

01-4595-11eb-b59f-01aa75ed71a1/language-en.

[26]DeVellis, F. (2012). Scale Development: Theory and Applications (3rd Ed. )[M]. Thousand Oaks, CA: Sage Publications:107-129.

[27]Dunn, M., Heggestad, D., & Shanock, R. et al. (2018). Intra-Individual Response Variability as an Indicator of Insufficient Effort Responding: Comparison to Other Indicators and Relationships with Individual Differences[J]. Journal of Business and Psychology, 33:105-121.

[28]ETF (2023). Digital Teaching Professional Framework[EB/OL]. [2023-11-09]. https://www.et-foundation.co.uk/wp-content/uploads/2023/06/ETF-DTPF-Full.pdf.

[29]European Commission (2017a). DigComp 2.1: The Digital Competence Framework for Citizens with Eight Proficiency Levels and Examples of Use[EB/OL]. [2023-02-28]. https://publications.jrc.ec.europa.eu/repository/handle/JRC106281.

[30]European Commission (2017b). Digital Competence Framework for Educators(DigCompEdu)[EB/OL]. [2023-05-23]. https://joint-research-centre.ec.europa.eu/digcompedu_en.

[31]European Commission (2022). DigComp 2.2: The Digital Competence Framework for Citizens[EB/OL]. [2023-08-30]. https://op.europa.eu/en/publication-detail/-/publication/50c53c01-abeb-

11ec-83e1-01aa75ed71a1/language-en/format-PDF/.

[32]Fornell, C., & Larcker, F. (1981). Evaluating Structural Equation Models with Unobservable Variables and Measurement Error [J]. Journal of Marketing Research, 18(1):39-50.

[33]Gerbing, W., & Hamilton G. (1996). Viability of Exploratory Factor Analysis as a Precursor to Confirmatory Factor Analysis[J]. Social Science Electronic Publishing, 3(1):62-72.

[34]Hair, F., Tatham, L., & Anderson, E. et al. (1998). Multivariate Data Analysis[J]. Technometrics, 30(1):130-131.

[35]Hinkin, R. (1998). A Brief Tutorial on the Development of Measures for Use in Survey Questionnaires[J]. Organizational Research Methods, 1(1):104-121.

[36]Hu, L., & Bentler, M. (1999). Cutoff Criteria for Fit Indexes in Covariance Structure Analysis: Conventional Criteria Versus New Alternatives[J]. Structural Equation Modeling, (1):1-55.

[37]INTEF (2022). Marco de Referencia de la Competencia Digital Docente[EB/OL]. [2023-11-09]. http://aprende.intef.es/mccdd.

[38]IZA-Institute of Labor Economics (2023). Effects of an Online Self-Assessment Tool on Teachers’ Digital Competencies[EB/OL]. [2023-08-09]. https://www.iza.org/publications/dp/15863.

[39]Kaiser, F. (1974). An Index of Factorial Simplicity[J]. Psychometrika, 39(1):31-36.

[40]Kelentrić, M., & Helland, K. (2018). Professional Digital Competence Framework for Teachers[EB/OL]. [2023-11-10]. https://www.udir.no/in-english/professional-digital-competence-frame

work-for-teachers/.

[41]Kost, G., & De Rosa, C. (2018). Impact of Survey Length and Compensation on Validity, Reliability, and Sample Characteristics for Ultrashort-, Short-, and Long-Research Participant Perception Surveys[J]. Journal of Clinical and Translational Science, 2(1):31-37.

[42]Lenham, R. (1995). Digital Literacy[J]. Scientific American, 273(3):253-255.

[43]Li, B., Kong, S., & Chen, G. (2015). Development and Validation of the Smart Classroom Inventory[J]. Smart Learning Environments, 2(1):1-18.

[44]Mandinach, B., & Gummer, S. (2016). What Does It Mean for Teachers to Be Data Literate: Laying Out the Skills, Knowledge, and Dispositions[J]. Teaching and Teacher Education, 60:366-376.

[45]OECD (2019). OECD Skills Outlook 2019: Thriving in a Digital World[R]. Paris: OECD Publishing:29,21,181.

[46]Peled, Y. (2021). Pre-Service Teacher’s Self-Perception

of Digital Literacy: The Case Of Israel[J]. Education and Information Technologies, 26:2879-2896.

[47]Sánchez-Cruzado, C., Santiago Campión, R., & Sánchez-Compaña, T. (2021). Teacher Digital Literacy: The Indisputable Challenge After COVID-19[J]. Sustainability, 13(4):1858.

[48]Streiner, L. (2003). Starting at the Beginning: An Introduction to Coefficient Alpha and Internal Consistency[J]. Journal of Personality Assessment, 80(1):99-103.

[49]Sürücü, L., & Maslakç, A. (2020). Validity and Reliability in Quantitative Research[J]. Business & Management Studies: An International Journal, 8(3):2694-2726.

[50]UNESCO (2011). Digital Literacy in Education[EB/OL]. [2023-06-01]. https://iite.unesco.org/publications/3214688/.

[51]UNESCO (2018). UNESCO ICT Competency Framework for Teachers[EB/OL]. [2023-07-13]. https://en.unesco.org/themes/ict-education/competency-framework-teachers.

[52]Wallace, P. (2007). Knowledge Management: Historical and Cross-Disciplinary Themes[M]. Westport: Greenwood Publishing Group:1-14.

[53]Willis, B. (2005). Cognitive Interviewing: A Tool for Improving Questionnaire Design[M]. Thousand Oaks, CA: SAGE:1-9.

收稿日期 2024-02-06 责任编辑 汪燕

The Localization Development of K-12 Teachers’ Digital Literacy Assessment Questionnaire

——Based on the Industry Standard of “Teachers’ Digital Literacy”

PENG Hongchao, ZHU Kaige

Abstract: Teachers are the backbone of promoting education digitization. In 2023, the Ministry of Education of the People’s Republic of China released an education industry standard, named “Digital Literacy of Teachers” (hereinafter referred to as the Standard). The Standard provides a reference for evaluating the level of digital literacy of teachers in China. However, standards alone can not effectively diagnose the development of teachers’ digital literacy. Therefore, assessment tools are indispensable. Although there are some assessment tools for teachers’ digital literacy at home and abroad, they are not based on this Standard, so the appropriateness of the assessment is not high. Digital literacy includes two core contents: information literacy and data literacy. The Standard stipulates digital literacy of Chinese teachers from five dimensions: digital consciousness, knowledge and skills of digital technology, digital application, digital social responsibility and professional development. Based on the detailed analysis of China’s Standard combined with the international mainstream digital literacy framework, the assessment questionnaire of K-12 teachers’ digital literacy in China is constructed according to the way of “selecting classics items and self-built supplement”. The questionnaire went through four stages of verification and revision: expert evaluation and cognitive review to ensure content validity, items analysis to ensure item differentiation and representativeness, exploratory and confirmatory factor analysis for guaranteeing the structural validity, and the convergent validity analysis to guarantee the clustering effect of similar items. The revised questionnaire, with good model fitting degree and internal consistency, can be used for teachers’ self-examination, pre-and post-tests of training projects, and regional and school-level surveys.

Keywords: K-12 Teachers; Digital Literacy; Assessment Tool; Survey Questionnaire