一种融合多尺度技术和并行网络的DR检测方法

2024-07-02陈宇徐仕豹

陈宇 徐仕豹

摘 要:针对糖尿病视网膜病变(DR)检测模型在下采样过程中关键信息丢失和模型鲁棒性差的问题,构建一个PM-Net模型(Parallel Multi-scale Network)。在下采样过程中,利用信息增强的方式设计了多尺度最大池化和多尺度卷积模块并对ResNet-50改进。进一步,为了提高模型的鲁棒性,使用双分支的架构对模型进行扩展。提出的多尺度模块使得模型在下采样的过程中获得了更加丰富的视网膜眼底图像特征,从而提高了DR检测的性能,同时提出的双分支模型在DR检测过程中用局部信息辅助全局信息保证了模型的鲁棒性。模型在EyePACS、DDR和私有数据集进行了实验验证。实验结果表明:与主流的模型相比,本模型在EyePACS数据集上的准确率和二次加权Kappa分数分别提高了258%和131%。

关键词:糖尿病视网膜病变;多尺度;并行网络;最大池化;ResNet-50

DOI:10.15938/j.jhust.2024.01.010

中图分类号: TP3914 文献标志码: A

文章编号: 1007-2683(2024)01-0087-09

A DR Detection Method Incorporating Multi-scale Techniques and Parallel Networks

CHEN Yu, XU Shibao

(College of Information and Computer Engineering, Northeast Forestry University, Harbin 150040, China)

Abstract:A PM-Net model (Parallel Multi-scale Network) has been constructed to solve the problems of loss of key information and poor model robustness in the downsampling process of diabetic retinopathy (DR) detection models Multi-scale maximum pooling and multi-scale convolution modules have been designed and improved on ResNet-50 using information augmentation in the downsampling process In addition, to improve the robustness of the model, the model was extended using a two-branch architecture The proposed multi-scale module allows the model to obtain richer retinal fundus image features during downsampling, thus improving DR detection performance, while the proposed two-branch model ensures the robustness of the model with local information supplementing global information during DR detection The model was experimentally validated on EyePACS, DDR, and private datasets Experimental results show that the model's accuracy and quadratic weighted kappa score on the EyePACS dataset are improved by 258% and 131% respectively compared to mainstream models

Keywords:diabetic retinopathy; multi-scale; parallel network; maximum pooling; ResNet-50

0 引 言

糖尿病视网膜病变(简称DR)是由糖尿病引起的并发症,它是一个严重的公共卫生问题,影响着全球463亿人,预计到2045年将增至7亿[1]。根据国际临床糖尿病视网膜病变量表(ICDRS),糖尿病视网膜病变分为5个阶段,无症,轻症、中症、重症和增值性病变。卷积神经网络(CNN)通过在下采样过程中提取关键特征并实现分类,但下采样过程中面临的问题是丢失了一些特征信息,在DR领域中任何特征信息的丢失都有可能导致对患者的误诊。因此,尽可能减少下采样过程中特征信息的丢失从而提升模型的性能依旧是一项挑战。同时,不同数据集之间存在着较大的域差异,模型鲁棒性差的问题也是一项严峻的挑战。

在过去的几年,已经有很多人开始使用机器学习和深度学习对糖尿病视网膜病变的检测进行了研究。Lin等[2]引入了一个名为MCG-Net的模块,该模块基于图卷积网络(GCN),可以更加有效地提取眼底图像的病灶特征。为了提高泛化能力,该作者基于自监督学习(SSL)构建了名为MCGS的网络增强模块,其中使用GCN代替全连接层以更好地捕获眼底图像的相关性,但该作者最终取得的实验结果并不理想,其中主要的原因则是因为下采样过程中丢失了部分关键信息,导致模型最终的分类性能欠佳。Narayanan等[3]将SVM模型应用于DR分类,并从主成分分析优化的全连接神经网络(DNN)中提取特征。与AlexNet、VGG、ResNet和Inception-v3等方法相比,作者得到了一个更高的准确率为995%,但该作者使用的数据集却不够具有代表性,通过实验对比的数据可以发现,该模型的鲁棒性并不理想。Hua等[4]在ResNet-50的基础上设计了一个名为Trilogy of Skip-connection Deep Networks(Tri-SDN)的DR检测模型,该模型应用Skip-connection block使训练速度更快,最终准确率和SP的准确率达到906%和821%,与不使用Skip-connection block的情况相比,该方法的性能得到了显著的提升。可以发现该作者的目的是为了提高网络的训练速度,但最终获得的准确率并不理想,通过模型可以看出,简单的3×3和1×1卷积堆叠并不能很好的提取完整视网膜眼底图像的病灶特征信息。为了减少可训练参数的数量,Zago等[5]提出了一种VGG16网络,在Messidor数据集上的灵敏度为094,AUC为0912。该作者使用的数据集评价标准与国际标准不一致,模型只能检测是否为DR而没有任何严重性指示,同时未报告准确率和F1分数, 使得模型的扩展性表现能力差。

陈宇等[6]设计了一个Xnet-CNN结构以实现糖尿病视网膜病变的分类算法,该作者对图像用边框裁剪、样本归一化和数据扩增等方式对数据进行了预处理工作,最终取得了91%的准确率。但是该作者使用了一个私有数据集,且数据集的病变等级评价标准于国际标准不一样,因此该方法的鲁棒性不好。周炎龙等[7]在代价敏感损失函数的基础上设计了一个双重代价敏感损失函数的随机森林算法来解决类不平衡的问题,他为数据不平衡的问题提供了一个新的研究思路,而DR图像也存在着严重的类不平衡问题,这对本文的研究具有非常高的参考价值。张培培等[8]在目标检测过程中为了缓解目标重合、遮挡等问题,将全局信息与局部信息结合并对目标进行检测。相同的是,在DR图像中病灶信息遍布于视网膜的各个角落且分布较均匀,本文也使用全局信息与局部信息相结合的思路,利用多尺度的方法对模型进行改进,从而提升模型的检测性能。王卫兵等[9]为了实现网络的鲁棒性,设计了一个多分支网络对目标进行检测,通过实验对比发现,在物体边缘检测方面该作者所设计的模型比采用单分支网络的检测模型具有更好的性能。

针对下采样过程中关键信息丢失和模型鲁棒性差的问题,本文设计了PM-Net模型。主要贡献可以总结如下两点:

1)提出了多尺度最大池化和多尺度卷积模块并对基础模型进行改进,极大地丰富了下采样过程中病灶信息的特征,使得模型的性能得到了显著提升。

2)提出的双分支架构将视网膜眼底图像的全局信息与局部信息进行了结合,使用局部信息为全部做辅助有效地保证了模型的鲁棒性。

1 具体实现

本文以ResNet-50为基础模块,所设计的模型整体结构如图1所示。图的中间部分是本文所提出的多尺度最大池化和多尺度卷积模块。图的上方是本模型的主干网络,通过随机裁剪得到的是本模型的第2个分支网络,并对模型中的最大池化模块和3×3卷积块进行了替换。本节将会对多尺度最大池化、多尺度卷积、并行网络和引入的代价敏感损失函数4个模块进行详细的介绍。

1.1 多尺度最大池化

图2是多种池化操作在视网膜眼底图像上提取信息的模拟图。如图所示,视网膜上有两个软性渗出物。

在图2中的视网膜上有两个软性渗出物。全局平均池化下,并未把软性渗出物单独识别成功,因此使用平均池化提取特征从而降低网络的复杂性是不理想的。全局最大池化下,将最完整的一部分软性渗出物识别成功,而跨像素的病变并未关注到,这是由于最大池化在一个分布较均匀的特征里面往往只能关注到一个最重要的特征。而视网膜眼底图像中的病变分布较均匀,任何病变的丢失都会导致对病人的误诊,这往往会带来不可逆的影响。本文的最终目的是实现最右侧所展示的结果。

本文将全局信息与局部信息进行结合,提出了一种新的多尺度最大池化策略。多尺度最大池化模块从不同的角度共同提取同一张图像的特征信息,全局信息所输入图像的形状为R448×448×3,局部信息通过裁剪原始图像来实现,每个裁剪的区域均为原始图像的14,既左上、右上、左下和右下(表示为LU、RU、LD和RD),再将其扩大到R448×448×3。多尺度最大池化共有5个分支,第1个分支以视网膜图像的全局信息作为输入,在其基础上进行两次Stride为2的3×3最大池化。为了获得更加丰富的图像特征,使用4个共享权重参数的分支作为辅助,对同一张图像实现多角度的特征信息提取。与第1个分支不同的是,4个分支的第1个池化采用Stride为2的3×3平均池化。可以理解为在裁剪1/4后,图像中的病变信息开始减少,而信息越少就显得越重要,则认为所有的病变信息包括背景均有同样的重要性。随后均采用Stride为2的3×3最大池化对4个分支进行特征提取,并将所有分支得到的特征进行拼接,多尺度最大池化的计算过程如式(1)所示。将原始的最大池化扩展到本文的多尺度最大池化,通过多角度的方法对图像中的特征信息进行提取。这种方式既可以关注全局信息又能关注局部细节信息,它更加适合本文数据集中病变信息的特点。因此本模型采用一种多尺度的方法对池化层进行改进。

ConFea=MO+MMOALU+MALUARU+MARUALD+MALDARD+MARD(1)

其中:ConFea为多个尺度池化后拼接得到的特征;M为最大池化;A为平均池化;O为原始图,LU、RU、LD、RD分别代表裁剪的区域;为特征的拼接。

1.2 多尺度卷积

视网膜眼底图像中的病变信息检测是一件非常具有挑战性的任务。往往是通过增加卷积神经网络的深度来提高分类性能,而过深的网络会导致一些关键病变信息的丢失。为此,本文在保证与ResNet-50网络相同深度的前提下设计了1个多尺度卷积模块,该模块采用不同的卷积核提取同一张图像中的病变信息,这可以极大地丰富图像的特征。多尺度卷积模块的详细设置以及拼接后的卷积核数量如表1所示,将其与图1中4个Block的3×3卷积分别进行替换。

本文的多尺度卷积模块设置了4个不同的卷积核,多尺度卷积均由3×3卷积、5×5卷积、7×7卷积和9×9卷积共同组成。每个卷积核各自提取特征,最终将得到的特征进行拼接。首先采用1个3×3卷积核对视网膜眼底图像进行特征提取,然后再采用1个5×5卷积核,它可以在3×3的基础上提取更多的局部信息。随后分别采用7×7和9×9卷积核,以更大的感受野来获取更多的局部信息。四个卷积核的参数与ResNet-50中的3×3卷积保持一致。为了降低梯度消失和梯度爆炸的影响,本文也保留了ResNet-50的残差连接。最终将本文提出的多尺度卷积替换掉ResNet-50中的3×3卷积核,可以用式(2)表示卷积替换的过程。

R3*3=3*35*57*79*9(2)

其中:R3*3为 3×3卷积替换之后的多尺度卷积;*为卷积操作;为特征的拼接。

1.3 并行网络

在以往的单分支中,若更换数据集则DR检测性能会明显的下降,这是由于网络不具备足够的鲁棒性。因此本模型提供了一种双分支检测模型,在主干路径外同时采用4个分支路径进行特征提取,用局部信息为全局信息做辅助。其主干输入视网膜图像的完整区域,分支则关注的是局部信息,局部图像信息通过对原始图像随机裁剪实现,裁剪的大小为原始图像的14,之后也将其尺寸再扩大到原始的R224×224×3。两条路径并行处理各自的图像,随后将得到的特征进行拼接,每个路径整体的计算过程均如式(3)所示。其中2个路径都对ResNet-50的最大池化层和3×3卷积依次进行上述的替换,两条路径并共享权重参数。

Con=GAP{Res(MP+MC)}∑4i=1GAP{Resi(MP+MC)}(3)

其中:Res(MP+MC)为主干路径对ResNet-50进行最大池化和3×3卷积的多尺度替换;Resi(MP+MC)代表4个分支网络同样的替换过程;GAP为全局平均池化;Con指的是2个路径得到的特征信息拼接后的结果。

1.4 引入损失函数

在DR分类的数据集中,存在着严重的不平衡问题,仅仅通过重采样的方式进行数据增强,依旧不能保证最终分类的性能,这是由于增强后的图像在样式和特征上面与原始图依旧存在着极大的相似性和重复性,增强后的图像无法拥有多样性的数据,这使得模型在训练阶段无法表现出更好的性能。因此将损失函数一并进行改进,使其与数据增强想结合共同解决数据不平衡的问题。本文在损失函数部分引用了王明智等[10]所提出的一种改进代价敏感正则化损失函数。该方法主要是根据预测等级和真实等级相差程度的不同,对其施加不同的惩罚,其中矩阵中的数值越高惩罚越低,数值越低惩罚越高。最终设计了具体的代价敏感正则化矩阵Md,如式(4)所示。如果只使用代价敏感正则化的损失会导致复杂的卷积神经网络陷入局部最小值,因此,把代价敏感正则化作为焦点损失函数的正则化,得到式(5)。

Md=0994000300030004640496004000015300210819000700002600720002000000620938(4)

L(,y)=-∑4i=0yiα(1-i)γ·log(i)+θ

其中:y为真实标签;为预测标签;α为加权因子;γ为聚焦参数[11];

2 实验结果与分析

2.1 数据集和指标介绍

本研究主要使用了三个数据集,EyePACS、DDR和海南眼科医院提供的私有DR分类数据集(以下称为Private dataset)。使用EyePACS来训练和测试本文的模型,使用DDR和Private dateset两个数据集验证模型的泛化性能,以下是上述数据集和实验指标的详细介绍:

EyePACS:该数据集[12]由EyePACS提供,包含35126张训练图像和53576张测试图像,所有图像都有DR分级标签,该数据集是最大的公开数据集,它同时遵守国际评价标准(ICDRS)。

DDR:该数据集[13]是第二大公开数据集,包括六个DR等级图像:正常、轻度、中度、重度、PDR和无法识别的类。在该实验中使用前五个等级,同时该数据集提供了微动脉瘤(MAs)、出血(HAE)、硬渗出物(H-Exs)、软渗出物(S-Exs)的分割图像,共计757张分割标注图像。

Private dataset:数据集从海南眼科医院所收集,并由两名眼科医生进行了分类标注,数据集共有2758张视网膜眼底图像,图像均有DR病变的分级标签。

实验指标:本研究用TP、FP、FN、TN分别表示真阳性、假阳性、假阴性、真阴性,采用准确率和二次加权Kappa来实现对分类网络的评价,Accuracy的计算方法如式(6),二次加权Kappa的计算如式(7)。

Accuracy=TP+TNTP+FP+TN+FN(6)

Kappa=1-∑ijωijOij∑ijωijEij(7)

其中:Oij表示将第i类误判为第j类的个数;ωij为加权系数,ωij和Eij的计算公式分别如式(8)和(9)所示:

ωij=(i-j)2(N-1)2(8)

Eij=∑iOij∑jOijn(9)

其中:N为类别数;n为样本的总数量。

2.2 预处理和实验参数设置

数据预处理:首先将原始图片裁剪,从中心处将图像分辨率裁剪为224×224×3的形状。去掉绝大部分的黑色背景,因为黑色背景对病变分割以及分类是没有意义。并采用直方图均衡化[14]以及非局部均滤波值去噪[15]等方式对视网膜图像进行处理。当图像色调和亮度调整到一定范围后再对其归一化[16]提高本文所设计模型的性能。

数据增强:每个数据集在分类问题上都存在着类之间不平衡的问题。为了缓解这个问题,本文采用重采样的方法,对数据量大的进行下采样,对数据少的进行翻转、旋转等操作。具体的数量根据每个数据集的数量不同所设置,最终要实现类之间的平衡。

数据清洗:在EyePACS数据集中存在着一些完全没有意义的图像,如图3所示。这些图像对分类网络起着明显的副作用,因此本文对数据集进行筛选并删除掉。

实验参数设置:初始Learning-rate设置为00001,Batchsize设置为32,Epoch设置为100,并使用随机梯度下降优化算法。在EyePACS数据集上训练分类网络,数据集的80%作为训练集,10%作为验证集,剩下的10%作为测试集。

2.3 实验结果

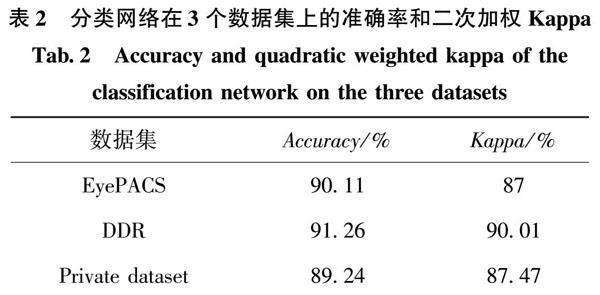

表2中展示了分类网络在3个数据集上所取得的结果,使用准确率和二次加权Kappa作为评价的指标。并展示了在EyePACS数据集上准确率和损失函数的变化过程,如图4所示。本文计算了TP、FP、FN和TN即真阳性、假阳性、假阴性和真阴性的值,并绘制了图5的混淆矩阵,

从图5中的混淆矩阵可以看出,实验的整体数值落在了对角线上,这也进一步验证了本文提出模型的性能。同时计算了真阳性率和假阳性率,绘制了ROC曲线并得到曲线下面积为0923,如图6所示。关于实验的对比分析以及消融实验,将会在接下来的小节进行详细的介绍。

2.4 GradCAM可视化

本文通过GradCAM[17]对提出的改进卷积网络在进行分类任务时所提取的不同DR等级的特征图进行了可视化展示,如图7所示。图中对正常的图像未做出可视化展示。本文清晰准确的展示了模型学习到的特征是有效的。在图中可以发现,模型对同类特征的大区域关注度并不高,而是关注到了同类特征的微小区域,因为这些微小的区域足以让模型对视DR图像做出诊断,这一点发现与文[18]所提到的一致。

2.5 与其他网络模型的比较

本节使用EyePACS数据集验证改进后的网络是否有所提升,使用准确率和二次加权Kappa作为评价的指标。结果如表3所示。

从表3中可以看出,使用所提出的模型在两个指标上比较新的模型均有所提升。比文[19]和文[20]模型的准确率和加权二次Kappa分别提高了 258%、611%和131%、15%。 比RF-GANS(AFN)[21]的准确率提高了109%,二次加权Kappa保持平衡。其中文[21]模型使用了对抗生成网络(GAN)做了数据增强并实现了糖尿病视网膜的五分类,但由于作者并未设计一个新的分类模型,所以结果并未得到显著的提升。相较于本文的结果,文[21]耗费了大量的算力,且训练网络需要花费很多的时间,因此综合性能比本文的模型欠佳。比Lindas等[22]提出的模型在两个指标上分别高出了1211%和6%。比基础模块ResNet-50在两个指标上分别高出了383%和314%,这也验证了对基础模块的改进是有效的。本文分析原因在于使用多尺度最大池化、多尺度卷积和并行分类网络在病变信息检测的过程中起到了关键性的作用,进一步证明本文的方法在EyePACS数据集上具有更好的性能。

为了验证所设计网络的泛化性能,本文也在DDR和Private dataset上验证了该方法的有效性。与EyePACS数据集相比,DDR数据集是一个更新的数据集,Private dataset是一个私有的数据集,两者报告的结果都很少,因此在两个数据集中应用了一些比较先进的分类方法进行了比较,如表4和表5所示。

从表4和表5中可以看出,本文所设计网络的分类性能依旧表现最佳。在两个数据集上本文所提出方法的准确率和二次加权Kappa两个指标中比ResNet-50分别高出了399%、404%和515%、472%。比RepVGG[25]分别高出了437%、489%和497%、546%。比Efficientent[24]分别高出了463%、437 %和553%、419%。综合来看,ResNet-50比其他的几个网络表现性能更高。因此本文以ResNet-50为基础模块,对其进行改进之后的模型更适合DR的分类。

26 消融实验研究

为了验证每个组件对本模型的影响,本文在EyePACS数据集上进行了必要的消融实验,如表6所示,表中的Res代指本文所采用ResNet-50的基础模块。

从表6中可以看出,本文提出的方法比采用了Res+多尺度最大池化+并行的组合在两个指标分别高出了09%、182%,这验证了本文所提出的多尺度卷积具有关键性的作用。本文提出的方法比采用了Res+多尺度卷积+并行的组合在两个指标分别高出了066%、118%,这验证了本文所提出的多尺度最大池化具有关键性的作用。比采用了Res+多尺度卷积+多尺度最大池化的组合在两个指标上分别高出了109%、199%,这验证了本文所提出的并行分支具有关键性的作用。通过消融实验说明了对ResNet-50每个部分的替换都起到了关键性的作用,最终在DR诊断方面取得了很好的性能。

3 结 论

本文针对DR检测问题,提出了一种PM-Net模型,使用多尺度最大池化和多尺度卷积对ResNet-50进行改进,同时用双分支架构对模型进行扩展。使模型在下采样的过程中获取更丰富眼底图像病变信息,模型的性能得到明显的提升且具有更好的鲁棒性。在EyePACS、DDR和私有数据集上分别得到了09011、09126和08924的准确率,实验结果充分证明了本文提出模型的性能更优。和其他分类网络相似,本文未来的工作也考虑使用对抗生成网(GAN)来实现多样性的数据增强,进一步提高DR分类的性能。

参 考 文 献:

[1] International Diabetes Federation. International Diabetes Federation Diabetes Atlas, Ninth Ed.https://www.diabetesatlas.org/en/.

[2] LIN J, CAI Q, LIN M. Multi-label Classification of Fundus Images with Graph Convolutional Network and Self-supervised Learning[J]. IEEE Signal Process. Lett., 2021, 28: 454.

[3] LEVENKOVA A, KALLONIATIS M, LY A, et al. Lesion Detection in Ultra-widefield Retinal Images for Diabetic Retinopathy Diagnosis[J]. In Medical Imaging 2018: Computer-Aided Diagnosis; International Society for Optics And Photonics:Bellingham, WA, USA, 2018: 1057531.

[4] HUA C H, HUYNH-THE T, KIM K, et al. Bimodal Learning Viatrilogy of Skip-Connection Deep Networks for Diabetic Retinopathy Risk Progression Identification[J]. Int. J. Med. Inform. 2019, 132:103926.

[5] ZAGO G T, ANDREO R V, DORIZZI B, et al. Diabetic Retinopathy Detection Using Red Lesion Localization And Convolutional Neural Networks[J]. Comput. Biol. Med., 2020, 116: 103537.

[6] 陈宇,周雨佳,丁辉. 一种XNet-CNN糖尿病视网膜图像分类方法[J].哈尔滨理工大学学报,2020,25(1):73.

CHEN Yu,ZHOU Yujia,DING Hui. An XNet-CNN Diabetic Retinal Image Classification Method[J].Journal of Harbin University of Science and Technology,2020,25(1):73.

[7] 周炎龙,孙广路.双重代价敏感随机森林算法[J].哈尔滨理工大学学报,2021,26(5):44.

ZHOU Yanlong,SUN Guanglu.Double Cost Sensitive Random Forest Algorithm [J].Journal of Harbin University of Science and Technology,2021,26(5):44.

[8] 张培培,吕震宇.基于全局信息的目标检测标签分配方法[J].哈尔滨理工大学学报,2022,27(4):32.

ZHANG Peipei,L Zhenyu.Target Detection Label Assignment Method Based on Global Information[J].Journal of Harbin University of Science and Technology,2022,27(4):32.

[9] 王卫兵,张晓琢,邓强.多分支主干监督网络下的RGB-D图像显著性检测[J]。哈尔滨理工大学学报,2022,27(4):39.

WANG Weibing,ZHANG Xiaozhuo,DENG Qiang.RGB-D Image Saliency Detection Based on Multi-branch Backbone Supervised Network[J].Journal of Harbin University of Science and Technology,2022,27(4):39.

[10]王明智,马志强, 赵锋锋, 等. 基于代价敏感正则化和EfficientNet的糖尿病视网膜病变分类方法[J/OL]。 液晶与显示, 2022: 1.

WANG Mingzhi, MA Zhiqiang, ZHAO Fengfeng, et al. Diabetic Retinopathy Classification Method Based on Cost Sensitive Regularization and Efficientnet[J/OL]. Chinese Journal of Liquid Crystals and Displays, 2022: 1.

[11]LU Y, JIANG M, WEI L, et al. Automated Arrhythmia Classification Using Depthwise Separable Convolutional Neural Network with Focal Loss[J]. Biomedical Signal Processing and Control, 2021, 69: 102843.

[12]Indian Diabetic Retinopathy Image Dataset (IDRID) Takenhttps://ieee-dataport.org/open-access/indian-diabetic-retinopathy-image-dataset-idrid,accessedonDecember 2021.

[13]DDRDataset,https://github.com/nkicsl/DDR-dataset,accessedon February 2022.

[14]XIAO Q, ZOU J, YANG M, et al. Improving Lesion Segmentation for Diabetic Retinopathy Using Adversarial Learning[C]//International Conference on Image Analysis and Recognition. Springer, Cham, 2019: 333.

[15]GHOSH R, GHOSH K, MAITRA S. Automatic Detection and Classification of Diabetic Retinopathy Stages Using CNN[C]//2017 4th International Conference on Signal Processing and Integrated Networks (SPIN). IEEE, 2017: 550.

[16]郭继峰, 李星, 庞志奇.自定义模糊逻辑与GAN在图像高光处理中的研究[J]. 小型微型计算机系统, 2021, 42(8):5.

GUO JF, LI X, PANG ZQ, et al. Custom Fuzzy Logic and Gan in Image Highlighting[J]. Small Microcomputer Systems, 2021, 42(8):5.

[17]SELVARAJU R R, COGSWELL M, DAS A, et al. Grad-cam: Visual Explanations from Deep Networks Via Gradient-based Localization[C]//Proceedings of the IEEE International Conference On Computer Vision, 2017: 618.

[18]NIU Y, GU L, ZHAO Y, et al. Explainable Diabetic Retinopathy Detection and Retinal Image Generation[J]. IEEE Journal of Biomedical and Health Informatics, 2021, 26(1): 44.

[19]LIN Z, GUO R, WANG Y, et al. A Framework for Identifying Diabetic Retinopathy Based on Anti-noise Detection and Attention-based Fusion[C]// in Proceedings of the International Conference on Medical Image Computing and Computer-Assisted Intervention, 2018: 74.

[20]ZHOU Y, WANG B, HUANG L, et al. A Benchmark for Studying Diabetic Retinopathy: Segmentation, Grading, and Transferability[J]. IEEE Transactions on Medical Imaging, 2020, 40(3): 818.

[21]CHEN Y, LONG J, GUO J. RF-GANs: A Method to Synthesize Retinal Fundus Images Based on Generative Adversarial Network[J]. Computational Intelligence and Neuroscience, 2021: 2021.

[22]LANDS A, KOTTARATHIL A J, BIJU A, et al. Implementation of Deep Learning Based Algorithms for Diabetic Retinopathy Classification from Fundus Images[C]//2020 4th International Conference on Trends in Electronics and Informatics (ICOEI)(48184), IEEE, 2020: 1028.

[23]HUANG G, LIU Z, VAN DER MAATEN L, et al. Densely Connected Convolutional Networks[C]// 2017: 4700.

[24]TAN M, LE Q. Efficientnet: Rethinking Model Scaling for Convolutional Neural Networks[C]//International Conference On Machine Learning. PMLR, 2019: 6105.

[25]DING X, ZHANG X, MA N, et al. Repvgg: Making Vgg-Style Convnets Great Again[C]// 2021: 13733.

(编辑:温泽宇)

基金项目: 国家自然科学基金(62172087); 中央高校基本科研业务费专项资金(2572021BH01)

作者简介:徐仕豹(1998—),男,硕士研究生

通信作者:陈 宇(1975—),男,博士后,副教授,E-mail:nefu_chenyu@163com