基于特征调节器和双路径引导的RGB-D室内语义分割

2024-06-01张帅雷景生靳伍银俞云祥杨胜英

张帅 雷景生 靳伍银 俞云祥 杨胜英

摘 要:针对室内场景图像语义分割结果不精确、显著图粗糙的问题,提出一种基于多模态特征优化提取和双路径引导解码的网络架构(feature regulator and dual-path guidance,FG-Net)。具体来说,设计的特征调节器对每个阶段的多模态特征依次进行噪声过滤、重加权表示、差异性互补和交互融合,通过强化RGB和深度特征聚合,优化特征提取过程中的多模态特征表示。然后,在解码阶段引入特征交互融合后丰富的跨模态线索,进一步发挥多模态特征的优势。结合双路径协同引导结构,在解码阶段融合多尺度、多层次的特征信息,从而输出更细致的显著图。实验在公开数据集NYUD-v2和SUN RGB-D上进行,在主要评价指标mIoU上达到48.5 %,优于其他先进算法。结果表明,该算法实现了更精细的室内场景图像语义分割,表现出了较好的泛化性和鲁棒性。

关键词:室内语义分割;特征调节器;双路径协同引导;RGB-D特征

中图分类号:TP391.41 文献标志码:A 文章编号:1001-3695(2024)05-044-1594-07

doi: 10.19734/j.issn.1001-3695.2023.07.0355

RGB-D indoor semantic segmentation based on feature regulator and dual-path guidance

Abstract:Aiming at the problems of inaccurate semantic segmentation results and rough saliency maps of indoor scene images, this paper proposed a network architecture (feature regulator and dual-path guidance, FG-Net) based on multi-modal feature optimization extraction and dual-path guided decoding. Specifically, the feature regulator sequentially performed noise filtering, re-weighted representation, differential complementation and interactive fusion on the multi-modal features at each stage, and optimized multi-modal feature representation in the feature extraction process by strengthening RGB and depth feature aggregation. Then, the dual-path guidance component introduced rich cross-modal cues after feature interactive fusion in the decoding stage to further take advantage of multi-modal features. The dual-path cooperative guidance structure outputted a more detailed saliency map by integrating multi-scale and multi-level feature information in the decoding stage. This paper conducted experiments on the public datasets NYUD-v2 and SUN RGB-D, and achieved 48.5% in the main evaluation metric mIoU, which is better than other state-of-the-art algorithms. The results show that the algorithm achieves more refined semantic segmentation of indoor scene images, and has good generalization and robustness. Key words:indoor semantic segmentation; feature regulator; dual-path cooperative guidance; RGB-D features

0 引言

近年来,语义分割作为一种有效的室内场景分析和处理的技术手段,被广泛应用于移动机器人、监控和智能家居等领域,为这些应用提供了有用的语义信息。然而,室内场景存在光线环境暗淡、物品杂乱等现象,这些因素影响了基于RGB图像进行室内场景语义分割的准确性,导致语义分割结果不理想。深度摄像机的使用提供了获取深度信息作为互补几何线索的条件,深度信息能够有效补充RGB图像的信息,提高模型对场景的理解和分析能力。然而,如何增强两种不同模态的特征表示,并有效利用互补信息实现跨模态信息融合是具有挑战性的任务。因此,许多学者致力于研究有效的策略来应对这些挑战,以释放多模态信息的全部潜力。在解决多模态信息差异性问题的过程中,学者进行了多种尝试。一些学者为RGB-D 数据设计了特定的体系结构,在多模态信息交互时,通过制定不同的策略融合两种数据,以获得更有效的跨模态线索。还有一些学者利用数据增强的方式,在特征提取阶段设计了专门的卷积层来增强RGB和深度信息。例如,Chen 等人[1]设计了一种门融合方法,在双流特征融合时通过多模态特征的重要性获得特征权值,利用特征权值对特征进行筛选和增强。Fernando等人[2]通过多任务联合优化引导语义分割,并提出了随机多目标梯度校正方法来增强多目标学习过程。Sun 等人[3]提出了一种有效的多任务剪枝和稀疏性训练方案,通过对多个任务进行重要性度量来实现一致决策。Popovic'等人[4]在处理多模态特征时,通过选择空间条件解决了空间多条件标签的异质性和稀疏性问题。Wu 等人[5]设计了一个深度适应偏移模块,利用深度线索指导 RGB 图像上的特征提取,并将深度信息进一步整合到RGB卷积神经网絡中。Dong 等人[6]提出了一种轻量级的带有点监督的边界细化模块,以提高现有分割模型生成的显著图的边界质量,并实现更好的边界特征提取。Cao 等人[7]引入了形状感知卷积层处理深度特征,通过对深度特征分解和重加权组合增强特征表示。在以往基于RGB-D信息的室内场景语义分割研究中,由于深度图像采集设备自身的缺陷,生成的图像在物体边界含有大量的噪声,成像物体的显著性也会随着距离的变远迅速降低。针对这个问题,Wu 等人[8]尝试仅获取少量的高显著深度线索,将深度信息作为辅助手段融入到RGB信息中。Seichter 等人[9]直接在编码器阶段将深度信息加到RGB信息中,将模型重心转移到解码器阶段。Li 等人[10]通过小容量适配器将多任务与网络对齐,从而将多任务网络的知识提取到单一网络。文献[9,11,12]中,研究人员制定深度信息和RGB信息融合的策略时,往往只是将两种信息进行相加或相乘合并,亦或只在解码阶段将模型注意力倾向于跨模态信息,直接输出显著图结果。上述算法在物体布局规整和空间结构简单的场景下具有非常不错的表现,但在室内场景物体体型小、互相遮挡,以及空间布局复杂时,语义分割算法精度会变低,显著图粗糙。简单的整合多模态特征的互补性不能进一步提高室内语义分割的准确性。深入挖掘和利用深度线索,将两种不同的统计数据整合到模型架构中,成为提高算法性能的关键。基于以上问题,本文提出的FG-Net采用了两个独立的ResNet50[13]骨干网络分支分别进行深度特征和RGB特征提取,并在编码器阶段设计了一个特征调节器来优化特征提取过程,同时对多模态信息进行特征增强。该部件具有特征强化聚合、特征差异性互补和特征交互融合三个功能,能够充分挖掘多模态线索并将它们紧密结合在一起,使得模型可以更加全面地学习多模态信息,提高对场景的语义分割能力。同时,本文设计了一个双路径协同引导结构,通过融合不同层次、不同尺度的特征强化解码过程,并利用不同阶段特征的特性进行双向引导,进一步细化显著图结果。实验数据表明,使用特征调节器和双路径引导结构可以显著增强模型的鲁棒性,尤其是在处理室内复杂场景时,模型的细节分割能力和语义识别能力较目前算法有显著提高。

1 本文模型与方法

1.1 模型架构

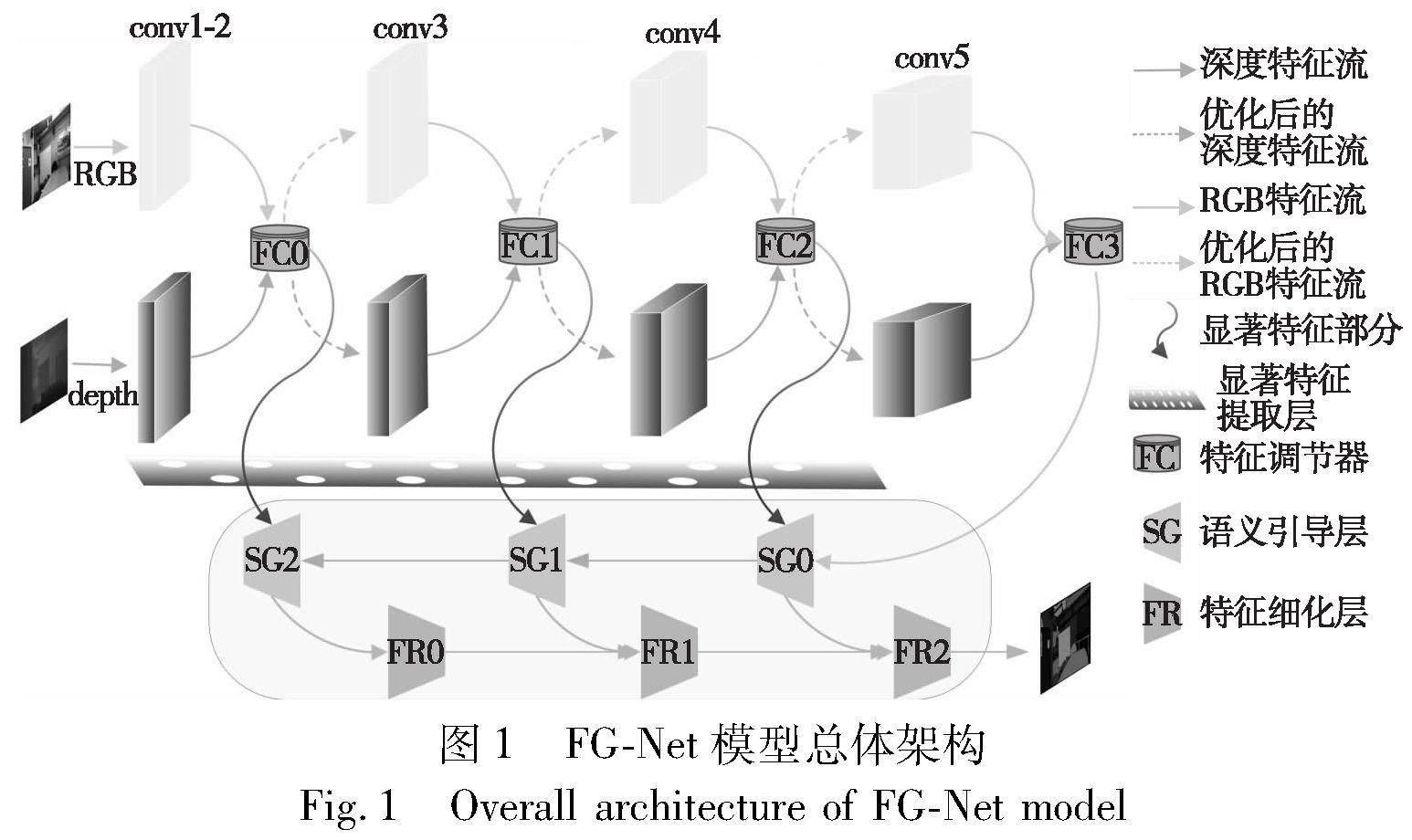

首先介绍了FG-Net的网络框架,然后描述了本文设计的特征调节器各个组件,以及双路径引导结构创新角度和解决的问题。最后,阐述了各个模块的工作流程和具体内容。如图1所示,本文采用编码器-解码器结构,使用两个独立的分支从RGB图像和深度图像中提取特征。这种设计既便于在特征提取阶段根据不同的模态特性设计针对性的特征处理方式,也可以使得每个模态的编码器专注于各自特征的提取。由于RGB图像与深度图像的特征存在显著差异,为了充分发挥多模态特征的特性,本文设计了特征调节器优化特征提取过程。首先,考虑到深度相机成像时在物体边界附近区域以及远距离物体的表面区域会出现很多噪声,特征强化聚合模块通过全局平均池化和卷积操作获得跨模态信息的全局表达和权重表示,并依据其中显著部分信息对噪声进行过滤,将过滤后的特征映射与交叉信息进行信道相乘,实现多模态特征的重加权表示,从而降低噪声干扰,增强特征表达。之后,为了充分发挥RGB特征和深度特征各自的优势,特征差异性互补模块利用池化和卷积操作对多模态信息进行特征质量评估,并选取显著部分补充到特征融合阶段,通过特征重建增强多模态特征优势。最后,不同于以往直接将两种模态信息相加或相乘的融合方法,特征交互融合模块从通道角度对两种模态特征进行切割、重组和交互。通过混合和连接两种类型的特征,并用归一化的卷积层、ReLU函数优化特征,以及调整通道数量,得到紧密聚合的特征表示,从而更深层次地结合多模态信息,并在特征传递时突出有用的线索。此外,考虑到编码时各个阶段的融合特征具有不同的层次体现,双路径协同引导结构通过跳跃连接的方式以及上采样和卷积操作,结合不同层次、不同尺度的融合特征引导解码过程,进一步细化语义分割显著图的输出。

RGB特征和深度特征经过特征调节器处理后,得到优化后不同尺度的融合特征FC0、FC1、FC2和FC3,这些融合特征依次传递到下一阶段的分支进行特征提取。在这个过程中,RGB-D特征经过特征强化聚合模块不断优化,而后通过互补和不断重组的方式,突出其包含的有效线索。随后,将每次的融合结果传递到解码阶段,结合本文提出的双路径协同引导结构,获得语义引导层的输出SG0、SG1和SG2。接着,将语义引导层的输出传递到特征细化层,得到细化的输出FR0、FR1和FR2,并最终输出显著图。

1.2 特征调节模块基于RGB-D跨模态信息的场景语义分割,主要的挑战在于如何充分发挥多模态特征的优势,尤其是在物体之间存在大量遮挡的室内环境中。这要求算法既要进一步获取有效的线索,又要高效利用获取的多模态信息。本文设计的特征调节器通过对多模态特征进行过滤、强化、重建增强和交互融合,可以获得更丰富和有效的多模态信息。特征调节模块由特征强化聚合、特征差异性互补和特征交互融合三个部分组成。

1.2.1 特征强化聚合

RGB数据和深度数据的特征存在显著差异,如何有效处理两种特征是首先要考虑的问题。此外,虽然深度图像包含大量几何线索,但由于深度传感器的物理特性,深度相机在采集物体信息时,性能会随着距离的扩大迅速地降低,导致物体边界附近区域以及远距离物体的表面区域会出现很多噪声。这些噪声会干扰特征提取过程,降低语义分割的精度。针对这个问题,在本文中,特征提取网络先通过特征强化聚合进行局部区域的噪声信号过滤和重加权强化表示,这样可以有效减少特征传播过程中误导性信息的出现,降低噪声的干扰。而且,通过强化特征进一步挖掘可利用线索,可以在特征融合时提供更多的对齐基准,进而提高语義分割的准确性。

模块设计原理如图2所示。本文利用RGB模态中的高自信激活部分辅助优化深度特征的提取,过滤掉低级别的异常深度激活信号。具体来说,首先从通道角度对两种特征进行全局平均池化,获取两种模态的全局空间信息,并通过这些信息获得跨模态优化的注意力向量:

φ=GAP(RGBin‖Depthin)(1)

其中:‖ 表示两种模态信息的特征映射的连接;GAP表示全局平均池化;φ 描述了跨模态信息全局的表达,用于展示整个输入的表达性统计信息。之后,将两种模态的特征映射输入到MLP操作中,通过将权重值变换为(0,1)的sigmoid函数对整个输入的信息进行表达性统计:

Wdepth=δ(FMLP(φ))(2)

其中:FMLP(φ) 表示MLP网络;δ 是输入信息经sigmiod函数将权重值转换为(0,1)值。这样,神经网络在学习过程中就可以通过光感特征和几何特征中最具有表达性和显著性的部分对深度流中异常的噪声信息进行过滤。然后,通过将过滤后的深度特征映射与输入到MLP中的交叉信息进行信道相乘,获得过滤后的深度表示,即过滤后的深度信息为

这样,就可以获得高质量的深度特征,这些更精确的深度特征在特征融合时会成为更精准的对齐基准,从而增强对RGB特征的响应。同样地,利用过滤后的深度信息中的高自信激活部分,对RGB图像中的异常噪声进行抑制。在实践中,本文采用这种对称和双向的方式重新校准不同模态信息,进而实现特征的强化聚合。

1.2.2 特征差异性互补

不同模态的特征具有不同的特性,例如RGB图像具有丰富的纹理、色彩等信息,深度图像则包含大量的几何线索。双流网络在特征提取时关注的注意力方向会因模态特性不同而不一致,而两者又具有强相关性。为了充分发挥多模态信息的优势,利用彼此的相关性,本文先对存在差异性的两种特征按通道分组,利用卷积操作进行权重分级,求得特征显著性,从而实现特征质量评估。然后,选取显著部分(经过概率转变后,大于0.5显著因子)补充到特征融合阶段,与融合后的交互信息实现特征重建增强。这种增强方式针对的是不同模态中最显著的部分,既可以进一步发挥各自的优势,还能够进一步丰富跨模态线索,从而输出更加细化的显著图。消融实验的结果和对比实验中模型可视化图部分验证了这种互补方法的有效性。具体的关于差异性信息互补性的衡量则是通过下文中特征质量评估方法IDM实现的。

特征差异性互补模块如图3所示。首先将两个编码器输出的RGB特征和深度特征输入到IDM模块进行特征质量评估。然后,对单模态特征的贡献基于评估的结果进行重加权表示,以促使神经网络在特征提取过程中将注意力偏向于特征图显著且具有各自代表性的区域。

然后,求得I(i) 的平均值β 作为F(i) 的显著因子,通过softmax函数归一化显著因子B=(β1,…,βk)T,就可以得到给定特征的质量评估结果。下一步,选取特征最显著部分(大于0.5显著因子)进行特征增强得到 Fb,并通过卷积操作得到显著特征的特定表示 Fp。

至此,可以获得两种模态信息中最显著的部分,同时,也是最具有代表性和差异性的部分。进一步地,将获取的显著信息补充到特征交互融合阶段,进行重建增强,以实现对多模态特征的充分探索和利用。

1.2.3 特征交互融合在特征融合阶段,将两种模态信息统一为一种高效的表示形式是非常有挑战性的任务。不同于以往直接将两种模态信息相加或相乘的融合方法,考虑到室内环境的复杂性,需要进一步突出多模态线索,以输出更细致的显著图。本文设计了一种特征重组-交互的方式,在多模态特征传递时,通过交叉组合,将不同模态的特征紧密结合在一起来突出有效线索。这种交互融合的方式从更深层次结合多模态特征,可以获得更丰富、更准确的校准信息,使得模型能够更加全面地学习多模态信息,从而提高其对场景语义分割的准确度。

本文方法从通道角度对两种模态特征进行切割、重组和交互,更深层次地结合深度特征和RGB特征,不仅强调了不同模态中的一致重要信息,还充分探索了不同层次之间的跨模态有效线索。多模态特征交互融合模块如图4所示。首先将两种模态特征fri 和ftj 按信道方向平均分成两部分,得到fij,在形式上为

fri,tj=Cat(fri,ftj) i=1,2; j=1,2

fri,rj=Cat(fri,ftj) i=1; j=2

fti,tj=Cat(fri,ftj) i=1; j=2(11)

其中:Chunk是沿通道轴分裂的操作;Cat是沿通道轴连接的操作。之后,将四个特征按信道方向成对拼接,得到多方位特征。同时,通过计算不同模态中每一对特征的乘积,强调了一致的重要信息,具体的过程是:

然后,为了进一步探索跨模态线索,混合这两种类型的特征,将它们连接起来,用归一化(BN)的卷积层和ReLU函数来优化特征 Frti 并调整通道数量。这样,就可以得到紧密聚合的特征 Fi 。

1.3 双路径协同引导结构基于文献[14],不同阶段的特征是整个对象不同层次的体现。高层特征具有丰富的综合性和边缘性的语义信息,底层特征受限于感受野的因素,具有丰富的局部性细节信息。为了追求更丰富的跨模态线索,本文设计了一种多阶段多尺度相互引导融合的机制,充分利用不同阶段的语义信息特点,优化多层次多模态特征聚合的结果。具体实现的过程是将交互融合后的特征提供给双向引导组件。双向引导组件致力于发挥不同阶段、不同尺度特征的特点,利用高层具有的丰富的语义信息,先自顶向下引导和底层特征的融合,之后,利用融合后的具有丰富细节信息的底层特征细化高层特征输出。通过两个路径聚合多尺度多层次特征,输出精确的语义分割结果,实验结果证明了这种解码机制更适合本文设计的框架结构。

双路径协同引导结构的工作流程如图5所示。

在解码阶段,首先获取融合特征的显著部分,方法与特征差异性互补模块中的方法一致,通过上采样,将特征调节器的输出与前一层获取显著特征相融合,由此获得融合后的特征SGi (i=0,1,2)。然后,通过下采样,将引导后的底层特征FRj (j=0,1,2)与下一阶段的高层特征SGj+1相融合,输出最终的语义分割显著图。

整个相互引导机制可以分为语义引导层(SG)和特征细化层(FR)两个部分。在语义引导层,先提取融合特征 FCi 的显著部分,并通过一个3×3卷积运算对该部分进行优化,得到输出 FCni。之后,经过特征调节器输出的高层特征 FCi+1 通過1×1卷积和平均池化操作后与前者进行元素点乘,接着,FCi+1 在经过上采样和3×3卷积运算后与点乘结果累加,输出引导后的特征 SGi,该步骤依次迭代至语义引导层结束。在特征细化层,底层特征 FRj-1 先经过3×3卷积操作后与 SGi 进行元素点乘,之后,点乘结果与 SGi 累加并通过1×1卷积输出细化后的特征 FRj。其中,所有的卷积操作都是在ReLU激活下进行的,整个流程可以描述为

2 实验针对基于RGB-D信息进行室内语义分割容易出现显著图粗糙、语义分割结果精度低的问题,本文提出了一个基于RGB-D信息的室内场景语义分割模型,其在光照条件恶劣、空间结构复杂以及物体堆叠等室内场景下可以获得更好的分割结果。本文在公开的室内场景数据集NYUD-v2[15]上进行了大量的对比和消融实验,NYUD-v2数据集包含了各种室内环境,可以验证算法的性能。此外,为了验证算法的鲁棒性,本文在SUN RGB-D[16]数据集上进行了对比实验,作为算法性能检验的补充。SUN RGB-D数据集包含了NYUD-v2数据集的所有图片,还额外具有8 886张室内场景图像,通过在此数据集上进行对比实验,验证了本文算法不仅在一个特定的数据集上表现良好,而且在不同数据集的场景下仍能保持较高的准确性,这种一致的表现可以被认为是算法鲁棒性的一个指标。通过与最近发表的最先进算法进行比较,本文算法在NYUD-v2和SUN RGB-D数据集上都取得了最佳结果,证明了算法的先进性和模型的鲁棒性。此外,本文还进行了严谨细致的消融实验,验证了每个方法和模块的可行性。

2.1 实验细节

本文实验平台使用 PyTorch,所有实验在一台内存为24 GB的 GeForce RTX 3090 上运行。在参数设置方面,本文对设计的模型进行了300个epoch的学习,batch size为6,使用 SGD 作为优化器,在模型训练的300个 epoch 中,设置动量参数为0.9,初始学习率为 5E-3,并随着训练轮数增加递减学习率,利用当前训练轮数与总训练轮数的比例控制学习率递减速度,并以0.9的指数进一步调整学习率的递减速度。为了防止过拟合,设置权重衰减为0.000 5。在数据预处理方面,本文采用了类似于文献[8,9,17~19]的数据增强方法,包括随机水平翻转、随机缩放和随机裁剪等技术。在每一轮的训练中,将数据集的输入设定为480×640的分辨率,RGB特征和深度特征先经过特征强化聚合模块实现噪声过滤和特征的重加权表示。之后,特征差异性互补模块利用特征质量评估,选取具有代表性的差异性信息补充到不同模态,并将重建的特征采取重组交互的方式进行特征融合。此外,获取融合后特征的显著部分信息补充到双向引导组件,以进一步发挥多模态特征的优势。在解码阶段,通过双重引导解码的方式融合不同层次、不同尺度的特征,输出更细致的语义分割图。

2.2 数据集和评估指标实验细节本文在具有说服力和挑战性的NYUD-v2数据集上对本文方法进行评估和对比,并在SUN RBG-D数据集上进一步验证了本文方法的泛化性和鲁棒性。NYUD-v2数据集由各种室内场景的视频序列组成,总共包括1 449张室内空间RGB-D图像,在数据集制作时,本文选择其中 795 张图像作为训练集,另外 654 张图像作为测试集,采用通用的标签设置,所有的标签都映射到40个类。SUN RGB-D数据集包含了NYUD-v2数据集的所有图片,具有10 335张室内场景RGB-D图像,本文采用包含5 285张图片的官方训练集进行训练,以及包含5 050张图片的官方测试集对模型进行评估。在评价指标方面,本文采用了近期研究[9,11,17,18,20,21]中广泛使用的三个指标,即类别平均精度 (mAcc)、平均交并比 (mIoU) 和像素准确率 (pixel Acc.)。

2.3 对比实验本节评估了本文模型在 NYUD-v2 数据集上的性能,并通过可视化部分场景的语义分割结果,与目前先进的算法进行比较。表1 显示了使用 ResNet-50 作为骨干与最先进模型在 NYUD-v2 数据集上的性能比较,图6分别展示了RGB、depth和GT图像,以及RGB单模态、FuseNet、ACNet、ESANet、RedNet和本文模型的可视化结果。

图6中的场景包括灯光昏暗的卧室、空间狭小的浴室、物体体型较小的厨房、摆放杂乱的玩具房、长焦镜头拍摄的书桌、广角镜头拍摄的餐厅,以及包含动态人物的场景。这些场景覆盖了曝光、物体遮挡、物体重叠、灯光昏暗、物体细小和布局紧密等复杂环境。本文模型在这些不同场景的室内环境下都能够产生更精细和准确的分割结果。从以上展示的可视化结果可以直观地看到,本文算法在细节分割方面优于其他方法。在没有深度信息的情况下,RGB单模态分割结果的性能较差,特别是对物体边缘的分割效果很差,很难准确识别物体语义。这是因为在没有深度信息的情况下,很难从RGB图像中提取出空间深度信息,因此很难进行精确的物体分割。FuseNet通过结合深度信息,提升了物体边缘的分割效果,但是由于其使用反卷积操作,导致生成的图像会产生棋盘效应和颗粒感,从而影响分割结果的精度和细节表现。ACNet和RedNet通过上采样等措施缓解了这种效应,但从用户的角度来看,仍然会产生较为模糊不清的分割图像。与之相比,ESANet的模型采用了中间融合策略和跳跃连接等方式,可以更好地提取RGB和深度特征,并进一步利用跨模态线索来优化分割结果的几何层面。然而,ESANet在准确分割和噪声去除方面仍有待进一步优化。本文模型能够更加准确地分割出堆叠的物体、识别在强曝光场景下的物体,并且在分割不同距离物体时表现更佳。特别是在物体边缘处理方面,本文模型的细化分割效果也是最好的。这得益于对多模态特征的优化提取和深层次整合,从而获取了更多有效的跨模态线索,进一步增强了几何层面的语义分割结果。这种方法在环境复杂、光照条件恶劣的室内场景中能够实现更好的场景语义分割。在NYUD-v2数据集上进行的对比和消融实验都证明了本文模型具有良好的鲁棒性和先进性。本文模型与目前最先进的语义分割方法在 NYUD-v2 数据集上,基于 mAcc、mIoU 和 pixel Acc. 三个主要评价指标进行了语义分割性能比较。如表1 所示(本文使用官方的开放源代码复现了部分模型,所有的实验设置都与本文模型参数一样),本文提出的特征调节器和双路径协同双向引导解码方式的训练结果能够媲美目前先进的算法,在 ResNet-50 的 backbone 上,mIoU结果可以达到 48.5% 。其中,本文模型比目前先进的语义分割算法 REDNet[18] 在主要指标 mIoU 上提高了 4.5%,比 ACNet[17] 提高了 4.7%,比 ESANet[1]提高了 1.2%。这些算法有的专注于多模态特征融合策略,有的专注于特征提取过程,各自研究的方法都达到了很好的效果,但在场景语义分割的结果上还有所欠缺。本文的研究同时考虑了这两个过程,在多模态特征融合过程中采用中期融合的策略优化特征提取,将高质量的多模态线索传递到神经网络深层,同时连接到解码过程,再通过不同阶段特征双向引导的方式完成了更精准的室内场景分析。本文还与一些其他 backbone 的模型进行比较,在分割性能方面依旧优于基于 Transformer 的 AdaPoinTr 的 44.1%精准度,对比多任务学习模型 TLAM 的结果提高了 10.2%。其中,FuseNet、ACNet、REDNet 和 ESANet 模型的分割结果是在与本文模型相同的环境配置下进行的模型复现,这种比较方式更有说服力。

此外,如表2所示,本文算法还与更深层次的算法网络进行了比较,即使使用更少的神经网络层数,依旧能够提高场景解析的性能,在主要指标mIoU上高于使用ResNet152结构的 RDFNet和CFNet的47.7%,相较于RefineNet提高了2.6%。这表现出本文模型在网络设计和参数设置方面的优越性,使其能够更加有效地利用特征信息,在减少网络计算和存储成本的同时,实现更准确的语义分割结果。

为了进一步验证本文算法的泛化性和鲁棒性,在更大的数据集SUN RGB-D上与目前先进的语义分割算法进行了比较,实验结果如表3所示。由于数据集庞大,本文在实验参数设置时只进行了200个epoch的训练,其他参数设置与NYUD-v2数据集实验一致。本文算法在该数据集上,即使面对更恶劣的光照条件和更复杂的室内环境,主要指标mIoU依旧达到了最高的47.6%,相较于RefineNet提高了1.9%,比SGNet提高了0.5%。其證明了在不同类型的对象下,本文提出的特征调节器可以充分发挥多模态特征各自的优势,并通过双路径引导结构,充分利用各个层次模态的特点,在不同数据集上能够实现更高的语义分割精度,输出更细致的室内语义分割显著图。

2.4 消融實验为了验证提出的特征调节器和双路径协同引导结构的效果,本文基于NYUD-v2 数据集,在相同的环境配置和超参数下进行了消融实验。在消融实验中,采用了mAcc、mIoU 和 Pixel Acc. 这三个评价指标,对比了特征调节器、双路径协同引导结构以及两者结合的模型,并且针对不同的特征融合策略进行了比较。

本文设计的特征调节器主要由三个部分组成,分别是能够过滤噪声的特征强化聚合模块、能够提取显著区域信息的特征差异性互补模块,以及可以紧密结合多模态信息的特征交互融合模块。为了验证特征调节器的性能,分别对三个模块进行了消融实验,结果如表4所示,以主要评价指标 mIoU 为评价标准,其可视化结果如图7所示。

从表4中可以看出,初始模型的语义分割结果为45.5%。在多模态特征未经过特征强化聚合模块进行特征筛选和强化的情况下,将多模态特征重组交互后模型的性能提高了0.7%。即使目前网络中存在异常噪声,特征重组仍旧能紧密结合两种模态信息,提高模型的鲁棒性。第5行的结果是加入特征强化聚合模块后的模型输出结果,性能提高了0.9%。这说明在排除异常噪声后,神经网络对室内场景学习和分析的能力得到了大幅提高。这一点还可以体现在第6行与第8行结果的对比上,因为更多有效几何信息的加入,模型语义分割的能力在特征经过噪声过滤和强化聚合后得到了显著的提升。为了更好地探索和利用多模态信息的优势,本文将两种单模态各自具有特性的部分延展到特征融合的阶段,通过传播多模态特征的差异性到网络中,实现跨模态传播共享特征和特定特征,以弥补缺少的特定信息并增强共享特征。通过特征重建增强,模型语义分割准确率提高了1.4%。该方法不需要对样本相似性进行建模,也无须接收邻近模态信息,从而大大减少了计算量和参数。第3行与第6行的对比结果验证了本文策略的正确性。

本文针对 ResNet50架构设计了双路径协同引导结构,通过聚合不同尺度的多模态特征和融合不同时期不同层次的特征表现,在挖掘和利用跨模态线索方面取得了非常好的效果。同时,考虑到初始数据对深度学习过程的指导作用非常重要,特别是随着深度网络的加深,这一作用愈加重要。因此,本文使用了类似于跳跃连接的方式对特征数据进行跨结构传输。不同的是,本文算法不直接传输数据,而是先对多模态特征融合结果进行显著信息提取,然后将提取的显著信息与解码过程中的特征信息进行多步骤的乘法和加法处理,从而取得了最好的实验结果48.5%。表4中第7行和第8行的结果表明,对融合特征进行显著性提取,确实可以进一步提高语义分割效果。

基于特征融合是多模态信息的重要环节,本文设计的多模态特征交互融合方法与目前比较流行和公认的特征融合方法结果进行了对比。表5的实验结果表明,本文算法在通道方面的独特设计,使其比基于RGB-D对应元素总和(即基线)、卷积注意力(CBAM)和SE注意力机制的特征融合方法性能表现更好。这验证了通过特征重组交互的方式,可以有效地紧密结合多模态特征。本文还展示了这几种不同特征融合方式的语义分割图,如图8所示。通过获取更丰富的跨模态线索,本文模型语义分割的结果在物体边缘分割和重叠物体区分等精细分割部分有更好的表现。

3 结束语

本文从多模态特征在神经网络中的提取和传递过程出发,针对现有语义分割算法难以妥善处理多模态数据、无法高效融合多模态特征的问题,提出了一个特征调节器,用于优化特征提取和传递过程。该组件在编码器阶段通过对双流特征进行筛选实现噪声去除,并通过特征差异性互补的方式实现共享特征和特定特征在神经网络中的传输,同时结合交互融合的方式进一步获取跨模态信息。在解码阶段,本文设计了双路径协同引导结构,用于融合多尺度、多层次的特征信息,并通过传递融合特征的显著部分到解码阶段,进一步提高了语义分割的准确率。相对于以往方法,本文方法在公开数据集NYUD-v2上的性能取得了更好的结果。

参考文献:

[1]Chen Xiaokang,Lin K Y,Wang Jingbo,et al. Bi-directional cross-modality feature propagation with separation-and-aggregation gate for RGB-D semantic segmentation [C]//Proc of European Conference on Computer Vision. Cham: Springer International Publishing,2020: 561-577.

[2]Fernando H,Shen Han,Liu Miao,et al. Mitigating gradient bias in multi-objective learning: a provably convergent approach [C]// Proc of the 11th International Conference on Learning Representations. 2022.

[3]Sun Xinglong,Hassani A,Wang Zhangyang,et al. DiSparse: disentangled sparsification for multitask model compression [C]// Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway,NJ: IEEE Press,2022: 12372-12382.

[4]Popovic' N,Chakraborty R,Paudel D P,et al.Spatially multi-conditional image generation [C]// Proc of IEEE/CVF Winter Conference on Applications of Computer Vision. Piscataway,NJ: IEEE Press,2023: 734-743.

[5]Wu Zongwei,Allibert G,Stolz C,et al.Depth-adapted CNNs for RGB-D semantic segmentation [EB/OL]. (2022-06-08) [2023-07-29]. https://doi. org/10. 48550/arXiv. 2206. 03939.

[6]Dong Zihao,Li Jinping,Fang Tiyu,et al. Lightweight boundary refinement module based on point supervision for semantic segmentation [J]. Image and Vision Computing,2021,110: 104169.

[7]Cao Jinming,Leng Hanchao,Lischinski D,et al. ShapeConv: shape-aware convolutional layer for indoor RGB-D semantic segmentation [C]// Proc of IEEE/CVF International Conference on Computer Vision. Piscataway,NJ: IEEE Press,2021: 7088-7097.

[8]Wu Zongwei,Gobichettipalayam S,Tamadazte B,et al.Robust RGB-D fusion for saliency detection [C]// Proc of International Conference on 3D Vision. Piscataway,NJ: IEEE Press,2022: 403-413.

[9]Seichter D,Khler M,Lewandowski B,et al. Efficient RGB-D semantic segmentation for indoor scene analysis [C]// Proc of IEEE International Conference on Robotics and Automation. Piscataway,NJ: IEEE Press,2021: 13525-13531.

[10]Li Weihong,Liu Xialei,Bilen H. Universal representations: a unified look at multiple task and domain learning [J/OL]. International Journal of Computer Vision. (2023-11-24). https://doi.org/10.1007/s11263-023-01931-6.

[11]Hazirbas C,Ma Lingni,Domokos C,et al. FuseNet: incorporating depth into semantic segmentation via fusion-based CNN architecture [C]// Proc of the 13th Asian Conference on Computer Vision. Berlin: Springer International Publishing,2017: 213-228.

[12]Chen Linzhuo,Lin Zheng,Wang Ziqin,et al. Spatial information guided convolution for real-time RGBD semantic segmentation [J]. IEEE Trans on Image Processing,2021,30: 2313-2324.

[13]He Kaiming,Zhang Xiangyu,Ren Shaoqing,et al. Deep residual learning for image recognition [C]// Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ: IEEE Press,2016: 770-778.

[14]Zeiler M D,Fergus R. Visualizing and understanding convolutional networks [C]// Proc of the 13th European Conference on Computer Vision. Cham: Springer,2014: 818-833.

[15]Silberman N,Hoiem D,Kohli P,et al. Indoor segmentation and support inference from RGB-D images [C]// Proc of the 12th European Conference on Computer Vision. Berlin: Springer,2012: 746-760.

[16]Song Shuran,Lichtenberg S P,Xiao Jianxiong.Sun RGB-D:a RGB-D scene understanding benchmark suite [C]// Proc of IEEE Confe-rence on Computer Vision and Pattern Recognition. Piscataway,NJ: IEEE Press,2015: 567-576.

[17]Hu Xinxin,Yang Kailun,Fei Lei,et al. ACNet: attention based network to exploit complementary features for RGB-D semantic segmentation [C]// Proc of IEEE International Conference on Image Proces-sing. Piscataway,NJ: IEEE Press,2019: 1440-1444.

[18]Jiang Jindong,Zheng Lunan,Luo Fuo,et al. REDNet: residual encoder-decoder network for indoor RGB-D semantic segmentation [EB/OL]. (2018-06-04) [2023-07-29]. https://doi. org/10. 48550/arXiv. 1806. 01054.

[19]Park S J,Hong K S,Lee S. RDFNet: RGB-D multi-level residual feature fusion for indoor semantic segmentation [C]// Proc of IEEE International Conference on Computer Vision. Piscataway,NJ: IEEE Press,2017: 4980-4989.

[20]Abbasi K,Razzaghi P. Incorporating part-whole hierarchies into fully convolutional network for scene parsing [J]. Expert Systems with Applications,2020,160: 113662.

[21]Lin Guosheng,Milan A,Shen Chunhua,et al. RefineNet: multi-path refinement networks for high-resolution semantic segmentation [C]// Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ: IEEE Press,2017: 1925-1934.

[22]Groenendijk R,Dorst L,Gevers T. MorphPool: efficient non-linear pooling & unpooling in CNNs [EB/OL]. (2022-11-25) [2023-7-29]. https://doi. org/10. 48550/arXiv. 2211. 14037.

[23]Yu Xumin,Rao Yongming,Wang Ziyi,et al. AdaPoinTr: diverse point cloud completion with adaptive geometry-aware transformers [J]. IEEE Trans on Pattern Analysis and Machine Intelligence,2023,45(12): 1414-14130.

[24]Lin Di,Chen Guangyong,Cohen-Or D,et al. Cascaded feature network for semantic segmentation of RGB-D images [C]// Proc of IEEE International Conference on Computer Vision. Piscataway,NJ: IEEE Press,2017: 1311-1319.