基于轨迹引导的移动机器人导航策略优化算法

2024-06-01李忠伟刘伟鹏罗偲

李忠伟 刘伟鹏 罗偲

摘 要:针对在杂乱、障碍物密集的复杂环境下移动机器人使用深度强化学习进行自主导航所面临的探索困难,进而导致学习效率低下的问题,提出了一种基于轨迹引导的导航策略优化(TGNPO)算法。首先,使用模仿学习的方法为移动机器人训练一个能够同时提供专家示范行为与导航轨迹预测功能的专家策略,旨在全面指导深度强化学习训练;其次,将专家策略预测的导航轨迹与当前时刻移动机器人所感知的实时图像进行融合,并结合坐标注意力机制提取对移动机器人未来导航起引导作用的特征区域,提高导航模型的学习性能;最后,使用专家策略预测的导航轨迹对移动机器人的策略轨迹进行约束,降低导航过程中的无效探索和错误决策。通过在仿真和物理平台上部署所提算法,实验结果表明,相较于现有的先进方法,所提算法在导航的学习效率和轨迹平滑方面取得了显著的优势。这充分证明了该算法能够高效、安全地执行机器人导航任务。

关键词:移动机器人自主导航;轨迹预测;轨迹-图像融合;轨迹约束;深度强化学习

中图分类号:TP242.6 文献标志码:A 文章编号:1001-3695(2024)05-025-1456-06

doi: 10.19734/j.issn.1001-3695.2023.09.0422

Autonomous navigation policy optimization algorithm for mobile robots based on trajectory guidance

Abstract:Addressing the exploration challenges faced by mobile robots using deep reinforcement learning for autonomous navi-gation in cluttered, obstacle-dense complex environments, this paper proposed the trajectory-guided navigation policy optimization (TGNPO) algorithm. Firstly, it employed an imitation learning approach to train an expert policy for a mobile robot, which could provide both expert demonstration behavior and navigation trajectory prediction and aimed to comprehensively guide the training of deep reinforcement learning. Secondly, it fused the predicted navigation trajectory from the expert policy with real-time images perceived by the mobile robot at the current moment. Combining the coordinate attention mechanism, it extracted feature regions which would guide the robots future navigation, thereby enhancing the learning performance of the navigation model. Finally, it utilized the navigation trajectory predicted by the expert policy to constrain the policy trajectory of the mobile robot, mitigating ineffective exploration and erroneous decision-making during navigation process By deploying the proposed algorithm on both simulation and physical platforms, experimental results demonstrated significant advantages in navigation learning efficiency and trajectory smoothness compared to existing state-of-the-art methods which fully proves the proposed algorithms capability to efficiently and safely execute robot navigation tasks.

Key words:autonomous navigation of mobile robots; trajectory prediction; trajectory-image fusion; trajectory constraint; deep reinforcement learning

0 引言

在移動机器人领域,自主导航被视为最为普遍的任务之一。特别是在杂乱、拥挤的环境下,机器人需要有效地解决避障、轨迹平滑以及避免次优解等问题,这增加了自主导航过程的复杂性和挑战性。

当面临复杂环境时,大多数传统基于地图的方法[1,2]的实现将变得困难。尽管已经有一些研究[3,4]在导航过程中可以无须地图信息,但是传统方法在应对复杂环境时缓慢的计算速度和对原始传感器数据中的噪声敏感性,降低了自主导航的效率。

近年来,为了解决传统算法在自主导航问题中的不足,已经提出了许多基于学习的方法[5~7]。其中一种称为模仿学习(imitation learning,IL)的方法[8~10]在移动机器人导航任务中实现了快速推理。这些方法基于深度神经网络强大的表示能力,直接将原始高维感官数据(如RGB图像和激光雷达点云)作为输入,并输出低级控制命令(如转向和油门)。然而,虽然IL可以高效地从专家演示中提取导航知识,但面临一个常见问题是分布不匹配,即模型在训练数据上表现良好,但在实際执行中的数据上可能表现不佳,这是因为训练数据和实际执行数据之间存在差异。

另一种基于深度强化学习(deep reinforcement learning, DRL)[11]的方法在移动机器人自主导航领域得到广泛应用[12~14]。DRL方法使移动机器人与环境互动学习,根据试错和奖励来改善其行为,其中一类被称为无模型的深度强化学习(model-free DRL)[15~18]。尽管无模型的深度强化学习在某些情况下表现出色,但在复杂环境中,状态空间可能变得极其庞大,包含大量不同的变量和可能的取值组合,这使得深度强化学习算法需要花费大量时间和资源来探索这个庞大的状态空间,以学习出适当的策略,从而导致学习效率低下。

为了提高移动机器人的学习效率,一些研究[19,20]提出模仿学习与深度强化学习相结合的方法。这些方法利用仅包含专家示范行为的专家策略来指导智能体(移动机器人)学习,通过衡量每一时刻专家策略与DRL策略之间的差距来决定采取哪种策略,虽然一定程度上可以降低智能体的自主探索率,但是可能导致专家策略对智能体的学习产生过多干预。

针对上述问题,本文使用模仿学习与深度强化学习结合的框架,并受Cimurs等人[21]提出的从环境中获得可能导航方向的兴趣点(PoI)这一观点的启发,提出了一种基于轨迹引导的移动机器人导航策略优化方法,下文叙述中DRL策略等同于导航策略。TGNPO中的专家策略考虑了专家示范行为和导航轨迹预测。专家策略的导航轨迹预测具备对导航中的关键特征区域的了解,将这些预测轨迹与机器人实时感知的图像融合,可以帮助导航策略模型更快地识别并了解这些特征区域,提高自主探索时模型的学习性能。同时,TGNPO中的轨迹约束的关键在于在自主探索和专家干预之间建立平衡。机器人首先有机会自主探索环境,这有助于了解环境和积累经验。然而,当自主探索的距离大于约束距离时,专家干预将确保机器人不会远离安全范围,从而降低了进一步探索的风险。这种平衡有助于提高学习效率,因为它允许机器人在探索和专家干预之间取得良好的折中。本文的主要贡献如下:

a)针对目前模仿学习中的专家策略都是只输出专家示范行为,忽略专家轨迹对导航策略的影响这一问题,提出在每一时刻可以同时提供专家示范行为与导航轨迹预测功能的专家策略,更全面地指导移动机器人导航策略优化。

b)提出一种新颖的轨迹-图像融合的方法,以迅速识别图像中对移动机器人未来导航具有指导意义的特征区域,提高导航模型性能。

c)提出一个新的基于轨迹约束的决策标准,用于移动机器人在特定时刻决定执行专家示范行为还是DRL策略,以在不同情境下优化决策。

e)提出一种适用于连续环境的惩罚-奖励机制,以提升DRL策略在模仿专家示范行为的准确性。

1 问题构建

本文讨论移动机器人在连续空间中学习自主导航,并将深度强化学习问题定义为马尔可夫决策过程(Markov decision process,MDP)中的策略搜索。MDP由状态空间Euclid Math OneSAp、动作空间Euclid Math OneAAp、转移概率Euclid Math OnePAp、奖励函数Euclid Math OneRAp:Euclid Math OneSAp×Euclid Math OneAApEuclid ExtraaApEuclid ExtraaBp,以及折扣因子γ组成。假设移动机器人处于状态st,依据DRL策略π选择动作at,π:Euclid Math OneSApEuclid ExtraaApEuclid Math OneAAp;基于选择的动作,移动机器人从环境中获得奖励rt,依据转移概率p(st+1|st,at)到达下一个状态st+1;重复此过程形成一条导航路径τ=(st,st+1,…,sT)。

1.1 状态空间

移动机器人自主导航的状态空间由元组(sp,sl,sg,sd)组成。其中,sp为当前时刻的RGB图像数据,sl为激光雷达数据,sg 为导航目标位置,sd为移动机器人实时方向角。图像数据捕捉视觉特征,激光雷达数据提供障碍物和距离信息,目标点位置和方向角则有助于移动机器人进行导航和位置定位。这些多模态数据类型可以提供丰富的环境信息,从而增强移动机器人的环境感知能力。

1.2 动作空间

移动机器人的动作空间包括连续的线性速度v和角速度w。经过一系列仿真测试,设置v∈[0,0.6]和w∈[-1,1]。动作空间范围的设定经过系统的分析和综合评估,旨在深入理解移动机器人在复杂环境中的运动行为。

1.3 奖励函数

奖励函数对于指导移动机器人在环境中学习和优化导航策略具有重要影响。本文构建了包含碰撞情况、导航目标点、机器人方向角与偏航角在内的多维状态信息的奖励函数,以引导机器人学习适应性的自主导航策略。具体的计算公式为

R(st)=Rg(st)+Rc(st)+Rh(st)+Rd(st)(1)

其中:Rg(st)为移动机器人到达目标点的奖励函数,其值为rgoal;Rc(st)为碰撞奖励函数,值为rcollision;Rh(st)为关于方向角与偏航角的奖励函数,如式(2)所示。

其中:式(2)中的h为移动机器人的方向角与偏航角之间的差值,用来表示移动机器人当前朝向与其期望朝向之间的偏差,其计算如式(3)所示;h0与h1为偏差阈值,在其范围内,h越小,移动机器人获得的奖励越高。

其中:a tan2(yg-y,xg-x)为反正切函数,用来计算移动机器人的方向角;yaw为偏航角;a tan2(yg-y,xg-x)-yaw 为方向角与偏航角差值,记为h*;(x,y)为移动机器人当前时刻的坐标;(xg,yg)为导航目标点坐标。

式(1)中的Rd表示移動机器人在当前时刻相对于前一时刻与目标点的距离的变化量,其计算公式如式(4)所示。

Rd(st)=‖ct-cg‖-‖ct-1-cg‖(4)

其中:ct为移动机器人在t时刻的坐标,cg为导航的目标点。

2 轨迹引导策略优化

本文提出的TGPON算法框架如图1所示,主要由四个模块构成,即专家策略模块、轨迹-图像融合模块、DRL模块、轨迹约束模块。专家策略模块在处理输入时仅考虑了RGB图像这一信息源。相比之下,DRL模块具有更丰富的信息输入,包括RGB图像、激光雷达数据、导航目标位置和方向角等多个数据维度。这种多维信息的融合使得DRL模块具备更全面的环境感知和任务理解能力,有助于更智能地制定导航决策和学习适应不同情况的策略。TGNPO通过轨迹-图像融合的方法改进DRL模块的价值与策略网络,显著提升了模型的学习性能,使模型更深入地理解环境。此外,该算法对移动机器人在深度强化学习策略下生成的导航轨迹进行了约束,以使机器人在处理复杂环境时表现得更加出色。算法流程如算法1所示。

算法1 TGNPO算法

2.1 专家策略模块

专家策略在自主导航中发挥了关键作用,其对DRL策略的学习过程进行了指导。本文通过对以往专家策略的改进,使其在每一时刻不仅能够输出当前的专家示范行为,还能够预测未来I个时间步的专家导航轨迹。这样的改进使得专家策略成为一个更为强大和全面的引导器,能够提供更长远的指引信息,指导DRL策略在未来的一系列时间步中作出更优的决策。

专家策略模块主要采用了监督学习的方法,将专家数据(st,(aEt,wEt,…,wEt+I))中的st看作样本输入,此时的st仅为RGB图像数据。(aEt,wEt,…,wEt+I)为标签,其中aEt为专家示范行为,(wEt,…,wEt+I)为未来I个时间步的专家导航轨迹,学习的目标为

其中:Euclid Math OneLAp(πEψ(s),(a,w))为损失函数,采用适用于回归任务的MSE。πEψ(s)为要学习的专家策略网络,采用一种计算量小、参数少、轻量级的神经网络架构MobileNet-v3[22]。

2.2 轨迹-图像融合模块

移动机器人当前时刻所感知到的图像中蕴涵着未来导航轨迹的重要线索,而移动机器人在自主导航中对位置信息极为敏感,准确的定位对其至关重要。坐标注意力机制(coordinate attention)[23]不仅能够捕获跨通道信息,还捕获方向感知和位置信息,这有助于模型更准确地定位和识别感兴趣的对象。因此,本文提出将当前时刻的未来I个时间步的专家导航轨迹与当前时刻移动机器人所感知的实时图像状态融合,结合坐标注意力机制提取导航所需要关注的图像中的重点区域。

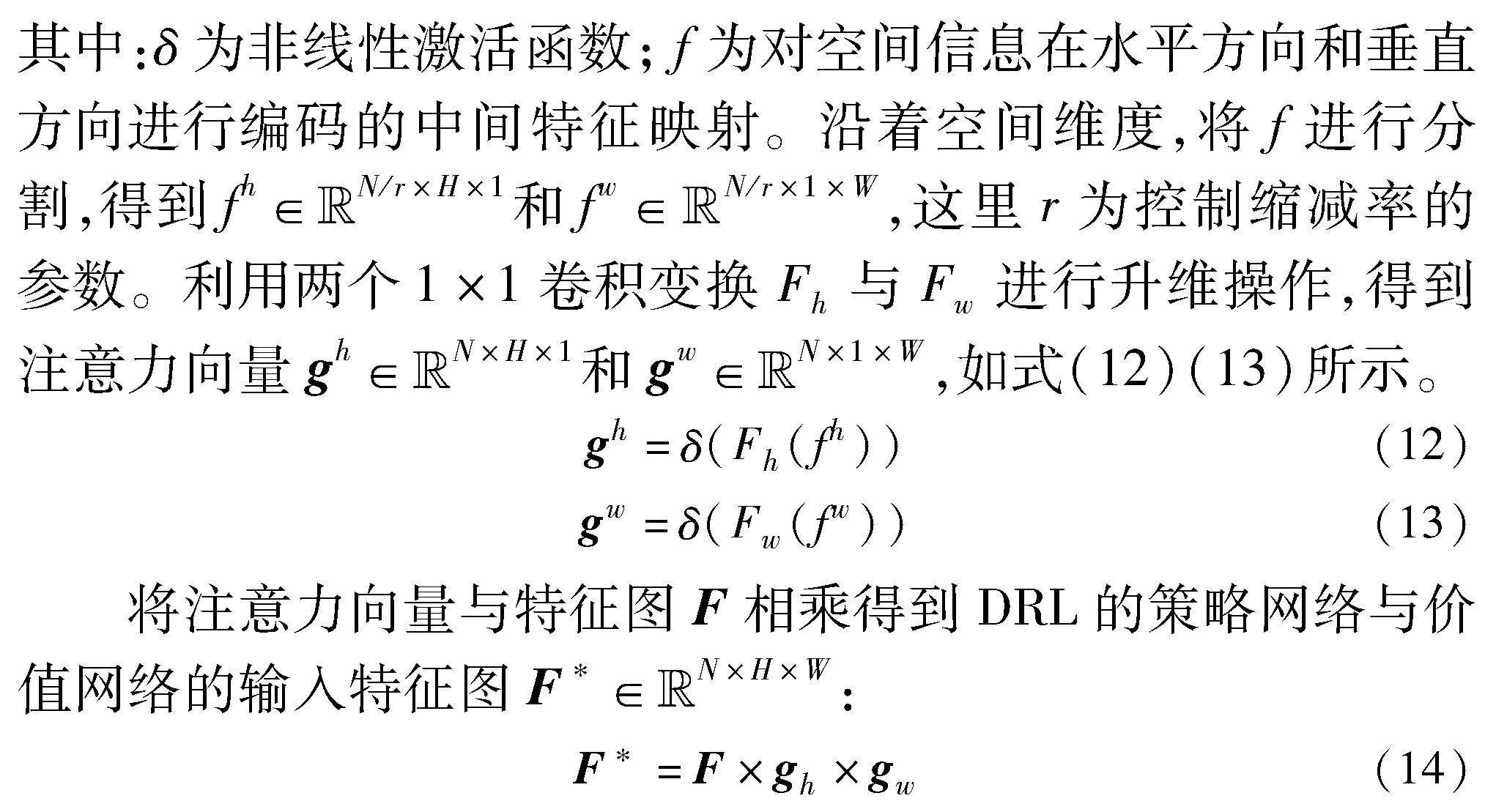

上述步骤实现了轨迹与图像的初步融合,在F上引入坐标注意力机制对其分配注意力权重,以便模型能够重点关注对导航起引导作用的特征区域。

对ZHN、ZWN进行合并,然后使用1×1卷积变换函数F1对其进行变换:

f=δ(F1([ZHN,ZWN]))(11)

上述方法将未来专家导航轨迹的特征表达FHM与FWM融合到图像特征中,捕捉不同特征之间的关联,丰富了特征图F的表达能力,自动地突出那些在未来导航中起关键作用的特征区域,提高移动机器人学习导航策略的效率。

2.3 DRL模块

TGNPO算法框架可以与广泛的深度强化学习算法协同工作,用于训练导航策略。本文选用了一种先进的离线策略方法,即soft actor-critic(SAC)[25]算法,来作为DRL的训练框架。该方法利用两个神经网络,包括估计状态-动作价值的Q网络Q,和策略网络πθ,和θ都是参数。在每一轮训练迭代中,算法通过交替执行策略评估和策略改进来进行训练。策略评估过程通过最小化熵正则化TD误差的L2范数来更新估计的Q函数:

图3展示了策略网络的结构示意图,而价值网络的结构与其类似。该模块首先对激光雷达数据、导航目标点位置以及方向角进行特征提取得到特征向量FM1;然后,从轨迹-图像融合模块得到F*并将其映射成特征向量FM2;最后,将FM1与FM2进行堆叠得到特征向量F′,再经过几层MLP后得到DRL策略aπ。该模块方法将不同传感器获取的信息进行堆叠,可以融合多个数据源的信息,从而获得更全面、多样化的特征表示。这有助于提升DRL策略网络的感知能力和决策质量。

2.4 轨迹约束模块

在复杂场景中,移动机器人面临巨大的探索空间,其中包含许多无效的行动路径,这给学习自主导航策略带来了挑战。TGNPO将未来专家导航轨迹与移动机器人自主探索轨迹之间的距离作为约束标准,在特定时间步通过模仿专家示范行为来引导移动机器人在复杂场景中进行探索学习。两条轨迹间的角度距离突出了轨迹的方向特征,欧拉距离突出了轨迹的空间分布特征。因此,本文结合方向与空间两个维度来计算距离d。

本文将移动机器人向前自主探索的步长等于专家策略预测的导航轨迹时间步长I。随后,通过计算这I个时间步长内移动机器人轨迹与专家轨迹的距离d,判断是否超过了预设的距离阈值η,其计算公式如式(18)所示。

其中:d_angle为两条轨迹的角度距离;d_euler为两条轨迹的欧拉距离;λ1与λ2分别为角度距离与欧拉距离的权重;tr_π为移动机器人自主探索的轨迹;tr_e为未来专家导航轨迹。tr_π·tr_e为两条轨迹的点积;‖tr_π‖×‖tr_e‖表示分别求两条轨迹的范数再相乘。

如果d<η,移动机器人将在下一个时间步采取DRL策略;否则,将在下一个时间步长引入专家策略进行干预,具体如图4所示。图5中,I=5并且d>η,在下一时刻专家将进行干预,移动机器人执行专家行为aE。

在此情景下,本文的目标是通过使用专家策略的指导,让移动机器人在执行任务时更加趋向于模仿专家的行为。为了实现这一目标, 本文借鉴Dey等人[26]提出构造转移元组(st,aπt,rpt,st+1)的方法,并且改进文献[27]中的非平滑的惩罚奖励函数,如式(19)所示,提出了一种基于双曲正切函数的连续平滑的惩罚奖励函数,如式(20)所示。

rpt=r-l(19)

rpt=r-|r|·tanh(‖aE-aπ‖/σ2)(20)

其中:r为正常的奖励值;l为惩罚常数项。式(20)中超参数σ用来控制模仿专家示范行为的精度,从而使移动机器人在执行任务时更加符合专家的行为模式。

3 实验分析

本章将通过对比实验来验证本文提出的TGNPO算法在导航性能方面的卓越表现,同时旨在通过消融实验来找到最佳导航轨迹。

在对比实验中,TGNPO与目前深度强化学习先进的SAC[25]、JIRL[26]和SAC-Lag[28]算法进行比较。在消融实验中,本文测试了轨迹-图像融合模块中的未来专家导航轨迹步长I与轨迹约束模块中的轨迹距离η这两个超参数对导航策略优化的影响。

下述指标用于评估TGNPO与其他方法之间的性能差异:

a)平均回报(average return,AR):移动机器人从起点到导航目标点所获的平均奖励总和。

b)平均轨迹长度(average trajectory length,ATL):移动机器人从起点到目标点的平均导航轨迹长度。

c)平均导航时间(average navigation time,ANT):移动机器人从起点到目标点的平均导航时间成本。

d)平均完成率(average completion rate,ACR):移动机器人从初始出发点到达碰撞点的距离与从初始出发点到导航目标点的距离之比,ACR∈[0.97,0.99]。

3.1 仿真对比实验环境

本文在Gazebo仿真平臺中构建了一个杂乱、障碍物密集的复杂环境,该环境划分简单和复杂区域,如图5所示。仿真移动机器人为搭载激光雷达、深度相机和控制器插件的LIMO智能车,如图6所示。深度相机拍摄的RGB图像大小为96×64,数据随后通过ROS(机器人操作系统)进行获取、传输。通过在这个具有挑战性的环境中进行实验,能够更全面地评估所提出的基于轨迹引导的移动机器人导航策略优化方法在面对复杂情况时的性能和适应能力。

本文实验使用一台配置有NVIDIA GTX 3090显卡、128 GB RAM以及Intel Xeon Silver 4216 CPU的计算机上训练导航策略。为了保证结果的稳定性和可靠性,所有实验使用了不同的随机种子来重复实验,共进行了5次训练。在训练中,移动机器人会在以下情况之一发生时终止训练:到达导航任务目标、发生碰撞,或执行了T个时间步。

表1列出实验所用到的超参数的值。

本文提出的TGNPO算法以及其他对比算法每次训练进行500个迭代。如图7(a)(b)所示,TGNPO在经过200个迭代的训练后迅速达到了收敛状态,其学得的导航策略能够生成奖励最高的导航轨迹。相比之下,JIRL与SAC-Lag算法也最终学得了导航策略,但所获得的奖励相对较低。SAC算法在经过320个迭代的训练后,奖励值和完成率保持了稳定,没有出现明显的变化,这表明其陷入了局部困难,无法完成导航任务。

实验采用SLAM(simultaneous localization and mapping) 算法来构建仿真环境的占据栅格地图,并将移动机器人的导航轨迹在地图上进行了可视化展示。根据图8的结果显示,在简单区域中,所有算法都能找到可行的导航路径。在复杂、拥挤的杂乱区域中,TGNPO算法学习到最安全的导航策略,使移动机器人用最少的时间步到达导航目标点,并生成平滑、最高奖励的导航轨迹,部分导航拍摄的图像状态如图9所示。与之相比,SAC-Lag和JIRL方法在面对障碍物时,线速度与角速度曲线波动较大,且未能作出更好的避障选择,需要大量资源来探索其他成功率较低、风险较高的可行解决方案。

表2显示了不同方法下机器人导航任务的详细比较结果。在整个地图中,SAC方法因为复杂的障碍物未能导航到目标位置。在导航轨迹长度方面, TGNPO算法在图5所示的复杂环境区域表现更为出色,相对较短的导航轨迹表明了导航策略的高效性,而SAC-Lag或JIRL在同样的环境中表现不佳。尽管SAC-Lag、JIRL和TGNPO最终都能够完成导航任务,但是可以发现TGNPO达到目标花费的时间显明更少。这表明TGNPO在导航任务中具有更高的效率,移动机器人能够更快地到达目标位置,从而提高了任务执行的速度。

3.2 现实场景对比实验

实验设置了两个现实场景来验证TGNPO的算法性能。实验采用搭载RPlidar A2激光雷达、ORBBEC@Dabai深度相机、Jetson Nano控制器与IMU的LIMO移动机器人,如图10所示。移动机器人的车长为322 mm,车宽为220 mm,轴距为200 mm,阿克曼最小转弯半径为0.4 m。实验基于ROS(开源机器人操作系统)平台进行数据交互。

在真實场景实验中将本文算法与JIRL、TGNPO算法进行对比,部分实验屏幕截图及其相应的轨迹如图11所示,TGNPO算法部分导航图像如图12所示。根据仿真实验的结果发现,JIRL算法在实际环境中表现出一些局限性,在一些情境下没有作出最优的决策,尽管在一些危险情况下可以进行及时修正,但相比于TGNPO算法,它生成的轨迹更长,导致了更高的时间成本;相反,TGNPO算法在面对障碍物时能够作出更加明智的决策,生成的导航轨迹更加安全、平滑。

3.3 消融实验

本文进行了一系列的消融研究,旨在研究轨迹-图像融合模块I和轨迹约束模块η对TGNPO导航策略的影响。TGNPO算法的参数在每次调整后都需要进行300个迭代的训练。表3记录了所有的测试数据。总体来看,当I=5,η=0.6导航策略的综合效果最佳。虽然当I=5,η=0.4时,平均轨迹长度最短且平均耗时最少,但专家策略干预度过高,这显然会限制移动机器人的探索性。实验结果发现,当I>5时,导航效果相对次优,这是因为在一些复杂且障碍物密集的区域,过长的轨迹信息无法完全反映在当前图像中,会对移动机器人导航产生偏差引导。而当I<5时,由于图像状态中包含的轨迹指引信息不足,导致导航效果同样次优。当η>0.6时,机器人的自主探索权过大,导致其在一些无效区域进行探索,进而产生较长的导航轨迹。相反,如果η越小,整个训练过程专家示范行为的控制比例越大,这将导致移动机器人的导航轨迹更加趋近于专家导航轨迹。

4 结束语

本文讨论了在杂乱、障碍物密集的复杂环境下移动机器人自主导航的问题,提出了基于轨迹引导的移动机器人导航策略优化(TGNPO)算法。该算法以深度强化学习为基础框架,同时引入了专家策略模块、轨迹-图像融合模块以及轨迹约束模块,以提高导航模型性能与移动机器人的探索效率。实验结果表明,TGNPO相对其他对比方法显著减少了导航策略的学习时间。同时,该算法所学到的导航策略产生了平滑、安全且高奖励的导航轨迹,这意味着移动机器人能够更快速地适应复杂环境,确保了导航的高效性。本文研究的是单目标点导航问题,未来将深入研究移动机器人在多目标点导航任务中的应用。

参考文献:

[1]Khan M S A,Hussian D,Ali Y,et al. Multi-sensor SLAM for efficient navigation of a mobile robot [C]// Proc of the 4th International Conference on Computing & Information Sciences. Piscataway,NJ:IEEE Press,2021: 1-5.

[2]Matsui N,Jayarathne I,Kageyama H,et al. Local and global path planning for autonomous mobile robots using hierarchized maps [J]. Journal of Robotics and Mechatronics,2022,34(1): 86-100.

[3]Missura M,Bennewitz M. Predictive collision avoidance for the dynamic window approach [C]// Proc of International Conference on Robotics and Automation. Piscataway,NJ:IEEE Press,2019: 8620-8626.

[4]Ali M A H,Shanono I H. Path planning methods for mobile robots: a systematic and bibliometric review [J]. ELEKTRIKA-Journal of Electrical Engineering,2020,19(3): 14-34.

[5]Patel U,Kumar N K S,Sathyamoorthy A J,et al. DWA-RL: dynamically feasible deep reinforcement learning policy for robot navigation among mobile obstacles [C]// Proc of International Conference on Robotics and Automation. Piscataway,NJ:IEEE Press,2021: 6057-6063.

[6]Fan Tingxiang,Long Pinxin,Liu Wenxi,et al. Distributed multi-robot collision avoidance via deep reinforcement learning for navigation in complex scenarios [J]. The International Journal of Robotics Research,2020,39(7): 856-892.

[7]Sartoretti G,Kerr J,Shi Yunfei,et al. Primal: pathfinding via reinforcement and imitation multi-agent learning [J]. IEEE Robotics and Automation Letters,2019,4(3): 2378-2385.

[8]Codevilla F,Müller M,López A,et al. End-to-end driving via conditional imitation learning [C]//Proc of International conference on robotics and automation. Piscataway,NJ:IEEE Press,2018: 4693-4700.

[9]Cai Peide,Wang Sukai,Sun Yuxiang,et al. Probabilistic end-to-end vehicle navigation in complex dynamic environments with multimodal sensor fusion [J]. IEEE Robotics and Automation Letters,2020,5(3): 4218-4224.

[10]Pan Yunpeng,Cheng C A,Saigol K,et al. Imitation learning for agile autonomous driving [J]. The International Journal of Robotics Research,2020,39(2-3): 286-302.

[11]Sutton R S,Barto A G. Reinforcement learning: an introduction [M]. [S.l.]:MIT Press,2018.

[12]許宏鑫,吴志周,梁韵逸. 基于强化学习的自动驾驶汽车路径规划方法研究综述[J]. 计算机应用研究,2023,40(11): 3211-3217. (Xu Hongxin,Wu Zhizhou,Liang Yunyi. Review of research on path planning methods for autonomous vehicles based on reinforcement learning [J]. Application Research of Computers,2023,40(11): 3211-3217.)

[13]张目,唐俊,杨友波,等. 基于时空感知增强的深度Q网络无人水面艇局部路径规划 [J]. 计算机应用研究,2023,40(5): 1330-1334. (Zhang Mu,Tang Jun,Yang Youbo,et al. Deep Q-network-based local path planning for unmanned surface vehicles enhanced with spatiotemporal perception [J]. Application Research of Computers,2023,40(5): 1330-1334.)

[14]贺雪梅,匡胤,杨志鹏,等. 基于深度强化学习的AGV智能导航系统设计 [J]. 计算机应用研究,2022,39(5): 1501-1504,1509. (He Xuemei,Kuang Yin,Yang Zhipeng,et al. Design of AGV intel-ligent navigation system based on deep reinforcement learning [J]. Application Research of Computers,2022,39(5):1501-1504,1509.)

[15]Francis A,Faust A,Chiang H T L,et al. Long-range indoor navigation with PRM-RL [J]. IEEE Trans on Robotics,2020,36(4): 1115-1134.

[16]Ruan Xiaogang,Lin Chenliang,Huang Jing,et al. Obstacle avoidance navigation method for robot based on deep reinforcement learning [C]//Proc of the 6th Information Technology and Mechatronics Engineering Conference. Piscataway,NJ:IEEE Press,2022: 1633-1637.

[17]Andrychowicz O A I M,Baker B,Chociej M,et al. Learning dexterous in-hand manipulation [J]. The International Journal of Robotics Research,2020,39(1): 3-20.

[18]Cai Peide,Wang Hengli,Huang Huaiyang,et al. Vision-based autonomous car racing using deep imitative reinforcement learning [J]. IEEE Robotics and Automation Letters,2021,6(4): 7262-7269.

[19]Menda K,Driggs-Campbell K,Kochenderfer M J. EnsembleDAgger:a Bayesian approach to safe imitation learning [C]// Proc of International Conference on Intelligent Robots and Systems. Piscataway,NJ:IEEE Press,2019:5041-5048.

[20]Liu Haochen,Huang Zhiyu,Wu Jingda,et al. Improved deep reinforcement learning with expert demonstrations for urban autonomous driving [C]//Proc of IEEE Intelligent Vehicles Symposium. Pisca-taway,NJ:IEEE Press,2022: 921-928.

[21]Cimurs R,Suh I H,Lee J H. Goal-driven autonomous exploration through deep reinforcement learning [J]. IEEE Robotics and Automation Letters,2021,7(2): 730-737.

[22]Howard A,Sandler M,Chu G,et al. Searching for MobileNetV3 [C]// Proc of IEEE/CVF International Conference on Computer Vision. Piscataway,NJ:IEEE Press,2019: 1314-1324.

[23]Hou Qibin,Zhou Daquan,Feng Jiashi. Coordinate attention for ef-ficient mobile network design [C]// Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press,2021: 13713-13722.

[24]He Kaiming,Zhang Xiangyu,Ren Shaoqing,et al. Deep residual learning for image recognition [C]// Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press,2016: 770-778.

[25]Haarnoja T,Zhou A,Hartikainen K,et al. Soft actor-critic algorithms and applications [EB/OL]. (2018).https://arxiv.org/abs/1812.05905.

[26]Dey S,Pendurkar S,Sharon G,et al. A joint imitation-reinforcement learning framework for reduced baseline regret [C]// Proc of International Conference on Intelligent Robots and Systems. Piscataway,NJ:IEEE Press,2021:3485-3491.

[27]Hester T,Vecerik M,Pietquin O,et al. Deep Q-learning from demonstrations [C]// Proc of AAAI Conference on Artificial Intelligence. 2018.

[28]Ha S,Xu Peng,Tan Zhenyu,et al. Learning to walk in the real world with minimal human effort[EB/OL]. (2020). https://arxiv.org/abs/2002.08550.