基于查询语义特性的稠密文本检索模型

2024-06-01赵铁柱林伦凯杨秋鸿

赵铁柱 林伦凯 杨秋鸿

摘 要:针对现有稠密文本检索模型(dense passage retrieval,DPR)存在的负采样效率低、易产生过拟合等问题,提出了一种基于查询语义特性的稠密文本检索模型(Q-DPR)。首先,针对模型的负采样过程,提出了一种基于近邻查询的负采样方法。该方法通过检索近邻查询,快速地构建高质量的负相关样本,以降低模型的训练成本。其次,针对模型易产生过拟合的问题,提出了一种基于对比学习的查询自监督方法。该方法通过建立查询间的自监督对比损失,缓解模型对训练标签的过拟合,从而提升模型的检索准确性。Q-DPR在面向开放领域问答的大型数据集MSMARCO上表现优异,取得了0.348的平均倒数排名以及0.975的召回率。实验结果证明,该模型成功地降低了训练的开销,同时也提升了检索的性能。

关键词:查询;稠密文本检索;近邻;对比学习;自监督

中图分类号:TP391 文献标志码:A 文章编号:1001-3695(2024)05-016-1388-06

doi: 10.19734/j.issn.1001-3695.2023.09.0412

Dense passage retrieval model based on query semantic characteristics

Abstract:Addressing the issues of low negative sampling efficiency and tendency towards overfitting in existing dense passage retrieval (DPR) models, this paper proposed a DPR model based on query semantic characteristics(Q-DPR). Firstly, it introduced a negative sampling method based on neighbor queries for the negative sampling process. This method constructed high-quality negative samples rapidly by retrieving neighboring queries, thereby reducing the training costs. Secondly, to mitigate overfitting, it proposed a query self-supervised method based on contrastive learning. This method alleviated overfitting to training labels by establishing a self-supervised contrastive loss among queries, thereby enhancing retrieval accuracy. Q-DPR performed exceptionally well on the large-scale MSMARCO dataset for open-domain question answering, achieving a mean reciprocal rank of 0.348 and a recall rate of 0.975. Experimental results demonstrate that this model successfully reduces trai-ning overhead while also improving retrieval performance.

Key words:query; dense passage retrieval; neighbor; contrastive learning; self-supervised

0 引言

隨着计算机科学与人工智能的发展,智能问答系统已成为生产和生活中必不可少的工具,巨大应用潜力和极高的商业价值使其在学术界和工业界都备受关注。目前,主流的智能问答系统,例如微软小冰、百度小度、苹果Siri等,大多采用基于检索的开放领域问答[1]。对于用户提出的问题,系统首先使用文本检索模型对知识库中所有候选文本进行检索,寻找与用户问题最相关的文本。然后使用机器阅读理解模型,在文本中抽取出能够准确回答用户问题的文本片段[2]。在这个过程中,文本检索模型扮演着重要角色,若文本检索模型无法准确检索到包含问题答案的文本,则无法对用户问题作出准确的回复。因此,文本检索在开放领域问答中尤为关键,它也成为了限制开放领域问答性能的主要瓶颈[3]。由于检索过程需要准确且高效地判断大量文本是否与查询相关,文本检索已经成为自然语言处理领域中最具挑战性的任务之一。

传统的文本检索方法,如TF-IDF[4]、BM25[5]等,通常采用基于统计的策略,通过统计查询以及文本之间的词频信息以建立它们之间的关系。尽管这种方法在早期的检索应用中表现优异,但它并未考虑隐含在词汇中的语义信息[6],这导致在检索的过程中,词汇一致但语义完全不同的两个文本可能被误判为高度相关。为了解决这个问题,以BERT(bidirectional encoder representation transformers)[7]为代表的深度学习模型被引入到文本检索领域。当前,基于深度学习的文本检索模型主要分为交互检索模型和稠密检索模型[8]两类。交互检索模型通过对查询和文本的词语义表征进行交互,获取丰富的交互信息以衡量它们的相似度。这种模型在检索任务中表现出极高的准确性,但高度耦合的语义交互却严重限制了检索速度。稠密检索模型则使用稠密向量表示查询和文本,其在检索的过程中只需使用简单的向量计算模型,就能快速预测出它们之间的相关性[9]。这种模型通过舍弃高度耦合的语义交互以提高检索速度,但同时也导致了检索准确性下降。为了克服这个难题,许多模型试图通过提高语义表征的广度或深度信息以提升检索的准确性[10]。提升语义表征的广度,即增加语义表征的数量或维度,这种方法简单且有效,但检索的开销也会随之增加。因此,许多研究人员开始转向提升语义表征的深度,即提升模型的语义表征能力,以获得高质量的语义表征向量,从而提高模型的检索准确性。

目前,许多研究人员正通过优化模型的负采样(negative sampling)过程以及对比损失(contrastive losses)的构建方法以增强其语义表征能力。他们致力于让模型在训练过程中接触到可能产生误判的难以区分的关键负相关信息,并建立起有效的对比损失。Karpukhin等人[11]提出的DPR引入了批次内负采样方法(in-batch negatives),使模型在训练过程中能够接触到同一批次内的更多负相关数据,从而提升模型的检索性能。然而,其仅在训练开始前采用BM25进行负采样,导致模型在训练的过程中无法接触到更多有效的负样本。为了解决这个问题,Xiong等人[12]提出了ANCE,其在训练过程中不断使用批次检查点模型(checkpoint)异步地对数据集进行检索,以生成静态难负样本(static hard negatives),并在新一轮的训练中使用静态难负样本进行模型训练,使模型在训练过程中能够接触到高质量的负相关数据,从而提高检索的准确性。然而,其使用批次检查点模型异步地生成静态难负样本,需要消耗大量的计算资源,导致模型的训练开销过大。为降低训练模型的资源开销,Hofsttter等人[13]从查询的聚类特征出发,提出了TAS-B,其在训练前对查询集合进行一次聚类,并对每个批次的查询样本进行聚类内平衡化处理,使模型即使使用小批次进行训练也能达到较好的效果。然而,该模型使用的无监督聚类过程非常消耗时间,同时,在训练的过程中将批次内的所有样本都设置为同一聚类内的样本会导致模型产生过拟合,从而降低模型的泛化能力。

针对上述问题,本文提出了一种基于查询语义特性的稠密文本检索模型(Q-DPR),其结构如图1所示。

模型使用RoBERTa[14]预训练模型作为编码器,分别将输入的查询和文本编码为稠密向量,并使用点积计算向量的相似度以衡量它们之间的相关性。同时,模型将查询、查询的正相关文本以及BM25检索的负相关文本作为训练数据。训练时,采用了一种基于近邻查询的负采样方法(nearest neighbor query negative,N2Q),该方法在表征空间中选取最近邻的查询及其对应的正负文本,在同一批次内采用批次内负采样策略,构建基于问答样本的有监督对比损失,以实现高效且高质量的负采样训练过程。同时,采用一种基于对比学习的查询自监督方法(self-supervised learning of query,S2Q),该方法使模型在训练过程中对查询进行两次独立编码,将同一查询的稠密向量作为正相关样本,不同查询的则作为负相关样本,使用自监督方式构建查询间的对比损失,以减轻模型在训练过程中可能出现的过拟合问题,提升模型的语义表征能力。

1 相关工作

稠密检索模型目前在文本检索领域的研究中占据重要地位。与交互检索模型不同,稠密检索模型将查询语句和文本独立地编码为低维的稠密向量。这种方法使模型能够在进行检索前预先推断并储存潜在文本的语义表征,而在检索过程中,仅需进行简单的向量交互,即可快速完成检索。

双塔模型(dual-encoder)是稠密检索模型的典型代表,该模型将查询和文本独立编码为单一的低维稠密向量,然后通过计算向量间的相似度以评估它们之间的关联性。双塔模型单一的向量表示以及简单的相似性计算极大地提升了检索的速度。然而,这种简化的检索方法对模型的语义表征能力要求极高,若表征能力不足,将严重影响检索的准确性。许多研究致力于通过增强语义表征的广度信息以提高检索的准确性。

增强语义表征的广度信息,即增加语义表征的数量或维度。Zhang等人[15]认为查询与文本之间存在一种单对多的关系,因此,仅使用单一的向量形式对文本进行表示,对于检索模型来说是有限的。基于这一理念,他们将文本编码为多个不同语义角度的表征向量,以提高模型的检索准确性。这种新颖的思路取得了可观的成果,但使用无监督的方法从不同语义角度对文本进行编码可能会导致模型产生过拟合,从而退化为双塔模型。为了提升检索准确性,语义交互过程被重新引入,并提出了延迟交互 (late interaction)模型。延迟交互模型能够预先推理并存储候选文本的细粒度语义向量,然后在检索过程中再进行查询和文本之间的细粒度语义交互。DC-BERT[16]使用Transformer模型实现了检索过程中细粒度的语义交互。Poly-Encoder[17]则使用了全局而非词标记级别的自注意力特征,并通过注意力机制(attention)实现细粒度的语义交互。这些大规模的交互过程确保了检索的准确性,但同时也降低了模型的检索速度,导致模型的推理速度和开销仍然难以满足检索的需求。TK[18]简化了细粒度语义交互的过程,只使用简单的神经网络模型进行交互。而ColBERT[19]则采用了一种简单的非神经网络交互步骤构建细粒度的相似性。ColBERT的灵活性更强,实现了TK不支持的端到端检索,极大地提高了模型的检索速度。

尽管延迟交互的发展显著提升了模型的检索速度,但对存储大量细粒度语义向量的需求,使其在低成本部署方面存在困难。此外,当系统中存在大量候选文本时,其检索速度仍未能达到理想的水平。

为了在保持检索速度的同时提升检索准确性,众多科研人员开始研究模型的负采样策略以及对比损失的构建方法。他们试图让模型能夠在训练过程中接触到可能产生误判的难以区分的关键负相关信息,以建立有效的对比损失,增强语义表征的深度。Karpukhin等人提出的DPR引入了批次内负采样操作。对于某一查询,该方法将同一批次内不同查询的正相关文本作为该查询的负相关数据进行对比损失的构建,使模型能够在同一批次内学习到更多关于查询的负相关信息。Qu等人[20]提出的RocketQA使用了跨批次负采样(cross-batch negatives)的方法,以增加训练过程中负相关样本的数量,并采用去噪的难负样本采样(denoised hard negative sampling)选取更可靠的负样本,以提升检索模型的效果。这些模型有效地提升了检索的准确性,但它们都有一个共同的缺陷,即需要大量的计算机资源进行大批次训练,使模型在训练过程中学习到有用的关键负相关信息。为了解决这个问题,Xiong等人提出了ANCE,首先让模型使用BM25检索结果生成的负样本进行warmup训练,然后在训练过程中不断使用批次检查点模型异步地对数据集进行检索,以生成静态难负样本(static hard negatives),并在新一轮的训练中使用静态难负样本进行模型训练。Zhang等人[21]提出的AR2将交互模型和双塔模型相结合,双塔模型作为检索模型,而交互模型作为重排序模型。检索模型学习并检索难负样本以欺骗重排序模型,而重排序模型通过难负样本进行学习,并采用知识蒸馏的方法向检索模型提供软标签,形成渐进式的反馈。这些模型有效地提升了关键负相关信息的质量,但其不断对难负样本索引进行刷新的过程仍然需要较大的开销。针对这个问题,Hofsttter等人提出了TAS-B,在训练前对查询进行一次聚类,并对每个批次的查询样本进行聚类内平衡化处理,从而使模型通过小批量训练就能达到良好的效果。然而,该模型使用的无监督聚类过程非常耗时,同时在训练过程中将批次内的所有样本都设置为同一聚类内的样本,可能会导致模型产生过拟合,从而降低模型的泛化能力。Zhan等人[22]则从理论上研究了不同的抽样策略,提出了STAR,使用BM25检索的负样本进行模型训练,并引入了随机采样的过程增强训练的稳定性,同时他们提出了ADORE[22]对查询的语义表征进行微调,该模型提升了检索的性能,但并没有考虑到在微调查询语义表征过程中模型的参数变化可能会使文本的语义表征同时发生变化,导致模型产生过拟合。

当前,稠密文本检索模型仍面临诸多问题和挑战,主要体现在训练开销过大及模型易产生过拟合等方面。对此,本文基于查询的语义特性,提出了一种新的稠密文本检索模型。

2 基于查询语义特性的稠密文本检索模型

在稠密文本检索任务中,假设存在候选文本集合D={d1,d2,…,d|D|}和待检索查询集合Q={q1,q2,…,q|Q|}。对于任意查询qi∈Q,检索模型的目标是在候选文本集合D中检索出与查询qi相关的文本。为实现这一目标,模型首先需要对所有的文本进行编码,得到任意文本dj∈D的语义表征E(dj),构成文本语义表征集合E(D)={E(d1),E(d2),…,E(d|D|)}。之后,模型将待检索的查询qi进行编码,得到查询的语义表征E(qi)。最终,模型通过简单的向量计算模型预测E(qi)与所有E(dj)∈E(D)的语义表征相关性,以此确定查询qi和文本dj之间的关联程度。检索的准确性对于检索模型来说极为关键,而稠密检索模型的检索性能与模型的训练过程息息相关。在模型的训练过程中,往往需要使用一些有效的负采样策略,以获得模型易产生误判的关键负相关信息,并建立高质量的对比损失以提升模型的检索准确性。因此,基于查询语义特性的稠密文本检索模型在结构上对双塔模型进行了优化,采用了共享编码器的方式以降低模型的训练成本。在训练方法层面,本文在DPR模型的基础上,引入了一种基于近邻查询的负采样方法,该方法通过对近邻查询进行检索,快速地构建高质量的负相关样本,从而提高负采样过程的效率。此外,本文优化了模型的损失函数,引入了一种基于对比学习的查询自监督方法。该方法通过自监督的方式构建查询间的对比损失,有效地减轻了模型的过拟合现象,提升了模型的检索性能。

2.1 模型结构

如图1所示,基于查询语义特性的稠密文本检索模型采用了双塔结构,其设计理念与DPR的模型结构相似。然而,区别在于DPR采用两个独立的编码器分别对查询和文本进行编码,而本文为了降低模型的训练成本,选择使查询和文本共享一个编码器。该模型将查询和文本编码为单一的语义向量,即

在得到查询和文本的语义表征之后,需要使用简单的向量计算模型来获取它们之间的相关性。本文使用点积相似度函数计算查询q的语义表征E(q)与文本d的语义表征E(d)之间的相似度。这种语义表征相似度被视为查询q和文本d之间的相关性得分f(q,d)。以下是计算f(q,d)的具体过程:

f(q,d)=E(q)T·E(d)(3)

2.2 训练方法

基于查询语义特性的稠密文本检索模型的训练方法基本流程如图2所示。首先,对于任意查询qi∈Q,模型将查询qi、其正相关文本d+i以及BM25检索出与其呈强负相关的文本d-i作为一个训练样本。接下来,采用基于近邻查询的负采样方法实现每一轮训练的负采样过程,将负采样的结果作为训练数据,采用批次内负采样策略构建基于问答样本的有监督对比损失LossN2Q。同时,采用基于对比学习的查询自监督方法构建查询间的无监督对比损失LossS2Q,并与LossN2Q进行联合损失计算,得到Q-DPR训练损失LossQ-DPR=LossN2Q+LossS2Q。最终,经过多轮训练,生成一个高效的文本检索模型。下文将详细阐述基于近邻查询的负采样及基于对比學习的查询自监督两种方法。

2.2.1 基于近邻查询的负采样方法

为了提高稠密检索模型训练过程中负采样的效率并提升负样本的质量,本文提出了一种基于近邻查询的负采样方法。该方法利用近邻查询语义表征向量在表征空间中的特性,即当查询的语义向量在表征空间中近邻时,它们对应的正负相关文本的语义向量在表征空间中也会呈现出近邻的情况。这种特性使查询及其近邻查询的正负相关文本形成了强负相关关系,从而让模型在训练过程中能通过检索近邻查询,将查询与其近邻查询的正负相关文本作为负相关数据,以构建高质量的对比损失。由于在训练集中,查询的数量及其序列长度都远小于文本,所以检索近邻查询的开销要远小于通过查询对文本进行检索的开销。相比于ANCE等负采样方法,这种方法极大地提高了负采样的效率。

假设数据集中存在查询集合Q={q1,q2,…,q|Q|},基于近邻查询的负采样过程可以描述如下:在每个训练轮次开始前,首先使用模型对查询集合Q进行编码,从

2.2.2 基于对比学习的查询自监督方法

为了缓解模型在训练过程中易产生过拟合的问题,本文提出了一种基于对比学习的查询自监督方法。诸如SimCSE[23]等基于对比学习的自监督方法,在文本相似性匹配任务中得到了广泛应用。自监督的方式使模型能够在无标签的情况下学习到文本间的语义信息,显著提升模型的语义表征能力。与需要标签的有监督训练相比,自监督的方式不再依赖于高质量的标签,

而是让模型自主学习语义关系,从而缓解由数据集引发的过拟合问题。虽然这种方法在文本相似性任务中取得了显著的成效,但在面向问答的文本检索任务中,这种方法并未展现出其优势。主要是因为在文本相似性匹配任务中,正相关的文本与文本之间在序列长度、语义表达上没有明显差异,而在面向问答的文本检索任务中,同一个文本可能能够与多个语义截然不同的查询相匹配,文本的语义存在多元性,这导致无监督的形式难以使模型学习到复杂的语义信息。然而,在面向问答的文本检索任务中,查询往往由序列简短的关键词汇构成,不存在多元的语义,这符合文本相似性匹配任务中文本的特征。因此,本文在基于问答样本的有监督训练方法中引入了基于对比学习的查询自监督损失,以此来扩大不同查询的语义向量在表征空间上的距离,缓解了模型在训练过程中易产生的过拟合问题,使模型学习到高质量的语义表征。

3 实验及结果分析

3.1 数据集

MSMARCO(Microsoft machine reading comprehension)[24]是一个大规模的开放领域问答数据集,它基于真实数据构建,主要致力于开放领域问答任务,如机器阅读理解、问题回答和文本排序等。该数据集提供了超过一百万的开放领域问题和超过八百万的待检索文本。在标签方面,对于每个问题,该数据集都提供了与之相关的一千个文本以及标准答案。MSMARCO的规模和真实性极大地推动了文本检索模型的发展。

3.2 评估指标

文本检索模型的性能通过平均倒数排名(mean reciprocal rank,MRR)和召回率进行评估。平均倒数排名首先对每个问题的标准答案在检索结果中的排位取倒数作为每个问题的检索准确度,之后,采用对所有问题的检索准确度取平均的方式以衡量模型的性能。召回率则常用于评估检索模型检索正确信息的能力,通常表示为模型检索出的正确文本在所有正确文本中所占的比例。

假设在待评估的验证集中存在|Q|个查询,其集合为Q={q1,q2,…,q|Q|},对于任意查询qi∈Q,其标准答案为d+i,检索模型检索出的与该查询最为相关的k个文本所构成的集合为Dqi={dqi1,dqi2,…,dqik}。若d+i∈Dqi,将其在Dqi中的下标记为ri,那么MRR和Recall的计算过程可以描述如下:

其中:k作为评估指标的参数,代表检索模型对排名误差的容忍度。若k值较大,对检索模型的要求则相对宽松;反之,若k值较小,则对检索模型的要求相对严格。

3.3 实验设置

Q-DPR在PyTorch平台上实现,并使用 NVIDIA 3090进行实验。表1列出了模型在MSMARCO数据集上使用的最优超参数。在处理原始数据时,将查询的最大序列长度设定为32,文本的最大序列长度设定为256,如果序列长度超过最大长度,则对序列进行裁剪。在模型训练阶段,将数据集中的BM25检索结果作为负样本,并使用MSMARCO数据集中的标准passage训练数据对模型进行训练,训练批次的大小设定为512,训练的轮次设定为30。在模型评估阶段,模型训练完成后,使用了MSMARCO提供的passage验证集进行性能评估。在实验过程中,通过调整学习率、K和L等超参数进行模型训练,比较模型的MRR和Recall指标以选择最优的参数组合。需要强调的是,模型性能将受到参数K和L的直接影响。参数K代表在基于近邻查询的负采样方法中检索近邻查询的质心数量。如果参数K设置过大,会降低模型的负采样效率并使模型在训练过程中难以收敛;若设置过小,则会降低负采样的质量。参数L代表在基于近邻查询的负采样方法中同一批次内近邻查询的数量。若参数L设置过大,模型会对近邻查询产生过拟合;反之,若设置过小,则会导致负采样的质量降低。本文对超参数K进行了一系列的实验,实验的取值为K∈{20×100,21×100,23×100,20×1000,21×1000,23×1000}。同样地,也对超参数L进行了实验,实验的取值为L∈{22,23,…,26}。最终,选取了在MSMARCO数据集表现最优的参数,即K=20×1000,L=22。

3.4 对比实验

3.4.1 与基线模型对比实验

表2为基于查询语义特性的稠密文本检索模型与其他基线模型在MSMARCO数据集上的性能对比。模型性能的评估采用了两个指标:k=10的平均倒数排名MRR@10以及k=1000的召回率R@1K。

在仅使用基于近邻查询的负采样方法进行训练的情况下,Q-DPR在MSMARCO数据集上实现了0.343的平均倒数排名和0.970的召回率。与其他基线模型相比,平均倒数排名有所提升,这验证了基于近邻查询的负采样方法相较于其他负采样方法的优越性。通过采用近邻查询检索负相关文本的方式,模型在訓练过程中能接触到高质量的关键负相关信息。这使模型建立了有效的对比损失,从而提高了模型的语义表征能力。然而,与此同时,召回率指标相对于其他基线模型有所下降。这是因为在训练过程中,考虑到训练的开销问题,并未采用刷新查询负相关文本的操作,这导致模型对近邻查询内的样本产生了过拟合,从而降低了召回率。

在仅采用基于对比学习的查询自监督方法进行训练的情况下,Q-DPR在MSMARCO数据集上的性能超过了其他基线模型,实现了0.342的平均倒数排名和0.972的召回率。这种提升得益于查询自监督学习为模型构建了强大的查询对比损失,使模型在缺乏查询间标签关系的情况下,仍能学习到向量空间下的相互关系,从而达到缓解过拟合的目的。

最终,通过应用基于近邻查询的负采样方法和基于对比学习的查询自监督方法,Q-DPR在MSMARCO数据集上实现了0.348的平均倒数排名和0.975的召回率。实验结果表明,该模型的性能优于其他基线模型,证明了采用基于近邻查询的负采样方法来检索高质量的负相关文本,同时利用基于对比学习的查询自监督方法来缓解模型的过拟合问题的有效性。

3.4.2 模型训练开销对比实验

表3为基于查询语义特性的稠密文本检索模型与一些高性能基线模型在MSMARCO数据集上的训练成本比较。利用近邻查询及其正负相关文本在向量空间上的特性,本模型在训练过程中仅对查询进行检索。由于查询的检索开销远小于文本的检索开销,这种方法确保了检索过程的高效性。仅需在两块GPU上进行36 h的训练,就可以得到一个高效的稠密文本检索模型。实验结果表明,Q-DPR的训练成本要显著低于其他基线模型。

3.5 消融实验

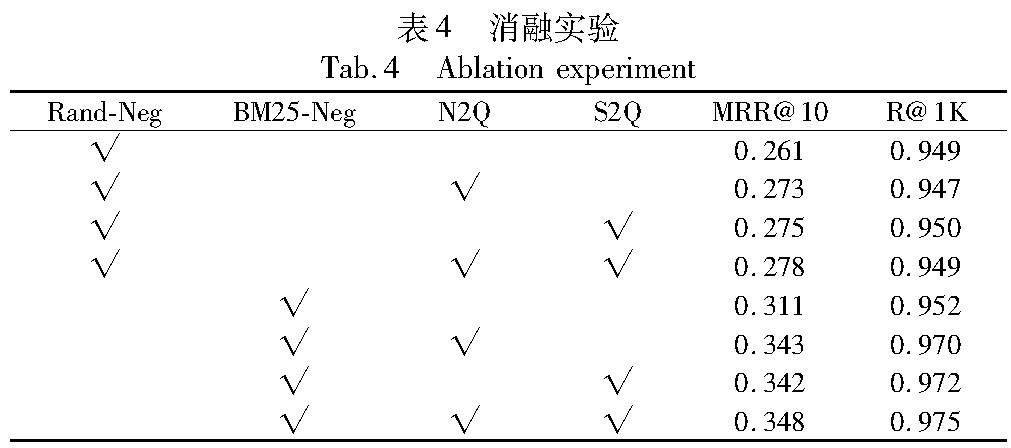

为了验证Q-DPR模型中各组成部分的有效性,本文在MSMARCO数据集上进行了一系列的消融实验。实验的目标是探究基于近邻查询的负采样方法(N2Q)、基于对比学习的查询自监督方法(S2Q)以及BM25负样本对模型性能的影响。

表4为Q-DPR的各类变体在MSMARCO数据集上的消融实验对比。其中,“Rand-Neg”代表采用随机批次内负采样策略;“BM25-Neg”代表采用BM25检索负样本进行批次内负采样;“N2Q”代表采用基于近邻查询的负采样方法;“S2Q”代表采用基于对比学习的查询自监督方法。值得注意的是,无论是否采用BM25检索负样本,使用N2Q或S2Q进行训练的模型在平均倒数排名指标上都有所提升。但是,在采用随机批次内负采样的情况下,模型的性能提升并不显著。这是因为随机批次内负采样的随机性无法确保负样本的质量,即使采用N2Q或S2Q也无法完全克服这一缺陷。同时,负采样的随机性使N2Q的负采样过程过于依赖聚类,导致模型在召回率指标上有所下降,这与3.4.1节的分析结果相吻合。在采用BM25检索负样本进行训练的情况下,使用N2Q或S2Q均能使模型性能得到普遍提升,这进一步证实了基于近邻查询的负采样方法和基于对比学习的查询自监督方法的有效性。

3.6 檢索样例

表5展示了在MSMARCO数据集上,DPR和Q-DPR对两个不同查询的检索结果。对于查询“What is on the outside of DNA?”,DPR检索出了错误的答案,其仅定位到查询中的关键词“DNA”,却未能捕捉到查询的核心语义“on the outside of DNA”,因此检索出的结果无法准确地回答问题。相反,Q-DPR检索出了正确的答案,准确地解答了DNA外侧的构成。这归功于Q-DPR模型强大的语义表征能力,能够捕捉查询的关键信息。对于查询“Which Vitamins help heal bruises?”,DPR和Q-DPR都捕捉到了查询的核心语义,给出了哪些维生素能够治疗瘀伤的答案。然而,DPR的检索结果更多的是在描述维生素E的作用,而Q-DPR的检索结果则更为准确,明确地回答了维生素C和维生素K能够治疗瘀伤。这进一步证实了Q-DPR具备更强的检索准确性。

4 结束语

为了降低稠密文本检索模型在训练过程中的负采样成本,并抑制可能出现的过拟合问题,提出了一种基于查询语义特性的稠密文本检索模型。该模型采用了基于近邻查询的负采样方法和基于对比学习的查询自监督方法。基于近邻查询的负采样方法通过对查询进行近邻检索,有效地提高了模型在训练过程中负采样的效率和质量,降低了模型的训练成本。基于对比学习的查询自监督方法通过构建查询间的对比损失,有效地抑制了模型的过拟合问题,使模型能够学习到高质量的语义表征。实验结果证明,Q-DPR在训练成本和检索性能方面表现优异,

但与交互模型相比,其检索准确率仍有待提高。未来的研究可以探索如何以低成本的方式利用交互模型进行负采样,实现从交互模型到稠密文本检索模型的知识蒸馏,从而进一步提升模型的检索准确性。这将成为稠密文本检索模型未来研究的重要方向。

参考文献:

[1]方明弘,万里,戴凡杰. 基于双层记忆网络的多领域端到端任务型对话系统 [J]. 计算机应用研究,2023,40(10): 2945-2950. (Fang Minghong,Wan Li,Dai Fanjie. Multi-domain end-to-end task-oriented dialogue system based on double-layer memory network [J]. Application Research of Computers,2023,40(10): 2945-2950.)

[2]赵芸,刘德喜,万常选,等. 检索式自动问答研究综述 [J]. 计算机学报,2021,44(6): 1214-1232. (Zhao Yun,Liu Dexi,Wan Chang-xuan,et al. Retrieval-based automatic question answer:a literature survey [J]. Chinese Journal of Computers,2021,44(6):1214-1232.)

[3]邸剑,刘骏华,曹锦纲. 利用BERT和覆盖率机制改进的HiNT文本检索模型 [J/OL]. 智能系统学报. (2023-09-27) [2023-10-22].http://kns.cnki.net/kcms/detail/23.1538.TP.20230926. 1452.002.html. (Di Jian,Liu Junhua,Cao Jingang. An improved hint test retrieval model using BERT and coverage mechanism [J/OL]. CAAI Trans on Intelligent Systems. (2023-09-27) [2023-10-22]. http://kns.cnki.net/kcms/detail/23.1538.TP.20230926.1452.002.html.)

[4]Aizawa A. An information-theoretic perspective of TF-IDF measures [J]. Information Processing & Management,2003,39(1):45-65.

[5]Robertson S,Zaragoza H. The probabilistic relevance framework: BM25 and beyond [J]. Foundations and Trends in Information Retrieval,2009,3(4): 333-389.

[6]韩华珍. 面向智能问答系统的语义匹配技术研究与实现 [D]. 成都: 电子科技大学,2021. (Han Huazhen. Research and implementation of semantic matching technology for intelligent question answering system [D]. Chengdu: University of Electronic Science and Technology of China,2021.)

[7]Devlin J,Chang Mingwei,Lee K,et al. BERT: pre-training of deep bidirectional transformers for language understanding [C]// Proc of Conference of the North American Chapter of Association for Computational Linguistics: Human Language Technologies. Stroudsburg,PA: Association for Computational Linguistics,2019: 4171-4186.

[8]胡文浩,羅景,涂新辉. 面向稠密检索的伪相关反馈方法 [J]. 计算机应用,2023,43(4): 1036-1042. (Hu Wenhao,Luo Jing,Tu Xinhui. Pseudo relevance feedback method for dense retrieval [J]. Journal of Computer Applications,2023,43(4): 1036-1042.)

[9]罗雅兰. 基于BERT上下文感知的多层级信息检索方法 [D]. 汕头: 汕头大学,2021. (Luo Yalan. Contextual awared multi-layer information retrieval method based on BERT [D]. Shantou: Shantou University,2021.)

[10]吴昭. 结合字面匹配与上下文交互的全文检索研究与实现 [D]. 吉林: 吉林大学,2022. (Wu Zhao. Research and implementation of full-text retrieval combining word matching and context interaction [D]. Jilin: Jilin University,2022.)

[11]Karpukhin V,Ouz B,Min S,et al. Dense passage retrieval for open-domain question answering [C]// Proc of Conference on Empirical Methods in Natural Language Processing. Stroudsburg,PA: Association for Computational Linguistics,2020: 6769-6781.

[12]Xiong L,Xiong Chenyan,Li Ye,et al. Approximate nearest neighbor negative contrastive learning for dense text retrieval [EB/OL]. (2020-10-20)[2023-10-22].https://doi.org/10.48550/arXiv.2007.00808.

[13]Hofsttter S,Lin S C,Yang J H,et al. Efficiently teaching an effective dense retriever with balanced topic aware sampling [C]// Proc of the 44th International ACM SIGIR Conference on Research and Development in Information Retrieval. New York:ACM Press,2021: 113-122.

[14]Liu Yinhan,Ott M,Goyal N,et al. RoBERTa: a robustly optimized BERT pretraining approach [EB/OL]. (2019-07-26) [2023-10-22]. https://doi. org/10. 48550/arXiv. 1907. 11692.

[15]Zhang Shunyu,Liang Yaobo,Gong Ming,et al. Multi-view document representation learning for open-domain dense retrieval [C]// Proc of the 60th Annual Meeting of the Association for Computational Linguistics. Stroudsburg,PA: ACL Press,2022: 5990-6000.

[16]Nie Yuyu,Nie Ping,Geng Xiubo,et al. DC-BERT: decoupling question and document for efficient contextual encoding [C]// Proc of the 43rd International ACM SIGIR Conference on Research and Development in Information Retrieval.New York:ACM Press,2020:1829-1832.

[17]Humeau S,Shuster K,Lachaux M A,et al. Poly-Encoders:Transformer architectures and pre-training strategies for fast and accurate multi-sentence scoring [EB/OL]. (2020-07-25) [2023-10-22]. https://doi.org/10.48550/arXiv.1905.01969.

[18]Hofsttter S,Zlabinger M,Hanbury A. Interpretable & time-budget-constrained contextualization for re-ranking [M].[S.l.]: IOS Press,2020: 513-520.

[19]Khattab O,Zaharia M. ColBERT:efficient and effective passage search via contextualized late interaction over BERT [C]// Proc of the 43rd International ACM SIGIR Conference on Research and Development in Information Retrieval. New York:ACM Press,2020: 39-48.

[20]Qu Yingqi,Ding Yuchen,Liu Jing,et al. RocketQA: an optimized training approach to dense passage retrieval for open-domain question answering [C]// Proc of Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Stroudsburg,PA: ACL Press,2021: 5835-5847.

[21]Zhang Hang,Gong Yeyun,Shen Yelong,et al. Adversarial retriever-ranker for dense text retrieval [EB/OL]. (2022-10-30) [2023-10-22]. https://doi. org/10. 48550/arXiv. 2110. 03611.

[22]Zhan Jingtao,Mao Jiaxin,Liu Yiqun,et al. Optimizing dense retrieval model training with hard negatives [C]// Proc of the 44th International ACM SIGIR Conference on Research and Development in Information Retrieval. New York:ACM Press,2021: 1503-1512.

[23]Gao Tianyu,Yao Xingcheng,Chen Danqi. SimCSE: simple contrastive learning of sentence embeddings [C]// Proc of Conference on Empirical Methods in Natural Language Processing. Stroudsburg,PA: Association for Computational Linguistics,2021: 6894-6910.

[24]Nguyen T,Rosenberg M,Song Xia,et al. MSMARCO: a human gene-rated machine reading comprehension dataset [EB/OL]. (2016-11-28) [2023-10-22]. https://doi.org/10.48550/arXiv.1611.09268.

[25]Nogueira R,Lin J,Epistemic A I. From doc2query to docTTTTTquery [EB/OL]. (2019-06-05)[2023-10-22].https://www.researchgate.net/publication/360890853_From_doc2query_to_docTTTTTquery.

[26]Mallia A,Khattab O,Suel T,et al. Learning passage impacts for inverted indexes [C]// Proc of the 44th International ACM SIGIR Conference on Research and Development in Information Retrieval. New York:ACM Press,2021: 1723-1727.

[27]Lu Shuqi,He Di,Xiong Chenyan,et al. Less is more: pretrain a strong Siamese encoder for dense text retrieval using a weak decoder [C]// Proc of Conference on Empirical Methods in Natural Language Processing. 2021: 2780-2791.

[28]Lin S C,Yang J H,Lin J. Distilling dense representations for ranking using tightly-coupled teachers [EB/OL]. (2020-10-22) [2023-10-22]. https://doi. org/10. 48550/arXiv. 2010. 11386.