基于改进U2Net网络和无人机影像的城市绿化识别方法

2024-05-23王桢杨培峰张秋仪杨晋苏

王桢 杨培峰 张秋仪 杨晋苏

文章编号:2096-398X2024)03-0174-08

(1.福建理工大学 计算机科学与数学学院, 福建 福州 350118; 2.福建理工大学 建筑与城乡规划学院, 福建 福州 350118)

摘 要:针对城市绿化识别中存在的无可用公开数据集、人工标注数据任务大、图像边界分割不精确的问题,提出结合无人机影像和深度学习网络的城市绿化自动识别框架.首先建立基于无人机影像的城市绿化数据集,其次,运用交互式自动标注工具EISeg对数据进行标注,引入U2Net用于无人机影像下的城市绿化识别,最后,在网络的特征提取模块引入最大池化索引来加强对目标边界的分割能力.结果表明,相较于其它深度学习网络,U2Net在小规模数据集中有着优异的表现且改进后的网络在1 000张的训练集中达到了97.16%的分类精度,较原始的U2Net提高0.68%,模型参数量、计算量、内存均未显著提升.改进后的方法提升了城市绿化的识别精度,可以为城市绿化识别提供一种新的自动解译方法.

关键词:城市绿化识别; U2Net; 无人机影像; 深度学习

中图分类号:TP751 文献标志码: A

Urban greening recognition method based on improved U2Net and unmanned aerial vehicle images

WANG hen1, YANG Pei-feng2*, HANG Qiu-yi2, YANG Jin-su2

1.College of Computer Science and Mathematics, Fujian University of Technology, Fuzhou 350118, China; 2.College of Architecture and Planning, Fujian University of Technology, Fuzhou 350118, China)

Abstract:An automatic urban greening identification framework that combines UVA images and deep learning networks was proposed for the problems of no available public dataset,large manual labeling data task,and imprecise image boundary segmentation in urban greening identification.Firstly,an urban greening dataset based on UAV images was established.Then,the interactive automatic labeling tool EISeg was used to label the data,and introduction of U2Net for urban greening identification under UAV images.At last,the max pooling indices was introduced in the feature extraction module of the network to strengthen the segmentation ability of the target boundary.The experimental results show that U2Net has excellent performance in small-scale datasets and the improved U2Net network achieved overall accuracy of 97.16% in a small datasets of 1 000,which is 0.68% better than the original U2Net,and the number of model parameters,computation,and memory has not been significantly improved.The improved U2Net network combined with UAV images can better recognize the green coverage area in the city and provide a new automatic decoding method for urban green recognition.

Key words:urban greening identification; U2Net; UAV images; deep learning

0 引言

城市建成區的绿化覆盖率高低反映了区域生态环境的好坏,是评估一个城市宜居性的重要因素[1],也是创建文明城市考核和评选国家园林城市的一个重要指标.早期我国针对城市绿化覆盖率的计算采取了人工丈量统计的方法,该方法费时费力且统计结果不精确.住建部在2010年发布了《城市园林绿化标准》GB/T50563-2010),规范中要求用卫星或航空遥感影像作为绿化覆盖率的评价依据和评价标准.在机器学习识别绿化的方法未兴起之前,主要运用GIS软件和遥感影像,通过目视解译来识别目标区域的绿化并计算绿化覆盖率[2].这种目视解译方法需要受过培训的解译人员在GIS软件上进行绿化识别和面积的绘制,虽然精度和可靠度高,但是当需要识别的绿化面积很大时,会产生难以计量的工作量,这无疑是一份冗长、乏味且费力的工作,因此亟需一种能够自动识别且准确率高的绿化识别方法.

在自动化提取绿化的需求下,一些诸如最大似然法、支持向量机等机器学习的方法被提出用于城市绿化的识别[3,4],但是受到“椒盐噪声”以及模型本身性能等因素的影响,通过机器学习方法取得的分类精度并不理想.此后基于遥感影像的面向对象方法[5,6]被提出用于城市绿化提取,虽然精度相较之前有所提高,但是需要人为调整参数,这仍然不够便捷.深度学习通过加深网络层数来学习目标物体更深层次的特征,近几年被广泛应用于遥感图像的识别和分类分割任务中[7,8].语义分割是用于遥感影像绿化识别的重要和热门方向.诸如FCN[9]、U-Net[10]、Seg-Net[11]、PSPNet[12] 、Deep labv3+[13]等经典语义分割方法如雨后春笋般崛起.

在这些网络中提出了全卷积层、U型网络编解码架构获取上下文信息、多尺度特征融合、空洞卷积等来提高网络在执行图像分割任务时的准确率.Deep labv3+也是近期用于城市绿化识别、城市道路识别等现实应用的主流网络 [14-17].但大多数基于深度学习的网络为防止过拟合[18]以及挖掘不同场景和不同尺度情况下目标的本质特征,通常需要大量数据来训练模型,Liu等[14]将Gaofen-2遥感影像作为数据源,手工制作了19 687个训练样本并结合deeplabv3+网络设计了城市绿化识别框架,数以万计带标签的数据保障了深度学习模型识别的准确率,但同时对数据量以及标注工作量提出了挑战.而遥感方面的高精度影像数据集,尤其是专门用于城市绿化识别方面的公开数据集目前十分稀少,虽然现在有诸如SIRI-WHU、Gaofen Image、Vaihingen等公开数据集,但这些公开数据集存在一些缺点:数据少且涉及范围广,单个数据集中城市场景的数据不超过200张;空间分辨率低,1米以上的空间分辨率,只能勉强识别出一些较大体积的目标;不同数据集的空间分辨率也不相同,所处地区经纬度差异大导致植被种类不同.不同的空间分辨率以及不同地区的植被特征使得模型學习特征困难,将多个数据集的数据整合到一起用于深度学习模型的训练可能反而会干扰模型对于特征的学习.

欧洲空间局ESA)在2015年6月起免费提供分辨率为10米/像素的哨兵2号MSI数据,这为利用遥感数据进行相关研究带来契机.虽然可以利用遥感数据对地表植被进行研究,但是到目前为止,主要是针对森林[19]和草原[20]这些大面积绿色的区域取得一些显著性的研究成果.这种10米分辨率级别的遥感数据对背景复杂的城市地区进行绿化识别仍然存在巨大的难度.例如,一般道路两侧成年行道树的冠幅平均宽度在4~6米之间,如果影像数据是10米一个像素点,那么一个像素点甚至无法表示一颗成年的行道树.而城市内有不少诸如行道树、街头绿化、小区绿化等小片绿化面积的情况,如果用5~10米精度级别的影像来识别城市中的绿化,那么许多小面积的绿化将因为像素原因很难被检测到,城市绿化统计结果的准确率也将大打折扣,因此5米以上分辨率的遥感影像不太适合于精细化的城市绿化识别.

卫星遥感影像的成像结果也会受到云雾、天气等影响.相较于卫星遥感影像,无人机影像有着灵活性高、云下飞行、分辨率高、时效性强、成本低等优点[21].到目前为止,无人机影像的分辨率可以达到厘米级像素,在相同区域面积和相同图像尺寸的前提下,使得其相较于卫星遥感影像亚米级以上的像素,带来了十倍乃至百倍更高精度的图像数据量.

此外,无人机影像成像时,若光线较弱或受到建筑物阴影遮挡,则绿植在图像中会表现得偏暗,且与部分偏黑的地面展现出视觉上的相似性,绿植与地面区别小以及一些复杂的地物背景会在一定程度上干扰网络精确分割出边界,从而导致整体准确率的降低.

为解决可用于城市绿化识别的公开数据集少的问题,提出以无人机的高分辨率影像作为数据源,将马路、住宅区、郊区、公园、城中村等城市中主要的绿化区域作为筛选对象,构建了数量分别为1 000 张、2 000张、4 000张的自制无人机影像数据集.为解决数据标注工作量大的问题,运用交互式自动标注工具EISeg进行数据标注并引入基于深度学习的像素级分类网络U2Net [22],运用其在不降低特征映射分辨率的前提下提取该阶段内的多尺度特征这一强化特征学习能力、增加目标语义信息的特点来降低网络对训练数据的需求量,一方面简化原有的标注流程、另一方面降低所需要标注数据的数量,结合两者来减少标注任务繁重的问题.为增强对于目标边界的分割能力,在网络的ReSidual U-blockRSU)的上下采样过程引入最大池化索引.最后将改进的网络和其它深度网络在自制的无人机影像数据集上进行定量和定性对比试验,以期为城市绿化的识别提供一种兼顾效率和准确率的自动解译方法.

1 网络架构及优化

1.1 网络架构

论文将U2Net作为城市绿化提取网络的原型.U2Net是一个基于深度卷积神经网络的编码器-解码器架构.这种U型的编码器-解码器以及多层特征融合的架构,使得网络即使面临数据量少的情况,仍然能通过模型训练得到非常不错的准确率.

该网络的最大特点是分为内外两个层级的结构,在一个大的U型结构里又嵌套了小型的U型结构,并在每个小U型结构中分别进行不同尺度的特征提取和融合.外层是与U-Net网络架构相似的6层U型结构,而每一层网络内部又是一个小型的类似于U-Net的模块,原作者将内部的U型结构称为RSU模块.RSU模块通过对特征图的逐级下采样以及膨胀卷积的使用,在不增加计算量的前提下获得了更大的感受野以及目标的局部与全局之间的联系,同时该模块也使得网络的层数变得更多.

通过RSU模块进行下上采样可以在不降低外层网络特征分辨率的情况下,获取到该特征分辨率下不同尺度的上下文信息.网络外层的编码器-解码器架构获取到不同层次下的目标特征,再通过特征融合模块实现不同层次特征的拼接,以此来获得丰富的上下文信息,将这些信息合成最终的预测结果,根据最终预测结果执行图像的分割任务.

U2Net的网络为了获得更大的感受野,在RSU模块里进行多次下采样,经过多次下采样后,网络会丢失原图的部分位置信息,因此最终得到的预测图可能存在目标边界位置表达能力欠缺的现象,而最大池化索引能在一定程度上弥补边界信息丢失过多的问题.

1.2 最大池化索引

最大池化索引Max Pooling Indices)最早在2016年的SegNet网络中被提出,后来被广泛应用到各种分类网络中.最大池化方法被用来压缩图像,加速运算过程.压缩图像时,图像中的细节信息难免丢失,而最大池化索引在网络编码部分进行最大池化操作时记录最大值所在的位置,然后在解码时通过池化索引实现非线性上采样.通过这样的方式获得更为精确的区域边界位置.增加特征图对于细节和边界区域的表达,得到更光滑的预测图[23].最大池化索引过程如图1所示.

1.3 融合最大池化索引的MPI-RSU

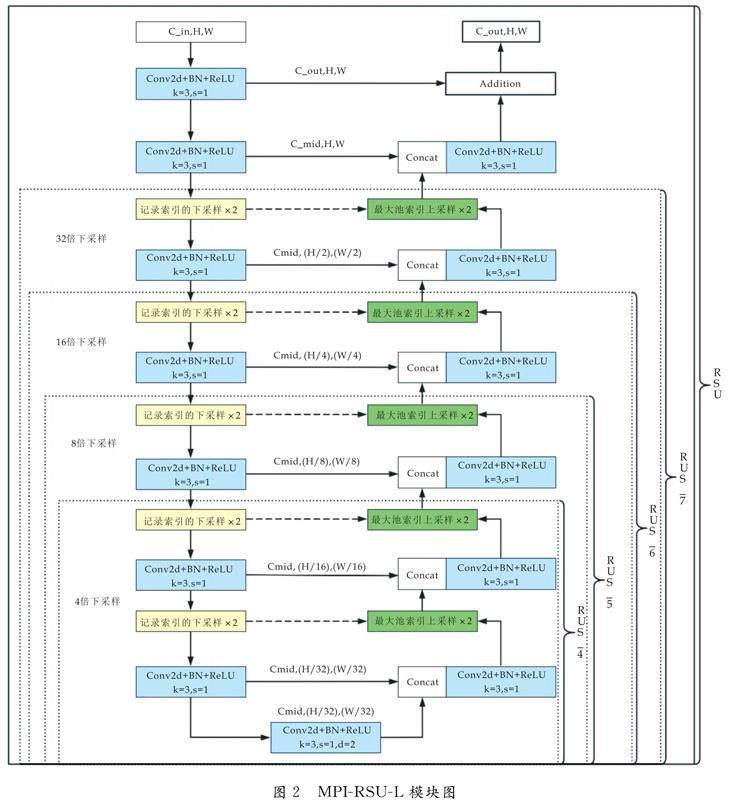

RSU模块进行不同尺度的下采样时,采用concat的方式将经过上采样后的解码器层与同个层级的编码器特征进行通道上的拼接,最终得到更多通道层面的特征信息,这样虽然得到更厚更丰富的特征,但每个通道本身的信息仍会随着下采样而逐渐丢失一些边缘信息,而最大池化索引捕获和记录了编码器特征映射中的位置信息,从而获得了更为精确的边界定位[23].图2展示了改进后的Max Pooling Indices ReSidual U-bolck LayerMPI-RSU-L)模块.为了使得RSU模块在上采样还原特征图的过程中能更加精确地还原照片中绿化与非绿化间的边界信息,在不显著增加计算负担的前提下,RSU模块引入了最大池化索引来替换原来的上下采样过程,相较于之前的采样过程,在2×2的池化器中只需在编码器特征映射中额外花费2位来存取其位置信息.编码部分采取记录索引信息的最大池化索引,而解码部分则通过记录索引位置还原回上一层的大小并和编码器部分的上一层通过concat方式進行拼接.网络中的RSU-4F模块通过膨胀卷积来代替池化操作,增加了网络的感受野.Qin在文献中提到,在RSU-4F部分,图片的尺寸通过网络外层的下采样已经非常小了,此部分继续进行池化很难提升模型的分类精度[23].基于此,只在RSU-7、RSU-6、RSU-5、RSU-4部分进行替换,对RSU-4F部分不做更改.RSU-7、RSU-6、RSU-5、RSU-4的区别在于随着网络外层层数变化,每当外层层数减一,相应RSU模块中编码器和解码器也减少一层池化卷积操作,详细情况如图2所示.

在图2中:H代表图片高度,W代表图片宽度.C_in代表输入通道数,C_out代表输出通道数,C_mid代表中间层通道数.Conv2d代表卷积层,BN代表批量归一化层,ReLU代表修正线性单元激活层,k=3代表卷积核尺寸为3×3,s=1代表步距为1.d=2代表采取膨胀系数为2的膨胀卷积.Concat表示网络层之间采用Concat拼接方法.

2 数据和技术框架

整体流程分为3部分:第一部分进行数据获取处理,第二部分进行模型优化和训练,第三部分进行绿化识别任务.

2.1 数据来源与处理

研究使用的无人机影像来自于大疆经纬M300RT在漳州市南靖县180米高空拍摄的影像,影像的获取时间是2022年8月,拍摄面积约8.63 km2,空间分辨率为5 cm,影像具有红、绿、蓝三波段.

数据获取过程为获取:(1)设定拍摄路径、范围、间距、高度后进行航空摄影;(2)空三加密、正射纠正;(3)引入OpenCV库用将原始影像切分为适合深度学习训练的尺寸512*512,并对切分后的图像进行编号;(4)对切分后的图像进行筛选,筛选策略为不同图片中各自包含马路、住宅区、城中村以及公园等这些城市中具有代表性的场景,数据集包含更多城市的绿化场景,使模型应对城市中不同场景下的绿化识别也拥有更为良好的泛化能力.被切分后的图片分为前景和背景,前景指城市中各类绿化覆盖区域的像素,背景是指除绿化之外的其它区域的像素,剔除背景区域超过90%的图片(正负样本平衡策略);(5)运用飞桨开发的自动交互式分割软件EISeg,该软件通过对目标区域的点击,自动预框选出与目标区域相似的区域,经过多次互动点击得到所需标注的目标区域,最后通过人工微调获取到准确地分割结果,通过该自动标注软件得到掩膜图像;(6)再次运用OpenCV库对原图和掩膜进行上下翻转、45度旋转和镜像进行数据扩充.按照9∶1的比例划分为训练集和验证集,共得到1 000 张、2 000张、4 000张三个不同量级的数据集,数据的获取与处理流程如图3所示.

2.2 模型优化、训练与对比

提出对U2Net网络中的优化方法,用最大池化索引来替换网络中原有RSU模块的上下采样过程,选择多个主流的深度学习语义分割网络用于进行后续对比试验,对网络设置相应的训练参数,准备不同数量的数据集进行训练.通过各个网络训练后的评价指标数据对比,网络改进的消融实验对比,实例预测的定性对比来验证改进后网络的有效性,网络修改和训练流程如图4所示.

2.3 绿化识别任务

验证模型的有效性后,将每一张大尺寸的无人机影像通过编程进行切分,将城市建成区范围内的影像均切分成大小为512*512的图片,并将切割后的图片以坐标位置_x的格式进行命名(其中x代表此坐标影像切分的第几张图片).调用此前训练好的模型权重,将所有图像载入模型进行预测任务.在模型进行像素级预测时,记录预测为绿化的像素数量并将图片名称和像素数量通过追加写的方式保存到csv文件中作为验证数据.将每张图片预测为绿化的像素进行累加并除以所有图片的总像素,得到目标区域的绿化覆盖率.最后将所有的预测图进行拼接融合,形成最终的建成区绿化覆盖图,任务执行流程如图5所示.

3 实验结果与分析

3.1 实验环境

本文的网络模型基于Pytorch深度学习框架进行搭建,采用CUDA并行计算平台.软硬件的详细信息为CPU:Intel Core i9-10900 CPU @3.70GHz; GPU:NVIDIA GeForce RTX3070; CUDA:11.6; Python:3.8.13; Pytorch:1.12.0; 操作系统:Windows 11 64-bit.

3.2 参数配置

模型共训练360个epoch;batch_size为 8;初始学习率le-3;选择Adamadaptive moment estimation)优化器,超参数lr=le-3,betas分别取0.9和0.999,weight_decay=le-2;学习率下降的方式是先进行热身训练,再通过“cos”的方式下降.

3.3 评价指标

为定量评估深度学习网络在城市绿化识别任务的表现,将精确率Precision)、召回率Recall)、综合指标Fβ-score),其中β2取1、总体分类精度Overall Accuracy,OA)作为评价指标,公式如式1)~4)所示.

Precision=GTPGTP+GFP(1)

Recall=GTPGTP+GFN(2)

Fβ-score=1+β2)Precision×Recallβ2Precision+Recall)(3)

OA=GTP+GTNGTP+GTN+GFP+GFN(4)

式1)~4)中:GTP是模型正确分割为绿化的像素数;GTN为模型正确分割非绿化的像素数;GFN为模型错误的将绿化分割为非绿化的像素数;GFP为模型错误的将非绿化分割为绿化的像素数.

3.4 模型优化有效性评价

通过消融实验,分析U2Net网络性能受不同池化方法的影响,从而证明改进方法的有效性和必要性.对比结果如表1所示.

在表1中,“√”代表引入了对应方法,而“×”则代表未引用对应方法.实验中除了改进方法不同,其他参数均相同.在模型的RSU模块引入Max Pooling Indices方法,然后与原来的池化方法所得到的结果进行对比.由表2可知,模型的参数量、计算量、模型内存均未发生改变.证明通过该改进方法并不会增加模型的计算成本和内存消耗.

3.5 不同网络对比实验

本文将改进的U2Net与FCN、U-Net、Deep labv3、Deep labv3+和原始U2Net在自制的无人机影像数据集上进行城市绿化识别对比实验.对比结果如表2所示.

表2中的实验数据以F1指标的最大值作为从每个epoch获取结果的依据.由表3可得,在1 000 张、2 000张、4 000张的数据集中,改进的U2Net在OA和F1值高于其它深度学习网络.尤其在1 000张量级的数据集中,U2Net和改进后的U2Net由于自身网络架构的优势,展现出远高于其它深度学习网络的性能,改进后的U2Net其各项评价指标为OA97.16%),F194.95%),Precision 95.23%),Recall94.06%),较改进之前分别提高了0.68%、1.01%、0.97%、1.18%.在不同数量的数据集中(数据集数量由小至大),改进后的网络较改进之前的OA分别提升了0.68%、0.53%、0.46%;而F1则分别提升了1.01%、1.23%、1.32%.证明替换为最大池化索引的网络性能得到一定的提升.

观察实验数据发现,表中其它深度学习网络各项指标随着数据集数量增加而提升显著,当前最热门的语义分割网络Deep labv3+在4 000张的数据集中,Recall的得分取得了所有对比网络中的最高分并且F1取得的成绩也逼近改进后的U2Net网络.此外,U2Net和改进后的U2Net的各项指标随着数据集数量的增加而提升,由于在1 000张数据集的训练中已经达到非常高的数值,后续数值的提升并不明显.

3.6 网络改进前后分割效果对比

为直观地观察U2MPINet与U2Net网络之间的實际分割效果,将经过1 000张数据集训练的网络进行实例分割.对比数据是从无人机影像中截取了部分训练集之外尺寸为512*512的图片.图6展示了不同城市场景下网络改进前后的绿化分割效果图.

U2Net与改进的U2Net网络都表现出和人工标签相近的分割结果.但是改进的U2Net在目标边界处展现出更为精确和光滑的分割结果.例如在马路场景中,改进后的U2Net能识别出图片中的路灯,而U2Net则不然;还有图片中的行道树,改进后的网络对行道树树荫与马路之间的区分做了精细化的分割,而U2Net得到一个更为“粗糙”的分割结果.在住宅区的场景中,改进后的网络在图片右下方出现了一定的误检,但是左下方因高楼遮挡而产生的阴影区域下细小的白色围栏这一非绿化区域被识别出来,而U2Net网络忽视了这一区域.在公园场景中,由于原始图像右下方的马路和草地之间边界模糊,U2Net将更多地草地预测成了非绿化区域,并且分割结果表现得不规则,而改进后的网络则表现得更好.在城中村场景中,图像右上角阴影部分的非绿化覆盖区域被改进后的U2Net准确识别出来,而U2Net则将这一深色部分识别为绿化覆盖区域了.

通过上述分析可以得到, U2Net与改进后的U2Net可以准确识别出图像中大部分绿化覆盖区域,但是改进后的U2Net对于目标的边界区域以及图像阴影区域的分割更为精确.

4 结论

本文将改进的U2Net网络应用于城市绿地识别任务中,提出一种面向高分辨率无人机影像的城市绿地自动识别技术.将改进前后的网络与当前流行的深度学习像素级分类网络进行对比,通过实验证明改进的有效性以及该网络在小规模数据集城市绿地识别任务中的显著优势,为今后城市进行绿地识别和监测提供一种新的、训练数据更少的、分类精度更优秀的自动解译方法,进一步减少城市绿地识别中的重复性工作.

整个技术框架仍然有改进空间,从数据和模型两个方面出发,数据层面:无人机影像只有红、绿、蓝三个波段的信息,波段信息有限,现阶段已有研究开始关注将特征工程融入到深度学习模型中来丰富特征学习的维度,例如加入不同季节的植被特征来加强网络对绿植的识别准确率.模型方面:为保障模型可以學习到丰富的特征,RSU模块将编码器阶段的特征通过拼接的方式拼接到解码器上来丰富特征信息,但是这样全盘接受在丰富特征信息的情况下也带来了计算量的增加,在保证分类精度的前提下,如何优化模块,以更少的计算量来得到等量或更多的特征信息,例如调整RSU模块的计算过程或增加注意力机制等,是此后需要进一步研究和解决的目标.

参考文献

[1] Han J,hao X,hang H,et al.Analyzing the spatial heterogeneity of the built environment and its impact on the urban thermal environment-case study of downtown shanghai.Sustainability,2021,1320):11 302.

[2] 杨 桄,刘湘南.遥感影像解译的研究现状和发展趋势.国土资源遥感,20042):7-10,15.

[3] 王修信,吴 昊,卢小春,等.利用混合像元分解结合SVM提取城市绿地.计算机工程与应用,2009,4533):216-217,226.

[4] Durduran S S.Automatic classification of high resolution land cover using a new data weighting procedure:The combination of k-means clustering algorithm and central tendency measuresMC-CTM).Applied Soft Computing,2015,35:136-150.

[5] 李成范,尹京苑,赵俊娟.一种面向对象的遥感影像城市绿地提取方法.测绘科学,2011,365):112-114,120.

[6] 李梦雅,朱小平,贾小凤.应用面向对象的高分辨率遥感数据提取城市绿地.北京测绘,2019,332):196-200.

[7] 郑远攀,李广阳,李 晔.深度学习在图像识别中的应用研究综述.计算机工程与应用,2019,5512):20-36.

[8] Weinstein B G,Marconi S,Bohlman S,et al.Individual tree-crown detection in RGB imagery using semi-supervised deep learning neural networks.Remote Sensing,2019,1111):1 309.

[9] Long J,Shelhamer E,Darrell T.Fully convolutional networks for semantic segmentation[C]//Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition.Boston:IEEE,2015:3 431-3 440.

[10] Ronneberger O,Fischer P,Brox T.U-net:Convolutional networks for biomedical image segmentation[C]//International Conference on Medical Image Computing and Computer-Assisted Intervention.Munich,Germany:Springer,2015:234-241.

[11] Badrinarayanan V,endall A,Cipolla.SegNet:A deep convolutional encoder-decoder architecture for image Segmentation.IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,3912):2 481-2 495.

[12] hao H,Shi J,Qi X,et al.Pyramid scene parsing network[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Hawaii:IEEE,2017:2 881-2 890.

[13] Chen L C,hu Y ,Papandreou G,et al.Encoder-decoder with atrous separable convolution for semantic image segmentation[C]//Proceedings of the European Conference on Computer Vision.Munich,Germany:Springer,2018:833-851.

[14] Liu W Y,Yue A ,Shi W H,et al.An automatic extraction architecture of urban green space based on DeepLabv3plus semantic segmentation model[C]//2019 IEEE 4th International Conference on Image,Vision and Computing ICIVC).Xiamen,China:IEEE,2019:311-315.

[15] 陈 周,费鲜芸,高祥伟,等.高分辨率遥感影像分割的城市绿地提取研究.测绘通报,202012):17-20.

[16] 任鴻杰,刘 萍,岱 超,等.改进DeepLabV3+网络的遥感影像农作物分割方法.计算机工程与应用,2022,5811):215-223

[17] 许泽宇,沈占锋,李 杨,等.增强型DeepLab算法和自适应损失函数的高分辨率遥感影像分类.遥感学报,2022,262):406-415.

[18] Li ,amnitsas ,Glocker B.Analyzing overfitting under class imbalance in neural networks for image segmentation.IEEE Transactions on Medical Imaging,2020,403):1 065-1 077.

[19] Mi L,Chen .Superpixel-enhanced deep neural forest for remote sensing image semantic segmentation.ISPRS Journal of Photogrammetry and Remote Sensing,2020,159:140-152.

[20] Wang B,Ma Y ,hang Y N,et al.Review of remote sensing applications in grassland monitoring.Remote Sensing,2022,1412):2 903.

[21] 杨 柳,陈延辉,岳德鹏,等.无人机遥感影像的城市绿地信息提取.测绘科学,2017,422):59-64.

[22] Qin X B,hang C,Huang C,et al.U2-Net:Going deeper with nested U-structure for salient object detection.Pattern Recognition,2020,106:107 404.

[23] ou Q,hang ,Li Q,et al.Deepcrack:Learning hierarchical convolutional features for crack detection.IEEE Transactions on Image Processing,2018,283):1 498-1 512.

【责任编辑:陈 佳】

基金项目:国家自然科学基金项目(42201225); 福建省自然科学基金青创项目(2021J05220)

作者简介:王 桢(1997—),男,浙江杭州人,在读硕士研究生,研究方向:图像处理、计算机视觉

通讯作者:杨培峰(1972—),男,浙江长兴人,教授,博士生导师,研究方向:城市生态规划、区域与城乡空间发展,young72@qq.com