生成式人工智能场景下虚假信息风险特殊性透视及应对

2024-05-15刘超民

摘 要:生成式人工智能改变了传统的信息生产机制而有广阔的应用场景,但其生成虚假信息速度快、逼真度高、无中生有的特征不仅放大了传统的虚假信息风险隐患,还使得信息信任风险成为虚假信息的重要风险类型,也使得社交媒体平台虚假信息治理防线有被全面突破的风险。对此,应基于生成式人工智能对虚假信息治理体系的挑战,从规范依据、虚假信息分类分级和实施部署方面着手推进虚假信息分级治理;应从应用准入、算法治理和训练数据质量管理方面强化虚假信息的源头治理;应从监管协同、义务细化和公私协同方面增强虚假信息的协同治理。

关键词:生成式人工智能;虚假信息;分类分级;源头治理;协同治理

中图分类号:D035 文献标识码:A 文章编号:1672-335X(2024)02-0112-10

DOI: 10.16497/j.cnki.1672-335X.202402010

2022年12月1日,美国OpenAI公司推出的ChatGPT以其在自然语言理解、文本生成、代码编写及知识问答等方面的强大功效让社会见证了生成式人工智能的广泛应用场景和市场前景。我国很多企业也纷纷投入生成式人工智能的研发并推出了类似产品,如百度“文心一言”、阿里“通义千问”、360“智脑”、中国电科“小可”等。但生成式人工智能在应用过程可能的负面影响也被揭露和关注,对此,既有研究探讨该技术在营销领域[1]、旅游领域[2]、教育领域[3][4]、科研领域[5]的应用可能引发的风险及应对,从不同视角揭示其应用风险。通过文献梳理发现,既有研究均将虚假信息作为该技术应用产生负面影响的原因之一,这充分说明在开展生成式人工智能场景下虚假信息治理理论研究的必要性。而观察生成式人工智能技术的应用,发现该技术不仅有凭空编造虚假信息的特征,而且有生成速度快、生成内容逼真度高的特点,可以想见该技术必然会使虚假信息的风险产生某种形塑进而对虚假信息治理产生冲击,[6]因而从实践需要讲也有对其展开研究的必要。既有虚假信息的治理实践和研究,主要停留在生成式人工智能未广泛应用前的社交平台虚假信息的治理,[7]尚且没有结合生成式人工智能技术对虚假信息风险的特殊性和治理的挑战来开展,因而难免缺乏针对性。因此,本文拟对生成式人工智能技术场景下虚假信息风险特殊性进行挖掘,进而分析既有虚假信息治理体系在面对技术挑战时的困局并探索纾困之策。

一、生成式人工智能技术下虚假信息风险特殊性透视

生成式人工智能技术在生成虚假信息方面有速度快、体量大和逼真度高的特征,[8]比人工生产虚假信息效率高出很多量级,甚至在图片、视频伪造等领域比人类更加高明。因此,生成式人工智能技术会对传统的虚假信息风险发生影响,甚至还会产生新的风险挑战。为对这些风险挑战进行揭示,本文通过文献调研法和案例收集法对风险样态进行总结,以便揭示在生成式人工智能下虚假信息风险的特殊性。

(一)放大已有虚假信息的风险隐患

虚假信息因存在领域不同会在个人权益、社会秩序以及国家安全等不同层面产生风险隐患,而生成式人工智能技术会让虚假信息的破坏性得以放大而难以控制。在个人权益层面,编造谣言对个体进行诽谤进而侵犯个体名誉权,这类虚假信息的风险在生成式人工智能广泛应用前就已经存在,而生成式人工技术场景下造谣成本的降低和造谣水平的增强,使得谣言破除难度更高且风险隐患也更高,这放大了已有虚假信息的风险隐患。在社会秩序层面,生成式人工智能技术使得虚假社会新闻制作成本更低、速度更快和欺骗性更强,进而使社会秩序维护面临更高的挑战。例如,杭州某小区居民用ChatGPT制作“明日杭州市取消依照尾号限行”的虚假政府通告并进行分享导致虚假信息被广泛传播,严重扰乱了社会秩序。[9]而民众信以为真的原因很大程度是因為ChatGPT编写的虚假新闻有很强的逻辑性和连贯性。在国家安全方面,生成式人工智能编写虚假信息能力给政治稳定、国防安全带来的隐患也不容忽视。事实上,生成式人工智能被用于政治领域的案例已经出现。例如,美国芝加哥市长选举中就曾出现利用人工智能软件伪造候选人谈话音频进而让选民对候选人政治立场产生误解的破坏选举事件。[10]而在国防安全方面,生成式人工智能技术可能被敌对国家用来对我国进行虚假信息攻击。这种虚假信息攻击主要有两种情形:一种情形是通过编造虚假信息来影响我国民众的认知进而营造有利于敌人的舆论。此种攻击手法美国对中东地区国家施展过,极大地增强了美国在当地的舆论优势。[11]第二种情形是伪造虚假情报信息干扰我国决策机构和国民对国安情势判断,进而危害我国国家安全。[12]尽管上述风险并不是因生成式人工智能而产生,但运用该技术会增加侵害手段的危害性,也会相应提升该种类风险的治理难度。

(二)增加信息信任损害为重要风险类型

生成式人工智能智能具有类人性、看似真实性等特征,这使其可能错被作为获取真实信息的工具,进而产生信息信任损害的风险。事实上,生成式人工智能下虚假信息引发的信息信任损害风险已经得到一定程度的显现,体现在个人信息信任和知识信息信任两个方面。在个人信息信任方面,已出现AI编造他人过往经历信息的现象。例如,澳大利亚某地市长布赖恩·胡德被ChatGPT编造其在1999年、2005年曾向外国官员行贿被判处刑罚的过往经历信息。[13]无独有偶,美国乔治华盛顿大学法学教授乔纳森·特利被编造有性侵女学生并被处罚的过往经历且曾因此事被《华盛顿邮报》公开报道。而事实上《华盛顿邮报》从未报道过该新闻,而特利也从未因性侵女性受过指控。[14]这说明生成式人工智能有编造个人过往经历的信息能力,如果将其作为获取他人经历信息的工具,必然引发个人信息信任的风险。在知识信息信任方面,类似ChatGPT的生成式人工智能能以聊天的方式向询问者快速提供合乎逻辑和可信的答案,在回答简单的知识常识等方面具有很好的客观性和真实性,因此很容易被作为无所不知的超级人工智能而被赋予知识基础设施的地位进而成为获取知识的重要渠道。而生成式人工智能对问题的回答是基于对训练数据的深度学习。如果学习的数据质量存在问题,其输出文本真实性难以保证。在特定高深的学术领域,其没有受到相关数据的训练,其对问题的回答存在事实性错误、概念误用甚至捏造信息等问题。生成式人工智能还会编造虚假的信息源,如果被其欺骗而怠于查证则无疑有害教育、科研的发展,[15]进而产生知识信任的问题。

(三)突破社交平台内容治理防线的风险

生成式人工智能连续对话、信息批量制造以及出色的伪装能力会使得社交平台面对治理海量高度逼真的虚假信息的挑战。社交媒体平台如微信、微博、抖音、知乎等已经是人们日常交往的重要方式,成为发布信息、获取信息与分享知识的重要场域,也是网络虚假信息泛滥的重灾区。社交媒体平台打破了传统媒体对信息发布的垄断,任何用户都可以是信息源,但也因用户发布信息往往不会经过真实性审核而面临如何有效治理虚假信息的困扰。[16]生成式人工智能技术在信息生产力方面的突破性进展,会进一步加剧社交平台虚假信息治理的难度。在治理对象识别方面,生成式人工智能生成虚假信息的高效率和欺骗性使得社交平台识别虚假信息的工作量和工作难度极大提高,进而增加社交平台识别虚假信息的成本。在虚假信息传播的技术反制方面,生成式人工智能的连续对话能力使其被作为社交机器人使用时更加难以识别,从而提高打击社交机器人的难度。传统的社交机器人只是简单复制与粘贴原帖来传播虚假信息而不能进行持续对话,相对容易被社交平台识别与禁止,而生成人工智能如ChatGPT却没有原有社交机器人的不足。因此,社交平台虚假信息的治理将会面临不同以往的全新挑战,甚至面临现有治理体系被全面突破的风险。在这种背景下,无论是监管机构还是社交媒体平台,都必须及时更新社交平台虚假信息的应对策略,才能更好地应对生成式人工智能技术给社交平台虚假信息治理带来的挑战。

二、既有生成式人工智能下虚假信息治理模式的困局及改进方向

网络虚假信息问题自互联网诞生之日就已经产生,但生成式人工智能广泛应用之前的虚假信息隐患远没有现在这么严重。虽然目前网络虚假信息的宏观框架和治理措施及安排,在一定程度上能对生成式人工智能技术引发的虚假信息问题进行应对,但从治理现状考察,既有治理体系面临治理对象范围扩大、源头治理力度不足、治理主体协同性不强的困局。

(一)生成式人工智能下虚假信息的治理现状

从虚假信息生成到发挥负面作用来看,依次会经历生成式人工智能编写虚假信息、社交平台传播、受众接受错误信息的过程。因此,虚假信息的治理包括信息生产、信息传播以及信息影响三个环节,涉及生成服务提供者、社交媒体平台以及网络用户等多方主体。与之相对应,网络虚假信息的治理也形成了覆盖多环节、多主体的治理格局。通过梳理有关法律、行政法规、部门规章以及地方性法规、网络平台的管理规约、用户协议等有普遍约束力或者局部约束力的文件,可将当前网络虚假信息的治理主体、治理环节及治理措施概括为图1。

总的来说,现有的以《网络信息内容生态治理规定》为基础构建的网络虚假信息治理体系在宏观治理框架方面已经相对完善,也基本覆盖到相关主体和信息生产、信息传播以及信息影响等环节。然而在治理规范的针对性层面,如《互联网深度合成服务管理办法》(以下简称“《办法》”)〖ZW(1B〗2022年11月11日,《互联网信息服务深度合成管理规定》由国家网信办、工信部、公安部联合发布,自2023年1月10日起施行。)直接指向人工智能深度合成虚假信息源头生产的治理规范还比较少,《办法》在第二章第六条只做了笼统的规定:“任何组织和个人不得利用深度合成服务制作、复制、发布、传播法律、行政法规禁止的信息,不得利用深度合成服务从事危害国家安全和利益、损害国家形象、侵害社会公共利益、扰乱经济和社会秩序、侵犯他人合法权益等法律、行政法规禁止的活动。深度合成服务提供者和使用者不得利用深度合成服务制作、复制、发布、传播虚假新闻信息。转载基于深度合成服务制作发布的新闻信息的,应当依法转载互联网新闻信息稿源单位发布的新闻信息”。《办法》没有对深度合成服务中的基础数据来源、数据质量、数据合成算法进行规范。而其他规范在应对生成式人工智能下虚假信息治理方面还缺乏针对性。在治理对象的覆盖范围上,现行治理规范只规制属于违法信息、不良信息和虚假新闻的虚假信息,而没有覆盖到人工智能生成的纯粹事实虚假信息,如虚假健康信息、虚假学术信息等。因此,在既有虚假信息治理体系中,生成式人工智能引发的虚假信息问题难以得到有效治理,还需要进一步解决。

(二)面向生成式人工智能的虚假信息治理困境

生成式人工智能技术对虚假信息生产效率、虚假性识别难度的提高以及其作为知识基础设施表面的虚假权威性,不仅放大了传统虚假信息的风险隐患,而且引发新的信息信任风险和平台虚假信息治理防线被突破的风险。然而生成式人工智能技术的积极价值也要保护,因此,在生成式人工智能时代下,虚假信息的治理目标在于实现人工智能科技创新与虚假信息隐患的平衡,尽全力将虚假信息隐患控制在合理范围。而从虚假治理规划的角度讲,应做好事前人工智能虚假信息的源头生成控制、事中虚假信息传播的阻断和事后虚假信息影响的消除等工作,而根据生成式人工智能的技术特性和事后修复虚假信息损害成本的考量,虚假信息治理的重点应放在事前虚假信息生成的监管和事中传播环节虚假信息的阻断,当然事后修复影响的责任追究和辟谣工作也要进行相应强化。因此,实现生成人工智能下虚假信息的治理,需要根据生成人工智能下虚假信息风险隐患的特殊性,从治理薄弱点出发,构建与生成式人工智能场景下虚假信息风险水平相匹配的治理体系。

但是,既有网络虚假信息治理体系在面对ChatGPT等生成式人工智能技術方冲击下面临困局,主要体现在治理对象、治理规划以及治理主体三个方面。在治理对象层面上,生成式人工智能使得虚假信息治理的范围扩张,而既有治理体系没有涵盖可能引发风险隐患的全部虚假信息。根据《网络信息内容生态治理规定》《互联网深度生成服务管理办法》《互联网信息服务算法推荐管理规定》《网络音视频信息服务管理规定》等规范,既有治理体系范围内的虚假信息仅包括违法信息、不良信息、虚假新闻,而没涵盖虚假健康信息、虚假学术信息以及偏见和歧视信息等事实虚假信息。以往事实虚假信息多由不法分子为了特定目的而刻意伪造,例如编造用铁锅炒菜能补充铁元素等虚假信息来销售铁锅等,而不会无目的地去伪造单纯事实虚假信息,而生成式人工智能由于自身智能缺陷却会不基于功利目的地去生产这些纯粹虚假和违反常识的信息,因此生成式人工智能场景下需要治理的虚假信息范围更为宽泛,如果采用同样的治理标准,则会产生不合理地增加企业合规成本、阻碍技术创新以及侵犯个体信息发布自由等问题,因此,应该综合考虑信息类型、信息领域以及风险程度进行分类分级治理。在治理规划层面上,生成式人工智能使得源头信息生产环节成为治理重点,既有治理体系在源头治理方面力度不足,具体体现在生成式人工智能的监管缺位。[17]以ChatGPT为代表的生成式人工智能之所以会产生虚假信息,除了人为操纵之外,还与其内在算法缺陷以及训练数据质量不高、语料库不能及时更新等有关。生成式人工智能的治理除了要对传播环节进行治理之外,还要回到生成人工智能规范本身,促使人工智能企业优化算法以及提高训练数据的质量来尽力减少不必要的错误。即便如此,也不可能将全部的错误问题解决,还需要人工智能服务提供者在可能的范围之内配合传播环节虚假信息的治理,如添加数字水印等。整体来说,既有对人工智能企业算法治理、训练数据质量管理以及配合后续治理的规范并非绝对欠缺,但都缺乏直接相关性。如,2022年3月1日施行的《互联网信息服务算法推荐管理规定》,尽管对生成合成类的算法推荐技术进行了规范,但是并没有直接从源头对算法训练数据、算法缺陷等进行规制;《互联网深度生成服务管理办法》中规定:深度合成服务提供者和技术支持者应当加强训练数据管理,采取必要措施保障训练数据安全;训练数据包含个人信息的,应当遵守个人信息保护的有关规定。但是此处并没有直接涉及训练数据的质量、可信度等方面的问题。当然,2023年8月公布的《生成式人工智能服务管理暂行办法》主要规定了生成式人工智能服务提供者的责任,但是后续治理的措施并不完备,传播平台责任者、服务使用者相关的责任并不明确,而且缺乏相应的惩罚措施。在治理主体的协同性方面,现有治理模式没有构建起责任明确、协作有效的生成式人工智能场景下的虚假信息治理机制。生成人工智能场景下的虚假信息从产生到传播会涉及多方主体,而不同主体应该负有相应责任,但由于缺乏明确的责任划定和协同义务过于宽泛,因而治理主体在治理职责的履行效果上很难保证。比如,法律只是抽象地规定监管机关有监管职责,网络服务提供者有防止生成、传播虚假信息的义务,而如何具体履行防范义务以及采取何种措施没有细化规定。又如,应对生成式人工智能给虚假信息治理的冲击,有关主体(如网信、电信、公安等部门)之间需要进行必要的信息沟通、事务协调以及联合行动,但目前尚缺乏相应的协调机制。因此,在虚假信息的治理上难免相互推诿,甚至即便部分主体(如公安机关、国家安全机关等部门)有心治理,但由于缺乏相应的协调机制其努力也因其他方面的掣肘而不能取得实效。此时,应该反思既有的虚假信息治理体系,根据人工智能对虚假信息治理的挑战来采取应对措施,实现多元主体的治理协同。

(三)生成式人工智能技术下虚假信息治理的改进方向

面对生成式人工智能技术带来虚假信息治理难题,既有虚假信息治理体系对生成人工智能场景下的虚假信息生产能力和风险隐患的特殊性缺乏有效的回应,因而需要进一步优化。以往虚假信息带来的问题主要还是谣言诽谤、虚假新闻以及虚假信息攻击,而且数量还停留在相对可控的范围,只要强化对传播各环节的把控,就能将虚假信息的影响控制在合理范围之内。既有治理体系之所以面对生成式人工智能会陷入困局,其原因在于现有治理对生成人工智能技术生成虚假信息的特性回应能力不足。详言之,正因为生成式人工智能无中生有、生成速度快的特性才使得需要治理的虚假信息类型增加、数量膨胀,进而才引发治理对象扩张的问题,也因其生成信息效率的革命性提高才使得信息生产环节的人工智能监管成为治理的中心,才使得不同治理主体的协同性需要调整,以此来适应治理需要。因此,既有治理体系的改进思路也应以生成式人工智能的技术特性和影响为基础来展开。详言之,首先,应重视违法信息、不良信息以及虚假新闻之外的虚假信息的治理,以遏制因治理疏漏而引发的信息信任等风险的现实化。其次,应增强生成式人工智能本身的治理,生成式人工智能产生虚假信息受其算法、训练数据、人工标注等因素的影响,如果只是简单去规定人工智能企业防止虚假信息生成的义务而不将治理的触角伸进人工智能治理,那么虚假信息的治理就只是隔靴搔痒。最后,应根据生成式人工智能下虚假信息生成速度快、体量大、逼真程度高的特征对虚假信息不同治理环节的治理主体、治理规范、治理措施提出新要求,对整个虚假信息的治理体系进行全过程、全链条优化。

三、生成式人工智能场景下虚假信息的治理对策

生成式人工智能技术的进展使得虚假信息风险发生了深刻变化,不仅传统虚假信息风险被放大,信息信任风险成为重要风险类型,还加剧了社交平台虚假信息治理防线被突破的风险,因此对这些风险进行应对已经成为生成式人工智能场景下不可回避的问题。为有效应对这些风险隐患,可从虚假信息的分类分级治理、虚假信息的生产源头治理以及治理主体的协同治理方面着手推进生成式人工智能场景下虚假信息的治理,进而疏解既有虚假信息治理体系在面对生成式人工智能冲击而遭遇的困局。

(一)推进虚假信息的分级治理

面对生成式人工智能技术引发虚假信息治理对象范围的扩充以及数量的急剧增加,务实的做法是对虚假信息进行分类分级治理,根据虚假信息损害法益的重要性和可能产生的危险性赋予治理主体差异化的治理责任,进而实现治理效果与治理成本的平衡。为实现分级治理,应从规范依据、分类分级指引、部署推进策略等方面来推进分级治理。

第一,应由监管机关明确规定虚假信息分类分級治理的要求,使得分级分类治理有法可依。分类分级治理的理念在数据治理[18]、个人信息保护[19]方面已得到贯彻并取得阶段性进展,而虚假信息分类分级还没有明确的规范依据,但《网络信息内容生态治理规定》将信息区分为违法信息、不良信息并规定差异化义务的做法已经体现了虚假信息内容分级治理的理念。为了使分类分级有明确的法律依据,同时考虑到分级治理制度还处于初创期,因此可由中央网信办在有关虚假治理规范中先做出原则性规定,以便给后续推行留下制度空间,但其中要包括内容分级原则性标准和差异化设置治理主体义务和法律责任等内容,以构建起分级治理的基本法律框架。

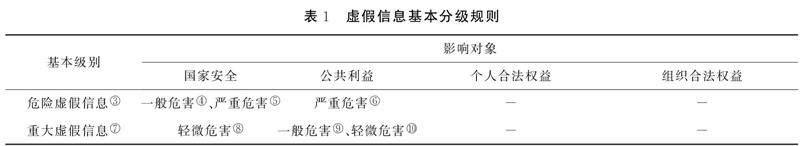

第二,应重视制定具有可操作性的虚假信息内容分类分级规范指引。科学且有可操作性的信息内容分类分级指引是落实虚假信息分类分级治理的先决条件和重要依托。[20]为确保该指引具有可操作性,在制定参与主体方面,应参考《网络数据分类分级指引》的制定过程,吸纳有关领域的监管机关、人工智能产业协会、社交平台企业行业协会以及不同行业的研究机构和专业人士共同参与,以吸取各方面智慧和经验来提高可执行性。在虚假信息内容分级指引参考标准上,可参考《网络安全标准实践指南》〖ZW(2B〗关于发布《网络安全标准实践指南——网络数据安全风险评估实施指引》的通知,https://www.tc260.org.cn/upload/2021-12-31/1640948142376022576.pdf。)的规定,综合考虑虚假信息的危害程度、影响对象、影响程度因素来确定虚假信息的风险等级。根据虚假信息对国家安全、公共利益或者个人、组织合法权益造成的危害程度,将其从低到高分成一般、重大、危险三个级别,根据所损害法益的类型影响对象可区分为国家安全、公共利益、组织利益以及个人利益四种,而影响程度可分严重、一般、轻微和无影响四个等级(参见表1)。考虑到国家安全、公共利益的重要性,即便对其仅有轻微影响也可以定为更高等级,而仅对个人、组织权益产生影响的虚假信息即便有严重影响也可能被定为相对较低的等级。如,捏造某人杀人的谣言,相比造谣明天将施行交通管制的情形,后者涉及了不特定多数人的公共利益,尽管对公共利益有轻微影响,可以将后者定位更高级,因为这种谣言需要及时纠正,涉及的群体比较大,而前者针对的是个体,即使产生严重后果,也不产生更大危害,所以定为较低级别。

第三,应遵循“先试点后推行”虚假信息分级治理推进思路。监管机关和符合条件的企业可先行开展分级治理试点,对分类分级规范指引、差异化义务设置和分类监管措施的实施效果进行检验,并为后续改进提供参考经验。为确保试点效果,首先要制订详细的试点规划,对测试周期、测试指标、测试结果评价、治理成本、保障机制、监督机制、网络用户权益保护等方面做出全面规定。其次,试点期间对参与试点的生成式人工智能企业、社交平台企业等主体给予特定的监管优待和财政补贴,调动企业参与试点的积极性。最后,要做好试点经验总结工作,对试点过程中的积极成果及时进行总结,将其作为分类分级规范指引、义务规范设置和监管措施调整的依据。

(二)强化虚假信息的源头治理

生成式人工智能对整个虚假信息治理链条的直接冲击体现在信息生产环节,因此,虚假信息治理应强化源头治理才能实现治理效能最大化。而人工智能产生错误信息除受人操纵外,还受其模型算法的局限性、预训练数据质量以及人工标注质量的影响。[21]因此,从根本上遏制虚假信息,除了规范网络用户使用网络行为、运用民法、刑法在事后打击滥用人工智能行为外,还要强化人工智能本身的治理来控制人工智能本身的虚假信息生成和提供。

第一,应对生成式人工智能应用领域设置准入负面清单,暂时禁止其进入如科研、教学、医疗等可能引发高风险的领域。暂时禁止生成式人工智能进入科研、教学、医疗等领域,可以避免其带来的不确定性风险,如避免学生学术诚信的担忧、深度虚假信息生成,也可以避免医学领域过度依赖人工智能可能造成不良预测事件、个人医疗信息泄露等。[22]与此同时,禁止生成式人工智能在这些领域的应用也会阻碍新技术的发展,不利于我国生成式人工智能技术的发展,阻碍科技创新。因此,相比于意大利禁止生成式人工智能ChatGPT应用的政策而言,意大利宣布禁用ChatGPT,限制OpenAI处理本国用户信息,https://www.thepaper.cn/newsDetail_forward_22539065。)我国应该保持政策的弹性,在目前生成式人工智能风险不明的情况下,对其设置准入负面清单,暂时禁止其进入某些领域,待到技术成熟时再全面放开。同时,我国要加大生成式人工智能的研发,不能因此错失生成式人工智能的发展机遇。从目前来看,生成式人工智能的代表ChatGPT在智能回答上已经表现出类人性特征,但因其算法、训练数据及人工标注的原因,其不可能成为知识基础设施,而只是对已有信息进行加工和合成。尽管将其应用在科研领域及教育等领域可能会产生很多难以控制的隐患,如影响认知塑造、科研诚信进而冲击人类的知识根基。但如果将其应用在电商领域以及政务问答等有相对固定模板的领域,则能起到提高生产力的功效,因此应对其应用领域进行限制。

第二,积极利用好算法备案审查制度抓手,通过细化和完善备案审查制度来督促生成式人工智能企业优化算法模型并对明显虚假的信息进行过滤。算法备案是国家机关实施算法治理、推进数字治理现代化的重要抓手。[23]实现虚假信息治理首先要修改算法备案的适用范围,目前算法备案仅对具有舆论属性与社会动员能力的算法适用,目前新出台的《生成式人工智能服务管理暂行办法》也没有规定其他类型的生成式人工智能算法需要备案。因此,首先,将高风险的生成式人工智能类算法纳入其中,算法分级从算法可能引发的风险入手,将个人权益、公共利益与国家安全纳入考虑范围,可以划分为高风险、中风险和低风险算法。参见陈兵,董思琰.分类分级治理算法的基本内涵及实践进路[J].西安财经大学学报,2023,(6):70-79.)不管算法是否具有舆论属性与社会动员能力;其次,细化和扩充备案内容,将是否采取措施对虚假信息进行过滤或者反制以及其实际阻止效果作为审查内容;再次,强化算法备案后的审查力度,并将通过备案审查作为算法投入使用的前置条件,避免备案流于形式。[24]最后,将提交备案审查的材料如虚假信息控制报告、治理承诺书等,将其作为后续追责的依据,如果已经备案的算法模型在后续使用中出现的风险影响范围、反制措施效果与备案内容描述有明显差距,应及时撤销备案并启动备案造假的追责程序,进而强化备案审查的效果。

第三,应积极推动监管机关和人工智能产业协会在充分协商基础上制定可供执行的训练数据质量管理规范,引导人工智能企业提高训练数据的质量,将因训练数据原因导致的虚假信息错误控制在合理范围。在训练数据库的选择上,应要求人工智能企业对该数据库中可能隐含的虚假信息的比例和对模型训练的影响进行整体性评估,如果该数据库虚假信息数据占比过高且会导致虚假信息输出风险极高,就应要求将其排除在训练数据之外。在选定可用于训练的数据库之外,应要求企业采取人工或者技术手段对数据库的虚假信息尽最大可能进行清洗,究竟应达到何种法律强制标准应由监管机关和产业协会进行协商,以保证标准的可行性。监管机关在制定法律强制性之前应该积极与产业协会开展听证会,听取专家学者、产业公司代表的意见。此外,产业协会应积极制定行业标准,在行业标准的基础上建立强制性国家标准,并以国务院部门规章的形式发布。

(三)增强虚假信息的协同治理

生成式人工智能场景下虚假信息生产的影响会传导到整个虚假信息治理链条,因此需要增强不同治理主体之间的协同性来强化治理效能。

第一,应设置监管机关“义务型”责任清单,注重监管机关的力量整合,强化监管机关的协同性,使监管力量得到充分释放,从而营造虚假信息治理的良好外部环境。监管者负有营造遏制虚假信息生态环境的重要责任,必须要通过压实责任和强化协同来营造遏制虚假信息的良好外部环境。首先,应制定监管“义务型”责任清单,倒逼监管机关履行职责。责任的最初内涵是做好分内之事,[25]因此可通过责任清单来明确监管机关的职责。同时责任清单要根据实际情况来进行科学制定,避免难以落地。责任清单应该主要包括生成式类算法机制机理风险性评估、虚假信息检测定期报告、虚假信息处理结果公告等。责任清单应贯徹到监管内容从产生、传播、影响及处理等整个环节。其次,应由对互联网虚假信息治理负有主体责任的网信部门牵头有关监管部门来搭建虚假信息治理协同平台、制定协调行动细则和衔接程序,最好借助已有的电子政务平台来提高协作效率。

第二,应积极应用行业规约、平台管理规约、用户服务协议等软法工具来实现治理义务的细化,使得人工智能企业、社交媒体平台、网络用户有更加可具操作性的行动指南。首先,可应用行业规约工具来将抽象的法律义务细化,将法律义务转化为对人工智能企业、社交平台企业内控制度、治理措施、治理标准等方面的具体要求,为企业在实际运营过程中落实责任提供指引。其次,社交媒体平台应在其平台管理规约落实治理虚假信息的义务,详细规定平台对虚假信息的定义、虚假信息的举报、投诉及处理机制、分级管理措施、违规行为的平台惩戒(如冻结、注销账号等措施)等,将平台的法律义务转化为具体的治理行动。最后,应发挥用户协议对用户的自律约束,将不得利用生成式人工智能生成虚假信息、不得发布和传播未经查证的人工智能生成信息纳入用户协议规定,并规定违反有关规定可能产生的平台惩戒以及法律责任。为确保用户了解有关协议,可采用各种举措,如醒目提示、协议内容考试等手段方法进行提醒。

第三,应建立由监管机关、人工智能产业协会、网络平台行业协会、重点企业代表、有关专家和其他人士组成的虚假信息治理协调机制。虚假信息治理的协同性除了要细化各自职责外,还需要彼此之间信息互通、工作协调、资源共享和良性互动。通过设置协调机制可以及时了解各个主体在虚假信息治理方面的进展、遇到的实际困难以及需要何种配合,进而形成治理主体之间对虚假信息治理的合力,提高对生成式人工智能虚假信息的治理效能。例如,对于虚假信息的重要措施之一就是对人工智能生成信息进行标注,而为了不影响用户使用,人工智能企业添加的标识可能需要利用技术才能加以识别,对此社交平台企业可通过和人工智能企业合作来获取标识的技术原理,以提高对生成消息的识别效率。

四、结语

生成式人工智能改变了传统的信息生产机制而有广阔的应用场景,但其生成虚假信息速度快、逼真度高、无中生有的特征,使得虚假信息风险样态发生了改变,不仅放大了传统的风险隐患,还使得信息信任风险成为虚假信息的重要风险类型,也使得社交媒体平台虚假信息治理防线有被全面突破的风险。尽管如同ChatGPT那般强大的生成式人工智能在我国还没有得到普遍应用,但其引发的虚假信息风险已经显现,而且随着生成式人工智能技术的快速发展将很快成为我国必须面对之问题。对此,既有虚假信息治理体系面临虚假信息数量类型、数量的扩张、信息生成环节治理压力增加、治理主体协同性不强等挑战,因此本文从虚假信息分级治理、源头治理、协同治理方面为应对上述挑战提供了治理对策。但本文提供的对策能否在实践中发挥预期效果还有待在治理实践中根据具体情况进行细化和进一步修正,比如企业如何通过内控制度来具体落实分级治理的要求还需要细化研究。除此之外,治理体系方面的改进只是虚假信息治理效能提升的重要部分而不是全部,因此,虚假信息的治理还需要推进相关反制技术研究的提升。

参考文献:

[1] Paul, Justin, Akiko Ueno, et al. ChatGPT and consumers:benefits, pitfalls and future research agenda[J].International Journal of Consumer Studies,2023,47(4):1213-1225.

[2] Mich, L., Garigliano, R. ChatGPT for e-Tourism: a technological perspective[J]. Inf Technol Tourism, 2023, (25):1-12.

[3] Farrokhnia, Mohammadreza. A SWOT analysis of ChatGPT:implications for educational practice and research[J].Innovations in Education and Teaching International,2023,(5): 1-15.

[4] 冯雨奂.ChatGPT在教育领域的应用价值、潜在伦理风险与治理路径[J].思想理论教育,2023,(4):26-32.

[5] 游俊哲.ChatGPT类生成式人工智能在科研场景中的应用风险与控制措施[J].情报理论与实践,2023,46(6):24-32.

[6] 刘霞.生成式AI或致虚假信息野蛮生长[N].科技日报,2023-06-13(04).

[7] Marsden C,Meyer T,Brown I. Platform values and democratic elections :how can the law regulate digital disinformation?[J]. Computer Law & Security Review,2020,36:105373 .

[8] 舒洪水,彭鹏.ChatGPT场景下虚假信息的法律风险与对策[J].新疆师范大学学报(哲学社会科学版),2023,44(5):124-129.

[9] 罕山.ChatGPT写假新闻,谣言该如何止于“智”者?[EB].https://k.sina.com.cn/article_5328858693_13d9fee4502001mky0.html, 2023-02-18/2023-04-25.

[10] 任文科.ChatGPT有可能搅乱美国大选[EB].https://mp.weixin.qq.com/s/4A8ajTIsmuCw6fKmEsr8Ug,2023-04-24/2023-04-26.

[11] 李志伟.美国实施“隐秘影响行动”炮制虚假信息[N].人民日报,2023-01-17(17).

[12] 吉磊,李大琨.ChatGPT技術潜在的政治安全风险[N].中国社会科学报,2023-03-29(08).

[13] 胡耕硕.被AI造谣找谁算账?澳洲一市长拟起诉ChatGPT诽谤[EB].https://m.mp.oeeee.com/a/BAAFRD00002023041478 4192.html,2023-04-14/2023-04-24.

[14] 腾讯网.又涉嫌造谣!ChatGPT编造法学教授性骚扰[EB].https://new.qq.com/rain/a/20230408A007TI00.html,2023-04-08/2023-04-25.

[15] Cotton, Debby R E, Peter A. Cotton, & J. Reuben Shipway. Chatting and cheating:ensuring academic integrity in the era of ChatGPT[J].Innovations in Education and Teaching International,2023: 1-12.

[16] 陈小燕,任书丽.社交媒体虚假信息的治理:基于平台社会的视角[J].新闻传播,2022,(20):15-17.

[17] 毕文轩.生成式人工智能的风险规制困境及其化解:以ChatGPT的规制为视角[J].比较法研究,2023,(3):155-172.

[18] 王玎.论数据处理者的数据安全保护义务[J].当代法学,2023,37(2):40-49.

[19] 童云峰.证立与提倡:读者个人信息的民法分类分级保护[J].现代情报,2021,41(12):97-106.

[20] 唐要家,唐春晖.网络信息内容治理的平台责任配置研究[J].财经问题研究,2023,(6):59-72.

[21] 莫祖英,盘大清,刘欢,等.信息质量视角下AIGC虚假信息問题及根源分析[J].图书情报知识,2023,40(4):32-40.

[22] 李川,杨胜刚.法益重塑与模式更新:场景化视域下个人信息刑法保护的动态转向[J].广西大学学报(哲学社会科学版),2023,(6):105-117.

[23] 张吉豫.论算法备案制度[J].东方法学,2023,(2):86-98.

[24] 刘艳红.生成式人工智能的三大安全风险及法律规制——以ChatGPT为例[J].东方法学,2023,(4):29-43.

[25] 刘启川.“依清单行政”之辨正[J].法学,2022,(12):52-64.

A Perspective on the Particularity of False Information Risks and Solutions under the Scenario of Generative Artificial Intelligence

Liu Chaomin

(Law School, Ocean University of China, Qingdao 266100, China)

Abstract: Generative artificial intelligence has changed the traditional information production mechanism and has a wide range of applications. However, its characteristics such as fast generation of false information, high fidelity and sheer fabrication of false information not only increase the traditional hidden dangers of false information, but also make information trust risk an important risk type of false information. It also puts the defensive line of social media platforms false information governance at risk of being completely broken through. Therefore, based on the challenge of generative artificial intelligence to the false information governance system, we should promote the hierarchical governance of false information from the aspects of normative basis, classification and deployment of false information. We should strengthen the control of false information source from the aspects of application access, algorithm governance and training data quality management. We should enhance the collaborative governance of false information from the aspects of regulatory coordination, obligation specification and public-private collaboration.

Key words: generative artificial intelligence; false information; classification; source governance; collaborative governance

责任编辑:高 雪

收稿日期:2023-04-19

作者简介:刘超民(1993- ),男,河北乐亭人,中国海洋大学法学院博士研究生,专业方向为网络空间法。

①2022年ll月11日,《互联网信息服务深度合成管理规定》由国家网信办、工信部、公安部联合发布,白2023年1月10日起施行。

②关于发布《网络安全标准实践指南——网络数据安全风险评估实施指引》的通知,https://www.tc260.org.cniupload/2021-12-31/1640948142376022576. pdf.

③危險虚假信息,是指关系国家安全、国民经济命脉、重要民生、重大公共利益等的虚假信息。这里只有涉及国家安全和公共利益的虚假信息才能被归属为危险虚假信息这种最高级别。而且涉及国家安全的虚假信息构成一般危害或者严重危害,才能归属于危险虚假信息,而涉及公共利益的虚假信息只有构成严重危害才能归属于危险虚假信息。这里是为了突出强渊国家安全的重要性。

④国家安全一般危害的参考:①对政治、国土、军事、经济、文化、社会、科技、网络、生态、资源、核安全等构成威胁,影响海外利益、生物、太空、极地、深海、人T智能等重点领域安全;②对本地区、本部门以及相关行业、领域生产、运行和经济利益等造成影响;③引发的级联效应明显,影响范围涉及多个行业、区域或者行业内多个企业,或者影响持续时间长,对行业发展、技术进步和产业生态等造成严重影响。

⑤国家安全严重危害参考:①对政治、国土、军事、经济、文化、社会、科技、网络、生态、资源、核安全等构成严重威胁,严重影响海外利益、生物、太空、极地、深海、人T智能等重点领域安全;②对本地区、本部门以及相关行业、领域的重要骨干企业、关键信息基础设施、重要资源等造成严重影响;③导致对本地区、本部门以及相关行业、领域大范围停工停产、大面积网络与服务瘫痪、大量业务处理能力丧失。

⑥公共利益严重危害参考:波及一个或多个省市的大部分地区,引起社会动荡,对经济建设有极其恶劣的负面影响。

⑦重大虚假信息,是指可能危害国家安全、公共利益的虚假信息。重大虚假信息一般不涉及个人合法权益信息和企业(组织)合法权益,但达到一定规模的有关个人的虚假信息或者基于海量个人信息加工衍生形成的虚假信息,如其非法利用可能危害国家安全、公共利益,也应归属于重大虚假信息。如果虚假信息对国家安全的影响是轻微的,就归属于重大虚假信息,而对公共利益产生一般危害或者轻微危害影响,也归属于重大虚假信息。

⑧国家安全轻微危害参考:①对本地区、本部门以及相关行业、领域生产、运行和经济利益等造成轻微影响;②影响持续时间短,对行业发展、技术进步和产业生态等造成一般影响。

⑨公共利益一般危害参考:波及一个或多个地市的大部分地区引起社会恐慌,对经济建设有重大的负面影响。

⑩公共利益轻微危害参考:波及一个地市或地市以下的部分地区,扰乱社会秩序,对经济建设有一定的负面影响。

⑩一般虚假信息,指的是可能对个人、组织合法权益造成危害,但不会危害国家安全、公共利益的虚假信息。

(12)国家安全无危害参考:对国家安全不造成影响。

⑩公共利益无危害参考:对公共利益不造成影响。

(14)个人合法权益无危害参考:对个人信息合法权益不造成影响,或仅造成微弱影响但可忽略不计。

(15)个人合法权益轻微危害参考:个人信息主体可能会遭受闲扰,但尚可以克服。如付出额外成本、无法使用应提供的服务、造成误解、产生害怕和紧张的情绪、导致较小的生理疾病等。

(16)个人合法权益一般危害参考:个人信息主体可能遭受较大影响,个人信息主体克服难度高,消除影响代价较大。如遭受诈骗、资金被盗用、被银行列入黑名单、信用评分受损、名誉受损、造成歧视、被解雇、被法院传唤、健康状况恶化等。

(17)个人合法权益严重危害参考:个人信息主体可能会遭受重大的、不可消除的、可能无法克服的影响,容易导致白然人的人格尊严受到侵害或者人身、财产安全受到危害。如遭受无法承担的债务、失去T作能力、导致长期的心理或生理疾病、导致死亡等。

⑩组织合法权益无危害参考:对组织合法权益不造成影响,或仅造成微弱影响但不会影响国家安全、公共利益、市场秩序或各项业务的正常开展。

⑩组织合法权益轻微危害参考:可能导致个别诉讼事件,或在某一时间造成部分业务中断,使组织的经济利益、声誉、技术等轻微受损。

(20)组织合法权益一般危害参考:可能导致组织遭到监管部门处罚(包括一段时间内暂停经营资格或业务等),或者影响部分业务无法正常开展的情况,造成较大经济或技术损失,破坏机构声誉。

(21)组织合法权益严重危害参考:可能导致组织遭到监管部门严重处罚(包括取消经营资格、长期暂停相关业务等),或者影响重要/关键业务无法正常开展的情况,造成重大经济或技术损失,严重破坏机构声誉,企业面临破产。

(22)意大利宣布禁用ChatGPT.限制()penAI处理本国用户信息,https://www.thepaper.cn/newsDetail- forward一22539065。