沉浸式剧场实时粒子特效系统研究

——以北京电影学院怀柔校区千人剧场为例

2024-04-12孙扬扬曾志刚

孙扬扬 曾志刚

1.北京电影学院中国电影高新技术研究院,北京 100088 2.北京电影学院影视技术系,北京 100088

1 引言

近年来,随着媒介与技术的创新发展,人们对于视觉艺术的追求也在稳步提升。沉浸式剧场运用先进的技术和创意设计,打破了传统舞台表演的局限性,使观众能够身临其境地沉浸于现实舞台与虚拟空间的融合环境中,因而广泛地被大众所接受。

人机交互旨在应用语音、图像、文本、眼动和触觉等信息进行人与计算机之间的信息交换,主要包含:大数据可视化交互、基于声学场感知的交互、混合现实事物交互、可穿戴交互和人机对话交互。

当下沉浸式剧场与虚拟影像的人机交互技术将成为未来研究与发展的方向。实时粒子特效指的是粒子特效跟随追踪对象的运动而运动,从而达到交互的目的。对于沉浸式剧场而言就是实时产生的粒子特效会跟随舞台上追踪对象的运动变化而产生相应的变化,包括粒子位置变化、粒子触发、粒子效果变换等。实时粒子特效是虚拟空间交互设计中较为普遍存在的一种特效技术,当前在交互展览、互动装置中具有广泛的应用。因此,为了在沉浸式剧场中实现实时粒子特效追踪效果就需要搭建一套与之适配的软硬件集成系统。

2 软硬件系统方案设计与实现

沉浸式剧场实时粒子特效系统方案可以依据功能进行分类,具体可以分为:追踪技术、实时粒子特效制作技术、预演技术和显示技术。通过追踪技术采集舞台上追踪对象的空间位置信息及其运动信息,并对采集数据进行加工处理。实时粒子特效制作技术通过交互设计软件制作实时粒子特效画面。预演技术负责在软件端预演真实舞台呈现效果。显示技术负责采集、管理、分配画面并传输给终端的显示设备。表1为软硬件系统解决方案。

表1 软硬件系统解决方案

追踪技术采用的主要方案包含BlackTrax、Opti-Track、诺亦腾、HTC VIVE、Vicon 等。当前主流的追踪技术采用光学追踪技术,分为有标记点的光学追踪技术和无标记点的光学追踪技术。其中有标记点的光学追踪技术又可分为主动式光学追踪技术和被动式光学追踪技术。主动式光学追踪技术采用的追踪点是本身可以发光的二极管,通过摄像头捕捉发光二极管发射的光线,从而定位追踪点。被动式光学追踪技术使用一些特制的小球作为追踪标记,小球表面存在一层强反光能力物质,使摄像头能够捕捉到小球的运动轨迹。其中BlackTrax 采用主动式光学追踪技术,OptiTrack、诺亦腾、HTC VIVE、Vicon 采用被动式光学追踪技术。

实时粒子特效制作常用的交互设计软件包含TouchDesigner、Notch、Unity 3D、Unreal Engine 等。TouchDesigner 在艺术表演和实时创意设计方面更为灵活,具有较强的交互性和实时可编程性,其节点式编程环境使用户能够自由地控制实时内容的流程和逻辑。Notch 更专注于高质量的视觉效果,应用于专业舞台演出。Unity 3D 和Unreal Engine 可实现游戏领域的画面渲染,兼容影视制作及工业应用。因此,Notch 和TouchDesigner 更适用于艺术表演和实时创意设计,而Unity 3D 和Unreal Engine 更适用于影视制作和游戏开发。

预演系统主要方案包含hecoos、Disguise 等。hecoos 和Disguise 是国内外主流的预演播控软件,用于模拟舞台、灯光、影像的现场效果,预演完整的活动过程,在视频播控、灯光设计和机械控制方面,可以实现设计过程与现场执行的无缝对接,极大提升现场执行效率,在虚拟摄制、大型现场演出、沉浸式装置体验、虚拟直播间等领域实现广泛应用。

显示技术通常采用LED 显示技术和激光投影显示技术。LED 显示技术是主动式发光显示技术,即LED 显示面板上的每颗灯珠主动独立发光,基于空间混色效应实现颜色显示。LED 显示技术具有高亮度、高动态范围、高对比度、寿命长、低功耗等特性。激光投影采用激光光源将影像放大投射到银幕上,经过漫反射进入人眼。相较于传统投影机,激光光源具有高亮度、广色域、低功耗、光源寿命长、稳定性好等特点。

笔者利用现有设备,在北京电影学院怀柔校区千人剧场搭建了一套由BlackTrax 主动式红外追踪系统、3D 舞台设计服务器系统、hecoos 多媒体服务器系统、JSTRON 视频处理器系统和激光投影机显示系统组成的沉浸式剧场实时粒子特效系统解决方案。

图1 为该系统的流程图,其中BlackTrax 主动式红外追踪系统通过红外信号定位追踪对象的空间位置,数据经由局域网传输给3D 舞台设计服务器。在3D 舞台服务器中使用TouchDesigner 软件制作粒子特效,并将特效画面通过局域网传输给hecoos 多媒体服务器。在hecoos 多媒体服务器的hecoos Pro 软件中完成预演与输出管理,JSTRON 视频处理器负责拆分视频画面,最终将画面以投影的形式输出。

图1 实时粒子特效系统图

本文将基于此方案分析沉浸式剧场实时粒子特效系统的关键技术,即基于BlackTrax 的追踪技术、基于TouchDesigner 的实时粒子特效制作技术、基于hecoos的预演技术和基于激光投影的显示技术。

3 追踪系统技术方案

BlackTrax 主动式红外追踪系统是一款实时空间定位系统,能够精确地捕捉舞台上的物体、演员或装置位置、方向角、速度与加速度信息。其设计目的旨在为舞台、演出和活动提供高精度实时定位和追踪解决方案。

3.1 软硬件系统搭建

BlackTrax 主动式红外追踪系统主要包含:Black-Trax 服务器、信标器、红外线缆、红外线感应器、时间同步器、路由器、eSync 2控制器和若干校准工具。

如图2 所示,红外线感应器的作用是捕捉信标器的红外线缆发射的信号并通过网线传输给POE 交换机。POE 交换机将红外线感应器、时间同步器、eSync 2 控制器和路由器传来的数据打包发送给BlackTrax 服务器。其中路由器接收信标器所传输的信息包含连接状态和电池状态。时间同步器与eSync 2 控制器配合使用,用来同步信标器与红外线感应器。

图2 BlackTrax 系统图

BlackTrax 服务器中包含三款软件:BlackTrax GUI、Motive、WYSIWYG。Motive 负责校准实验环境中红外线感应器的位置并管理红外线感应器、捕捉追踪位置信息。BlackTrax GUI 的作用是管理定位信息并将追踪数据传输给第三方系统。WYSIWYG 的作用是管理灯具型号、地址码和追踪区域,从而替代灯光控制台实现灯光追踪。

在完成软硬件系统搭建后,需要校准红外线感应并将定位数据传输给第三方系统。校准的目的是在软件中还原红外线感应器的空间位置,以便定位信标器的空间位置信息。数据通常交由第三方系统进行加工处理,目的是与第三方系统制作的内容进行实时匹配。

3.2 校准

在校准过程中需使用Motive 软件和校准工具,校准工具包含校准棒、手杖电池和地坪校准器。

校准过程分为两步。首先连接好手杖电池与校准棒,在红外线感应器能接收信号的有限空间中挥舞校准棒,使每个红外线感应器能均匀捕捉校准棒的空间位置信息,每个红外线感应器捕捉的数据量至少为20000 个。随后,对捕捉的数据进行运算,应用校准数据就能还原对应红外线感应器的相对位置信息。

之后设置坐标原点,使用的工具是地坪校准器和手杖电池。如图3所示,在舞台中央摆放地坪校准器,以观众席的视角为准,Y 轴方向是舞台后方,X 轴方向是舞台右侧。设定完成后,在Motive 软件中保存校准文件,便完成校准流程。

图3 地坪校准器的放置

3.3 数据传输

数据传输指的是将数据传输到第三方系统,使用BlackTrax GUI 软件实现,具体通过设置输出参数(Output Configuration)、传送追踪对象(Sending Trackables)、输出模块(Output Modules)三个界面的参数实现。

首先,在BlackTrax GUI 的Output Configuration 界面中新建一个输出口。由于传输的是追踪点的位置信息,因此数据传输类型为RTTrPM 协议,NIC 设定为本机的IP 地址,地址设置成接收端的IP 地址,需要保持信号发送端与接收端端口一致。

随后,设置Sending Trackables 参数,在窗口中具有四种类型的追踪对象数据可以传输,即Beacon、Min、Rigid、Soft。Beacon 和Min 指的是信标器的类型,Rigid 和Soft 指的是追踪对象的类型,即刚体与柔体。刚体指的是形状和尺寸在运动和受力状态下保持不变的物体,通常用于描述没有弯曲、拉伸或挤压的物体。因此可以将至少三个红外线缆固定在刚体上,在BlackTrax GUI中将带有线缆的刚体绑定为刚体对象。柔体指的是形状和尺寸随运动或外力的变化而变化的物体,对于柔体的追踪通常需要指定追踪点为框架创建解决方案。分配给柔体的追踪点数量没有限制,对柔体的追踪本质上是对柔体质心的追踪。

最后,需在Output Modules 模式中选择对应数据传输类型,包含LED、质心、方向角、时间戳、速度与加速度。LED 数据即追踪点数据,用来发送单个追踪点的3D 坐标信息。质心数据用于传输刚体的空间位置信息,由于刚体对象是一个至少由三个追踪点形成的空间立体结构,对于刚体对象能获取其6D位姿信息。质心数据通常搭配方向角数据一起使用。方向角数据包含四元数数据与欧拉角数据。四元数数据是一种复杂但更为有效描述旋转的数学工具,它是由一个实部和三个虚部组成的结构体数据,用于表示旋转轴和旋转角度。欧拉角则将物体的旋转分解成三个连续的基本方向旋转,可以拆解成绕X 轴旋转(Roll)、绕Y 轴旋转(Pitch)、绕Z 轴旋转(Yaw)。速度与加速度用来传输追踪对象的速度与加速度数据,需要与LED 或质心数据搭配使用。

4 实时粒子特效制作

TouchDesigner 是一款节点式可视化编程工具,其中包含Comp、Top、Chop、Sop、Dat、Mat 六大类型的基本元件和功能丰富的集成插件。TouchDesigner 具有丰富的软硬件接口支持,其支持的硬件设备包含Kinect 体感设备、LeapMotion 体感控制器、激光雷达、Arduino 智能硬件设备等交互设备。其支持的传输协议包括DMX 协议、OSC 协议、MIDI 协议、NDI 协议等,通过这些协议能传输灯光控制信号、音视频信号、空间位置信息等。

使用TouchDesigner 实现实时粒子特效制作的过程主要分为两步,第一步是传输协议的转换,第二步是粒子特效的设计。

4.1 协议转换

在特效制作过程中需要处理两次传输协议的转换。第一次是将BlackTrax GUI 传输来的RTTrPM 协议转换成OSC 协议,第二次是将制作完成的粒子特效以NDI协议传输给hecoos多媒体服务器。

4.1.1 RTTrPM 协议

BlackTrax GUI 传输的追踪协议具有两款,分别是实时跟踪协议-照明(RTTrPL)和实时跟踪协议-运动(RTTrPM)。RTTrPL 协议主要用于灯光追踪,传输的数据包中包含灯具的域、通道及通道值的相关信息。其本质上是将空间坐标信息转化成灯具的Pan 或Tilt 通道的数值,从而达到灯光追踪的目的。RTTrPM 协议用来处理运动追踪,传输的数据包中包含运动物体的位姿数据,包括LED、质心、方向角、时间戳、速度与加速度。RTTrPM 协议是一种网络传输协议,既能使用TCP 的方式传输也能使用UDP 的方式传输。考虑到数据传输的实时性,通常使用UDP的方式进行数据传输。

4.1.2 OSC 协议

OSC(Open Sound Control)协议即开放式声音控制,是一种网络传输协议,采用UDP 方式进行网络传输。OSC 协议要求信息发送设备与接收设备处于同一局域网中,并且监听同一个端口信号。OSC 协议最初是为音频服务的,音频控制器OSC 协议能更好地控制音频设备。随着技术的发展,OSC 协议的用途越来越广泛,不仅可以用于控制视频设备、灯光系统、动作捕捉设备,还可用于发送命令、控制参数、传输实时数据等。

4.1.3 NDI协议

NDI(Network Device Interface)协议即网络设备接口协议,旨在实现高质量、低延迟的实时视频、音频和元数据的网络传输与共享。NDI 协议在2015 年发布,提供免费开源的软件开发工具包(Software Development Kit,SDK)。NDI 协议能传输视频信号、音频信号、TALLY 信号(用于指示视频切换器中信号状态的灯光)以及控制方案,其采用高效的编码技术,高清信号压缩比约为15∶1,延迟能够控制在100ms以内。目前广泛用于直播、会议、视频制作、医疗、教育等领域。

4.1.4 OSC 信号处理

由于BlackTrax GUI 传输的是RTTrPM 协议,因此需要使用BlackTrax 官方提供的Python 代码将其转换成OSC 协议。在TouchDesigner 中创建OSC In 元件,通过调整OSC In 元件参数面板的接收端口并激活该元件,就能获取局域网中对应端口发送的OSC信号。图4是对OSC 信号处理的流程,该流程实现拆解OSC 数据,并对捕捉到的数据进行一定变换从而实现与运动对象的匹配。流程中,创建Select 元件拆解OSC 元件中的数据,添加Math 元件将数据进行一定的变换,并将数据传输给Null 元件。Null 元件是一个特殊的节点,本身不执行任何操作。Null 节点的作用类似于连接器,用于连接和组织网络节点。

图4 OSC 信号处理节点流程图

4.2 粒子特效设计流程

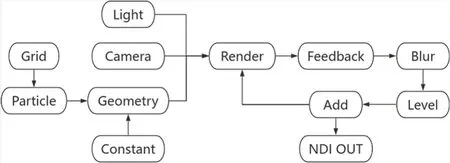

图5 为本次实验粒子特效设计的节点流程图。Grid 元件划定区域,Particle 元件产生粒子,将Null 元件当作Grid 元件参数的引用,从而将追踪位置传输给粒子。通过渲染“四元件”:Light 元件、Camera 元件、Geometry 元件、Constant 元件输出给Render 元件,由Render 元件实时渲染输出,其中Light 元件负责灯光设置,Camera 元件负责搭建相机视角,Geometry 元件存放各种需要渲染的对象,Constant 元件负责贴上材质信息,经过这样操作便能产生粒子特效。由于粒子具有生命周期,因此要产生连续粒子追踪效果就需要循环“四元件”,Feedback 元件开启循环,Blur 元件添加模糊,Level 元件调整亮度,Add 元件负责将当前画面叠加回Feedback 元件达到循环目的。最后添加NDI OUT 元件将粒子特效画面传输给hecoos 多媒体服务器系统。

图5 TouchDesigner 节点流程图

5 预演与显示系统技术方案

预演与显示系统包含hecoos 多媒体服务器、JSTRON 视频处理器和多台激光投影机(图6)。其中hecoos 多媒体服务器中的hecoos Pro 软件负责舞台的预演、投影机的控制与软件端的输出管理。JSTRON视频处理器负责裁切视频信号,由于投影机数量较多,需要通过hecoos Pro 软件与JSTRON 视频处理器进行输出控制与管理,从而实现端到端的映射。

图6 预演与显示系统图

hecoos Pro 是一款实时预演现场的全案设计创作软件,能完成项目技术方案的设计、舞台的搭建、效果的预演,并输出给对应的投影机、音响设备、LED 屏幕、灯具和舞台机械装置。设计师可以在软件中模拟真实投影机的光路设计和画面畸变,从而完成具体模型的3D 映射效果和光路设计。

北京电影学院怀柔校区千人剧场使用的hecoos多媒体服务器搭载i9-10900K 处理器、RTX6000 显卡和64G 内存,具有强大的编解码能力和渲染输出能力。hecoos 多媒体服务器具备6 个DP1.2 接口,最大支持4K 分辨率输出,支持最多10 路高清NDI 网络采集,支持最多4 路SDI 接口的4K 采集卡采集视频信号。

如图7 所示,千人剧场搭建了一套由11 台固定安装的激光投影机和5 台流动激光投影机组成的投影系统,投影机的标准分辨率为1920×1200,而hecoos 多媒体服务器最多支持6 路DP 输出,因此需要通过视频处理器,将一路输入信号裁切成多路输出信号。

图7 投影机点位布局图

视频处理器是一种专门处理数字视频信号的设备,具有分割屏幕、拼接屏幕、自定义EDID、混合矩阵、自定义横纵向排布等功能。EDID(Extended Display Identification Data)即扩展显示识别数据,通过EDID 显示设备可以向计算机发送自身的技术规格、支持的分辨率、频率范围和色彩特性等信息。EDID提供了一种标准化的方式,用于确保计算机与显示设备之间能够有效交换显示配置信息,从而实现最佳的显示效果与兼容性。

千人剧场采用4 台JSTRON LVP9000-D 视频处理器,每台视频处理器具有2 路输入和4 路输出。2路输入分别支持DP1.2 标准和DP1.1 标准,能接收超高清(UHD)信号,最大支持3840×2400 无损分割。4路输出支持DVI 1.0 标准,最大输出分辨率为1920×1200。

5.1 输出管理

输出管理是将hecoos 多媒体服务器的4 路DP 输出,通过视频处理器的分割屏幕功能拆解成16 路DVI 输出,从而匹配整个沉浸式剧场的16 台激光投影机。首先需要调整视频处理器的输入设置,通过EDID 功能将画面修改为3840×2400。视频处理器的输入信号就是hecoos 多媒体服务器的输出信号,设置完成后就能在hecoos Pro 软件输出管理界面的添加本机显示中识别到该屏幕。在hecoos Pro 中通过切片功能将4路虚拟屏画面拼接成一路输出画面,在视频处理器的输出时序中完成分辨率调整,在拼接设置中实现将一路输入信号裁切成4 路输出信号。完成上述设置,就能实现投影画面软硬件端的匹配。

5.2 效果展示与评价

本次实验使用12 个红外线感应器,在舞台上搭建了一个4m×6m×3m 的追踪空间。追踪对象手持信标器与红外线缆,在追踪空间中运动。在BlackTrax GUI 中激活对应的信标器后,就能将数据传输给TouchDesigner。传输的数据类型为Beacon,即被追踪对象的3D 坐标信息。通过在hecoos Pro 的媒体面板中添加NDI 信号采集,将采集到的媒体信号放入时间线,选择对应的映射,输出到虚拟屏中。由于在之前已经完成输出管理即虚拟屏到真实投影机输出画面之间的映射,当前只需要在菜单栏中打开所有显示,就能将画面传输给对应的投影机打出。最后回到TouchDesigner 中修改Math 元件的参数,使投射出的粒子特效能完美匹配追踪对象的运动。

图8 展示的是本次实验中实时粒子特效效果,投影机打出的粒子特效画面随着舞台上追踪对象运动而运动。追踪对象在舞台中完成慢跑、急停、下蹲、上跳等动作时,粒子特效可实时反馈。整套系统可根据具体剧目创作需求,实现灵活修改与软硬件设施拓展。通过修改红外线感应器的数量与安装位置设定追踪对象的活动范围,通过增加追踪范围内信标器与红外线缆的数量,实现道具、演员与装置的多样化追踪;通过修改数据传输类型合理设计追踪效果方案,通过修改粒子特效的设计呈现不同的视觉感受,通过投影画面的选择、拼接与匹配,可实现更加沉浸的效果。因此应合理地应用沉浸式剧场实时粒子特效系统,给观众带来更加沉浸的视听盛宴。

图8 实时粒子特效效果展示图

6 结语

本文基于北京电影学院怀柔校区千人剧场,搭建了一套沉浸式剧场实时粒子特效系统,实现了粒子特效与追踪对象运动的匹配,目前已实现多追踪对象的实时追踪和多投影机的投影特效。但由于TouchDesinger 软件的限制,无法做到实时特效的触发,需借由游戏引擎的蓝图功能,进行相关功能的补充并提升可控性。未来随着空间定位技术与交互技术的不断发展,更多的特效形式与交互方案会应用到沉浸式剧场中,从而实现更加真实的虚拟影像交互效果,将为沉浸式剧场的内容创作带来更多的可能性。❖