科研仪器平台评价体系的比较研究

2024-03-20王肖波李锦钰

王肖波,穆 超,李锦钰

(1.中国科学院西北生态环境资源研究院,甘肃 兰州 730000;2.中国科学院近代物理研究所,甘肃 兰州 730000)

0 引言

党的二十大报告指出,应在完善科技创新体系方面优化配置创新资源,提升国家创新体系整体效能。大型科研仪器等创新资源是国家创新体系的重要组成部分,也是科技创新活动的重要基础保障[1-2]。中国高校和科研院所已建超过10万台套原值不低于50万元的大型科研仪器,其中超过80%组织了科研仪器平台以集约化管理运行科研仪器[3]。 《国务院关于国家重大科研基础设施和大型科研仪器向社会开放的意见》 (以下简称 《意见》)发布后,各有关部门和管理单位加快推进科研仪器开放共享[2-4],于2018年起开展科研仪器平台运行管理评价工作。在当前常态化考评阶段,对不同评价方式进行比较研究,有助于建构科学合理的评价体系,为后续优化升级提供标靶,进一步发挥科技评价的效用。

近年来,科研仪器平台的持续稳定运行已成为科技管理的重要研究内容,侧重于效益或效率的科研仪器平台运行评价体系也成为研究热点[5-7]。同时,科研仪器开放共享运行的年度考评结果在科学技术部网站上公布[8],受到社会各界广泛关注。但评价只是手段,目标仍是提升开放共享水平,为强化国家创新体系整体效能提供服务[4]。检验既有平台评价体系的优点和不足,识别考评工作中的属性指标及其关联效应,有助于深入了解科研仪器平台运行的使命要求,进一步提升管理和共享应用水平,为科研仪器平台运行要素的配置和优化路径的定制提供科学依据,对于推动创新资源优化配置与科技创新体系建设深度融合、推进科技体系创新发展改革和全面建设社会主义现代化科技强国都具有现实意义。

1 文献综述

随着科技投入持续增加,科技资源集聚效应带来的规模化、集约化和多样化特征,要求科研仪器平台既要体现功能的基础性、创新性和公益性,也要符合技术服务的精准性、有效性和可及性的更高标准。科技创新活动的综合性和复杂性,也要求平台组织能够衔接不同的创新服务需求和相应的创新资源。事实上,科研仪器平台可归结为从资源经济价值到文化知识价值的桥梁,抑或从科技资源投入到服务产品输出的功能链[9-10]。面向科研仪器平台运行的各类评价,或可理解为基于这种功能链整合不同利益攸关方的偏好,进而整体性地处理效益和效率问题[11]。

当前主流的效率研究方法有DEA和SFA,前者无需考虑模型的参数问题而更受学者欢迎。数据包络分析 (Data Envelopment Analysis,DEA)是大量基准研究中用于评估组织效率并区分一组给定组织相对效率的常用方法,比如,基于对外服务情况和科技资源管理单位规模现状表征资源的配置和共享效率[6,12]。开放共享只是科研仪器平台运行的目标之一,效率评价还应关注支撑科研人员创新产出的情况,也即成效。基于组织执行和目标导向层面区分的两阶段DEA效率评价进一步细分了平台管理和支撑服务两个阶段的运行水平[11],进而选取决策单元整体、子阶段和交叉效率及超效率值,可用于重要性或有效性的排序,实现评价分级的目标[13]。

效益评价还具有多维特征,从符合性和诊断性的视角选择绩效指标,量化 “做得如何”的标定问题[7,14]。例如,按前述 《意见》要求设计的4个方面18条具体指标的绩效评价体系[15]。将DEA整合到平衡记分卡法[16],也满足效益评价的基本需求。遵循通用性和可操作性原则,将量化绩效指标融入平衡记分卡模型,可兼顾多维度评价的目标[17-18]。此外,以平台服务能力评价为目标,有助于还原运行的过程及其根本性特征[19]。在组织运行的战略和实践中嵌入可持续性,已成为当下运行管理必然面对的挑战[20]。应对越来越激烈的竞争环境,整合可持续的效益评价,既要求构建一套可开展广泛应用的指标评价体系,也旨在明确可持续发展战略的重点[21]。然而,受限于评价主体的立场,效率评价诸如DEA方法总是自我评估的有效性检验[13]。同时,从平台本身出发的效益评价也缺失用户需求视角的反馈和建议[22-23]。相反,可持续绩效评价模型指出,相较于只是降低自身收费标准,用户导向的发展策略可能更有助于运行绩效的改善[21]。因此,将用户满意度作为解释评价结果的预测指标将有益于理解科研仪器平台运行的实际情况。

综上所述,现有研究在科研仪器平台运行机制和评价方面丰富了知识,但仍存在一些不足。首先,没有通过系统性研究还原科研仪器平台的运行过程,识别影响运行效率和效益的属性指标,量化相互作用关系,提升运行绩效,发挥评价效用。其次,当前的工作主要依据研究方法的假设,未能提供一组通用的权重来表示决策者的偏好结构,致使无法开展大范围的应用。最后,甚少对得到的评价结果进行平行检验和比较研究,明确不同评价方式的优点和不足,以便促进评价工作的改善与提升。因此,基于科研仪器平台的功能链和组成要素及其相关性,结合文献分析、实践经验和专家意见等多元信息反馈,识别科研仪器平台卓越运行的关键要素,进而借助结构方程模型解析开放共享评价考核结果可能的逻辑内涵,以便更好地发挥评价考核的作用,为科研仪器平台的高效运行提供科学依据,也可为仪器平台持续提升原动力和竞争力助力。

2 科研仪器平台绩效评价方法与数据采集

2.1 数据来源

本文以中国科学院所属各研究院所建设的科研仪器平台为研究对象,中国科学院自2007年开展科研仪器平台建设[1],目前已建成超过90家平台。在科学技术部牵头组织的2019年度中央级高校和科研院所重大基础设施和大型科研仪器开放共享考评工作中,共有344家法人单位参评[24]。中国科学院所属单位有99家平台参与,其中评优的为38家,优秀比例为38.4%,远超15.1%的全国优秀率,占全部52家优秀单位的73.1%。

中国科学院运行模式可作为当前阶段科研仪器平台运行管理的标杆[11]。进入 “择优”序列的科研仪器平台 (所级公共技术中心)应按年度向主管部门递交上一年度工作报告,并接受运行效果的评价。互评工作资料显示有85家平台参与2019 年度运行评价,其中82家参与2019年科学技术部组织的考评。同时,主管部门组织的函评工作邀请了15位技术支撑体系建设和运行资深专家,给出一组百分制评分结果。从科学技术部网站查阅这些所级中心的最终排名和评级结果[24],获得一组可对比的管理部门评价集。

经与上述平台负责人代表磋商,并在中国科学院主管部门的指导下,从参评的85家单位年度工作报告中整理获得39条量化指标。一级层面可分为技术队伍、平台建设、运行效果及财务状况四个方面。以技术队伍为例,属性指标包括在职人数、项目聘用人数、正高级专业技术岗位 (正高)人数、副高级专业技术岗位 (副高)人数、高级人员比例、队伍结构合理性评分、专职管理人数及平台负责人的领导作为等。

2.2 年度考核指标、效益评价体系和效率计算模型

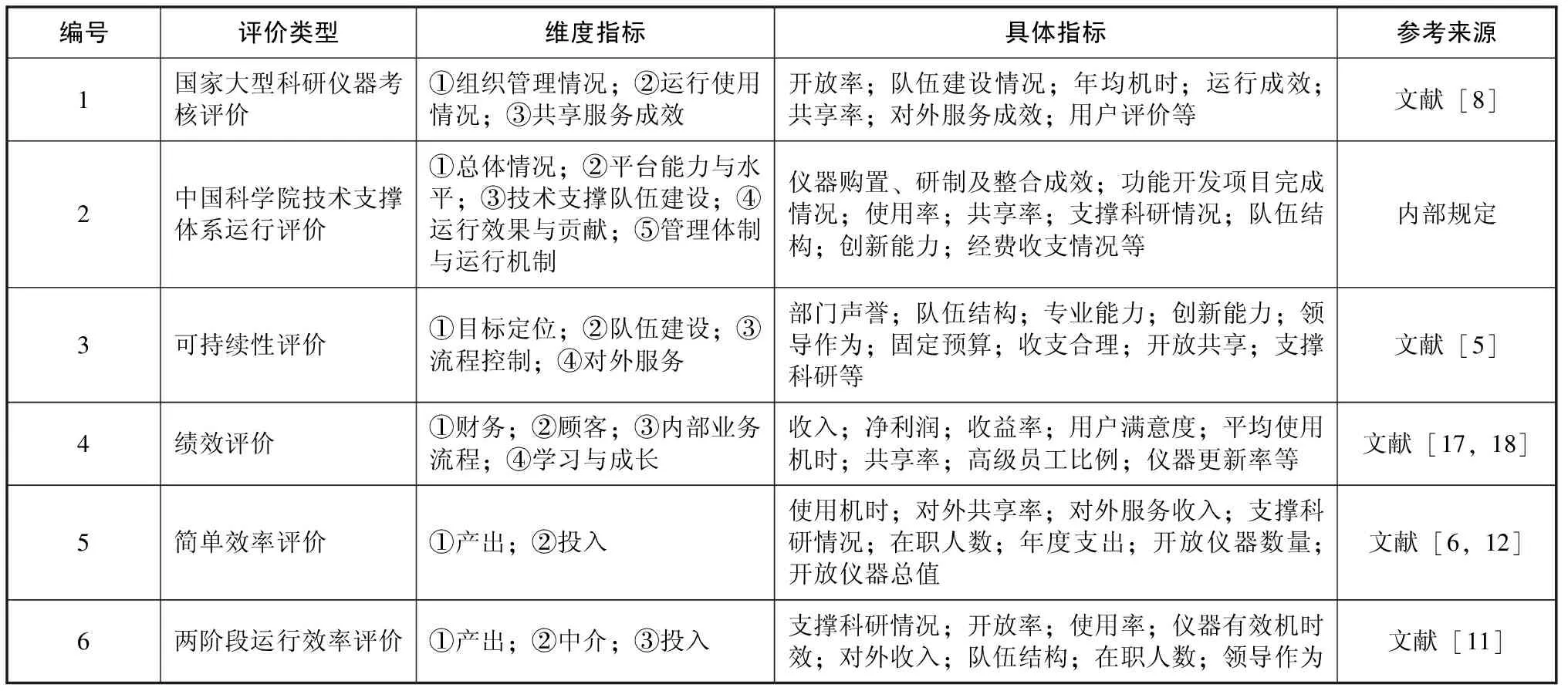

科研仪器平台主管部门实施的年度运行考核有据可依。其中,2019 年科学技术部考核评价的指标体系一级指标包括组织管理、运行使用和服务成效三个方面,在2022年以管理法规公开发布[11]。中国科学院技术支撑体系建设与运行也有一套指标评价体系,分别从总体情况 (10%)、平台能力与水平 (20%)、技术队伍 (25%)、运行效果与贡献 (25%)和体制机制 (15%)五个方面评价,评价体系见表1。

在效益评价体系方面,文献综述提及的可持续性评价框架和平衡记分卡方法都基于层次分析模型设计,通常需要根据实际情况计算特定的指标权重[5,18]。简单起见,对科研仪器平台可持续性评价模型中的20个指标和组织绩效评价体系中的16个指标分别予以相同的权重处理。在可持续性评价模型代入16个现有属性指标,以5聚类数为其中13个指标赋分,其余指标全部给定满分的方式计算得分。在绩效评价体系中代入14个现有属性指标,同样以5聚类数为其中的11个指标赋分,其余指标则给定满分计算对应的评价结果。

此外,表1所示的简单效率评价借助DEAP 2.1软件,设定4个产出指标、4个投入指标,以产出导向和规模报酬可变进行计算[6]。使用率和共享率与其他投入指标的相关性及同向性较差,故选择使用机时和对外共享率替换,以提高可信度。结果显示有18个决策单元达到了综合效率有效,能区分不同评价对象的效率水平,故不再以超效率模型深入区分。两阶段运行效率评价的计算同样存在相关性不足和同向性问题,经研判以对外共享率代替开放率产出指标,有效使用机时代替使用率中介指标,副高人数代替队伍结构,日常运行支出代替领导作为投入指标。借助MaxDEA Ultra软件,设定两个节点,分别按3投入3产出和3投入2产出模型计算运行和产出两个阶段的效率值,并以两阶段效率的乘积作为最终评价结果。

表1 科研仪器平台现有评价体系

2.3 冗余分析和结构方程模型

遵循简约性原则,将39个定量指标输入Canoco5软件中检验预测变量的弓形效应 (arch effect),以6种评价体系产出结果为结果变量,并通过排除多重共线性和较低贡献度的预测变量精简分析模型[25]。39个变量的因子分析揭示超过4个组成部分的影响,直接代入约束排序必然导致可解释性水平降低。因此,在预处理中按变量相关性和变量贡献度删除共线性变量7个。然后,通过非约束性排序分析计算32个指标解释度和贡献度,剔除指示性小于整体平均值的变量,最终筛选出17个最具信息性的变量,见表2。这种正向逐步选择分析也评估了预测变量与评价结果间特征值的差异,以确定指标数据集中是否删除了错误变量或删除了过多变量。表2同时列出了科研仪器平台2018年度的平均量化水平,其中,使用率的计算是依据某个科研仪器平台总计的仪器使用机时除以仪器总数,再除以标准化的年度工作机时1600小时获得。共享机时是指扣除最大使用机时用户外其余人员的使用机时,外部共享机时则是提供外部用户使用的机时数,共享率等于共享机时除以有效使用机时。比如,2019年开放共享考评结果显示,平均有效使用机时为1440小时,对外服务机时240小时。对应地,使用率为90%,对外共享率为16.7%。用户满意率是由各平台自行联系用户评定的值,仪器有效机时率是指使用机时数占开机机时的比率。

对效率和效益评价得到的结果可通过聚类方法进行不同级别的分划,比如K-mean聚类处理的分类结果显著,则说明评价结果可用于评定优秀、良好和合格的区别。以不同评级对科研仪器平台编组,不同组别对应属性指标的异质性检验采用Kolmogorov-Smirnov方法,借助IBM SPSS Statistics 22软件计算。对影响科研仪器平台得分高低的属性指标则可借助回归模型进行拟合验证,但对不同指标因子及其相互之间作用的强弱关系,需要在结构方程模型中进行逐一比较验算。借助MPLUS 8软件[26]的BOOTSTRAP方法,以从低到

高逐一排除显著性大于0.05的指标进行模型拟合,最终取拟合信息相比最好的结果进行解释。

3 实证分析

3.1 不同评价体系的冗余分析

为了深度挖掘信息,基于2019年开放共享考评结果给出的排名,归一化后作为不同科研仪器平台的得分结果,均值为0.679。同时,中国科学院主管部门的评价结果去掉最高最低评分后取平均分,最高分为91.4,最低分为71.6,平均分为83.2。简单效率评价方式的最大值为1.000,最小值为0.232,平均效率为0.722。两阶段效率评价的平均效率为0.351,最大值为1,最小为0.048。可持续性评价方式最大值为77.9,最小值为58.0,平均得分为65.9。绩效评价方式的平均得分为41.1,最高分59.6,最低分28.3。

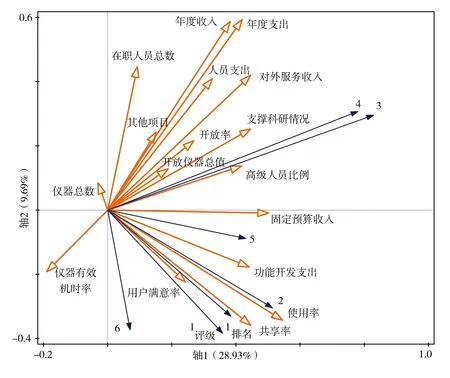

根据表2中属性指标正向选择结果,选择约束性标准分析方法,可得到不同评价结果与属性指标的相关关系结果。模型提取四个维度的总计解释方差为54.8%,且所有轴的显著性水平为0.002,表明分析结果可信。图1选择冗余分析结果前两个解释维度作为坐标系进行绘制。其中,实线箭头的数字代表表1中不同评价方法对应的评价结果,空心箭头表示贡献度较大的属性指标。箭头之间的夹角指示变量之间的相关关系,夹角越接近直角则表明相关性越小。箭头的长度则分别表明属性指标的解释度和评价结果的被解释度。

表2 科研仪器平台属性指标的描述性统计与交互式正向选择模型结果 (n=85)

图1表明科学技术部和中国科学院评价结果的相关性较高,意味着管理部门对科研仪器平台的评价基本一致。其中,利用科学技术部评级结果和用排名标准化值计算的结果基本相近,说明平台之间确实存在等级层次差别,故当前排名具有实际意义,在一定程度上表明科研仪器平台对相关工作的落实不均衡,部分平台存在统筹管理不到位和开放共享不充分的问题[3]。3号和4号实线箭头代表的绩效评价结果与管理部门评价结果的夹角偏向正交关系,表明结果之间仅呈现较低程度的相关性,说明以综合指标评价体系开展的绩效评价结果与研究期管理部门评价结果存在偏离。效率评价结果与管理部门的结果相关性较高,说明研究期的管理部门开放共享评价考核倾向于效率评价。

不同的预测指标也展现出与不同评价方式之间明显的相关趋势,比如,使用率和共享率指标与1号和2号评价结果呈现高度相关性,说明可作为这类评价主要的预测指标。用户满意率与1 号和2 号评价结果呈现高度相关性,固定预算收入也支持2号评价结果。3号和4号评价结果则倾向于对外服务收入、开放仪器总值、副高人数及功能开发支出等指标。开放率和支撑科研情况为5号和6号评价结果的主要产出指标,因此两者与其相关性较高。表现异常的指标主要为仪器总数、领导作为和仪器有效机时率,前两者与3号和4号评价结果呈显著负相关,说明对绩效水平存在较明显的负面作用。总之,图1表明不同指标在不同评价方式中的效用不同,为不同评价体系之间的比较研究明确了前提。

图1 科研仪器平台运行评价结果冗余分析

3.2 不同评价体系的应用比较

中国科学院主管部门评分4聚类结果的聚类中心依次为84.5、74.7、89.2和80.4,显著性p<0.001,可将对应评级良好、较差、优秀和合格赋予各评级对象。以表1中3号和5号评价体系的结果为例,将4类评级结果作为多样本K-S检验的分组信息,对科研仪器平台的属性指标进行分析,得到如表3所示的结果。可知,在职人数、年度收入和仪器总值等规模指标确非管理部门关注的重点,但效率和效益评价模型都将其作为主要考察指标。相反,在管理部门重点关注的使用率和共享率指标方面,效率和效益评价并不能准确辨识,说明文献研究的指标体系容易因涉及的评价内容过多而失去针对性。

表3 科研仪器平台部分属性指标的多样本K-S检验 (n=85)

在当前发展阶段,基于现有理论提出指标体系仍存在一定的适用性问题。相较于DEA和可持续性评价模型,科学技术部组织的开放共享考核评价结果中,关注的属性指标存在显著性差异的,只有使用率和外部共享率。但这并不说明其余指标一定不重要,可能是因为在中国科学院范围内的科研仪器平台其余属性指标之间整体差异性小,

而无法在现有分级情况下进行识别。在中国科学院的运行评价中,判定不同运行水平的平台之间获得的固定预算与功能开发支出有所不同,这反映了定期评估和择优支持的管理体制所带来的优势,也体现了中国科学院建设综合型科研仪器平台的策略。同时,从开机机时到使用机时,再到共享机时和外部服务机时等指标,不同运行水平的平台也都存在差别,指明仪器利用在平台运行中重中之重的地位。

3.3 专家评价结果的内涵研究

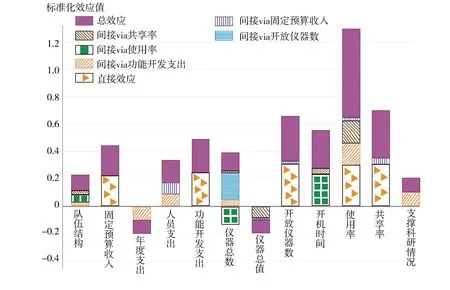

在MPLUS软件中以反向逐一剔除拟合结构模型,得到5个中国科学院运行评价得分的直接解释变量,包括开放仪器数、固定预算收入、功能开发支出、使用率和共享率。进而对这些属性指标分别拟合解释结构模型,然后纳入多路径因果分析,来计算不同属性指标的直接和间接影响效应。图2所示的结构模型参数表明当前建模具有较好的解释度。在主管部门评价中,对最终评分产生显著影响的还包括规模体量方面队伍结构、仪器总数、仪器总值和开放仪器数,财务方面是年度支出、人员支出。模型通过BOOTSTRAP的95%置信区间检验,且变量间基本不存在共线性问题。此时,年度支出和开机时间对功能开发支出产生负面作用,仪器总数和仪器总值分别对使用率和共享率有负面作用,使用率、共享率及功能开发支出等指标也有多路径的影响作用。

图2 科研仪器平台属性指标对主管部门评价结果的直接或间接影响

计算模型标准化效应值,得到图3所示结果。在中国科学院主管部门评价中,使用率的作用最大,标准化效应值为0.649,其次是共享率0.351,再次为开放仪器数0.329,三者占全部正向效应50%以上,其余属性指标的标准化效应值都小于0.3。仪器总值和年度支出产生较小的负面作用,标准化效应值分别为-0.097和-0.099,说明仪器总值所代表的运行规模在一定程度上降低了共享率,年度支出则限制了用于功能开发支出产生的效用,但仪器总数和开放仪器数作为规模指标在一定程度上对评价结果产生了加分作用。另一方面,属性指标的间接作用标准化效应值之和为1.113,占全部正向效应值的46.3%,说明产生间接效应的属性指标也具有不可忽视的作用。

图3 中国科学院科研仪器平台运行评价结果的属性指标标准化效应

同理,将结果变量替换为科学技术部2019 年度开放共享考核评价结果,可得到类似的结构模型。模型拟合χ2值为63.429,df为56,p=0.23。模型的RMSEA值为0.040、SRMR值为0.042、CFI和TLI分别为0.986和0.980,表明模型具有较好的解释度。可知,科学技术部运行评价主要关注仪器方面如开放仪器价值、开机时间、使用率和共享率,人员和财务方面兼顾队伍结构、年度收入、人员支出和功能开发支出。说明不同管理部门之间的评价结果虽然存在一定相关性,但关注的属性指标及作用强度间存在较大差异。故图1所示相似性的前提是二者相对于效益和效率评价的排序结果。通过计算属性指标的标准化效应值,可得图4所示结果。由图4可见,开放仪器价值、开机时间、使用率和共享率等开放共享属性指标是获得更好评级的重要指标,且相互之间存在较复杂的调控作用。年度收入是较显著的直接负面影响指标,说明在平台开放共享评价中经费规模对评价结果产生了减分作用。但人员支出的量化作用却很重要,仅次于使用率,成为第二贡献度指标,说明在科学技术部的评价中,技术人员队伍建设受到较高程度的关注。但在公开结果中没有直接体现,且两者相反的影响方向也说明相较于正高级职称人员对技术队伍人才的提升,副高级职称人员及其他人员的构成比例更有利于促进平台发展。正高人员通过年度收入、使用率和共享率对评价结果产生负面间接影响,这意味着正高人员虽有助于平台提升收入规模,但一定程度上限制仪器的使用率和共享率。此外,功能开发支出从人才培养、创新投入及仪器改造视角验证了技术队伍建设对评价结果的裨益。总之,仪器运行的总效应值达到1.064,是科研仪器平台运行的重点,而人员相关指标绝对效应总值为0.853,也占相对较高的比重。

图4 科研仪器平台属性指标对科学技术部开放共享考评结果影响的标准化效应

4 结论与启示

尽管关注的科研仪器平台属性指标相似,但不同评价体系的结果存在显著差异。研究期效率模型与专家评价的结果相关,但前者将投入指标作为负面特征,且借助投入产出比获得的效率有别于平台仪器自身的使用率和共享率等特征,两者存在本质区别。效益评价则充分将科研仪器平台运行仪器的最终服务成效当作评价目标,且对相关指标的赋权不同,导致与前两者结果都存在偏离。专家评价中,科学技术部的工作重点关注科研仪器平台集约化管理的仪器设备开放率、使用率和共享率,兼顾平台运管的技术人才队伍建设和稳定。相比这种面向全国科研院校的应用,中国科学院的评价工作则进一步激励迈向持续性和竞争性的发展目标。

基于管理部门目前常态化的开放共享考核评价结果,采用多种评价体系对科研仪器平台运行开展比较研究,不仅可为平台高效稳定运行提供优化路径和客观依据,也可为相关科技评价体系的合理性检验提供参考。在后续评价应用中,应首先明确评价目标,而后选择适宜的方法,进而定制关键指标,才能做到有的放矢。另一方面,评价工作中面向对象的选择也应根据不同的基础条件、组织模式以及发展水平,分类别和阶段开展,以加强实际的可比性和可操作性。此外,评价体系应准确识别优势和症结。正如科研仪器平台的运行是一个系统性过程,同时区分优劣对应的属性指标,有益于充分发挥科技评价工作的效用,为评价对象的优化升级提供标靶。