基于AHRFaultSegNet 深度学习网络的地震数据断层自动识别

2024-01-01李克李文韬窦一民朱信源阳致煊

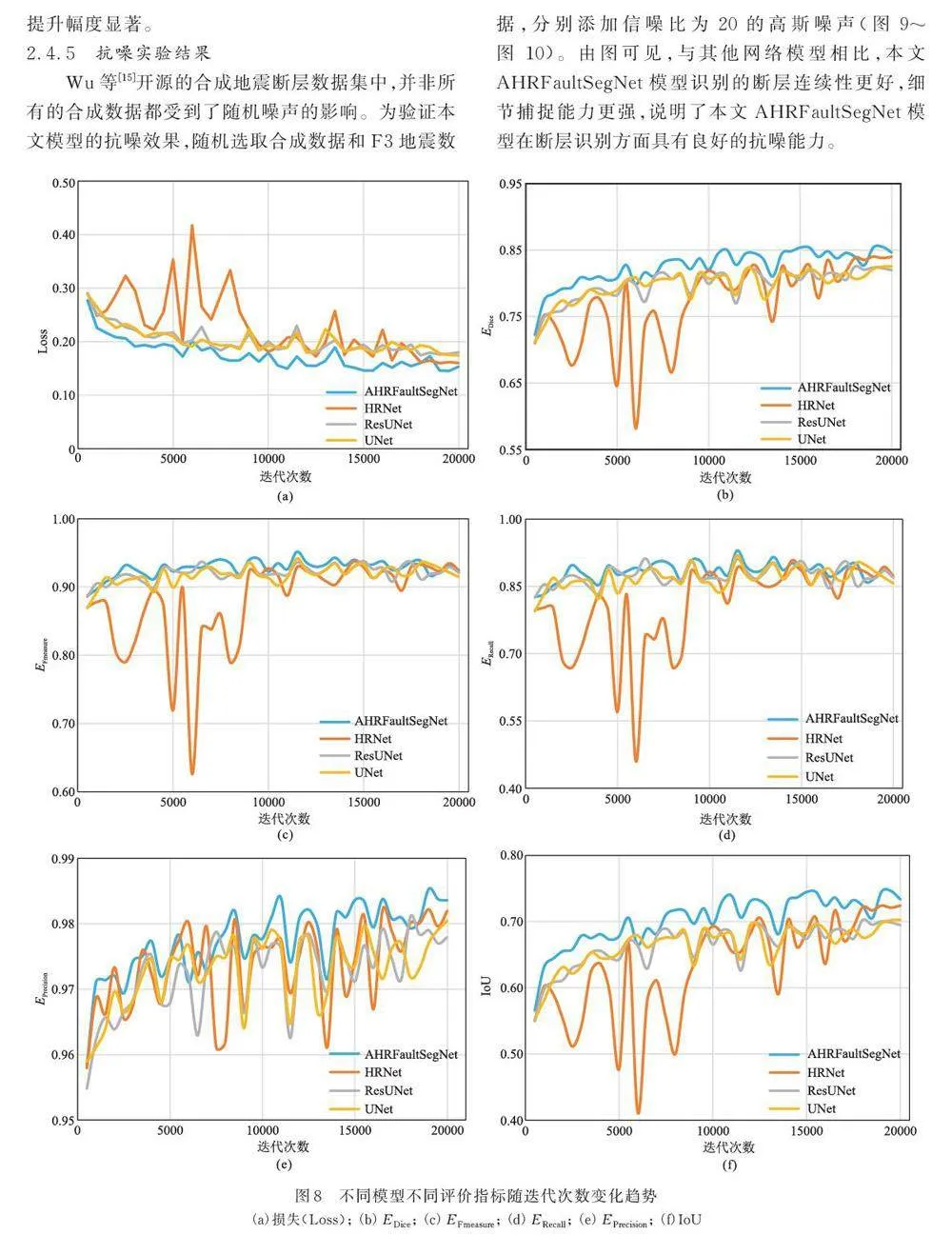

摘要: 断层识别是地震数据解释的重要环节之一。深度学习技术的发展有效提高了断层自动识别的效率和准确性。然而,目前在断层的自动识别任务中,如何准确捕捉断层细微结构并有效抵抗噪声干扰仍然是一个具有挑战性的问题。为此,在HRNet 网络的基础上,构建了一种基于解耦自注意力机制的高分辨率断层识别网络模型AHRFaultSegNet。对于自注意力机制解耦,结合空间注意力和通道注意力,代替HRNet 中并行传播的卷积层,在减少传统自注意力机制计算量的同时,模型可以在全局范围内计算输入特征的相关性,更准确地建模非局部特征; 对解耦自注意力使用残差连接来保留原始特征,在加速模型训练的同时,使模型能够更好地保持细节信息。实验结果表明,所提出的网络模型在Dice、Fmeasure、IoU、Precision、Recall 等性能评价指标上均优于其他常见的断层自动识别网络模型。通过对合成地震数据与实际地震数据等进行测试,证明了该方法对断层细微结构具有良好的识别效果并且具有良好的抗噪能力。

关键词: 断层检测识别,深度学习,解耦自注意力机制,残差连接

中图分类号:P631 文献标识码:A DOI:10. 13810/j. cnki. issn. 1000‐7210. 2024. 06. 004

0 引言

断层识别是地震数据解释的重要环节之一,它是通过分析地震数据确定断层位置和形态的过程。断层识别通常要求地震资料具有较高的分辨率[1],特别是在揭示地下断层中的微小特征和连续性差的复杂结构方面,这对于地震危险性评估和地质资源勘探至关重要[2‐3]。实际地震资料在采集过程中易受到噪声的干扰,这就要求断层识别方法具有良好的抗噪声能力[4‐5]。

传统的断层识别方法通常依赖于人工解译,耗时且容易受到主观因素的影响。针对断层识别中存在的问题,学者们提出例如相干体技术[6‐7]、方差体技术[8]、边缘检测技术[9]、断层似然性技术[10]和全三维解释技术[11]等断层自动识别方法。这些方法提高了断层识别的精度,但存在着计算过程繁琐、运算速度相对较慢、易受到噪声等非地质因素的影响等缺陷。

近年来,利用人工智能技术自动、快速、准确地识别断层成为了地球物理勘探领域的热点之一。Huang 等[12]将卷积神经网络(CNN)用于地质特征分析,利用多种地震属性作为特征对断层进行自动识别。Xiong 等[13]利用相干体作为断层标签数据,训练CNN 模型,模型的预测结果与应用相干体技术预测断层结果相似,但精度并未明显提高。Guo 等[14]将三维地震数据切片的二维数据和人工标注的标签数据作为CNN 模型的输入,提高了自动识别断层的效率,但是模型受限于人工标注标签的准确性。Wu等[15]提出了一种基于U‐Net 网络的三维地震数据断层识别方法,三维地震数据驱动的方法大幅度提高了模型的预测精度和效率。杨午阳等[16]将残差模块引入U‐Net,提出了基于ResU‐Net 的三维地震数据断层识别方法,进一步提高了模型预测结果的准确率。Cunha 等[17]将迁移学习用于断层识别,对训练好的卷积神经网络进行改进,提高了断层识别的效率和准确性,但是对复杂地区细微构造的识别仍较困难。Yang 等[18]利用U‐Net++ 提取三维地震数据的断层特征,对断层进行自动检测,但是具有较大的计算复杂度。Gao 等[19]提出了一种多尺度注意力卷积神经网络(MACNN),使生成的断层图像具有更高的分辨率和保真度,但是由于注意力机制的计算难以并行化,训练和推理速度受限。

尽管利用深度学习检测断层技术已取得了较大的进展,但是在实际地震资料应用过程中还存在着构造复杂地区断层细微结构识别困难、现有模型对噪声的抗干扰能力较差的问题。为此,本文构建了一种基于注意力机制的高分辨率断层识别网络模型(Attention based High ‐ Resolution Fault SegmentationModel,AHRFaultSegNet),实现对地震数据断层快速、准确地自动识别。该模型主要对HRNet[20]中并行传播的卷积层进行改进,用解耦自注意力代替传统的卷积层,在减少传统自注意力机制计算量的同时,对噪声进行筛选和压制,从而更准确地建模非局部特征; 同时,使用残差连接保留原始特征,加速模型训练的同时,使模型能够更好地保持细节信息。最后,通过数据实验测试本文方法的有效性,以期为地震勘探提供一种更为精确且高效的断层识别方法。

1 AHRFaultSegNet 网络模型

1. 1 解耦自注意力

对于三维地震数据,传统的自注意力机制中大量的矩阵计算带来非常高的计算复杂度。目前常用的办法就是对自注意力计算进行解耦[21]。本文改进传统的自注意力模块,对空间和通道进行了注意力解耦,提出了解耦自注意力模块(Decoupled Self‐Attention)。

1. 1. 1 解耦查询和键

传统的自注意力机制将查询和键作为具有相同维度的线性变换结果。然而,这种处理方式可能导致查询和键之间的冗余信息,增加了计算复杂度并可能降低建模效果。解耦自注意力模块通过使用不同的线性变换处理查询和键,即分别对它们应用独立的线性变换,可以减少冗余信息,提高建模效果,并降低计算复杂度。

如图1 所示,通过三个不同的自注意力权重矩阵f ( x )、g ( x ) 和h ( x ) 计算得到查询向量Q、值向量V 和键向量K。分别用不同的卷积核对各向量进行两次卷积,其中查询向量Q 通过卷积后对空间维度进行全局池化( GAP1 ) 得到向量QS; 键向量K 通过卷积后对通道维度进行全局池化( GAP2 ) 得到向量K C。QP、K P 是Q、K 分别进行卷积后的结果向量。V P0 、V P1分别是值向量通过不同卷积核卷积后的结果向量。

利用局部化的卷积和池化操作分别得到向量QS 和向量K C,利用它们分别代替传统注意力机制中的查询向量Q 和键向量K,实现了计算注意力时对空间和通道维度的解耦处理。这在减少计算量的同时,使注意力机制只关注特定维度的相关信息,避免了不同维度间的冗余交互。另外,通过不同层次的特征融合,使模型能够更好地捕捉不同尺度下的特征,提高了建模的精度。