基于视觉数据融合和机器学习算法的在役桥梁病害智能检测方法

2023-12-27赵琳

赵琳

(上海市建筑科学研究院有限公司,上海 201108)

随着城市化建设的不断推进,我国在役桥梁保有量已经处于世界领先水平,这些在役桥梁经过长时间的使用必然会出现各种损伤问题,比如裂缝、腐蚀、风化、脱落、露筋等,所以需要定期进行安全检测和保养维护。传统检测方法依靠人工,不仅检测时间长、速度慢、准确率低,还存在不少安全隐患[1,2],所以改进在役桥梁病害检测方法是亟须解决的重要问题。

新的研究方向主要集中在使用机器人等进行在役桥梁图像采集,结合计算机视觉技术对病害图像进行分类、识别,从而实现快速、高效、低成本在役桥梁病害智能检测。韩晓健等采用了计算机视觉的检测方法,通过训练神经网络AlexNet,建立了在役桥梁病害智能检测模型,可以快速准确地识别病害[3]。邹俊志等改良了YOLO v3基本网络模型,在检测层增加了两个分支,即空间金字塔池化以及SE注意力机制,将桥梁病害数据集用K-means算法聚类,得出病害检测结果[4]。上述两种方法不能解决多病害的分类检测问题,导致误检和漏检现象时有发生,同时检测结果的准确性和效率也有待提高。

近年来无人机以其快速方便、经济高效的特点被广泛应用于在役桥梁病害检测领域。相对于人工检测和机器人巡检的缓慢低效,无人机可以快速轻便地到达二者无法到达的区域进行拍摄,同时还可以降低检测成本,是非常经济实用的一种探测设备[5-7]。

由此,本文利用无人机探测数据,设计基于视觉数据融合和机器学习算法的在役桥梁病害智能检测方法,测试结果表明该方法能够准确采集和定位在役桥梁图像,实现多病害的精细化智能检测。

1 在役桥梁病害智能检测

1.1 雷达与视觉数据融合的无人机高清图像采集与定位

1.1.1 无人机探测设备

由于在役桥梁病害检测普遍存在结构复杂、规模较大、病害类型多以及检测难度高的情况,如何精准找到病害位置是利用无人机解决在役桥梁病害检测的关键[8],因此在无人机的设备选择上需要满足以下几个条件:

(1)飞行性能稳定且续航能力强,能够进行长时间的飞行检测工作。

(2)搭载可自由旋转的云台和高清相机,可以实现上下左右多方向的高清图像采集。

(3)携带测距雷达,可以准确测量周围障碍物的距离。

(4)具有精准的GPS定位导航、位置控制和自动躲避障碍物的功能,可以实现在复杂桥梁结构中安全灵活飞行。

(5)在桥梁底部接收不到GPS信号时,可以自动悬停或返航。

根据以上条件选择合适的无人机探测设备,采集在役桥梁病害位置图像,应用于后续病害检测中。

1.1.2 雷达与视觉数据融合的在役桥梁图像采集

为了保证在役桥梁病害的实际位置与无人机采集图像中的病害区域位置一致,需要将雷达扫描的数据与无人机高清相机采集的视觉数据进行融合,实现准确定位[9]。雷达与视觉数据融合包括两个方面:空间融合和时间融合。

(1)空间融合

由于相机和雷达安装的位置与角度是不同的,所以雷达与视觉数据的空间融合主要是实现雷达与相机坐标系的统一。

本文以激光雷达为例,其坐标系O1X1Y1Z1与激光雷达中心一致,扫描采集的点云数据以该中心为圆点向外呈圆形分布。相机坐标系OCXCYCZC同样与相机中心统一,是采集高清图像数据的位置坐标。将激光雷达坐标系与相机坐标系实行联合标定,即为两种设备的空间数据融合。二者之间的转换关系如下:

(1)

式中,(xc,yc,zc)为采集图像数据的位置坐标;(x1,y1,z1)为激光雷达扫描点云数据坐标;两个坐标系的相对转移矩阵和旋转矩阵分别用T和R表示。

在激光雷达点云数据集内,3D点云b=(x1,y1,z1)在转换过的相机坐标系中的投影位置a表达式如下:

(2)

激光雷达的点云数据通过公式(2)进行坐标转换,即可投影到相机采集的高清图像上。

(2)时间融合

由于雷达和相机各自按照不同的时间标准进行数据采集,而且频率不同,采集到的数据存在时间差异,并不是统一时刻的数据。因此二者采集的数据在时间上达到同步,即雷达数据与视觉数据的时间融合。

为了使视觉数据与雷达数据达到时间同步,需要以扫描频率更低的雷达扫描时间为标准,对应调整相机的采集频率,每次雷达在扫描的同时启动相机进行一次图像采集。

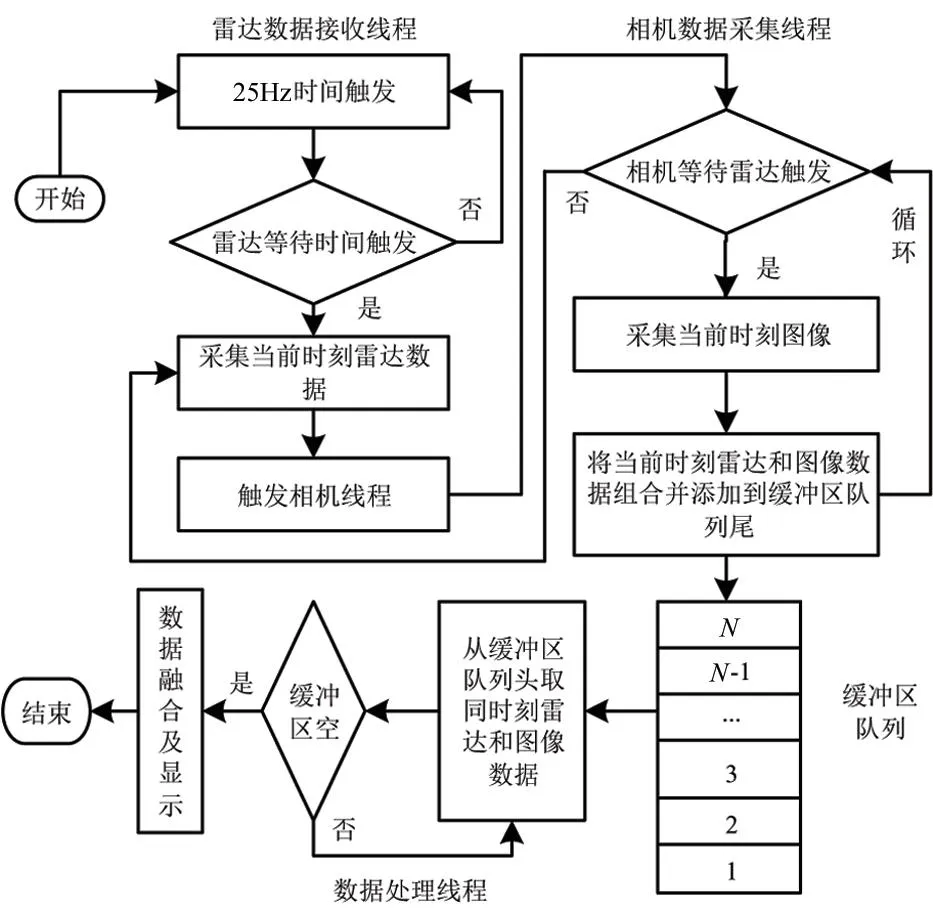

在无人机雷达与相机数据的采集和处理上使用三线程同时进行的方法,具体过程如图1所示。

图1 时间融合过程示意图

如图1所示,雷达在进行扫描时,每一次启动都会采集当下时刻的雷达数据,按照25Hz时间启动雷达数据接收线程;同步启动相机数据采集线程,雷达数据线程进入阻塞等待状态,直到下一次启动时间。一直处于阻塞状态的相机数据采集线程,等待雷达数据接收线程启动后,采集当下时间的图像,将当前图像数据和雷达数据按顺序排列并添加到缓冲区队列尾部;相机线程再次进入阻塞状态,直到下一次雷达触发。一直处于循环运行状态的数据处理线程,在缓冲区头部获取前两个线程的统一时间数据,完成雷达和视觉数据的时间融合。

1.1.3 在役桥梁高清图像定位

为了根据采集和融合的在役桥梁图像有效识别病害,需要掌握采集图像的位置信息,对无人机采集的在役桥梁图像进行定位。

(1)确定无人机的拍摄距离

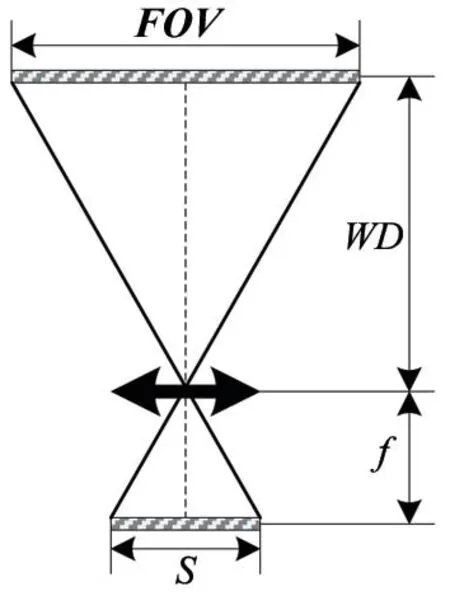

在无人机高清图像采集过程中,为了获取大小相同、符合精度要求的在役桥梁图像,需要在图像采集之前进行拍摄距离WD的运算。设定无人机视觉传感平台达到摄像距离时进行主动拍摄,这样获得的在役桥梁高清图像才能够有效识别病害的详细信息[10]。符合要求的拍摄距离依据成像系统的简化模型运算,如图2所示。

图2中,图像传感器的尺寸用S表示;镜头焦距、图像拍摄距离和相机坐标系视场坐标向量分别用f、WD和FOV(xc,yc,zc)表示;则三者之间的关系如下式:

(3)

由拍摄目标最小特征尺寸lmin、代表最小特征的像素数Pmin以及传感器分辨率Rmin决定FOV(xc,yc,zc)的大小,因此图像工作距离求解公式为:

(4)

根据图像工作距离获取在役桥梁图像位置。

图2 成像系统简化模型

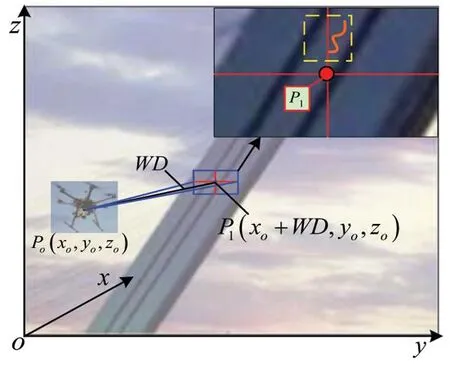

(2)获取在役桥梁图像位置

为了对无人机采集的在役桥梁图像进行定位,必须准确掌握该图像对应在役桥梁的详细位置。假设无人机拍摄的图像位于桥塔部位,则建立一个与桥塔立面平行的坐标系。由于无人机搭载了GPS定位系统,所以对在役桥梁进行图像采集时可以随时得到自身的位置坐标Po(xo,yo,zo),该坐标信息会在采集的图像当中同步显示。则采集到的图像中心坐标为P1(xo+WD,yo,zo),即在役桥梁图像的具体位置,其原理如图3所示。

图3 在役桥梁图像定位

1.2 基于Mask R-CNN的在役桥梁病害检测模型

1.2.1 Mask R-CNN工作原理

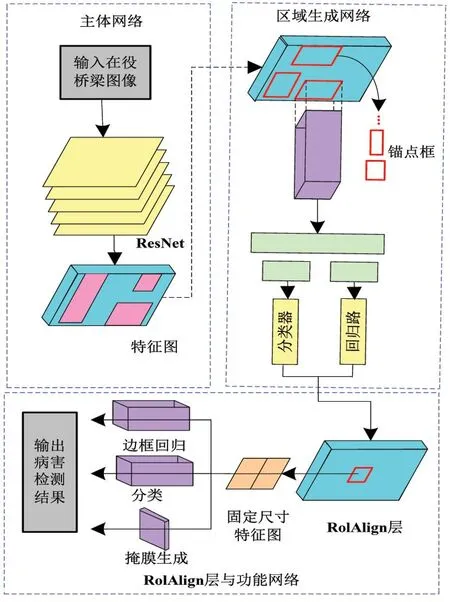

Mask R-CNN(Mask Region Convolutional Neural Network)是一个组合型神经网络,其改良了之前的Faster R-CNN网络[11-13]。将1.1.3小节获取的在役桥梁图像输入到网络中进行检测训练,同时增加一个预测分割分支,将在役桥梁病害检测和语义分割结合起来,从而达到实例分割的效果,最终输出病害图像识别结果。

Mask R-CNN分为三个部分,其结构用图4表示。

(1)主体网络

主体网络包括金字塔特征网络和残差网络。提取在役桥梁图像特征信息,通过这两种网络结构组合实现[14]。

(2)区域生成网络

RPN(Region Proposal Network,RPN)是Faster-RCNN网络用于提取锚点框(Anchor Boxes)的部分,RPN优化了其原有的性能局限,引入卷积神经网络,通过提取特征实现锚点框和置信度的生成[15]。

(3)RoIAlign层与功能网络

RoIAlign(Region of Interest Align,RoIAlign)是一种区域特征聚集方法,采用双线性插值法映射特征图,准确匹配各个像素的空间对应关系,从而提升检测模型的准确性。

图4 Mask R-CNN结构示意图

1.2.2 Mask R-CNN有监督训练

为了准确识别在役桥梁病害,需要事先筹备训练图像,对Mask R-CNN网络进行有监督训练,从而构建一个在役桥梁病害检测模型。采用已有桥梁病害图像作为训练样本,利用训练图像样本对Mask R-CNN网络进行迁移学习训练,调整训练参数,得出最优的在役桥梁病害检测模型。

基于迁移学习算法中的动态学习率调整策略提升模型检测的准确率,公式如下:

(5)

<1),且各件产品是否为不合格品相互独立.

由此通过动态学习率训练优化检测模型,得出最优的在役桥梁病害检测模型。

为了加强在役桥梁病害检测模型的泛化能力,需要对数据集中的图像采用随机噪声消除技术进行数据增强。

随机噪声可通过消噪掩模法进行消除,用h(x,y)描述像素点(x,y)的滤波系数。依次逐点移动掩模是消噪掩模法的基本原理。滤波器掩模尺寸为m×n,线性滤波公式为:

(6)

公式中,a=(m-1)/2,且b=(n-1)/2。w表示像素权值。(s,t)表示滤波掩膜范围。

由此通过消噪掩模法的滤波处理方法将图像中所有像素的值替换为相邻范围内像素的权值,实现数据降噪增强功能。

将滤波增强后的无人机采集在役桥梁高清图像数据输入在役桥梁病害检测模型中,即可实现各种桥梁病害在图像中的分类和识别。

2 实验分析

2.1 实验环境设置

本文实验选择某大桥作为检测对象,主桥为双独塔、双索面、钢筋混凝土斜拉桥,全长1038 m,桥面有效宽度为26 m,塔高105 m,主跨186 m。

测试无人机选用四旋翼无人机,型号为大疆PHANTOM 4 RTK,相机选用1英寸2000万像素的CMOS传感器,搭载PIX-hawk飞控、GPS定位系统、激光测距雷达以及视觉传感平台Guidance等。

无人机根据天气、风速、温度等环境情况制定好拍摄计划和巡航路线,在航拍过程中为了达到安全避险和精度达标的目的,将有效拍摄距离控制在8.5m左右,航拍范围选择整个塔面,由塔顶向塔底顺序拍摄在役桥梁的高清图像,图像重叠率设置在50%,耗时12 h一共采集579张有效图像,作为测试样本。

本文采用公开的桥梁病害数据集COncrete DEfect BRidge I Mage Dataset中的1200张图像作为训练样本,其中包含六种桥梁图像类别,包括裂缝、脱落、露筋、风化、腐蚀五种病害图像以及无病害图像。

2.2 激光雷达与视觉数据融合定位实验

本文根据张正友标定算法进行相机和激光雷达的联合标定,使用2D黑白棋盘格标靶图像作为标定板,制作20张不同方位和角度的标定板图像,输入MATLAB工具箱进行标定,计算出相机与激光雷达之间的转换关系矩阵。

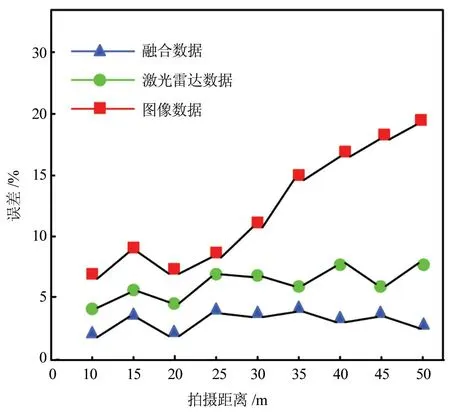

实验在大桥的桥塔、桥面、桥墩和在役桥梁底部分别选择25个不同的病害点和不同的拍摄距离,分别进行无人机高清图像采集和实际位置测量。然后将相机与激光雷达数据融合后进行转换得出的病害位置与实际测量的病害位置进行匹配,计算定位误差。对比相机图像位置和激光雷达位置的定位误差,其统计结果如图5所示。

图5 定位误差

实验结果表明,与单纯使用激光雷达定位数据或相机拍摄数据的定位误差相比,融合雷达与视觉数据对在役桥梁病害的定位数据与实际位置之间的误差最小,低于5%,可以更加准确地定位在役桥梁病害的位置。

2.3 病害图像检测效果对比

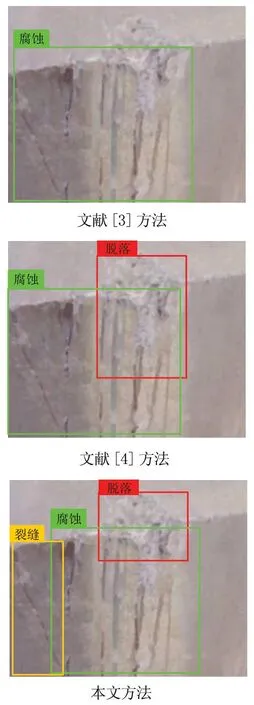

在实际采集的在役桥梁病害高清图像中,任意选择两张进行对比实验,采用的对比方法是文献[3]的计算机视觉检测方法、文献[4]的YOLO v3检测方法。本文方法、文献[3]方法、文献[4]方法的检测结果分别用图6描述。

分析图6(a)可得,文献[3]方法将图像最左侧的裂缝误检为腐蚀,并且未检测出脱落病害;文献[4]方法识别出了腐蚀和脱落两种病害,但同样误将裂缝识别为腐蚀,未识别出裂缝灾害。而本文方法能够精准检测出裂缝、腐蚀和脱落三种病害;分析图6(b)可得,文献[3]方法只能检测出单一的脱落病害;文献[4]方法检测出了露筋病害,并将脱落病害误识别为露筋病害,未检测出脱落病害;而本文方法可以详细的检测出脱落病害中包含的露筋病害。

(a)病害检测一

(a)病害检测二

实验结果表明,本文方法对在役桥梁病害图像的检测比文献[3]方法、文献[4]方法更加细致准确,明显减少对目标病害的误检和漏检,实现一图多病害的精细化检测,具有更好的检测效果。

2.4 不同类型病害检测效果

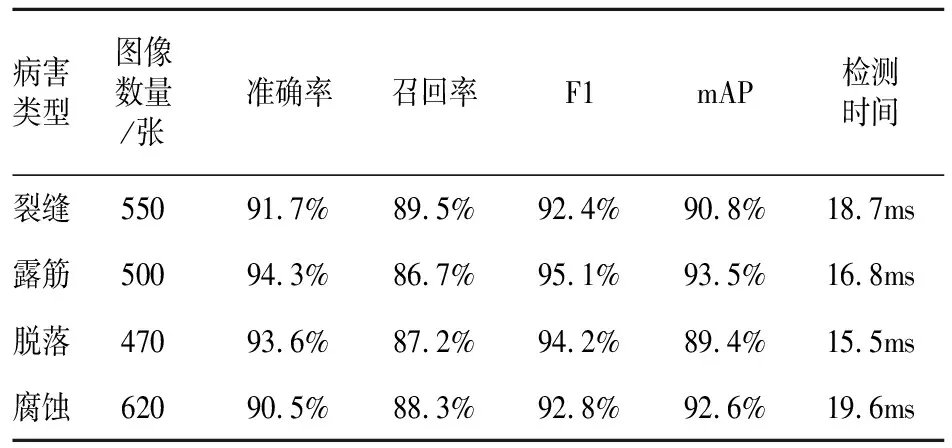

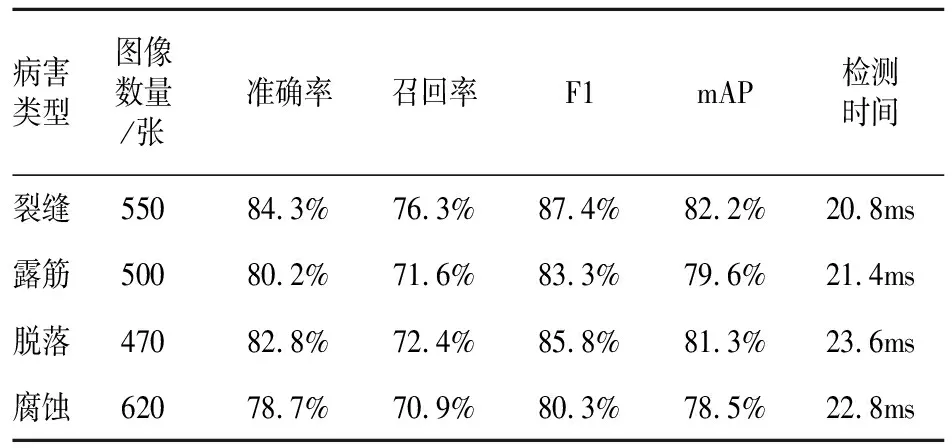

在役桥梁病害分为很多不同种类,本文选用裂缝、露筋、脱落、腐蚀四种常见病害进行实验。本文实验的评估指标使用准确率、召回率、mAP(Mean Average Precision)和F1。召回率是指识别出的病害图像与实际存在病害数量的百分比,mAP是在役桥梁病害检测模型的平均精度均值,F1是准确率和召回率的调和平均数。在相同条件下同时采用本文方法、文献[3]方法、文献[4]方法进行各种病害图像的检测,三种方法的检测结果如表1、表2、表3所示:

表1 本文方法病害检测结果

表2 文献[3]方法病害检测结果

表3 文献[4]方法病害检测结果

对比表1、表2、表3可以看出,使用本文方法进行在役桥梁病害检测,针对裂缝、露筋、脱落、腐蚀四种病害检测的准确率都达到90.5%以上,召回率都达到86.7%以上,在役桥梁病害检测模型的平均精度均值达到89.4%以上,检测时间最低可以缩短到15.5ms。而其他两种方法的准确率、召回率、平均精度均值均低于本文方法的检测结果,且检测时间高于本文方法,均在20ms以上。

3 结 论

本文方法使用雷达与视觉数据融合的无人机航拍技术进行在役桥梁病害的高清图像采集和定位。构建基于Mask R-CNN神经网络的在役桥梁病害检测模型,实现对在役桥梁各种病害的智能检测。实验结果表明,本文方法对在役桥梁各种类型的病害检测都具有良好的适应性,准确率和召回率都较高,检测速度快,在病害图像检测方面更加细致准确,减少了误检和漏检的情况,实现一图多病害的精细化识别,具有非常好的检测效果。