集成数据预处理技术及其在机器学习算法中的应用

2023-12-13郭旗

郭旗

(首都经济贸易大学管理工程学院,北京 100070)

随着计算机技术和人工智能的飞速发展,各个领域的数据激增,数据量呈现出爆炸性增长的趋势。这种快速增长的数据量对于计算机技术的发展提出了严峻的挑战,同时也为数据科学家和工程师们提供了更多的机遇和挑战。为了更好地利用这些数据,需要不断地开发新的技术和算法,以便从这些庞大的数据集中提取出有价值的信息和见解。但是目前所接触的数据存在着信息量大、信息冗余、价值隐性等特点,为后续机器学习建模带来了不少困扰。基于其统计特性[1],数据预处理方法在提升模型性能方面发挥着重要作用,特别是在大数据的背景下。更重要的是,处理大数据的过程中,应该关注数据处理的各个方面,包括噪声数据的处理、类别不平衡数据的处理及特征选择方法等,从多层次出发全方位地关注整个数据预处理过程,并不断优化数据处理的各个部分,使其适应多种数据集的需要。

中国已成为全球最大的互联网市场,这些数据在加速推动着中国的数字经济和人工智能技术的发展,并且正在对全球的计算机科学和数据分析领域产生着深远的影响。特别是2022 年习近平总书记在党的二十大上所做的报告中提出了建设数字中国的战略目标,包括加快数字基础设施建设、加强数据资源保护、推动数字经济发展等。基于此,本文从数据预处理的角度出发,结合其在机器学习算法中的应用,探讨数据预处理技术的重要性。

1 数据预处理技术的研究现状

为了给机器学习模型输入整齐、有用的数据,整个数据预处理的过程包含数据清洗过程、类别不平衡数据处理过程、特征选择过程等方面。

1.1 数据清洗

在数据清洗过程中,重复值、缺失值、噪声数据的处理构成了3 个重要的方面,具体如下:①重复值的处理。对于数据集中出现的重复值,如重复订单、重复客户信息、重复出行数据等,可以对重复值进行去重处理[2],采用保留其在数据集中唯一值的方法进行数据预处理。②缺失值的处理。对于缺失值,目前有2 种处理方法。一种方法是对无用数据的缺失而言,且缺失数据占总数据量比例较少,在确保删除缺失值对于分析结果没有影响的前提下,往往采用删除的方式对数据集进行处理;另一种方法是对缺失数据进行填充,在缺失数据量较高或者数据价值较高的情况下,选择某种替代值对缺失数据进行填充,能够在很大程度上对原有数据进行还原。③噪声数据的处理。由于数据集中的噪声数据与其他数据间存在较大的偏差,为此要以某种标准对这些噪声数据进行剔除处理[3]。一般来说,通过使用基于统计的异常值检测方法,如计算数据的平均数和标准差,可以有效地检测出离群值。

1.2 类别不平衡数据处理

对于类别不平衡数据的处理,一般采用某种采样方法增加数据集中少数类实例或者减少多数类实例已达到数据集中不同类别数据的相对平衡。过采样方法是类别不平衡数据预处理技术中最常用的方法,通过按照某种标准增加新的少数类实例以达到类间相对平衡的效果,从而实现原始偏态数据的再平衡[4];欠采样方法则相反,是通过删除多数类实例的数目来达到类间分布的平衡。大多数人使用过采样方法,因为欠采样方法容易丢失重要的样本信息且其分类结果不稳定。然而,一些研究人员通过改进和调整欠采样方法,仍然能够获得良好的分类结果[5]。

1.3 特征选择方法

高维度的数据集为分类预测任务增加了难度,当将维度过多的数据输入到机器模型算法中进行学习和预测时,分类器无法对其中的特征进行有效处理。因此,特征选择方法的运用在数据预处理过程中很有必要,其目标是选择更多相关的特征。

特征选择研究于20 世纪60 年代初就已经开始,当时的研究主要集中于统计学方面的问题,而且由于数据量较少,涉及的特征也较少。20 世纪90 年代以来,随着数据量的膨胀和机器学习模型的发展与应用,迫切需要一个综合性能较好的特征选择算法。文献[6]将特征选择方法和遗传算法进行结合,并将其应用于短时强降水和非强降水预报中,发现特征选择方法能够将预测准确率分别提升8.66%和1.05%。

2 集成数据预处理技术

2.1 数据清洗

本文选择删除空缺值和重复值、去除偏离平均值3 倍标准差以上数据的方法来对数据进行清洗。

2.2 类别不平衡数据的处理

过采样和欠采样是不平衡数据预处理的2 种主要方法。其中过采样(Synthetic Minority Oversampling Technique,SMOTE)算法[7]的思想是分析少数类样本,根据少数类样本人工合成新样本,并将其添加到数据集中。

假设:首先,对于少数类中的每个样本x,使用欧几里得距离来计算从它到少数类样本集中所有样本的距离,并得到它的k个最近邻居;然后,根据样本不平衡率来确定采样率N,对于每个少数类样本x,从其k个最近邻居中随机选择n个样本;最后,根据等式xnew=x+rand(0,1)×(x-xn),在原始样本之间及其n个邻居之间进行插值生成n个新的合成样本而基于聚类的欠采样(Cluster Under-Sampling,CUS)[8]从原始数据集中分离出多数类和少数类,并使用k均值聚类算法将多数类实例聚类为k个聚类。此后,通过随机选择大多数样本的1/n并去除其余样本集,对每个创建的聚类进行随机欠采样。由于在采样之前使用聚类,理论上该算法将消除由于随机欠采样而导致的显著数据减少的一些影响。

欠采样技术的基本思想是删除部分多数类样本,因此会造成分类信息的丢失;而过采样技术通过增加少数类样本的数量,保留甚至增加了少数类的分布信息。因此,使用过采样和欠采样结合的手段来重新调整数据集间不同类别之间的样本分布。

2.3 特征选择方法

在输入空间里,过多的输入特征会导致整个模型的冗余,删除冗余的特征将有助于减少计算成本并提升模型的准确性,也将有助于避免模型的过拟合。此外,更紧凑的指标可以帮助研究者关注更重要的指标,并持续跟踪重要指标后续的预测性能。本文采用基于特征权重的启发式搜索方法RFE(Recursive Feature Elimination,递归特征消除),启发式搜索是利用启发式信息不断缩小搜索空间的方法。在特征选择中,特征权重可作为启发式信息。该算法的思想是进行多轮训练,每轮训练后,消除若干低权值(例特征权重系数或者特征重要性)的特征,再基于新的特征集进行下一轮训练,一直迭代到保留需要数量的特征为止。

2.4 集成数据预处理技术

将上述3 种方法集成起来,提出基于集成的数据预处理技术,不仅能够多维度进行数据预处理,克服多方面数据集本身存在的弊端;还可以结合各自方法的优势,将数据预处理的能力发挥到最大。

3 实证研究

3.1 数据选择与模型构建

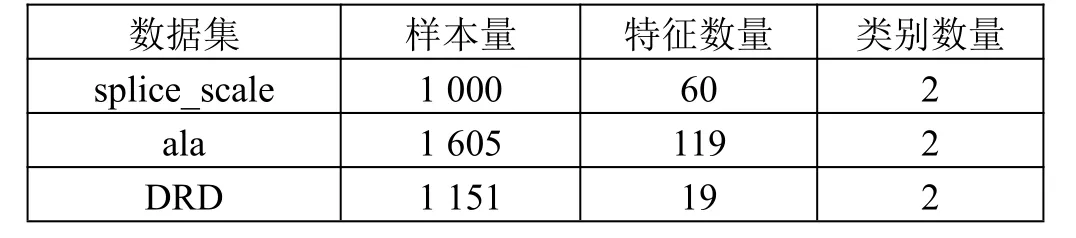

在UCⅠ数据库中选取了3 个数据集,如表1 所示。选择决策树、支持向量机和神经网络这3 种机器模型以验证所提出的数据预处理方法的有效性。

表1 3 个UCI 数据集

按照7∶3 的比例划分为训练集和测试集。首先用训练集训练3 个机器学习模型,迭代30 次从而得到最优参数;然后再用测试集验证模型的准确性。所使用的模型评价指标包括召回率、准确率和AUC(Area Under Curve,ROC 曲线下与坐标轴围成的面积)值。ROC(Receiver Operating Characteristic,受试者工作特征)曲线被称为接受者操作特征曲线,可以用来评估分类算法的性能;AUC 值用于衡量分类模型的性能。AUC 的值介于0~1 之间,越接近1 表示模型的性能越好,越接近0.5 表示模型的随机猜测性能,而越接近0 表示模型的性能越差。

3.2 实证结果

本文提出的基于集成的数据预处理方法下的3 种机器学习模型的实证结果如表2 所示,其中符号“&”前后的数字分别表示数据预处理前后的指标得分。从实证结果可以看出,无论是决策树、支持向量机还是神经网络,虽然在数据预处理之前就已经达到了很高的预测效能,均在85%以上,但是采用本文提出的基于集成的数据预处理技术之后,每一个机器学习模型的预测性能又更上一层楼,分别提升0.8%~4.7%,这表明了基于集成的数据预处理技术对于提高机器学习算法性能的有效性。从3 个算法来看,支持向量机在3 项指标上均表现出最优秀的性能,其次是神经网络,然后是决策树。

4 结论

本文提出了一种基于集成的数据预处理技术,将数据清洗、类别不平衡数据处理、特征选择3 个阶段集成到一起,并将其在决策树、支持向量机、神经网络这3 种机器学习算法上进行应用。通过UCⅠ数据库的3 个数据集(splice_scale、ala 和DRD)的实证分析结果可以看出,在经过数据预处理之后,无论是哪个机器学习模型,都不同程度地提升了模型的预测性能,最高将预测准确率提升了3.5%。这样的结果也证明了在大数据时代数据预处理方法作为数据分析、建模的首要部分,在整个过程中的重要性。