基于雷达与视觉融合的双模态煤矿井下环境感知技术

2023-12-06杨志方

杨志方

(1.煤炭科学技术研究院有限公司,北京 100013;2.煤矿应急避险技术装备工程研究中心,北京 100013;3.北京市煤矿安全工程技术研究中心,北京 100013)

0 引言

煤矿井下高粉尘、高水雾、低照度等恶劣工况往往导致传统视觉图像采集装置的环境感知能力受限,给井下作业和安全监测工作的开展带来巨大挑战。如何准确地感知环境信息并协助采取相应预警干预措施,对于保障煤矿井下安全生产意义重大[1-2]。随着计算机、通信、微电子技术的迅速发展,多传感器数据融合技术受到普遍关注和广泛应用[3-5]。将井下多种类型的传感器信息进行融合处理,在降低理解模糊性的同时提高数据利用率,可以有效推进煤矿智能化发展[6-8]。

在矿用多传感器数据融合方面,视觉相机因能获取环境丰富的纹理、颜色信息且价格低廉而被广泛使用[9-10]。杨静宜等[11]基于机器视觉理论,利用视觉传感器实现了对巷道路面边界的感知。尽管视觉相机感知简单直观,但其对环境光照变化敏感,易受煤矿井下环境因素的影响,感知结果具有一定的不准确性。雷达具有良好的精度和距离测量能力,且受煤矿暗光、粉尘、多雾等环境因素影响较小,因而被用于煤矿环境感知中,但其存在对细节感知不足的问题[12-13]。为更好地结合相机和雷达的优势,张海波[14]通过将图像点云与激光点云进行融合和分割,实现了煤岩分布情况的准确识别;袁晓明等[15]将深度相机红外成像技术和平面激光雷达探测技术相结合,实现了机器人的环境感知功能;杨春雨等[16]认为煤矿机器人环境感知的关键技术是多元传感器融合,其中包括雷达和视觉信息的融合。可见,将视觉相机和激光雷达所采集的信息融合,可有效提升对煤矿井下复杂多变环境的感知能力。

在实际应用中,雷达和相机数据的融合方法直接影响环境感知结果。陈少杰等[17]提出一种基于视差图特征点对求解激光雷达与双目相机之间配准参数的方法,通过视差图的互补特性感知高精度的三维环境信息,实现二者的高度融合;张赛赛等[18]提出了一种基于多维度动态卷积的激光雷达与相机外参标定方法,提高了雷达和相机外参标定的精度。但上述方法对于煤矿井下特殊的作业环境并不具有普适性。

针对煤矿井下复杂环境及作业场景多任务需求,本文对矿用摄像仪图像信息与雷达信息进行研究,提出了雷达与视觉双模态空间融合方法,可更好地将摄像仪与雷达在环境感知方面的优点结合,有效弥补了摄像仪在煤矿环境感知过程中易受环境影响导致信息不准,雷达感知结果因其稀疏性造成感知细节不够、远距离目标分类精度低等不足;同时,为了更好地提取目标特征信息,提出了双模态融合环境感知网络架构,为后续多任务的进行提供了技术参考。通过实验证明,提出的方法及技术架构可有效提升煤矿井下环境感知能力,为煤矿道路环境感知和视觉测量系统、无人矿车导航系统、矿井搜救机器人等应用场景提供可靠的图像信息及技术支持。

1 雷达与视觉双模态空间融合方法

雷达信息与摄像仪信息融合分为前融合和后融合2 种方式。前融合是指借助相机标定的空间坐标系与世界坐标系之间的关系,获得相机世界三维坐标信息,再将雷达获得的世界三维信息以相机世界三维坐标作参照进行融合,并将融合后的环境三维空间信息送到感知网络中进行处理。后融合是指将摄像机与雷达获得的三维环境空间信息分别送到感知网络中进行处理,获得环境特征信息后再将其进行融合。

针对煤矿井下低算力限制和应用需求,提出了雷达与视觉双模态空间融合方法。该方法属于前融合方法,实质上是通过2 类不同传感器之间的坐标转换来实现融合。坐标转换的具体过程:获取雷达的外参,即完成数据在雷达坐标系与世界坐标系之间的转换,之后计算数据在世界坐标系与相机坐标系之间的转换,最终获取目标数据从相机坐标系到像素坐标系的转换关系。通过这种坐标系之间的递进关系,即可完成雷达与摄像仪之间的数据转换。其中世界坐标系在该过程中相当于连接2 个传感器坐标系的桥梁。5 种坐标系之间的关系如图1 所示。

图1 坐标系转换关系Fig.1 Conversion relationship among coordinate systems

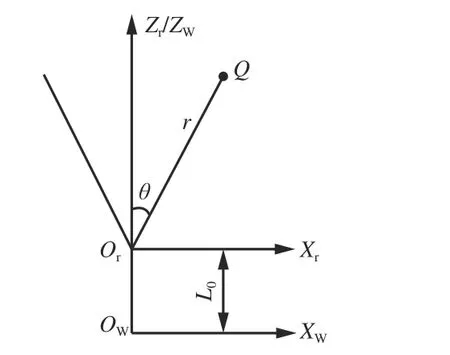

1)雷达坐标系与世界坐标系之间的转换。转换关系如图2 所示,雷达安装在雷达坐标系的原点Or处,XrOrZr平面为雷达探测平面。假设雷达探测的目标为点Q,其探测距离r与角度θ已知,在世界坐标系中的位置为(Xw,Yw,Zw),则坐标转换关系为

图2 雷达坐标系与世界坐标系的转换关系Fig.2 Conversion relationship between radar coordinate system and world coordinate system

式中:H为雷达检测平面与世界坐标系平面之间的距离;L0为雷达坐标系原点Or与世界坐标系原点Ow之间的距离。

2)世界坐标系与相机坐标系之间的转换。世界坐标系到像素坐标系之间的转换过程需要经历相机坐标系及图像坐标系的转换。像素坐标系、相机坐标系、图像坐标系之间的转换关系如图3 所示。世界坐标系XwYwZw描述物体在真实世界中的相对位置,其坐标原点Ow为人工设定;相机坐标系XcYcZc描述真实物体与相机的相对位置关系,其坐标原点Oc为相机光心所在的位置。二者的功能都是描述空间目标的位置信息,只是坐标系的原点不同,所以二者可以通过平移或旋转实现转换。设点P在相机坐标系中的位置为(Xc,Yc,Zc),在世界坐标系中的位置为(Xw,Yw,Zw),简单的平移变换公式为

图3 相机成像模型Fig.3 Camera imaging model

式中UX,UY,UZ为三轴平移量。

若在进行平移变换的同时存在旋转操作,则空间点P由相机坐标系到世界坐标系的转换关系为

式中:R为旋转矩阵,为3×3的单位正交矩阵,表示2 种坐标系之间的旋转关系;T为平移矩阵,表示2 种坐标系之间的平移关系;M1为相机坐标系与世界坐标系的转换矩阵。

M1由旋转矩阵R、平移矩阵T及三维零向量组成,通过M1即可完成2 种坐标系之间的转换。

3)相机坐标系与图像坐标系之间的转换。在图3 中,为了方便后续的推导计算,将成像平面放在相机中心和物体之间,虚构出一个虚拟成像平面。已知点P在相机坐标系中的位置为(Xc,Yc,Zc),点P在成像平面的投影为P′,则在虚拟成像平面的投影也为P′,在图像坐标系中的坐标为(x,y),则可以将虚拟成像平面的P′点和相机坐标系中的P点看作2 个相似三角形的顶点,根据其相似的性质可以得到任意点的相机坐标系与图像坐标系的转换关系:

式中f为相机焦距。

将式(4)用齐次坐标表示,并转换为矩阵形式,可得

式中M2为相机内参。

将式(3)和式(5)结合,可以获得世界坐标系到图像坐标系的转换关系:

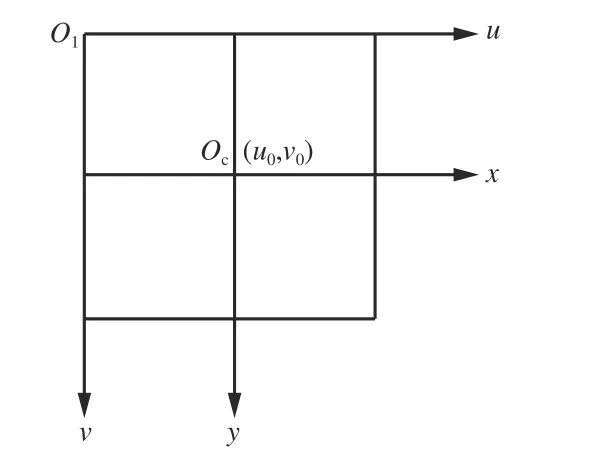

4)像素坐标系与图像坐标系之间的转换。图像坐标系是一个二维坐标系,用于描述相机捕捉到的图像位置和方向,其原点位于图像中心。在图像坐标系中每个像素都有1 个对应的坐标(u,v)。因此,像素坐标系也称为图像物理坐标系,其原点在图像的左上角。像素坐标系和图像坐标系关系如图4 所示。假设图像坐标系的原点Oc在像素坐标系下的坐标为(u0,v0),若图像坐标系中存在某点(x,y),则对应像素坐标系中的坐标为

图4 像素坐标系与图像坐标系Fig.4 Pixel coordinate system and image coordinate system

由式(7)进一步转换可得

将式(8)改写为矩阵形式:

式中M3为相机外参。

由式(9)可进行图像坐标系与像素坐标系之间的坐标转换。已知由式(6)可以进行世界坐标系与图像坐标系之间的坐标转换,将2 个公式结合,则可以获得像素坐标系与世界坐标系之间的转换关系:

M1与相机外参相关,M0与相机内参相关。为了方便后续内参及外参的求取,可以将式(10)转换为

相机内外参可以通过相机标定的方法获取,当各参数已知后,即可进行世界坐标系与像素坐标系之间的转换。同时通过式(1)得到雷达坐标系与世界坐标系的转换关系,便可将雷达采集的数据投影至相机所采集的图像上,即完成雷达与视觉传感器的空间融合。

完成雷达与视觉传感器空间融合后,将融合数据送入双模态融合环境感知网络中进行处理,经过特征提取和任务处理后可得相应结果。

2 双模态融合环境感知网络架构

双模态融合环境感知网络架构如图5 所示。其包括双模态环境感知信息融合模块、双模态特征提取网络模块、多任务处理网络模块。

图5 双模态融合环境感知技术网络架构Fig.5 Network architecture of bimodal fusion environment perception technology

在双模态环境感知信息融合模块中,摄像仪和雷达双传感器获取周围环境信息,经雷达与视觉双模态空间融合方法进行融合处理,得到细节更加丰富的环境信息;融合信息输入双模态特征提取网络模块,通过神经网络对环境信息特征进行学习;针对煤矿不同工业场景需求,多任务处理网络模块采取相应的任务头程序处理双模态特征提取网络模块提取的目标特征信息,进而完成图像增强、目标检测、图像分割、目标分类等环境感知任务,最终实现对煤矿环境的有效感知与应用。

1)双模态特征提取网络模块。该模块是一种通用的特征提取神经网络架构,主要依靠神经网络的卷积、池化、注意力机制等通用技术操作实现特定场景的特征提取,具体实现方法可参考文献[19-20]。本文主要介绍该模块的技术路线,如图6 所示,其主要是基于卷积神经网络构成的深层卷积网络,由卷积操作、注意力机制、时空校对模块、解卷积4 个部分组成。当图像信息经双模态特征融合网络模块处理后得到二维图像特征和三维图像特征,之后输入多任务功能模块。

图6 双模态特征提取网络模块架构Fig.6 Architecture of bimodal feature extraction network module

由于矿用神经网络模型在实际部署过程中需考虑轻量化的要求,所以设计双模态特征提取网络模块时通常采用通道剪枝、正则化、多层参数剪枝、模型量化方法进行模型轻量化[21]。

2)多任务处理网络模块。双模态特征数据融合后的输出为空间特征信息图,后续需加上不同任务的任务头程序对特征信息进行处理。针对矿用场景,常用的任务头包括分割头、目标检测头、分类头3 种,在不同的应用场景下,网络任务的侧重点不同,通过调整相应的权重比例赋予各任务不同的优先级,进而得到最终输出结果,其具体实现方法可参考文献[22-24]。

3 硬件实现与应用

3.1 硬件实现

本文所用的雷达主要为矿用毫米波雷达和矿用激光雷达2 种。毫米波雷达波长通常为4~12 mm,激光雷达波长通常为900~1 500 nm。相比毫米波雷达,激光雷达可以看得更“细”、更精确,但成本更高,安标认证难度更大。矿用摄像仪无需使用特殊的发射器和接收器,硬件要求及成本低,可直接根据环境光采集图像。

由于2 种传感器设备的自身特性,难免存在摄像仪和雷达标定不准、同步存在误差及运动过程中松动等问题,同时在实际使用过程中,由于受到多粉尘、多雾、暗光等煤矿井下环境影响,摄像仪存在图像模糊、雷达存在形成凝露情况,甚至出现雷达点云数据丢帧、摄像仪画面缺失问题。

在实际应用中,对于摄像仪,可进行摄像仪到图像坐标系的内参、三维空间坐标到摄像仪坐标系的外参标定,从而进行偏移补偿;对于雷达,可采用姿态调节方式对其位置信息、前后帧的相对位置关系进行建模和补偿。摄像仪及激光雷达的畸变补偿方法可参考文献[25]。通过计算雷达自身角速度与线速度,尽量还原激光真实情况,完成畸变补偿,从而确保某一时刻的点云和该时刻对应位置的雷达能同时触发。对于不同传感器的同步误差问题,采用硬同步方法,以激光雷达作为触发其他传感器的源头,当激光雷达转到某个角度时才触发该角度的摄像仪,从而缓解不同传感器之间时间差过大的问题,且该时间同步方案可以嵌入硬件内部,大大降低了同步误差,改善了数据对齐效果。对于雷达丢失点云信息或出现凝露等问题,可通过添加故障报警装置,在设备出现异常情况时及时给出故障提示,并结合人工或机械制动方式进行故障处理。

3.2 实际场景应用

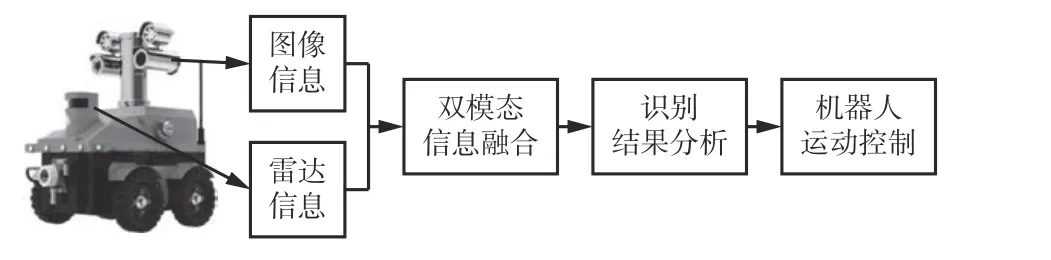

在实际应用中,本文提出的煤矿井下环境感知技术整体运行由感知、决策规划、控制3 个部分组成。先用激光雷达与双目摄像仪获得环境信息,再利用内置芯片及云端同步处理相关数据,最终实现井下设备控制和应用。

根据装置运行时的工作状态,可将其分为固定点位装置和移动装置2 类。固定点位装置主要为矿用激光雷达摄像仪,场景应用如图7 所示。采用提出的煤矿井下环境感知技术获得处理结果后,通过云-边-端协同技术将处理结果上传到本地服务器及云端服务器进行数据存储及处理。当出现预先设定的违规危险情况,如有落石、行人误闯入危险区、未戴安全帽等,云-边-端协同的处理中心将根据危险层级进行相应的设备控制。例如,检测到未戴安全帽情况时,可将处理结果传输到移动边缘控制器进行处理,并由移动边缘控制器对报警器等设备进行联动控制;检测到有落石情况时,可由本地或云端服务器进行报警记录,并发布警报至集控中心,由人工协同进行处理(包括封闭现场等)。

图7 固定点位场景应用Fig.7 Fixed position scenario application

对于移动装置,如移动机器人、无人巡检机器人、自动驾驶矿车等,采用提出的煤矿井下环境感知技术获得处理结果后,将结果传输到自身处理器。处理器根据专家系统或自身预设的处理命令,将命令下发至控制器(以电动机控制器为主),通过控制转速,实现装置转向、停止、加速、急停等操作。移动场景应用如图8 所示。

图8 移动场景应用Fig.8 Mobile scenario application

4 实验及结果分析

4.1 实验设置及评价指标

整体模型前期训练过程中,在实验室GPU 服务器上进行加速实验,实验环境及参数如下。

网络模型训练过程中使用的损失函数为交叉熵损失函数[26],其用于描述检测预测值与实际标签值2 个概率分布之间的差异性。交叉熵损失函数值越小,表明预测结果越接近目标结果。

采用平均精度均值(mean Average Precision,mAP)、召回率、平均交并比(Mean Intersection over Union,MIoU)作为客观评价环境感知效果的指标。

4.2 实验结果分析

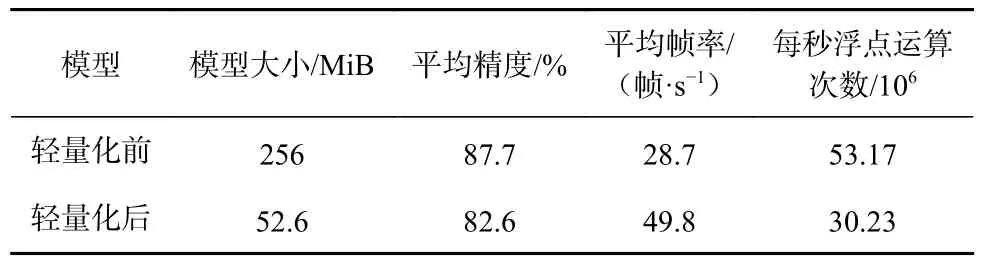

1)模型轻量化效果。在实验室测试中,双模态特征提取网络模块采用YOLOv5s 目标检测算法架构[27-28],并采用特征金字塔结构[29]将不同层级的特征图进行拼接,从而减小网络深度和计算量,以实现轻量化操作,效果见表1。可看出轻量化模型较原模型的检测精度降低约5%,检测速度为原模型的1.7 倍,每秒浮点运算次数提升43.14%。可见,轻量化模型在达到原模型相似精度的基础上,检测速度大幅提升,为煤矿井下模型部署提供了理论依据和技术路线。

表1 模型轻量化效果Table 1 Model lightweighting effects

2)单模态与双模态感知对比实验。在煤矿现场测试中,采用YOLOv5s 架构,在巷道暗光环境中进行行人检测重复测试,场景包括单人行走、多人并排行走等。检测结果见表2,可看出双模态煤矿井下环境感知技术在井下暗光条件下较视觉、雷达感知成功率分别提升15%,10%,证明了本文融合方法可克服单传感器的缺点,有效提升环境感知能力。某次行人感知结果如图9 所示,可看出融合感知对暗光环境中行人边界的感知更加清晰。

表2 单模态与双模态检测结果对比Table 2 Comparison between of unimodal and bimodal detection results

图9 煤矿井下行人感知结果Fig.9 Personnel perception results in underground coal mine

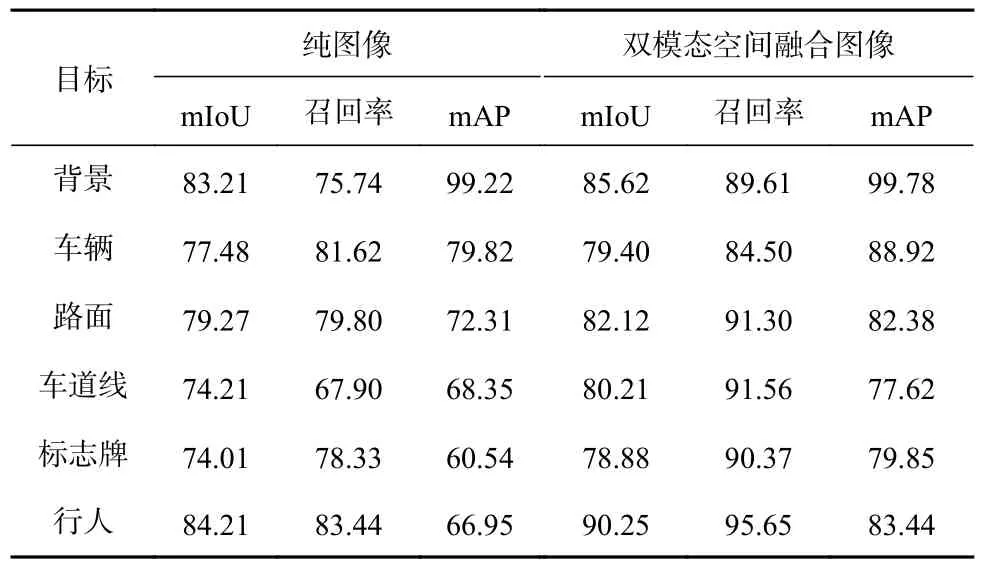

3)各类目标分割实验。在实验室测试中,采用YOLOv5s 架构,对煤矿井下低能见度场所下的背景、车道线、车辆、路面、标志牌、行人等目标进行分割实验。采集煤矿井下相关图像,采用翻转、平移等操作增加数据集的多样性和泛化性,最终制作成实验用数据集(含训练集1 628 张,测试集569 张)。目标分割结果见表3。可看出在煤矿井下低照度环境中进行分割任务时,采用双模态空间融合图像时不同目标分割的准确率较纯图像有所提升,mAP 均提升10%以上,对行人、标志牌识别的mAP 提升度最高,分别为20%,24%。某图像的目标分割效果如图10 所示,可看出双模态空间融合图像的分割结果更加接近真实标签,对边界、不同类别分割得更加清晰,错分、误分更少。由此可知,视觉与雷达双模态空间融合较单模态具有更强的环境感知能力,进一步验证了本文方法的优越性。

表3 煤矿井下各类目标分割结果的评价指标Table 3 Evaluation indexes of segmentation resultsof various types of object in underground coal mine%

图10 煤矿井下目标分割结果Fig.10 Object segmentation results in underground coal mine

5 结论

1)针对煤矿井下复杂环境及作业场景多任务需求,融合雷达点云信息与摄像仪信息,提出了雷达与视觉双模态空间融合方法,可以有效地结合雷达和摄像仪在环境感知上的优势,获得更加丰富的环境感知信息。

2)为了更好地提取目标特征信息,创新性地提出了双模态融合环境感知网络架构,包含双模态环境感知信息融合模块、双模态特征提取网络模块、多任务处理网络模块3 个部分,为提取双模态目标特征信息及后续多任务的开展提供了可行技术路线。

3)通过实验验证了提出的基于雷达与视觉融合的双模态煤矿井下环境感知技术相较于单模态感知技术的环境感知能力有较大提升,提高了目标检测、分割、分类等智能视觉任务的准确率,为煤矿道路环境感知、视觉测量系统、无人矿车导航系统、矿井搜救机器人等应用场景决策提供了可靠的图像信息来源及技术支持。

4)未来将在矿用模型算法研究、多模态信息融合方向进行更多尝试,探索新的煤矿环境感知技术,不断提升对煤矿环境的感知能力。