计及多元灵活性的不同地理分布数据中心协同运行优化策略

2023-12-05顼佳宇李笑彤王晓冰周世博顾靖达

顼佳宇,李笑彤,王晓冰,李 冰,周世博,周 明,顾靖达

(1.国网北京市电力公司,北京 100031;2.中国国际工程咨询公司,北京 100048;3.新能源电力系统国家重点实验室(华北电力大学),北京 102206)

0 引言

近年来,随着大规模虚拟化、云计算等技术的发展和互联网服务需求快速增长,数据中心(Data Center,DC)产业的投资、规模以及能源消耗在信息数字化蓬勃发展的大背景下呈现出指数级增长趋势,其机架数量预计在2025 年将达759 万架,较2021年增长45%,这使得数据中心的用电量逐年上升,2021年数据中心的电能消耗约占全社会电力总消耗的2.7%[1]。随着东数西算战略的提出,为应对我国数据中心巨大耗电量及区域能源禀赋差异的问题,我国正在全面探索多区域数据中心灵活协同运行的新模式[2-3]。

目前,随着我国相关政策的不断落实,数据中心产业集群将逐渐形成数据要素跨区流通的局面,数据中心的规模和灵活性潜力将进一步扩大[4-5],需要数据中心开展协同运行,促进数据中心优化自身运行,充分发挥自身灵活可调优势。随着数据中心规模的快速增长,其改变自身用电行为,将影响所在区域的电力价格[6-7]。当前,国内外对于数据中心参与需求响应和实现灵活运行的研究主要分为两类:一是专注于单体数据中心内部运行[8-[9];另一种则是考虑不同地理分布多数据中心协同运行[10]。针对单体数据中心内部运行,文献[11]考虑了满足延迟服务质量的时域负载灵活性调度问题,通过负载自身时延特性,结合不同时段的电价差异,实现数据中心在时域范围内的迁移。文献[12]则在时域调度的基础上,考虑了新能源出力的随机性与波动性,实时控制数据中心内部负载迁移至新能源高发时段,以尽可能消纳新能源。而数据中心源自于自身负载的特殊性,具备其他灵活性资源所没有的空间灵活调度能力,进而实现不同地理分布多数据中心协同运行,文献[13]以协同运行成本最小为目标,充分利用不同区域间的电价差异性,激励高电价区域数据中心负载迁移至低电价区域数据中心中进行处理。文献[14]则同时考虑单体数据中心内部优化运行以及考虑不同地理分布多数据中心协同运行,以区域电力供需匹配度为目标函数,通过电价及不同激励政策的影响,促进数据中心内负载迁移至新能源丰富的区域或时段,实现电力系统供需平衡。现有文献中关于数据中心灵活运行的研究主要聚焦于工作负载特性所激发的时空灵活性,却忽视了同样能耗巨大的数据中心制冷系统的灵活调节能力,往往将其用固定的电源使用效率(Power Usage Effectiveness,PUE)指标所描述。

基于研究的不足,本文提出了一种计及数据中心时空多元灵活性的双层优化模型。其中上层模型是以最小化数据中心运行成本为目标,对单体数据中心内部工作负载和制冷系统进行配置,下层模型则是以火电和风电联合运行成本最小化为目标,对系统侧的火电机组以及新能源机组进行优化配置。最后以IEEE-30 节点系统为例进行验证,结果表明所提双层优化模型利用了不同地理分布多数据中心时空多元灵活性,同时降低了系统侧联合发电成本与数据中心的协同运行成本。

1 数据中心灵活性分析

1.1 数据中心计算负载灵活性

一般数据中心的任务负载可根据任务对处理时间的灵敏性分为延迟容忍型负载和延迟敏感型负载。延迟容忍型负载主要由数据处理信息复杂、计算时间长的任务组成,能够容忍一定程度的时间延迟[15];延迟敏感型负载主要由实时任务组成,对时间延迟的敏感型高。数据中心空间灵活性是指不同地理位置上的数据中心之间的工作负载迁移处理,不管是延迟容忍型负载还是延迟敏感型负载都具备空间灵活性。考虑到数据中心集群的地域分布特征、环境温度和资源丰富度等差异,不同地理位置和时刻数据中心的电价也不尽相同,利用数据中心时空尺度的灵活性能够将负载迁移到电价低的数据中心处理,实现多数据中心协同,以减少数据中心用电成本。但同时在计算负载迁移过程中,不可避免会出现传输线路堵塞以及接收路由器等网络设备的能耗,进而增加数据的传输成本,因此在调控空间转移负载时需要综合考虑运行成本进行决策[16]。

1.2 数据中心制冷系统灵活性

当前制冷系统一般有空气自由冷却和液体冷却两种方式,但液体冷却技术对环境要求较高,而空气自由冷却的核心则是中央空调,普适性强。中央空调系统(Central Air-Conditioning System,CACS)的核心是热储存和热延迟效应的应用,其具体运行过程如图1 所示。

图1 数据中心灵活运行框架Fig.1 Flexible operation framework for data center

制冷柜在给定时间段内存储热量,其值等于外界太阳和计算器所释放热量与外界冷空气散发热量和制冷设备散发热量之差。考虑到数据中心内部的服务器等设施都有一定的工作温度区间,可以在新能源出力较大,节点电价较低时增加制冷系统的用电量,多余的冷空气则存储在蓄冷罐中;在电价升高时可以减少制冷系统的用电量甚至是关闭制冷系统,蓄冷罐则释放之前所存储的冷空气,使数据中心内部温度在一段时间内维持在合适的区间,达到可中断负荷的作用,激发制冷系统的灵活性[17]。

由于数据中心内部配备大量的控制器和实时反馈设备,能够实现高度自动化的负载处理流程,能够对IT 设备(如服务器、存储设备等)和辅助设备(主要以空调系统为例)的电力负荷和状态进行实时监控和全局调动,因此数据中心具有较大的灵活性潜力,可积极参与需求响应[18]。由图1 可知数据中心灵活运行框架主要分为两部分:一是不同地理分布多数据中心之间的协同灵活调度;另一种则是单体数据中心内部工作负载和制冷系统的灵活调度。

2 考虑不同地理分布多数据中心的双层协同优化模型

数据中心的多元灵活性赋予其在时间和空间2个维度上进行用电负荷的转移,而随着数据中心耗能的不断增加,其用电负荷行为的改变不仅仅影响到自身计算负载处理策略,还会影响到其所在区域的电价。因此本文建立了考虑不同地理分布多数据中心协同双层优化模型,其中上层模型是数据中心决策模型,以多数据中心运行成本最小为目标函数,根据自身用能组成和下层传递的节点电价信号优化数据中心用电行为;下层模型为市场出清模型,以火电和风电的联合出清成本最小为目标函数,根据上层数据中心的用电行为影响市场出清,形成市场价格信号,量化数据中心多元灵活性价值。

2.1 上层模型

2.1.1 目标函数

建立考虑不同地理分布多数据中心和电网协同交互的双层优化模型,其中上层模型是以最小化数据中心运行成本为目标函数,由云服务商管理(Cloud Service Provider,CSP)。不同地理分布多数据中心协同运行成本如式(1)所示;多数据中心用电成本如式(2)所示;数据中心间利用光纤通信转移计算负荷的传输成本如式(3)所示:

式中:Cop为多数据中心运行耗电成本;为数据中心i经过需求响应后在t时段的用电量;γi,t为数据中心i所在节点的节点边际电价;Ctrans为数据中心的传输成本;Ztr为传输成本系数,其由传输距离、传输介质材料等因素所决定;和Ei,t分别为数据中心i在t时段需求响应前、后的计算负载数量;T为一天24 时刻的集合;I为多个数据中心集合。

2.1.2 约束条件

1)数据中心工作负载约束。由于数据中心具有时空多元灵活性,即数据中心可以在时间和空间两个维度转移负荷,可以将数据中心的计算负载聚合后转移到节点边际电价较低的时段和节点进行处理,进一步挖掘数据中心的灵活性潜力,从而达到节约数据中心的用电成本的目的。式(4)—式(11)主要描述了灵活调度前后的约束关系:

2)数据中心制冷系统约束。随着储热技术的发展,制冷出力不再是无法控制的恒定量,而变成可调节的灵活变化量[19]。因此,本文采用了基于空气自由冷却的CACS 方式,充分挖掘制冷系统的灵活调节潜力。CACS 一般由释放冷能的空调机组和存储并释放冷能的蓄冷罐组成,其关于释放的冷能约束如式(12)—式(18)所示:

3)数据中心服务器温度适宜度约束。已有研究表明,数据中心内部的计算服务器存在一定范围内的工作温度区间,温度过高将导致计算服务器损耗的加速,温度过低将导致计算性能的大幅度下降,因此数据中心制冷系统在持续制冷的过程中要保持室内温度保持在一定的合理区间内,其具体约束如式(19)—式(21)所示:

4)数据中心能耗约束。综上所述,数据中心能耗一般由IT 设备能耗和制冷能耗所组成,但仍有一小部分不具备灵活调节能力的设备能耗,因此本文采用固定常数的形式来表征。数据中心总能耗如式(22)所示:

式中:常数Ci则为数据中心内部一些不具备灵活调节能力的设备能耗。

2.2 下层模型

2.2.1 目标函数

下层模型是以社会福利最大化,即火电和风电联合运行成本最小化为目标函数,由独立系统运营商(Independent System Operator,ISO)管理[20]。

2.2.2 约束条件

下层约束条件主要包括火电机组的运行约束(如火电机组爬坡约束、旋转备用约束等)、风电机组运行约束(如风电机组机电转换效率约束、风电弃电约束等)和系统约束。其中,火电机组运行约束和风电机组运行约束见文献[21],系统约束如式(29)—式(33)所示。

式中:αn为位于节点n处的发电机集合;βn为位于节点n处的负荷集合;to(n)为终点为节点n的线路集合;fr(n)为起点为节点n的线路集合;为线路净传输功率;Pk,t为除数据中心以外的其它负荷需求;cw,ck分别为风电和负荷的波动系数;l 为系统电力线路;k 为系统中不参与需求响应的负荷。

2.3 模型的求解

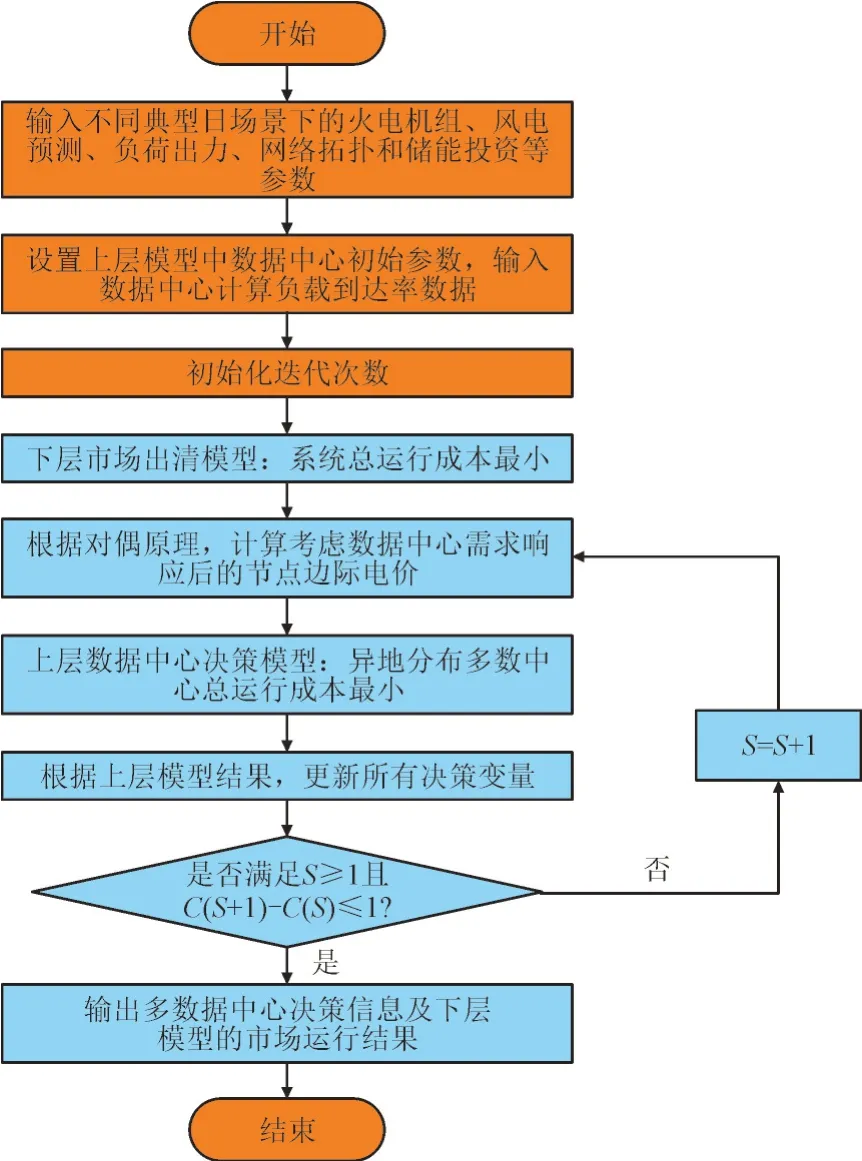

由于上层模型式(3)中包含了绝对值,其本质是一个分段函数,采用0-1 变量可将其转变为线性约束进行求解。在此基础上,本文的双层协同优化模型可转化为混合整数线性规划模型,可采用Cplex 求解器进行求解。具体迭代过程如图2 所示,其中S为迭代轮次。

图2 考虑数据中心多元灵活性的双层优化模型求解流程图Fig.2 Flowchart for solving bi-level optimization model considering of data center with multiple flexibility

3 算例分析

3.1 算例设置

本文以IEEE30 节点系统为例进行算例分析,在原有的8 台火电基础上,分别在节点4,16,22 处增添风电机组、光伏机组与数据中心,具体如图3所示。其中G 代表火电机组,R 代表新能源机组。

图3 系统网络拓扑结构Fig.3 System network topology

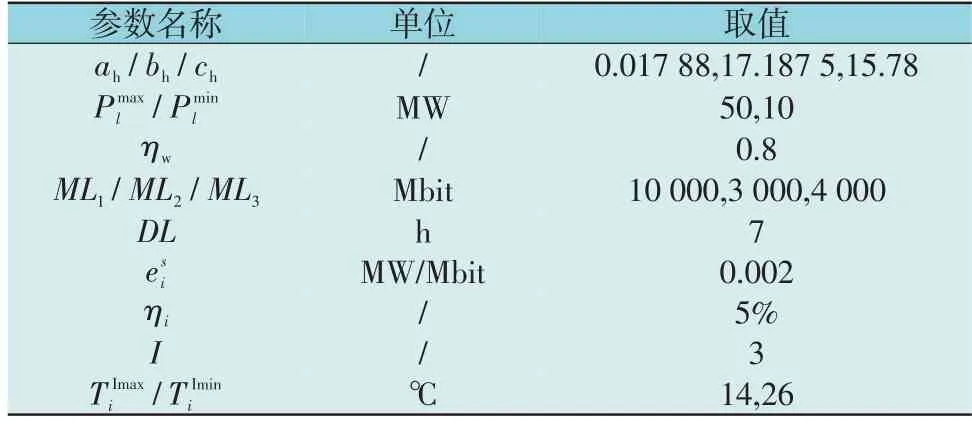

本算例中使用中国3 个地区真实的风电光伏数据,负荷数据使用了当地的负荷数据,不同地理分布的多个数据中心为了简化采用同一内部参数,其中火电、风电的相关参数来源于文献[18],数据中心相关参数来源于文献[22]和[23],具体如表1 所示。

表1 数据中心基础参数设置Table 1 Basic parameters settings of data center

3.2 需求响应后数据中心灵活运行结果分析

利用2.3 节所介绍的方法迭代求解双层协同优化模型,其中数据中心总成本在需求响应前后的变化情况如图4 所示。

图4 需求响应前后成本变化情况Fig.4 Cost changes before and after demand response

其中底层表示的是3 个数据中心在负载高峰时段(10:00—20:00 时)的成本变化情况;中间层表示的是总成本在需求响应前后的变化幅度;上层则表示的是总成本在不同时间段的变化百分比。由图4 可以看出3 个数据中心在进行需求响应后,其成本在负载高峰时间段都有明显的减少,其中在18:00 成本下降幅度最大,达到了692.4 元,较需求响应前下降了55.56%。分析其原因,一是数据中心中的工作负载在电价差异的激励下的时空迁移,二是数据中心内制冷系统的灵活调度所带来的节能优化。

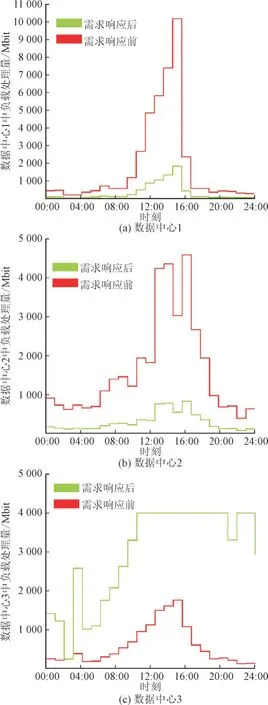

图5 为含有数据中心节点4,16,22 的节点边际电价图。由图5 可以看出数据中心3 所在节点的节点边际电价要小于其他2 个节点。图6(a)—图6(c)给出了3 个数据中心参与需求响应前后其处理负载的运行状态。

图5 节点边际电价图Fig.5 Locational marginal price map

图6 数据中心负载处理量Fig.6 Load processing capacity of data center

对于数据中心1 而言,其作为工作负载初始接受量最大的数据中心,其需求响应后的负载大幅减少,其中绝大多数延迟容忍型负荷迁移给了其他数据中心,而部分延迟敏感型负载受到服务质量的约束仍保留在数据中心1 中。因为数据中心1 所在节点的边际电价要明显高于数据中心3 所在节点,工作负载会优先转移至低电价的数据中心中去处理;而因为数据中心2 所在节点的边际电价更低且数据中心3 的处理容量限制,仍会有相当一部分的延迟容忍型负载留在数据中心1 内部处理。对于数据中心2 而言,其所在节点的边际电价最低,导致所有延迟容忍型负载到率转移到了数据中心3处,同样地其延迟敏感型负载受到服务质量的影响会保留一部分在数据中心2 里面处理。对于数据中心3 而言,作为所在节点的边际电价最低的数据中心,其承担了大量外来工作负载,其空间灵活性没有得到满足但是时间灵活性发挥了作用,部分延迟容忍型负载为了避开4 时和21 时的尖峰电价,会迁移至其他时段。

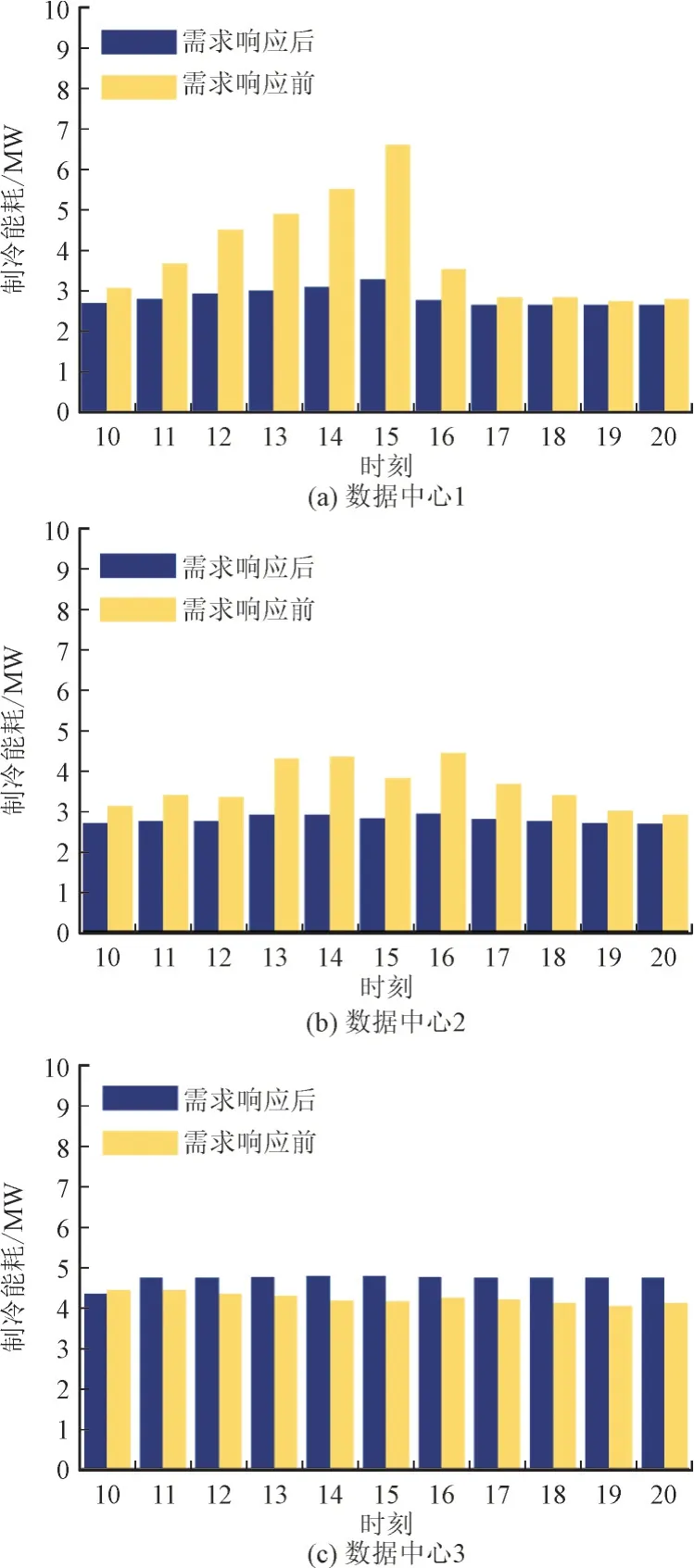

另外一部分成本优化的原因是数据中心内部制冷系统中的空调负荷的灵活调度能力,通过蓄冷罐吸收释放冷空气,以实现制冷系统的高效节能运作。图7(a)—图7(c)展现了需求响应前后不同数据中心内部制冷能耗的变化情况。选取负载处理高峰时段(10:00—20:00 时),可以看出数据中心1和数据中心2 的制冷能耗都有所下降,而数据中心3 的制冷能耗却有所增加,其主要原因在于数据中心内部的制冷功耗与数据中心室内热量息息相关,而数据中心室内热量主要由计算服务器处理负载时所散发,处理的负载越多,散发的热量就越多[24]。此外,在相同参数的数据中心之间进行负载迁移,其负载处理的能耗量是保持不变的,这意味若采取以往的PUE 值表示制冷能耗,需求响应前后制冷能耗的总量也不应变化[12,14,18],但本文所提出的CACS灵活调节系统在需求响应前后,其制冷能耗总量从253.27 MW 下降至229.70 MW。这说明本文所提出的制冷系统灵活调度不仅能受到电价时域差异影响改变出力,也可以实现制冷能耗的减少。

图7 数据中心制冷变化情况Fig.7 Changes in cooling energy consumption of data center

综上所述,数据中心的多元灵活性在需求响应前后可以导致不同地理分布多数据中心集体成本的下降,从13 573.43 元下降到9 447.03 元,下降了30.40%,其中部分原因是利用工作负载自身特性感知不同区域和不同时段的电价差异性进行计算负载的时空迁移,部分原因是利用CACS 调节手段,实现制冷能耗的减少。

3.3 数据中心服务器工作适宜度分析

类比于人体,数据中心内部的计算服务器存在一定范围的高效工作温度区间,温度过高将加快计算服务器及辅助设备的损耗,温度过低将导致内部服务器处理负载速率变慢,可能造服务质量下降[25]。因此数据中心系统在制冷过程中不是随意出力,要保持室内温度在一定的合理区间内。本研究通过不断改变室内温度的上下限,借此分析在不同温度限制下,制冷能耗的变化情况。

表2 展示了在上限和下限温度不断变化下的制冷能耗的变化情况。从表2 可知上限温度与制冷能耗总量呈反比,上限温度越高,制冷能耗最低,其原因在于服务器的耐热程度越高,所需求的冷空气需求越少,制冷系统出力越少;而下限温度则与制冷能耗总量呈正比,但上升幅度要明显小于上限温度造成的制冷能耗变化情况。此外,在改变上限温度同时保持下限温度(14 ℃)不变,改变下限温度同时保持上限温度(30 ℃)不变,即不断改变上限实则是不断拉大适宜度的范围,而不断改变下限则是不断缩小适宜度的范围,因此扩大计算服务器的工作温度范围将有利于数据中心内部制冷系统的节能高效运行。

表2 不同温度范围内的制冷能耗Table 2 Cooling energy consumption with different temperature conditions

4 结语

本文通过挖掘数据中心多元灵活调度能力,利用工作负载特性和制冷系统的可调节能力,明确数据中心参与需求响应能力,提出计及数据中心多元灵活运行框架;建立一种考虑不同地理分布多数据中心的双层协同优化模型来进行与电网的交互模拟,通过该模型分析数据中心需求响应前后对自身运行状态的影响。分析结果表明,在电价差异性的激励下,去追踪电价较低的区域和时段,将数据中心内工作负载在时空双维度上进行迁移,实现自身成本的优化。此外,在制冷柜与蓄冷罐的协作下,制冷系统能在电价低的时段加大制冷出力,在电价高的时段减少制冷出力,实现能耗减少和进一步减少用电成本。