基于OPENFACE 的学习者表情分析

2023-11-12徐航

徐航

1.陕西师范大学计算机科学学院;2.山东省青岛第五十九中学

2018 年,教育部印发的《教育信息化2.0 行动计划》中指出,要以人工智能、大数据、物联网等新兴技术为基础,依托各类智能设备及网络,积极开展智慧教育创新研究和示范,推动新技术支持下教育的模式变革和生态重构[1]。“人工智能+教育”的发展为评估学生学习状态,从而辅助进行课堂教学效果诊断提供了一种有效途径,是实现个性化教学和教育公平的强有力手段。

在“以学习者为中心”的建构主义思想指导下,学习者在学习过程中的情感表达备受瞩目,现有针对六种基本表情(生气、厌恶、害怕、开心、悲伤、惊讶)识别的算法已经发展得较为成熟[2-5],然而这些大幅度的情感表达在日常生活中,尤其是标准化课堂环境下出现的频率并不高,更为常见的是面部局部特征的细微变化(例如眉毛提升、皱鼻、下巴抬起等)。基于此,Ekman提出以面部动作单元(Action Unit,AU)为基础的面部活动单元编码系统(Facial Action Coding System,FACS)[6],为细粒度表情识别提供了依据。

然而,目前对于教学环境下学习者表情与动作单元之间联系的研究较少,因此,本文定义了学习者表情及其对应的AU 表示,结合OPENFACE 开展实验研究,为评估学生学习状态提供依据。

1 AU 相关研究

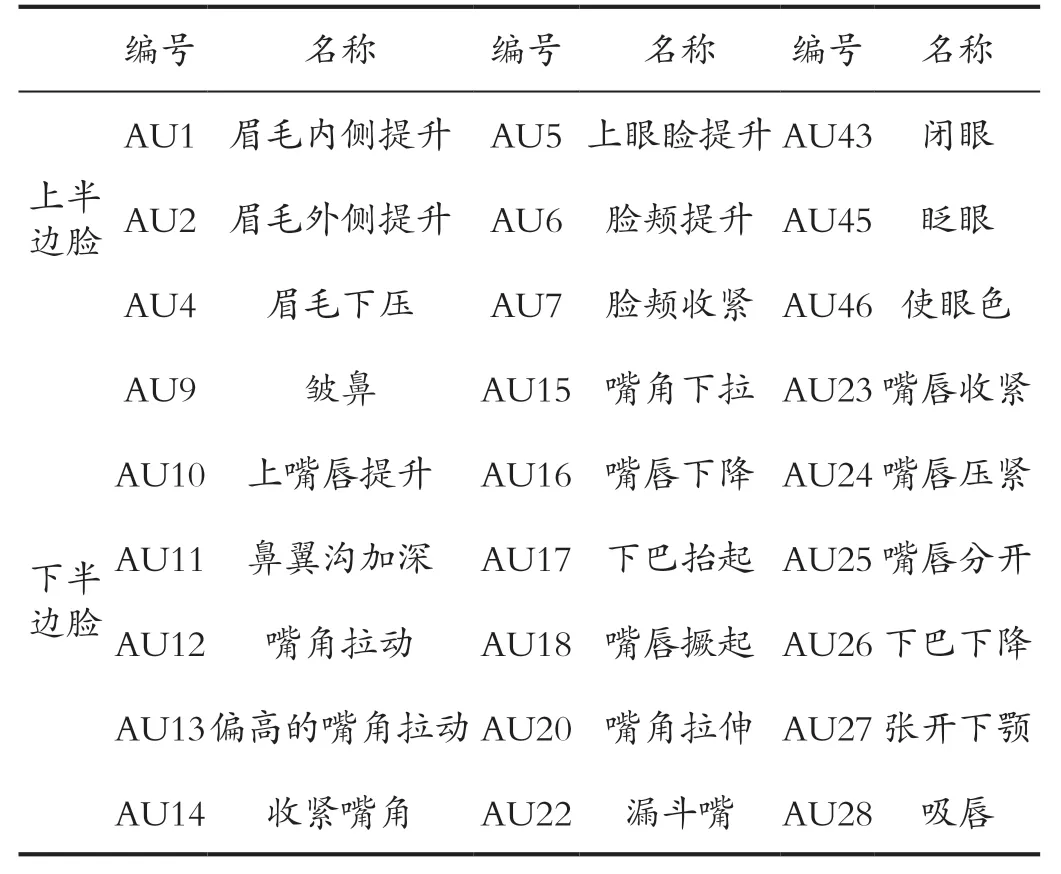

Ekman 提出的面部动作编码系统(FACS),根据表情发生时肌肉动作的不同,将其拆解为若干个动作单元,其中上半边脸定义了9 个AU,用来描述眉毛、眼睛和脸颊区域的动作,下半边脸定义了18 个AU,主要用来描述唇部肌肉的收缩变换(如表1 所示)。

表1 AU 编号及对应名称Tab.1 AU numbers and corresponding names

FACS 因其对面部动作单元的精确划分,能有效识别学习者无意识的细粒度表情,从而为精准捕捉学生学习状态提供了一种有效途径,因此学习者表情与AU 之间的联系(如表2 所示)逐渐受到教育领域学者们的关注。Craig 认为AU1、2、14 与受挫情感密切相关,且AU1 和AU2 经常同时出现;困惑表现为与AU4、AU7和AU12 之间的联系,且AU4 和AU7 的出现有一定相关性;无聊与AU43 呈现出一定的联系[7]。Kapoor 则用AU6+12 表示微笑,AU7 表示注意力集中,AU5 和AU1+2 表示感兴趣、惊讶或兴奋,以上均为积极的学习状态;反之,AU1+4、AU9、AU15 则暗示学生走神[8]。高倩认为大多数情况下单独的AU 并不能判定某种表情的发生,需要结合多个动作单元综合判断,例如,AU4和AU5 同时出现代表愤怒,AU9 和AU10 的组合代表厌恶,AU6 和AU12 组合代表高兴等[9]。孙波系统研究了高兴、惊讶等7 种情感与AU 之间的关系,其中惊讶、厌烦、困惑、疲劳4 种情绪可以使用单独出现的AU 进行判断,例如,当AU26 单独出现时可认为学生表达了“惊讶”表情,AU9 单独出现时可认定“厌烦”的发生;其他几种情绪则不能使用单个AU 直接表达,需要多个AU 组合在一起联合判断[10]。Mcdaniel 通过实验验证了困惑表现为AU4、AU7 的出现和AU12 的缺失;高兴则表现为AU7、AU12、AU25、AU26 的出现和AU45 的缺失[11]。

表2 表情与AU 关系的相关研究对比(*表示次要因素,-代表缺失)Tab.2 Comparative studies on the relationship between expressions and AU(* represents secondary factor, - represents missing)

2 学习者表情模型构建及表情-AU 关系定义

2.1 基于建构主义的学习者表情模型

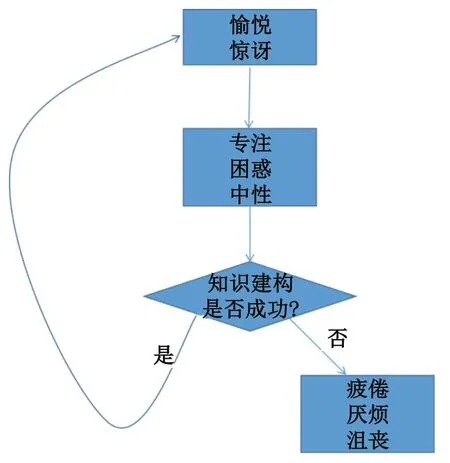

基于建构主义思想,本文构建了学习者表情模型(如图1 所示),将学生在学习过程中的表情定义为愉悦、惊讶、专注、困惑、疲倦、厌烦、沮丧和中性8 种。其中愉悦和惊讶常出现在创设情境阶段,而在整个知识建构过程中,困惑、专注和中性占据学习者表情的主导地位,最后,根据意义建构的成功与否,将分化为两种截然不同的结果:意义建构成功会提升学习者自我效能感,使其满怀动力迎接下一个阶段的学习,并进入良性循环;反之,当意义建构失败,伴随着学习过程中挫败感的积累和自我怀疑,学习者容易产生厌烦、疲倦、沮丧等负面情绪。

图1 基于建构主义的学习者表情模型Fig.1 A constructivist based learner expression model

2.2 学习者表情对应的AU 定义

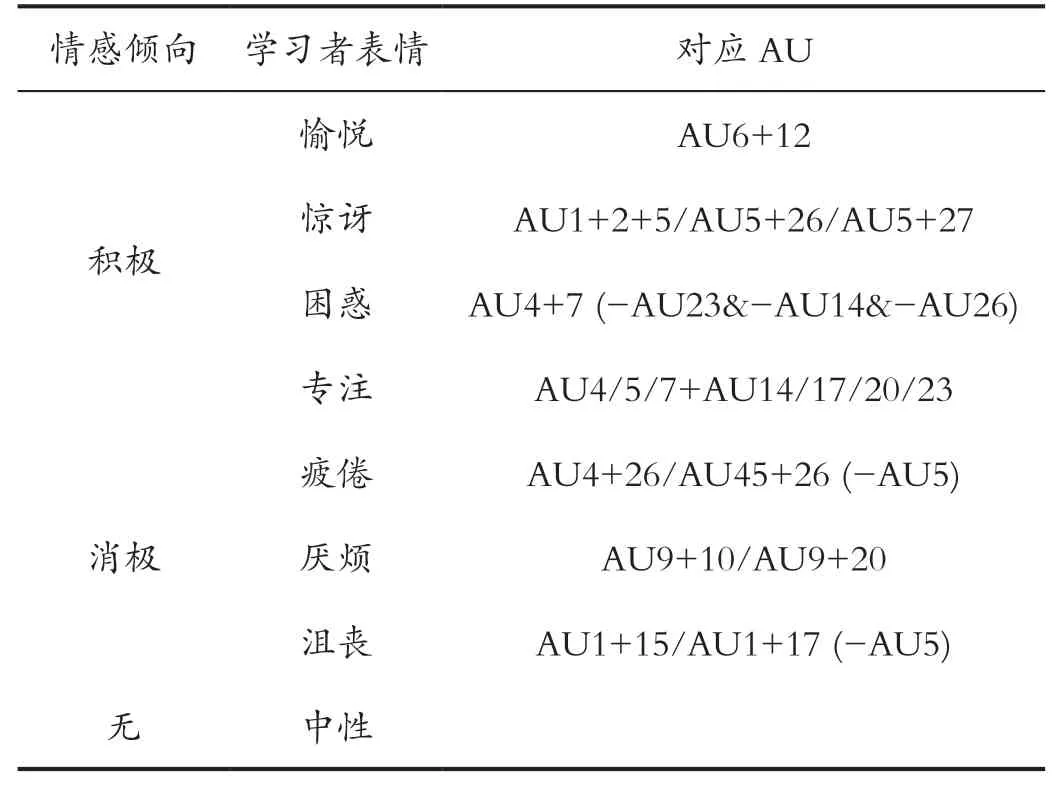

通过对学习者表情发生时面部肌肉动作特征进行分析,并结合相关研究,将这8 种学习者表情与AU 之间的关系定义为如下(如表3 所示)。

表3 学习者表情——AU 对应表(-代表互斥条件)Tab.3 Learner expression-AU correspondence table (-represents mutually exclusive conditions)

愉悦:通常表现为脸颊提升和嘴角倾斜向上(AU6+12)。惊讶:面部肌肉动作主要体现在眉眼部或唇部,在此给出两种判别方法:(1)仅依靠上半边脸的特征进行判断,即当眉毛内外侧同时抬起,伴随着上眼睑提升时可认为惊讶表情的发生(AU1+2+5);(2)上半边脸和下半边脸综合判断:眼部表现为上眼睑提升,唇部则根据惊讶程度的强弱,分别呈现出下巴下降或张开下颚的特征(AU5+26/AU5+27)。困惑:表现为眉毛降低并靠拢,同时带动眼部肌肉动作导致眼睑收紧(AU4+7)。专注:表现为上半边脸和下半边脸肌肉同时的收缩性动作,其中皱眉或眼睑拉紧可作为专注发生时上半边脸的判断条件,下半边脸主要表现为唇部收紧,按照学习者思考程度的深浅表现为不同的收缩幅度,大致呈现出嘴角拉伸、收紧嘴唇、收紧嘴角至出现酒窝、收紧下巴这4 种特征,其中任意一种皆可作为下半边脸的判断条件(AU4/5/7+AU14/17/20/23)。疲倦:该表情的一个典型特征是打哈欠,表现为下巴下降,伴随着眉毛降低或眨眼(AU4+26/AU45+26)。厌烦:以皱鼻作为厌烦发生时的明显信号,同时唇部表现为上嘴唇提升或嘴角拉伸(AU9+10/AU9+20)。沮丧:抬起内眉梢伴随着撇嘴或下巴抬起导致的下唇向上(AU1+15/AU1+17)。中性:面部肌肉动作不明显。

值得注意的是,实际对学生的面部表情进行分析时,在每一帧定格的面部画面中出现多个AU 的情况时有发生,单纯按照以上定义,不同AU 之间的组合将会被同时诊断为2 ~3 个表情,例如,当AU4、AU5 和AU26 同时出现,根据以上定义,疲倦和惊讶将被同时识别(AU4+26 代表疲倦,AU5+26 代表惊讶),而这既不符合常理,也给统计带来了不便,因此,在以上定义的基础上增加互斥条件:(1)疲倦与惊讶互斥:假定在疲倦状态下AU5 一定不发生,则疲倦和惊讶不会被同时识别;(2)沮丧与惊讶互斥:假定在沮丧状态下AU5 一定不发生,则沮丧和惊讶不会被同时识别;(3)困惑与专注互斥:假定在困惑状态下AU23 和AU14 皆不出现,则困惑与专注不会被同时识别;(4)困惑与疲倦互斥:假定在困惑状态下AU26 不出现,则困惑与疲倦不会被同时识别。通过以上4 条互斥条件,较好地限制了表情识别的唯一性。

3 实验结果及分析

3.1 实验平台

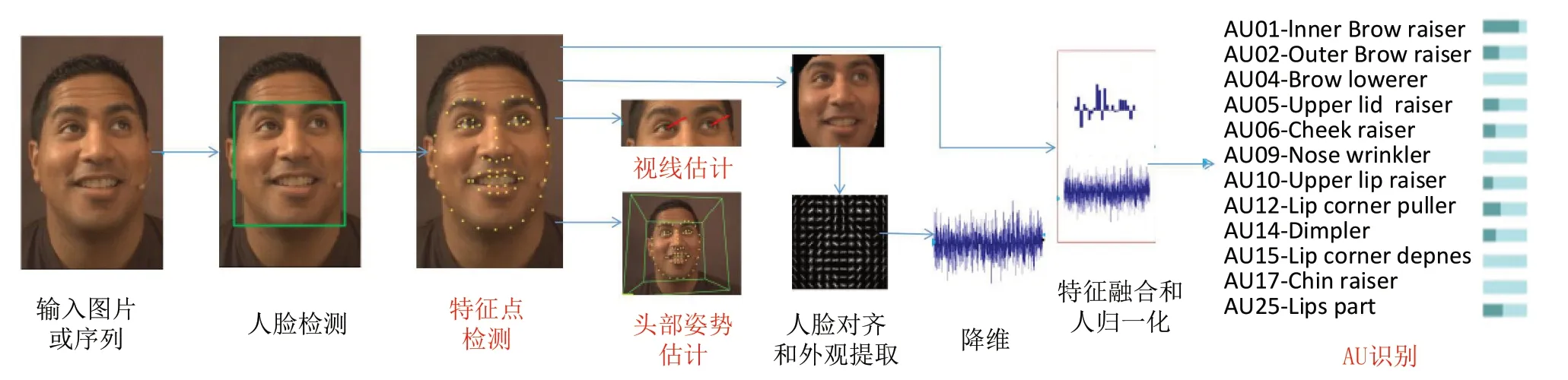

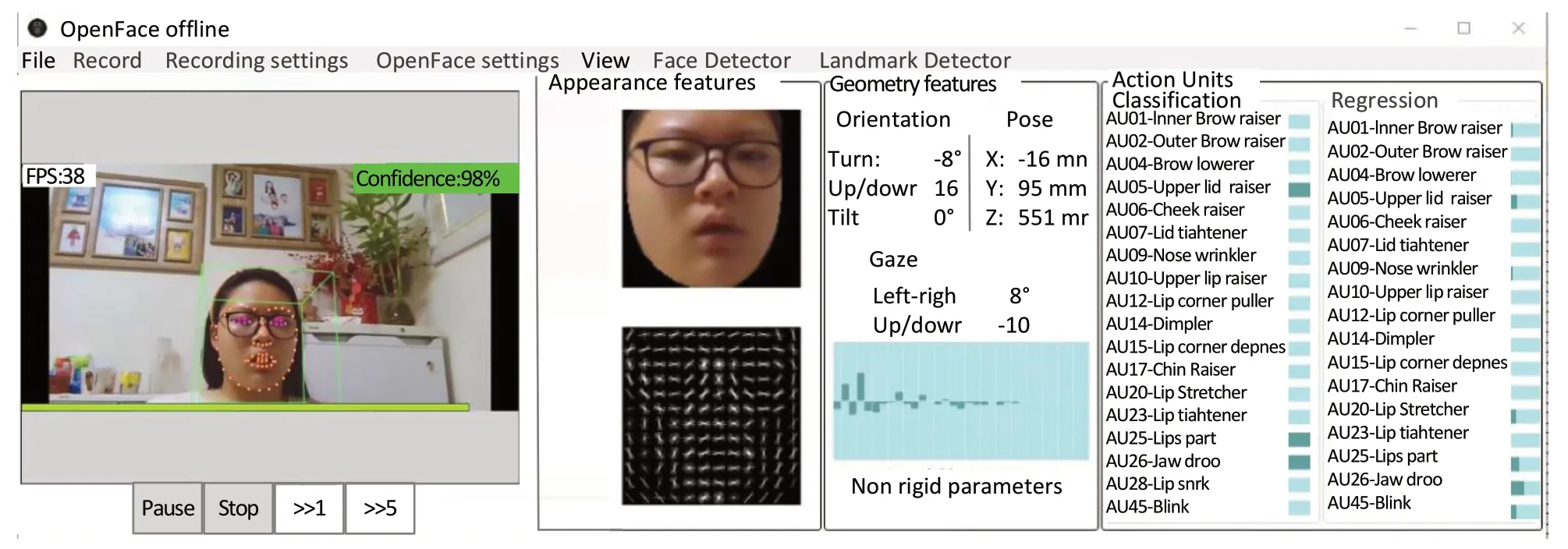

本文主要采用OPENFACE 开展实验研究,OPENFACE是Baltrusaitis 等人研发的一个开源的面部行为分析套件[12,13],可以对图像、视频序列甚至Webcam 捕捉到的实时画面中的对象进行面部状态的评估,主要包含特征点检测、头部姿势估计、视线估计和AU 识别4 个子功能(如图2 所示[12])。

图2 OPENFACE 关键技术Fig.2 Key technologies of OPENFACE

在AU 识别方面,首先用约束局部神经域模型(Constrained Local Neural Field,CLNF)进行特征点检测和追踪,然后,为了移除非面部信息的影响,对图像进行对齐和遮罩。特征提取阶段采用梯度方向直方图(Histograms of Oriented Gradients,HOGs)提取外观特征,并用主成分分析方法(Principal Component Analysis,PCA)进行降维,对于几何特征,则采用CLNF 模型在人脸跟踪期间推断出的对象空间中的非刚性形状参数和坐标点位置表示。

在以中性表情为基准计算归一化特征之后,用支持向量机方法(Support Vector Machines,SVM)进行AU 出现与否的检测,用支持向量回归的方法(Support Vector Regression,SVR)进行AU 强度估计,从而完成对AU的检测。

3.2 实验过程

实验开展的整体思路为:实验对象被要求观看一段微课,并对整个学习过程中的面部表情进行录制,生成一段视频序列,将该视频序列投入到OPENFACE 中进行AU 识别,并根据《学习者表情——AU 对应表》(如表3 所示)进行学习者表情分类,基于分类结果开展教学评价。

其中,微课内容取自“Python 编程基础——累加求和”一节,由“导入——新知讲授——测验”三部分组成,模拟完整的教学环节,长度为5 分30 秒。实验对象为10 名初一学生,并且所有学生前期均未接触过该节内容。在观看微课过程中由PC 端自带摄像头对学习者表情进行全程录像,屏幕分辨率为1280×720,平均帧率为15FPS,总共生成4950 帧画面。录像结束后,对每位学习者学习过程中生成的4950 帧画面使用OPENFACE 进行AU 识别,识别结果如图3 所示,该帧截图被检测出AU5、AU25 和AU26,根据表3,该表情符合“惊讶”的分类定义。

图3 OPENFACE 识别结果Fig.3 Identification results of OPENFACE

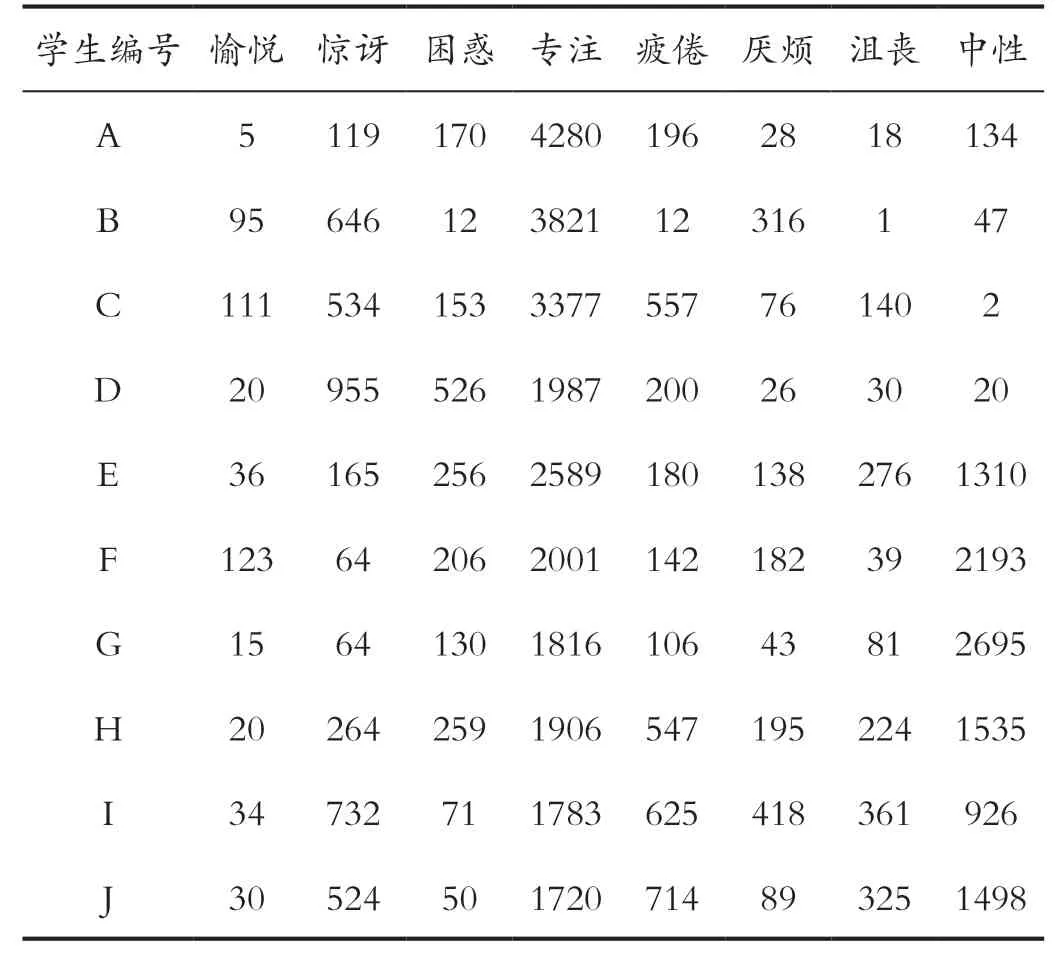

如表4 所示列出了10 名参与者的表情识别结果,为验证学习者表情与测验成绩之间的相关性,将10 条数据按照测验成绩从高到低的顺序排列,学生A 测验成绩最高,学生J 测验成绩最低,分析表4 中数据可得,在测验成绩高者的表情中,专注占据绝对主导地位,反之疲倦、厌烦和沮丧的比例升高。

表4 学习者表情(按测验成绩排序)Tab.4 Learner expressions (sorted by test scores)

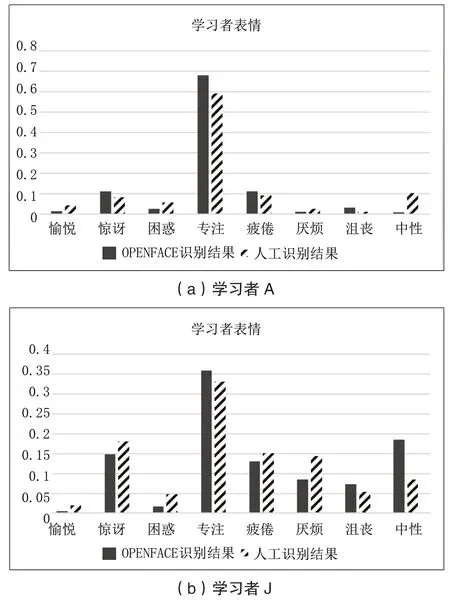

为验证OPENFACE 识别的效果,从表4 中选取两个典型数据——A 和J,将OPENFACE 识别结果与人工识别结果进行对比。在人工识别方面,依据Ekman 的研究结果:情绪的表达持续时间大约为3s[14]。因此,将学生在学习过程中的录像设置为每隔3s 自动暂停,停顿的时间内由人类专家对该段时间中学生所表现出来的表情进行判断。在每个停顿处的判断全部结果之后,统计各表情出现的频率,结合OPENFACE 识别结果,绘制柱形图(如图4 所示,其中图4(a)是学习者A 的对比图,图4(b)是学习者J 的对比图)。

图4 OPENFACE 与人工识别对比Fig.4 Comparison between OPENFACE and manual recognition

用组内相关系数(ICC)评估二者的一致性,图4(a)和图4(b)一致性得分分别为ICC(C,1)=0.962 和ICC(C,1)=0.886,由此可见,OPENFACE 识别结果表现出与人工识别结果的高度一致性,可以用来辅助教师进行学习者表情分类,为评估学生学习状态提供依据。

4 结语

面部表情是分析学生学习状态的重要依据,学习者在学习状态下无意识流露出来的表情具有变化幅度小、持续时间短的特点,无法用宏表情准确刻画,相较而言,Ekman 提出的面部动作编码系统更适合用来分析学习者细粒度表情变化。本文在已有研究基础上,提出了基于建构主义的学习者表情模型,定义学习者表情与AU 之间的关系,引入OPENFACE 进行AU 识别,为教师评估学生学习状态提供了依据,有利于教师基于此制定个性化教学方案,改善课堂教学成效。

引用

[1] 教育部.关于印发《教育信息化 2.0 行动计划》的通知[Z].教技[2018]6号,2018-04-18.

[2] LIU M,SHAN S,WANG R,et al.Learning Expressionlets on Spatio-temporalmanifold for Dynamic Facial Expression Recognition[C]//IEEE Conference on Computer Vision and Pattern Recognition(CVPR),2014:1749-1756.

[3] JUNG H,LEE S,YIMJ,et al.Joint Fine-tuning in Deep Neural Networks for Facialexpression Recognition[C]//IEEE International Conference on Computer Vision,2015:2983-2991.

[4] DING H,ZHOU S K,CHELLAPPAR.Facenet2expnet:Regularizing a Deep Facerecognition net for Expression Recognition[C]//IEEE International Conferenceon Automatic Face & Gesture Recognition,2017:118-126.

[5] YANG H,CIFTCI U,YIN L.Facial Expression Recognition by De-expressionresidue Learning[C]//IEEE Conference on Computer Vision and Pattern Recognition,2018:2168-2177.

[6] EKMAN P,FRIESEN W V.Facial Action Coding System:A Technique for The Measurement of Facial Movement[M].Palo Alto:Consulting Psychologists Press,1978.

[7] CRAIG S D,MELLO S,GHOLSON B,et al.Emotions During Learning:The First Steps Toward an Affect Sensitive Intelligent Tutoring System[C]//E-Learn:World Conference on E-Learning in Corporate,Government,Healthcare,and Higher Education.Association for the Advancement of Computing in Education(AACE),2004:264-268.

[8] KAPOOR A,MOTA S,PICARD R W.Towards a Learning Companion that Recognizes Affect[C]//AAAI Symposium on Emotional and Intelligent,2016.

[9] 高倩.基于RealSense的自发学习表情识别研究[D].武汉:华中师范大学,2019.

[10] 孙波,刘永娜,陈玖冰,等.智慧学习环境中基于面部表情的情感分析[J].现代远程教育研究,2015(2):96-103.

[11] MCDANIEL B,D'MELLO S,KING B,et al.Facial Features for Affective State Detection in Learning Environments[C]//Proceedings of the Annual Meeting of the Cognitive Science Society,2007,29(29):467-472.

[12] BALTRUSAITIS T,ROBINSON P,MORENCY L P.OpenFace:An Open Source Facial Behavior Analysis Toolkit[C]//IEEE Winter Conference on Applications of Computer Vision.IEEE,2016:41-53.

[13] BALTRUSAITIS T,ZADEH A,LIM Y C,et al.OpenFace 2.0:Facial Behavior Analysis Toolkit[C]//IEEE International Conference on Automatic Face & Gesture Recognition.IEEE Computer Society, 2018:59-66.

[14] EKMAN P.Emotions Revealed:Recognising Facial Expression[J].British Medical Journal,2004,328(Suppl S5).