基于POS 数据的无人机高精度匹配定位方法

2023-10-26殷少锋郑献民林宏旭陈光武

郑 锴,殷少锋,郑献民,林宏旭,陈光武

(1.陆军炮兵防空兵学院郑州校区,郑州 450000;2.解放军32146 部队,河南 焦作 454000)

0 引言

无人机具有机动性强、风险小、代价低等优点,无人机侦察已成为现代战争中重要的侦察手段。无人机高精度多目标快速定位,是国内外广泛关注的研究热点,在侦察监视、引导打击、效能评估等领域具有迫切的应用需求[1-3]。当前无人机侦察应用中,存在定位精度不高的技术难题,尤其无人机在高空、大角度、存在操作误差等条件下定位误差较大,难以实现战场精确侦察。

无人机目标定位方法主要包括:基于成像模型的共线定位方法、多点目标定位方法、基于基准地图的目标定位方法等。共线定位方法和多点目标定位方法,应用无人机位置和姿态数据、光电云台姿态等定位定向(positioning and orientation system,POS)数据进行空间解算,受到各种安装误差和测量误差的限制,难以大幅度提高目标定位精度[4-5];基于基准地图的目标定位方法,受到航拍图像与基准图像的范围、尺度、旋转和光照等差异影响,匹配定位的可靠性受到制约[6-8]。为了提高匹配定位方法的性能,许多学者提出了不同的解决方法。文献[9]根据图像序列生成稠密三维点云,通过变换观察视角由稠密三维点云生成与卫星图像拍摄视角相近的虚拟视图,将虚拟视图与卫星图像匹配并得到无人机的地理坐标。文献[10]根据任务规划获取某固定区域的航摄影像,分析了坐标解算及底图生成方法,基于特征匹配算法完成景象匹配,实现航摄影像二维定位。文献[11]利用机载惯性导航信息求解实时图与参考图之间的单应性矩阵,对实时图进行视角变换以减小图像间视角差异,使用改进ORB(oriented fast and rotated brief)算法实现了快速图像匹配。

1 原理架构

基于POS 数据的无人机高精度匹配定位的典型应用场景为:无人机根据设定的任务航迹飞行,无人机任务操作手操控航空相机或光电载荷搜索目标,当发现感兴趣目标时,开启航空相机拍照或控制光电云台锁定跟踪目标,而后应用航空相片或航拍视频帧图像、POS 数据、基准卫星地图或预先拼接图像,实现目标匹配定位,获取任意点的目标精确位置数据,实施侦察监视、引导打击、效能评估等应用。

基于POS 数据的无人机高精度匹配定位方法的原理架构,如图1 所示。具体表述为:1)图像采集。无人机航拍图像包括航拍相片或视频帧图像,当无人机载荷为数码相机时采集航拍相片和POS数据,当无人机载荷为光电云台时采集视频帧图像和POS 数据。基准匹配图像包括具有精确位置信息的数字卫星地图或预先拼接图像。数字卫星地图可通过测绘部门申请或资源下载等形式获取;预先拼接图像可应用预先侦察所获取的航空相片或视频,基于自动空三测量方法获取拼接图像。2)基于POS数据的航拍图像粗匹配。应用无人机和光电云台的位置和姿态数据,基于共线成像方程校正实时侦察图像,获取侦察图像的区域位置,基于区域位置裁剪基准卫星图或拼接图,获取包含侦察图像范围的小区域基准匹配底图。3)基于改进SIFT 特征的图像精匹配。提取航拍校正图像和基准裁剪图像中的SIFT 特征关键点,采用改进SIFT 特征描述符描述关键点;根据暴力匹配(brute force,BF)方法构建初始SIFT 匹配点对;基于特征向量欧式距离、地理位置距离的二次误匹配剔除方法,充分抑制匹配点对的误匹配;而后基于随机采样一致性(random sample consensus,RANSAC)算法计算航拍图像与基准底图的变换矩阵;根据变换矩阵实现图像匹配融合,并依据融合图像的位置信息引导至地理信息系统(geographic information system,GIS),进而获知航拍图像上任意点位置数据和区域态势信息。

图1 匹配定位方法流程框图Fig.1 Block diagram of matching positiong approach process

2 基于POS 数据的图像粗匹配

利用无人机位置和姿态角、光电平台姿态角等POS 参数,基于共线成像方程初步解算出图像中任意点位置数据,实现航拍图像校正。根据航拍图像的四角点位置,确定基准图像的区域范围,减小匹配搜索范围,裁剪出小区域的匹配底图。

2.1 基于共线方程的航拍图像位置解算

基于POS 数据的共线定位方法中使用了像空间坐标系、无人机机体坐标系、无人机地理坐标系、高斯平面直角坐标系等4 个坐标系[5]。各坐标系定义如下:1)像空间坐标系s。原点Os为投影中心,Xs、Ys分别平行于成像面阵外框且与图像显示存储方向一致,Zs依右手坐标系确定,相机光轴为Zs轴;2)无人机机体坐标系b。坐标原点Ob为飞机质心,Xb指右,Yb指前,Zb指上;3)无人机地理坐标系e。坐标原点Oe为飞机质心,Xe指东,Ye指北,Ze指天;4)高斯平面直角坐标系g。

设航空相机或摄像机云台的高低角为α,方位角为β,设无人机的航向角为ψ,俯仰角为θ,倾斜角为γ。根据坐标变换原理,得到不同坐标系之间的坐标变换矩阵。设目标在无人机地理坐标系e 中的坐标为(xe,ye,ze),目标在像空间坐标系s 中的坐标为(xs,ys,-f),f 为相机或摄像机焦距。则两者之间的坐标变换关系表示为:

设目标在高斯平面直角坐标系g 中的坐标为(xg,yg),无人机在高斯平面直角坐标系g 中的坐标为(xa,ya),H 为无人机与地面目标点的相对高度。则基于无人机姿态数据、航空相机或摄像机的姿态数据和内参数等遥测参数,根据成像模型的共线条件方程可得

随着互联网的出现和广泛使用,越来越多传统行业都在与互联网技术结合,形成“互联网+”模式。传统金融行业的借款和贷款业务也在与互联网技术的基础上,形成了互联网金融理财业务和互联网贷款业务。

基于上式,可以求出航拍图像中任意像素点的高斯平面直角坐标。根据航拍图像的像素坐标、高斯平面直角坐标和坐标变换矩阵,应用最邻近插值重采样实现图像校正。正射校正图像可抑制图像畸变、减弱拍摄角度差异等,与卫星地图或预先拼接图像视角类似,从而有效提高图像匹配定位的成功率和精度。

2.2 基于区域位置的基准图像裁剪

数字卫星地图或预先拼接图像的区域范围,远大于单幅航拍图像。为缩小图像匹配区域、减小图像匹配时间,根据航拍图像的四角点位置裁剪基准地图,获取图像匹配的基准底图。根据式(2)可得航拍图像四角点位置分别为(x1,y1)、(x2,y2)、(x3,y3)、(x4,y4),各点的坐标极值(xmin,xmax,ymin,ymax)分别为

共线定位方法求得的位置坐标存在定位误差,为确保航拍图像在基准底图范围内,需要将航拍图像范围适当外扩。如图2 所示基准图像裁剪示意图,设最大定位误差值为l,则可确定裁剪图像的左上角坐标为(xmax+l,ymin-l)、右下角坐标为(xmin-l,ymax+l)。根据裁剪图像坐标进行基准图像裁剪,获得小区域范围的基准底图,实现航拍图像的粗匹配。

图2 基准图像裁剪示意图Fig.2 Schematic diagram of reference image clipping

图像裁剪通常依据像素坐标进行裁剪,需要进行位置坐标与像素坐标之间的坐标变换。设基准图像左上角位置坐标(x0,y0),裁剪图像左上角位置坐标(xs,ys)、像素坐标(rs,cs),x 方向上的图像像素分辨率t1,y 方向上的图像像素分辨率t2,行旋转参数t3,列旋转参数t4,图像上方指北时旋转参数为0。位置坐标与像素坐标变换关系表示为:

3 基于改进SIFT 特征的图像精匹配

SIFT 特征具有旋转、缩放和仿射不变性,对视角亮度变化及噪声具有一定的稳定性[12-13]。结合POS数据辅助高精度匹配定位的场景,改进了SIFT 特征描述,设计基于特征向量欧式距离、POS 地理距离的二次误匹配剔除方法,提高图像匹配定位的成功概率和匹配精度。

3.1 改进SIFT 特征提取和描述

SIFT 特征是一种图像尺度不变特征,利用高斯差分(difference of gaussian,DOG)算子提取关键点,精确确定关键点位置和主方向,生成关键点的局部邻域描述子。

Step 1 SIFT 特征提取。SIFT 特征提取主要包括尺度空间构建、空间极值点检测两个步骤。尺度空间构建的基础是DOG 金字塔,二维图像I(x,y)在不同尺度下的尺度空间表示为L(x,y,σ),可由图像I(x,y)与高斯核G(x,y,σ)的卷积得到。

其中,x,y 分别表示像素点的横纵坐标;σ 代表高斯正态分布的方差。尺度空间中某一个点在周围8 个点以及上下层18 个邻域点中是最大或最小值,就可确定该点是一个极值点。为了提高特征点匹配的稳定性,通过三维二次拟合函数精确确定关键点的位置和尺度。

Step 2 改进SIFT 特征描述。传统SIFT 特征描述主要包括确定关键点主方向、生成关键点特征描述子两个步骤。利用关键点邻域内所有像素点的梯度方向投影,确定关键点的主方向,使关键点保持旋转不变性;而后生成关键点特征描述子,以关键点为中心选取16 个4×4 像素的小邻域,在每个小邻域形成8 个方向的梯度直方图,最终得到一个128 维的特征向量。

针对航拍校正图像与基准图像匹配的应用场景,校正图像与基准底图的视角类似,可忽略确定关键点主方向步骤,直接设特征主方向为0。省略关键点主方向判定,能够提高算法速度,获得更多匹配控制点,提高匹配成功率。

3.2 基于二次误匹配剔除的特征匹配

由于航拍图像和基准图像异源特征的复杂性,SIFT 特征匹配点往往存在大量的错误匹配点对,将可能使无人机匹配定位精度降低,甚至导致匹配定位失败。传统SIFT 特征匹配采用固定阈值的相似性度量,剔除错误特征匹配点,难以适应不同图像的差异性。设计了基于特征向量欧式距离、匹配点对地理距离的二次匹配方法,充分剔除误匹配点对,并结合RANSAC 算法解算出图像变换矩阵。

Step 1 应用暴力匹配方法,确定基准图像和航拍图像之间的初始匹配点对,采用匹配点对的特征向量欧式距离,初步滤除误差较大的匹配点对。计算出待配准图像中匹配点对的欧式距离,求出所有匹配点对的最小和最大距离。若匹配点对距离小于设定阈值的最近和最远距离,则保留该匹配点对,否则舍弃该匹配点对。

式中,xi,k为航拍图像中第i 个特征点的特征向量的第k 个元素;yi,k为基准图像中第j 个特征点的特征向量的第k 个元素;n 为特征向量的维数;di,j为航拍图像第i 个特征点与基准图像第j 个特征点的匹配点对欧式距离;dmax为匹配点对最大欧式距离;dmin为匹配点对最小欧式距离;α 和β 为设定阈值。

Step 2 应用POS 数据计算匹配点对的地理距离,进一步剔除误匹配点对。利用POS 数据计算匹配点对的位置坐标和地理距离,将最大定位误差值作为阈值剔除误匹配点,可适应不同类型的输入图像,提高匹配概率和匹配精度。定义基准图像中特征匹配点Pa的像素坐标(ra,ca)、高斯平面直角坐标(xa,ya),航拍图像中Pb的像素坐标(rb,cb)、高斯平面直角坐标(xb,yb),基准图像中Pa的高斯平面直角坐标可参考式(4)解算,航拍图像中Pb的高斯平面直角坐标可参考式(2)解算。Pa和Pb的地理位置距离k 为

若k<l,即匹配特征点对的地理距离k 小于最大定位误差l,则接受该匹配点对,否则丢弃该匹配点对。

Step 3 依据RANSAC 算法,计算基准图像与航拍图像之间的变换矩阵。通过基于特征向量欧式距离、地理距离的二次匹配方法,有效滤除了误匹配点,减少了RANSAC 的计算量。设航拍图像匹配控制点的像素坐标为(ri,ci),基准图像匹配控制点的像素坐标为(rri,cri),变换矩阵H 表示为

Step 4 根据图像变换矩阵,实现航拍图像和基准图像的图像融合。航拍图像叠嵌在基准裁剪图像上,根据匹配图像四角点位置引导至地理信息系统上,获取航拍图像上任意点精确位置坐标,并可将实时图像与周围环境、历史记录形成对照,输出可视化的目标态势信息。

4 实验验证

针对无人机高精度匹配定位的应用需求,采用Visual Studio 2015、QT5.8、osgearth2.7 开发环境,基于本文提出的匹配定位方法,开发了无人机高精度匹配定位软件。软件界面如图3 所示,主要包括菜单栏、GIS 显示区域、状态显示区域等。

图3 基于共线定位位置引导的测试结果Fig.3 Test result guided by the location of collinear positioning

测试1:侦察视频的匹配定位。无人机任务载荷为光电云台,采集航拍视频帧图像和POS 数据。主要POS 参数为:无人机相对高度为2 000 m,无人机俯仰角1.87°,无人机倾斜角296.2°,无人机航向角0.12°,图像分辨率为1 920*1 080。分别基于共线定位位置引导方法和本文提出的匹配定位方法进行测试,图3 和图4 为测试结果图,表1 为测试结果比较表。

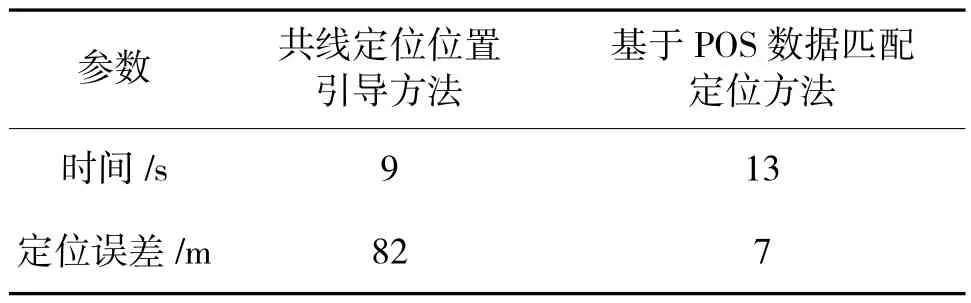

表1 视频帧图像的定位测试分析Table 1 Positioning test analysis of video frame images

图4 基于POS 数据匹配定位的测试结果Fig.4 Test result of matching positioning based on POS data

图3 所示为共线定位位置引导方法的测试结果。依据共线定位方法解算位置坐标,将航拍视频帧校正图像依四角点位置引导至GIS 系统,在GIS中通过移动鼠标获知航拍图像目标点的位置数据,定位解算时间为9 s。可以看出,航拍视频帧图像与基准底图存在一定的位置偏差,位置偏差主要来自于测量误差和计算误差。采集10 个目标点解算出定位误差均值为82 m。

图4 所示为本文提出的匹配定位方法的测试结果。在共线定位解算的基础上,裁剪出小区域的基准底图,基于改进SIFT 特征的图像匹配方法,实现航拍校正图像和基准底图的匹配融合,根据基准匹配图像位置数据,将匹配融合图像引导至GIS 系统,可获知任意点位置数据,定位解算时间为13 s。可以看出,航拍图像精确匹配至基准图像,匹配定位误差较小,定位误差主要来自基准地图误差和匹配误差等。采集10 个目标点解算出定位误差均值为7 m,具有较高的定位精度。

测试2:航拍相片的匹配定位。无人机任务载荷为数码相机,采集航拍相片和POS 数据。主要POS参数为:无人机相对高度为1 110 m,无人机俯仰角2.56°,无人机倾斜角3.55°,无人机航向角183.7°,图像分辨率为4 000*5 000。分别基于共线定位位置引导方法和本文提出的匹配定位方法进行测试,下页图5 和图6 为测试结果图,表2 为测试结果比较表。

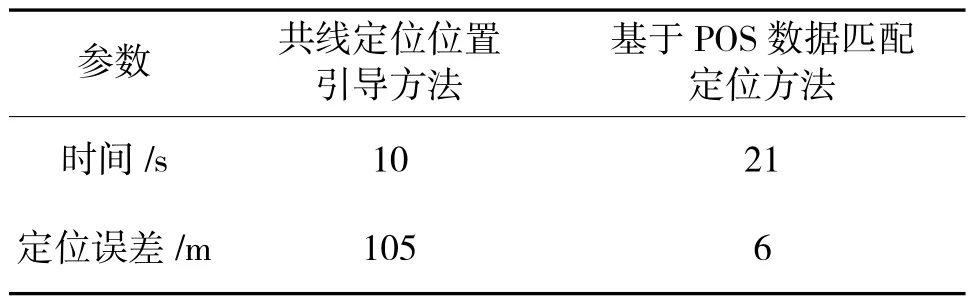

表2 航拍相片的定位测试分析Table 2 Positioning test analysis of aerial photos

图5 基于共线定位位置引导的测试结果Fig.5 Test result guided by the location of collinear positioning

图6 基于POS 数据匹配定位的测试结果Fig.6 Test result of matching positioning based on POS data

图5 所示为共线定位位置引导方法的测试结果。依据共线定位方法解算位置坐标,将航拍视频帧校正图像依四角点位置引导至GIS 系统,在GIS中通过移动鼠标获知任意点位置数据。定位解算时间为10 s。可以看出,航拍视频帧图像与基准底图存在较大的位置偏差,位置偏差主要来自于测量误差和计算误差。采集10 个目标点解算出定位误差均值为105 m。

图6 所示为本文提出的匹配定位方法的测试结果。在共线定位解算的基础上,裁剪出小区域的基准底图,基于改进SIFT 特征的图像匹配方法,实现航拍校正图像和基准底图的匹配融合,根据基准匹配图像位置数据,将匹配融合图像引导至GIS 系统,可获知任意点位置数据。定位解算时间为21 s。可以看出,航拍图像精确匹配至基准图像,匹配定位误差较小,定位误差主要来自基准地图误差和匹配误差等。采集10 个目标点解算出定位误差均值为6 m,具有较高的定位精度。

5 结论

基于POS 数据的无人机高精度图像匹配定位方法,综合应用无人机的POS 数据和图像信息,从原理上克服了定位精度直接受制于导航系统姿态测量误差的问题,并可基于POS 数据提高图像匹配概率和匹配精度。首先利用无人机POS 数据解算出图像区域坐标,获取航拍图像的正射校正图像,裁剪出局部基准匹配图像;而后基于改进SIFT 特征提取匹配点对,基于特征向量欧式距离、地理距离的二次匹配方法剔除误匹配点,实现航拍正射图像和基准图像的匹配融合,匹配后的图像依据位置信息引导至GIS 系统中,获取航拍图像中任意点的坐标数据和态势信息。设计了无人机匹配定位软件,验证了本文方法可实现高精度多目标定位。该方法定位精度高、适应性好、易于工程实现。下一步,将进一步结合更多的测试场景,与多种目标定位方法对比分析,优化提高匹配定位方法的鲁棒性和适用性。