基于EfficientNet的实时目标检测模型

2023-09-04赵昀杰张太红姚芷馨

赵昀杰 张太红 姚芷馨

(新疆农业大学计算机与信息工程学院 新疆 乌鲁木齐 830052)

0 引 言

随着道路交通系统的发展,道路中各种交通工具的数量与日俱增。然而大量的交通拥堵甚至交通事故也随之而来,这给自动驾驶和驾驶员辅助设备等智能驾驶领域的研究带来了巨大的挑战。在车辆行驶过程中目标检测算法作为辅助驾驶员和自动驾驶系统的重要方法,一直受到研究者的关注,其对车辆前方目标的准确检测影响着智能驾驶的安全性。

在过去的几年里,目标检测是一项重要且具有挑战性的任务,得益于卷积神经网络(Convolutional Neural Network,CNN)的发展,大量效果显著的目标检测模型相继出现。目前,大部分精确的模型推演时间较长,这些模型在交通领域大多被用于通过摄像头推荐空停车位等对模型推演速度要求较低的场景。然而,基于摄像头的车辆危险预警等需要模型快速响应的场景,仍缺乏准确且高效的模型。

基于CNN的目标检测算法主要可以分为两类,一类是基于候选区域的双阶段目标检测模型(Two-stage Object Detection),另一类是可实时推演的单阶段检测模型(One-stage Object Detection)。前者将目标检测任务分为两个阶段进行,首先通过候选区域网络选出一组可能包含目标的感兴趣区域,再对这些区域进行进一步分类,从而得到最终的目标检测结果,其中具有代表性的模型有Faster R-CNN[1]、R-FCN[2]、RepPoints[3]等。后者则是直接通过CNN所提取的全局特征直接进行目标的定位和分类,该类模型推演速率要优于双阶段检测算法,但精度有所下降,其中具有代表性的模型有YOLO[4-7]、SSD[8]、RetinaNet[9]等。

在这些基于CNN的目标检测模型中YOLO模型兼顾了推演速度与准确率,但其主干网络(Backbone)与脖颈网络(Neck)效率仍比较低,且模型中缺少具有注意力机制的模块。该类型模块现已大量应用于基于卷积神经网络的计算机视觉任务中,通过融入上下文信息,使模型能提取到更有用的特征信息,并摒弃冗余的特征信息。这些内容的缺失导致网络本身的拟合能力和推演速率受到了一定限制。因此,为构建高效的驾驶场景目标检测模型,本文借助单阶段检测算法的思想,使用EfficientNet-B1[10]对图像进行特征提取,并将提取到的特征图送入空间金字塔池化[11](Spatial Pyramid Pooling,SPP)层和路径聚合网络[12](Path Aggregation Network,PANet)进行特征融合。最终使用K-means算法在训练集中聚类出目标框的先验,并借助这些先验框在多尺度特征融合后的特征图上进行目标框的预测和分类。此外,针对PANet推演速率慢的问题,通过对PANet结构进行改进,提出一种计算量更小的目标检测网络模型,并通过训练技巧进一步提升模型的精度。

1 相关工作

2016年5月,Redmon等[4]提出了单阶段目标检测模型YOLOv1,该模型是YOLO系列的首个模型也是其发展至今的基础。该模型将目标检测任务作为回归问题来处理,通过单个卷积神经网络提取图像的特征图,将模型最终输出特征图中每个像素点看作一个网格,每个网格负责预测中心点落入其感受野的目标及目标的类别,该模型不仅推演速度快,且可以进行端到端的训练。之后Redmon等又在首个YOLO模型的基础上先后提出了YOLO9000[5]、YOLOv3[6],引入了特征金字塔网络[13](Feature Pyramid Networks,FPN)作为脖颈网络,让模型输出的网格融入多个尺度的特征,并在多个不同尺度特征图上进行预测。同时,使用K-means对训练集中的目标框进行聚类,模型预测时在聚类结果的基础上进行缩放以得到最终结果,这相当于引入了先验信息,使训练过程中模型对目标坐标的回归变得容易。YOLOv3的准确率达到了当时实时目标检测的SOTA水平。因此,基于YOLO模型在不同场景中的应用与研究也逐渐增加,如Qi[14]和Wang[15]等在YOLOv3的基础上,对主干网络和脖颈网络结构进行改进,提高了模型的推演效率及精度。Jiang等[16]通过增加主干网络的卷积核个数,提升了网络的检测精度。

2017年8月,Lin等[9]提出了使用焦点损失函数(Focal Loss)的RetinaNet,该模型使用残差网络(ResNet)与FPN的结合输出特征图,并通过两个子网络预测出目标框和类别,该网络通过改进损失函数有效地抑制了类别不平衡问题。

2020年4月,Bochkovskiy等[7]提出了YOLOv4网络,其以YOLOv3为基础,对原始YOLOv3主干网络进行改进,并通过马赛克数据增强(Mosaic)、修改损失函数等技巧,大幅提升了模型的准确率,其准确率已然超越了部分双阶段检测器。

与YOLO模型类似,大部分单阶段目标检测模型都是由三个部分组成的,第一部分是在ImageNet大型图像分类数据集上预先训练的主干网络,第二部分是进行多尺度特征融合的脖颈网络,第三部分是输出预测结果的检测头(Head)。

2 算法模型设计

本文将提出的基于EfficientNet-B1的目标检测模型命名为Eff-InnerStage,其整体结构如图1所示。

2.1 主干网络

在YOLO模型中,使用DarkNet-53作为主干网络提取不同尺度的特征图。随着EfficientNet网络模型的提出,该模型因其能以极少的计算量达到较高的准确率,而备受关注。为保证单阶段目标检测器能在保证精度的情况下进一步提高推演效率,选择计算量较少的EfficientNet-B1作为目标检测模型的主干网络。该网络主要由移动反向瓶颈卷积[17](Mobile Inverted Bot-tleneck Convolution,MBConv)模块和基于通道域注意力的压缩与激发[18](Squeeze and Excitation,SE)模块组成。

传统目标检测模型中,主干网络的结构均可以分为多个阶段,每个阶段均由多个相同的模块组成,主流的目标检测模型中通常将这些阶段的结果作为特征层输出给后续的脖颈网络。然而通过观察不同网络的结构后,发现这些阶段性的特征图维度较小,使用其作为特征层,将影响后续模型的表征能力。以输入为512×512的EfficientNet-B1为例,移除该模型末端分类层后结构如表1所示。

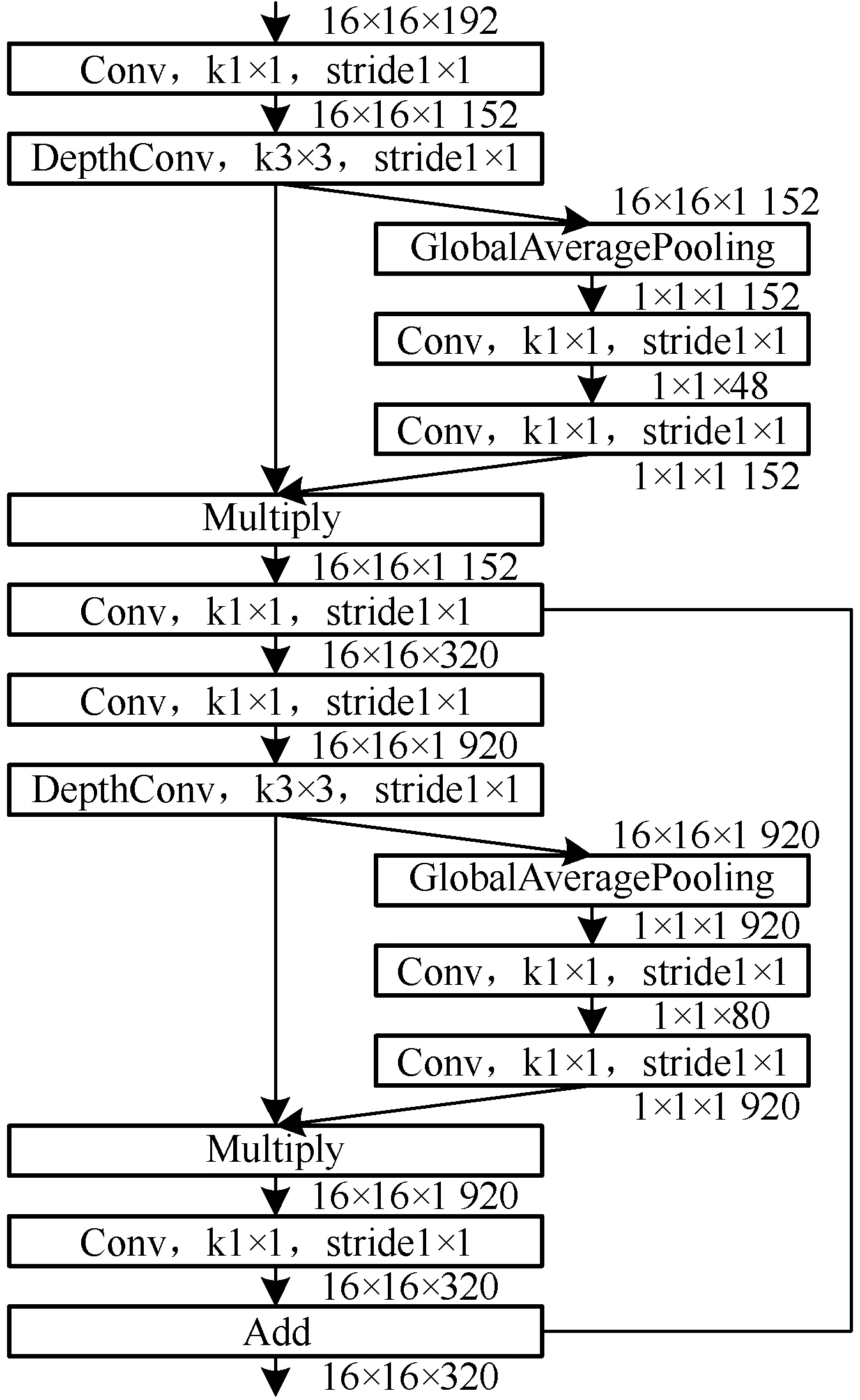

表1 EfficientNet-B1结构表

表1中各阶段的输出特征图维度逐渐增大,但相比于阶段9较小,这一现象必然会导致主干网络输出的高层语义信息明显多于低层位置信息。为在不改变原网络结构的前提下解决该问题,以阶段8为例,将其整体结构展开并省略不影响维度的批归一化层和激活函数层,结构如图2所示。可以看出,相对于整个阶段8输出的特征图维度,在阶段8内部存在着许多维度更大的特征图,最大的特征图维度达到了1 920,是阶段8输出维度的6倍。但在选择特征图的时候只考虑维度是不全面的,如在阶段8中所有输出维度为1 920的模块,均包含在一个短路连接中。因为有旁路的存在,若使用这些模块的输出作为特征图,必然会导致输出的特征有所缺失。综合考虑各方面因素,对于EfficientNet-B1选择其各阶段中第一个卷积层的输出作为候选特征层,该层不含旁路链接且维度相对较大。这种特征选择方式不会改变原主干网络的卷积核数量,便于模型使用预训练权重。

图2 EfficientNet-B1阶段8结构图

为保证不引入过多的计算量,选择EfficientNet-B1中下采样倍数为8、16、32的网络层输出作为主干网络提取的特征图,对应网络中阶段5、7、9第一个卷积层的输出。为验证所述特征层选择方法的有效性,以传统方法选择一组特征层进行对比实验,对应网络中阶段4、6、9的输出。

2.2 脖颈网络

针对街景中目标数量多、尺度大小多样导致检测精度下降的问题,采用空间金字塔池化与PANet的组合对主干网络特征进行融合,并通过引入深度可分离卷积,在保证模型精度不过度下降的同时进一步压缩模型的计算量。

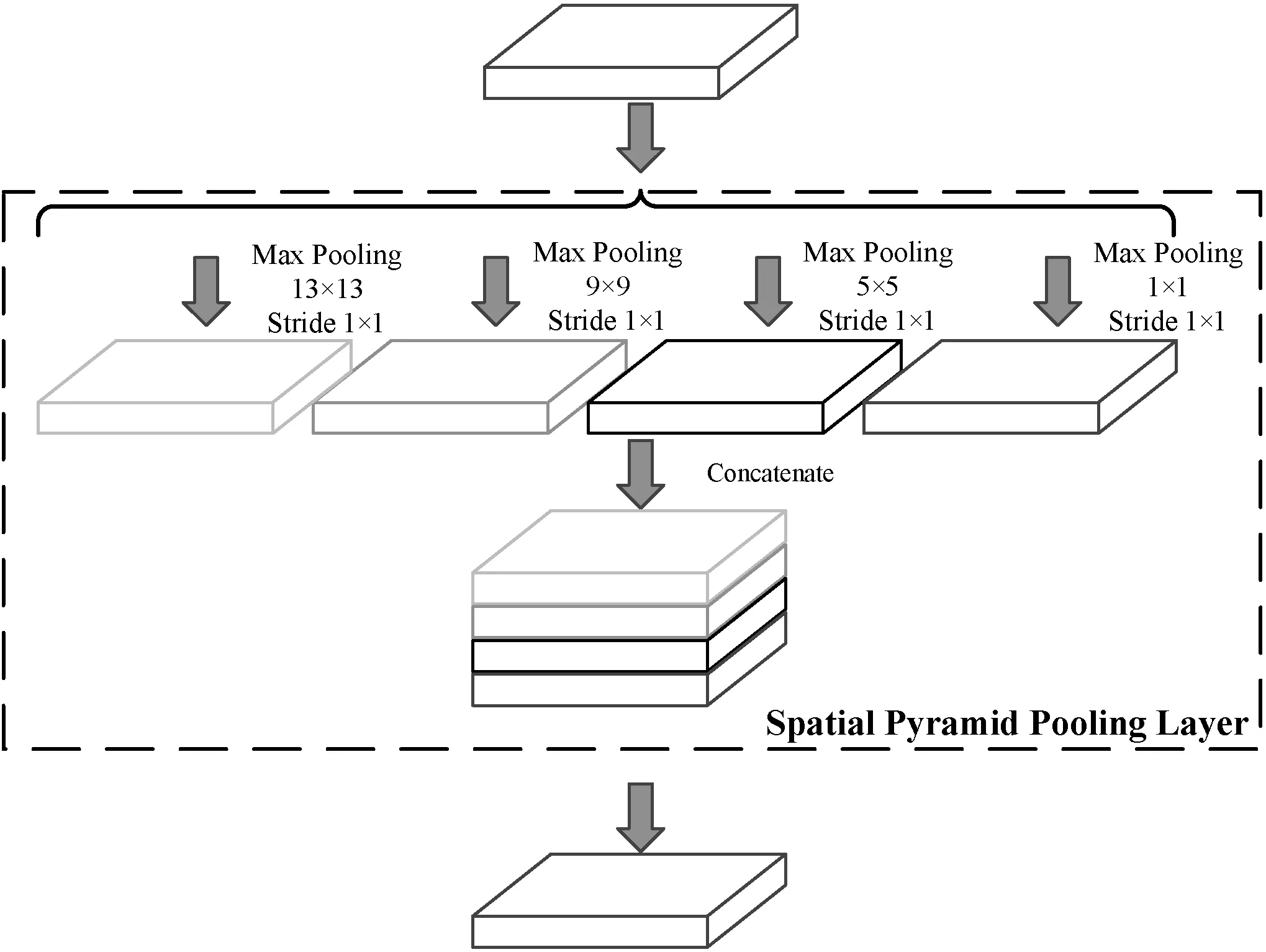

为进一步放大主干网络的有效感受野,借助空间金字塔池化,使用尺寸不同但步长大小都为1的最大池化层,对下采样倍数为32倍的特征图进行多尺度池化,使网络对原始图片中占据区域较大的目标有更好的适应能力,其结构如图3所示。

图3 空间金字塔池化模块图

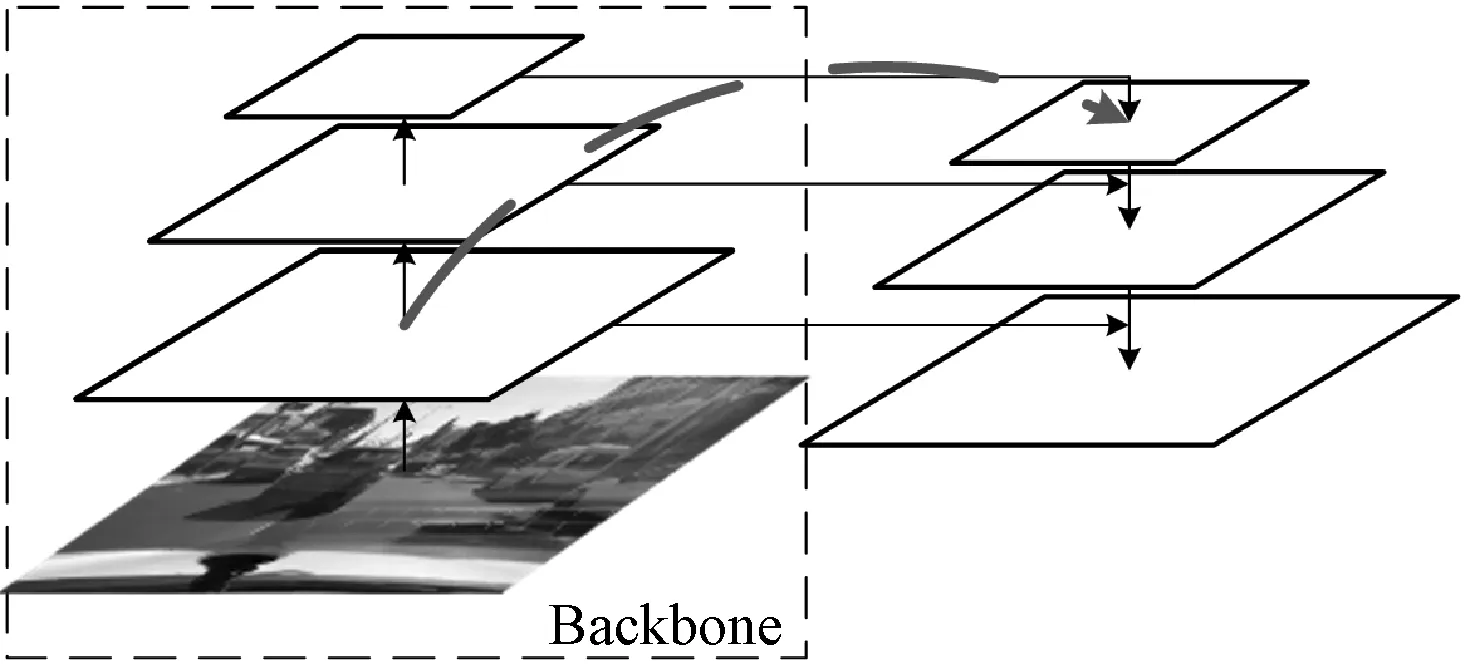

在主干模型中随着网络层数的加深,其语义信息变得越来越丰富,而网络低层中的位置信息却逐渐丢失,对于小目标的检测,网络低层特征往往起着决定性的作用。当前FPN作为脖颈网络被应用于大量目标检测和实例分割任务中,其结构如图4(a)所示,FPN结合了不同尺度特征的信息,通过更丰富的特征表示提升网络整体的表征性能。在FPN中主干网络低层特征比较容易融入高层的语义信息,而主干网络的高层特征要融入低层的位置信息则需要通过主干网络的大量卷积操作后才能完成,如图4中的虚线箭头所示。在车辆行驶场景中经常会遇见聚集的人群和拥堵的车辆,网络低层中精确的定位信息对密集目标检测影响巨大,为此选择PANet作为脖颈网络,其结构如图4(b)所示。PANet中卷积操作的数量要远小于主干网络,因此高层特征更易融入低层特征。如图4中虚线箭头所示,PANet在高层特征和低层特征之间建立了一个快读通道,从而提升模型的整体精度。

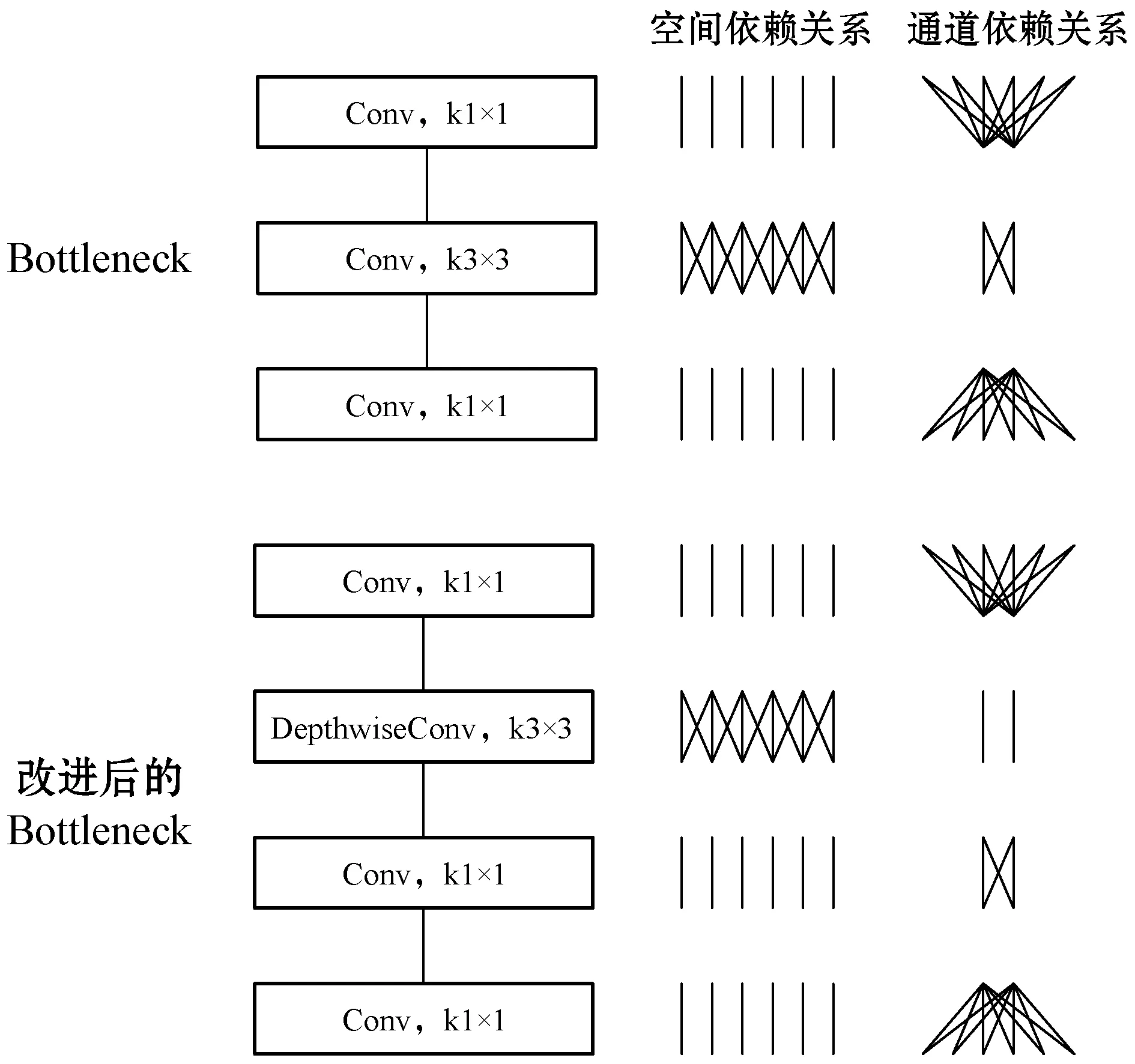

(a) FPN

虽然PANet能为模型带来精度的提升,但其引入的计算量也相对较大,在原始PANet结构中,特征图之间主要使用了瓶颈(Bottleneck)结构来减少计算量,该结构主要由1×1、3×3、1×1的三个卷积组成。首先通过第一个1×1卷积进行降维,以减少接下来3×3卷积所需的计算量,最后再通过1×1的卷积回复维度。该结构虽然可以显著地降低计算量,但3×3的卷积仍然会带来大量计算量。为此,使用深度可分离卷积(Depthwise Separable Convolution)对瓶颈中3×3卷积核进行进一步的优化,改进前后的瓶颈结构及其输入与输出间的依赖关系如图5所示。

图5 改进前后的Bottleneck结构对比图

从改进后的瓶颈结构中,可以看出原结构中的Bottleneck结构被分解为了两部分,直接有效地降低了模型的计算量。但是若无针对性地替换原PANet中的所有3×3卷积操作必然会导致模型性能的大幅下降。考虑到PANet的主要任务是特征融合,对于图4(a)中PANet的每个特征图,若其仅包含一条输入路径,则说明该特征图对特征融合的贡献较少,针对连结这些特征图的瓶颈结构及卷积结构进行改进,最终保证整个模型在拟合不受到过多影响的情况下,大幅降低模型的计算量。

2.3 检测头

模型的检测头主要由两个卷积核组成,其在脖颈网络输出的3个特征图上进行最终的预测,由于使用了基于先验框(Anchor Bases)的目标检测方法,模型预测出的目标框长度和宽度是一个缩放系数,其需要与先验框尺寸相乘才能得到最终的预测大小。该先验框需通过聚类计算得到,将交并比(Intersection of Union,IoU)作为样本点与质心之间的距离计算公式,使用K-means算法对训练集中所有目标框进行聚类,以得到9个不同尺寸的先验框,用于模型的训练和预测。对于预测结果使用非极大抑制(Non-Maximum Suppression,NMS)对预测出的所有目标框进行筛选,以得最终结果。

2.4 损失函数

模型训练时,在YOLO模型损失函数的基础上,引入CIoU损失函数替换原定位损失函数。在对模型预测的定位信息进行损失函数值计算时,YOLO主要使用均方误差(Mean Square Error,MSE)损失函数计算预测框与真实框之间的位置及大小差距,其公式如下:

(1)

Losslocation=1-IoU+RCIoU

(2)

(3)

(4)

(5)

式中:IoU表示对预测框和真实框进行传统的交并比计算;ρ2(b,bgt)表示真实框中心点与预测框中心点之间的欧氏距离;c表示真实框与预测框组成最小矩形的对角线长度;v表示真实框长宽比与预测框长宽比之间的差距;α是平衡参数,该参数在真实框和预测框交并比较小时,缩小v的权重,使模型更注重于中心点和边框长宽的回归。可以看出CIoU损失函数与YOLO的原始定位损失函数相比,考虑了更多因素,能驱使模型预测出定位更加精准且更加贴合目标的预测框,但在梯度回传时式(4)容易出现梯度爆炸和梯度消散问题,其中v对w和h的导数公式为:

(6)

(7)

式(6)和式(7)中w2+h2位于分母位置直接导致了梯度值的不稳定,为了解决这一问题,在计算梯度值时,对原梯度公式进行改进,将式(6)和式(7)同时乘以(w2+h2)以保证梯度的稳定回传。

3 训练技巧

3.1 中心点缩放因子

整个预测流程中,在对目标中心点坐标进行预测时,会对模型的预测结果使用sigmoid函数以得到0~1之间的值,其正好对应了目标中心点在每个网格中的相对坐标。计算公式为:

bx=sigmoid(tx)+cx

(8)

by=sigmoid(ty)+cy

(9)

式中:tx和ty为模型对目标框中心点坐标的预测结果,其需要通过sigmoid计算转化为目标所在网格中的相对坐标,最终通过加入网格索引cx和cy,得到预测框中心点在特征图中的坐标by和by。可以发现sigmoid函数的计算结果起着决定性的作用,但由于该函数本身的特性使其计算结果很难达到接近0和1的值,这一特性必然会导致中心点靠近网格边缘的目标受到影响。当目标中心点预测出现偏移,整个预测框的位置都将受到影响,致使原本贴合目标的预测框出现偏移。在训练过程中模型为了拟合这些位于网格边界的目标,则需要通过放大参数来增大tx和ty的值。尽管放大参数可能会使模型得到相对正确的预测结果,但过大的参数极易引起过拟合问题。为使网络对靠近网格边缘的目标更加敏感,将原中心点计算公式进行如下改进:

(10)

(11)

式(10)和式(11)中引入了系数α,该系数将sigmoid的计算结果进行放大和缩小,使其更容易得到接近或等于0和1的值。这一方法有效降低了模型对目标中心点的拟合难度,尤其是中心点位于网格边缘的目标。同时由于引入的参数较少且计算简单,增加的计算量完全可以忽略不计,α的值通常设置为1.05。

3.2 马赛克图像增强

马赛克图像增强是工业界的研究者在YOLO模型的基础上提出的,在模型训练过程中,将四幅图片通过裁剪拼接的方式组合在一起,相当于把原本属于四幅图片的标签融入了一幅图片中,增加了单个样本中所包含的目标数量,也变相增大了批处理大小(Batch Size),使模型在训练时可以使用较小的批处理大小。但对整个数据集采用该方法会导致原数据集中的大型目标尺寸严重缩减,甚至导致部分本就较小的目标因尺寸过小而不参与训练。最终致使模型对目标的识别准确率下降,故使用概率参数来控制其使用频率。经该方法增强后的图像如图6所示。

图6 马赛克图像增强

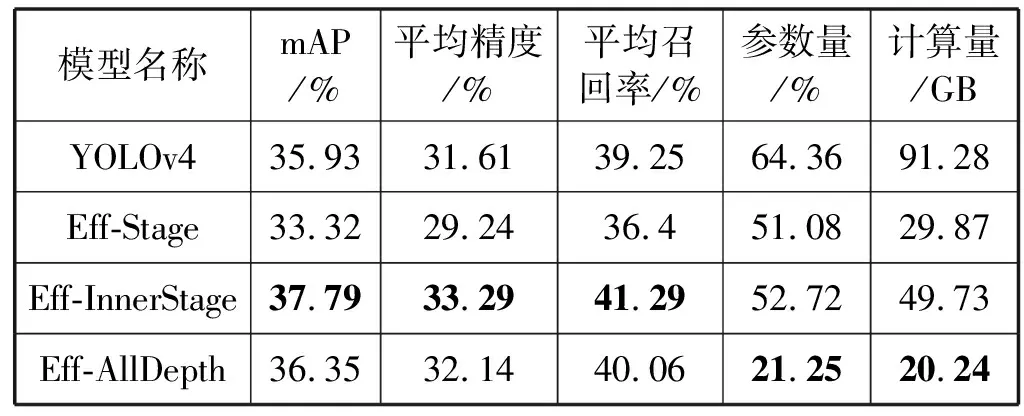

3.3 余弦退火

在使用梯度下降算法对模型进行优化时,损失函数的值通常会随着训练时间的增加变得越来越小。当损失函数值接近全局最小值时,应该使用更小的学习率来保证模型不会因为过度调参而远离最优解,而余弦退火(Cosine Annealing)可以通过余弦函数来降低学习率。在余弦函数中,当弧度值处于0到π之间时,余弦函数首先缓慢下降,接着加速下降,最后恢复缓慢下降,这种学习率衰减模式能有效地提升模型的性能。虽然使用了学习率衰减策略,但在模型训练初期仍需要通过使用更小的学习率来防止梯度爆炸。随着学习率的衰减,本就较小的学习率将随着训练时长的增加变得越来越小,模型的训练速度也将变得越来越慢,甚至止步不前,这导致模型难以收敛到更高的精度,且当模型陷入局部最优解时,由于学习率的不断降低,模型很难跳出局部最优解。为解决这些问题,引入带有预热(Warm up)的余弦退火,在训练初期先对学习率进行放大,当达到预设的最大学习率后,再对学习率进行余弦衰减,这加快了模型的训练速度,让模型在训练时使用更大的学习率,帮助模型收敛至更高的精度。但若在整个训练过程中仅使用一次带有预热的余弦退火来降低学习率,在训练中后期模型仍然会出现落入局部最优解的情况,为此在引入预热的基础上对整个训练周期引入热重启(Warm Restart),其对学习率的调整过程如图7所示。

图7 学习率余弦退火变化曲线

这种周期性的学习率调整模式,可以让模型有效地跳出局部最优解,且随着训练轮数的增加,每个衰减周期的时间会逐渐变长,避免模型因过度震荡而出现无法收敛的情况,保证其能收敛至更好的结果。

4 实 验

4.1 实验环境与数据集

本实验使用的GPU为NVIDIA Tesla V100,显存32 GB。CPU为Intel Xeon Gold 6151,内存64 GB。操作系统为Ubuntu 16.04.3 LTS。

为了评价模型的检测效果,本实验分别使用了BDD100K和PASCAL VOC两个数据集。其中BDD100K数据集主要针对驾驶场景中的10种常见目标,包括行人、汽车、公交车等。每种目标又被细分为被遮挡目标、被截断目标和正常目标。数据集中每幅图片都有三个独立的属性,分别为天气、场景、时段。PASCAL VOC数据集主要针对通用目标检测任务,其包含20类目标,该数据集还对目标是否被截断和是否难以识别进行了标注。针对BDD100K数据集,将其中包含真值标记的80 000幅图片随机打乱,并按9∶1的比例分为训练集和测试集。针对PASCAL VOC,将PASCAL VOC 2007和PASCAL VOC 2012的训练集和验证集进行融合,总计16 551幅图片作为训练集,并将PASCAL VOC 2007的4 952幅图片作为测试集。

4.2 实验参数设置

本实验使用Tensorflow框架,在两个数据集上采取完全相同的训练参数及过程。采用的数据增强手段有随机裁剪、随机缩放、水平翻转、随机亮度、随机对比度、随机色彩饱和度、随机锐度、马赛克图像增强。训练过程分为两个阶段,总计训练50个epoch。第一阶段,首先加载主干网络在ImageNet上的预训练权重,并冻结主干网络参数,对网络的其余部分进行5个epoch的训练,以在训练初期得到较稳定的结果,防止梯度爆炸;第二阶段,将网络参数整体解冻进行训练,直至训练周期结束。

在整个训练过程中,设置批处理大小(Batch Size)为16,输入图像大小为512×512×3。使用SGD优化器,设置初始学习率为0.001;动量值为0.9;衰减率为0.000 5,并使用余弦退火重启对学习率进行动态调整。

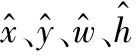

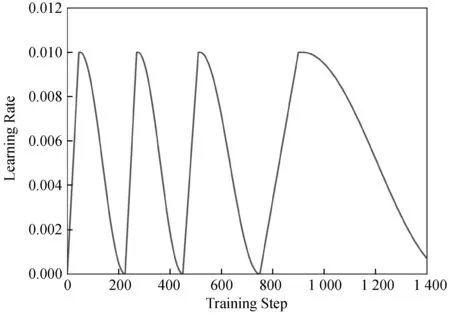

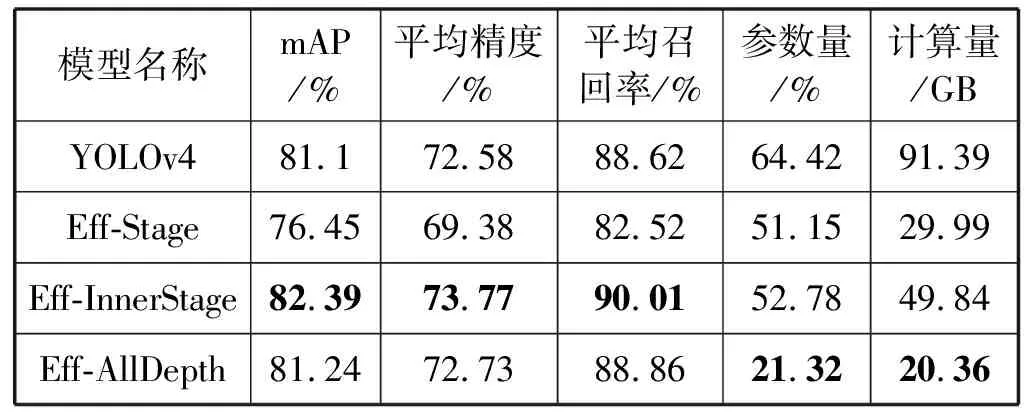

设置四组对比实验。第一组使用复现后的YOLOv4模型结构,训练结果命名为YOLOv4;第二组使用EfficientNet-B1中阶段4、6、9的输出作为特征层,使用SPP与改进的PANet进行特征融合,训练结果命名为Eff-Stage;第三组使用EfficientNet-B1中阶段5、7、9第一个卷积层的输出作为特征层,使用SPP与改进的PANet进行特征融合,训练结果命名为Eff-InnerStage;第四组使用与第三组相同的配置,但将PANet中所有的瓶颈结构均使用深度可分离卷积进行替换,训练结果命名为Eff-AllDepth。所有实验中超参数设置、训练流程与训练技巧均保持一致。最后,为测试所使用训练技巧和损失函数的实际效果,在BDD100K数据集上,使用Eff-InnerStage进行消融实验。

4.3 评价指标

为测试实验中模型的性能,使用与PASCAL VOC相同的评价指标,平均精度(mean Precision)、平均召回率(mean Recall)和mAP(mean Average Precision)作为模型检测性能的评价指标。

在考虑模型精确程度的同时,模型的推演速度和模型所占内存的大小也决定其能否被应用于更多样的设备及场景。对于模型所占内存大小,可以使用参数量来进行衡量。而对于模型的推演速率,以往使用推演时间(Infer Time)和每秒处理帧数(Frame Per Second,FPS)作为衡量指标具有一定的局限性,因为不同的设备之间计算能力各不相同,仅仅考虑推演时间和FPS是不全面的,故使用十亿次浮点运算(Giga Floating Point of Operations,GFLOPs)作为衡量模型推演速率的指标。

4.4 实验结果

模型在两个数据集上的训练结果如表2和表3所示。

表2 在BDD100K数据集上模型的指标对比

表3 在PASCAL VOC数据集上模型的指标对比

可以看出,相比于YOLOv4模型,使用EfficientNet-B1作为主干网络对网络整体性能的提升是比较显著的。

在两个数据集上,Eff-InnerStage模型相比于YOLOv4模型消耗了更少的计算量,但mAP、mPrec、mRec的提升较高。Eff-AllDepth模型相比于Eff-InnerStage模型计算量缩小了29.48 GB,但其精度下降较多,针对速度要求高于精度要求的目标检测任务,可应用该模型。可以看出深度可分离卷积改进后的PANet在减小计算量的同时,仍保持着较好的特征融合能力。然而准确率的提升也取决于主干网络中特征层的选择,如模型Eff-Stage虽然计算量较小,但其准确率相比于其它实验模型过于低下,说明提出的特征层选择方法有效改进了主干网络输出的特征层质量。

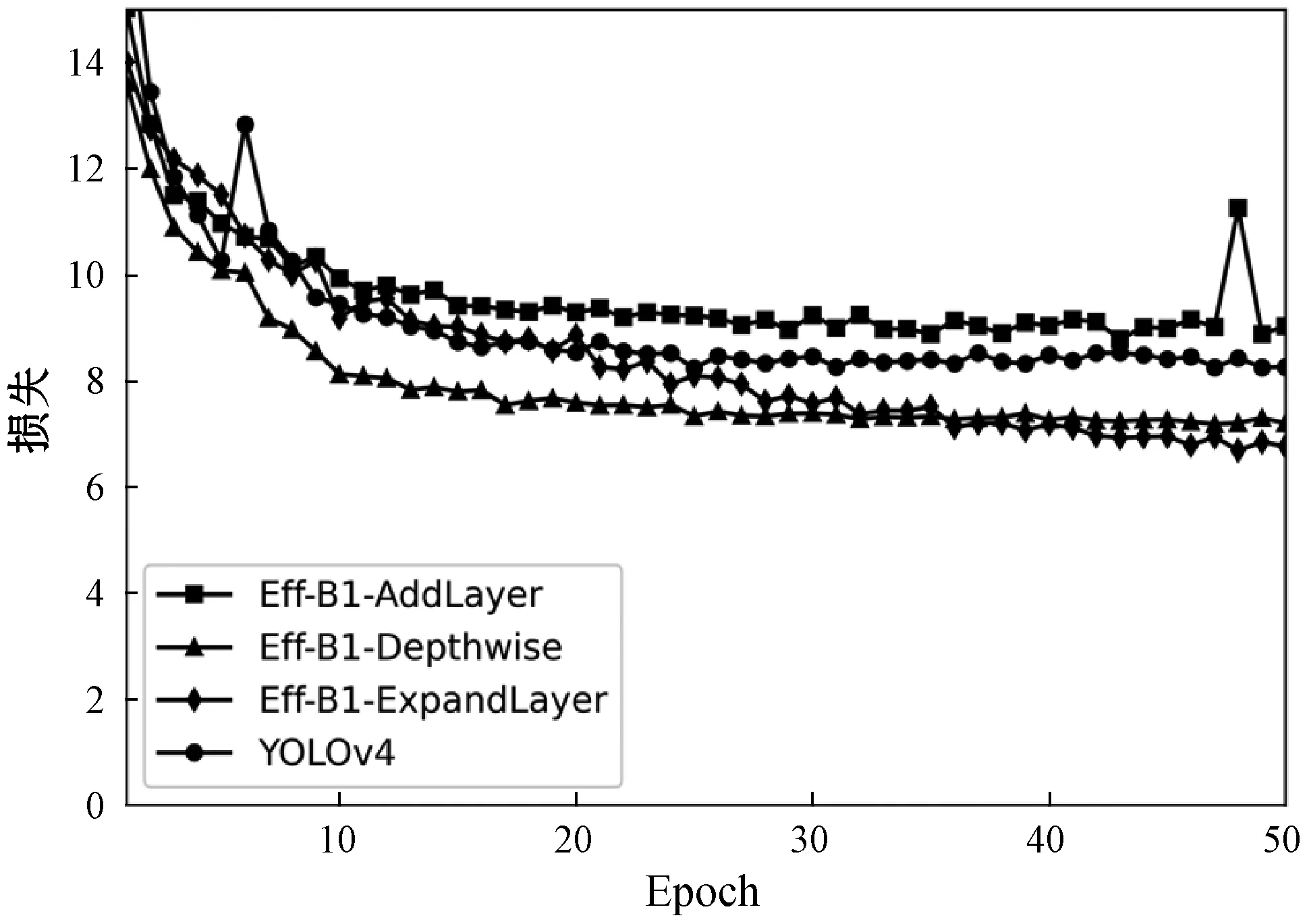

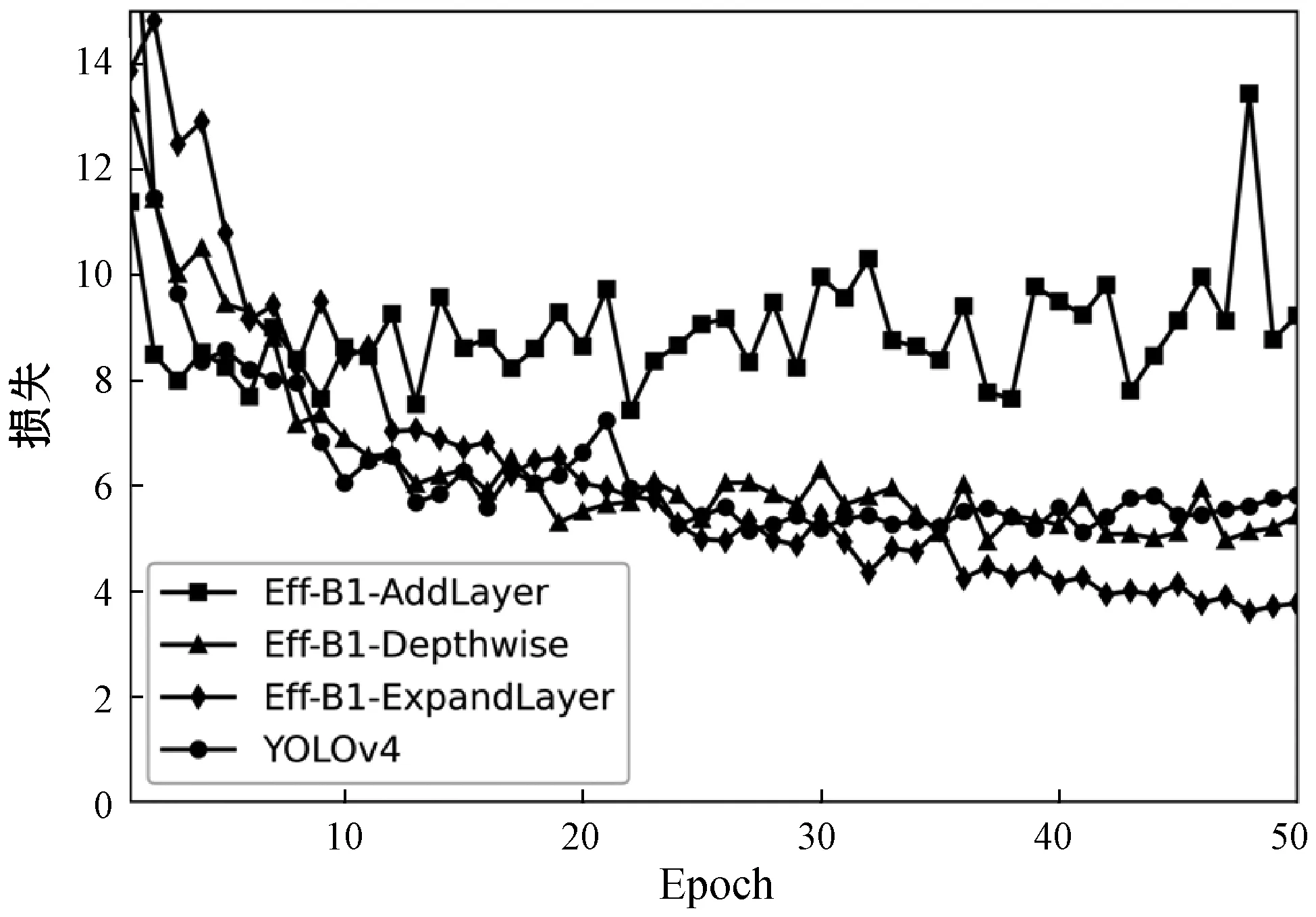

为进一步对比实验中模型的拟合能力和收敛速度,截取训练过程中训练集损失函数值的变化图像,如图8和图9所示。验证集损失函数值的变化图像如图10和图11所示。

图9 PASCAL VOC训练集上各模型的损失函数变化曲线

图10 BDD100K验证集上各模型的损失函数变化曲线

图11 PASCAL VOC验证集上各模型的损失函数变化曲线

在BDD100K数据集上,从损失函数值的变化可以看出,Eff-Stage、Eff-InnerStage和Eff-AllDepth在同样的训练周期中,训练集损失函数值要低于YOLOv4,说明使用EfficientNet-B1作为主干网络是可行的。所有实验模型均可在训练集上快速收敛,这一现象说明了CIoU损失函数能保证模型正常且快速的收敛。对于验证集损失函数值,Eff-Stage的损失值要高于其他模型,Eff-InnerStage损失值最低,这与测试集上的结果相符。在PASCAL VOC数据集上,各模型损失函数值的变化情况与BDD100K的结果相似,Eff-Stage的验证集损失函数随着训练时长的增加,损失函数值由初始的快速降低变为缓慢上升,但该模型的训练集损失函数值却比其他几个模型的损失值都要低,这表明模型Eff-Stage出现了过拟合现象。而实验中其他使用EfficientNet-B1作为主干网络的模型均未出现过拟合问题,故本文提出模型的主干网络特征选择是较合理的。

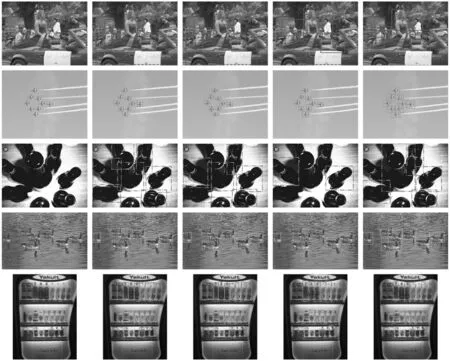

为更直观地展示实验中模型的检测准确率,从两个数据集的测试集中分别选取5幅图片对模型进行测试,并将结果进行可视化展示和对比,结果如图12和图13所示。

(a) 原图 (b) Eff-InnerStage (c) Eff-AllDepth(d) Eff-Stage (e) YOLOv4图12 模型在BDD100K测试图片上的检测效果

(a) 原图 (b) Eff-InnerStage(c) Eff-AllDepth (d) Eff-Stage(e) YOLOv4图13 模型在PASCAL VOC测试图片上的检测效果

图12和图13中相同线型的目标边框表示同一类别的目标,其中(a)是测试集原图,其余每一列图片均来自不同模型的预测结果。观察图12(b)和图13(b)可以发现,Eff-InnerStage模型具有较高的检测精度和普适性,这和训练得到的各项结果相符,也证明了该模型在面对不同规模数据集时均有着较好的检测精度,故针对PANet的改进是有效的。图12中第二、第三行的测试图片分别来自强光直射的白天和光线昏暗的夜晚两种情况,从这两幅图片的检测结果可以看出Eff-InnerStage模型相比于YOLOv4模型有着更好的鲁棒性,其受图片质量的影响更小。对比图13中各模型的检测结果可以发现Eff-InnerStage相比于YOLOv4模型有着更贴合目标的预测框,且对密集的目标更加敏感。

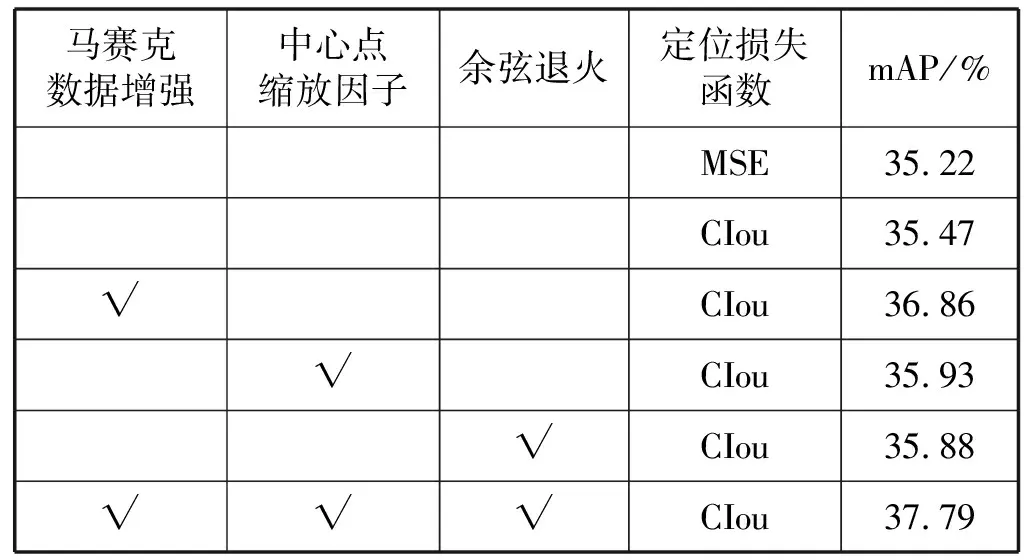

在消融实验中,针对Eff-InnerStage的实验结果如表4所示。

表4 消融实验结果

可以发现在BDD100K数据集上,三种训练技巧均为模型带来了一定的提升。模型Eff-InnerStage使用CIoU定位损失函数替换MSE损失函数提升不明显,但在实验中能加快模型收敛。中心点缩放因子和余弦退火对模型的精度提升较小,然而在训练阶段能为模型的训练提供保证,避免因梯度爆炸和欠拟合问题而导致大量无效实验。马赛克数据增强带来的提升较大,相比于仅使用CIOU损失函数的模型提升了1.39百分点,这表明本文设计的模型是受数据驱动的,可范化至其他检测任务中。最终多种训练技巧的联合使用为模型带来了2.57百分点的精度提升,不仅说明了训练技巧的有效性,也说明了不同训练技巧之间具有一定的互补性。

5 结 语

针对智能驾驶领域的目标检测问题,使用精确高效的EfficientNet作为主干网络,结合SPP与PANet构建单阶段目标检测模型,并通过改进PANet提出该模型的轻量级架构。使用改进后的YOLO损失函数,结合多种训练技巧对模型进行训练。实验结果表明,提出的Eff-InnerStage网络模型以较低的计算量消耗在BDD100K和PASCAL VOC数据集上分别达到了37.79%和82.39%的准确率,并通过对比实验和消融实验证明了网络模型及训练技巧的有效性。