基于RGB-D相机的黄瓜苗3D表型高通量测量系统研究

2023-07-31徐胜勇王成超别之龙

徐胜勇 李 磊 童 辉 王成超 别之龙 黄 远,

(1.华中农业大学工学院, 武汉 430070; 2.华中农业大学深圳营养与健康研究院, 深圳 518000;3.中国农业科学院深圳农业基因组研究所, 深圳 518000; 4.华中农业大学园艺林学学院, 武汉 430070)

0 引言

种苗培育是蔬菜生产的重要环节。种苗表型测量是品种选育、栽培管理、生长建模等研究中必需的重要环节。植物叶片大小是监测植物生长及预测植物生长的重要参数[1-2],而叶面积是衡量叶片大小的重要特征,叶面积对农作物产量构成具有重要作用,是作物栽培和育种实践中常用的指标,对植物的生长发育有着显著影响。真叶数量是判断种苗生长阶段的重要依据,真叶也是植物后期进行光合作用和蒸腾作用的主要器官。下胚轴长、茎粗和株高等茎秆表型参数可以反映种苗的生长状况,是壮苗评价的重要表型参数。当前种苗表型检测方法依赖于传统的人工测量,存在效率低、主观性强、误差大、破坏种苗等问题,限制了数字化育苗的发展[3]。传统依赖于人工的数据采集方式正面临转型升级。计算机视觉和人工智能等先进技术的应用使得无损测量作物表型成为可能。Kinect传感器是一种经典的RGB-D相机,能够同时获取目标的彩色、红外和深度信息,具有成本低廉、体积小巧的特性和优势,使得该传感器在现代农业信息领域获得了推广和应用。

RBG-D相机在点云精度、处理速度和可自动化3方面表现较为均衡,广泛应用于表型测量[4]。RGB-D相机是在RGB摄像头的基础上增加了深度测量,主流深度测量方案包括结构光、飞行时间(TOF)和双目视觉等3种。①结构光:它的基本原理是通过近红外激光器主动发射一定结构光到被测物体,再由红外相机捕捉被测物体表面的结构光图案,再结合三角测量原理计算被测物体的位置和深度信息。这类深度相机主要包括Kinect V1、RealSense SR300/D415/D435、DKam 130和Asus Xtion Pro。文献[5]基于RealSense SR300型深度相机采集褐蘑菇床图像进行原位测量,计算出单体蘑菇的位置、直径、偏向角、倾斜角。文献[6]研究了通过使用RealSense D415型相机,基于深度学习的融合二维彩色图像和深度图像的生菜表型参数(湿质量、干质量、株高、直径、叶面积)高精度估算算法。文献[7]基于RealSense D435型相机建立了棉花生长点三维空间坐标的计算模型,有助于实现棉花生长点的检测和定位。②飞行时间(TOF):它的基本原理是根据发射的红外光脉冲被物体反射返回传感器之间的时间差来测量每个像素的距离。基于飞行时间测距的RGB-D相机主要包括Azure Kinect、Kinect V2、PMD深度相机,文献[8]利用Azure Kinect对南瓜砧木根系表型进行无损测量。文献[9]研究了利用Kinect V2深度相机基于几何模型测量出绿萝叶片外部表型参数,包括叶长、叶宽和叶面积。文献[10]基于Kinect V2相机,通过测量穴盘苗发芽率、株高、叶面积、壮苗指数实现了穴盘苗生长过程的无损监测。③双目视觉:它的基本原理是模拟人眼对周围环境距离的感知,从两部相机拍摄同一景物获得左右两幅视图,进行立体匹配,计算出图像对应点间的位置偏差,从而获取物体的三维信息的方法。基于双目视觉测距的RGB-D相机主要包括ZED、小觅智能S1030-IR-120和Bumblebee2相机。文献[11]提出了一种双目相机结合改进YOLO v3目标检测算法的行人障碍物检测和定位方法。文献[12]将小觅智能S1030-IR-120型标准版双目相机部署在拖拉机前方并结合喷雾机前进速度计算冠层体积。文献[13]通过双目立体视觉拍摄不同视角的拟南芥图像,将二维图像信息重建为三维模型,实现了对作物叶片长度、宽度和茎秆长度的测量,测量误差均在5%以内。

综上所述,基于结构光的深度相机,易受强光干扰且不适合远距离深度信息采集;基于飞行时间的深度相机的分辨率较低,但其运算速度快能够实时测量且功耗较低;基于双目立体视觉的深度相机重建速度快、结构最简单,但其高精度点云需要高性能的图像和稳定的成像环境[14]。而以Kinect为代表的深度相机(RGB-D)在提供深度信息的同时可以生成深度图像,在机器视觉测量领域得到了广泛应用。目前,对于种苗表型的无损检测技术研究相对较少,已经成为限制种苗相关研究的瓶颈。本文以Azure Kinect深度相机为采集设备,以子叶期到2叶1心期共3个生长时期的黄瓜苗为实验对象,开发一系列种苗表型无损测量算法,并研制自动化图像采集平台。

1 材料与方法

1.1 实验材料与数据采集

实验样本为黄瓜,品种为津春4号。样本于2021年12月到2022年1月在华中农业大学园艺林学学院人工气候室培育。温汤浸种,处理后放置在28℃恒温箱中催芽,待90%种子露白后播种到50孔的穴盘,播种前向基质中添加雅苒苗乐复合肥料(1.0 kg/m3),基质中草炭、蛭石、珍珠岩体积比为3∶1∶1。播种完成后将穴盘放置于温室苗床上,昼/夜温度为28℃/18℃,相对湿度为65%~85%。在1叶1心期后喷施1 000倍液莱瑞育苗专用肥1号,培育至2叶1心期结束。共培育10盘黄瓜苗。其中6盘黄瓜苗用于算法设计,另4盘黄瓜苗共197株用于验证算法,其中对子叶展平时期、1叶1心时期和2叶1心时期共 150株黄瓜苗采取破坏性实验进行表型算法验证。

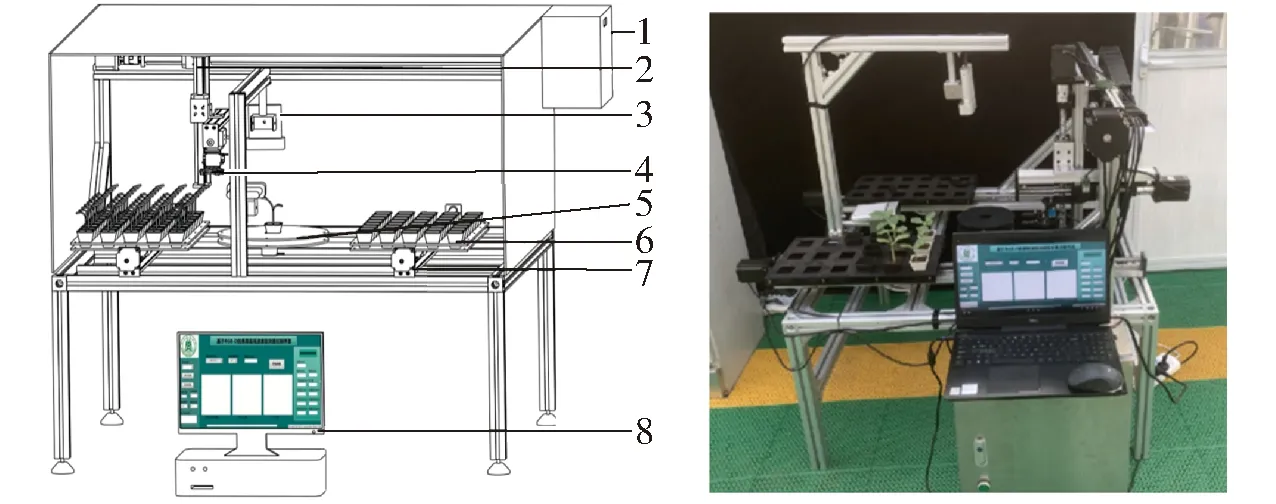

如图1所示,通过使用自动化图像采集平台采集黄瓜苗图像。为了确保获取到高质量的黄瓜苗的彩色图和深度图像,一台Azure Kinect相机被安装在距黄瓜苗正上方25~30 cm,用于获取黄瓜苗的俯视图像序列;另一台被安装在距黄瓜苗正前方25~30 cm,用于获取黄瓜苗的侧视图像序列。自动化采集平台通过机械手夹取分体式苗钵,移动穴盘苗到旋转平台,对黄瓜苗进行俯视视角和侧视视角的图像采集。图像采集完成后,机械手夹取苗钵移动到空穴盘对应位置。本文在SolidWorks、LabVIEW、OpenCV基础上开发了图像处理算法与控制电路。通过基于LabVIEW软件开发的黄瓜苗表型测量软件调用图像采集与处理算法程序,控制两台相机拍摄黄瓜苗,得到4 096像素×3 072像素的彩色图、1 024像素×1 024像素的深度图、1 024像素×1 024像素的近红外图和1 024像素×1 024像素的RGB-D对齐图。使用相机提供的SDK函数,将RGB-D对齐图和深度图转换为3D点云[4]。

图1 自动化图像采集平台设计图和实物图

对采集图像后的黄瓜苗,人工使用直尺测量生长点到基质平面的距离作为株高,测量子叶节点到基质表面的距离作为下胚轴长(精度1 mm);采用数显游标卡尺3次测量茎秆取平均值得到茎粗(精度为0.01 mm);使用Epson Expression 12000XL型扫描仪(爱普生公司,分辨率0.01 mm2)扫描人工采摘并铺平的叶片,得到叶面积数据。

1.2 深度学习使用的训练数据集制作

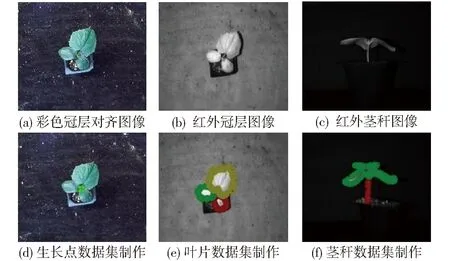

利用自动化图像采集平台,共拍摄了281幅原始图像数据集。为了提高网络模型的精度和泛化性能,将训练集通过数据增强的方式进行扩充。分别通过图像旋转(45°、90°)、亮度调整(0.8倍和1.3倍)、对比度增强至0.8,数据集扩充到原来的5倍,其中训练集975幅,测试集430幅。人工使用数据标注软件对黄瓜苗的近红外图像进行标注,以生成深度学习需要的训练数据集。使用 LabelMe 软件对黄瓜苗近红外图像中的叶片和茎秆轮廓进行标注,只标注未遮挡部分的轮廓,对于一幅图中的同一类标签用不同的顺序进行标注,标注信息将会保存到与原图像对应的json文件中;使用LabelImg软件对冠层RGB-D图像中的生长点用矩形框进行标注,标注信息将会保存到与原图像对应的xml文件中。共制作了1 405幅近红外图、RGB-D对齐图用于网络训练。训练数据集的制作如图2所示。

图2 训练数据集制作

2 黄瓜苗3D表型无损测量方法

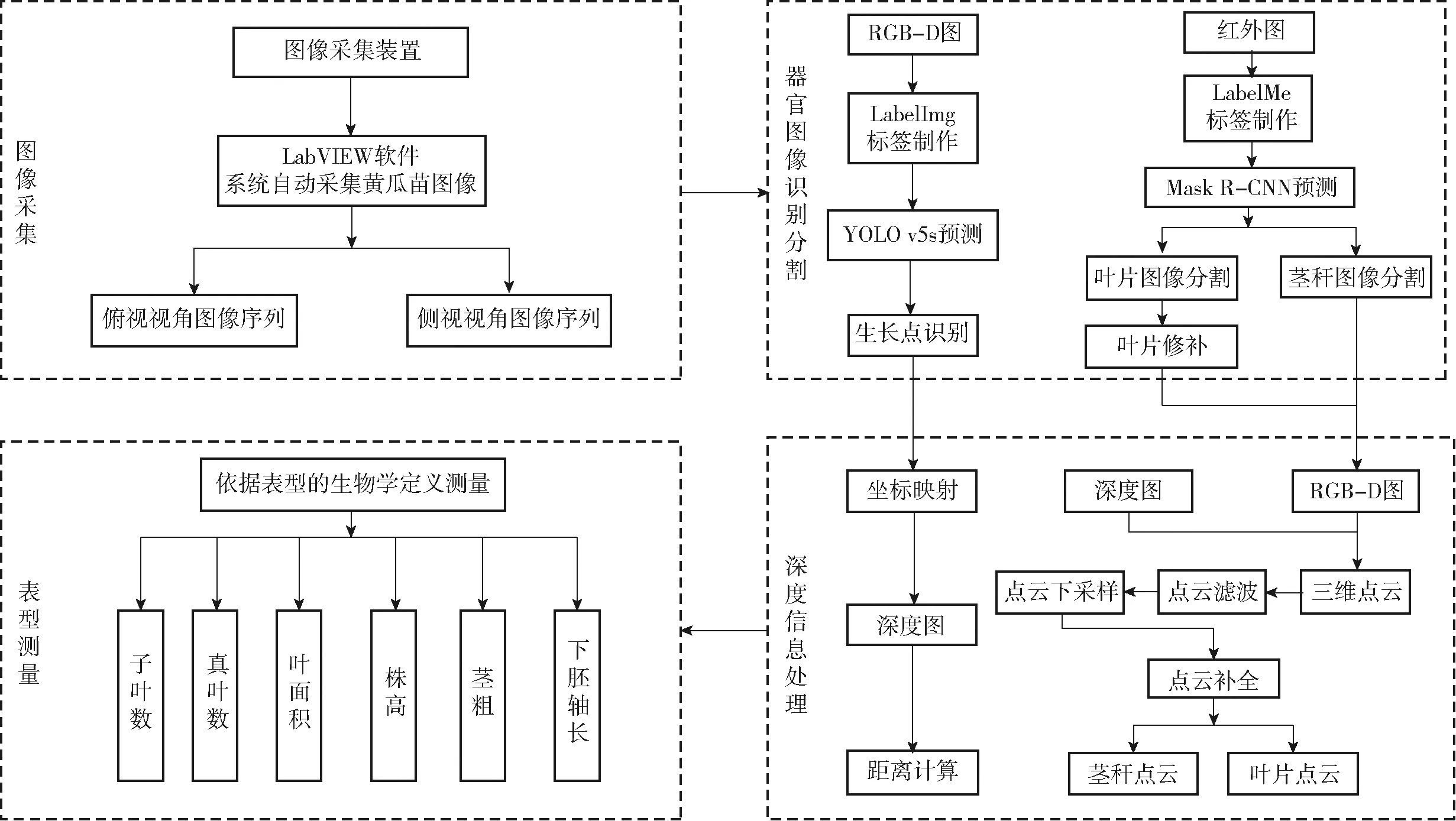

本文技术流程图如图3所示。使用自动化图像采集平台拍摄俯视视角和侧视视角下的黄瓜苗。俯视视角图像用于叶片数、叶面积、株高、生长点等表型参数测量;侧视视角图像序列用于下胚轴长、茎粗表型参数测量。为验证无损测量的准确程度,对无损测量结果与人工测量结果进行了比较分析。

图3 黄瓜苗3D表型无损测量技术流程图

2.1 基于Mask R-CNN的黄瓜苗图像分割算法

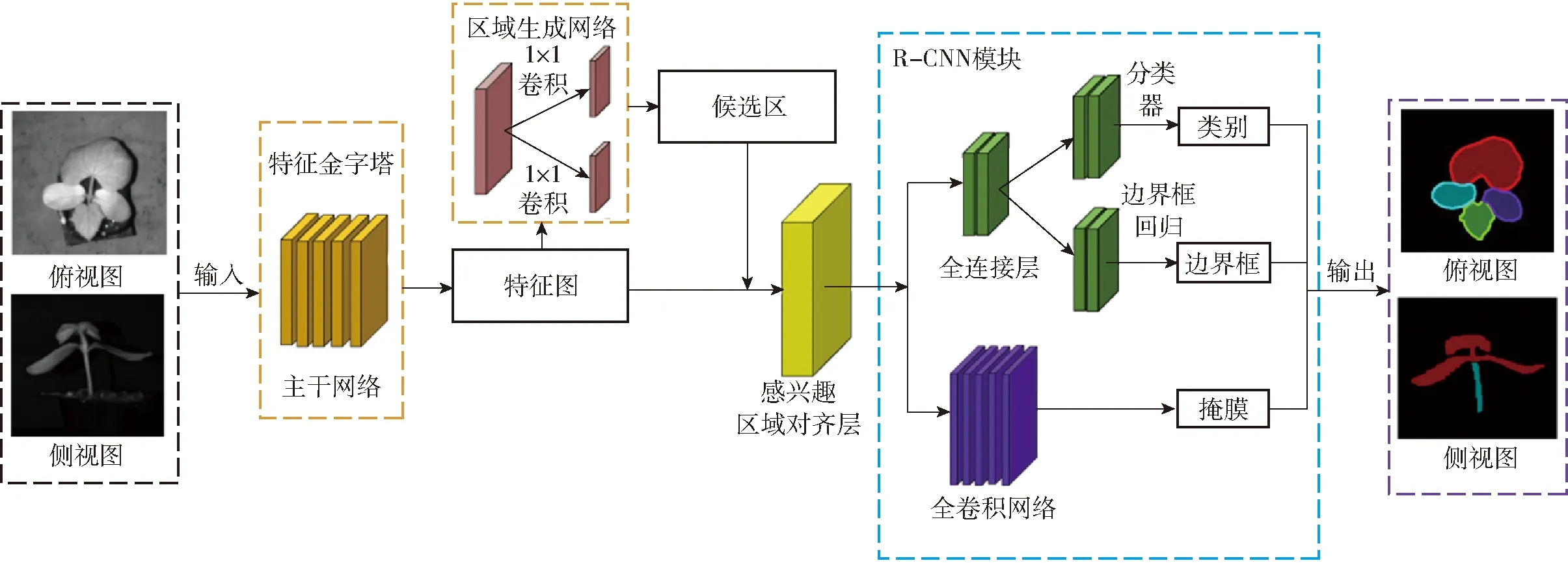

Mask R-CNN是在Faster R-CNN目标检测模型的基础上增加了Mask分支,并用ROI Align改进原有的ROI Pooling模块,解决了Faster R-CNN区域匹配存在误差的问题[15]。Mask R-CNN网络的处理流程如图4所示,Mask R-CNN网络模型由主干网络、区域生成网络、感兴趣区域对齐层和R-CNN共 4个模块构成[16]。主干网络由残差网络和特征金字塔网络构成,对输入图像进行特征提取并生成多尺度特征图,区域生成网络的作用是生成目标候选区域,完成特征图中前后景目标分类和边界框的回归,并获取前景目标的粗略位置;感兴趣区域对齐层是进一步对特征图进行像素校正,然后分别输入全连接层与全卷积网络层;全连接层输出含叶片边缘边界框位置和分类得分,全卷积网络层输出叶片区域掩膜。最后,R-CNN模块综合各分支输出信息,得到一幅包含黄瓜苗器官类别、器官定位边界框和器官分割掩膜的图像。Mask R-CNN深度学习网络模型是在Tensorflow-Gpu 1.13.2,Keras 2.1.5深度学习框架下展开,基于Windows 10 64位操作系统,处理器为Inter Xeon E5-2650,显卡为Nvidia Quadro p4000,训练每次迭代批处理量为1。

图4 Mask R-CNN网络分割叶片和茎秆示意图

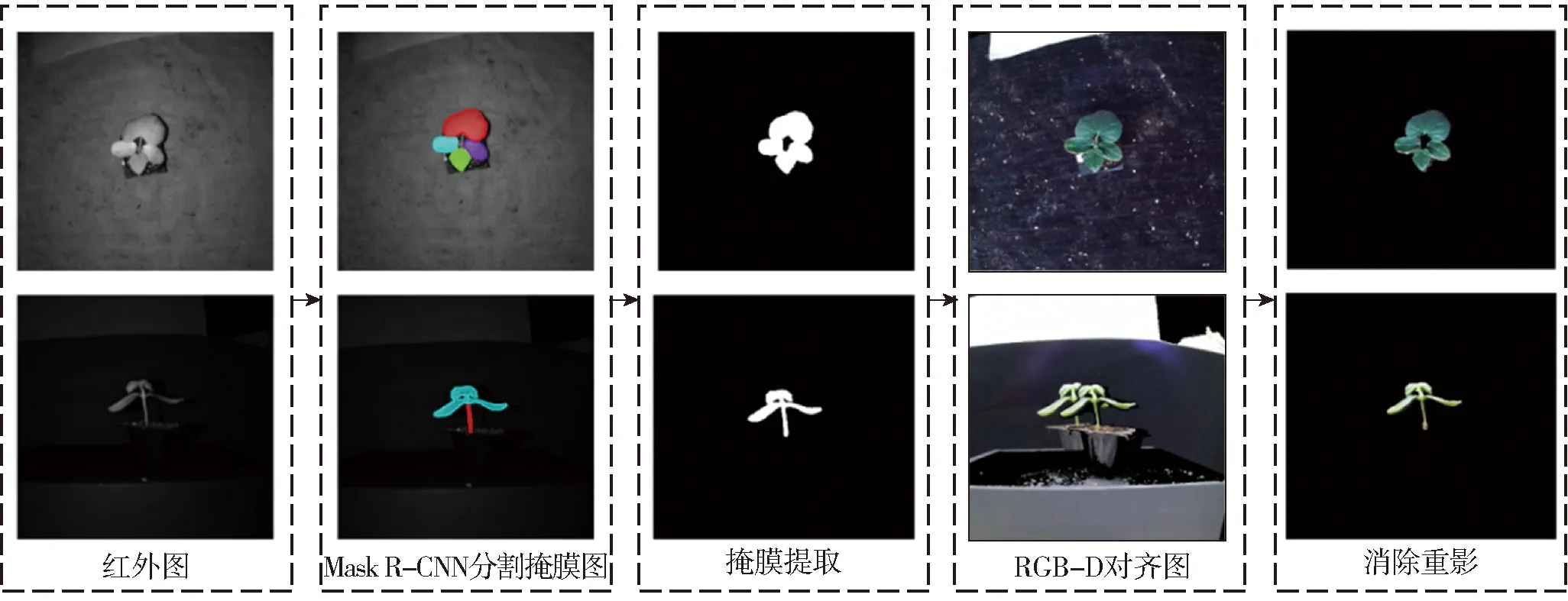

在使用Azure Kinect相机时,由于深度摄像头和彩色摄像头相机间的视差导致使用开源函数Depth_Image_to_Color_Camera进行RGB-D对齐造成明显的颜色映射错误,产生重影。为了解决此问题,本文提出一种改进的RGB-D对齐方法,如图5所示。先对近红外图像使用实例分割网络Mask R-CNN生成预测结果,再对预测结果进行二值化,二值化结果与相机对齐结果进行掩膜,该方法可以得到高质量的对齐结果与器官图像分割结果。

图5 改进冠层、侧视视角RGB-D对齐方法流程图

2.2 基于YOLO v5s网络的黄瓜苗生长点检测算法

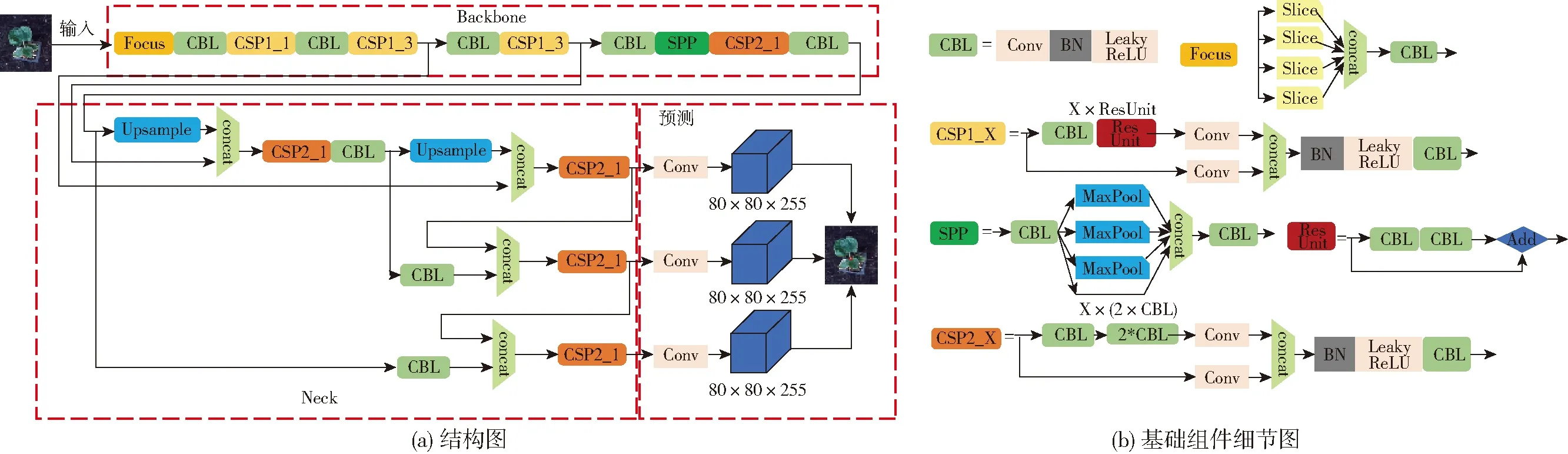

YOLO v5网络模型共有YOLO v5s、YOLO v5m、YOLO v5l和YOLO v5x等4个版本,其主要区别是网络特征提取模块的宽度和深度不同[17]。自动化图像采集平台获取的黄瓜苗图像背景相对简单,生长点与周围坏境相比特征明显,故选用YOLO v5系列中深度最小、速度最快的YOLO v5s网络进行黄瓜苗生长点的检测。图6为YOLO v5s的网络结构示意图。YOLO v5s 在结构上分为 4 部分,分别为:①输入端:将输入图像进行预处理,调整到与网络输入的大小保持一致,进行归一化等操作,通过使用 Mosaic 数据增强提高目标检测的准确性和训练速度。②Backbone:对图像进行卷积和切片操作,用于提取输入图像的特征。③Neck网络:采用 FPN+PAN 结构进一步提高对图像的检测精度。④预测:采用非极大抑制的方法,消除干扰框,用于对目标位置进行预测。YOLO v5s网络模型是在Tensorflow-Gpu 1.13.2,Keras 2.1.5深度学习框架下展开,基于Windows 10 64位操作系统,处理器为Inter Xeon E5-2650,显卡为Nvidia Quadro p4000,训练每次迭代批处理量为1。

图6 YOLO v5s网络预测流程图

2.3 邻域最值滤波改进算法

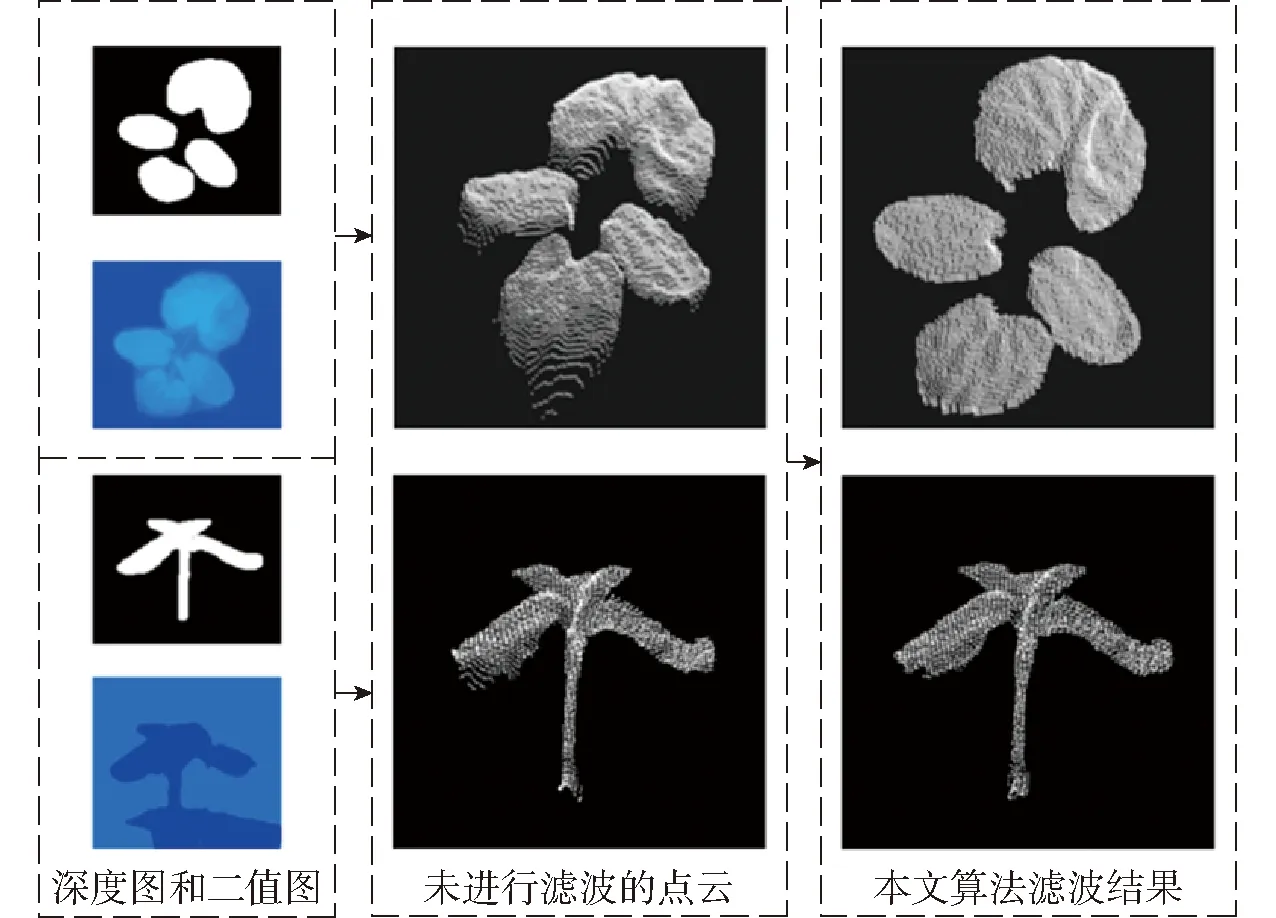

点云中存在背景、离群和悬浮点这3种类型的噪声。对点云进行滤波是提高点云质量和测量准确性的重要环节。背景噪声在上述的改进RGB-D对齐方法中已被消除。离群噪声使用统计滤波[18]去除。悬浮点噪声使用邻域最值滤波方法。然而该方法在有效去除悬浮点的同时也将部分目标点云错误剔除了,这不仅降低了点云质量还影响了测量的结果。因此,本文提出了一种深度图插值法,对邻域最值滤波[4]的结果进行进一步处理,以恢复误剔除的目标点云。主要算法流程包括:

(1)首先,利用训练好的Mask R-CNN模型对黄瓜苗叶片进行分割。

(2)然后,通过遍历步骤(1)叶片分割后对应的深度图,检索非0像素点的位置坐标(xi,yi)。

(3)针对深度图中坐标为(xi,yi)的像素点,计算其像素距离小于等于N的邻域范围内某像素点的深度信息,并计算邻域范围内的最值Zm。

(4)计算并与给定的阈值D比较,若任意一个大于D即判断为悬浮点,令像素点的像素值为0,去除该悬浮点。

(5)重复上述步骤,遍历整幅深度图。

(6)在步骤(5)结束后,同时遍历二值图和深度图,检索二值图中像素值为255、深度图中像素值为0的像素点,搜索其像素距离小于等于M的邻域范围,将距离该像素点最近的像素点的深度信息进行填充。

通过多次实验发现,N为3、D为5、M为5时对黄瓜苗悬浮点的剔除效果最好,能够实现保边去噪的效果。图7展示了改进邻域最值滤波算法的效果,可以明显看出叶片和茎秆点云在边缘处的质量得到大幅度的提升。

图7 改进的领域最值滤波算法效果

2.4 黄瓜苗表型计算方法

2.4.1叶片表型无损测量

Mask R-CNN网络属于实例分割网络,它不仅能够分辨图像中每个实例所包含的像素,也能统计每个类别的数量。本文利用Mask R-CNN网络预测的结果可同时获取子叶和真叶的叶片数量与分割结果。利用Mask R-CNN生成的预测二值图与原图相乘,获得仅包含叶片的图像。再采用本文提出的邻域最值滤波改进算法,获得单片叶片的三维点云。由于本文采用单视角测量黄瓜苗冠层表型,在拍摄时可能会存在叶片的遮挡,叶片遮挡处理有基于点云修复[19]和二维彩色信息修复。本文使用文献[20]提出的一种针对无监督图像翻译的循环生成对抗网络CycleGAN对叶片的二维图像进行修复。因为同种苗的同种类的叶片形状具有高度的相似性,可以使用CycleGAN网络对遮挡叶片进行修复,具体测量流程包括:

(1)Mask R-CNN分割种苗RGB-D图像得到二值图,遍历二值图中像素值为255的像素点,计算其平均深度。

(2)使用CycleGAN网络修复叶片RGB-D图像。

(3)将修复结果的二值图与原分割结果的二值图相减,得到叶片被修复的部分。

(4)将步骤(1)得到的平均深度赋值给步骤(3)的修复部分对应的深度图。

(5)经过以上步骤得到修复后的RGB-D叶片图像和深度图像,叶片的遮挡部分被修复,转换为叶片点云。

将得到的叶片点云进行下采样、点云滤波处理,再使用最小二乘法平滑点云数据,最后采用贪婪投影三角化对叶片点云进行三角面片化[21]。经三角面片化后的叶片由若干个三角面片组成,再利用海伦公式,计算叶片包含的所有三角面片,累加求和后得到叶片面积A,公式为

(1)

其中

(2)

(3)

式中A——叶片面积,mm2

Ai——第i个三角形面积,mm2

a、b、c——三角形边长,mm

pi——第i个三角形周长的一半,mm

n——三角形个数

2.4.2株高无损测量

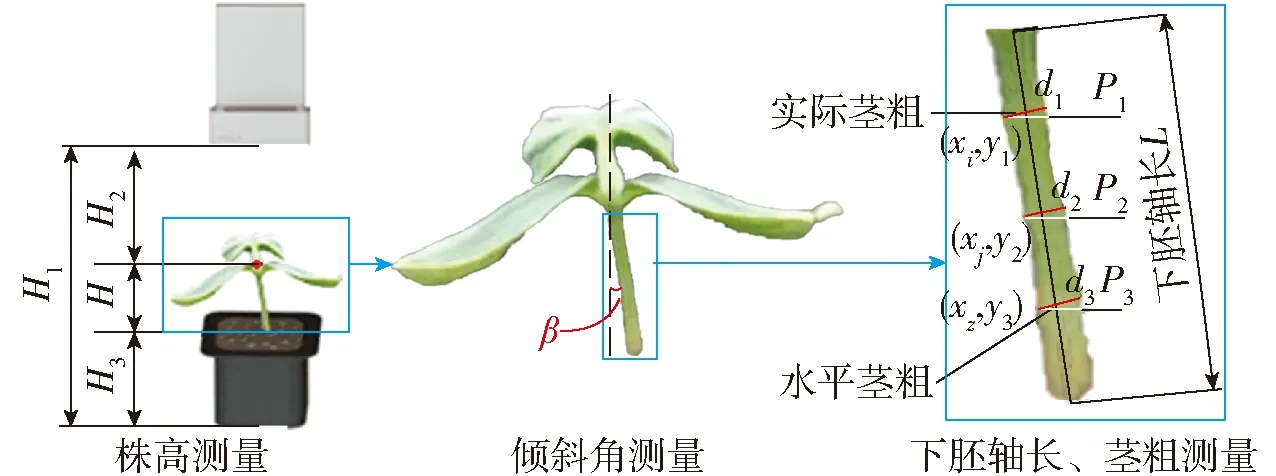

株高是幼苗品质判别的关键因子,株高定义为植株基部至主茎顶部即生长点的距离[10]。单株黄瓜苗株高测量示意图如图8所示。利用训练好的YOLO v5s网络模型识别黄瓜苗的生长点,然后将生长点像素坐标映射到相应深度图中,可以测量出生长点距离相机平面的深度信息H2。为减小因深度相机成像误差对测量精度造成的影响,本文在拍摄前,使用深度相机测量拍摄平面到相机平面的距离H1,使用直尺测量苗钵高度H3。株高测量示意图如图8所示,黄瓜种苗株高计算公式为

图8 茎秆表型测量示意图

(4)

式中H——株高,mm

β——最小外接矩形的倾斜角,(°)

2.4.3茎粗无损测量

茎秆与种苗的生长状况密切相关[22]。黄瓜种苗茎秆较细且在整个生长期间粗细不均匀和Azure Kinect相机精度影响,茎粗无损测量的准确率一直难以得到较高提升[23]。本文为提高黄瓜苗茎粗测量的准确性,首先在测量时选择固定的茎粗测量位置作为测量结果。本文茎粗测量方法是先利用Mask R-CNN对茎秆的分割图使用minAreaRect函数找到茎秆的最小外接矩形,并得到最小外接矩形的参数,包括倾斜角β。之后将茎秆部分4等分并计算等分线y1、y2和y3的y轴坐标,通过测量坐标((xi,y1),(xi+1,y1),…,(xi+n1,y1));((xj,y2),(xj+1,y2),…,(xj+n2,y2));((xz,y3),(xz+1,y3),…,(xz+n3,y3))在深度中x轴方向上的相邻像素点的实际距离并取其平均值作为相邻两点的实际距离。又因为茎秆在生长过程中并不是直立生长的,会由于环境等因素造成茎秆产生不同程度的倾斜,故在y1、y2和y3处的茎粗只是茎秆在水平方向上的茎粗P1、P2和P3,再通过结合茎秆的倾斜角β,由Mask R-CNN提取出的下胚轴区域,即可测量出茎秆的实际茎粗d,茎粗测量示意图如图8所示,茎粗计算公式为

(5)

其中

式中d——茎秆的实际茎粗,mm

d1——y1位置的实际茎粗,mm

d2——y2位置的实际茎粗,mm

d3——y3位置的实际茎粗,mm

devx——x轴相邻像素点的平均距离,mm

2.4.4下胚轴长度无损测量

下胚轴长度是地面与子叶节之间的距离[24]。为准确测量黄瓜苗下胚轴长度,利用Mask R-CNN生成的茎秆的二值图像与原图像进行像素相乘,获得茎秆图像。结合只包含有茎秆的二值图像与深度图像,通过测量y轴方向相邻像素点之间的欧氏距离取平均值获得黄瓜苗的胚轴部位在y轴方向的平均深度距离,再通过对二值图中的下胚轴区域进行骨架提取,计算出骨架所包含的像素数量,根据计算出的深度图在y轴方向上的两点像素之间的平均距离,得到下胚轴长度,下胚轴长度测量示意图如图8所示,下胚轴长度计算公式为

L=Ndevy

(6)

式中L——下胚轴长度,mm

N——骨架所包含的像素数量

devy——y轴相邻像素点的平均距离,mm

3 实验结果与分析

3.1 实例分割网络检测和分割性能评估

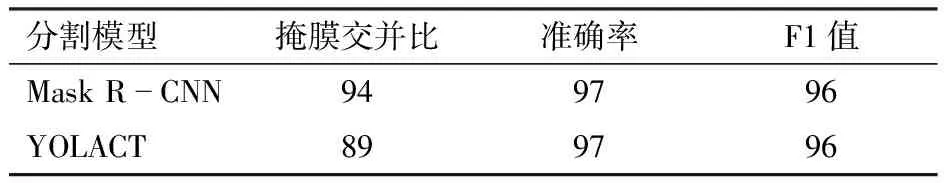

为了更加全面、客观评价分析Mask R-CNN对黄瓜苗器官分割数据处理的可行性,将本文算法与使用场景较多的实例分割算法YOLACT进行实验对比。YOLACT算法是一阶段实例分割算法,即利用网络自身的平移可变性这一特性,生成对不同实例产生不同响应的特征图,将特征图进行线性组合,进而区分不同实例[25]。Mask R-CNN是二阶段算法,即先通过锚框产生ROI区域,再对该区域进行分类、边界框回归和掩膜预测。利用已有的黄瓜苗数据集分别对Mask R-CNN、YOLACT网络进行训练,并将训练好的网络模型在测试集上进行了实验分析。本实验采用掩膜交并比、准确率、召回率和F1值作为模型指标评价黄瓜苗器官分割数据处理结果。算法分割结果和真实结果区域面积的交并比,用以衡量模型器官分割精确度;又因为黄瓜苗的叶片检测包括叶片类型和数量,故采用准确率、召回率和F1值作为模型评价指标。准确率表示在预测中正确预测样本占模型认为是正样本的比例;召回率表示正确预测样本占所有正样本的比例,F1值表示准确率和召回率的调和平均。考虑到真叶对作物生长后续阶段的作用更大,故选用真叶的分割情况作为黄瓜苗真叶分割模型算法性能评估,表1是黄瓜苗真叶分割模型性能评价对比。

表1 黄瓜苗真叶分割模型性能评价对比

从表1可以看出,Mask R-CNN和YOLACT在红外图中对真叶识别的准确率、F1值相同,但在掩膜交并比评价指标下,Mask R-CNN高于YOLACT,而掩膜交并比数值越接近于1,该模型的分割性越好。因此,本文选择了Mask R-CNN算法作为叶片分割算法,可以满足后续表型测量的分割要求。

3.2 叶片表型检测结果与分析

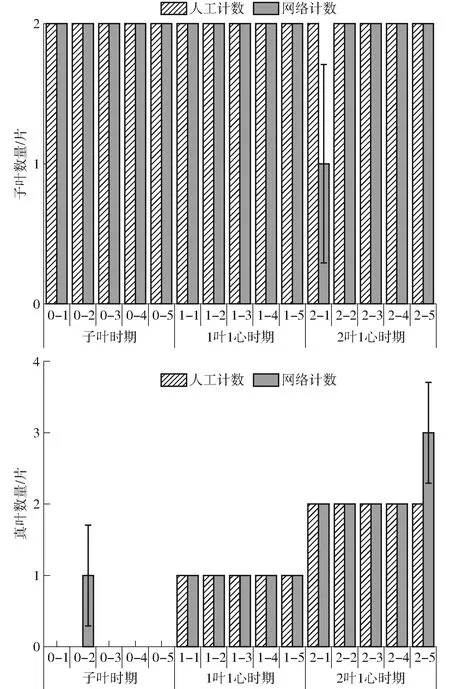

图9为3个生长时期黄瓜苗真叶数和子叶数的算法计算与人工测量结果的对比图。测量结果证明Mask R-CNN网络能够有效对黄瓜苗叶片进行分类、识别、计数。随着生长时期的变化,黄瓜苗叶片数测量产生的误差也增大。误差产生的主要原因是黄瓜苗从子叶时期到2叶1心时期,真叶从发芽到变大变多,导致子叶和真叶遮挡情况的发生,从而造成子叶和真叶的误检测。

图9 黄瓜苗真叶和子叶数量的测量结果

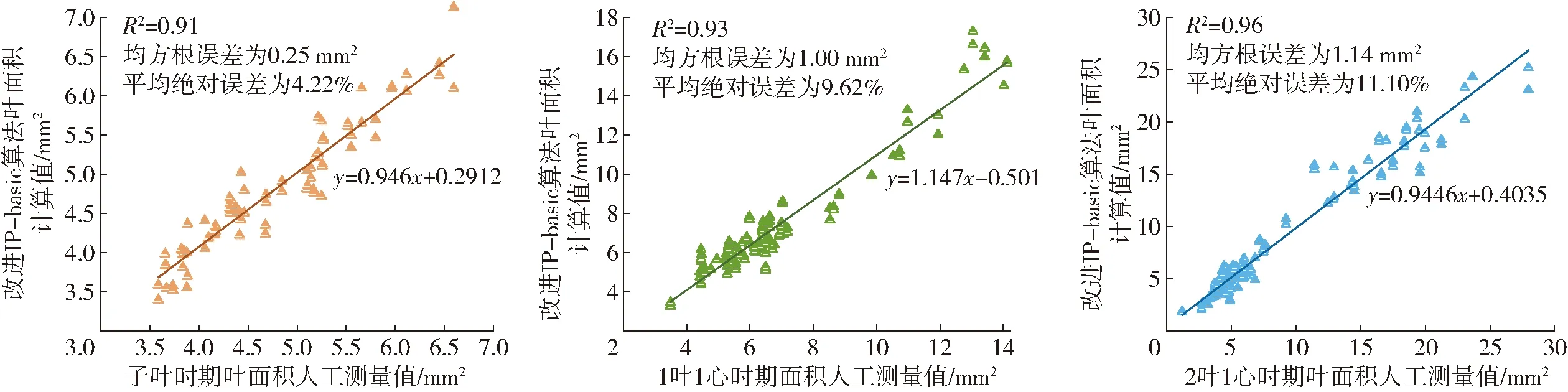

利用冠层视角测量黄瓜苗叶面积时,会因为视角问题,造成子叶和真叶的遮挡。但在大部分的遮挡情况是只存在于子叶的遮挡,又因为黄瓜苗的子叶近似于椭圆形,故先通过改进IP-basic算法[26]利用叶片未遮挡部分的轮廓对子叶进行拟合,并对发生遮挡的子叶利用临近像素间的深度信息恢复其缺失的深度信息。图10为经过改进IP-basic算法对子叶进行椭圆拟合后,真叶未处理,每一片叶面积的算法计算结果与人工测量结果拟合图,叶面积测量结果与真实值相比决定系数R2分别为0.91、0.93、0.96,均方根误差分别为0.25、1.00、1.14 mm2,平均绝对误差分别为4.22%、9.62%、11.10%。

图10 单片叶面积使用改进IP-basic算法计算与人工测量的线性拟合结果

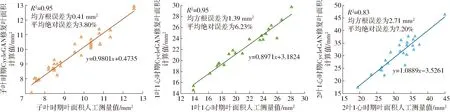

但是,仅考虑子叶的遮挡是不恰当的,在2叶1心时期,黄瓜苗的第2片真叶逐渐变大,可能会造成真叶的遮挡。为了解决子叶和真叶在叶面积测量中的遮挡问题,采用CycleGAN对抗网络修复子叶和真叶的遮挡。图11为经过网络修复的叶面积计算值与人工测量结果拟合图,叶面积测量结果与真实值相比决定系数R2分别为0.95、0.95、0.83,均方根误差分别为0.41、1.39、2.71 mm2,平均绝对误差分别为3.80%、6.23%、7.20%。该测量结果表明,基于CycleGAN修复子叶和真叶,在单视角黄瓜苗测量是可行的。叶面积测量产生误差的原因如下:部分叶片表面与相机成像平面成一个陡峭的角度,导致相机无法捕获反射回的深度信息,造成了叶片点云缺失;在对邻域最值滤波后的点云进行矫正修补时,存在误差,造成了无损测量值的增大;在子叶时期和1叶1心时期,子叶几乎是展平的,但是在2叶1心时期,子叶逐渐弯,导致利用基于CycleGAN叶面积测量时造成较大误差。

图11 CycleGAN修复叶面积与人工测量叶面积的线性拟合分析

3.3 株高测量结果与分析

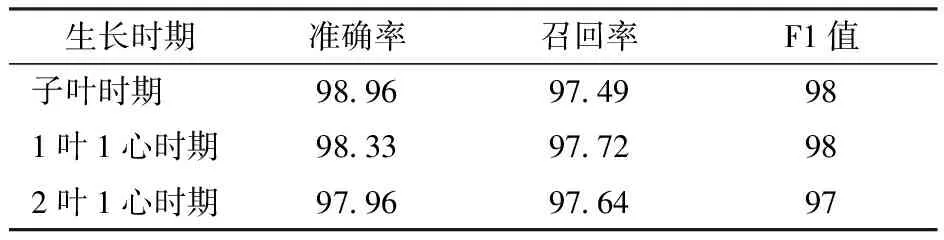

本文通过准确率、召回率和F1值来评价黄瓜苗生长点模型的检测性能,表2为不同生长时期黄瓜苗在置信度为0.7时生长点模型评价数据。通过表2可以看出YOLO v5s对子叶、1叶1心、2叶1心时期的黄瓜苗生长点识别具有较为准确的识别精度。

表2 置信度为0.7时生长点检测结果评估

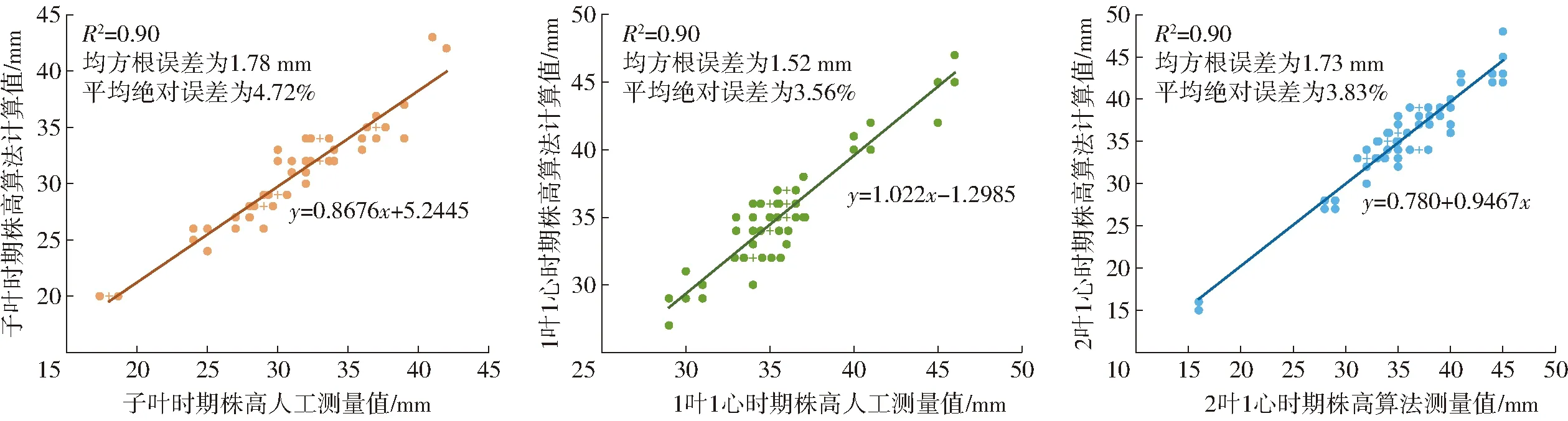

图12为3个生长期黄瓜苗的株高算法计算与人工测量结果拟合图。株高测量结果与真实值相比决定系数R2分别为0.90、0.90、0.92,均方根误差分别为1.78、1.52、1.73 mm,平均绝对误差分别为4.72%、3.56%、3.83%。

图12 黄瓜苗株高算法计算值与人工测量值线性拟合分析

株高产生测量误差原因如下:植物在生长过程中具有趋光性,这导致在整盘育苗时位于穴盘边缘的种苗会出现向光源弯曲生长,这造成了株高测量误差较大;在进行人工测量时,穴盘基质平面不平整导致了测量误差。

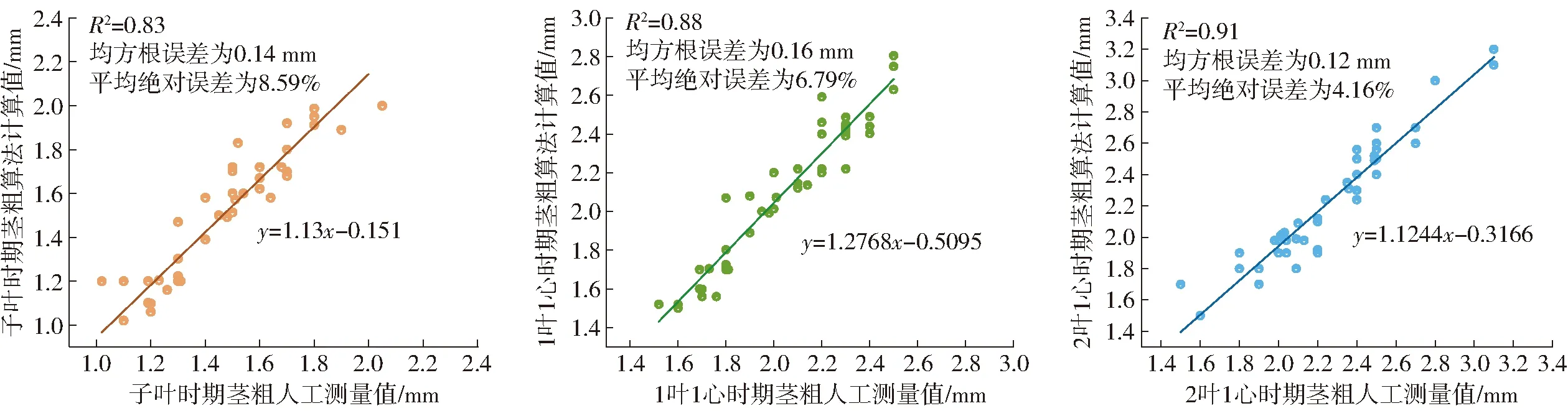

3.4 茎粗测量结果与分析

图13为3个生长时期茎粗算法计算和人工测量结果拟合图。茎粗测量结果与真实值相比决定系数R2为0.83、0.88、0.91,均方根误差分别为0.14、0.16、0.12 mm,平均绝对误差分别为8.59%、6.79%、4.16%。该测量结果表明,算法测量黄瓜苗茎粗误差较大。实验结果虽在误差允许的范围内,但仍需要进一步改善,提高表型测量的精度。

图13 黄瓜苗茎粗算法计算值与人工测量值线性拟合分析

茎粗测量误差主要原因如下:子叶时期的黄瓜苗茎秆部分纤细,一旦获取到的茎秆深度数据缺失一部分,茎粗测量误差就较大;茎秆的横截面类似椭圆,测量结果与相机正对被测苗的方向有关。

3.5 下胚轴长测量结果与分析

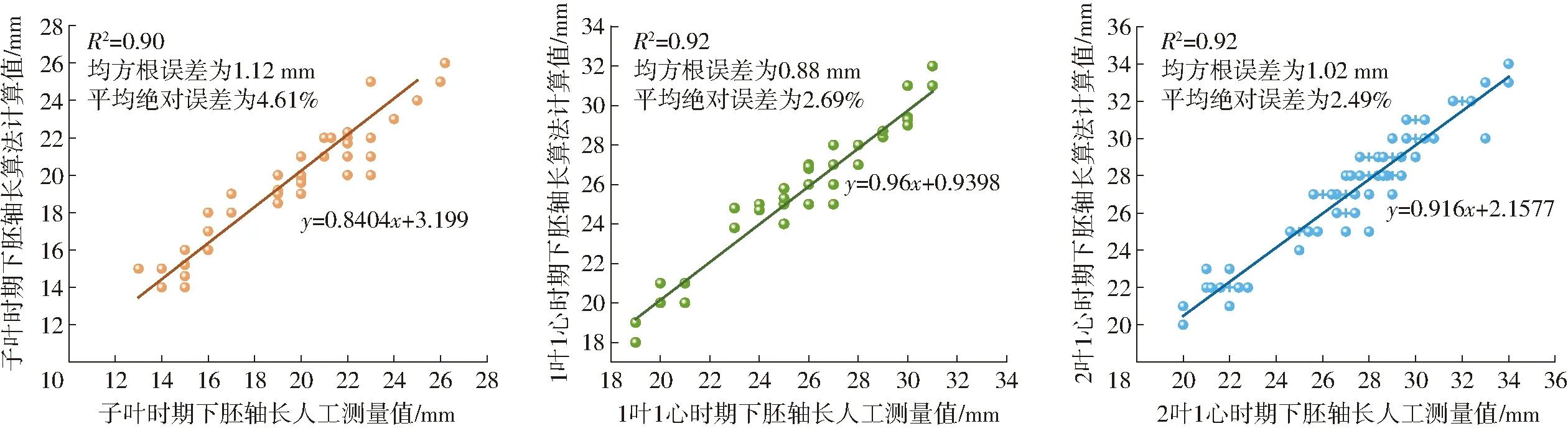

图14为3个生长期黄瓜苗下胚轴长算法计算和人工测量结果拟合图。下胚轴长测量结果与真实值相比决定系数R2为0.90、0.92、0.92,均方根误差分别为1.12、0.88、1.02 mm,平均绝对误差分别为4.61%、2.69%、2.49%。测量结果表明,本研究提出的测量方法精确度较高,可以较好地替代人工测量。下胚轴长产生误差原因:受子叶时期的黄瓜苗茎秆纤细程度和相机精度影响,深度图可能丢失部分深度信息,造成测量误差。

图14 黄瓜苗下胚轴长算法计算值与人工测量值线性拟合分析

4 结论

(1)设计了一套自动化的RGB-D图像采集平台,可以满足自动化的种苗表型检测需求,不仅减轻了图像数据采集的工作强度,还提高了黄瓜苗表型检测的效率,兼顾测量的全面性、精确性和高通量需求。

(2)设计了一系列基于黄瓜苗图像的深度学习分割算法。通过Mask R-CNN网络分割俯视角度下的黄瓜苗红外图,再将Mask R-CNN的分割结果与RGB-D对齐图掩膜,得到RGB-D图像中真叶、子叶的分割结果,其中真叶分割结果的掩膜交并比在0.94以上;使用YOLO v5s网络检测RGB-D图像中的黄瓜苗生长点,置信度为0.7的情况下生长点预测准确率均在97.96%以上。

(3)提出了单株黄瓜苗表型参数的计算方法。针对获取的黄瓜苗三维点云,设计了一系列点云计算方法,通过相关的方法计算黄瓜苗叶片数、叶面积、株高、下胚轴长和茎粗等参数。实验结果表明,本文方法满足种苗科研所需的测量精度要求,可较好地替代人工测量方式。