AI需要被限制吗?

2023-07-20陈冰

陈冰

在史蒂文·斯皮尔伯格导演的电影《人工智能》中,一对因车祸痛失爱子的夫妻收养了人工智能“大卫”。在被人类养育的过程中,大卫渐渐产生了“我到底是一个机器,还是一个人”的困惑。

这背后隐含了一个深刻的哲学问题——机器能够思考吗?

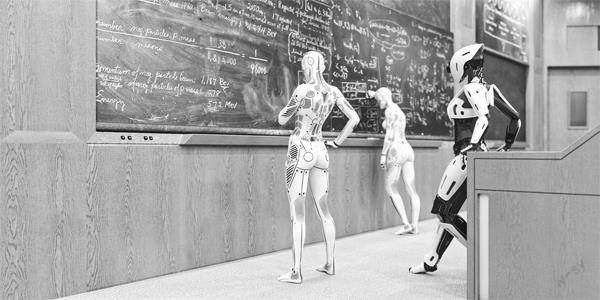

随着AI的快速发展,许多人类自以为机器无法触达的领域正在被机器攻破,以至于国内知名的软件人发出了这样的感慨——人不知疲倦地重复劳动,让自己变成机器;而机器不断地学习提升智能,让自己变成人……

对于人工智能的发展,社会各界的观点目前可大致分为乐观论、悲观论和泡沫论三类。支持“泡沫论”的华裔科学家、斯坦福大学教授李飞飞曾说,不要高估现在人工智能的发展水平,从物理学角度看人工智能,它目前还处于前伽利略阶段。

不管AI目前处于何种阶段,其狂飙突进的技术演进,引发了人们深深的担忧:它催生的是一个更便捷、更快速、彻底解放劳动力的时代?还是一个信息垃圾滔天,人类注意力迅速耗竭的时代?

何为生成式人工智能?

目前,生成式人工智能还没有统一的定义,一般可以理解为一种能够根据提示生成文本、图像或其他媒体信息的人工智能系统。

“这个技术不是像魔法一样凭空出现的,而是有着悠久的历史渊源。”浙江大学公共管理学院信息资源管理系研究员蒋卓人指出,在生成式人工智能90多年的发展历程中,不乏人类智慧闪耀的时刻。

1932年,法国工程师Georges Artsrouni创造了装置“mechanical brain”(机器大脑)。机器大脑通过查询多功能词典完成翻译,输入、输出都是一条纸带。蒋卓人认为,虽然它和今天的机器翻译不同,但它完全符合今天对生成式人工智能的定义,即人类输入一段内容,机器产生一段新的内容。

1956年的夏天,美国达特茅斯学院一群志同道合的学者驱车赴会,畅谈如何利用刚刚问世不久的计算机来实现人类智能的问题。在会议筹备期间,麦卡锡建议学界以后就用“人工智能”一词来标识这个新兴的学术领域,与会者则附议。

20世纪中叶,麻省理工学院创造了最早的生成式人工智能之一伊莉莎,计算机科学家朱迪亚·珀尔引入了贝叶斯网络因果分析概念,人工智能科学家杨立昆等人展示了如何利用卷积神经网络来识别图像……

2006年,李飞飞着手构建数据库ImageNet。该数据库中有超过1400万张手工标注的图片,包含超过2万个类别。正是有了这样一个庞大数据库的支撑,深度学习才能得以兴起。

2022年ChatGPT发布后,成为有史以来用户增长最快的应用。

“AI奠基人”陷入AI恐慌

在复旦大学哲学学院教授徐英瑾看来,生成式人工智能的本质并不困难。

生成式人工智能系统训练方式不得不把“常人”的意见加以建制化与机械化,由此使得社会意识形态的板结现象变得更为严重。换言之,从机器的视角看,一个正确的意见就是被大多数人所认可的意见,因此,少数“异类”提出的“离经叛道”之说在技术上就会被过滤掉。

“这需要我们高度警惕。”徐英瑾强调。

从时间样态上看,“常人”的天然时间标签是“过去”,而“自由”的天然标签则是“未来”,但任何的深度学习机制都必然带有“过去”的时间标签。因为大量的数据收集、喂入与训练都会消耗大量的时间,并由于这种消耗所造成的时间差而必然与“当下”失之交臂,更不用说去拥抱未来了。

作为与杨立昆、约书亚·本吉奥并称为人工智能领域三位奠基人之一的杰弗里·辛顿也表达了类似的担忧。5月1日,这位75岁的图灵奖得主突然宣布从谷歌离职。他在社交平台发文称,他离开谷歌是为了可以公开地谈论人工智能的危险。他表示,对自己的毕生工作感到非常后悔。

辛顿说:“相比大模型,人类在学习速度上并无优势。AI所制造的‘幻觉并不是缺陷,而是特性,编造也是人类记忆的一个特点,这些模型正在做类似于人类的事情,它们现在已经非常接近人类了,将来会比我们聪明得多,我们将如何生存?”

新智能面临新挑战

面对生成式人工智能带来的挑战,世界各国都曾出现过“AI威胁论”。

马斯克就是其中最为有名的一员。今年3月,一份名为《暂停大型人工智能研究》的公开信在未来生命研究所官网上发布。紧接着,5月初,AI领域知名投资人伊恩·霍加斯在外媒專栏中发表了一篇名为《我们必须放慢通往人工智能的速度》的文章,警告AI公司的研究存在“一些潜在的风险”。

霍加斯在文中指出,目前AI研究已经发展到“大模型时代”,若是继续不加管控,让AI按照预定轨迹发展下去的话可能会对地球环境、人类生存、公民身心健康等方面造成威胁。

复旦大学国家智能评价与治理实验基地副主任、大数据研究院教授赵星指出:“科技界曾将人工智能的应用比作炼金术,人们将数据一股脑往模型里面扔,至于能否炼出有价值的东西,炼出的是什么,却没有明确的预期。”很明显,在技术层面上,生成式人工智能存在内生的不确定性。

面对生成式人工智能这个新对手,赵星认为不能沿用传统治理“被动回应外在威胁”的方法。

“我们应当在年轻人的成长过程中,让他们学会如何与人工智能良好共处与规避‘信息茧房,以及如何去做一个智能社会中的‘好人。”赵星说。

内生安全治理模型的原理,是基于群体智能将个体“未知的未知”转化为群体“已知的未知”,从而进一步将其转化为“已知的已知”。

“初步结果显示,虽然现阶段的生成式人工智能远没到能胜任学术评价这样的严肃评价工作的程度,但生成式人工智能表现出的‘跨学科评价能力和‘涌现推断预测潜力值得我们高度关注。”赵星表示。

(摘自《新民周刊》)