基于RFID与目标检测的种鹅个体产蛋信息监测方法

2023-06-30陶雪阳施振旦郭彬彬戴子淳

陶雪阳 施振旦 郭彬彬 戴子淳

摘要:为解决群养种鹅个体产蛋信息监测难度大的问题,提出一种基于射频识别技术(radio frequency identification,RFID)与目标检测算法的种鹅个体产蛋信息监测方法。首先,使用134.2 kHz低频RFID实现无接触获取产蛋种鹅身份信息。其次,引入目标检测算法实时获取种鹅与鹅蛋的位置与数量信息,采用微调训练的方法分阶段训练目标检测模型,以增加模型在小数据集情况下的收敛速度与精度。利用种鹅定点产蛋的行为特点,将图像中每个独立产蛋区域提取为感兴趣区域,实现对每个产蛋区域的独立监测。最后,设计目标计数算法减小计数结果的误差,通过判断种鹅与鹅蛋的数量变化情况,获得种鹅个体开始产蛋时间、结束产蛋时间及产蛋结果。试验结果表明,YOLOv4目标检测模型检测种鹅与鹅蛋的平均精度均值(mAP)为93.59%,种鹅个体身份信息的监测准确率为98.5%,产蛋行为信息的监测准确率为91.3%,符合产蛋信息监测的要求。

关键词:种鹅;产蛋监测;无线射频识别;目标檢测;YOLOv4;目标计数

中图分类号:S126;TP391.41文献标志码:A

文章编号:1002-1302(2023)05-0200-08

我国是鹅生产和消费大国,鹅产业规模总量占据世界的95%,但鹅养殖技术和产业发展水平较低[1]。养鹅业的现代化发展受到鹅繁殖性能的制约,由于鹅应激性较大难以个体笼养而不易准确记录产蛋信息,导致产蛋信息获取效率和准确性低,从而影响了养殖从业者对高产种鹅选育工作的开展。现阶段,自动化监测鸡、鸭产蛋信息的相关研究较多[2-3],而在鹅个体上的相关研究较少,且难以运用在实际生产中。传统的人工记录方法,工作量大,易对鹅造成应激,不满足动物福利要求也降低了生产效益。因此,研究一种适用于群养种鹅个体的产蛋信息监测方法,对提高高产种鹅选育、提高种鹅养殖经济效益、增加畜牧养殖过程自动化具有重要意义。

目前,射频识别技术(radio frequency identification,RFID)与计算机视觉技术被广泛应用畜禽目标检测与行为跟踪,且取得了较多成果。RFID是一种可通过非接触的方式获得目标物体信息的技术[4],常用于获取畜禽的身份信息。目标检测是计算机视觉中的一项基础任务,畜禽的目标分割、行为跟踪、关键点检测等均以目标检测为基础。以YOLOv4目标检测算法为例,该算法使用多种方法提高检测模型的检测精度与速度,能较为准确地预测目标的位置信息,在工农业与科研领域均有应用[5]。在家禽产蛋监测研究中,有学者采用RFID技术对产蛋鹅个体的产蛋行为进行自动化记录[6-7],将RFID与光电传感器结合实现种鹅、蛋鸡的产蛋自动监测,配合嵌入式控制器,以较低的成本实现产蛋信息的监测[8-9],以及使用YOLO v4目标检测模型自动监测鸡舍中鸡的行为,并根据视频图像时序提取出超过时间阈值的行为[10],利用摄像机与多种深度神经网络实现畜禽行为自动跟踪[11-12]。上述方法均表明,RFID与计算机视觉方法对实现家禽目标检测与行为跟踪有较好的效果。但由于家禽行为的复杂性与不确定性,使用单一的技术方法难以实现较高的准确率,以至于现有的种鹅产蛋信息自动化监测的相关研究无法兼顾产蛋信息获取的准确率与效率[6]。

本研究以产蛋期的种鹅为对象,在已有研究的基础上,将RFID与基于深度神经网络的目标检测方法相结合,并设计相关的算法,旨在实现对小规模群养环境下的种鹅个体产蛋信息的监测。

1 种鹅个体产蛋信息监测方案构建

1.1 监测流程设计

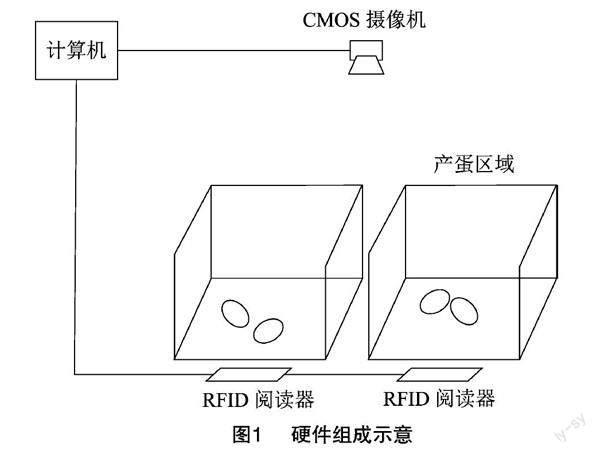

种鹅的产蛋信息包括种鹅个体身份信息与产蛋行为信息,即种鹅个体身份、开始与结束产蛋时间、产蛋结果。种鹅具有定点产蛋的行为特征,根据该特征,所设计的产蛋信息监测方法包括硬件部分和模型部分,硬件主要包括计算机、RFID模块、支持红外功能的互补金属氧化物半导体(complementary metal oxide semiconductor,CMOS)传感器摄像机,及独立的产蛋区域。该方法的工作原理为:由摄像机获取包含产蛋区域的图像信息,并由目标检测算法与目标计数算法分别对每个产蛋区域种鹅、鹅蛋进行计数,根据产蛋区域种鹅与鹅蛋数量的变化得到产蛋行为信息,并由RFID模块获取对应的种鹅身份信息,并将以上信息记录至数据库。种鹅个体产蛋信息监测方法的硬件组成见图1。

模型部分包括基于深度神经网络的目标检测算法(YOLOv4)、目标计数算法。目标检测算法对图像内的目标物体进行检测分类并标记出高于置信度阈值的目标,并给出目标在像素坐标系下的位置与边界框信息[13-14]。种鹅个体产蛋信息监测工作流程如图2所示,它是对单个产蛋区域内种鹅个体产蛋信息的监测流程,流程出口在任意位置均可。

1.2 RFID通信方案设计

为获得种鹅身份,将电子标签佩戴在种鹅的脚上,RFID阅读器与天线放置在产蛋区域的下方。本研究采用低频阅读器,频率为134.2 kHz,最大识别距离为10 cm, 该距离可有效避免电子标签的误读、信号干扰的问题。实际脚环距离阅读器的距离为7~8 cm,符合阅读器的工作距离要求。

考虑RFID阅读器与计算机的通信便捷性,采用基于Modbus RTU通信协议的RFID阅读器[15],阅读器型号为KEZLIY-JY-L860-485M。将多个阅读器通过RS485总线连接至计算机(图3),将硬件通信与目标检测算法结合,当检测到目标则发送消息帧至阅读器,返回代表种鹅身份的脚环信息,即完成一次通信。

2 监测模型构建

2.1 数据集采集

试验数据集采集自江苏省农业科学院六合基地禽场,采集对象为小规模群养环境下,正处于产蛋期的扬州鹅,固定拍摄距离,使用摄像机录制处于产蛋区域的种鹅与鹅蛋的视频,由于鹅舍内日夜光照条件不同,夜晚采集的图像为红外图像,细节特征与白天相差较大。因此,随机取不同时间段的图像信息,以保证数据集同时包含夜晚与白天的图像,并在数量上保持相对平衡。最终共采集种鹅与鹅蛋图像1 100张,将图像尺寸由1 920×1 080像素裁剪为1 056×704像素,并使用LabelImg工具对种鹅与鹅蛋以VOC数据集格式进行标注。

2.2 数据增强

数据增强可有效增加数据集的丰富性[16],本节对数据增强方式进行设计。为减少使用缩放造成的尺度变化,未采用YOLOv4使用的Mosaic数据增强方法,而是采用仿射变换、裁剪、亮度变化、翻转的方式来随机对1张图片进行多次处理,以增加不同条件下输入的可能性。裁剪与亮度变化即对图像的像素值做变换,仿射则计算原图中每个像素点在变换后的位置,即可得到变换后的结果,翻转则与仿射变换原理类似。设图像中某点A(x,y),角度为α,则逆时针旋转θ角度后该点A′(x′,y′)的坐标变换如下:

2.3 YOLOv4目标检测模型

目前,具有代表性的目标检测模型有Faster R-CNN[17]、SSD[18]、YOLO系列等。YOLOv4是YOLO系列目标检测模型中最优的一种,有较好的小目标检测能力,对硬件的需求低、应用成本小,适用于复杂的实时检测场景。主要由CSPDarknet53主干特征提取网络及Neck、YOLOv3 Head組成[13],Neck由空间金字塔池化层(spatial pyramid pooling,SPP)[19]与特征金字塔(feature pyramid network,FPN)[20]、路径聚合网络(path aggregation network,PANet)[21]组成。YOLOv4的网络结构见图5,当种鹅与鹅蛋图像以416×416尺寸输入网络后,经主干特征提取得到19×19大小的特征图,经SPP层4次不同尺寸的池化,得到融合不同尺度特征的特征图,再经FPN与PANet结构,将深层的语义特征与浅层特征融合,进一步提高检测精度。YOLOv3 Head通过回归得到多个预测结果,经非极大值抑制得到更为准确的目标位置信息。

深度神经网络的训练过程均根据损失函数值来指导权值的更新,YOLOv4的损失函数L如公式(5)所示,由边界框回归损失(LCIOU)、分类损失(LCls)以及置信度损失(LConf)[13]构成。

相比YOLOv3模型,YOLOv4将对角线长度、重叠面积及长宽比纳入参考,因此增加了边界框回归的准确度与速度,对目标的预测精度有了较大的提升。公式(6)、公式(7)中b为预测框;bgt为真实框;ρ为欧式距离;α为权重系数;v表示长宽比的一致性;c为b与bgt的最小包围框对角线长度;IOU为b与bgt的交并比。

公式(8)中w、h分别表示预测框的宽、高;wgt、hgt分别表示真实框的宽、高。 αv则表示b与bgt之间长宽比的相似程度,在训练过程中模型尽可能保持长宽比接近。由公式(7)、公式(8)可知,当预测框与真实框长宽比完全相等时,αv项即为0,加入该项,从而保证预测框位置信息的准确度。对于分类损失与置信度损失,均采用交叉熵来计算每一类的损失并求和。

经过上述理论研究分析,在种鹅与鹅蛋识别任务中基本采用了YOLOv4的所有方法,但未考虑Mosaic数据增强,输入端的缩放方法未使用不失真缩放。

2.4 ROI提取与目标计数算法设计

2.4.1 ROI提取

定点产蛋是种鹅产蛋行为特征之一,在产蛋区域数量充足时,种鹅均会进入产蛋区域内产蛋。此外,每个产蛋区域的大小仅能容纳1只种鹅,因此只需对产蛋区域内的种鹅与鹅蛋目标进行计数即可根据数量变化来判断种鹅的产蛋行为信息。实际来自摄像机的图像包含多个产蛋区域,即单个图像内同时存在多个产蛋区域、多只鹅的产蛋信息。考虑将图像中的产蛋区域分别提取出来,即可同时记录每个区域中的产蛋信息。本研究将提取出的产蛋区域称为感兴趣区域(region of interest,ROI)[22]。

取输入视频中某一帧图像,以4个顶点所构成的四边形表示ROI(图6)。在像素坐标系中,已知a1、a2、a3、a4的坐标,即可拟合出4条边所在直线的方程。任意2点的坐标为(x1,y1),(x2,y2),则经过2点直线的表达式由公式(9)、(10)得出。以同样方式将图像中其他完整可视产蛋区域提取为ROI,并将每个ROI的表达式写入算法中。

系统运行过程中,目标检测算法得到每个目标框中心坐标(x,y),判断其是否在4条直线所构成的ROI内,并由计数算法统计数量。由图7可知,深色框区域为ROI,即独立的产蛋区域,可同时记录3只鹅的产蛋信息。

2.4.2 目标计数算法

由于目标检测算法得到每一帧图像内的目标数量和位置,实时监测时,由于目标检测算法自身的系统误差,及不可知的种鹅行为导致的随机误差,所检测到的目标数量是非连续的,存在较大抖动,影响了产蛋信息的判定信号。为减小系统误差所引起的抖动,采用递推消抖算法来消除目标数量的波动,以增加判定信号的准确性。

递推消抖算法的原理见图8,将N个连续帧中检测到的N个目标数量看成1个队列,新的数据添加至队列末尾,并删除原来队列的第1个数据,保证队列长度不变。判断队列中出现次数最多的数据,则认为该N个采样值所代表的一段时间内视频画面中的目标数量,以该数量表示第N+1时刻的数量。缺点是修正后的目标数量相对于实际数量有延迟,该延迟取决于设定的N值大小与检测速度,本研究取N为51,即在视频输入帧率为25帧/s时,取前2 s的数量作为参考。

种鹅产蛋结束离开产蛋箱后,达到时间阈值则对鹅蛋进行计数,但在计数前目标的数量可能存在波动,从而导致计数结果的错误。因此,在递推消抖的基础上设计二次消抖算法,具体方式为:以同样的方法将递推消抖后得到的数量固定为长度为N的队列,取队列中数量变化的次数,若变化次数大于设定的阈值,则认为视频画面不稳定,或鹅蛋被短暂遮挡,因此延迟对产蛋区域数量的判定,直至数量稳定。本研究取变化次数阈值为3。

随后对目标进行计数并获取产蛋信息。种鹅未进入ROI时,记录鹅、鹅蛋初始数量;若区域内种鹅数量在时间阈值5 s内由0稳定变化为1,则判定种鹅开始产蛋,系统从RFID阅读器获取种鹅身份并记录时间;区域内种鹅数量在5 s内由1稳定变化为0,则判定种鹅离开区域,此时获得鹅蛋的数量,并与产蛋行为发生前区域内鹅蛋的数量对比,得到产蛋结果并记录时间。

2.5 模型訓练

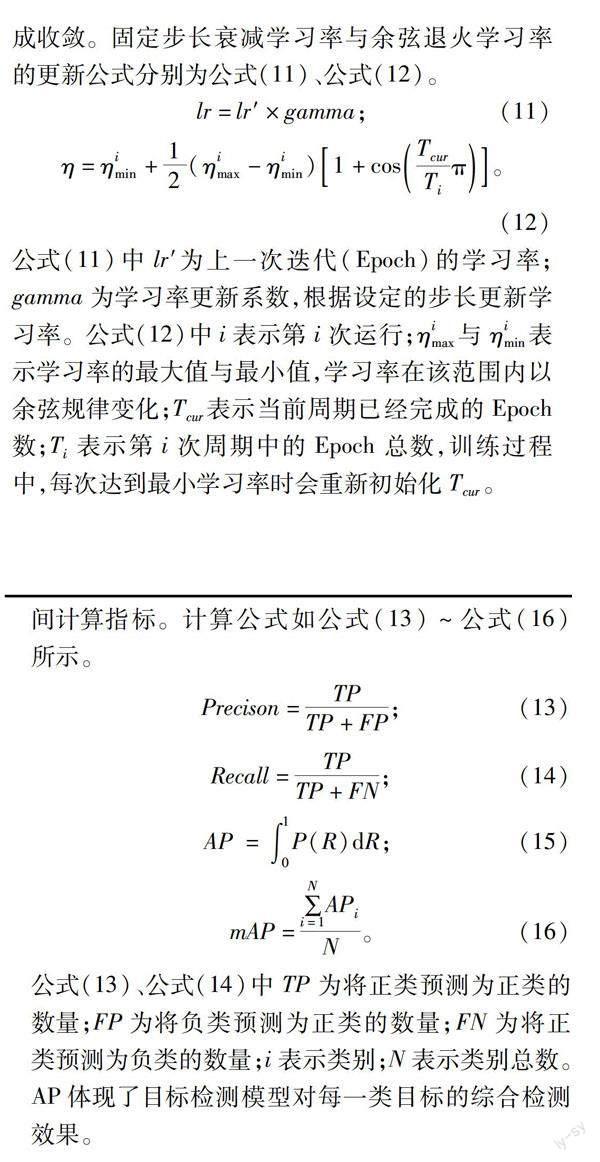

采用模型微调训练(fine-tune)的方式训练网络,该方式是迁移学习的一种,已被证明适用于小数据集的训练任务[23],有效提高模型的训练速度与特征提取能力[24]。本研究使用YOLOv4在大规模数据集中训练得到的权重作为训练初始化参数,具体分为2个阶段。第一阶段为冻结主干特征提取网络,此时特征提取网络不变,禁止冻结层参数的更新,仅对网络进行微调;第二阶段,特征提取网络发生改变,网络的所有参数均会更新。此外,使用Adam优化器训练网络模型,但修改了学习率的更新方式。在训练第一阶段,采用固定步长衰减学习率(StepLR)加快模型的收敛,第二阶段采用余弦退火学习率(CosineAnnealingLR)[25],使模型收敛于全局最优点。余弦退火策略使得学习率在设定范围内变化,使模型跳过局部最优点,从而更准确地完成收敛。固定步长衰减学习率与余弦退火学习率的更新公式分别为公式(11)、公式(12)。

公式(11)中lr′为上一次迭代(Epoch)的学习率;gamma为学习率更新系数,根据设定的步长更新学习率。公式(12)中i表示第i次运行;ηimax与ηimin表示学习率的最大值与最小值,学习率在该范围内以余弦规律变化;Tcur表示当前周期已经完成的Epoch数;Ti表示第i次周期中的Epoch总数,训练过程中,每次达到最小学习率时会重新初始化Tcur。

3 结果与分析

3.1 参数与硬件

本试验所使用的硬件参数为:Intel i9-10900k处理器,Nvidia Geforce RTX 3090显卡,windows 10操作系统,使用Pytorch-1.8.0深度学习框架,加速环境为CUDA11.2、cuDNN8.1,Opencv-4.1.1,使用python作为程序开发语言。所使用的RFID设备通过Modbus RTU协议通信,电气接口为双线制RS485,使用Modbus_tk库开发通信程序。

训练目标检测模型时,设置初始学习率为 0.000 4,前50次Epoch的学习率以等间隔减小的方式下降,步长为1,更新系数gamma为0.92,之后采用余弦退火学习率,学习率变化范围为2×10-5~5×10-6,学习率变化周期Ti为5,批大小(Batch-size)为12。

3.2 试验方法

试验主要分3个部分进行,一是验证目标检测模型的准确性,二是验证RFID设备获取种鹅个体身份信息的准确性,三是验证整体算法对种鹅产蛋行为信息监测的准确性。在江苏省农业科学院六合基地禽场搭建小规模种鹅群养环境,录制种鹅产蛋视频并用于验证种鹅个体产蛋监测方法的准确率,并通过模拟验证RFID设备获取种鹅个体身份信息的准确率。目标检测模型的准确性则通过制作的数据集来验证。

采用精度均值(average precision,AP),平均精度均值(mean average precision,mAP)及帧率(frames per seconds,FPS)作为评价目标检测算法的标准。其中,精确率(precision,P)与召回率(recall,R)为中间计算指标。计算公式如公式(13)~公式(16)所示。

公式(13)、公式(14)中TP为将正类预测为正类的数量;FP为将负类预测为正类的数量;FN为将正类预测为负类的数量;i表示类别;N表示类别总数。AP体现了目标检测模型对每一类目标的综合检测效果。

RFID设备获取种鹅个体身份的准确性与整体算法对种鹅产蛋行为信息监测的准确性均以准确率指标来评价。

3.3 结果分析

为验证YOLOv4在本方法中的有效性,分别训练Faster R-CNN、SSD及YOLOv4目标检测模型,评估各模型在测试集上的表现。不同模型在IOU阈值为0.5时,2类目标的AP、mAP和帧率的结果见表1。

由表1可知,YOLOv4在测试集上的2类目标的AP均高于Faster R-CNN与SSD中的结果。其中,鹅蛋类的AP在YOLOv4中达94.53%,远高于在另2种目标检测模型中的效果,种鹅类AP也达到92.65%,mAP达到93.59%。此外,YOLOv4的检测速度表现也较好,为57 f/s,可见YOLOv4对鹅蛋类小目标的检测效果更好。综合观察,YOLOv4的速度与精度更优,能满足检测种鹅与鹅蛋任务的实时性要求与精度要求。最终,模型运行时的置信度阈值取0.5,以兼顾精确率与召回率。

为验证RFID设备获取种鹅个体身份信息的准确性,模拟种鹅随机进入产蛋区域200次,每次固定脚环标签至阅读器的距离为7 cm,脚环标签随机出现在产蛋区域,以测试RFID阅读器在产蛋区域不同位置时识别种鹅个体身份信息的正确率,由表2可知,为验证种鹅个体产蛋行为信息监测的准确性,使用由10只产蛋种鹅在群养环境中录制的92个产蛋行为视频,产蛋行为分布在视频中的3个产蛋区域,视频尺寸为1 056×704分辨率,25 f/s,与摄像机输入尺寸相同,对系统进行测试,人工统计视频中正确的产蛋行为信息数据,并与测试得到的结果对比,得出产蛋行为信息监测结果,见表3。

由表2可知,当RFID阅读器位于产蛋区域正下方时,识别准确率最高,为98.5%,比放置于产蛋区域入口处高5.5%,更有利于准确识别种鹅个体身份。由表3可知,在使用递推消抖算法与二次消抖算法时,进出判断准确率均为94.6%,主要原因是目标检测算法自身的准确率导致无法检测所有目标,即系统误差导致,二次消抖的产蛋判断准确率为92.4%,比递推消抖提升了5.5%,综合准确率也由85.9%提高到91.3%,即二次消抖增加了对鹅蛋计数的准确性。由于当前时刻的目标数量参考过去一段时间内的目标数量,有效地减小了目标数量的波动,使得通过时间阈值来判定产蛋行为信息的方法可行,因此获得了较高的产蛋行为信息判断准确率。

图9為一个典型产蛋过程的目标数量与递推消抖后的计数结果,可知递推消抖有效抑制了目标数量的波动,即使对数量的判断有所延迟,但更有利于准确判断目标的数量。

图10为测试集图像在不同模型中的试验结果,在鹅舍复杂光线环境下,Faster R-CNN与SSD均出现了漏检现象,主要问题是对鹅蛋的检出效果较差,白天图像与夜晚图像中均未能完全检出鹅蛋,且检出的鹅蛋位置信息不准确。YOLOv4则成功检出所有目标,且置信度分数更高,对另2类未检出鹅蛋的置信度也达0.98,在多个鹅蛋图像黏连时也能够成功将其检出。根据种鹅产蛋行为信息监测的结果,YOLOv4对小规模群养环境中的种鹅与鹅蛋的检测效果较好,其准确率基本满足种鹅产蛋信息监测的要求。

4 结论与讨论

本研究将 RFID技术与目标检测算法结合,构建种鹅个体产蛋信息监测方法,该方法的硬件组成简单,对种鹅影响小,能实现无应激监测种鹅个体产蛋信息。

对采集的单张种鹅与鹅蛋图像组合使用仿射、随机裁剪、亮度变化、翻转变换,有效增加了数据集中图像的丰富性,经数据增强,所构建数据集的图像数量由1 100张扩增为3 820张。

以134.2 kHz低频RFID阅读器与电子标签获取种鹅身份,识别距离在10 cm以内。利用种鹅定点产蛋的习性,构建YOLOv4目标检测算法与目标计数算法共同组成的产蛋信息监测方法,在分析YOLOv4目标检测模型的基础上,调整训练方法与训练参数。目标计数算法由递推消抖算法与二次消抖算法组成,设定获取种鹅产蛋行为信息的时间阈值为5 s。试验结果表明,本研究构建的种鹅个体产蛋信息监测方法能有效地获取产蛋种鹅的身份信息与产蛋行为信息,不受光线条件变化的影响。相比主流的Faster R-CNN、SSD目标检测算法,YOLOv4算法对2类目标的mAP达93.59%,帧率达到57 f/s,满足产蛋信息监测的实时性要求与精度要求,种鹅的产蛋行为信息监测准确率达91.3%,个体身份信息准确率达98.5%。

本研究构建的种鹅产蛋信息监测方法尽管对种鹅与鹅蛋的检测精度较高, 但在种鹅数量较多或出现鹅与鹅之间遮挡时,检测精度还有待提高。应用在大规模群养环境则需进一步研究多个产蛋视频同时输入模型时的监测效果,以降低应用成本。

参考文献:

[1]郭彬彬,朱欢喜,施振旦. 鹅的季节性繁殖及其调控机制与技术的研究进展[J]. 黑龙江动物繁殖,2020,28(1):42-46.

[2]李久熙,王春山,吕继兴,等. 平养蛋鸭种蛋智能收集和标记系统设计与试验[J]. 农业工程学报,2017,33(17):136-143.

[3]王春山,李久熙,黄仁录,等. 蛋鸡生产参数自动监测系统设计与实现[J]. 农业工程学报,2014,30(16):181-187.

[4]刘秀敏,魏冬霞. RFID技术在畜牧业中的应用探析[J]. 家畜生态学报,2020,41(1):78-80.

[5]易 诗,李俊杰,张 鹏,等. 基于特征递归融合YOLOv4网络模型的春见柑橘检测与计数[J]. 农业工程学报,2021,37(18):161-169.

[6]孙爱东,尹 令,石凯歌,等. 基于RFID的群养种鹅个体产蛋记录方法[J]. 江苏农业科学,2016,44(2):420-423.

[7]许译丹,谢秋菊,闫 丽,等. 基于RFID的种鹅个体产蛋智能监测系统设计与试验[J]. 黑龙江八一农垦大学学报,2019,31(6):78-84,117.

[8]李丽华,黄仁录,霍利民,等. 蛋鸡个体生产性能参数监测装置设计与试验[J]. 农业工程学报,2012,28(4):160-164.

[9]李 琴,王丽辉,张 峰,等. 基于光电检测与无线射频技术的种鹅育种监控技术[J]. 激光杂志,2015,36(8):72-74.

[10]李 娜,任昊宇,任振辉. 基于深度学习的群养鸡只行为监测方法研究[J]. 河北农业大学学报,2021,44(2):117-121.

[11]Fang C,Huang J D,Cuan K X,et al. Comparative study on poultry target tracking algorithms based on a deep regression network[J]. Biosystems Engineering,2020,190:176-183.

[12]Riekert M,Klein A,Adrion F,et al. Automatically detecting pig position and posture by 2D camera imaging and deep learning[J]. Computers and Electronics in Agriculture,2020,174:105391.

[13]Bochkovskiy A,Wang C Y,Liao H Y M. YOLOv4:optimal speed and accuracy of object detection[C]// IEEE Conference on Computer Vision and Pattern Recognition(CVPR 2020). Seattle,2020.

[14]Roy A M,Bose R,Bhaduri J. A fast accurate fine-grain object detection model based on YOLOv4 deep neural network[J]. Neural Computing and Applications,2022,34(5):3895-3921.

[15]艾 博,许向阳,贾月明. 基于Modbus RTU协议的数据采集平台设计与实现[J]. 电子工业专用设备,2021,50(5):46-49.

[16]Zoph B,Cubuk E D,Ghiasi G,et al. Learning data augmentation strategies for object detection[C]//European conference on computer vision. Cham:Springer,2020:566-583.

[17]Ren S Q,He K M,Girshick R,et al. Faster R-CNN:towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(6):1137-1149.

[18]Liu W,Anguelov D,Erhan D,et al. SSD:single shot MultiBox detector[C]//European Conference on Computer Vision. Cham:Springer,2016:21-37.

[19]He K M,Zhang X Y,Ren S Q,et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(9):1904-1916.

[20]Lin T Y,Dollár P,Girshick R,et al. Feature pyramid networks for object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Hawaii:IEEE,2017:2117-2125.

[21]Wang K X,Liew J H,Zou Y T,et al. PANet:few-shot image semantic segmentation with prototype alignment[C]//Proceedings of the IEEE International Conference on Computer Vision. Seoul:IEEE,2019:9197-9206.

[22]宋燕星,袁 峰,丁振良. 目標感兴趣区域检测算法[J]. 吉林大学学报(工学版),2010,40(5):1421-1425.

[23]Kding C,Rodner E,Freytag A,et al. Fine-tuning deep neural networks in continuous learning scenarios[C]//Asian Conference on Computer Vision. Cham:Springer,2016:588-605.

[24]李雨鑫,普园媛,徐 丹,等. 深度卷积神经网络嵌套fine-tune的图像美感品质评价[J]. 山东大学学报(工学版),2018,48(3):60-66.

[25]Loshchilov I,Hutter F.SGDR:stochastic gradient descent with warm restarts[C]// 5th International Conference on Learning Representations. Toulon,2017.

收稿日期:2022-05-23

基金项目:国家现代农业产业技术体系专项资金(编号:CARS-40-20)。

作者简介:陶雪阳(1997—),男,安徽合肥人,硕士研究生,主要从事农业视觉检测与控制研究。E-mail:1508294002@qq.com。

通信作者:施振旦,博士,研究员,主要从事家禽繁殖内分泌调控研究。E-mail:zdshi@jaas.ac.cn。