基于BERT预处理模型的网络舆情细粒度情感分析

2023-06-22徐子昂

摘 要:自互联网诞生以来,因其便利性、传播性和高自由度逐渐成为舆论的主要发酵地,也引起了网络空间中的舆论治理问题。在越来越多的社会事件中,舆论影响了整个事件的走向或者处理方式,甚至对事件中的相关人员产生影响,因此对舆情监控已然成为一个急需解决的问题。但舆情的负面性、矛盾性和复杂性也为监管增加了难度。为了推进舆情监控发展,研究使用基于BERT预处理模型的E2E-ABSA,通过比较其他模型的表现来判断模型的可靠性,并与其他研究中使用的情感分析模型进行比较,并得出结论细粒度情感分析在评论携带多个主题且观点不一致的场景下具有明显优势。

关键词:BERT;E2E-ABSA;神经网络;深度学习;舆情监控;网络治理

中图分类号:TP391 文献标识码:A 文章编号:2096-4706(2023)03-0014-06

Network Public Opinion Fine-Grained Emotion Analysis Based on BERT Preprocessing Model

XU Ziang

(Shenzhen Campus, Jinan University, Shenzhen 518053, China)

Abstract: Since the birth of the internet, because of its convenience, communication and high degree of freedom, it has gradually become the main fermentation place of public opinion, which has also caused problems of public opinion governance in cyberspace. In more and more social events, public opinion has affected the trend or handling method of the whole event, and even affected the relevant personnel in the event. Therefore, the monitoring of public opinion has become an urgent problem to be solved. However, the negative, contradictory and complex features of public opinion also increase the difficulty of supervision. In order to promote the development of public opinion monitoring, this paper researches and uses E2E-ABSA based on BERT preprocessing model. It judges the reliability of this model by comparing the performance with other models, and compares with the emotion analysis model used in other researches, and concludes that fine-grained emotion analysis in comments with multiple topics and scenario of inconsistent views has obvious advantages.

Keywords: BERT; E2E-ABSA; neural network; deep learning; public opinion monitoring; network governance

0 引 言

中國互联网络信息中心CNNIC发布的第49次《中国互联网络发展状况统计报告》显示截至2021年12月,我国网民规模达到了10.32亿,网络普及率达73%。互联网的规模越来越大,中国互联网出现了如微博、知乎、百度贴吧、抖音等信息交流的平台,互联网用户可以借助这些平台表达自己对实事的看法,互联网也因此具有一定的舆论价值,在群体性事件发生、发展过程中,网络媒体有关群体性事件的报道、评论及相关信息传播,会形成较具社会影响力的网络舆情,使群体性事件进一步聚集、扩大,从而加大了相关机构预防与处置群体性事件的难度。例如在2021年5月9日发生的“成都四十九中学生坠楼”事件:事件经过发酵,在网络上迅速传播,并出现了不同版本的事件猜测。在新浪微博平台,该事件登上热搜。三人成虎,许多不明真相的群众以传播的非事实为据,声讨甚至网暴与此事无关的人员。最后警方通报认定49中学高二学生林某某系高坠死亡,排除刑事案件,并告知家属,家属对调查结论无异议。至此舆论平息,但是此次事件也对许多无关人员造成了身心伤害,一定程度上损害了社会稳定性和政府公信力。由此,准确把握群体性事件网络舆情的特征,加强网络舆情监控与引导,既有利于当事人着手社会扩散性事件的处理,也有利于社会整体的安定。

本研究旨在应用以BERT预处理模型的基础建立的针对网络平台热搜的端到端的细粒度情感分析(End to End Aspect-Based Sentiment Analysis, E2E-ABSA)模型,这种模型提取数据中的方面项和其感情极性,输出数据中包含的情绪是正面或负面和程度大小,预期训练处具有准确性和鲁棒性,能较为准确、快速地生成细粒度情感分析词条的模型。在此基础上,对研究过程进行分析,讨论ABSA在舆情监控方面的作用,分析其的优点和不足,并尝试给出解决方向。

1 背景分析

1.1 细粒度情感分析研究现状

对于细粒度情感分析来说,早期的情感细粒度分析任务主要为单一的ABSA任务。单一任务有方面项抽取(Aspect Term Extraction, ATE)、方面类别识别(Aspect Category

Detection, ACD)、观点项抽取(Opinoin Term Extraction, OTE)

和方面情感分类(Aspect Sentiment Classificatio, ASC)。例如Xue等人的文章中使用ATE抽取文本中的方面项,使用ASC提取方面项中的情感极性。后来预训练模型(PLMs)问世,例如基于Transformer的双向编码器特征(Bidirectional Encoder Representations from Transformer, BERT)和RoBERTa,使得ABSA模型的鲁棒性和泛用性得到了大幅提高,Lee等人首次使用BERT在E2E-ABSA中取得了SOTA的效果。自PLMs问世,其对于ABSA任务的提升得到了学界广泛认可,因此预训练成了NLP领域的主流方法,后来的复合ABSA任务大部分都是基于PLMs。复合的ABSA任务的目标涉及多个情感元素,因此复合的ABSA任务可以认为是单一ABSA任务的组合与关联。本文采用一种复合的ABSA任务:E2E-ABSA,同时提取方面项和其感情极性,其方法有三种:流水线(Pipeline)、联合(Joint)和统一(Unified),其中Pipeline方法是独立地提取两个情感元素,在最后耦合,如同上述的AOPE,Joint和Unified方法则进行联合训练,Unified方法特别地消除了两个任务的边界,三种方法都具有良好的性能。而且无论采用哪种方法,都要考虑方面边界和情感极性之间的关系,而且由于意见项为方面术语和情感取向提供了指示性线索,意见术语的提取已经成为E2E-ABSA的一个辅助任务。

1.2 舆情监控研究现状

对于舆情监控方面,研究已经从快速发展阶段转为稳定发展阶段,杨应全对研究现状做出了较为全面的概括,提出“在目前的研究中,学者引入了大数据、云计算、系统动力学、情感倾向、意见领袖等技术与理念,涉及管理学、计算机科学、统计学、心理学、社会学等多个学科。多学科的交叉融合是该领域研究的发展方向”。曲成义提出“在信息化高速发展的情况下,必须对突发事件网络舆情进行治理,维护社会稳定,从而提升政府的执政能力”。徐晓日认为“如果对网络舆情处置不当,可能会激起网民的负面情绪,进而影响社会秩序的稳定”。在以往的研究中,突发事件、新媒体、网络舆情治理和舆情监测与预测是热门关键词。

1.3 应用于舆情监控的情感分析研究现状

而对于相对粗略的情感分析,目前舆情监控应用方面的研究,史伟概括性地提出“近年来,国内外网络舆情相关的研究成果主要分为基础理论、支持技术和应用研究三个层次,所分析的领域已经从在线产品评论转向社交媒体文本”,曾子明利用改进后的情感词典提出一种融合深层演化特征、浅层词性特征和情感特征的多层次特征组合模型,将情感进行正负性分类并且准确度达到85%,栗雨晴构建双语情感词典将微博文本情感分为社会关爱、高兴、悲伤、愤怒、恐惧五类,解决了情感分析基于单一语种的问题。

但是对于细粒度情感分析来说,目前较少研究其舆情监控方面的应用。但也有如孙雷研究提出“基于分词的预训练模型在进行中文下游任务情感分析能取得更好的结果”为未来细粒度情感分析应用提供研究基础。

1.4 研究意义

在互联网规模日益增大,互联网影响力随之增大的情况下,网络舆情的力量是不容忽视的。网络空间给予互联网中的人们极大的自由度和包容性,这对于网民来说是表达自己意见绝佳的场所。而观点则是大众对于某一发生的社会事件在不同的视角下持有的态度。当一件社会事件发生时,互联网时代带来的信息浪潮是不可与纸媒时代同日而语的,人们持有的观点蕴藏着巨大的应用价值和潜在危害。对于这些观点进行监测并对大众舆情做出正确的反应,可以有效减少舆情的潜在危害,发挥其应用价值;如果不能及时精确地监测舆情,对舆情进行正确的引导,不仅会对当事人造成伤害,妨碍社会事件的处理,还会降低政府公信力,甚至出现舆情错误引导群众对无关人员进行攻击的现象。提高舆情治理能力是网络时代的必然要求,特别是重大突发事件发生期间舆论密度会加剧,政府、企业和网络自媒体等应改进网络舆情的治理方式,现有单一的治理体系并不能有效地引导舆情,政府应加强网络环境建设,与企业和网络媒体等主体形成协同治理格局。

此外,对于舆情监控来说,交叉学科是其未来研究方向。目前基于情感分析的研究相对较多,但是将ABSA应用到舆情监控方面的相对较少。情感分析往往只能对一个事件的整体得出极性词,当其应用于舆情监控时,会有一定的局限性,例如舆情监控人员无法得到事件中大众对某一主体的详细观点,而且网络舆情评论一般较为简短,上下文关联性强,普通的情感分析与ABSA比较不能较好地针对这些特点进行处理。相较于一般的情感分析来说,ABSA可以得出主体中某一方面的极性词,特别地,E2E-ABSA能较好地处理文本较短、上下文关联强的数据集,并且能适应多个主题、携带情感不一致的复杂情况。而此研究对于舆情监控方面的应用,也可以较好地补充此方面的空白,拓展ABSA的应用领域。

2 方法介绍

鉴于上文中提到的,对于舆情监控,有大量非细粒度情感分析的模型应用,但是对于细粒度情感分析模型的应用少之又少。舆情中蕴含的情绪具有复杂、多元和程度的区别,对于ABSA来说,由于其能提取数据中更详细的方面项,笔者相信其在舆情监控方面能提供更全面的舆论分析,补足非细粒度情感分析只能对舆情整体而无法对舆情中某个主体進行分析的空白。

本研究將使用基于BERT的E2E-ABSA模型,收集某段时间内新浪微博上热搜的评论,并对其进行人工标注,形成训练数据集,研究的模型将在此数据集的基础上进行训练。训练出来的模型将使用未参与训练的数据集进行测试,得出当时舆情的情况,并进行任务的评估。除此之外,本研究还将测试模型的参数,并与其他已有的ABSA模型进行比对,最后得出本研究使用的模型是否适用于舆情监控。

2.1 BERT预训练模型

BERT模型的全称是Bidirectional Encoder Representations from Transformer,基于Transformer的双向编码器特征,是一个预训练的语言表征模型,它强调了不再像以往一样采用传统的单向语言模型或者把两个单向语言模型进行浅层拼接的方法进行预训练,而是采用新的Masked Language Model(MLM),以致能生成深度的双向语言表征。Li等人的实验证实了BERT预处理模型的优越性,BERT模型加上具体的任务层在各个方面都优于LSTM-CRF和现有其他模型。因此本研究使用的BERT预训练模型将会使最后的模型在测试和应用方面表现得更加出色。

与基于Word2Vec或GloVe的嵌入层相比,BERT嵌入层会以句子作为输入,而不是整段文章,并用整个句子计算token级特征,如图1所示。

BERT会针对两个任务进行预训练:语言建模和下一句预测。BERT预训练结果是使模型学习了词的上下文嵌入。基于此,模型可以在较小的数据集上使用更少的资源进行微调,以优化其在特定任务上的性能。例如图1给出的句子“My dog is cute”BERT会先将输入特征打包为H0={e1,…,eT},

其中eT(t∈[1,T])是与输入特征xt相关联的Token Embedding、Position Embedding和Segment Embedding的组合。然后引入L个Transformer层,逐层细化token级的特征。最后BERT输出对应token的Transformer输出。

2.2 E2E-ABSA模型

端到端的ABSA(E2E-ABSA)是本研究模型的主体,用来同时提取舆情评论中方面项和它相应的情感极性,抽取数据中的(a, p)pairs。其可以看作是ATE和ASCE两个任务的结合。E2E-ABSA有三种方法:Pipeline、Joint和Unified,鉴于三种方法训练出的模型都具有良好的性能,本研究将采用Unified方法。这种方法将上述两个任务的边界抹除,并用“Unified”标签标记情感元素。基于此,E2E-ABSA可以通过标准序列标记器(Standard Sequence Tagger)使用TokenClass范式处理。

本研究借鉴了Li等人的模型,在BERT模型的基础上假设了E2E-ABSA模型,以执行研究需要的E2E-ABSA任务。该模型分为四个部分:线性层、循环神经网络、自注意力网络和条件随机场。

2.2.1 线性层

BERT预训练输出的token特征可以直接运用到线性层中,利用softmax激活函数计算出token级的预测,其表示如式(1)所示:

(1)

其中线性层的可学习参数 。

2.2.2 循环神经网络

循环神经网络(RNN)是E2E-ABSA任务绝佳的解决方案,本研究采用Cho等人提出的GRU,Jozefowicz等人验证过了其相比于LSTM和一般的RNN具有优越性。第t步特定任务的隐藏特征 计算公式如式(2)、式(3)和式(4)所示:

(2)

(3)

(4)

其中σ表示sigmoid激活函数,rt,zt,nt分别表示reset gate,update gate和new gate, 和 是GRU的参数。在Transformer的输出上直接使用RNN,BERT输出的特征 可能会使训练结果不能达到理想的水平。因此计算gate时在原本基础上添加一层Layer-Normalization(LN)。加入softmax层得到预测结果:

(5)

2.2.3 自注意力网络

自注意力机制是深度学习领域的又一大有力工具。自注意力网络(SAN)以其在训练模型中优越的表现被广泛地运用在RNN和CNN中。本研究使用两种SAN的变种构建特定任务的token特征。

其中一种包含一层简单的自注意力层和一层残差网络,其计算公式如式(6)和式(7)所示:

H T=LN(H L+SLFATT(Q, K, V)) (6)

Q, K, V=H LW Q, H LW K,H LW V (7)

其中SLFATT表示Self-Attentive Scaled Dot-Product Attention,H表示前文h的向量,Q、K、V分别表示三个矩阵,Q表示注意力矩阵,K表示键,V表示值。

另一种是一层与BERT中Encoder层类似的Transformer层,其计算公式如式(8)和式(9)所示:

(8)

(9)

其中FFN表示Point-Wise Feed-Forward Networks。

最后将一层与2.2.1中相同的线性层堆叠在本层上,用于输出预测结果。

2.2.4 条件随机场

条件随机场(Conditional Random Fields, CRF)被广泛应用于序列标记的任务中,其被证实是在序列建模中较为有效的方法。本研究采用一种在BERT嵌入层上的线性链CRF层。本层用于全局寻找最符合的标签序列,y={y1, …, yT}的可能性p(y|x)与序列级分数s(x, y)计算公式如式(10)和式(11)所示:

(10)

p(x| y)=softmax(s(x, y)) (11)

其中 是用来建立预测之间依赖关系模型的随机初始化转移矩阵, 是根据BERT特征HL线性变换得来的发射矩阵。此处的softmax函数针对所有可能的标签序列,解码时则将得分最高的标签序列输出:

y*=argmaxy s(x, y) (12)

3 实验结果与分析

3.1 数据收集和处理

数据收集是一项极其重要的工作,收集数据的质量决定了训练出的模型的质量。本研究以新浪微博为数据抓取对象,对微博热搜页下的实时评论进行抓取,获得原始数据,部分原始数据如图2所示。

在抓取的过程中,将会设置相关的屏蔽条件,例如抓取用户等级较高的用户评论,尽可能排除网络水军的冗杂数据,为后续数据处理减少工作量。

利用浏览器自带开发者工具对微博热搜页进行观察发现,热搜页有共计50条热搜,每条热搜的元素中有热搜详情页的url。热搜详情页的url默认为热门微博,而热门微博大部分为官方媒体通稿,不符合数据采集要求。观察发现热搜详情页旁导航栏有实时动态,对其url解析后发现热门页面与实时页面url结构为“热搜页面域名”+“热门/实时”+“热搜词条”+“热门/实时”。因此可以对新浪服务器請求得到页面,然后用xpath表达式获得指定url,并对url进行修改获得实时页面url,从而获得实时评论数据。

在实际数据抓取中,秉持爬虫网站友好原则,对数据的抓取频率为4次/小时。之后将收集的数据整理成模型能够识别的数据集。对数据进行简单的清洗,人工去除微博评论中的非评论元素。之后对数据进行人工标注,部分数据集如图3所示。

标注格式是OT。其中O标记表示token不属于任何块。“T-”前缀是标记一个在另一个块之后且之间没有O标记的块的开始,“T-NEG”表示负面的感情极性而“T-POS”表示正面,“T-NEU”表示中性。

3.2 模型训练

在模型中,研究将上游部分BERT的Transformer层数设置为12,dimh为768。而对于下游的E2E-ABSA组件,研究使用单层架构并且设置维度同样为dimh。学习率为2e-5[16]。数据集的批处理大小设置为16。模型的训练迭代次数设置为1 000。在模型训练完后,使用未参与训练的数据集进行测试。

3.3 基于BERT的E2E-ABSA效果

3.3.1 模型效果

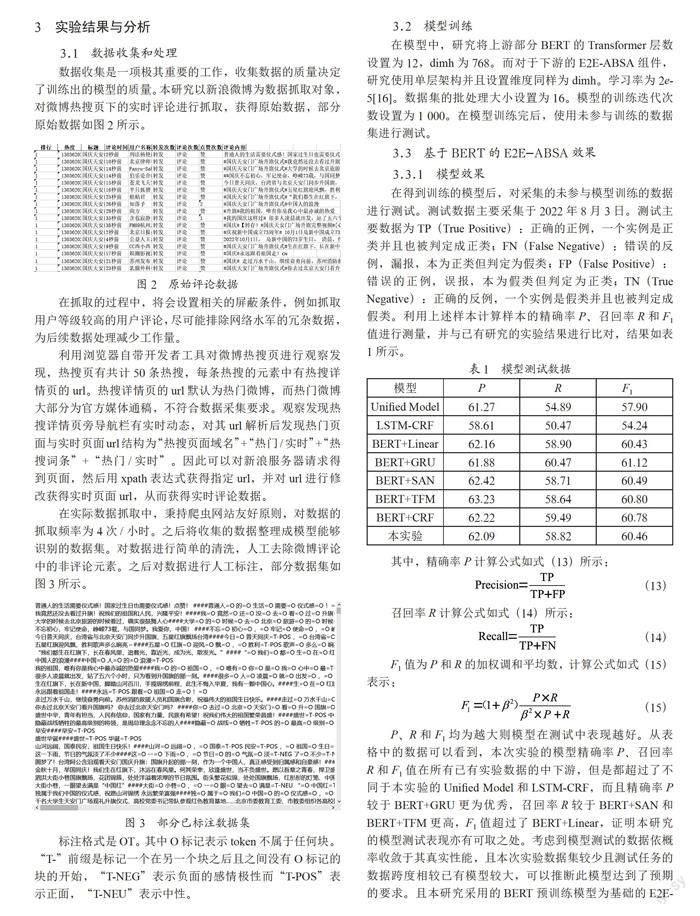

在得到训练的模型后,对采集的未参与模型训练的数据进行测试。测试数据主要采集于2022年8月3日。测试主要数据为TP(True Positive):正确的正例,一个实例是正类并且也被判定成正类;FN(False Negative):错误的反例,漏报,本为正类但判定为假类;FP(False Positive):错误的正例,误报,本为假类但判定为正类;TN(True Negative):正确的反例,一个实例是假类并且也被判定成假类。利用上述样本计算样本的精确率P、召回率R和F1值进行测量,并与已有研究的实验结果进行比对,结果如表1所示。

其中,精确率P计算公式如式(13)所示:

(13)

召回率R计算公式如式(14)所示:

(14)

F1值为P和R的加权调和平均数,计算公式如式(15)表示:

(15)

P、R和F1均为越大则模型在测试中表现越好。从表格中的数据可以看到,本次实验的模型精确率P、召回率R和F1值在所有已有实验数据的中下游,但是都超过了不同于本实验的Unified Model和LSTM-CRF,而且精确率P较于BERT+GRU更为优秀,召回率R较于BERT+SAN和BERT+TFM更高,F1值超过了BERT+Linear,证明本研究的模型测试表现亦有可取之处。考虑到模型测试的数据依概率收敛于其真实性能,且本次实验数据集较少且测试任务的数据跨度相较已有模型较大,可以推断此模型达到了预期的要求。且本研究采用的BERT预训练模型为基础的E2E-ABSA相较于其他方法,如Unified Model和LSTM-CRF均有明显优势,证明本研究采用的模型相较于一些其他的模型在测试的表现中更好,在未来实际运用过程中可能更加适合。

3.3.2 舆情监控效果

在模型经过测试后,得到了2022年10月3日某时间段内微博热搜实时评论的细粒度感情极性输出,利用Python中的wordcloud库将其可视化并做成词云,如图4和图5所示,图4为正面词云,图5为负面词云,其中词的大小表示频度,颜色的深浅表示情绪的强烈程度。

可以从词云看到当天的某时间段内,微博用户主要对国庆和北溪管道被破坏事件关注度比较高。在图4正面词云中,“国庆”一词大小最大,颜色最深,表明其讨论度最高、在用户评论中出现频率最高且正面的情感词性最强烈,“生日”一词大小较小,颜色深度较浅,表明其在用户评论中出现频率较少且正面情感词性较弱,猜测可能是因为有些用户提及“生日”时并表达正面情绪较少或反映出负面情绪。在图5负面词云中,“疫情”一词大小最大,颜色深度较深,表明了用户在提及“疫情”一词的频率较高,且带有较大的负面情绪,对于“天然气”一词其大小较大但是颜色深度在次云中并不突出,表明用户提及“天然气”频率较高但是负面情绪虽然不强烈但也有一定量级。而从整体来看,正面词云颜色深度较于负面词云较深,表明当天某时间段内用户的情感极性普遍表现为正面。

由上述分析与普通的应用于舆情监控的情感分析作对比,可以看出ABSA可以将舆情中的某一个客体剥离出来,或者是更进一步将这个客体的两种不同的感情极性剥离出来,这为舆情监控提供了更加细化的分析。这些特点使得模型在公众对一个事件持有不同态度、情感极性程度不同的情况下对舆情的测量更为准确。王巍提出“在网络空间治理过程中公众的情绪和观点如果凌驾于事实之上,扩大化的涉警网络舆情危机将冲击公平正义。公安机关在处置舆情危机的过程中稍有不慎,尤其是在突发事件发生的同期,将会影响事件的发展和演变更为严重的后果,将导致狂风暴雨式的蝴蝶效应”。

4 结 论

本研究使用了基于BERT预处理模型的E2E-ABSA建立模型,并使用某一时间段内新浪微博平台上热点事件用户评论进行测试。模型训练的成果达到预期要求,各项指标均在预期范围之内。研究结果证明,该模型可以对于在公众对一个事件持有不同态度、情感极性程度不同的情况下可以独立地提取不同方面的感情极性,舆情监控的效果相较传统情感分析模型具有相当的优势,精确性和可信度较高。

同时,本研究也存在着一定的问题。本研究使用的训练数据集为笔者自己收集和标注,并且相较于ABSA一般的应用场景——商品或服务评论,事件的评论会随着事件变化较大,同一个方面词在不同的事件中可能会表现出不同的感情极性。鉴于此训练出的模型效果可能并不会和一般应用场景中的好,模型测试的数据也证实了这一点。此外,E2E-ABSA模型虽然可以给出方面项和对应的感情极性,但是其感情极性分为正面和负面两种,在实际生活中人们对事件的态度是多维的,可能是愤怒、悲伤、开心等甚至是两种以上的情感结合,E2E-ABSA任务只能提取正面或负面的感情极性,因此对于应用于舆情监控的情感分析还存在着改善的空间。另一方面,目前研究应用于舆情监控的ABSA较少,在此领域存在较大空白,因此本研究可以比较和参考的文献较少,可能存在潜在的问题。对于这些问题,可能的解决方向如下:使用更加完善的数据集、使用更加全面和完善的ABSA模型和持续学习的ABSA。

互聯网由于其时域性、互动性和低成本性,成了当下网络舆论的主要发酵地。网络舆情已经和社会稳定密切相关,网络舆情的监控有利于国家平稳发展,预防可能存在的公共事件导致的舆情危机,帮助分析舆情中的演变机制等。本研究也持这样的目的,希望推进网络舆情监控方面的发展,减少舆情对社会带来的负面冲击。此外,本研究也希望推进ABSA应用场景的扩展,不再局限于商品和服务的评论。

参考文献:

[1] 中国互联网络信息中心.CNNIC发布第49次《中国互联网络发展状况统计报告》 [J].新闻潮,2022(2):3.

[2] 彭知辉. 论群体性事件与网络舆情 [J].公安理论与实践:上海公安高等专科学校学报,2008(1):46-50.

[3] XUE W,ZHOU W B,LI T,et al. MTNA:A Neural Multi-Task Model for Aspect Category Classification and Aspect Term Extraction on Restaurant Reviews [C]//the Eighth International Joint Conference on Natural Language Processing.Taipei:IJCNLP,2017,2:151-156.

[4] DEVLIN J,CHANG M W,LEE K,et al. BERT:Pre-Training of Deep Bidirectional Transformers for Language Understanding [J/OL].arXiv:1810.04805 [cs.CL].[2022-08-09].https://arxiv.org/abs/1810.04805v1.

[5] KAPIL P. A Novel Neural Network Architecture for Sentiment-Oriented Aspect-Opinion Pair Extraction [D].Bangalore:Indian Institute of Science,2021.

[6] ZHANG W X,LI X,DENG Y,et al. A Survey on Aspect-Based Sentiment Analysis:Tasks,Methods,and Challenges [J/OL].arXiv:2203.01054 [cs.CL].[2022-08-07].https://arxiv.org/abs/2203.01054.

[7] FAN F F,FENG Y S,ZHAO D Y. Multi-Grained Attention Network for Aspect-Level Sentiment Classification [C]//the 2018 Conference on Empirical Methods in Natural Language Processing.Brussels:EMNLP,2018:3433-3442.

[8] 杨应全,刘子辉.我国突发事件网络舆情研究综述 [J].重庆科技学院学报:社会科学版,2022(2):40-48+71.

[9] 曲成义.网络突发事件的应急对策与治理环境的建设 [J].信息化建设,2005(10):16-17.

[10] 徐晓日.网络舆情事件的应急处理研究 [J].华北电力大学学报:社会科学版,2007(1):89-93.

[11] 史伟,薛广聪,何绍义.情感视角下的网络舆情研究综述 [J].图书情报知识,2022,39(1):105-118.

[12] 曾子明,万品玉.融合演化特征的公共安全事件微博情感分析 [J].情报科学,2018,36(12):3-8+51.

[13] 栗雨晴,礼欣,韩煦,等.基于双语词典的微博多类情感分析方法 [J].电子学报,2016,44(9):2068-2073.

[14] 孙雷.基于主题模型的微博评论细粒度情感分析研究 [D].邯郸:河北工程大学,2021.

[15] SANG E F T K,VEENSTRA J. Representing Text Chunks [J/OL].arXiv:cs/9907006 [cs.CL].[2022-08-08].https://arxiv.org/abs/cs/9907006.

[16] DEVLIN J,CHANG M W,LEE K,et al. BERT:Pre-training of Deep Bidirectional Transformers for Language Understanding [J/OL].arXiv:1810.04805 [cs.CL].[2022-08-09].https://arxiv.org/abs/1810.04805v1.

[17] LI X,BING L D,ZHANG W X,et al. Exploiting BERT for End-to-End Aspect-Based Sentiment Analysis [J/OL].arXiv:1910.00883 [cs.CL].[2022-08-06].https://arxiv.org/abs/1910.00883.

[18] CHO K,MERRIENBOER B V,GULCEHRE C,et al. Learning Phrase Representations Using RNN Encoder-Decoder for Statistical Machine Translation [J/OL].arXiv:1406.1078 [cs.CL].[2022-08-06].https://arxiv.org/abs/1406.1078.

[19] JOZEFOWICZ R,ZAREMBA W,SUTSKEVER I. An Empirical Exploration of Recurrent Network Architectures [C]//the 32nd International Conference on Machine Learning.Lille:ICML,2015,37:2342-2350.

[20] CHENG J P,DONG L,LAPATA M. Long Short-Term Memory-Networks for Machine Reading [J/OL].arXiv:1601.06733 [cs.CL].[2022-08-06].https://arxiv.org/abs/1601.06733v5.

[21] VASWANI A,SHAZEER N,PARMAR N,et al. Attention is all You Need [J/OL].arXiv:1706.03762 [cs.CL].[2022-08-08].https://arxiv.org/abs/1706.03762.

[22] HUANG Z H,XU W,YU K. Bidirectional LSTM-CRF Models for Sequence Tagging [J/OL].arXiv:1508.01991 [cs.CL].[2022-08-09].https://arxiv.org/abs/1508.01991.

[23] LI X,BING L D,LI P J,et al. A Unified Model for Opinion Target Extraction and Target Sentiment Prediction [J/OL].arXiv:1811.05082 [cs.CL].[2022-08-09].https://arxiv.org/abs/1811.05082.

[24] LAMPLE G,BALLESTEROS M,SUBRAMANIAN S,et al. Neural architectures for Named Entity Recognition [J/OL].arXiv:1603.01360 [cs.CL].[2022-08-05].https://arxiv.org/abs/1603.01360.

[25] 譚翠萍.文本细粒度情感分析研究综述 [J].大学图书馆学报,2022,40(4):85-99+119.

[26] 张继东,张慧迪.融合注意力机制的多模态突发事件用户情感分析 [J].情报理论与实践,2022,45(11):170-177.

[27] 杨晓晨.基于深度学习的文本情感分类方法研究 [D].天津:天津理工大学,2022.

[28] LI X,BING L D,LI P J,et al. A Unified Model for Opinion Target Extraction and Target Sentiment Prediction [J/OL].arXiv:1811.05082 [cs.CL].[2022-08-07].https://arxiv.org/abs/1811.05082.

[29] 华玮,吴思洋,俞超,吴婕洵,徐健.面向网络舆情事件的多层次情感分歧度分析方法 [J/OL].数据分析与知识发现,2022:1-23[2022-07-09].http://kns.cnki.net/kcms/detail/10.1478.g2.20220613.1153.008.html.

[30] 王宇琪,郑安琪,郝川艳.基于细粒度情感分析的情感目标过程性评价机理与路径研究 [J].计算机时代,2022(7):94-97+100.

[31] 苏红旗,聂金慧,曾志.基于特征聚类的网络评论信息挖掘研究 [J].信息网络安全,2013(12):51-54.

[32] 赵宏,傅兆阳,王乐.基于特征融合的中文文本情感分析方法 [J].兰州理工大学学报,2022,48(3):94-102.

[33] DO H H,PRASAD P W C,MAAG A,et al. Deep Learning for Aspect-Based Sentiment Analysis:A Comparative Review [J].Expert Systems with Applications,2019,118:272-299.

[34] MINAEE S,KALCHBRENNER N,CAMBRIA E,et al. Deep Learning Based Text Classification:A Comprehensive Review [J/OL].arXiv:2004.03705 [cs.CL].[2022-08-11].https://arxiv.org/abs/2004.03705.

[35] XU H,LIU B,SHU L,et al. BERT Post-Training for Review Reading Comprehension and Aspect-Based Sentiment Analysis [J/OL].arXiv:1904.02232 [cs.CL].[2022-08-12].https://arxiv.org/abs/1904.02232.

[36] PHAN M H,OGUNBONA P O. Modelling Context and Syntactical Features for Aspect-Based Sentiment Analysis [C]//Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics.ACL,2020:3211-3220.

[37] RAMSHAW L A,MARCUS M P. Text Chunking Using Transformation-Based Learning [M]//ARMSTRONG S,CHURCH K,ISABELLE P. Natural Language Processing Using very Large Corpora.Dordrecht:Springer,1999:157-176.

[38] 王巍.解析網络舆情下官民互动的蝴蝶效应 [J].武警学院学报,2017,33(11):81-84.

[39] 于龙.涉警网络舆情危机的治理对策 [J].中国人民警察大学学报,2022,38(6):25-30.

作者简介:徐子昂(2001.03—),男,汉族,河南信阳人,本科在读,研究方向:自然语言处理。

收稿日期:2022-09-13