基于单目视频的手术器械相对工作空间估计方法

2023-06-21苏 赫,白 雪

苏 赫,白 雪

基于单目视频的手术器械相对工作空间估计方法

苏 赫,白 雪

(天津大学机械工程学院,天津 300354)

由于单目手术视频的镜头参数未知,仅凭该单目图像难以准确估算内镜镜头下的手术器械的三维坐标.针对这一问题,提出一种手术器械相对工作空间的估计方法.首先,对用U-Net网络分割后的掩膜图像进行直线检测,对图像坐标系下的直线映射到参数空间上的点进行聚类,从而优化直线检测效果.然后,利用边缘线段的相对几何位置特征对因网络分割效果欠佳导致的边缘线段残缺进行补足,从而提取出与目标边缘高度拟合的完整线段. 结合目标器械实际尺寸与图像尺寸间的比例关系,利用平行线在投影平面上的消隐点特性计算出目标器械目标点处的实际三维坐标.最后,进行测距实验和轨迹跟踪实验. 实验结果表明:该方法较磁导航传感器准确度高、鲁棒性强,距离测量精度可达2.6581mm,轨迹拟合度达91.2%,满足实际情况下手术器械相对工作空间的估算要求.

工作空间;单目视觉;三维坐标估算;手术机器人

进入21世纪,随着以由美国Intuitive Surgical公司开发的da Vinci机器人系统[1]为代表的手术机器人的开发并迅速投入临床应用,第三代外科手术时代到来[2].微创手术机器人在传统微创手术优点的基础上,还具有精度高、可单人施术、省力、学习曲线短、工作空间污染少、可远程手术等优点,在时空层面减少手术条件限制,极大程度提高手术效率.为最大程度地拓展手术医生操作能力,手术机器人的自由度更高,故而整体结构复杂.由于其从操作端上安装的手术器械工作在狭小的人体内部空间,所以从操作端工作空间设置不当会导致器械干涉的问题,其主从分离式结构[3]也会产生一定的人机交互困难的问题,导致手术机器人术前规划困难.因而研究微创手术所需的操作空间和操作模式对手术机器人的结构设计、运动控制系统设计和手术切口设置有重要意义.

手术器械运动空间检测的方法有两类,分别是基于运动学或外设传感器的方法和基于视觉的方法.前者通过用正运动学原理将机器人各关节运动映射到器械末端,或者在末端添设传感器直接跟踪,该类方式直接简单、准确度高,但其关节位姿映射存在一定的误差,增设传感器需在手术中器械上进行改造,存在临床消毒等问题,进行大数据统计亦存在成本高和很难征招志愿者等困难.基于视觉的方法是一种无接触的器械跟踪方法,主要分为两类,基于标记点特征的方法和基于目标特征的方法.前者需要在器械上附加带有特殊颜色的标记,会对手术有影响,而基于手术器械特征进行识别跟踪的方法无需额外添加标记,仅仅通过视觉图像求解,但该方法较其他方法精度较低.Zhang等[4]提出基于深度学习的无标记手术器械追踪框架,将手术器械关节定义为追踪点,在跟踪精度和速度上均有较好的效果.Peng等[5]提出基于YOLO网络预测的箭头对象边界框器械尖端自主识别方法,该方法实现器械关键部位的识别和定位,具有36.5帧/s的速度和较高的准确率效果,但该方法仅实现于二维图像中的器械跟踪.

单目内窥镜体积更小、自由度更大,但单目三维目标检测区别于多目三维目标检测,其最大的难点在于深度的估计,对此,当前用于单目内窥镜的深度估计研究方法分为传统的三维重建方法和基于深度学习的方法.Mahmoud等[6]利用改进的单目ORB-SLAM算法来估计内窥镜场景位置和手术场景的3D结构,但其重建地图稀疏,只能用于内窥镜定位.Phan等[7]提出了结合密集光流的交叉矩阵结构(switch fabric module,SFM)的图像表面重建方法,该方法改进弱纹理区域的特征匹配效果,用于胃镜下的三维重建.岑仕杰等[8]使用位姿估计网络提供无监督数据,结合双重注意力模块对自然场景进行深度估计,但该方法位姿估计准确性较低.

当前较为成熟的单目深度估计研究主要在自动驾驶领域,有3种方法:使用深度估计、使用激光雷达引导和直接回归的方法[9]. CaDDN方法[10]跳脱出精确估计深度的桎梏,提出估计深度范围的方法,将连续值的回归问题转化为离散值的分类问题,减小深度预测难度,提高三维检测效果;MonoPSR方法[11]利用了边框预判和形状重构等方法,降低三维定位难度,提高准确率;直接回归的方法往往借助于几何先验条件,利用目标的几何关系、关键点等已知条件回归目标深度.这些方法由于应用在自动驾驶中,其目标物体多数较为单一,如行人、车辆等,尺寸类型较少,因而进行3D包围盒的检测时更偏向于全包括性而非获得实际深度尺寸.

内窥镜系统因其具有超清图像、高亮度发光二极管(light emitting diode,LED)冷光源特点,可将手术视野稳定并完美呈现[12],除为术者提供清晰的手术操作图像、提高手术效率、降低病人不适感和手术复杂度外,医疗内镜拍摄的视频也常用于术后临床病例讨论、远程会诊和教学中,为教学、科研提供可靠的资料.

当下,以达芬奇为主的手术机器人由于其售价高、耗材花费大、常用器械使用次数少导致的单次使用成本高等问题,导致普通人负担不起巨额手术费,再加上长期以来中国医保并未覆盖到机器人辅助手术,所以中国的手术机器人市场渗透率极低[13].而部分国内手术机器人公司研发出术式较少的机器人,如微创医疗机器人自主研发的适用于机器人辅助腹腔镜根治性前列腺切除术(robot-assisted laparoscopic radical prostatectomy,RALRP)的图迈腔镜手术机器人[14]、适用于全膝关节置换术(total knee arthroplasty,TKA)的鸿鹄骨科机器人等[15],该类手术机器人虽部分尚处于研发过程中还未投入使用,但因其术式较少,可助力专用手术的标准化诊疗流程建设,其成本显著下降,因而这类机器人或将更有研究和应用价值.而手术的实时录像不仅可作为术者的术中参考,还可以在专用手术机器人的结构设计、运动控制、术前规划等方面提供指导作用.

本文基于单目手术视频,将对其语义分割后的掩膜图像作为输入,结合消隐点特性和手术器械的直线特征,对单目视频中的手术器械相对于镜头的三维坐标进行估算,并绘制出器械的运动轨迹,从而获得手术器械的操作空间,该方法可在专用手术机器人的结构设计、运动控制、术前规划等方面提供指导作用.

1 本文研究方法

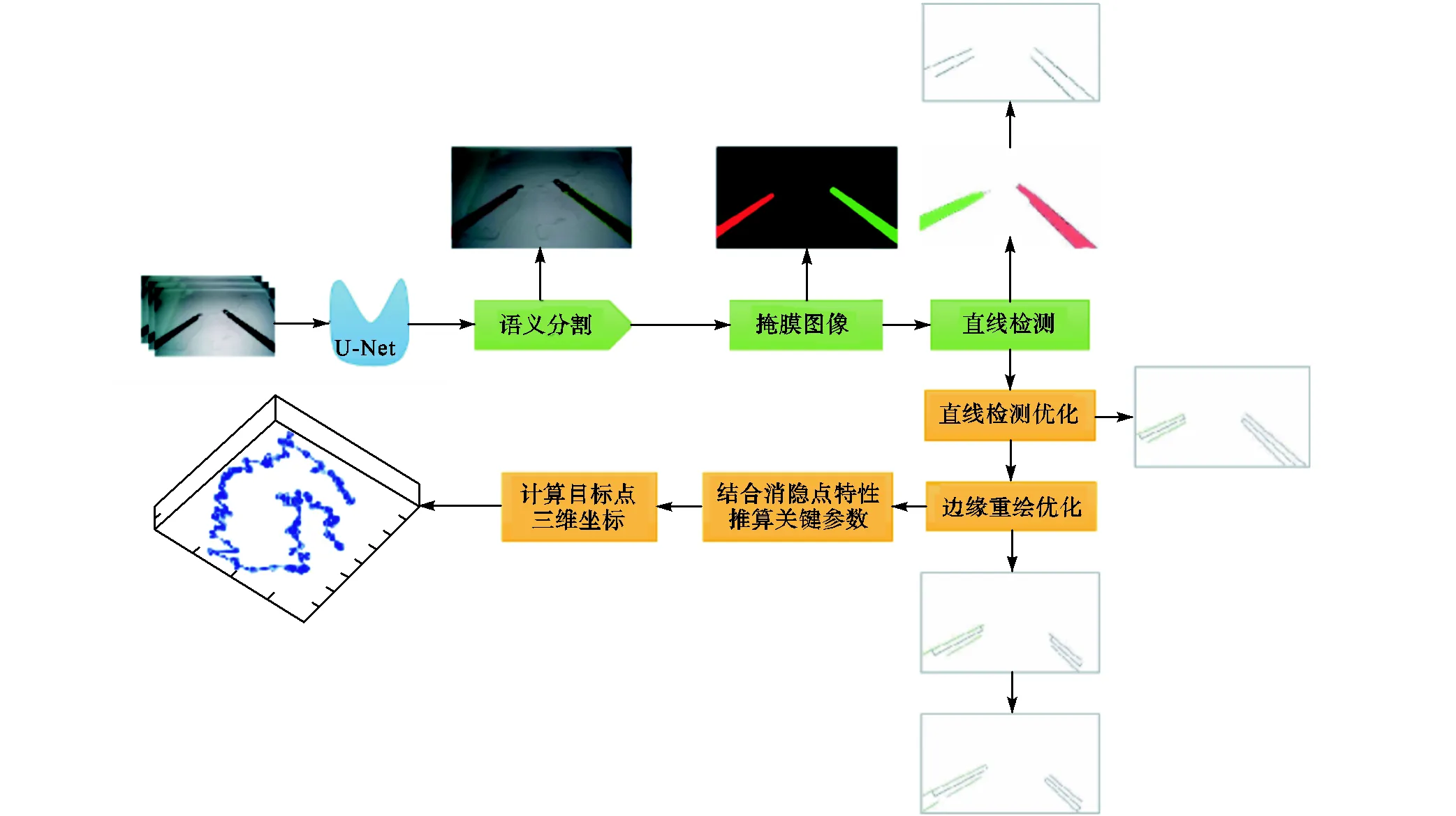

为了满足操作空间计算的准确性,本文提出的手术器械操作空间估计方法利用消隐点特性和目标器械几何特征来计算单目视觉下的手术器械三维位姿.该方法基于对单目手术视频图像的分析,在内镜运动参数以及内参未知的情况下,以U-Net网络语义分割得到的掩膜为输入数据,结合霍夫变换原理,提出直线检测优化方法,结合目标器械特征优化边缘重绘效果,最后利用消隐点特性,建立模型并推导出手术器械的相对三维坐标,构成手术器械操作空间.本文算法流程如图1所示.

图1 本文算法流程

1.1 直线检测与刀柄边缘重绘

基于霍夫变换原理,引入相似者相同的方法优化直线检测效果,并针对因网络分割不准确等引起的识别不完整问题,采用目标长度比较的方法获得更为接近的边缘重绘结果.

在对掩膜图像进行直线检测时,由于U-Net网络对图像进行先压缩后扩展操作,导致图像边缘出现锯齿效应[16],加上图像本身因光照、快速运动等原因出现边界不清晰、掩膜图像有波浪状缺失的情况,此时直线检测效果较差,无法提取有效信息.利用霍夫变换[17]将图像空间上的直线映射到参数空间上的点的原理,对其参数空间点坐标进行阈值限定,优化直线检测效果.

图2 霍夫变换原理示意

然而在实际应用中,由于光照、快速运动、虚焦等原因产生的模糊边缘以及图像分割时产生的锯齿效应等使得直线检测效果变差,无法得到有效边缘线段,故需对此进行优化.

(2) 根据线段的值的正负判断线段方向,求得合成线段的两端点坐标;

两端点坐标暂不分前后,优化效果如图3所示. 图3(a)为掩膜图像上直线检测的图像;图3(b)为单独的直线检测效果,其中存在许多断续的短线段;图3(c)为优化后的直线检测效果,经过该优化后,断 续的短线段结合为完整的长线段,其优化效果直观 可见.

图3 直线检测优化效果

在实际图像分割时,由于光照、特征相似、遮挡等原因,往往出现目标分割不完整的问题,这对形状较为规则的目标的边缘重绘影响极大,而针对每张图片的分割效果进行直线检测阈值调整工作量巨大且无法自动化实现,而采用自适应阈值[18]等方法对原图像的分割效果进行优化不能针对性地解决部分数据分割效果差的问题.所以在手术刀柄边缘重绘时,选取过边线较远端点与骨线相垂直的线段作为器械末端的有效识别半径,实现方法如下.

其通过两刀头端点有不同截距,其表达式分别为

图5 边缘重绘优化效果

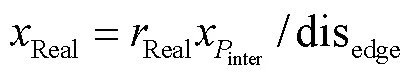

1.2 结合消隐点特性估算器械相对操作空间

欧氏空间中两条平行直线相交于无穷远点,在理想小孔模型下,两条平行直线经过摄像机得到的投影交点称为消隐点(vanish point)[19],它是无穷远点在平面上的投影.

目标手术器械刀柄为圆柱体,故其两条可视母线(即上文提到的边线)也是两条平行直线,其在图像上也会交于一消隐点,利用该特性可求出图像视野内刀柄部分实际长度.绘制器械柄部在投影平面上示意如图6所示.

图6 器械投影平面上消隐点示意

(14)

已知在同一深度距离下,两物体的实际尺寸之比等于图像尺寸之比,即

若器械上某点处深度距离与参考图片中某处距离相同,则其图像尺寸之比等于其实际尺寸之比,若距离不同,则在图中绘制出其相应比例的图像尺寸,将消隐点与等深度下图像端点相连,延长至实际图像尺寸上,此时该交点对应坐标值即为该点处的实际深度坐标.

2 实验分析

2.1 实验设备及步骤

为了证明所提出的三维位姿检测算法的有效性、可行性和结果的准确性,本文采用NDI Aurora电磁传感器作为验证依据,该传感器参数[21]如表1所示,使用直径4.78mm(±2mm)手持器械、Lap Game腹腔镜手术模拟训练箱和直杆腹腔镜进行实验,实验装置如图8所示.首先验证两器械末端端点间距离检测结果的准确性,然后进行器械末端跟踪实验,得到与电磁传感器轨迹相匹配的结果,最后根据所得实验结果进行特定轨迹绘制实验,验证本文方法较电磁传感器的准确性更好.

表1 NDIAurora电磁传感器参数

Tab.1 Parameters of NDI Aurora electromagnetic sensor

本文所采用数据集均为大小1080×1920分辨率、25帧/s的实拍视频,数据预处理方法流程如下.

图8 实验装置及环境

(1) 输入一段视频.

(2) 对视频隔帧截取,获得一组图片,得到待预测样本.

(3) 对待预测样本抽取10%,即对70张图片使用Labelme标记工具进行数据标记,生成训练集.

(4) 将训练集输入U-Net网络进行训练,并将全部待预测样本进行预测.U-Net网络运行环境为:Windows10系统,Python3.7,Tensorflow1.13.1,keras2.2.4;网络相关参数:batch size=2,epoch=200.其损失曲线如图9所示,可见其迭代至60步就已趋于稳定,训练集整体损失loss稳定至0.004,同时验证集整体损失val_loss稳定至0.012,且两者同步下降,说明训练良好,未出现过拟合现象,最终进行预测得到分割掩膜图片,即为本文所需数据集.

图9 U-Net网络的loss曲线

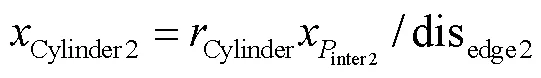

2.2 器械末端端点间距离实验

实验前将电磁传感器分别用透明胶固定在两器械柄部末端,固定直杆腹腔镜保证相机不发生相对运动,固定器械位置,手动测量两器械上传感器间距离并拍摄图片,同时使电磁传感器识别两器械的坐标,共拍摄并测量12组数据.

图10 器械柄部末端距离实验数据

分析得知,NDI磁导航传感器定位结果产生较大偏移,磁导航传感器工作时将其磁针的磁场强度与磁针的磁场特性结合从而确定磁导航传感器的位置,在其使用环境中,手术器械上的金属材料使得传感器周围磁场发生变化,导致传感器定位偏移,该偏移量稳定在11mm左右.计算得磁导航传感器偏差均值为10.2753mm,本文算法偏差均值为2.6581mm,磁导航传感器误差标准差为0.07855mm,本文误差标准差为0.07330mm,可见本文方法较磁导航传感器定位更准确,且其误差离散程度更小.

由于当下基于单目视觉的手术器械定位方法均需要进行相机标定或已知相机内参,而本算法无需此步骤,故与几个常用的手术器械定位方法进行比较从而说明其可用性.表2比较了多种手术导航定位与跟踪系统的平均定位精度,从表中可见,本研究提出的估计方法精度接近手术导航定位精度,且其无需增设任何设备,也不需要进行相机标定,相较之下具有一定的先进性.

表2 不同定位方法精度比较

Tab.2 Comparison of accuracy of different positioning methods

2.3 器械末端跟踪实验

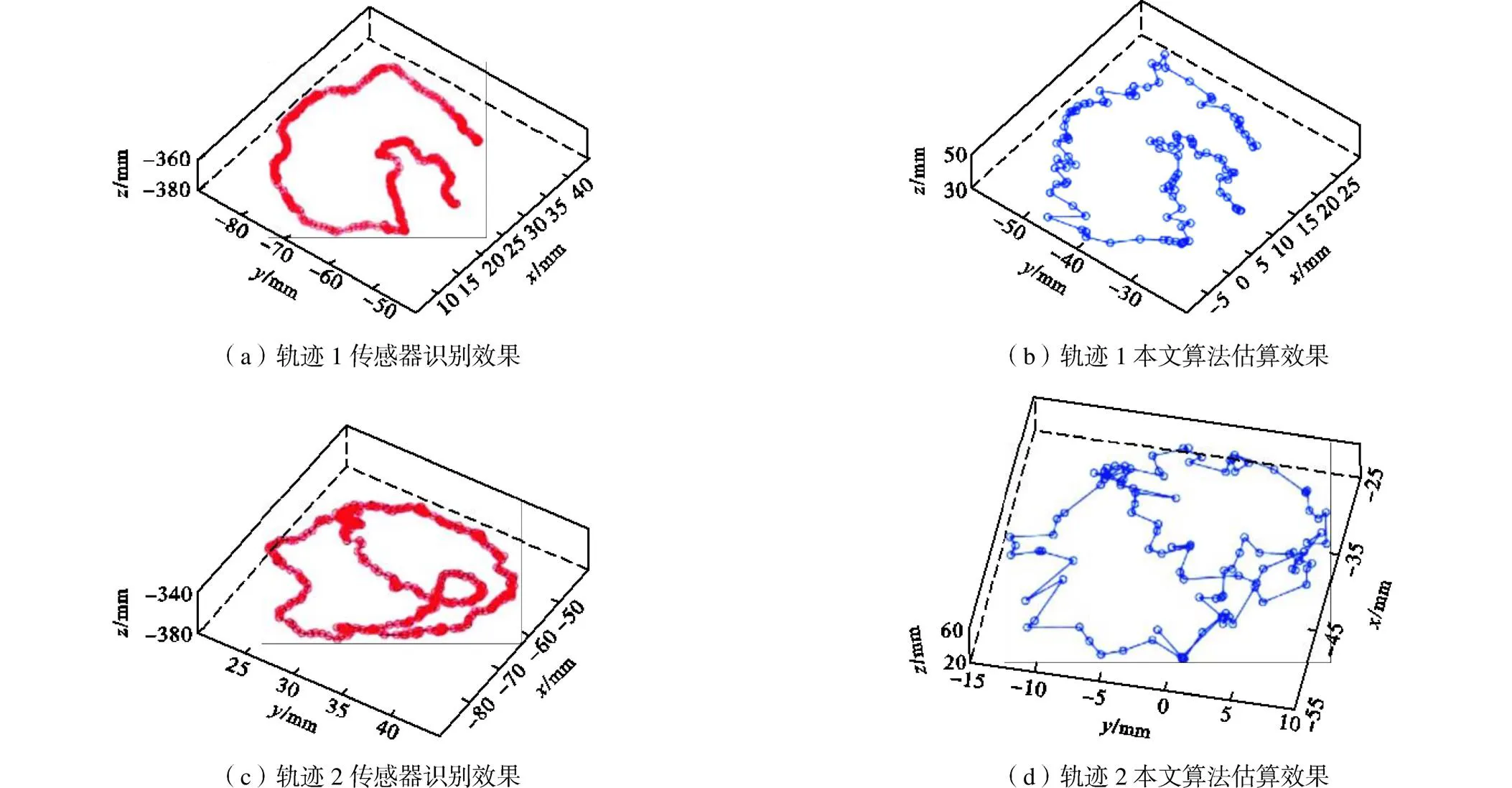

该实验仅需跟踪单个手术器械的运动轨迹,故仅在一把手术器械柄部末端贴上电磁传感器,实验过程中同时进行视频录制和电磁传感器跟踪,操作时将器械进行缓慢移动,移动轨迹尽量清晰简单,共设置5组实验,每组实验录制时长60s,视频帧率为25帧/s.对视频每隔15帧截取图片,获得100组数据,NDI电磁传感器的刷新频率约为40次/s,故每隔8次取300组传感器数据最终将本文算法估算得到的器械坐标与NDI电磁传感器识别坐标分别进行轨迹绘制,5组实验的轨迹如图11所示.

可看出本文算法能够较为准确地还原目标运动轨迹,与磁导航传感器跟踪获得的轨迹相似程度高,图12描述了5组实验中两方法的轨迹范围对比,其偏差不超过3.2mm,由于传感器与器械末端间相对姿态变化导致识别点存在1~2mm误差[25],且电磁传感器精度大于2.0000mm[26],可证明本文方法估算三维坐标达到准确率要求.

2.4 特定轨迹跟随图形拟合实验

由器械末端端点间距离实验可看出本文算法可获得准确率较高的距离估算值,在器械末端跟踪实验中,对单个器械进行轨迹跟踪实验时,将其与电磁传感器跟踪数据轨迹进行对比也可见本文算法具有较好的轨迹匹配效果,然而由于第2.2节所述实验1中电磁传感器较真实测量值发生较大偏移,故进行特定尺寸轨迹跟踪实验,跟踪实验目标点如图13中箭头所指处.

首先绘制半径为50mm的标准圆,将该圆固定于较为平整的平面上,将相机固定于任意合适位置. 以成像范围覆盖该标准圆为准,手持直径为5mm的手持器械,使其柄部末端处沿着圆周缓慢运动并录制该运动的视频. 视频时长30s,留有5s的数据同步时间以避免传感器发生延迟等,从第6s开始运动,运动时长25s.截取该运动片段并对此每隔5帧截取图片,获得125组数据,进行数据集预处理. 然后用本文估算方法计算每组数据的实际坐标,将该125组离散点坐标输入Matlab并进行标准圆拟合,得到半径52.1801mm的拟合圆,拟合效果如图14所示. 用拟合圆半径与标准圆半径之差再除以标准圆半径得到拟合误差,计算得具有4.36%的拟合误差,拟合圆心坐标为(-32.3540,25.2230,11.8670),通过计算离散点到拟合圆心的距离与理想圆半径做差,得到偏差值,绘制离散图如图15所示,有114组数据在4.8mm偏差范围内(91.2%的数据在此范围内).由于在实验中进行手持器械沿圆周运动操作时存在轨迹本身不完全重合于理想圆的情况,操作中产生 ±2mm以内的操作偏差,所以该实验误差可接受.

图12 两种方法轨迹范围对比

图13 特定轨迹跟踪轨迹实验

图14 拟合圆效果

图15 离散点拟合偏差

3 结 语

本文提出基于单目手术视频的器械工作空间研究的方法,该方法利用深度学习网络获得的手术器械分割掩膜作为输入,结合霍夫变换及投影平面上的平行线消隐点特性,建立直线检测优化模型并推导出目标点处的相对三维坐标.实验表明,本文方法具有比磁导航传感器更高的位置估计准确度和抗干扰性,测距偏差均值为2.6581mm,测距误差标准差为0.07330mm,具有可行的定位精度和较小的误差离散程度,获得了较高的轨迹拟合程度和91.2%的轨迹拟合率.为仅提供单目手术图像的条件下计算手术器械相对操作空间提供了可行性方案,对微创手术机器人的设计和手术切口设置具有重要的意义.

通过本文研究可知,基于单目视频进行手术器械的三维坐标估算方法是可行的,该方法具有计算量少、无附加条件限制等优点,但仍无法达到多目、外设传感器等更成熟的方法的精度,且在对比实验中存在难以避免的系统误差.未来的研究方向可以考虑将单目视频流的时序特征与卷积神经网络相结合,有望进一步提高三维坐标估计精度.最后,进一步探索更好的模型框架,对相机运动进行估算也是本领域将来的研究方向之一.

[1] Guthart G S,Salisbury J K. The intuitiveTMtelesurgery system:Overview and application[C]//IEEE Interna-tional Conference on Robotics & Automation(ICRA). San Francisco,USA,2000:618-621.

[2] 安芳芳,荆朝侠,彭 燕,等. 达芬奇机器人的“前世、今生、来世”[J]. 中国医疗设备,2020,35(7):148-151,168.

An Fangfang,Jing Zhaoxia,Peng Yan,et al. The past,present and future of the da Vinci robot[J]. China Medical Equipment,2020,35(7):148-151,168(in Chinese).

[3] 倪志学. 腹腔微创手术机器人控制系统研究[D]. 长春:吉林大学机械与航空航天工程学院,2021.

Ni Zhixue. Research on the Robot Control System for Minimally Invasive Abdominal Surgery[D]. Chang-chun:School of Mechanical and Aerospace Engineer-ing,Jilin University,2021(in Chinese).

[4] Zhang J Y,Gao X. Object extraction via deep learning-based marker-free tracking framework of surgical instruments for laparoscope-holder robots[J]. International Journal of Computer Assisted Radiology and Surgery,2020,15(8):1335-1345.

[5] Peng J,Chen Q,Kang L,et al. Autonomous recognition of multiple surgical instruments tips based on arrow OBB-YOLO network[J]. IEEE Transactions on Instrumentation and Measurement,2022,71:1-13.

[6] Mahmoud N,Cirauqui I,Hostettler A,et al. ORBSLAM-based endoscope tracking and 3D reconstruc-tion[C]// International Workshop on Computer-Assisted and Robotic Endoscopy(CARE). Qubec City,Canada,2017:72-83.

[7] Phan T B,Trinh D H,Lamarque D,et al. Dense optical flow for the reconstruction of weakly textured and structured surfaces:Application to endoscopy[C]// IEEE International Conference on Image Processing(ICIP). Taipei,China,2019:310-314.

[8] 岑仕杰,何元烈,陈小聪. 结合注意力与无监督深度学习的单目深度估计[J]. 广东工业大学学报,2020,37(4):35-41.

Cen Shijie,He Yuanlie,Chen Xiaocong. A monocular depth estimation combined with attention and unsupervised deep learning[J]. Journal of Guangdong University of Technology,2020,37(4):35-41(in Chinese).

[9] Ma X Z,Ouyang W L,Simonelli A,et al. 3D object detection from images for autonomous driving:A survey[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition(CVPR). New Orleans,USA,2022.

[10] Reading C,Harakeh A,Chae J,et al. Categorical depth distribution network for monocular 3D object detection[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition(CVPR). 2021:8551-8560.

[11] Ku J,Pon A D,Waslander S L. Monocular 3D object detection leveraging accurate proposals and shape reconstruction[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition(CVPR). Long Beach,USA,2019:11867-11876.

[12] Bao Y D,Li K,Qi D B,et al. Recent patents on the structure of medical endoscope[J]. Recent Patents on Engineering,2022,16(4):81-95.

[13] Zhang W,Li H Y,Cui L L,et al. Research progress and development trend of surgical robot and surgical instrument arm[J]. The International Journal of Medical Robotics+Computer Assisted Surgery,2021,17(5):e2309.

[14] 微创医疗. 图迈®腔镜手术机器人[EB/OL]. https:// www.microport.com.cn/health/product/109.html,2022-06-13.

MicroPort. Toumai™ endoscopic surgery robot [EB/OL]. https://www.microport.com.cn/health/product/ 109. html,2022-06-13(in Chinese).

[15] 微创医疗. 鸿鹄®骨科手术机器人[EB/OL]. https:// www.medbotsurgical.com/patientcare/robot/guke,2022-06-13.

MicroPort. Honghu(SkyWalker™ for FDA(510k)) [EB/OL]. https://www.medbotsurgical.com/patientcare/ robot/guke,2022-06-13(in Chinese).

[16] 李雄宗,李翠华,张丹莹,等. 一种柔化锯齿的超分辨率图像重建方法[J]. 厦门大学学报(自然科学版),2012,51(3):348-352.

Li Xiongzong,Li Cuihua,Zhang Danying,et al. A method of softening the jagged in image super-resolution reconstruction[J]. Journal of Xiamen University(Natural Science),2012,51(3):348-352(in Chinese).

[17] Ballard D H. Generalizing the Hough transform to detect arbitrary shapes[J]. Pattern Recognition,1981,13(2):111-122.

[18] 刘川熙,赵汝进,刘恩海,等. 基于RANSAC的SIFT匹配阈值自适应估计[J]. 计算机科学,2017,44(增1):157-160.

Liu Chuanxi,Zhao Rujin,Liu Enhai,et al. Estimate threshold of SIFT matching adaptively based on RANSAC[J]. Computer Science,2017,44(Suppl1):157-160(in Chinese).

[19] 关 闯,魏 朗,乔 洁,等. 一种基于消隐点的单目视觉车辆测距方法[J]. 电子测量技术,2018,41(11):83-87.

Guan Chuang,Wei Lang,Qiao Jie,et al. A vehicle distance measurement method with monocular vision based on vanishing point[J]. Electronic Measurement Technology,2018,41(11):83-87(in Chinese).

[20] 毕嘉桢,沈 拓,张轩雄. 基于机器视觉的轨道交通自动测距研究[J]. 电子科技,2022,35(9):1-7.

Bi Jiazhen,Shen Tuo,Zhang Xuanxiong. A research on distance measurement between trains in rail transit based on machine vision[J]. Electronic Science and Technology,2022,35(9):1-7(in Chinese).

[21] NDI. Product[EB/OL]. https://www.ndigital.cn/,2022-07-11.

[22] 孙九爱,庄天戈. 计算机辅助外科手术中被动多眼定位方法[J]. 上海交通大学学报(自然科学版),2002,36(1):76-78.

Sun Jiu’ai,Zhuang Tiange. Passive multi-eye localizing method in computer assisted surgery[J]. Journal of Shanghai Jiaotong University(Natural Science Edition),2002,36(1):76-78(in Chinese).

[23] 王遵亮. 图像导航外科手术光学三维定位系统的研究与开发[D]. 南京:东南大学生物科学与医学工程系,2002.

Wang Zunliang. Research and Development of Optical 3D Positioning System for Image Navigation Surgical Operation[D]. Nanjing:School of Biological Science & Medical Engineering,Southeast University,2002(in Chinese).

[24] 陈 为,Georios Sakas,彭群生. 手动式电磁定位及图像导航的短径癌症放射治疗系统[J]. 计算机辅助设计与图形学学报,2002,14(9):870-877.

Chen Wei,Georios S,Peng Qunsheng. A free hand navigation system for brachytherapy[J]. Journal of Computer Aided Design &Computer Graphics,2002,14(9):870-877(in Chinese).

[25] 郭兆君,丁 辉,王广志,等. 手术导航中定位跟踪系统精度问题的研究[J]. 北京生物医学工程,2008,27(2):146-150.

Guo Zhaojun,Ding Hui,Wang Guangzhi,et al. Research of orientation and tracking system accuracy in image guide surgery[J]. Beijing Biomedical Engineering,2008,27(2):146-150(in Chinese).

[26] 姜立军,甘东兵,王国荣. 基于双目视觉传感的计算机辅助骨外科手术导航模型[J]. 华南理工大学学报(自然科学版),2006,34(2):67-72.

Jiang Lijun,Gan Dongbing,Wang Guorong. Navigation model of computer-assisted orthopedic surgery based on binocular vision sensor[J]. Journal of South China University of Technology(Natural and Science Edition),2006,34(2):67-72(in Chinese).

Relative Workspace Estimation Method of Surgical Instruments Based on Monocular Video

Su He,Bai Xue

(School of Mechanical Engineering,Tianjin University,Tianjin 300354,China)

It is difficult to accurately estimate the three-dimensional coordinates of surgical instruments under an endoscopic lens based on the monocular image because the lens parameters of monocular surgical video are unknown. Consequently,a method for estimating the relative workspace of surgical instruments is proposed to address this difficulty. First,the straight lines in the mask image segmented by U-Net were detected,and the points mapped from straight lines in the image coordinate to parameter space were grouped to maximize the effect of straight-line detection.Second,to make up for the incomplete lines caused by poor network segmentation,the edge segment’s geometric position feature was used by extracting the complete segment with a high degree of fit with the edge of the target. Furthermore,the actual 3D coordinate estimation of the target equipment was calculated using the proportional relationship between the actual and image size of the target instrument and the characteristics of the parallel line’s vanishing point. Finally,ranging and trajectory tracking experiments were conducted. The experimental results show that this method has higher accuracy and robustness than magnetic navigation sensors,and it achieves a distance measurement accuracy of 2.6581mm and a trajectory fitting degree reaching 91.2%,which meets the requirements of the relative workspace estimation of surgical instruments in the actual situation.

workspace;monocular vision;3D coordinate estimation;surgical robot

10.11784/tdxbz202206022

TP391

A

0493-2137(2023)08-0785-11

2022-06-05;

2022-09-10.

苏 赫(1984— ),男,博士,副教授,suhe@tju.edu.cn.Email:m_bigm@tju.edu.cn

白 雪,snowwhite29@126.com.

国家自然科学基金资助项目(52175028).

the National Natural Science Foundation of China(No. 52175028).

(责任编辑:王晓燕)