融合残差和卷积注意力机制的U-Net网络高分影像道路提取

2023-06-15张亚宁张春亢王朝游晨宇

张亚宁 张春亢 王朝 游晨宇

融合残差和卷积注意力机制的U-Net网络高分影像道路提取

张亚宁 张春亢 王朝 游晨宇

(贵州大学矿业学院,贵阳 550025)

针对在高分辨率遥感影像中因道路特征模糊或“同谱异物”现象影响,出现局部道路提取缺失和提取错误的问题,提出一种融合残差和卷积注意力机制的U-Net网络高分影像道路提取方法。首先,以U-Net网络为基础,加入改进的残差模块缓解网络训练过程中易出现的网络性能退化问题;然后,嵌入卷积注意力机制模块加强对道路细节特征的深度表征能力;最后通过几何变换对数据集进行合理扩充,增强网络泛化能力。在公开数据集马塞诸塞州数据集(Massachusetts Roads Dataset)和DeepGlobe道路数据集上对模型进行测试,实验结果表明:文章提出的方法在两个数据集上整体精度分别达到97.02%和98.26%,相比其他模型具有更好的提取效果,对道路特征的深度表征性更强,抗干扰性较好,有效改善了道路提取中出现的错提、漏提现象,显著提高了道路提取的精度和完整性。

道路提取 残差模块 卷积注意力机制 高分辨率遥感影像

0 引言

道路作为重要的基础地理信息要素,其分布错综复杂,建设范围较广,及时更新道路分布信息是地理信息数据库建设的重要基础,因此从高分辨率遥感影像中实现对道路的精准提取成为近些年国内外学者的研究热点。

以道路提取层次的推进为分类依据,一般将道路提取方法分为三类[1]:1)基于像元的道路提取方法。该类方法主要利用道路的波谱特征对道路信息进行提取。如罗庆洲等将道路的光谱特征与几何特征相结合实现了对道路的提取[2];罗巍等利用角度纹理特征结合最小方差方向对城市主干道路进行提取[3];Sghaier等通过基于小束变换的纹理分析和多尺度推理有效提取出道路[4]。该类方法对道路分布稀疏、背景单一、图像清晰的高分辨率遥感影像适用性较强,但在道路特征不明显的复杂场景下或受其他地物干扰情况下提取精度较低。2)基于对象的道路提取方法。该类方法主要将遥感图像中的道路视为整体,对其进行小面积分割,然后以小面积为单位再进行道路提取。如陈杰等提出结合尺度空间思想利用分水岭算法和形态学的方法对道路信息进行提取[5];Guo等将形状特征与构造的随机森林标记学习分类器得到的后验概率相结合,利用张量投票法得到道路中心线[6];林鹏等提出利用复合向量机结合形态学进行城镇道路自动提取[7];汪闽等提出结合马尔科夫随机场模型结合支持向量机进行道路网提取[8]。该类方法适合于背景地物多样且特征明显的类型单一化道路的遥感图像,而对特征信息相似的各类地物易发生混分或粘连现象。3)基于深度学习的道路提取方法。该类方法具有较强的学习能力能够高效地表达地物特征,有效辨别出道路区域和非道路区域。如Zhou等提出以LinkNet网络[9]为主干结合扩张卷积层的方法对道路信息进行提取[10];Lin等提出改进的深度残差卷积神经网络模型(RDRCNN),其结合剩余连接单元(RCU)和扩展感知单元(DPU)来获取道路信息[11];马天浩等提出以多尺度特征融合膨胀卷积神经网络的方法获得道路信息[12]。该类方法适合于背景地物类型多样,特征相似且道路分布复杂的遥感影像,但其提取结果仍会出现道路断裂和毛刺现象,精确度有待于进一步提升。

为了进一步提升高分辨率遥感影像道路提取和分割的精度,近年来,众多学者从深度学习角度出发,不断探究和改进模型结构,其中U-Net网络[13]结构融合了深层特征的语义信息和底层的位置信息,可以在浅层特征和深层特征之间自由选择,对语义分割具有较强的优势,在图像分割领域被广泛应用。如Ren等提出一种融合胶囊表征和注意力机制的双注意胶囊U-Net(DA-CapsUNet)对道路区域进行提取[14];孔嘉嫄等将U-Net网络结构加深至七层,加入多维度监督机制(MD-MECA)达到优化目的,并利用激活失活模块(DropBlock)和批归一化(Batch Normalization)层,有效地解决了道路提取中出现的过拟合问题[15]。但以上方法在道路边缘地物特征模糊处仍会发生提取缺失的现象。

本文针对道路提取过程中因道路特征模糊或“同谱异物”现象影响,易出现的局部道路提取缺失和提取错误等问题,提出一种融合残差和卷积注意力机制的U-Net网络高分影像道路提取方法。该方法以U-Net网络模型为基础框架,加入改进的残差模块即将原本残差模块中的Relu激活函数[16]改为Mish激活函数[17]缓减梯度消失,防止随着网络层数增加易产生的性能退化问题,并嵌入卷积注意力机制加强对道路细节特征的深度表征能力,抑制非道路信息。改进后的模型可以更深层次地提取到道路细节特征,无论对浅层纹理特征还是多尺度特征都有更精确化地表达,最后将本文算法与FCN[18]、PSPNet[19]、Deeplabv3+[20]、CE-Net[21]和U-Net网络算法进行比较,有效地改善了提取中易出现的错提、漏提现象。

1 网络结构

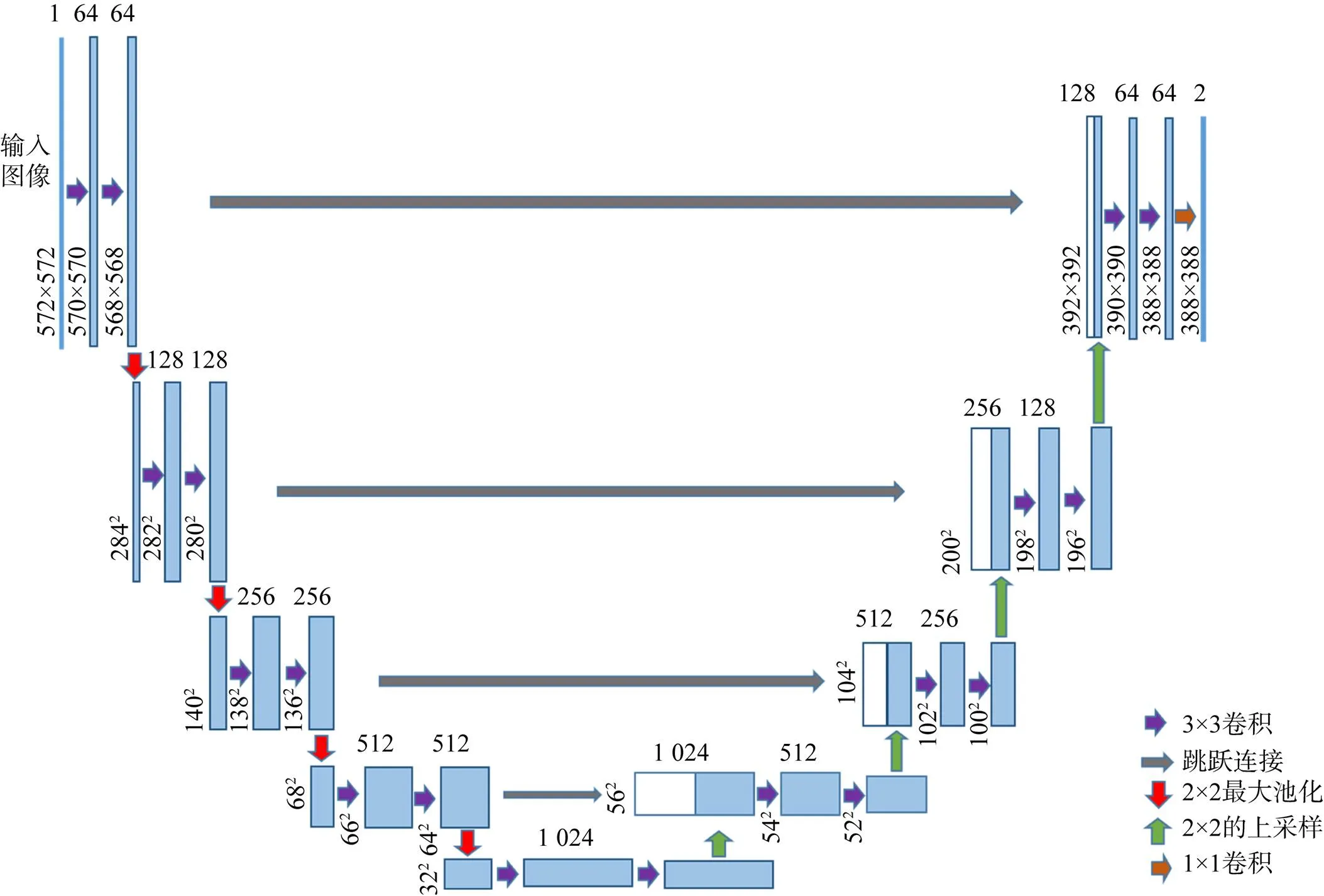

1.1 U-Net网络结构

U-Net网络是一款专为生物医学图像分割而开发的卷积神经网络,采用经典的编码器-解码器结构和跳跃连接方式,如图1所示。U-Net网络由一个获取全局信息的收缩编码路径和一个与其对称的用于精确定位的扩展解码路径组成,可以将浅层的定位信息和高层的像素分类判定信息相融合,从而得到更佳的定位效果。收缩路径采用典型的卷积神经网络,每个特征尺度采用3×3卷积运算,然后用2×2的最大池化做降采样(步长为2),每次降采样的特征通道数都会增加一倍。扩展路径采用2×2的反卷积,每次反卷积的特征通道数减少一半,与同尺度的降采样部分的特征图直接拼接,然后再经过两个3×3的卷积层,最后通过1×1卷积运算完成操作,将特征图映射到实际需要的分类数目的通道数,进而达到最佳的分割结果。

图1 U-Net网络结构

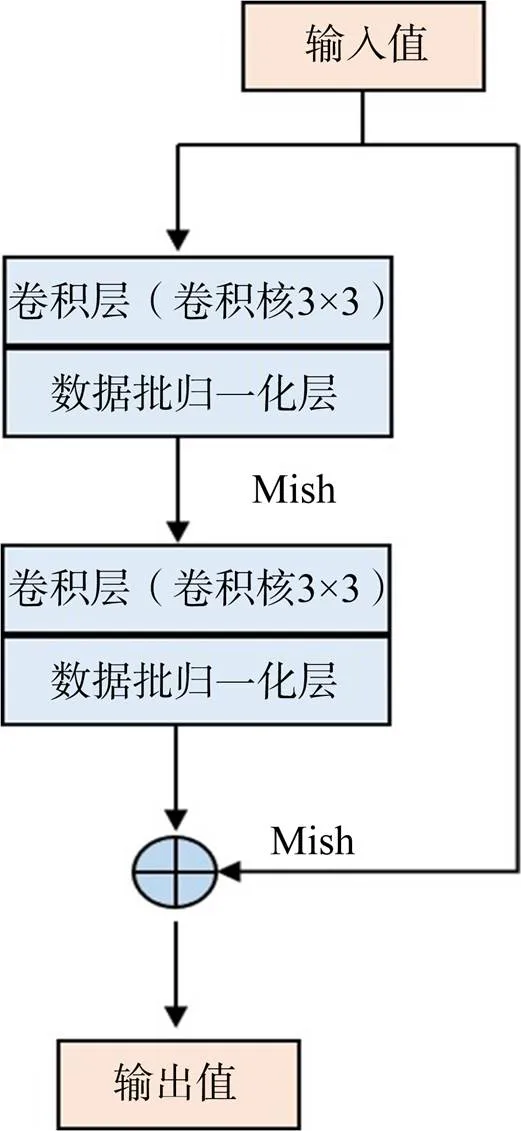

1.2 改进的残差模块

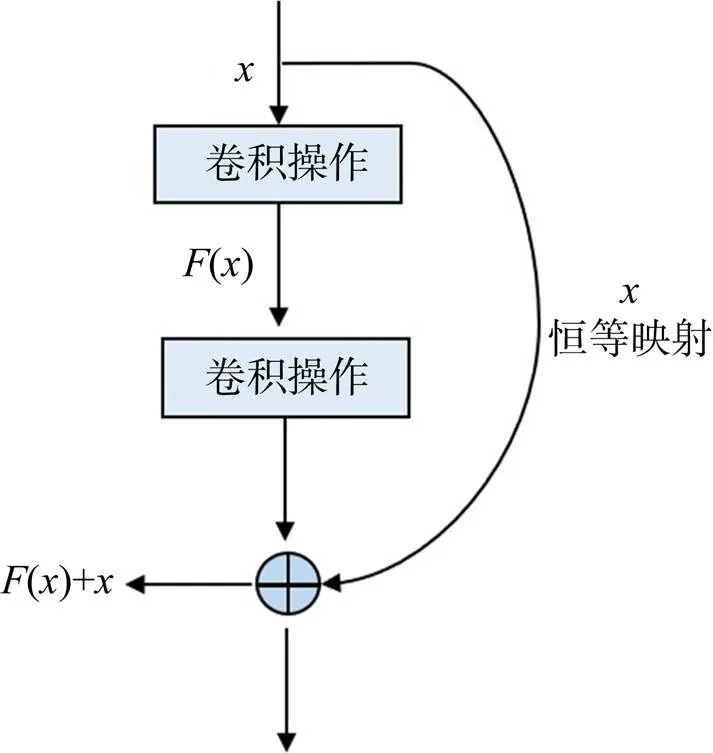

在深度学习训练过程中随着网络深度的增加,训练难度逐渐变大,易出现网络性能退化问题。U-Net网络在压缩降维和扩展路径过程中,通过多次复杂的连续卷积和池化运算,像素间关系的计算难度增大,网络承载信息量能力不足导致网络抖动,精度容易达到饱和,产生网络性能退化问题,训练精度也会随之迅速下降。He等针对网络模型层数加深时,堆叠层引起的网络性能退化问题,提出了残差结构模块[22],如图2所示,图2中表示输入值,()表示残差值,()+表示学习到的特征值,该结构通过“便捷连接”有效预防梯度消失或梯度爆炸现象的产生,可加快网络的收敛速度。通常为了使网络模型能够学习到更深层次图像特征,网络层数在逐渐加深过程中会产生冗余层,通过残差学习结构使残差值()=0让该层网络恒等映射到上一层的输入,可规避网络性能退化问题,并且不会增加模型的参数复杂度,避免模型在学习过程中训练误差变大,特征信息提取能力下降这一问题。

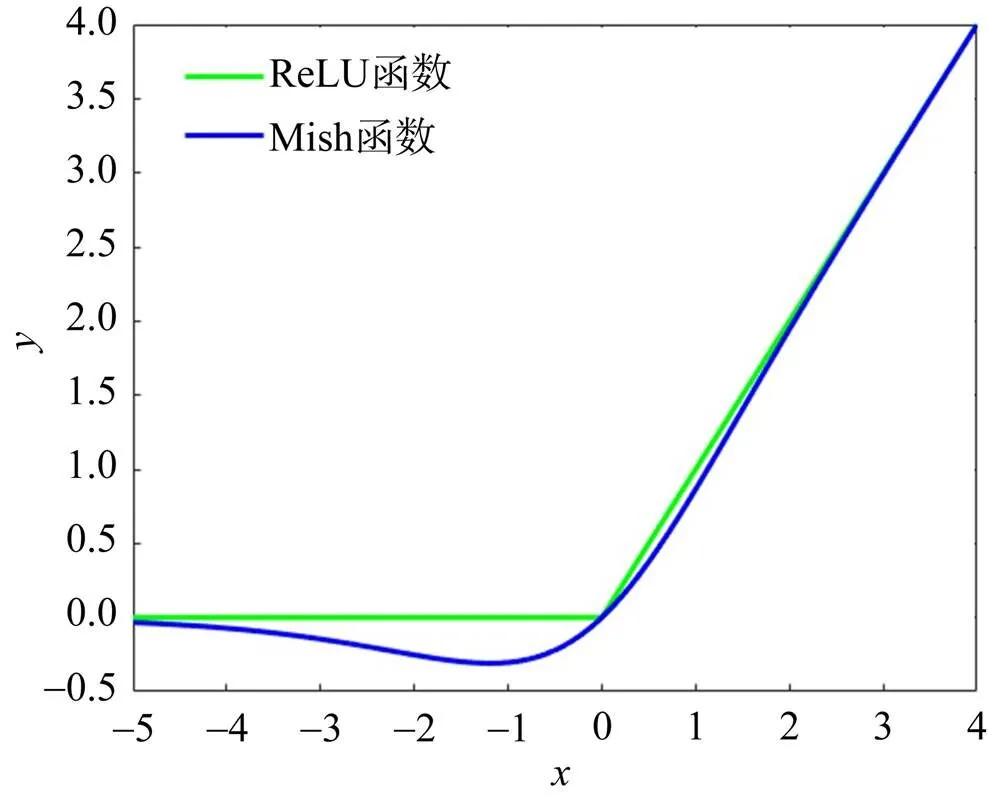

激活函数的主要作用是完成对传输数据的非线性变换,提高线性模型的表达能力,解决模型分类能力不足的问题。在残差结构模块中,当负梯度流经过ReLU激活函数时,输出值为0,产生梯度消失,降低模型对数据正确拟合能力或训练能力。为了解决梯度消失问题,本文根据YOLO v4算法[23]主干的结构组成,将残差网络中的ReLU函数替换成Mish函数,两种激活函数的比较如图3所示,图3中表示输入值,表示对应的输出值。Mish函数具有连续可导性,是一种光滑的自正则非单调激活函数,其非单调性有助于保持小的负值,从而稳定网络梯度流,缓减梯度消失问题,稳定结构;无穷连续性和光滑性使其具有较好的泛化能力和有效优化能力。

图2 残差结构

图3 激活函数比较

图4 改进的残差结构

改进后的残差模块如图4所示,由3×3卷积层、数据批归一化层(BN)以及Mish激活函数组成。

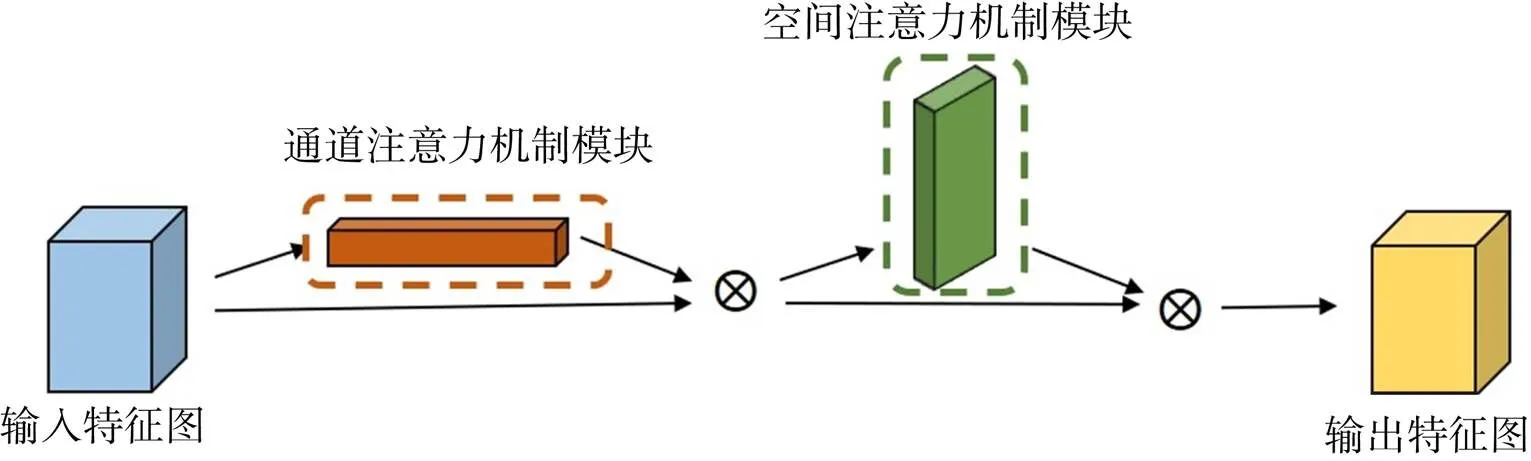

1.3 卷积注意力机制

注意力机制核心作用是有效捕捉图像中重点区域细节特征,强化关键特征信息量的语义表达,忽略无关特征。在U-Net网络图像处理传输过程中,嵌入卷积注意力机制(CBAM)[24]模块可自适应地细化跳跃连接阶段的特征映射,增强对编码区特征信息传输过程中浅层道路细节纹理特征的提取能力,有利于模型对道路特征信息的深度表征,而对其他特征信息进行抑制,使解码区对道路特征信息的提取具有更强的针对性,在传递到解码区的过程中,可以更好地完成对道路边缘处细小道路的分割细化能力。CBAM模块的特征学习过程如图5所示,主要通过通道注意力机制和空间注意力机制两个子模块协同作用,帮助信息在网络中流动,完成整个学习过程。

图5 卷积注意力机制

式中 表示Sigmoid激活函数;;;r表示衰减率;和分别对应经过多层感知机的权重。

式中 AvgPool表示平均池化;Maxpool表示最大池化;表示滤波器大小为的卷积运算。

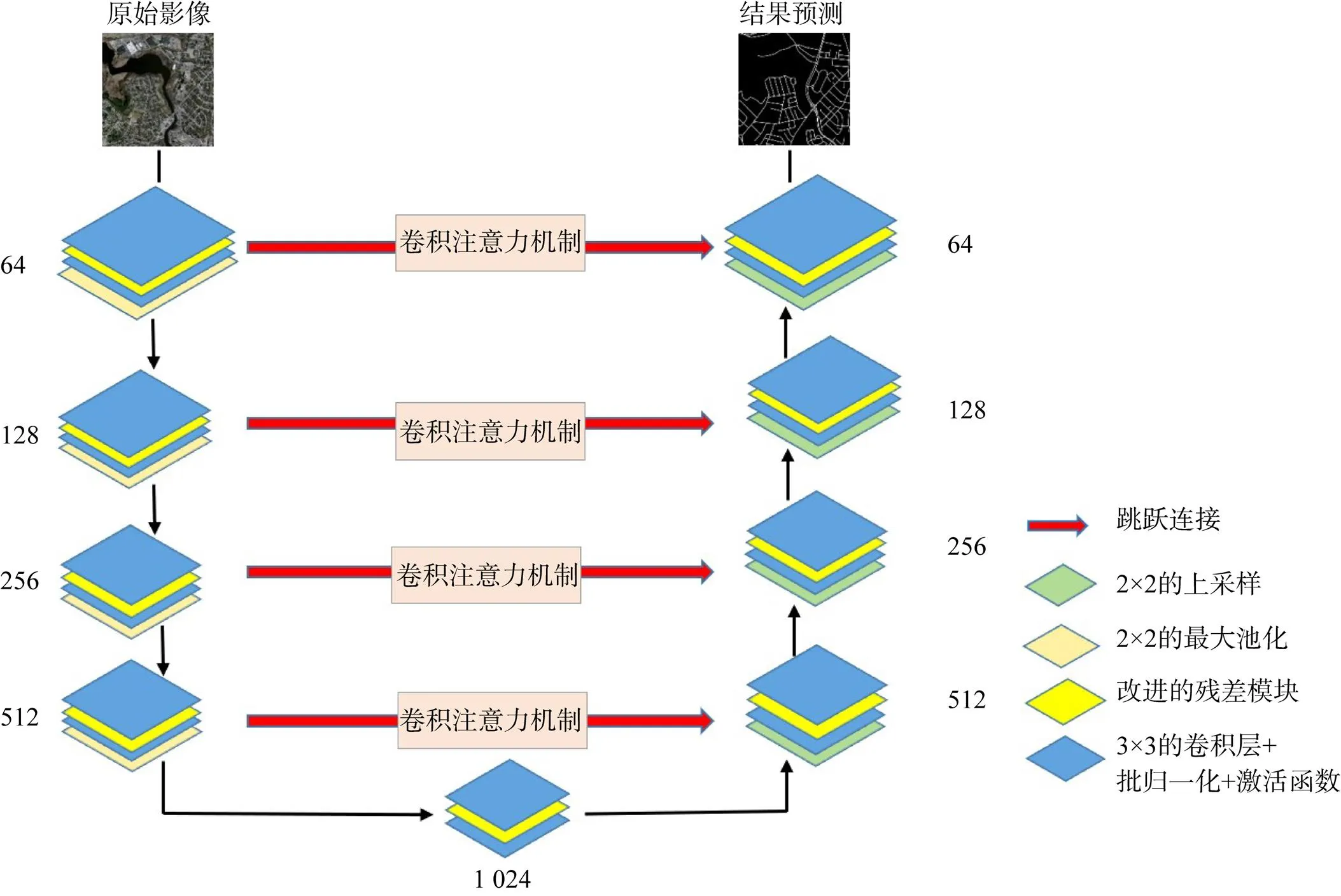

1.4 融合后整体网络结构

本文实验的网络结构如图8所示,在U-Net网络编码区和解码区每两个相邻的3×3卷积层中间加入改进的残差模块,可避免卷积层连续堆叠的复杂计算造成像素区域信息丢失,同时增加网络深度,使其可以学习到更多深层次的特征信息,有效防止训练过程中随着网络层数深度的增加,精度达到饱和,引起的网络性能退化的问题。为使道路边缘细节特征提取尽量完整,在跳跃连接阶段嵌入卷积注意力机制模块可以将编码区的浅层道路纹理特征进一步准确分割,实现道路特征信息的深度表征能力,有效抑制非道路信息的表达。

图8 融合后整体网络结构

2 实验与评价指标

2.1 实验数据集及预处理

本文采用的实验数据集为公开数据集马萨诸塞州道路数据集(Massachusetts Roads Dataset)和DeepGlobe卫星数据集[25]。Massachusetts Roads数据集中包含了波士顿地区的城市、乡村、城乡结合部等地区航空遥感影像数据。数据集中的遥感影像空间分辨率为1 m,每张影像尺寸大小为1 500像素×1 500像素,总覆盖面积超过2 600 km2,共包含1 171张红绿蓝(RGB)三通道影像数据及对应的标签数据,其中1 108张影像及其对应的标签数据用于训练,49张影像及其对应的标签数据用于测试,14张影像及其对应的标签数据用于验证。

DeepGlobe卫星数据集共包含6 226张训练样本及其对应的标签数据,影像的地面分辨率为0.5 m,每张影像尺寸大小为1 024像素×1 024像素,将其按照8:1:1进行随机划分,其中训练集由4 980张影像及其对应的标签数据组成,测试集和验证集分别由623张影像及其对应标签数据组成。

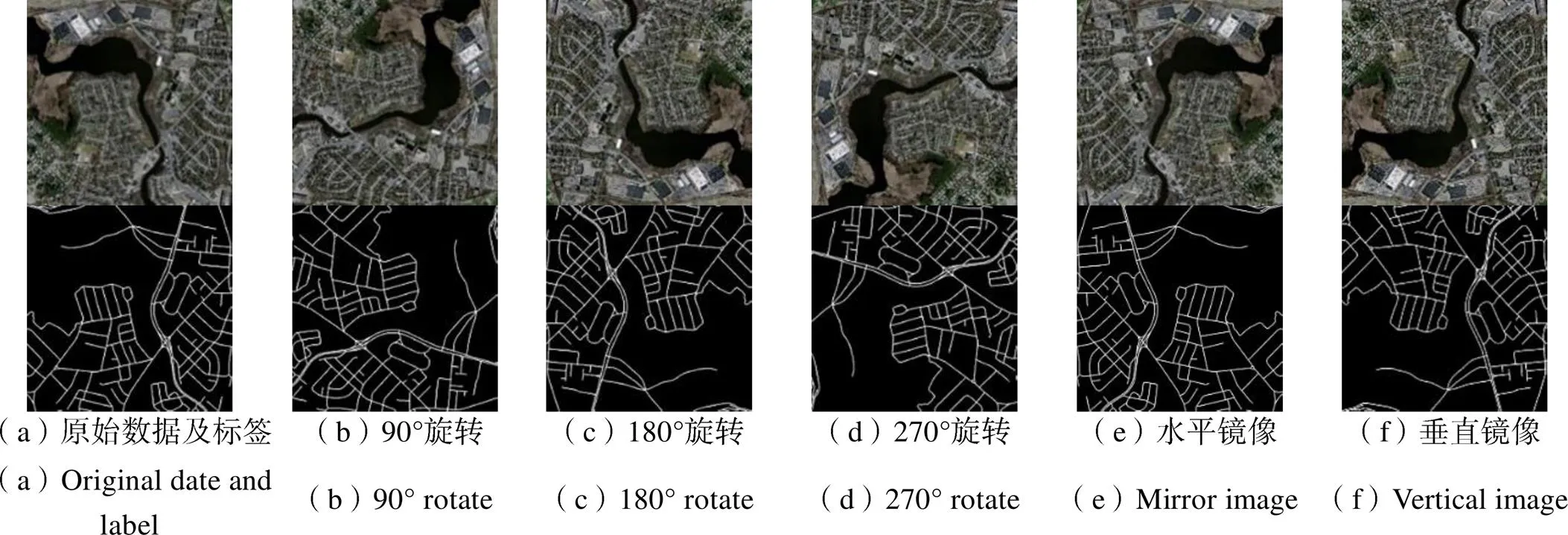

考虑到实验硬件条件的现实情况,本文将数据集中所有影像缩放为512像素×512像素大小。为了防止模型发生过拟合,提高网络泛化能力,使训练数据尽可能的接近测试数据,从而提高测试精度,本文用几何变换方法实现对训练的数据集进行扩充处理。图9为部分扩充数据。

图9 扩充训练数据

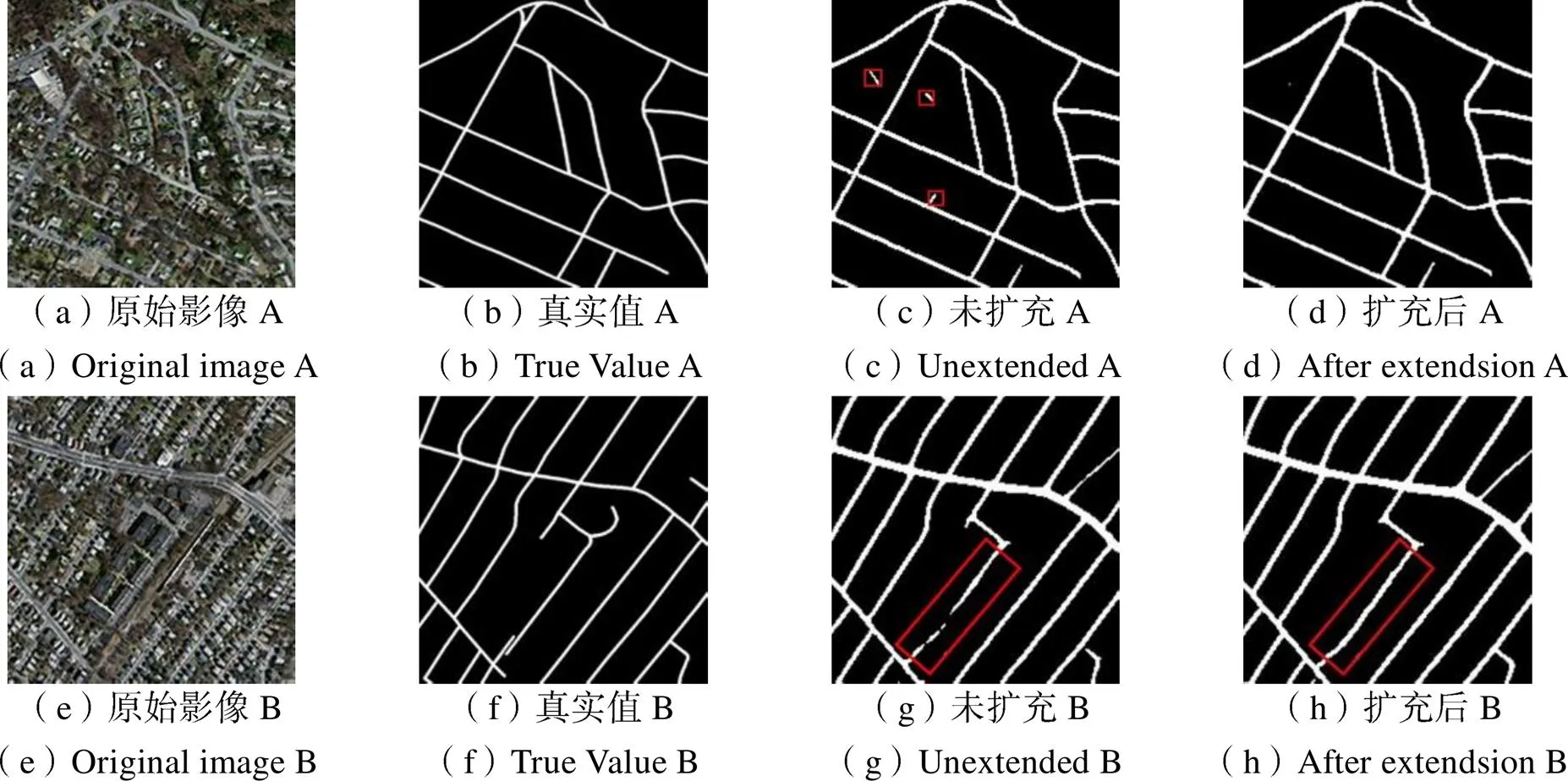

同时为了探究影像扩充前后的数据集对本文提出的实验方法的影响,分别将扩充前后的两个数据集加入到实验模型中训练,实验结果如图10所示。

图10 扩充实验对比

实验结果表明,通过几何变换进行数据集扩充后道路提取效果提升明显。影像A整体区域中,在部分建筑物密集区,当数据集未扩充时存在将建筑物误分为道路的现象,数据集扩充后该现象明显减少;影像B整体区域中,当道路特征不明显时,数据集未扩充时出现道路断裂情况,而数据集扩充后该现象得到有效缓减。结合以上实验现象说明本实验扩充数据集后网络模型的泛化能力增强,道路提取结果有显著提升。

2.2 实验环境及参数设置

本次实验为Ubuntu20.04系统平台,采用Python程序语言,基于Pytorch1.9.0深度学习框架,运行环境为CPU Intel Core i9-990 0k,显卡型号为NVIDIA RTX 208 0T i 11Gb。本文在该计算机硬件条件允许下,经过多次反复的测试实验后,得到最佳的参数设置如下:模型基本学习率(base_lr)设置为0.001,迭代轮数(epoch)设置为30,训练集和验证集的批大小(batch size)均设置为4。

2.3 评价指标

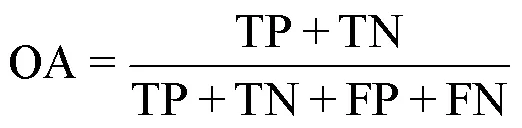

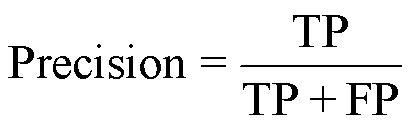

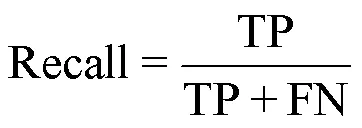

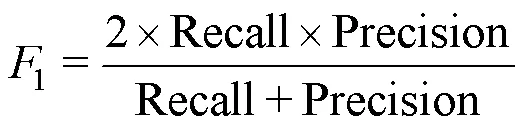

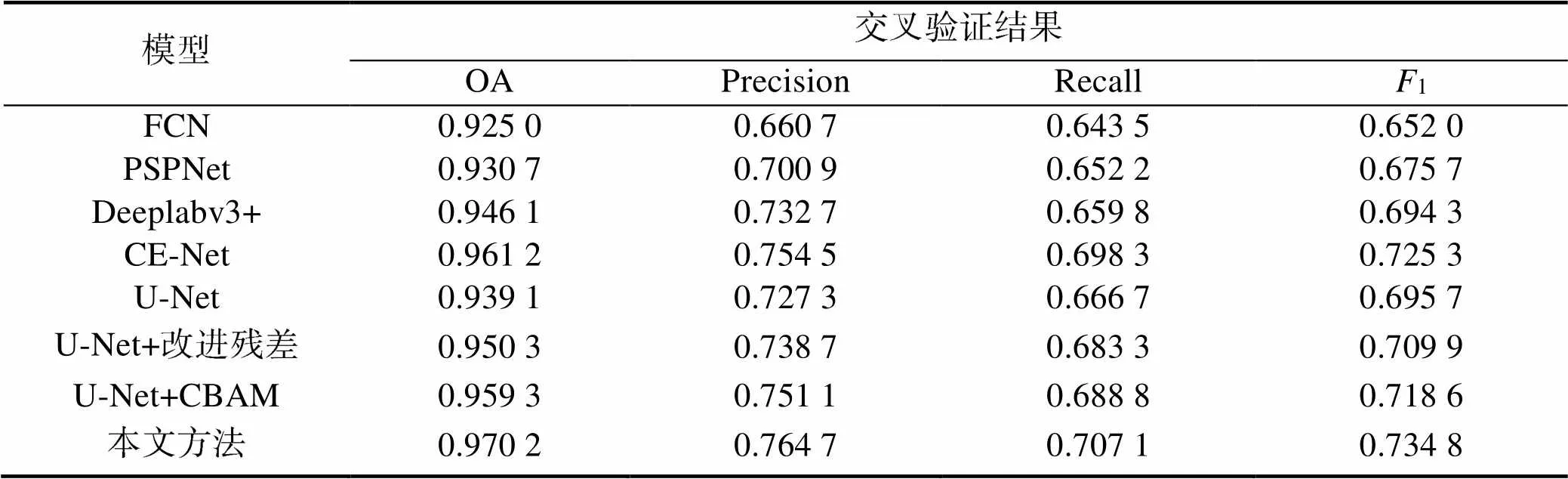

为了评估本文提出的道路提取方法的有效性及准确性,实验从整体精度OA(Overall Accuracy)、准确率Precision、召回率Recall、1值[26]等4个指标对道路提取结果进行评定。定义见下式

3 实验结果对比与分析

3.1 各模型在Massachusetts Roads数据集的实验结果与分析

为了证明本文方法的有效性和优越性,在Massachusetts Roads数据集上,分别训练经典语义分割模型FCN、PSPNet、Deeplabv3+、CE-Net、U-Net与本文提出的模型,通过整体精度、准确率、召回率、1值等四项指标对各模型的道路提取能力进行比较。表1为各项评定指标的定量比较,从表1可知:1)本文提出的融合残差和卷积注意力机制的U-Net模型在整体精度、准确率、召回率、1值分别达到了97.02%、76.47%、70.71%、73.48%,相较于U-Net网络对应的各项指标值分别提高了3.11%、3.74%、4.04%、3.91%,提升较大;2)本文方法与FCN、PSPNet、Deeplabv3+、CE-Net网络模型比较,在各项评定指标值上也有提升;3)通过消融实验,对比U-Net+改进残差和U-Net+CBAM网络,本文方法在各项对应指标值上也稍有提升。综上可知,本文方法具有一定的道路提取优势。

表1 各模型在Massachusetts Roads数据集上的精度对比

Tab.1 Accuracy comparison of each model on the Massachusetts Roads dataset

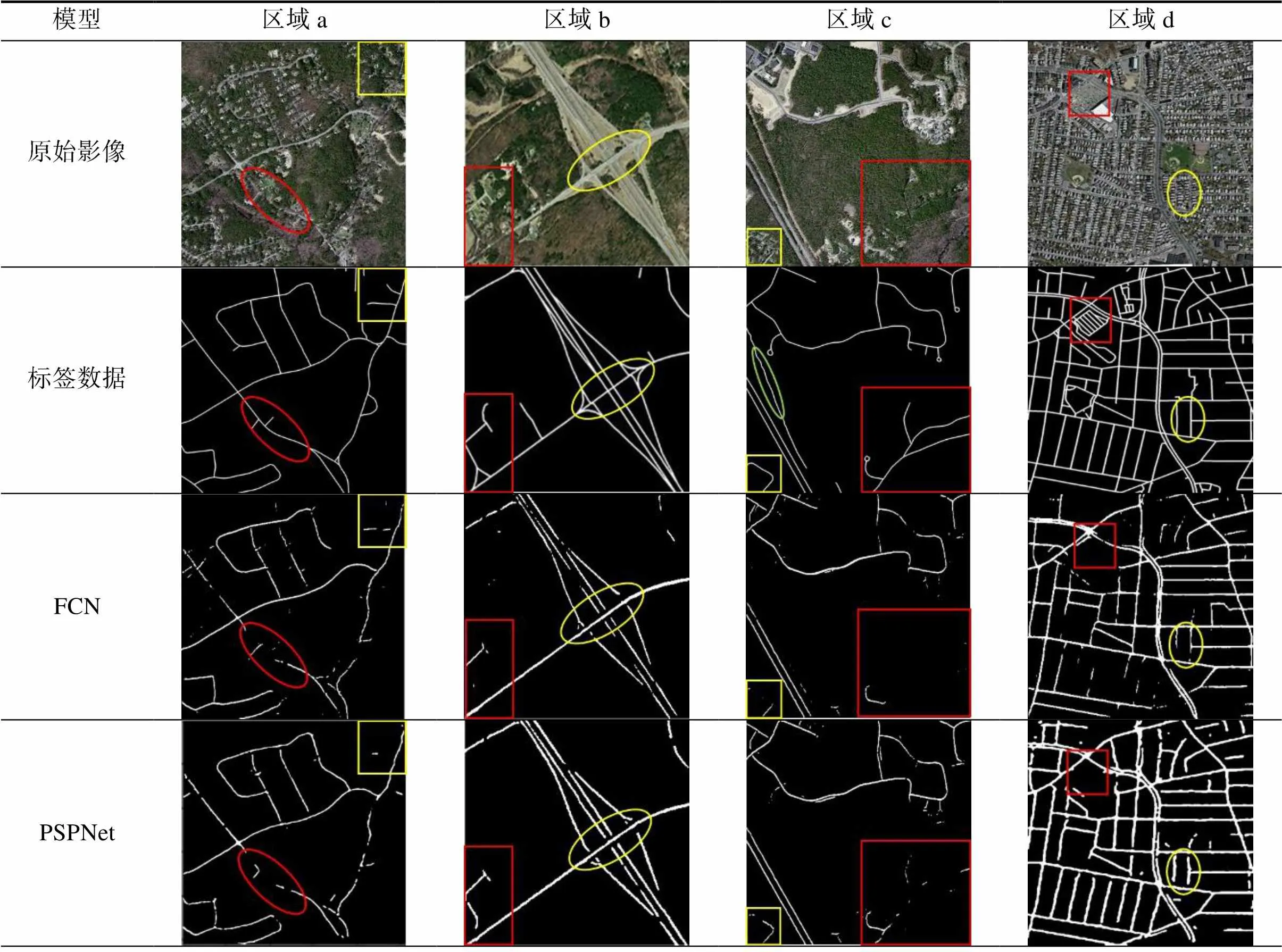

为证明本文方法的普遍适用性,分别选取了四种不同场景的道路提取结果图进行比较,如表2所示。区域a为植被道路混合区域,区域b为立交桥背景区域,区域c为大面积植被覆盖区,区域d为复杂的大型城市道路网。在区域a中,该区域红色框标和黄色框标路段受周围植被遮挡,黄色区域为边缘细小道路特征尤为模糊,本文提取方法对此区域道路特征模糊路段较原U-Net模型提取相对完整。在区域b中,在所标出的两道路交叉口处,由于交叉口本身较小,在原U-Net模型提取过程中易出现缺失,但本文方法不仅在交叉口细节处提取完整使连通性较好,且在主干道路相邻近处不存在道路粘连现象。在区域c中,红色框标处道路受大面积植被全覆盖,造成提取困难,黄色框标部分道路特征也不明显,本文方法在该两处提取结果较原U-Net模型较佳,且在绿色框标处提取到该路段的部分缺失道路。在区域d中,道路分布错综复杂,不相关地物较多,红色框标区域易出现“同谱异物”现象,受光谱特征影响可能出现道路提取错误或缺失,且该处相邻路段距离较近,黄色框标区域不仅道路长度较短,且特征模糊,提取难度较大,本文方法有效改善这一现象,提取效果较原U-Net模型提升明显。综上可知,与FCN、PSPNet、Deeplabv3+、CE-Net、U-Net模型的提取相比,本文所提出的方法道路细化分割能力强,对道路细节处提取相对完整,整体提取效果较好。

通过以上的定量分析和不同场景的道路提取结果进行对比分析可知:本文所提出的融合残差和卷积注意机制的U-Net网络模型较FCN、PSPNet、Deeplabv3+、CE-Net、U-Net模型的可视化提取结果上完整性和准确度更高,可以获取更多的道路细节特征信息,改善原网络模型道路细节处提取错误和缺失问题,抑制其他无关地物信息的干扰,使整体道路提取效果更优,具有一定优势性。

表2 各模型在Massachusetts Roads数据集上部分提取结果

Tab.2 Partial extraction results of each on the Masschusetts Roads dataset

(待续)

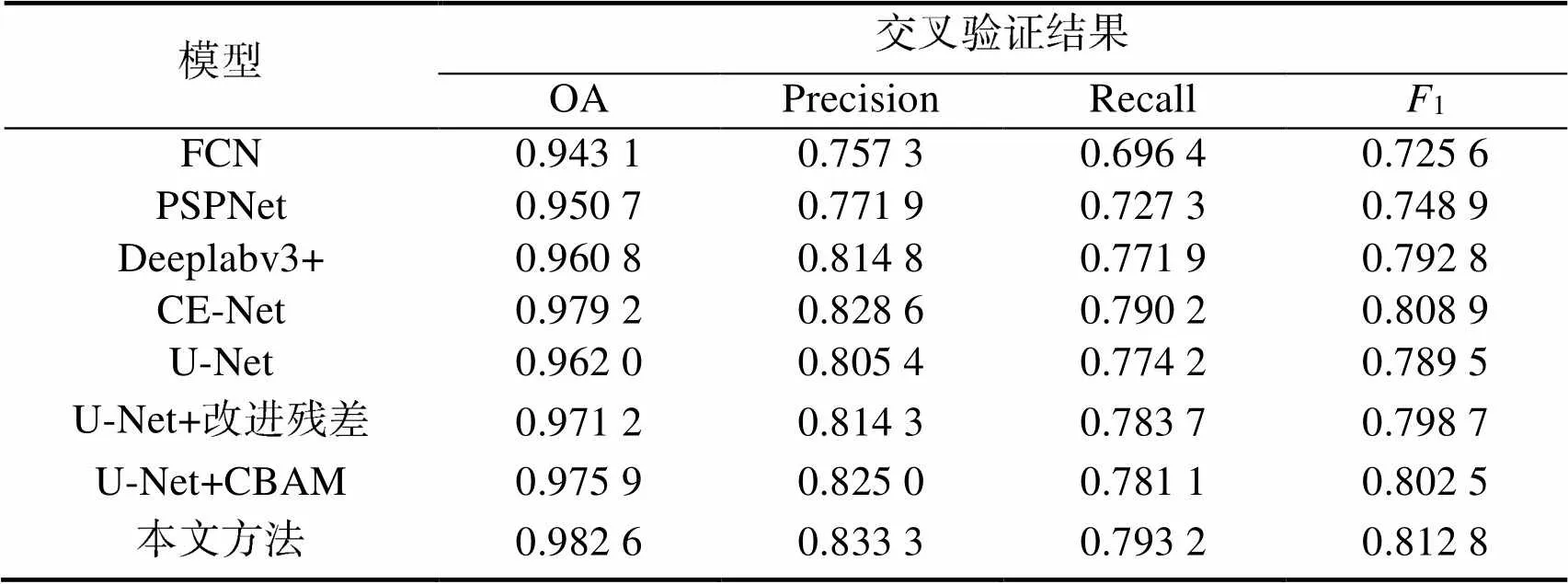

3.2 各模型在GeepGlobe数据集的实验结果与分析

为了进一步验证本文所提出的融合残差和卷积注意力机制的U-Net网络道路提取方法的优越,在DeepGlobe卫星数据集上再一次进行实验,分别训练FCN、PSPNet、Deeplabv3+、CE-Net、U-Net以及本文所提出来的模型,表3为各模型的评定指标值的定量比较。从表3可知:1)本文所搭建的网络模型在整体精度、准确率、召回率、1值分别达到了98.26%、83.33%、79.32%、81.28%,较原U-Net模型对应的各项评价指标值分别提高了2.06、2.79、1.90和2.33个百分点,指标值提升较大;2)本文方法与FCN、PSPNet、Deeplabv3+、CE-Net网络模型比较,在各项评定指标值上也有提升;3)通过消融实验对比U-Net+改进残差和U-Net+CBAM模型,其对应的各项指标值也稍有提升。综上可知:本文所提出的道路提取方法可进一步准确提取出道路特征。

表3 各模型在DeepGlobe数据集上的精度对比

Tab.3 Accuracy comparison of each model on the DeepGlobe dataset

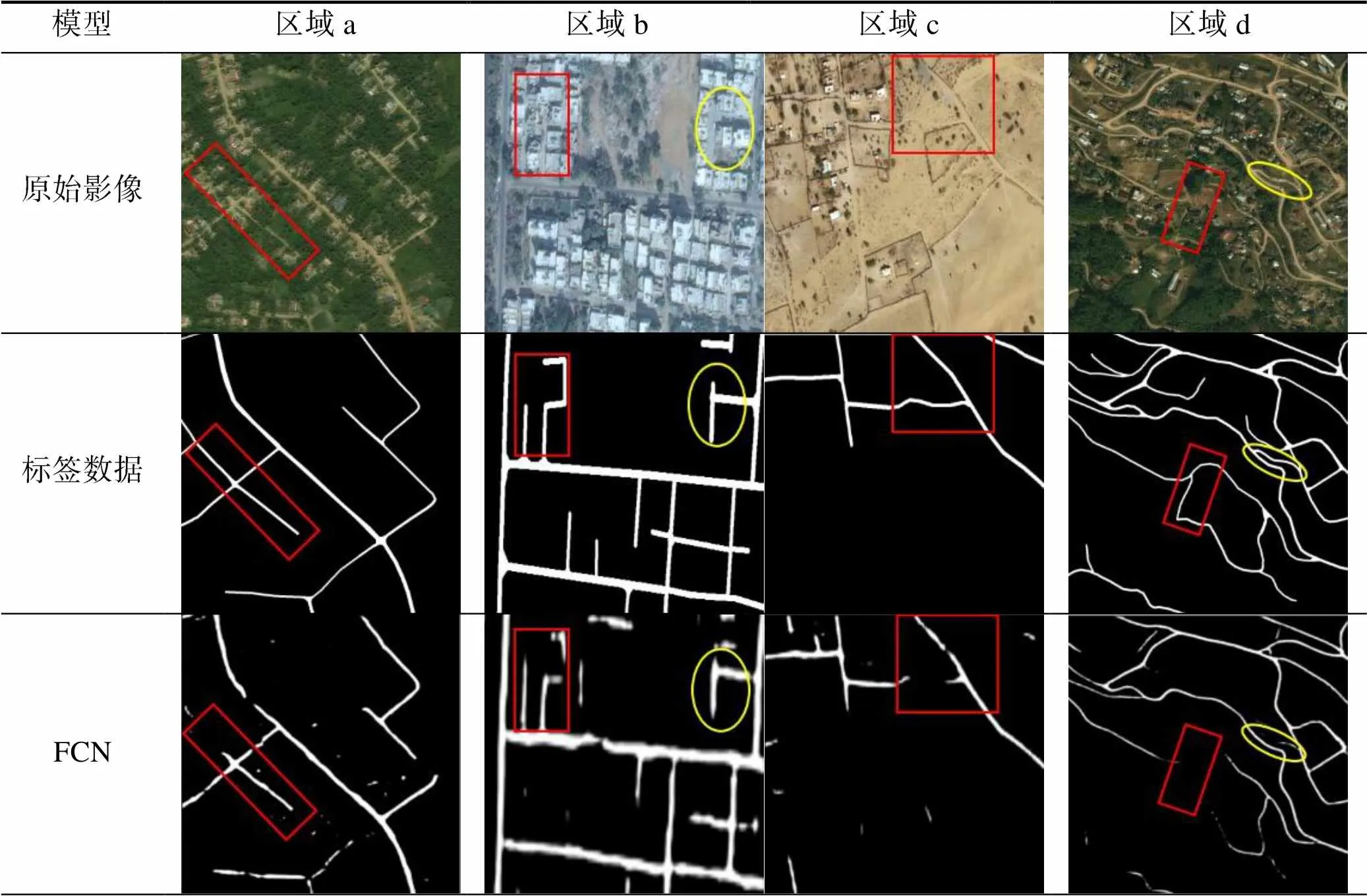

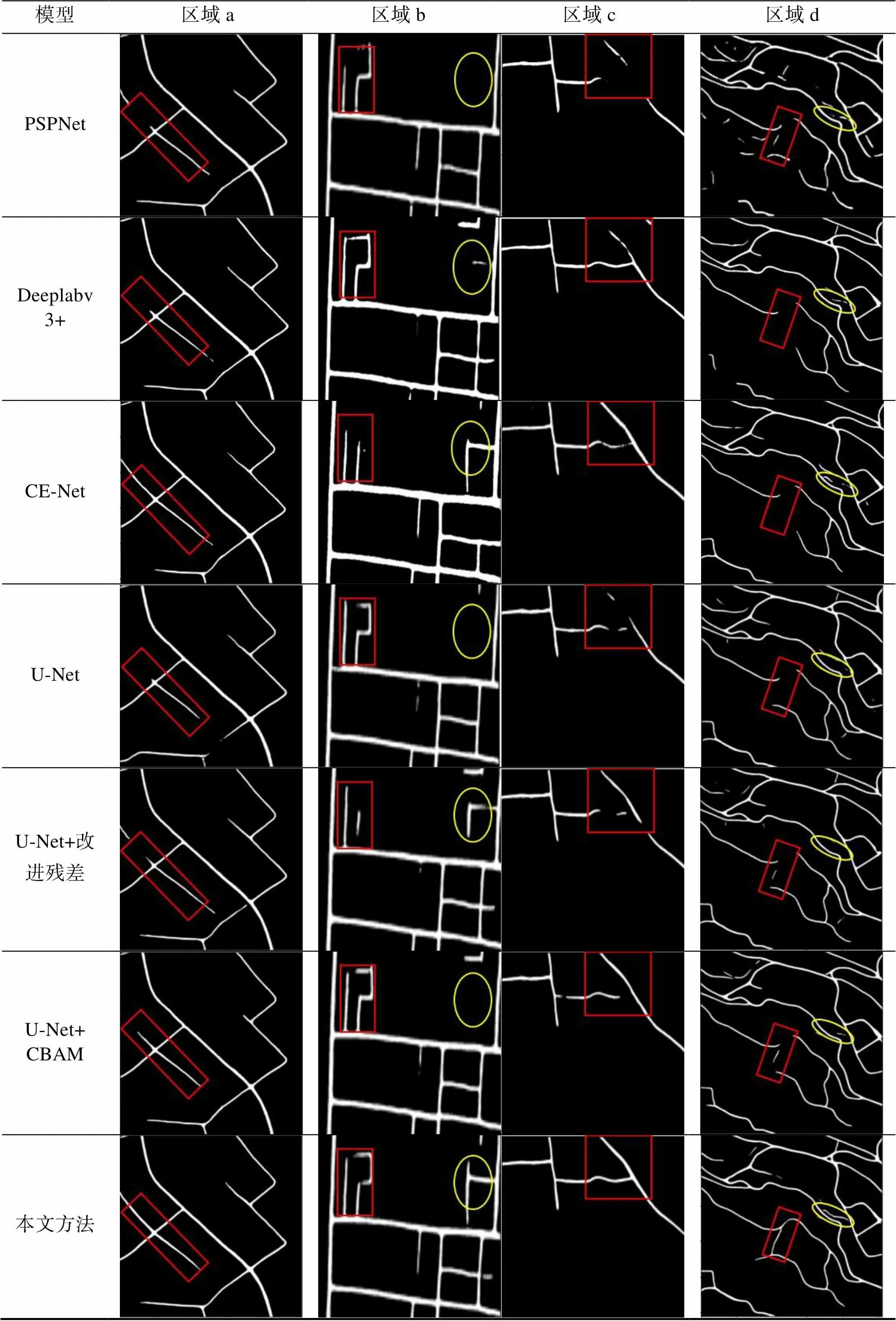

该数据集道路分布相对稀疏,郊区道路居多,场景丰富多样,提取结果的可视化如表4所示。区域a中道路区域受植被遮挡严重,原U-Net模型出现局部提取缺失,本文方法对遮挡部分完整提取出来;区域b中道路特征模糊且提取时容易受周围建筑物干扰,原U-Net模型提取在道路特征模糊区域出现局部提取缺失和错提现象,本文方法相对来说提取效果更加,无明显错提;区域c中道路的光谱特征与周围地物相似,道路特征模糊,原U-Net模型受光谱特征影响,提取结果不够完整,本文方法提取结果的可视化基本完整;区域d为复杂的山区道路,其分布错综崎岖,原U-Net模型提取时在地物特征不明显的崎岖路段和边缘细小道路处未提取到该路段,说明其对多尺度特征的地物提取效果较差,但本文方法对该路段基本提取完整。通过以上四个区域的提取结果可知,本文道路提取方法受植被遮挡和“同谱异物”现象影响较小,且具有较好的获取多尺度信息的能力,但对于个别局部特征不明显或道路特征模糊区域仍会出现漏提现象。

表4 各模型在DeepGlobe数据集上部分提取结果

Tab.4 Partial extraction results of each model on the DeepGlobe dataset

(待续)

(续表4)

结合表1和表3中本文方法在两种不同数据集上对应的评定指标值可得:本文方法在DeepGlobe数据集上训练得到的整体精度、准确率、召回率、1值比在Massachusetts Roads数据集上对应的各项指标值分别提高1.24、6.89、8.61和7.80个百分点。从整体提取效果的完整性上看,本文方法在GeepGlobe数据集上提取结果更加接近对应的真值影像,整体提取效果更佳。由此可知:本文所提出的融合残差和卷积注意力机制的U-Net道路提取方法在数据集道路结构分布相对稀疏、不相关地物干扰较小的区域所提取到的道路更加完整准确。

4 结束语

本文以U-Net网络为基础,在编码区和解码区的每两个相邻卷积层中间加入改进的残差网络模块,既可加深网络深度获得更多的道路特征,也可以规避网络性能退化,防止梯度消失;在跳跃连接阶段嵌入卷积注意力机制模块,提高模型对道路信息的表征能力,抑制非道路信息传输。在Massachusetts Roads数据集和DeepGlobe卫星数据集上,通过对不同场景的提取结果对比发现:本文所用方法无论是对道路本身特征不明显,或受植被遮挡,或光谱特征影响,还是不相关地物干扰较多的道路网,其提取结果都较原U-Net模型的道路提取结果提升效果明显,有效改善了道路信息提取缺失或错误的问题,准确性和完整度较好,但对于背景信息复杂的大型城市道路网提取效果仍不够理想,出现细节丢失和噪声点等问题,成为后续实验改进的重点。

[1] 张永宏, 何静, 阚希, 等. 遥感图像道路提取方法综述[J]. 计算机工程与应用, 2018, 54(13): 1-10, 51. ZHANG Yonghong, HE Jing, KAN Xi, et al. Summary of Road Extraction Methods for Remote Sensing Images[J]. Computer Engineering and Applications, 2018, 54(13): 1-10, 51. (in Chinese)

[2] 罗庆洲, 尹球, 匡定波. 光谱与形状特征相结合的道路提取方法研究[J]. 遥感技术与应用, 2007, 22(3): 339-344. LUO Qingzhou, YIN Qiu, KUANG Dingbo. Research on Extracting Road Based on Its Spectral Feature and Shape Feature[J]. Remote Sensing Technology and Application, 2007, 22(3): 339-344. (in Chinese)

[3] 罗巍, 王东亮. 利用角度纹理特征提取高分辨率遥感影像中城市主干道路[J]. 中国图象图形学报, 2017, 22(11): 1584-1591. LUO Wei, WANG Dongliang. Method Using the Angle Texture Feature to Extract Urban Trunk Road Information from High-resolution Remote Sensing Images[J]. Journal of Image and Graphics, 2017, 22(11): 1584-1591. (in Chinese)

[4] SGHAIER M O, LEPAGE R. Road Extraction from Very High Resolution Remote Sensing Optical Images Based on Texture Analysis and Beamlet Transform[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2015, 9(5): 1946-1958.

[5] 陈杰, 邵权斌, 梅小明, 等. 结合尺度空间的面向对象高分辨率影像城市道路提取[J]. 测绘工程, 2016, 25(12): 5-11. CHEN Jie, SHAO Quanbin, MEI Xiaoming, et al. Object-based Urban Road Extraction from High Resolution Imagery with Space-scale Theory[J]. Engineering of Surveying and Mapping, 2016, 25(12): 5-11. (in Chinese)

[6] GUO Q, WANG Z. A Self-supervised Learning Framework for Road Centerline Extraction from High-resolution Remote Sensing Images[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2020, 13(9): 4451-4461.

[7] 林鹏, 阮仁宗, 王玉强, 等. 一种基于面向对象的城镇道路自动提取方法研究[J]. 地理与地理信息科学, 2016, 32(1): 49-54. LIN Peng, RUAN Renzong, WANG Yuqiang, et al. Research on Extraction of Road Based on Object Oriented in an Urban Context[J]. Geography and Geo-Information Science, 2016, 32(1): 49-54. (in Chinese)

[8] 汪闽, 骆剑承, 周成虎, 等. 结合高斯马尔可夫随机场纹理模型与支撑向量机在高分辨率遥感图像上提取道路网[J]. 遥感学报, 2005, 29(3): 271-276. WANG Ming, LUO Jiancheng, ZHOU Chenghu, et al. Extraction of Road Network from High Resolution Remote Sensed Imagery with the Combination of Gaussian Markov Random Field Texture Model and Support Vector Machine[J]. Journal of Remote Sensing, 2005, 29(3): 271-276. (in Chinese)

[9] CHAURASIA A, CULURCIELLO E. LinkNet: Exploitingencoder Representations for Efficient Semantic Segmentation[C]//2017 IEEE Visual Communications and ImageProcessing, December 10-13, 2017, St. Petersburg, FL, USA. IEEE, 2017: 1-4.

[10] ZHOU L, ZHANG C, WU M. D-LinkNet: LinkNet with Pretrained Encoder and Dilated Convolution for High Resolution Satellite Imagery Road Extraction[C]//IEEE Conference on Computer Vision and Pattern Recognition Workshops, June 18-22, 2018, Salt Lake City, UT, USA. IEEE, 2018: 182-186.

[11] GAO L, SONG W, DAI J, et al. Road Extraction from High-resolution Remote Sensing Imagery using Refined Deep Residual Convolutional Neural Network[J]. Remote sensing, 2019, 11(5): 552-568.

[12] 马天浩, 谭海, 李天琪, 等. 多尺度特征融合的膨胀卷积残差网络高分一号影像道路提取[J]. 激光与光电子学进展, 2021, 58(2): 341-348. MA Tianhao, TAN Hai, LI Tianqi, et al. Road Extraction from GF-1 Remote Sensing Images Based on Dilated Convolution Residual Network with Multi-Scale Feature Fusion[J]. Laser & Optoelectronics Progress, 2021, 58(2): 341-348. (in Chinese)

[13] RONNEBERGER O, FISCHER P, BROX T. U-net: Convolutional Networks for Biomedical Image Segmentation[C]//International Conference on Medical Image Computing and Computer-assisted Intervention, October 5-9, 2015, Munich, Germany. Springer, Cham, 2015: 234-241.

[14] REN Y, YU Y, GUAN H. DA-CapsUNet: A Dual-attention Capsule U-Net for Road Extraction from Remote Sensing Imagery[J]. Remote Sensing, 2020, 12(18): 2866-2883.

[15] 孔嘉嫄, 张和生. 改进U-Net网络及在遥感影像道路提取中的应用[J]. 中国空间科学技术, 2022, 42(3): 105-113. KONG Jiayuan, ZHANG Hesheng. Improved U-Net Network and its Application of Road Extraction in Remote Sensing Image[J]. Chinese Space Science and Technology, 2022, 42(3): 105-113. (in Chinese)

[16] YAROTSKY D. Error Bounds for Approximations with Deep ReLU Networks[J]. Neural Networks, 2017, 94(7): 103-114.

[17] SODMANN P, VOLLMER M. ECG Segmentation using a Neural Network as the Basis for Detection of Cardiac Pathologies[C]//2,020 Computing in Cardiology, September 13-16, 2020, Rimini, Italy. IEEE, 2020: 1-4.

[18] LONG J, SHELHAMER E, DARRELL T. Fully Convolutional Networks for Semantic Segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 39(4): 640-651.

[19] ZHAO H, SHI J, QI X, et al. Pyramid Scene Parsing Network[C]//IEEE Conference on Computer Vision and Pattern Recognition, July 21-26, 2017, Honolulu, HI, USA. IEEE, 2017: 2881-2890.

[20] CHEN L C, ZHU Y, PAPANDREOU G, et al. Encoder - decoder with Atrous Separable Convolution for Semantic Image Segmentation[C]//European Conference on Computer Vision, September 8-14, 2018, Munich, Germany. L Leal-Taixé, Roth S, 2018:801 -818.

[21] GU Z W, CHENG J, FU H Z, et al. CE-Net: Context Encoder Network for 2D Medical Image Segmentation[J]. IEEE Transactions on Medical Imaging, 2019, 38(10): 2281-2292.

[22] HE K, ZHANG X, REN S, et al. Deep Residual Learning for Image Recognition[C]//IEEE Conference on Computer Vision and Pattern Recognition, June 27-30, 2016, Las Vegas, USA. Piscataway, IEEE, 2016: 770-778.

[23] BOCHKOVSKIY A, WANG C Y, LIAO H Y. Yolov4: Optimal Speed and Accuracy of Object Detection[EB/OL]. [2021-10-11]. http://arxiv.org/pdf/2,004.10,934.

[24] WOO S, PARK J, LEE J Y, et al. Cbam: Convolutional Block Attention Module[C]//European Conference on Computer Vision, September 8-14, 2018, Munich, Germany. L Leal-Taixé, Roth S, 2018: 3-19.

[25] DEMIR I, KOPESLI K, LINDENBAUM D, et al. Deepglobe 2018: A Challenge to Parse the Earth Through Satellite Images[C]//IEEE Conference on Computer Vision and Pattern Recognition Workshops, June 18-22, 2018, Salt Lake City, UT, USA. IEEE, 2018: 172-181.

[26] HEIPKE C, MAYER H, WIEDEMANN C, et al. Evaluation of Automatic Road Extraction[J]. International archives of photogrammetry & Remote sensing, 1997, 32(3): 47-56.

Road Extraction Method of High-Resolution Image Based on U-Net Network Combining Residual and Convolution Attention Mechanism

ZHANG Yaning ZHANG Chunkang WANG Chao YOU Chenyu

(College of Mining, Guizhou University, Guiyang 550025, China)

Aiming at the problems of missing local road extraction and wrong extraction due to the blurring of road features or the phenomenon of "same-spectrum foreign objects" in high-resolution remote sensing images, this paper proposes an improved method for road extraction from high-resolution remote sensing images, which is based on U-Net combining residual and convolutional attention mechanism. Firstly, based on the U-Net network, an improved residual module is added to alleviate the problem of network performance degradation that is easy to occur during network training. Secondly, the convolutional attention mechanism module is embedded to enhance the deep representation of road details. Finally, the data set is reasonably expanded through geometric transformation to enhance network generalization ability. The model is tested on the public datasets Massachusetts roads and DeepGlobe road datasets, and the experimental results show that the overall accuracy of the method proposed in this paper reaches 97.02% and 98.26% respectively on the two datasets. Compared with other models, it has a better extraction effect, and has a stronger deep representation of road features and better anti-interference performance, which can effectively improve the problems of wrong and missing extraction phenomenon in road extraction, and significantly improve the accuracy and integrity of road extraction.

road extraction; residual module; convolutional attention mechanism; high-resolution remote sensing images

P237

A

1009-8518(2023)03-0119-14

10.3969/j.issn.1009-8518.2023.03.013

张亚宁,女,1994年生,2018年获咸阳师范学院测绘工程专业工学学士学位,现于贵州大学测绘科学与技术专业攻读硕士学位。主要研究方向为高分遥感信息提取。E-mail:59547207@qq.com。

2022-09-26

国家自然科学基金(41701464);中国科学院战略性先导科技专项子课题(XDA2806020101);贵州大学培育项目(贵大培育[2019] 26号)

张亚宁, 张春亢, 王朝, 等. 融合残差和卷积注意力机制的U-Net网络高分影像道路提取[J]. 航天返回与遥感, 2023, 44(3): 119-132.

ZHANG Yaning, ZHANG Chunkang,WANG Chao, et al. Road Extraction Method of High-Resolution Image Based on U-Net Network Combining Residual and Convolution Attention Mechanism[J]. Spacecraft Recovery & Remote Sensing, 2023, 44(3): 119-132. (in Chinese)

(编辑:庞冰)