从隐空间认识CLIP多模态模型

2023-06-02高焕堂

高焕堂

1 前言

AIGC 可生成的内容形式包含文本( 文句)、图像、音频和视频。它能将文本中的语言符号信息或知识,与视觉中可视化的信息( 或知识) 建立出对应的关联。两者互相加强,形成图文并茂的景象,激发人脑更多想象,扩大人们的思维空间。其中,最基础的就是文本(Text) 与图像(Image) 之间的知识关联。本篇来介绍文本与图像的关联,并以CLIP 模型为例,深入介绍多模态AIGC 模型的幕后架构,例如隐空间(Latent space) 就是其中的关键性机制。

2 简介CLIP模型

在2020 年,OpenAI 团队提出了CLIP,它是典型的多模态(Multi-modal) 机器学习模型。OpenAI 从互联网上找到大量的文本(Text) 与图像(Image) 的配对,可以用来训练CLIP 模型,然后让CLIP 进行其预测任务,即是输入1 张图像,然后预测出哪一个文本与它是配对的。

CLIP 的目标是透过大量图片及文字描述,建立两者间的对应关系。其做法是利用ResNet50 等来萃取图像的特征,并映射到隐空间(Latent space)。也就是将图像编码成为隐空间向量。

同时,也利用Transformer 萃取与图像相配对文句的特征,并將文句编码成为隐空间向量。最后经由模型训练来逐渐提高两个向量的相似度。换句话说,CLIP能将图像和文句映像到同一个隐空间,因此可以迅速计算图像与文句的相似度。

CLIP 模型学习整个文句与其对应的图像之间的关系。当我们在整个文句上训练时,模型可以学到更多的潜在的东西,并在图像和文句之间找到一些规律。值得留意的是,在训练CLIP 模型时,我们输入的是整个文句,而不是像猫、狗、汽车、电影等单一类别而已。

3 CLIP的基本架构

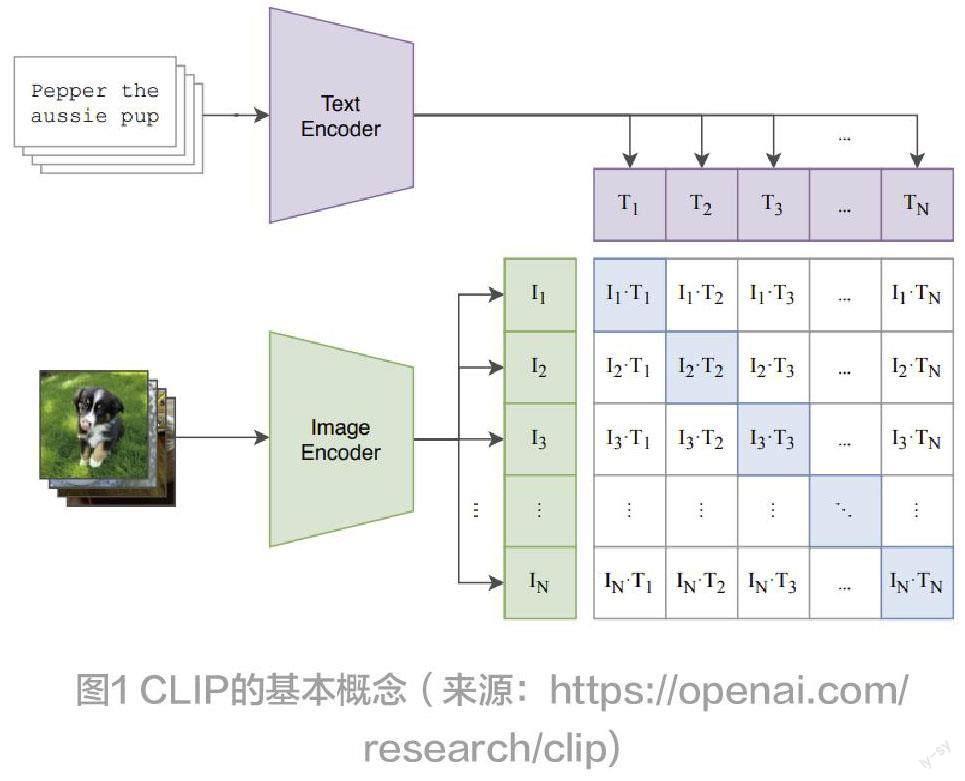

CLIP 的核心设计概念是,把各文句和图像映射到隐空间里的一个点( 以向量表示)。针对每一个文句和图像都会提取其特征,并映射到这个隐空间里的某一点。然后经由矩阵运算,来估计它们之间的相似度,如图1。

在训练CLIP 模型的过程中,会不断调整各点的位置( 在隐空间里),以表达出它们之间的相似度。CLIP在整合文句与图像两种模态上有突破性的表现。一旦训练完成之后,就可以对新图像进行预测了,亦即预测出一个文本与它是配对的。例如,输入1 张新图像,经由图像编码器( 如ResNet50) 来提取这张图象的特征,然后映射到隐空间里的一个新的点。

然后经由矩阵运算,即可预测出它与我们所给的一些文句的相似度,就可以得到预测值了。此外,CLIP也能输入描述文句来找到相对应的图像。

4 图解CLIP的空间对映

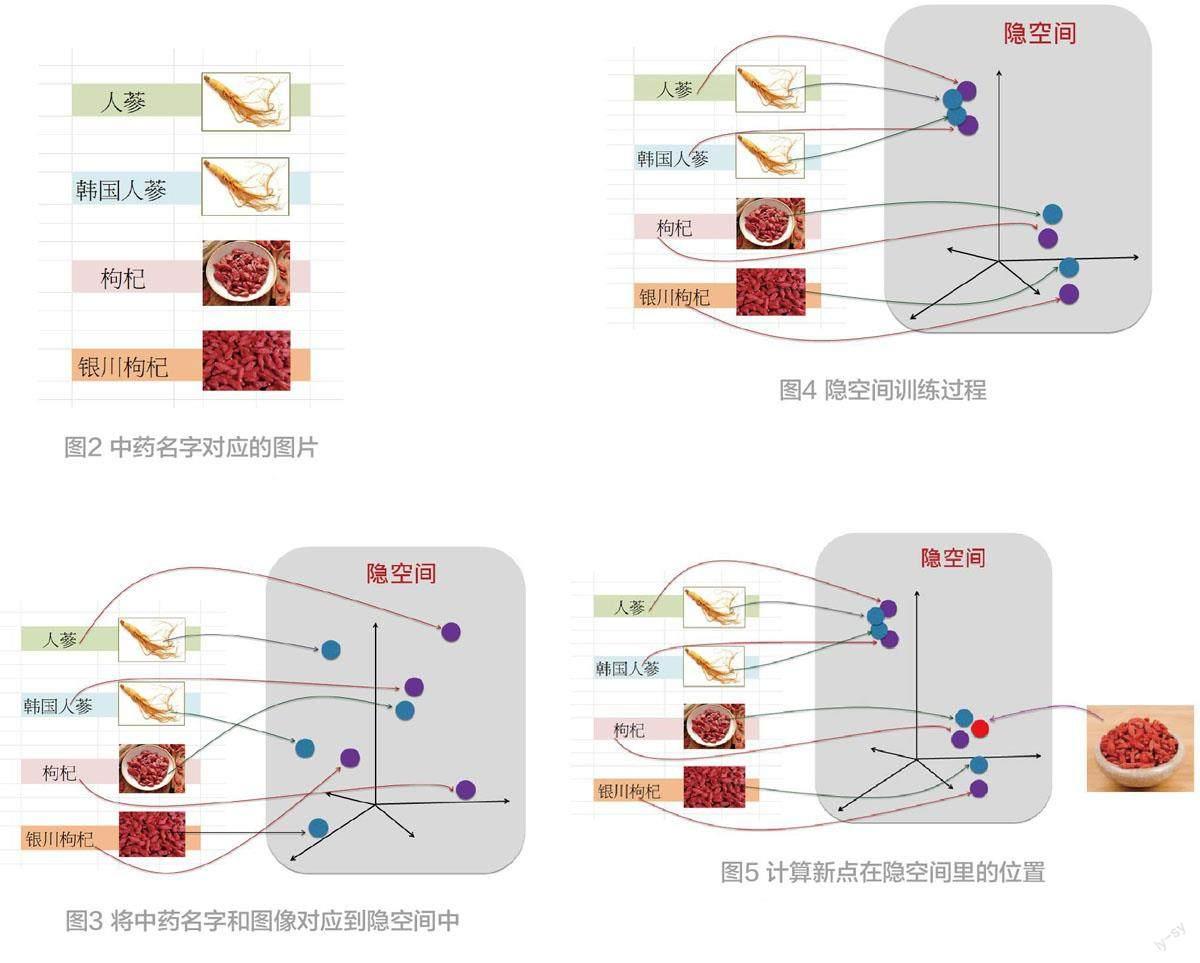

兹以中药材的CLIP为例,例如有4 张中药材的图像,以及其对应的文句,或单词( 图2)。

这里的文本与图像之间的对应关联,可以是人们给予的,也可以是从互联网页的数据而得来的。那么CLIP 模型就来建立这些关联性。

在前面已经说明了,CLIP 会利用ResNet50 等模型来协助提取各图像的特征,并将各图像( 随机) 对映到隐空间( 即数学上欧式空间) 的点。同时,也使用Transformer 模型来帮助提取个文句的特征,并将各文本( 随机) 对映到隐空间的点( 图3)。

这就是空间对映(Space mapping),意味着从可观察空间( 即上图里的图像和文句空间) 对映到隐空间。

5 展开训练

在进行训练的过程中逐渐地修正CLIP 模型里的参数( 如weight 和bias 值),也就是逐渐地调整隐空间里各点的位置( 坐标),来呈现出这些点之间的相似性(Similarity)。例如,在隐空间里,我们可以让愈相似的点,会愈相互靠近( 图4)。

以上训练完成了。其智能表达于模型里的参数( 如weight 和bias) 值里。虽然人们可以理解文本和图像的涵意,但并无法理解模型里的参数,以及所计算出的隐空间向量的涵意,所以才称为隐藏性空间,或称黑箱(Block-box)。

6 预测范例1:从图像找文本

在刚才的训练过程中,CLIP 已经持续调整各笔数据( 如文本和图像) 的其隐空间里的位置( 以隐空间向量表示),来表达其所蕴含的关联性。一旦训练完成了,就能进入预测或推理的阶段了。

例如,拿来1 张新图像输入给CLIP,它就( 要求ResNet50 等) 来帮忙提取这新图像的特征,并依据其所训练出来的参数( 即weight 和bias) 值,而计算( 对映)出这个新点在隐空间里的位置( 图5)。

由于这张新图像的特征与左边第3 张( 由上而下)图像特征很接近,也就意味着这两张图象很相似,所以在潜藏空间里两者会很靠近。如此,计算出这个新点与其他各点之相似度,然后挑出相似性最高的文本是:枸杞( 图6)。于是,就顺利完成从图像关连到文本的任务了。

7 预测范例2:从文本找图像

刚才的范例是:从图找文。CLIP 还可以提供:从文找图。例如,拿来一个新文句输入给CLIP,它就( 要求Transformer 等) 来帮忙提取这新文句的特征,并依据其所训练出来的参数( 即weight 和bias) 值,而计算( 对映) 出整潜藏空间里这个新点的位置。接着,计算出这点与其他各点之相似度,然后挑出相似性最高的图像( 图7)。

由于CLIP 幕后有Transformer 预训练模型来帮忙,可以发现”宁夏枸杞”与”银川枸杞”两个文本很相似,就找出与”银川枸杞”相对应( 即相似性高) 图像了。

8 结束语

在互联网上,CLIP 可以找到非常大量的图像,以及描述这些图像的文字,而且涵盖各行各业,非常广泛,使得CLIP 成为一项通用性极高的双模态AIGC 模型。