基于改进YOLOv7的复杂环境下红花采摘识别

2023-05-15王小荣周建平陈金荣

王小荣,许 燕,周建平,陈金荣

·农业信息与电气技术·

基于改进YOLOv7的复杂环境下红花采摘识别

王小荣1,2,许 燕1,2,周建平1,2※,陈金荣1

(1. 新疆大学机械工程学院,乌鲁木齐 830017;2. 新疆维吾尔自治区农牧机器人及智能装备工程研究中心,乌鲁木齐 830017)

针对光照、遮挡、密集以及样本数量不均衡等复杂环境造成红花机械化采摘识别不准问题,该研究提出一种基于YOLOv7的改进模型,制作红花样本数据集建立真实采摘的复杂环境数据,增加Swin Transformer注意力机制提高模型对各分类样本的检测精准率,改进Focal Loss损失函数提升多分类任务下不均衡样本的识别率。经试验,改进后的模型各类别样本的检测平均准确率达到88.5%,与改进前相比提高了7个百分点,不均衡类别样本平均精度提高了15.9个百分点,与其他模型相比,检测平均准确率与检测速度均大幅提升。改进后的模型可以准确地实现对红花的检测,模型参数量小,识别速度快,适合在红花采摘机械上进行迁移部署,可为红花机械化实时采摘研究提供技术支持。

图像识别;图像处理;复杂环境;YOLOv7;注意力机制;多分类Focal Loss损失函数;红花采摘

0 引 言

红花花丝是一种具有医疗、染料等多种用途的经济作物[1]。随着其功效在医药保健、农副产品、化妆品等行业的不断研发,其需求量正在稳步上涨。目前红花花丝的采摘仍以人工采摘为主[2],红花花期短,时效性要求高,劳动强度大,且作业环境差,受天气影响严重。为提高红花采收效率,降低劳动成本,机械化采收成为红花产业化种植发展的必然趋势。

针对红花机械化采收研究,国内外学者进行了初步探索。围绕采收设备的研究,BERTETTO等[3]设计制作背负式便携采收设备进行红花采收,但仍需要劳动者长时间背负设备工作,没有真正意义代替人工;针对末端采摘执行机构的研究,国内多位学者进行了结构设计,主要包括气力式[4]、对辊式[5]、梳夹式[6]、旋切式[7]以及拉拔式[8];关于采收机械路径规划研究,GUO等[9]通过运动学分析、采摘试验探索并联机器人在红花采摘中的可行性,ZHANG等[10]通过改进蚁群算法探索双辊型红花采摘机器人路径规划方法。以上关于红花采收的研究均是在实验室理想条件下开展,在实际农田中的应用研究尚存在很大空间,因此红花机械化采收研究处于起步阶段。

在采摘过程中,光照、遮挡等自然环境与红花目标小而密、成熟度不同等作物特性构成了复杂环境因素,导致红花机械采摘过程难以准确识别精准定位。近年来,随着深度卷积网络目标检测技术的发展以及Fast R-CNN[11]、YOLO系列[12-14]等经典目标检测算法不断开源,基于深度学习算法的采摘机器人被广泛地应用在苹果、番茄、柑橘等[15-17]果蔬采摘中。JIA等[18-19]学者通过改进Mask RCNN算法可以提高在树叶遮挡等复杂环境下模型的苹果识别的准确度和识别精度,但是Mask RCNN作为两阶段检测方法,其识别速度和效率较低;ZHANG等[20-21]学者采用Fast R-CNN模型算法分别对苹果和蓝莓进行识别,识别准确率和效率明显提高,针对复杂环境下小目标的检测效果也有所改善,但是Fast R-CNN算法需要采集大量的数据用作模型训练,对于少样本或样本不均衡情况下目标检测效果有待加强。近年来,YOLO算法作为单阶段检测方法,具有速度快效率高等特点,在实际场景目标检测中应用广泛。李天华等[22-24]学者在YOLOv4基础上对模型进行了改进,并对复杂环境下的番茄进行实时识别,能够有效解决遮挡、粘连、或光照影响下目标识别准确率低的问题。因采茶与红花采收有相似性,以上研究为红花的采摘检测与识别提供借鉴。CHEN等[25]提出了一种基于YOLOv3的茶蕾识别与采摘点提取的方法,该方法将深度学习与传统的图像处理算法相结合,验证了在遮挡光照等自然环境下茶蕾识别与采摘点定位的可行性,提高了茶蕾采摘的完整率,但是该算法识别的准确率有待加强。CAO等[26]提出了一种集成YOLOv5和GhostNet的茶芽检测模型,该模型的精度、召回率均有所提高,但在自然环境下因受样本数量、拍摄角度和照明角度的影响,该算法F1得分值没有试验效果明显。

基于此,本文建立复杂环境下红花数据集,选用YOLOv7检测网络模型,针对数据样本存在的问题进行算法模型改进与优化,为红花机械化采摘提供研究基础。

1 试验数据

1.1 试验数据的获取

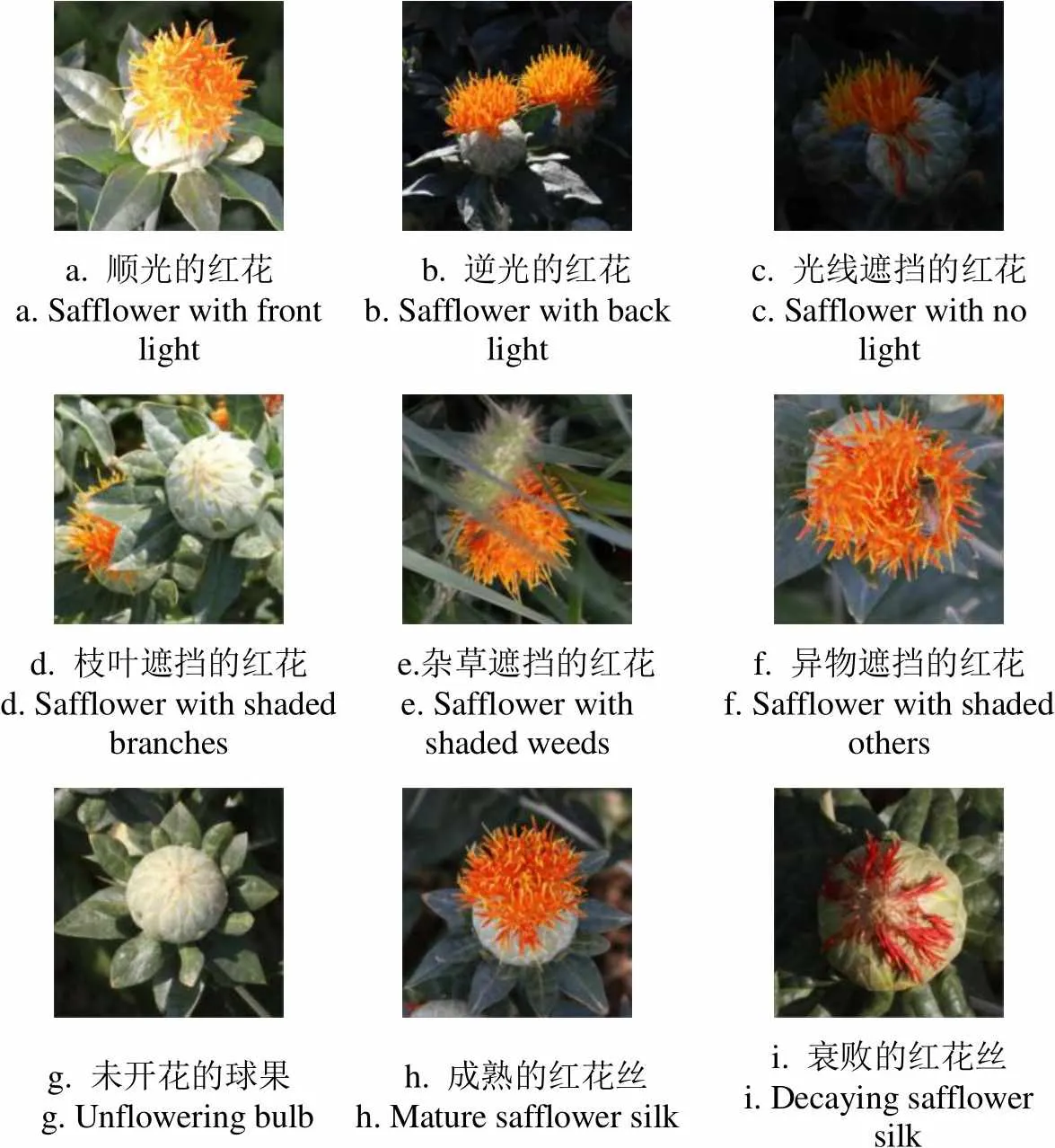

新疆地区红花种植面积占国内红花种植面积的80%以上,本文以新疆吉木萨尔县种植红花为研究对象。为满足复杂环境下红花识别的多样性以及种植场景真实性,采用不同时间段不同角度拍摄,收集到不同成熟度、不同光照、不同遮挡程度以及不同姿态的红花图片约1 596张,经过筛选后的图片1 500张,从中随机抽取1 200张作为训练集,150张作为验证集,150张作为测试集。图1分别为复杂环境下不同光照、遮挡以及成熟度的红花样本数据。光照、遮挡等因素容易造成模型对红花丝的特征提取不准确,从而导致错检漏检,影响网络模型的性能。不同成熟度的红花,因含水量不同,采摘决策不同,因此需对3种不同类别的红花目标进行识别与定位。

a. 顺光的红花a. Safflower with front light b. 逆光的红花b. Safflower with back lightc. 光线遮挡的红花c. Safflower with no light d. 枝叶遮挡的红花d. Safflower with shaded branches e.杂草遮挡的红花e. Safflower with shaded weeds f. 异物遮挡的红花f. Safflower with shaded others g. 未开花的球果 g. Unflowering bulb h. 成熟的红花丝h. Mature safflower silki. 衰败的红花丝i. Decaying safflower silk

1.2 试验数据标注与分析

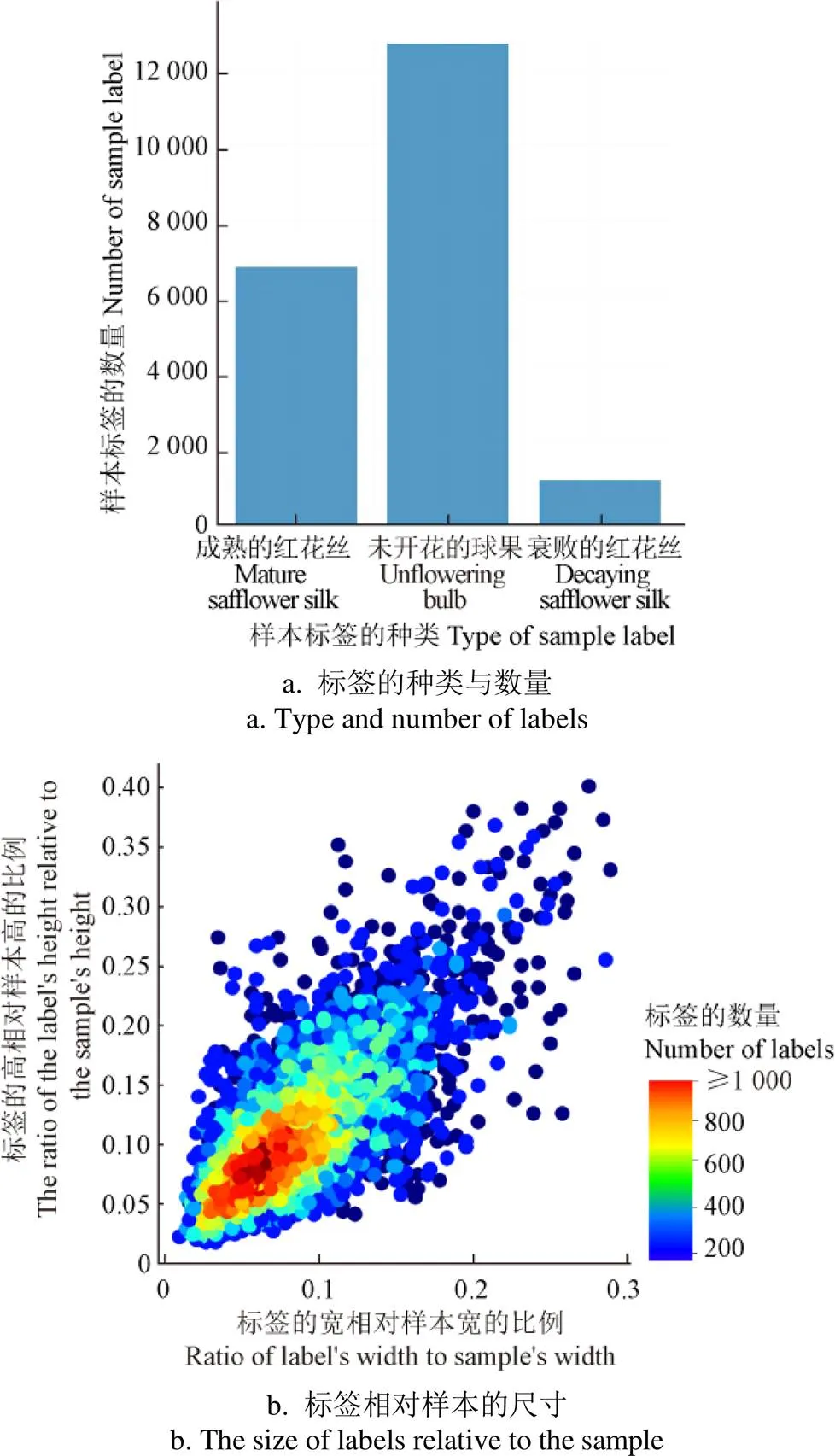

根据采收决策,本文按照成熟的红花丝(silk)、未开花的球果(bulb)、衰败的红花丝(decay)对样本进行分类,利用Labelme图像标注软件对数据集进行人工标注并对训练集的标注文件进行可视化分析,如图2所示。

从图2a可以看出,在复杂场景下silk、bulb和decay三种样本数量比例约为5∶9∶1,样本的数量是不均衡的,容易导致在模型训练过程中decay样本的准确率较低。对图 2b中标签尺寸相对样本尺寸而言,标签的宽和高大多为样本尺寸的0.02~0.15倍,小目标偏多,易导致模型准确率不高。以上2种情况是由于红花的种植模式、生长特性以及采摘视野等多重因素造成,均会影响模型的检测效果。

图2 训练集标签分布情况

针对以上问题,本文在YOLOv7网络模型的第50层特征提取层增加Swin Transformer注意力机制,以提高模型骨干网络对小目标特征的提取能力;改进适用于多分类的Focal Loss损失函数,应用于目标置信度损失和分类损失,以提高网络模型反向传播时对不均衡样本的关注程度,最终设计符合复杂环境下红花检测网络模型以满足实时准确的检测需求。

2 网络模型及改进

2.1 YOLOv7目标检测模型

YOLO作为单阶段目标检测典型算法,因较快的运行速度被广泛应用于实时检测,而YOLOv7在MSCOCO数据集上的检测效果显示,其准确率和速度超越其他YOLO系列模型,因此本文选择YOLOv7作为红花目标检测的算法模型。

YOLOv7网络结构[27]主要包括Input层、Backbone层和Head层。Input层为输入层,主要作用是对输入的图片进行预处理后输入到Backbone层;Backbone层又被称作特征提取层,主要功能是提取不同大小的目标信息特征,由51层(Layer0~50)不同的卷积组合模块构成,其最大特点是采用了高效的E-ELAN网络架构,可以提高算法的检测效率,Backbone层的输出为不同大小的特征信息,位置分别位于第24层、第37层以及第50层;Head层主要是融合Backbone层给出的特征生成边界框并预测类别,主要包括SPPCPC层、若干Conv层、MPConv层以及REP层,Head层在第75层、第88层以及第101层输出不同大小的特征图,经过重参数化结构REP层输出预测结果。

2.2 网络模型的改进

2.2.1 Swin Transformer注意力机制

注意力机制是一组通过网络自主学习得出权重系数,并以“动态加权”的方式来强调感兴趣的区域,抑制不相关背景区域的机制。目前主流的注意力机制可以分为通道注意力机制、空间注意力机制混合注意力机制以及自注意力机制。通道注意力机制通过对每个特征图做全局池化获取每个通道的重要程度,得到权重系数并以此来提升特征或抑制不重要的特征,该权重系数具有全局感受野,对本文复杂环境下红花的小目标检测问题效果不佳。空间注意力机制仅关心与任务相关的区域,当目标区域被遮挡或受光照干涉时会影响注意力机制的判断。混合注意力机制是由通道注意力及空间注意力串联或并联而成,因存在全局池化及平均池化操作,因此对复杂环境下红花目标的检测仍存在问题。自注意力机制与前三者不同,是对输入的特征进行一系列的复杂矩阵运算得到特征之间的相关权重,找到特征之间的关系,自注意力机制不依赖于卷积网络,更加关注每个像素特征之间的关系,适合小目标的识别,因此本文在YOLOv7网络增加Swin Transformer自注意力机制。

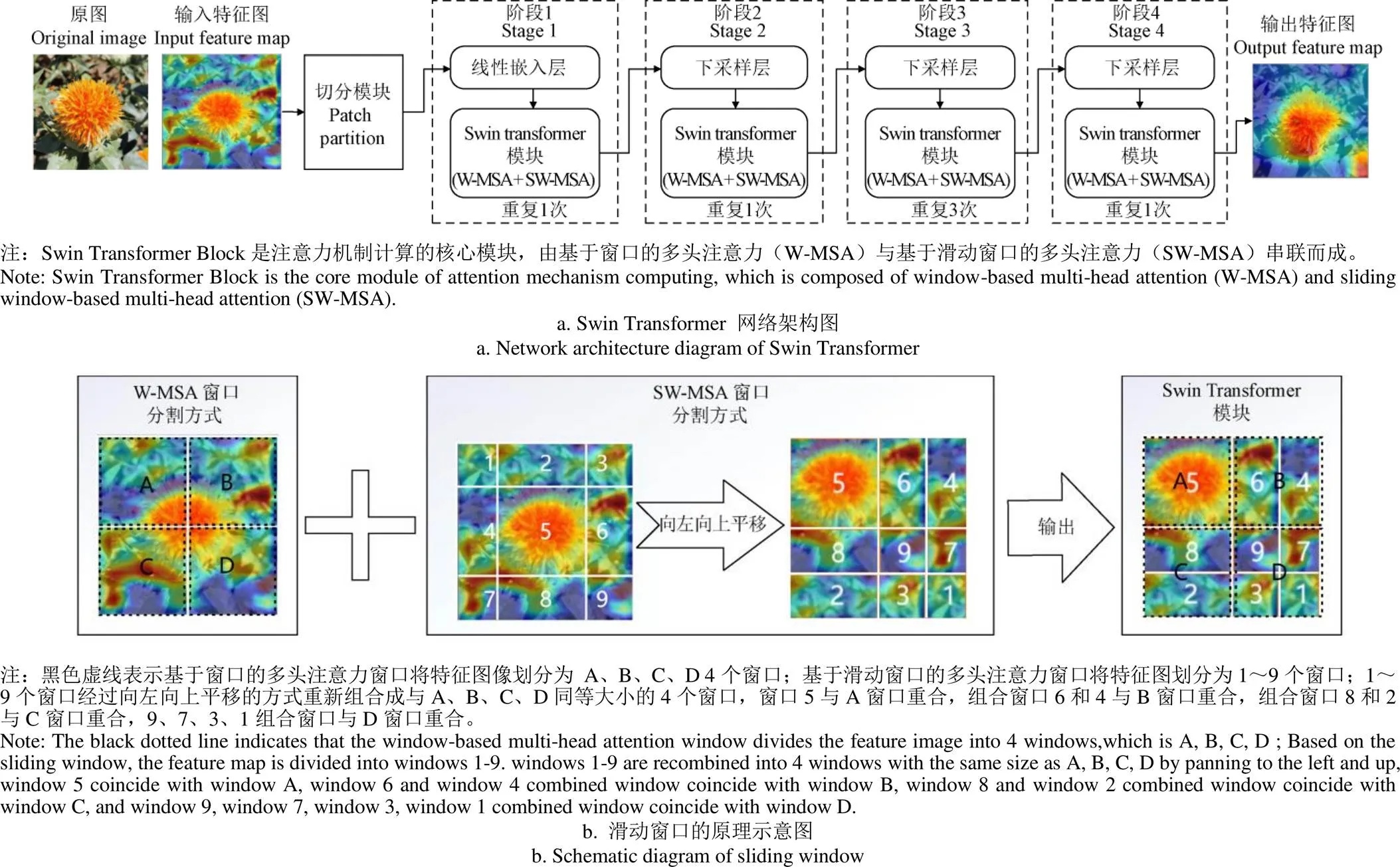

在进行自注意力机制训练时,如果以特征序列为计算单位在图像全局进行矩阵计算,计算量大且训练速度慢。Swin Transformer[28]是一种以窗口和分层的形式代替长序列的自注意力机制,可以在提升检测性能的同时降低对运行速度的影响。Swin Transformer注意力机制的网络结构如图 3a所示,首先输入一张3通道的特征图像,经过Patch Partition切分模块将图像切割,将切割的图像送入Lineat Embedding层,得到嵌入向量。然后分4个阶段(Stage1~Stage4)逐步下采样分层计算注意力。Swin Transformer Block是注意力机制计算的核心模块,是由基于窗口的多头注意力(W-MSA)计算与基于滑动窗口的多头注意力(SW-MSA)计算串联而成。滑动窗口原理如图3b所示,首先基于窗口多头注意力将特征图像划分为 A、B、C、D 4个窗口,为得到4个窗口的内部联系,再利用滑动窗口将图像特征划分为编号为1~9的9个窗口,此时9窗口的计算量比4窗口多了2.25倍,为并行计算MSA,必须保证二者之间窗口数一致,因此采取向上、向左平移的策略将9个窗口重新组合成与ABCD同等大小的4个窗口,最后进行MSA计算,输出特征图。在YOLOv7中利用GradCAM可视化热力图对增加Swin Transformer注意力机制前后红花数据的特征进行可视化,如图3a所示,模型输入的原图经过前期特征提取,在第37层网络中获得的特征图为输入特征图,经过Swin Transformer 注意力机制后输出特征图,可以看出,增加Swin Transformer注意力机制后,网络更加专注于对红花丝的识别,即使是处于图片边缘叶片遮挡下的红花丝小目标也可以识别出来。

图3 Swin Transformer 注意力机制网络架构及原理

2.2.2 多分类任务Focal Loss损失函数

YOLOv7的损失函数L用于更新梯度的损失,由坐标损失ciou、目标置信度损失obj和分类损失cls三部分求和而成。如式(1)所示。

loss=ciou+obj+cls(1)

其中目标置信度损失和分类损失采用带对数的二值交叉熵损失。为了解决样本不均衡问题,LIN等[29]首先改善了分类过程中的交叉熵函数,提出了针对二分类可以动态调整权重的Focal Loss。针对本文红花图像数据,分为silk、bulb和decay 3种分类样本,因此本文基于Focal Loss对多分类动态调整权重的损失函数进行了推导。

样本的标签为Onehot形式,与二分类不同的是多分类任务是以Softmax作为最后激活函数。例如silk、bulb、decay 3类标签分别为1(1,0,0),2(0,1,0),3(0,0,1),Softmax输出为(1,2,3),1、2、3分别对应3种类别的概率,1、2、3的和为1。以Sofmax作为激活函数的多分类任务损失函数(multi-classification focal loss,简写为MCFL)计算式推导过程如下:

MCFLylgP(2)

MCFLα(1-P)ylgP(4)

MCFL-α(1-P)ylgP(5)

式(2)为多类交叉熵损失,为降低易分类样本的比例,式(3)函数中增加(1-P)做衰减;为调节正负样本比例式(4)用α来调整该样本的权重。因标签是Onehot形式,样本标签中的值只有在对应位置上为1,其余都为0,最终得到多分类以Sofmax作为激活函数的动态调整权重损失函数(式(5)),其中为衰减参数,可以通过试验对比获得最佳取值,α为该类别样本的权重参数,与α是相互作用的,并且起的作用比α大。

2.3 网络模型的训练

2.3.1 环境配置

试验运行环境操作系统为Windows 10(64位),内存为16 GB,显卡驱动RTX3060,搭载12th Gen Intel(R) Core(TM) i5-12400F 2.50 GHz处理器,编程平台Anaconda 4.12.0,CUDA 11.6,开发环境PyTorch,编程使用Python 3.8。

2.3.2 超参数设置

训练时选用官方提供的YOLOv7.pt预训练权重进行训练,数据集选用自己建立的红花数据集,标签格式为YOLO格式,输入图像大小为640×640,Batchsize大小为16,迭代次数Epoch为100,采用Adam优化器并设置初始学习率为0.01。

2.3.3 评价标准

为了评价模型对红花识别检测结果的好坏,评价标准选用准确率(precision)、召回率(recall)、平均准确率(mean average precision,mAP)与检测速度(frames per second,FPS)[16]。

2.3.4 模型集成

本文在YOLOv7网络增加Swin Transformer注意力机制,对目标置信度损失和分类损失均采用改进的多分类损失函数Multiple Classifications Focal Loss计算,主要集成方法如下:第一步,在common.py文件中增加Swin Transformer网络模型代码,并在配置文件中的特征提取层(backbone)第50层增加该网络结构。第二步,在loss.py文件中定义多分类任务 Focal Loss损失函数并通过改变数据集配置文件中fl_gamma的参数值对其进行调用,实现两种模型与YOLOV7网络的集成。

3 结果与分析

3.1 YOLOv7模型与YOLO系列其他模型对比

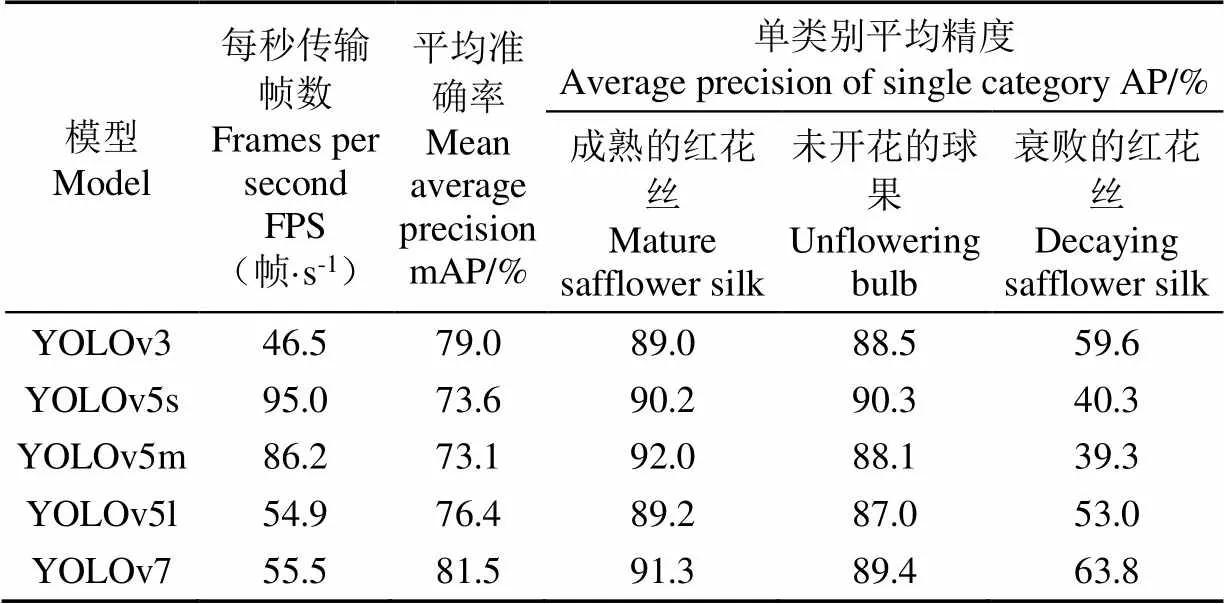

为验证YOLOv7在红花数据集上检测效果,本文分别将YOLOv3、YOLOv5s、YOLOv5m、YOLOv5l和YOLOv7五种网络模型在红花数据集上进行训练,试验结果如表1所示。

通过表1对比结果可以看出,在相同迭代次数内,由于YOLOv7网络的模型参数量增加,模型检测速度低于YOLOv5s和YOLOv5m,但55.5帧/s的检测速度已能满足红花采收决策需求。YOLOv7模型在红花数据集上的mAP值比YOLOv3高出2.5个百分点,比YOLOv5s、YOLOv5m、YOLOv5l三个不同大小的模型分别高出7.9、8.4、5.1个百分点,尤其是在不均衡样本类别上优势更加明显,在decay不均衡样本上分别高出4.2、23.5、24.5、10.8个百分点。因此本文选用YOLOv7模型,并在此基础上进行改进以增强其在复杂环境下对红花实时检测的准确率。

表1 红花数据集在不同YOLO系列模型检测效果

3.2 Swin Transformer注意力机制对模型影响

为验证不同注意力机制对模型的影响,分别将通道注意力机制SE、混合注意力机制CBAM以及自注意力机制Swin Transformer 3种注意力机制模块添加到YOLOv7的特征提取层第50层进行试验,结果显示3种注意力机制均降低了模型的检测速度,下降比例分别为21.08%、25.22%、17.66%,Swin Transformer速度下降比例最小。增加SE注意力后,模型的mAP值反而降低了3.1个百分点,说明在本文数据集上SE注意力机制强化了成熟红花丝、未开花的球果的通道特征,抑制了衰败红花丝的特征。CBAM注意力机制对3种样本的平均准确率分别提升0.8、2.1、3.0个百分点,Swin Transformer注意力机制对3种样本的平均准确率分别提升1.6、2.1、10.6个百分点,说明Swin Transformer注意力机制在本数据集上提升效果优于其他两种注意力机制。分析以上结果,这是由于Swin Transformer自注意力机制强化了各特征之间的关系,降低了对全局注意力计算的结果,因此Swin Transformer注意力机制在3种样本上效果均有所改善,尤其是对衰败红花丝这种数量少的样本改善效果更加明显。为验证Swin Transformer模型添加位置对模型的影响,分别在特征提取层的第24、37层增加Swin Transformer,并相应地调整Head层级数进行对比,试验结果见表2。

表2 注意力机制对YOLOv7模型训练过程影响

通过以上结果可以看出,在第24层、37层、第50层增加Swin Transformer对平均准确率有所提升,而且插入的位置层级越大,模型性能提升越明显,这是由于插入的位置层级越大,感受野越大,特征提取就越多,效果越明显,因此本文在特征提取网络的第50层增加Swin Transformer注意力机制。

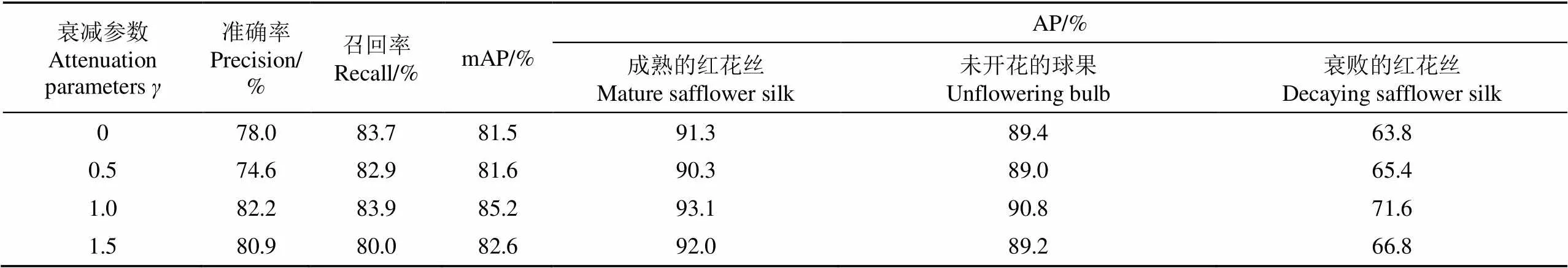

3.3 多分类任务Focal Loss损失函数对模型的影响

在计算损失函数时,为确定衰减参数对模型的影响,本文在loss.py文件通过改变数据集配置文件中fl_gamma的参数值对其进行调用,设定3个样本参数权重α为0.3、0.3、0.4,分别对在0.25~3取值范围模型的性能与改进前(=0)进行对比,得出以下结论:1)关于模型训练损失loss:当=0.5时出现了不收敛现象,值越大损失越小。2)关于均值精准率mAP值,0.5≤≤1.5时,模型的mAP值有所提升。3)关于准确率precision:当≤0.5,≥2.0时,准确率均下降。4)关于召回率recall,当≥0.5时,召回率均有所提升。

综上,当0.5≤≤1.5时,损失函数对模型的性能提升效果较好。本文分别对选取=0.5、1.0、1.5与改进前=0进行结果对比,如表3所示,当=1.0时,改进的损失函数比改进前各类别mAP值提高3.7个百分点,对单类别AP值分别提升1.8、1.4、7.8个百分点,可以看出该损失函数对数量较少的样本进行了强化,从而可以提高样本不均衡造成的识别率低的现象。

表3 衰减参数γ=0.5、1.0、1.5与改进前γ=0对模型影响对比

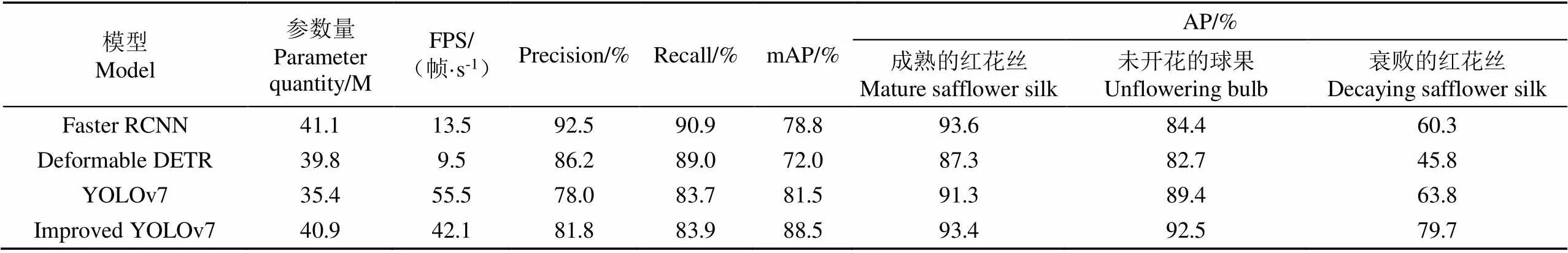

3.4 与其他模型性能对比

本文模型在YOLOv7特征提取层第50层插入Swin Transformer,目标置信度损失和分类损失使用改进损失函数计算。在红花数据集上,利用MMDeteceion检测工具箱将本文模型与改进前的YOLOv7模型以及其他典型目标检测算法模型Faster RCNN、Transformer 框架目标检测算法Deformable DETR分别进行对比,结果如表4所示。

表4 不同模型在红花数据集检测效果对比

通过对比可以看出,4种模型YOLO系列模型优势是实时的检测速度,虽然Faster RCNN、Deformable DETR模型的准确率及召回率较高,但是平均准确率比YOLO系列低,在实际采摘中就会错检漏采情况较为明显。本文根据YOLOv7改进后的模型平均准确率与Faster RCNN、Deformable DETR、YOLOv7模型相比,分别提高了9.7、16.5、7.0个百分点,尤其是针对不均衡样本的平均准确率分别提高了19.4、33.9、15.9个百分点,综合性能指标有一定优势。

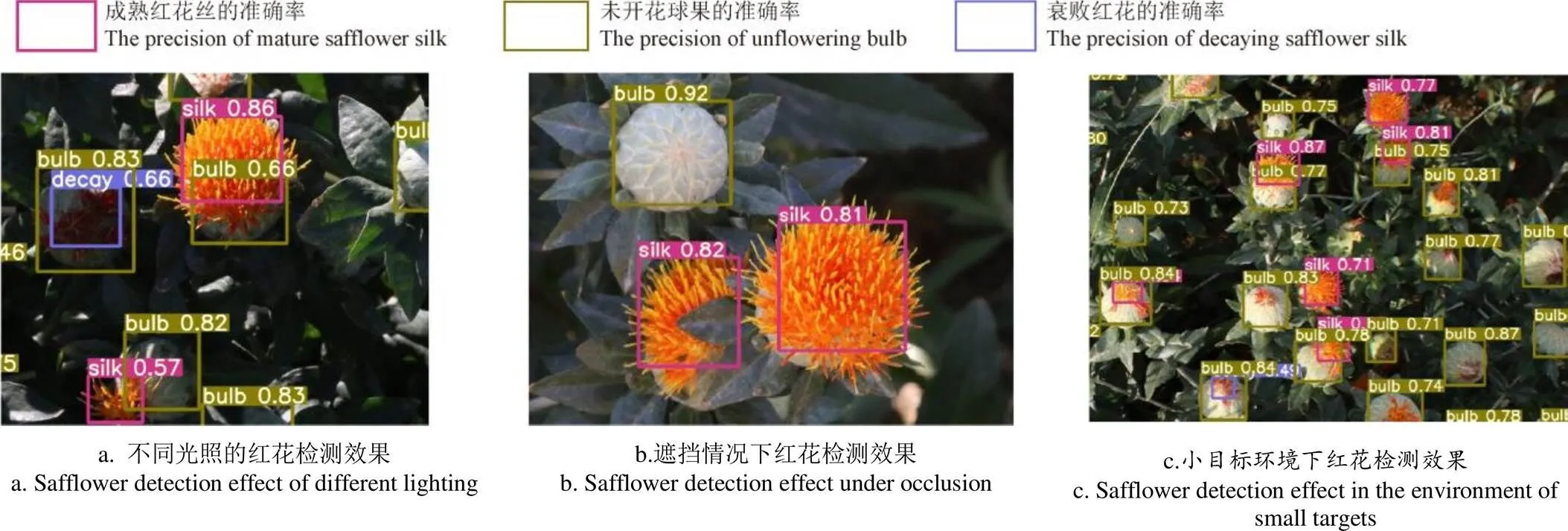

3.5 模型检测效果

利用改进后的模型对红花数据集进行训练与验证,并在测试集中进行测试,检测效果如图4所示。可以看出,改进后的算法在不同光照、遮挡以及小目标等复杂环境下,可以准确地识别出成熟的红花丝、未开花的球果以及衰败的红花丝3种样本,且识别的准确率达到0.6以上。说明改进后的模型对复杂环境下红花样本的识别效果较好。

图4 改进后的模型在复杂环境下的检测效果

4 结 论

本研究针对环境背景复杂、光线遮挡以及样本不均衡造成红花机械化采摘识别率低的问题,建立红花样本数据,增加Swin Transformer注意力机制提高模型对各分类样本的检测精准率,改进Focal Loss损失函数提升多分类任务下不均衡样本的识别率,并与其他典型算法模型进行对比,得出如下结论:

1)在本文红花数据集上,改进后模型的检测效果与改进前相比,各类样本检测的平均准确率达到88.5%,提高了7.0个百分点,不均衡样本衰败红花丝decay的平均准确率提高了15.9个百分点;与Faster RCNN模型相比,平均准确率提高了9.7个百分点,不均衡样本衰败红花丝decay的平均准确率提高了19.4个百分点;与Deformable DETR算法模型相比平均准确率提高了16.5个百分点,不均衡样本衰败红花丝decay的平均准确率提高了33.9个百分点;无论是综合检测效果、还是对不均衡样本检测的平均准确率,改进后模型的优势都比较明显。

2)在模型特征提取层增加Swin Transformer注意力机制可以提高复杂背景下目标的检测准确率,尤其是提升不均衡样本的检测准确率,可以减少红花采摘过程的漏检现象,但是会降低模型的检测速度,降低后的识别速度仍可以满足机械化实时采摘要求,而且对于机械化采摘而言,在保证识别准确率的前提下,牺牲较小的速度指标,匹配采摘动作更有利于保障采摘机械的稳定性。

3)改进后的多分类任务Focal Loss损失函数通过调整衰减参数的大小抑制不同类别样本的权重,改善样本不均衡问题,经过试验对比确定衰减参数取值范围:0.5≤≤1.5,且在本数据集上取值1.0时模型性能提升效果最好。

本文所提方法可以有效改善网络模型在复杂环境下对红花的识别与检测,尤其是解决样本不均衡问题、光照遮挡等问题,可以为真实农田环境下各种作物的识别提供借鉴。在今后的研究中,将从数据层面通过扩大样本数量缩小种类间的不均衡,为模型在采摘机械上的迁移部署提供支持。

[1] 曹卫彬,焦灏博,刘姣娣,等. 基于TRIZ理论的红花丝盲采装置设计与试验[J]. 农业机械学报,2018,49(8):76-82. CAO Weibin, JIAO Haobo, LIU Jiaodi, et al. Design of safflower filament picking device based on TRIZ theory[J]. Transactions of the Chinese Society for Agricultural Machinery, 2018, 49(8): 76-82. (in Chinese with English abstract)

[2] 陈飞,葛云,张立新,等. 红花采摘机器人集条预定位机构设计与试验[J]. 农业工程学报,2021,37(15):10-19. CHEN Fei, GE Yun, ZHANG Lixin, et al. Design and experiment of the strip-collected pre-positioning mechanism for safflower picking robots[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(15): 10-19. (in Chinese with English abstract)

[3] BERTETTO A, MANUELLO, RICCIU R, et al. A mechanical saffron flower harvesting system[J]. Meccanica, 2014, 49(12): 2785-2796.

[4] 钱营,葛云,谷家伟,等. 正压红花采摘装置气流场分析与结构优化[J]. 计算机仿真,2016,33(1):264-267. QIAN Ying, GE Yun, GU Jiawei. et al. Air flow simulation and flow field optimization for positive pressure safflower picking device[J]. Computer Simulation, 2016, 33(1): 264-267. (in Chinese with English abstract)

[5] 陈元博,葛云,梁丹丹,等. 对辊式红花采收实验台的设计与研究[J]. 农机化研究,2017,39(10):38-41. CHEN Yuanbo, GE Yun, LIANG Dandan, et al. Design and research of the roller type safflower harvest test bed[J]. Journal of Agricultural Mechanization Research, 2017, 39(10): 38-41. (in Chinese with English abstract)

[6] 曹卫彬,连国党,牛驰,等. 梳夹式红花丝采摘头等高采收性能试验与参数优化[J]. 农业工程学报,2018,34(22):36-44. CAO Weibin, LIAN Guodang, NIU Chi, et al. Harvest performance test and parameter optimization of comb-type safflower-filaments picking head at same height[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(22): 36-44. (in Chinese with English abstract)

[7] 张振国,吕全贵,任杰宇,等. 旋转剪切式红花花丝采摘机械关键部件的设计[J]. 中国农机化学报,2019,40(7):1-6. ZHANG Zhenguo, LV Quangui, REN Jieyu et al.Design of critical compinents for safflower harvesting machinery by rotary shear[J]. Journal of Chinese Agricultural Machanization, 2019, 40(7): 1-6. (in Chinese with English abstract)

[8] 张晓伟,葛云,陈飞,等. 三手指拉拔式红花采摘末端执行器的设计[J]. 机械设计与制造,2022(1):145-149. ZHANG Xiaowei, GE Yun, CHEN Fei, et al. Design of three-finger pull-out safflower picking end effector[J]. Machinery Design and Manufacture, 2022(1): 145-149. (in Chinese with English abstract)

[9] GUO H, LUO D, GAO G, et al. Design and experiment of a safflower picking robot based on a parallel manipulator[EB/OL]. (2022-06-18)[2022-11-19] https://doi.org/10.1590/1809- 4430-Eng.Agric.v42n1e20210129/2022.

[10] ZHANG H, GE Y, SUN C, et al. Picking path planning method of dual rollers type safflower picking robot based on improved ant colony algorithm[J]. Processes, 2022, 10(6): 1213.

[11] Girshick R. Fast R-CNN[C]//Santiago: Proceedings of the IEEE International Conference on Computer Vision. 2015: 1440-1448.

[12] Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection[C]//Las Vegas, NV, USA: IEEE Conference on Computer Vision and Pattern Recognition. 2016: 779-788.

[13] Redmon J, Farhadi A. YOLOV3: An incremental improvement[EB/OL].(2018-04-08)[2022-11-19] https://arxiv.org/abs/1804.02767.

[14] WANG C Y, Bochkovskiy A, Liao H Y M. YOLOv7: Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[EB/OL]. (2022-07-06)[2022-11-19] https://arxiv.org/abs/ 2207.02696.

[15] 宋怀波,尚钰莹,何东健. 果实目标深度学习识别技术研究进展[J]. 农业机械学报,2023,54(1):1-19. SONG Huaibo, SHANG Yuying, HE Dongjian. Review on deep learning technology for fruit target recognition[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(1): 1-19. (in Chinese with English abstract)

[16] 赵德安,吴任迪,刘晓洋,等. 基于 YOLO 深度卷积神经网络的复杂背景下机器人采摘苹果定位[J]. 农业工程学报:2019,35(3):164-173. ZHAO De’an, WU Rendi, LIU Xiaoyang, et al. Apple positioning based on YOLO deep convolutional neural network for picking robot in complex background[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(3): 164-173. (in Chinese with English abstract)

[17] 吕佳,李帅军,曾梦瑶,等. 基于半监督SPM-YOLOv5的套袋柑橘检测算法[J]. 农业工程学报,2022,38(18):204-211. Lyu Jia, LI Shuaijun, ZENG Mengyao, et al. Detecting bagged citrus using a semi-supervised SPM-YOLOv5[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(18): 204-211. (in Chinese with English abstract)

[18] JIA W, TIAN Y, LUO R, et al. Detection and segmentation of overlapped fruits based on optimized mask R-CNN application in apple harvesting robot[J]. Computers and Electronics in Agriculture, 2020, 172: 105380.

[19] 岳有军,田博凯,王红君,等. 基于改进Mask RCNN的复杂环境下苹果检测研究[J]. 中国农机化学报,2019,40(10):128-134. YUE Youjun, TIAN Bokai, WANG Hongjun, et al. Research on apple detection in complex environment based on improved Mask RCNN[J]. Journal of Chinese Agricultural Machanization, 2019, 40(10): 128-134. (in Chinese with English abstract)

[20] ZHANG J, Karkee M, ZHANG Q, et al. Multi-class object detection using faster R-CNN and estimation of shaking locations for automated shake-and-catch apple harvesting[J]. Computers and Electronics in Agriculture, 2020, 173: 105384.

[21] 朱旭,马淏,姬江涛,等. 基于Faster R-CNN的蓝莓冠层果实检测识别分析[J]. 南方农业学报,2020,51(6):1493-1501. ZHU Xu, MA Hao, JI Jiangtao, et al. Detecting and identifying blueberry canopy fruits based on Faster R-CNN[J]. Journal of Southern Agriculture, 2020, 51(6): 1493-1501. (in Chinese with English abstract)

[22] 李天华,孙萌,丁小明,等. 基于YOLO v4+HSV的成熟期番茄识别方法[J]. 农业工程学报,2021,37(21):183-190. LI Tianhua, SUN Meng, DING Xiaoming, et al. Tomato recognition method at the ripening stage based on YOLO v4 and HSV[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(21): 183-190. (in Chinese with English abstract)

[23] 杨坚,钱振,张燕军,等. 采用改进YOLOv4-tiny的复杂环境下番茄实时识别[J]. 农业工程学报,2022,38(9):215-221. YANG Jian, QIAN Zhen, ZHANG Yanjun, et al. Real-time recognition of tomatoes in complex environments based on improved YOLOv4-tiny[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(9): 215-221. (in Chinese with English abstract)

[24] 张伏,陈自均,鲍若飞,等. 基于改进型 YOLOv4-LITE 轻量级神经网络的密集圣女果识别[J]. 农业工程学报,2021,37(16):270-278. ZHANG Fu, CHEN Zijun, BAO Ruofei, et al. Recognition of dense cherry tomatoes based on improved YOLOv4-LITE lightweight neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(16): 270-278. (in Chinese with English abstract)

[25] CHEN C, LU J, ZHOU M, et al. A YOLOv3-based computer vision system for identification of tea buds and the picking point[J]. Computers and Electronics in Agriculture, 2022, 198: 107116.

[26] CAO M, FU H, ZHU J, et al. Lightweight tea bud recognition network integrating GhostNet and YOLOv5[J]. Mathematical Biosciences and Engineering, 2022, 19(12): 12897-12914.

[27] 张大刀,YOLOv7 网络架构深度解析[EB/OL].(2022-07-20)[2022-11-19] https: //blog. csdn. net/zqwwwm/article/details/125901507.

[28] LIU Z, LIN Y, CAO Y, et al. Swin transformer: Hierarchical vision transformer using shifted windows[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Virtual, 2021: 10012-10022.

[29] LIN T Y, Goyal P, Girshick R, et al. Focal loss for dense object detection[C]//Proceedings of the IEEE International Conference on Computer Vision. Venice, 2017: 2980-2988.

Safflower picking recognition in complex environments based on an improved YOLOv7

WANG Xiaorong1,2, XU Yan1,2, ZHOU Jianping1,2※, CHEN Jinrong1

(1.,,830017,;2.,830017,)

Safflower silk is one of the most important cash crops in the medical treatment and dye. The manual picking of safflower silk cannot fully meet the large-scale production at present. The mechanized harvesting can be expected to improve the safflower harvesting efficiency and labor cost-saving in the industrial planting. The complex environmental factors have made great difficulty to accurately identify and locate the safflower during mechanical picking, including the natural environment (such as the light and shelter), and the safflower characteristics (such as the small and dense target, as well as the different maturity). In this study, an improved YOLOv7 model was proposed to rapidly and accurately locate the safflower recognition in the complex environment. 1500 safflower images were established to divide into three types of samples, silk, bulb, and decay. The small target was found in the datasets with uneven sample size, especially the data of decay. The safflower sample dataset was produced to build the complex environment data for the real picking. Firstly, the Swin Transformer attention mechanism was added to the YOLOv7 network model, in order to improve the detection accuracy of the model for each classification sample, and the ability of the backbone network, especially to extract the small target features. Secondly, the Focal Loss function of the multi-classification was improved in the recognition rate of unbalanced samples under multi-class tasks, particularly for the target confidence loss and classification loss. The attenuation parameterswas adjusted to balance the sample. The attenuation parameters were determined after experimental verification. Finally, the safflower detection network model was designed to meet the real-time and accurate detection requirements under the complex environment. The test results show that the best performance of the model was achieved in the attenuation parameters of 1.0, where the position of Swin Transformer was the layer 50. The average precision of the improved model reached 88.5% in each category sample, which was 7.0 percentage points higher than before. The average detection accuracy of the unbalanced category sample decay was 15.9 percentage points higher. Compared with the Faster RCNN model, the detection speed increased by three times, while the average accuracy increased by 9.7 percentage points; Compared with the Deformable DETR model, the detection speed increased by about 5 times, and the average accuracy increased by 16.5 percentage points. The improved model performed the best, in terms of the detection efficiency, detection speed, and model size. The improved model can also be expected to accurately detect the safflower, indicating the smaller parameters and the faster recognition speed suitable for the migration deployment on the safflower picking machinery. The finding can provide the technical support for the mechanized picking in real time. In the future research, the balance between species can be promoted to expand the number of samples from the data level in the harvesting machinery.

image recognition; image processing; complex environments; YOLOv7; attention mechanisms; multi-classification focal loss function; safflower picking

10.11975/j.issn.1002-6819.202211164

S225;TP391

A

1002-6819(2023)-06-0169-08

王小荣,许燕,周建平,等. 基于改进YOLOv7的复杂环境下红花采摘识别[J]. 农业工程学报,2023,39(6):169-176.doi:10.11975/j.issn.1002-6819.202211164 http://www.tcsae.org

WANG Xiaorong, XU Yan, ZHOU Jianping, et al. Safflower picking recognition in complex environments based on an improved YOLOv7[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2023, 39(6): 169-176. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.202211164 http://www.tcsae.org

2022-11-19

2023-03-01

新疆维吾尔自治区创新团队项目-机器人及智能装备技术科技创新团队(2022D14002)

王小荣,博士生,研究方向为人工智能、农业机械化与信息化。Email:XiaorongWang@xju.edu.cn

周建平,教授,博士生导师,研究方向为机电一体化、农业机械化与信息化。Email:linkzhou@163.com